L'apprentissage automatique (ML) aide les organisations à augmenter leurs revenus, à stimuler la croissance de l'entreprise et à réduire les coûts en optimisant les fonctions commerciales de base dans plusieurs secteurs verticaux, tels que la prévision de la demande, la notation du crédit, la tarification, la prévision de l'attrition des clients, l'identification des meilleures offres suivantes, la prévision des livraisons tardives et amélioration de la qualité de fabrication. Les cycles de développement ML traditionnels prennent des mois et nécessitent des compétences rares en science des données et en ingénierie ML. Les idées des analystes pour les modèles ML restent souvent dans de longs backlogs en attendant la bande passante de l'équipe de science des données, tandis que les scientifiques des données se concentrent sur des projets ML plus complexes nécessitant toutes leurs compétences.

Pour aider à sortir de cette impasse, nous avons introduit Amazon SageMaker Canvas, une solution de ML sans code qui peut aider les entreprises à accélérer la livraison de solutions de ML en heures ou en jours. SageMaker Canvas permet aux analystes d'utiliser facilement les données disponibles dans les lacs de données, les entrepôts de données et les magasins de données opérationnelles ; créer des modèles ML ; et utilisez-les pour faire des prédictions de manière interactive et pour la notation par lots sur des ensembles de données en masse, le tout sans écrire une seule ligne de code.

Dans cet article, nous montrons comment SageMaker Canvas permet la collaboration entre les scientifiques des données et les analystes commerciaux, en accélérant la mise sur le marché et en accélérant le développement de solutions ML. Les analystes disposent de leur propre espace de travail ML sans code dans SageMaker Canvas, sans avoir à devenir un expert en ML. Les analystes peuvent ensuite partager leurs modèles depuis Canvas en quelques clics, avec lesquels les data scientists pourront travailler dans Amazon SageMakerStudio, un environnement de développement intégré (IDE) ML de bout en bout. En travaillant ensemble, les analystes métier peuvent apporter leur connaissance du domaine et les résultats de l'expérimentation, tandis que les data scientists peuvent créer efficacement des pipelines et rationaliser le processus.

Voyons en profondeur à quoi ressemblerait le flux de travail.

Les analystes commerciaux créent un modèle, puis le partagent

Pour comprendre comment SageMaker Canvas simplifie la collaboration entre les analystes métier et les data scientists (ou ingénieurs ML), nous abordons d'abord le processus en tant qu'analyste métier. Avant de commencer, consultez Présentation d'Amazon SageMaker Canvas, une capacité d'apprentissage automatique visuelle et sans code pour les analystes commerciaux pour obtenir des instructions sur la construction et le test du modèle avec SageMaker Canvas.

Pour cet article, nous utilisons une version modifiée du Ensemble de données de détection de fraude par carte de crédit de Kaggle, un ensemble de données bien connu pour un problème de classification binaire. L'ensemble de données est à l'origine très déséquilibré - il contient très peu d'entrées classées dans une classe négative (transactions anormales). Quelle que soit la distribution des fonctionnalités cibles, nous pouvons toujours utiliser cet ensemble de données, car SageMaker Canvas gère ce déséquilibre lorsqu'il entraîne et ajuste automatiquement un modèle. Cet ensemble de données se compose d'environ 9 millions de cellules. Vous pouvez également télécharger un version réduite de cet ensemble de données. La taille de l'ensemble de données est beaucoup plus petite, à environ 500,000 0 cellules, car il a été sous-échantillonné de manière aléatoire puis sur-échantillonné avec la technique SMOTE pour garantir que le moins d'informations possible soit perdue au cours de ce processus. L'exécution d'une expérience complète avec cet ensemble de données réduit vous coûte XNUMX $ dans le cadre de l'offre gratuite de SageMaker Canvas.

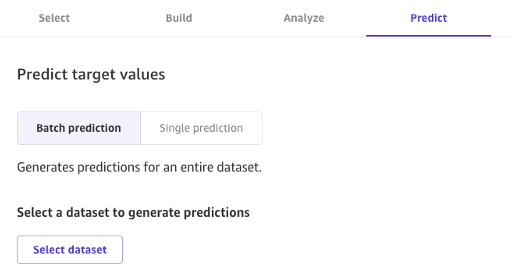

Une fois le modèle créé, les analystes peuvent l'utiliser pour effectuer des prédictions directement dans Canvas pour des demandes individuelles ou pour un ensemble de données d'entrée complet en masse.

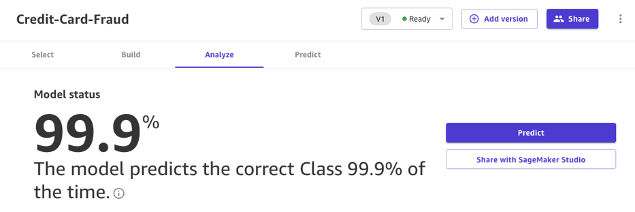

Les modèles créés avec Canvas Standard Build peuvent également être facilement partagés en un clic avec des scientifiques des données et des ingénieurs ML qui utilisent SageMaker Studio. Cela permet à un scientifique des données de valider les performances du modèle que vous avez construit et de fournir des commentaires. Les ingénieurs ML peuvent récupérer votre modèle et l'intégrer aux workflows et produits existants disponibles pour votre entreprise et vos clients. Notez qu'au moment de la rédaction, il n'est pas possible de partager un modèle construit avec Canvas Quick Build, ou un modèle de prévision de série chronologique.

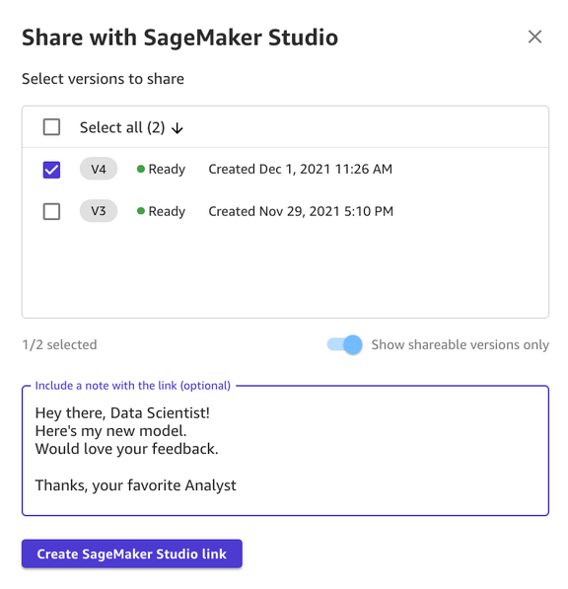

Partager un modèle via l'interface utilisateur Canvas est simple :

- Sur la page affichant les modèles que vous avez créés, choisissez un modèle.

- Selectionnez Partager.

- Choisissez une ou plusieurs versions du modèle que vous souhaitez partager.

- Si vous le souhaitez, incluez une note donnant plus de contexte sur le modèle ou l'aide que vous recherchez.

- Selectionnez Créer un lien SageMaker Studio.

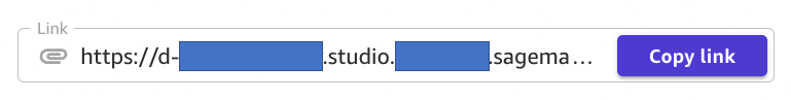

- Copiez le lien généré.

Et c'est tout! Vous pouvez maintenant partager le lien avec vos collègues via Slack, e-mail ou toute autre méthode de votre choix. Le scientifique des données doit être dans le même domaine SageMaker Studio pour accéder à votre modèle, alors assurez-vous que c'est le cas avec l'administrateur de votre organisation.

Les data scientists accèdent aux informations du modèle depuis SageMaker Studio

Maintenant, jouons le rôle d'un data scientist ou d'un ingénieur ML, et voyons les choses de leur point de vue en utilisant SageMaker Studio.

Le lien partagé par l'analyste nous emmène dans SageMaker Studio, le premier IDE basé sur le cloud pour le flux de travail ML de bout en bout.

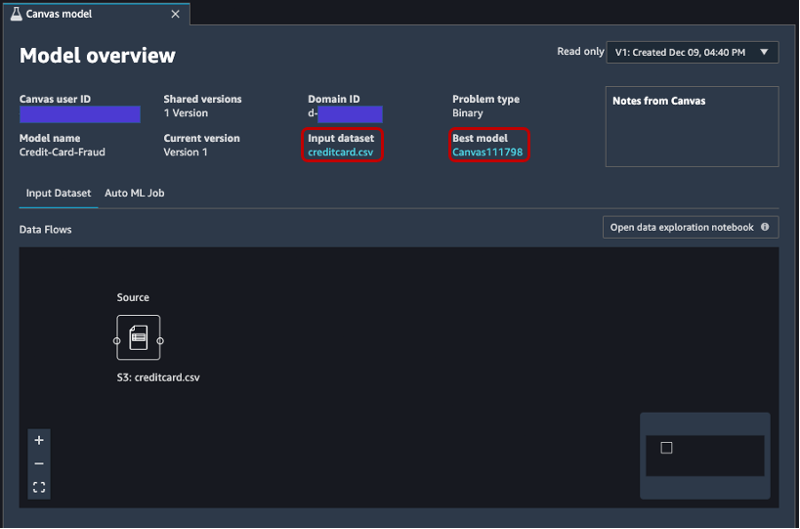

L'onglet s'ouvre automatiquement et affiche un aperçu du modèle créé par l'analyste dans SageMaker Canvas. Vous pouvez voir rapidement le nom du modèle, le type de problème ML, la version du modèle et l'utilisateur qui a créé le modèle (sous le champ ID utilisateur Canvas). Vous avez également accès à des détails sur l'ensemble de données d'entrée et le meilleur modèle que SageMaker a pu produire. Nous y reviendrons plus tard dans le post.

Sur le Jeu de données d'entrée , vous pouvez également voir le flux de données de la source vers le jeu de données d'entrée. Dans ce cas, une seule source de données est utilisée et aucune opération de jointure n'a été appliquée, de sorte qu'une seule source est affichée. Vous pouvez analyser les statistiques et les détails du jeu de données en choisissant Cahier d'exploration des données ouvertes. Ce bloc-notes vous permet d'explorer les données qui étaient disponibles avant la formation du modèle et contient une analyse de la variable cible, un échantillon des données d'entrée, des statistiques et des descriptions des colonnes et des lignes, ainsi que d'autres informations utiles pour le scientifique des données. en savoir plus sur l'ensemble de données. Pour en savoir plus sur ce rapport, consultez Rapport d'exploration de données.

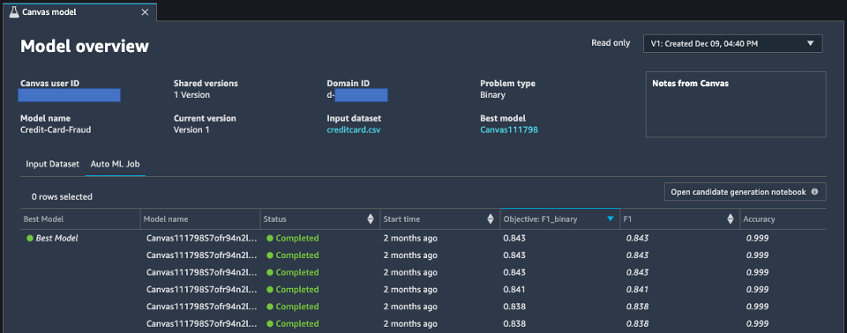

Après avoir analysé le jeu de données d'entrée, passons au deuxième onglet de la vue d'ensemble du modèle, Tâche AutoML. Cet onglet contient une description de la tâche AutoML lorsque vous avez sélectionné l'option de construction standard dans SageMaker Canvas.

La technologie AutoML sous SageMaker Canvas élimine les lourdes tâches liées à la création de modèles ML. Il construit, forme et ajuste automatiquement le meilleur modèle ML basé sur vos données en utilisant une approche automatisée, tout en vous permettant de garder un contrôle et une visibilité totale. Cette visibilité sur les modèles candidats générés ainsi que les hyper-paramètres utilisés lors du processus AutoML est contenue dans le cahier de génération de candidats, qui est disponible sur cet onglet.

La Tâche AutoML L'onglet contient également une liste de tous les modèles créés dans le cadre du processus AutoML, triés par la métrique d'objectif F1. Pour mettre en évidence le meilleur modèle parmi les jobs d'entraînement lancés, une balise avec un cercle vert est utilisée dans le Meilleur modèle colonne. Vous pouvez également visualiser facilement d'autres mesures utilisées pendant la phase de formation et d'évaluation, telles que le score de précision et l'aire sous la courbe (AUC). Pour en savoir plus sur les modèles que vous pouvez entraîner au cours d'une tâche AutoML et sur les métriques utilisées pour évaluer les performances du modèle entraîné, consultez Prise en charge du modèle, métriques et validation.

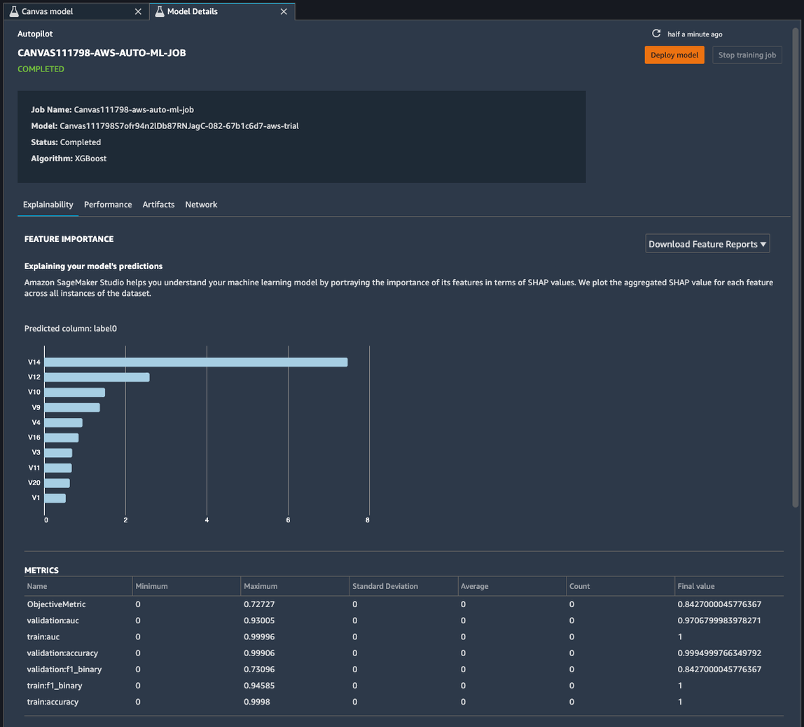

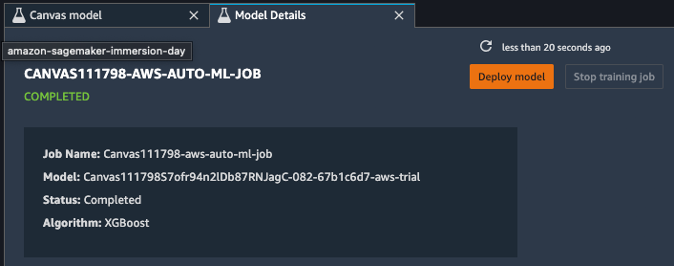

Pour en savoir plus sur le modèle, vous pouvez maintenant cliquer avec le bouton droit sur le meilleur modèle et choisir Ouvrir dans les détails du modèle. Alternativement, vous pouvez choisir le Meilleur modèle lien en haut de la Aperçu du modèle section que vous avez visitée pour la première fois.

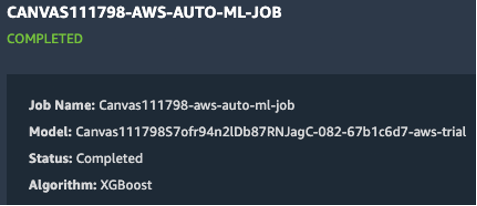

La page des détails du modèle contient une pléthore d'informations utiles concernant le modèle qui a le mieux fonctionné avec ces données d'entrée. Concentrons-nous d'abord sur le résumé en haut de la page. L'exemple de capture d'écran précédent montre que, sur des centaines d'exécutions d'entraînement de modèle, un modèle XGBoost a obtenu les meilleurs résultats sur l'ensemble de données d'entrée. Au moment d'écrire ces lignes, SageMaker Canvas peut former trois types d'algorithmes ML : apprenant linéaire, XGBoost et un perceptron multicouche (MLP), chacun avec une grande variété de pipelines de prétraitement et d'hyperparamètres. Pour en savoir plus sur chaque algorithme, reportez-vous à page des algorithmes pris en charge.

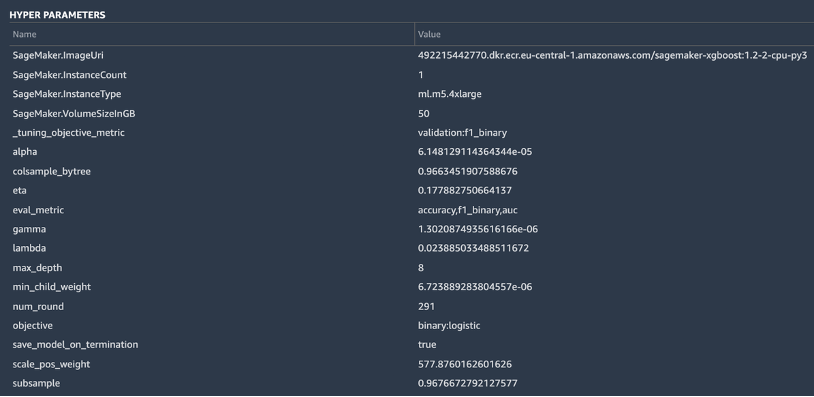

SageMaker intègre également une fonctionnalité explicative grâce à une implémentation évolutive et efficace de NoyauSHAP, basé sur le concept d'une valeur de Shapley du domaine de la théorie des jeux coopératifs qui attribue à chaque fonctionnalité une valeur d'importance pour une prédiction particulière. Cela permet une transparence sur la façon dont le modèle est arrivé à ses prédictions, et il est très utile de définir l'importance des caractéristiques. Un rapport d'explicabilité complet comprenant l'importance des fonctionnalités est téléchargeable au format PDF, bloc-notes ou données brutes. Dans ce rapport, un ensemble plus large de métriques est affiché ainsi qu'une liste complète des hyper-paramètres utilisés pendant la tâche AutoML. Pour en savoir plus sur la façon dont SageMaker fournit des outils d'explicabilité intégrés pour les solutions AutoML et les algorithmes de ML standard, consultez Utilisez des outils d'explicabilité intégrés et améliorez la qualité du modèle à l'aide d'Amazon SageMaker Autopilot.

Enfin, les autres onglets de cette vue affichent des informations sur les détails des performances (matrice de confusion, courbe de rappel de précision, courbe ROC), les artefacts utilisés pour les entrées et générés pendant la tâche AutoML, et les détails du réseau.

À ce stade, le data scientist a deux choix : déployer directement le modèle ou créer un pipeline de formation qui peut être programmé ou déclenché manuellement ou automatiquement. Les sections suivantes donnent un aperçu des deux options.

Déployer le modèle directement

Si le data scientist est satisfait des résultats obtenus par la tâche AutoML, il peut déployer directement le modèle à partir du Détails du modèle page. C'est aussi simple que de choisir Déployer le modèle à côté du nom du modèle.

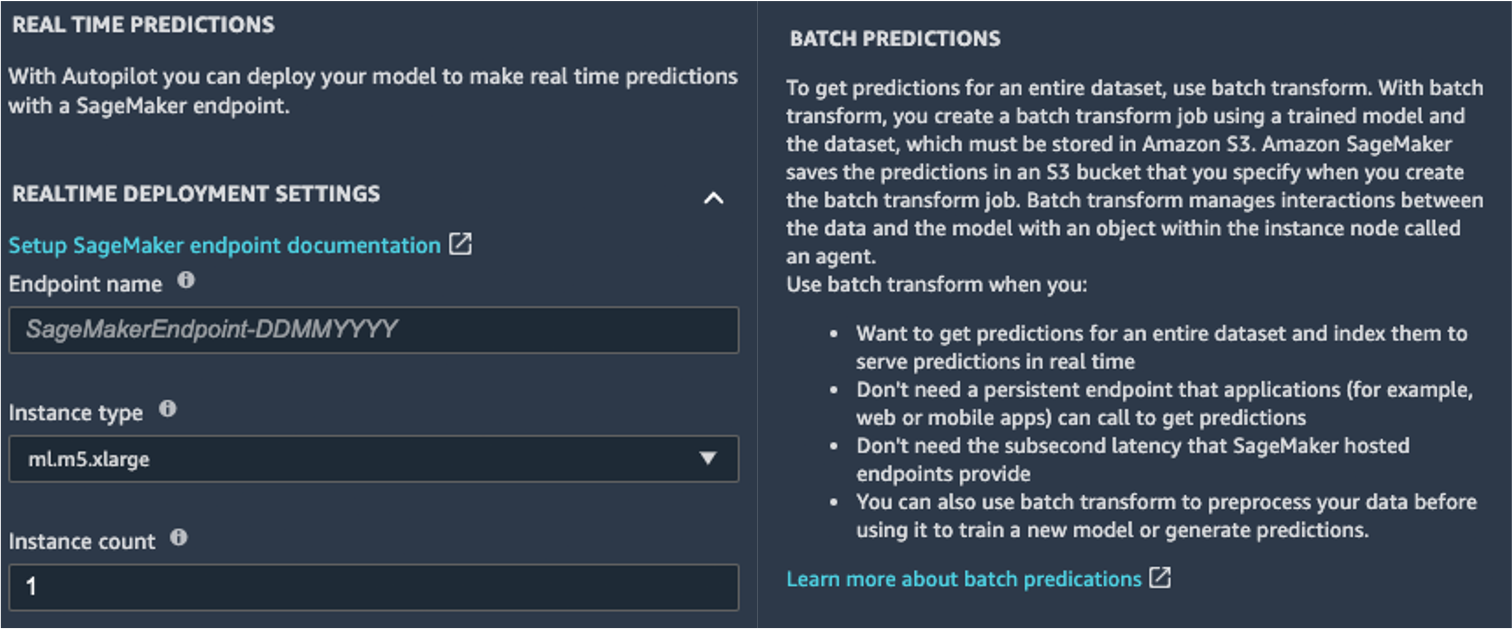

SageMaker vous propose deux options de déploiement : un point de terminaison en temps réel, optimisé par Points de terminaison Amazon SageMaker, et l'inférence par lots, optimisée par Transformation par lots Amazon SageMaker.

SageMaker fournit également d'autres modes d'inférence. Pour en savoir plus, consultez Déployer des modèles pour l'inférence.

Pour activer le mode de prédictions en temps réel, il vous suffit de donner au point de terminaison un nom, un type d'instance et un nombre d'instances. Étant donné que ce modèle ne nécessite pas de ressources de calcul lourdes, vous pouvez utiliser une instance basée sur le processeur avec un nombre initial de 1. Vous pouvez en savoir plus sur les différents types d'instances disponibles et leurs spécifications sur le Page de tarification d'Amazon SageMaker (dans le Tarification à la demande section, choisissez la Inférence en temps réel languette). Si vous ne savez pas quelle instance choisir pour votre déploiement, vous pouvez également demander à SageMaker de trouver la meilleure pour vous en fonction de vos KPI en utilisant le Recommandateur d'inférence SageMaker. Vous pouvez également fournir des paramètres facultatifs supplémentaires, indiquant si vous souhaitez ou non capturer les données de demande et de réponse vers ou depuis le point de terminaison. Cela peut s'avérer utile si vous prévoyez suivi de votre modèle. Vous pouvez également choisir le contenu que vous souhaitez fournir dans le cadre de votre réponse, qu'il s'agisse uniquement de la prédiction ou de la probabilité de prédiction, de la probabilité de toutes les classes et des étiquettes cibles.

Pour exécuter une tâche de scoring par lots en obtenant des prédictions pour un ensemble complet d'entrées à la fois, vous pouvez lancer la tâche de transformation par lots à partir de l'onglet Console de gestion AWS ou via le SDK SageMaker Python. Pour en savoir plus sur la transformation par lots, reportez-vous à Utiliser la transformation par lots et les cahiers d'exemple.

Définir un pipeline de formation

Les modèles ML peuvent très rarement, voire jamais, être considérés comme statiques et immuables, car ils dérivent de la ligne de base sur laquelle ils ont été formés. Les données du monde réel évoluent au fil du temps, et davantage de modèles et d'informations en émergent, qui peuvent ou non être capturés par le modèle d'origine formé sur des données historiques. Pour résoudre ce problème, vous pouvez configurer un pipeline de formation qui réentraîne automatiquement vos modèles avec les dernières données disponibles.

Lors de la définition de ce pipeline, l'une des options du data scientist est d'utiliser à nouveau AutoML pour le pipeline de formation. Vous pouvez lancer une tâche AutoML par programme en appelant l'API create_auto_ml_job() à partir du SDK AWS Boto3. Vous pouvez appeler cette opération à partir d'un AWS Lambda fonction au sein d'un Fonctions d'étape AWS workflow, ou à partir d'une LambdaStep dans Pipelines Amazon SageMaker.

Alternativement, le spécialiste des données peut utiliser les connaissances, les artefacts et les hyperparamètres obtenus à partir de la tâche AutoML pour définir un pipeline de formation complet. Vous avez besoin des ressources suivantes :

- L'algorithme qui a le mieux fonctionné pour le cas d'utilisation – Vous avez déjà obtenu ces informations à partir du résumé du modèle généré par Canvas. Pour ce cas d'utilisation, il s'agit de l'algorithme intégré XGBoost. Pour obtenir des instructions sur l'utilisation du SDK Python SageMaker pour former l'algorithme XGBoost avec SageMaker, reportez-vous à Utiliser XGBoost avec le SDK SageMaker Python.

- Les hyperparamètres dérivés par la tâche AutoML - Ceux-ci sont disponibles dans le Explicabilité section. Vous pouvez les utiliser comme entrées lors de la définition de la tâche de formation avec le SDK SageMaker Python.

- Le code d'ingénierie de fonctionnalité fourni dans la section Artefacts – Vous pouvez utiliser ce code à la fois pour prétraiter les données avant la formation (par exemple, via le traitement Amazon SageMaker) ou avant l'inférence (par exemple, dans le cadre d'un pipeline d'inférence SageMaker).

Vous pouvez combiner ces ressources dans le cadre d'un pipeline SageMaker. Nous omettons les détails de mise en œuvre dans cet article - restez à l'écoute pour plus de contenu à venir sur ce sujet.

Conclusion

SageMaker Canvas vous permet d'utiliser ML pour générer des prédictions sans avoir besoin d'écrire de code. Un analyste métier peut commencer à l'utiliser de manière autonome avec des ensembles de données locaux, ainsi que des données déjà stockées sur Service de stockage simple Amazon (Amazon S3), Redshift d'Amazon, ou Flocon de neige. En quelques clics seulement, ils peuvent préparer et joindre leurs ensembles de données, analyser la précision estimée, vérifier quelles colonnes ont un impact, former le modèle le plus performant et générer de nouvelles prédictions individuelles ou par lots, le tout sans avoir besoin de faire appel à un spécialiste des données. Ensuite, selon les besoins, ils peuvent partager le modèle avec une équipe de scientifiques des données ou d'ingénieurs MLOps, qui importent les modèles dans SageMaker Studio et travaillent aux côtés de l'analyste pour fournir une solution de production.

Les analystes commerciaux peuvent obtenir des informations de manière indépendante à partir de leurs données sans avoir de diplôme en ML et sans avoir à écrire une seule ligne de code. Les scientifiques des données peuvent désormais disposer de plus de temps pour travailler sur des projets plus ambitieux qui peuvent mieux utiliser leurs connaissances approfondies de l'IA et du ML.

Nous pensons que cette nouvelle collaboration ouvre la porte à la création de nombreuses solutions de ML plus puissantes pour votre entreprise. Vous avez maintenant des analystes qui produisent des informations commerciales précieuses, tout en laissant les scientifiques des données et les ingénieurs ML aider à affiner, ajuster et étendre selon les besoins.

Ressources additionnelles

- Pour en savoir plus sur la manière dont SageMaker peut aider davantage les analystes métier, reportez-vous à Amazon SageMaker pour les analystes commerciaux.

- Pour en savoir plus sur la façon dont SageMaker permet aux data scientists de développer, former et déployer leurs modèles ML, consultez Amazon SageMaker pour les scientifiques des données.

- Pour plus d'informations sur la manière dont SageMaker peut aider les ingénieurs MLOps à rationaliser le cycle de vie ML à l'aide de MLOps, reportez-vous à Amazon SageMaker pour les ingénieurs MLOps.

À propos des auteurs

David Gallitelli est un architecte de solutions spécialisé pour l'IA/ML dans la région EMEA. Il est basé à Bruxelles et travaille en étroite collaboration avec des clients dans tout le Benelux. Il est développeur depuis qu'il est très jeune et a commencé à coder à l'âge de 7 ans. Il a commencé à apprendre l'IA/ML à l'université et en est tombé amoureux depuis.

David Gallitelli est un architecte de solutions spécialisé pour l'IA/ML dans la région EMEA. Il est basé à Bruxelles et travaille en étroite collaboration avec des clients dans tout le Benelux. Il est développeur depuis qu'il est très jeune et a commencé à coder à l'âge de 7 ans. Il a commencé à apprendre l'IA/ML à l'université et en est tombé amoureux depuis.

Marc Roy est un architecte principal d'apprentissage automatique pour AWS, aidant les clients à concevoir et à créer des solutions AI / ML. Le travail de Mark couvre un large éventail de cas d'utilisation du ML, avec un intérêt principal pour la vision par ordinateur, l'apprentissage en profondeur et la mise à l'échelle du ML dans l'entreprise. Il a aidé des entreprises dans de nombreux secteurs, notamment l'assurance, les services financiers, les médias et le divertissement, la santé, les services publics et la fabrication. Mark détient six certifications AWS, dont la certification ML Specialty. Avant de rejoindre AWS, Mark a été architecte, développeur et leader technologique pendant plus de 25 ans, dont 19 ans dans les services financiers.

Marc Roy est un architecte principal d'apprentissage automatique pour AWS, aidant les clients à concevoir et à créer des solutions AI / ML. Le travail de Mark couvre un large éventail de cas d'utilisation du ML, avec un intérêt principal pour la vision par ordinateur, l'apprentissage en profondeur et la mise à l'échelle du ML dans l'entreprise. Il a aidé des entreprises dans de nombreux secteurs, notamment l'assurance, les services financiers, les médias et le divertissement, la santé, les services publics et la fabrication. Mark détient six certifications AWS, dont la certification ML Specialty. Avant de rejoindre AWS, Mark a été architecte, développeur et leader technologique pendant plus de 25 ans, dont 19 ans dans les services financiers.

- Coinsmart. Le meilleur échange Bitcoin et Crypto d'Europe.

- Platoblockchain. Intelligence métaverse Web3. Connaissance amplifiée. ACCÈS LIBRE.

- CryptoHawk. Radar Altcoins. Essai gratuit.

- Source : https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- code-ml-et-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- À propos

- accélérer

- accélérer

- accès

- Selon

- à travers

- Supplémentaire

- admin

- AI

- algorithme

- algorithmes

- Tous

- Permettre

- déjà

- Amazon

- selon une analyse de l’Université de Princeton

- analyste

- api

- une approche

- Réservé

- autour

- Automatisation

- disponibles

- AWS

- Baseline

- devenez

- LES MEILLEURS

- frontière

- Bruxelles

- construire

- Développement

- construit

- intégré

- la performance des entreprises

- Appelez-nous

- cas

- Certifications

- choix

- Réseautage et Mentorat

- classification

- code

- collaboration

- Colonne

- Venir

- Sociétés

- Société

- complexe

- calcul

- concept

- confusion

- contient

- contenu

- des bactéries

- coopérative

- Core

- Costs

- crédit

- courbe

- Clients

- données

- science des données

- Data Scientist

- page de livraison.

- Demande

- déployer

- déploiement

- Conception

- Détection

- développer

- Développeur

- Développement

- différent

- distribution

- Ne fait pas

- domaine

- down

- même

- efficace

- Endpoint

- ingénieur

- ENGINEERING

- Les ingénieurs

- Entreprise

- Divertissement

- Environment

- estimé

- exemple

- expérience

- exploration

- étendre

- plus rapide

- Fonctionnalité

- Réactions

- la traduction de documents financiers

- services financiers

- Prénom

- flux

- Focus

- Abonnement

- le format

- fraude

- Test d'anglais

- plein

- fonction

- jeu

- générer

- obtention

- Don

- Vert

- Croissance

- ayant

- la médecine

- aider

- aide

- Souligner

- très

- historique

- détient

- Comment

- How To

- HTTPS

- Des centaines

- importance

- améliorer

- comprendre

- Y compris

- Améliore

- individuel

- secteurs

- d'information

- idées.

- Assurance

- intégrer

- des services

- intérêt

- IT

- Emploi

- Emplois

- rejoindre

- spécialisées

- Etiquettes

- Nouveautés

- lancer

- APPRENTISSAGE

- apprentissage

- Gamme

- LINK

- Liste

- peu

- locales

- Location

- recherchez-

- love

- click

- machine learning

- gestion

- manuellement

- fabrication

- marque

- Marché

- Matrice

- Médias

- Métrique

- million

- ML

- modèle

- numériques jumeaux (digital twin models)

- mois

- Bougez

- réseau et

- cahier

- Offres Speciales

- ouvre

- Opérations

- Option

- Options

- de commander

- organisation

- organisations

- Autre

- performant

- performances

- phase

- et la planification de votre patrimoine

- Jouez

- Point de vue

- possible

- solide

- prédiction

- Prédictions

- établissement des prix

- primaire

- Directeur

- Problème

- processus

- produire

- Vidéo

- Produits

- projets

- fournir

- fournit

- tirant

- qualité

- vite.

- gamme

- raw

- en temps réel

- réduire

- rapport

- exigent

- Ressources

- réponse

- Résultats

- de revenus

- Courir

- pour le running

- évolutive

- mise à l'échelle

- Sciences

- Scientifique

- scientifiques

- Sdk

- choisi

- Série

- Services

- set

- Partager

- commun

- étapes

- SIX

- Taille

- compétences

- mou

- So

- Solutions

- RÉSOUDRE

- Commencer

- j'ai commencé

- statistiques

- storage

- STORES

- studio

- Support

- Target

- équipe

- Technologie

- Essais

- La Source

- tout au long de

- fiable

- ensemble

- les outils

- top

- traditionnel

- Formation

- les trains

- Transactions

- Transformer

- Transparence

- ui

- comprendre

- université

- us

- utilisé

- Plus-value

- Voir

- définition

- vision

- Quoi

- que

- WHO

- dans les

- sans

- Activités:

- travaillé

- de travail

- vos contrats

- écriture

- années