Je suis un grand fan de l'émission de voyage d'Anthony Bourdain Pièces inconnues. Dans chaque épisode, le chef visite des villages reculés à travers le monde, documentant la vie, les aliments et les cultures des tribus régionales avec un cœur et un esprit ouverts.

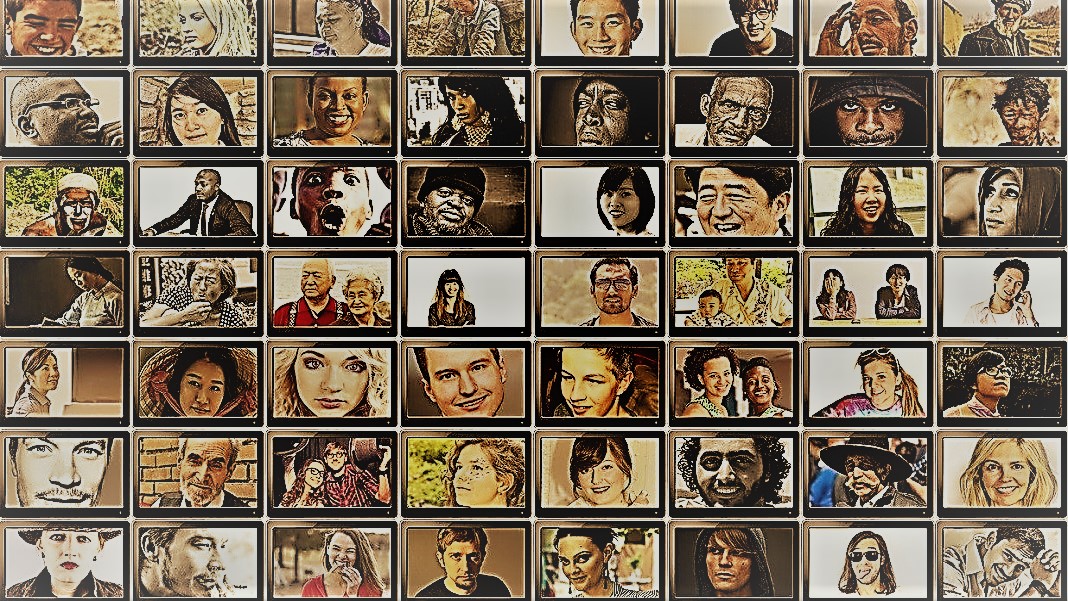

Le spectacle donne un aperçu de l'étonnante diversité de l'humanité. Les spécialistes des sciences sociales ont un objectif similaire - comprendre le comportement de différentes personnes, groupes et cultures - mais utilisent une variété de méthodes dans des situations contrôlées. Pour les deux, les vedettes de ces poursuites sont les sujets : les humains.

Et si vous remplaciez les humains par des chatbots IA ?

L'idée semble saugrenue. Pourtant, grâce à l'avènement de ChatGPT et d'autres grands modèles de langage (LLM), les spécialistes des sciences sociales flirtent avec l'idée d'utiliser ces outils pour construire rapidement divers groupes d '«humains simulés» et mener des expériences pour sonder leur comportement et leurs valeurs comme proxy pour leurs homologues biologiques.

Si vous imaginez des esprits humains recréés numériquement, ce n'est pas ça. L'idée est de puiser dans l'expertise de ChatGPT pour imiter les réponses humaines. Parce que les modèles récupèrent d'énormes quantités de données en ligne (blogs, commentaires Youtube, fan fiction, livres), ils capturent facilement les relations entre les mots dans plusieurs langues. Ces algorithmes sophistiqués peuvent également décoder des aspects nuancés du langage, tels que l'ironie, le sarcasme, les métaphores et les tons émotionnels, un aspect essentiel de la communication humaine dans toutes les cultures. Ces atouts permettent aux LLM d'imiter plusieurs personnalités synthétiques avec un large éventail de croyances.

Un autre bonus ? Par rapport aux participants humains, ChatGPT et d'autres LLM ne se fatiguent pas, permettant aux scientifiques de collecter des données et de tester des théories sur le comportement humain à une vitesse sans précédent.

L'idée, bien que controversée, a déjà du soutien. Un article récent l'examen du domaine naissant a révélé que dans certains scénarios soigneusement conçus, les réponses de ChatGPT étaient en corrélation avec celles d'environ 95 % des participants humains.

L'IA "pourrait changer la donne pour la recherche en sciences sociales" a affirmé Valérie Plante. Le Dr Igor Grossman de l'Université de Waterloo, qui a récemment rédigé avec des collègues un article prospectif dans Sciences. La clé d'utilisation Homo silicium dans la recherche? Gestion prudente des biais et fidélité des données, a déclaré l'équipe.

Sonder l'esprit sociétal humain

Qu'est-ce que la science sociale exactement ?

En termes simples, il s'agit d'étudier comment les humains, soit en tant qu'individus, soit en tant que groupe, se comportent dans différentes circonstances, comment ils interagissent les uns avec les autres et se développent en tant que culture. C'est un parapluie de poursuite académique avec plusieurs branches: économie, science politique, anthropologie et psychologie.

La discipline aborde un large éventail de sujets importants dans l'air du temps actuel. Quel est l'impact des réseaux sociaux sur la santé mentale ? Quelles sont les attitudes actuelles du public à l'égard du changement climatique à mesure que les épisodes météorologiques violents augmentent ? Comment les différentes cultures valorisent-elles les méthodes de communication et qu'est-ce qui déclenche les malentendus ?

Une étude en sciences sociales commence par une question et une hypothèse. Une de mes préférées : les cultures tolèrent-elles différemment les odeurs corporelles ? (Sans blague, le sujet a été étudié un peu, et oui, il existe une différence!)

Les scientifiques utilisent ensuite une variété de méthodes, comme des questionnaires, des tests comportementaux, l'observation et la modélisation pour tester leurs idées. Les sondages sont un outil particulièrement populaire, car les questions peuvent être conçues et vérifiées de manière rigoureuse et atteindre facilement un large éventail de personnes lorsqu'elles sont distribuées en ligne. Les scientifiques analysent ensuite les réponses écrites et tirent un aperçu du comportement humain. En d'autres termes, l'utilisation de la langue par un participant est essentielle pour ces études.

Alors, comment ChatGPT s'intègre-t-il ?

"L'Homo Silicus"

Pour Grossman, les LLM derrière des chatbots tels que ChatGPT ou Google's Bard représentent une opportunité sans précédent de repenser les expériences en sciences sociales.

Parce qu'ils sont formés sur des ensembles de données massifs, les LLM "peuvent représenter un vaste éventail d'expériences et de perspectives humaines", ont déclaré les auteurs. Parce que les modèles "errent" librement sans frontières sur Internet - comme les personnes qui voyagent souvent à l'étranger - ils peuvent adopter et afficher un plus large éventail de réponses par rapport aux sujets humains recrutés.

ChatGPT n'est pas non plus influencé par les autres membres d'une étude ou ne se fatigue pas, ce qui lui permet potentiellement de générer des réponses moins biaisées. Ces caractéristiques peuvent être particulièrement utiles dans les « projets à haut risque », par exemple, imiter les réponses de personnes vivant dans des pays en guerre ou sous des régimes difficiles par le biais de publications sur les réseaux sociaux. À leur tour, les réponses pourraient éclairer les interventions dans le monde réel.

De même, les LLM formés sur des sujets culturels brûlants tels que l'identité de genre ou la désinformation pourraient reproduire différentes écoles de pensée théoriques ou idéologiques pour éclairer les politiques. Plutôt que d'interroger minutieusement des centaines de milliers de participants humains, l'IA peut générer rapidement des réponses basées sur le discours en ligne.

Mis à part les utilisations réelles potentielles, les LLM peuvent également agir comme des sujets numériques qui interagissent avec des participants humains dans des expériences de sciences sociales, quelque peu similaires aux personnages non joueurs (PNJ) dans les jeux vidéo. Par exemple, le LLM pourrait adopter différentes « personnalités » et interagir en ligne avec des volontaires humains du monde entier en utilisant du texte en leur posant la même question. Parce que les algorithmes ne dorment pas, il pourrait fonctionner 24h/7 et XNUMXj/XNUMX. Les données qui en résultent peuvent ensuite aider les scientifiques à explorer comment diverses cultures évaluent des informations similaires et comment les opinions – et la désinformation – se propagent.

Baby Steps

L'idée d'utiliser des chatbots à la place des humains dans les études n'est pas encore courante.

Mais il y a des preuves précoces que cela pourrait fonctionner. UN étude de pré-impression publié ce mois-ci par Georgia Tech, Microsoft Research et Olin College a révélé qu'un LLM reproduisait les réponses humaines dans de nombreuses expériences de psychologie classique, y compris le tristement célèbre Expériences de choc de Milgram.

Pourtant, une question cruciale demeure : dans quelle mesure ces modèles peuvent-ils vraiment capturer la réponse d'un humain ?

Il y a plusieurs pierres d'achoppement.

Le premier est la qualité de l'algorithme et des données d'apprentissage. La plupart des contenus en ligne sont dominés par une poignée de langues seulement. Un LLM formé sur ces données pourrait facilement imiter le sentiment, la perspective ou même le jugement moral des personnes qui utilisent ces langues, héritant à leur tour des biais des données de formation.

"Cette reproduction de biais est une préoccupation majeure car elle pourrait amplifier les disparités mêmes que les spécialistes des sciences sociales s'efforcent de découvrir dans leurs recherches", a déclaré Grossman.

Certains scientifiques craignent également que les LLM ne soient que régurgiter ce qu'on leur dit. C'est l'antithèse d'une étude de sciences sociales, dans laquelle le point principal est de capturer l'humanité dans toute sa beauté diverse et complexe. D'autre part, ChatGPT et des modèles similaires sont connus pour "halluciner», inventant des informations qui semblent plausibles mais qui sont fausses.

Pour l'instant, "les grands modèles de langage s'appuient sur les 'ombres' des expériences humaines", a déclaré Grossman. Parce que ces systèmes d'IA sont en grande partie des boîtes noires, il est difficile de comprendre comment ou pourquoi ils génèrent certaines réponses, ce qui est un peu troublant lorsqu'on les utilise comme proxys humains dans des expériences comportementales.

Malgré les limites, "les LLM permettent aux spécialistes des sciences sociales de rompre avec les méthodes de recherche traditionnelles et d'aborder leur travail de manière innovante", ont déclaré les auteurs. Dans un premier temps, Homo silicus pourrait aider à réfléchir et à tester rapidement des hypothèses, les hypothèses prometteuses étant ensuite validées dans les populations humaines.

Mais pour que les sciences sociales accueillent vraiment l'IA, il faudra de la transparence, de l'équité et un accès égal à ces puissants systèmes. Les LLM sont difficiles et coûteux à former, les modèles récents étant de plus en plus enfermés derrière de lourds murs de paiement.

"Nous devons nous assurer que les LLM en sciences sociales, comme tous les modèles scientifiques, sont open-source, ce qui signifie que leurs algorithmes et, idéalement, leurs données sont accessibles à tous pour être examinés, testés et modifiés", a affirmé Valérie Plante. l'auteur de l'étude, la Dre Dawn Parker de l'Université de Waterloo. "Ce n'est qu'en maintenant la transparence et la reproductibilité que nous pourrons garantir que la recherche en sciences sociales assistée par l'IA contribue réellement à notre compréhension de l'expérience humaine."

Crédit image: Gerd Altmann / Pixabay

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :possède

- :est

- :ne pas

- $UP

- 23

- a

- A Propos

- académique

- accès

- à travers

- Agis

- adopter

- avènement

- AI

- algorithme

- algorithmes

- Tous

- permettre

- Permettre

- déjà

- aussi

- quantités

- an

- il analyse

- ainsi que

- Anthony

- une approche

- SONT

- Arizona

- tableau

- article

- AS

- d'aspect

- aspects

- At

- auteur

- auteurs

- disponibles

- basé

- BE

- Beauté

- car

- était

- humain

- derrière

- va

- croyances

- jusqu'à XNUMX fois

- biais

- biaisé

- Bit

- Noir

- Blocs

- corps

- Bonus

- limites

- tous les deux

- boîtes

- remue-méninges

- branches

- Pause

- mais

- by

- CAN

- capturer

- prudent

- certaines

- Change

- caractères

- Chatbots

- ChatGPT

- conditions

- Climat

- Changement climatique

- collègues

- recueillir

- Université

- commentaires

- Communication

- par rapport

- complexe

- PROBLÈMES DE PEAU

- construire

- contenu

- contribue

- contrôlée

- controversé

- pourriez

- d'exportation

- crédit

- critique

- aspect critique

- à la diversité

- Culture

- Courant

- données

- ensembles de données

- un

- développer

- différent

- difficile

- numérique

- numériquement

- Commande

- distribué

- plusieurs

- Diversité

- do

- Ne fait pas

- Ne pas

- dr

- dessiner

- chacun

- "Early Bird"

- même

- Économie

- énorme

- assurer

- épisode

- égal

- notamment

- évaluer

- Pourtant, la

- Chaque

- exactement

- exemple

- cher

- d'experience

- Expériences

- expériences

- nous a permis de concevoir

- explorez

- justice

- non

- ventilateur

- Fiction

- fidélité

- champ

- Prénom

- s'adapter

- aliments

- Pour

- trouvé

- De

- plus

- jeu

- Games

- Genre

- générer

- État de la Georgie

- obtenez

- Coup d'œil

- globe

- Groupes

- main

- poignée

- Vous avez

- Santé

- Cœur

- vous aider

- HOT

- Comment

- HTML

- http

- HTTPS

- majeur

- humain

- Expérience humaine

- Humanité

- Les êtres humains

- Des centaines

- idée

- idéalement

- et idées cadeaux

- Identite

- if

- Impact

- in

- Dans d'autres

- Y compris

- Améliore

- de plus en plus

- individus

- infâme

- influencé

- informer

- d'information

- technologie innovante

- idées.

- interagir

- développement

- ironie

- IT

- SES

- jpg

- juste

- ACTIVITES

- connu

- langue

- Langues

- gros

- principalement

- moins

- comme

- limites

- Vit

- vie

- LLM

- Entrée

- Courant dominant

- Maintenir

- majeur

- Fabrication

- gestion

- massif

- Mai..

- sens

- Médias

- Membres

- mental

- La santé mentale

- méthodes

- Microsoft

- l'esprit

- esprits

- Désinformation

- modélisation statistique

- numériques jumeaux (digital twin models)

- modifier

- Mois

- moral

- (en fait, presque toutes)

- plusieurs

- must

- my

- naissant

- Besoin

- aucune

- maintenant

- nombreux

- of

- souvent

- on

- ONE

- et, finalement,

- en ligne

- ouvert

- open source

- Opportunités

- or

- Autre

- nos

- participants

- Personnes

- pour cent

- Personnalités

- objectifs

- perspectives

- Platon

- Intelligence des données Platon

- PlatonDonnées

- plausible

- Point

- politiques

- politique

- Populaire

- populations

- Poteaux

- l'éventualité

- solide

- sonde

- important

- prometteur

- preuve

- fournit

- procuration

- Psychologie

- public

- poursuite

- qualité

- question

- fréquemment posées

- gamme

- rapidement

- plutôt

- nous joindre

- monde réel

- vraiment

- récent

- récemment

- reconcevoir

- régimes

- régional

- Les relations

- libéré

- compter

- reste

- éloigné

- remplacé

- reproductibilité

- répliquées

- représentent

- reproduction

- un article

- réponse

- réponses

- résultant

- grossièrement

- Courir

- Saïd

- même

- scénarios

- Écoles

- Sciences

- STARFLEET SCIENCES

- sur une base scientifique

- scientifiques

- sentiment

- set

- plusieurs

- sévère

- montrer

- similaires

- simplement

- situations

- sleep

- Réseaux sociaux

- réseaux sociaux

- Publications sur les réseaux sociaux

- sociétal

- quelque peu

- sophistiqué

- vitesse

- Étoiles

- départs

- étapes

- forces

- s'efforcer

- études

- Étude

- Étudier

- trébuchant

- tel

- Support

- haute

- Système

- Tacles

- Exploiter

- équipe

- technologie

- tester

- tests

- que

- Merci

- qui

- La

- leur

- Les

- puis

- théorique

- Là.

- Ces

- l'ont

- this

- ceux

- bien que?

- pensée

- milliers

- Avec

- fatigué

- à

- outil

- les outils

- Les sujets

- vers

- traditionnel

- Train

- qualifié

- Formation

- Transparence

- Voyage

- troublant

- vraiment

- TOUR

- parapluie

- devoiler

- sous

- comprendre

- compréhension

- université

- sans précédent

- utilisé

- Usages

- en utilisant

- validé

- Plus-value

- Valeurs

- variété

- Vaste

- très

- vérifié

- Vidéo

- jeux vidéo

- Visites

- bénévole

- guerre

- façons

- we

- Météo

- bienvenu

- WELL

- Quoi

- quand

- qui

- WHO

- why

- large

- Large gamme

- plus large

- Wikipédia

- sera

- comprenant

- sans

- des mots

- activités principales

- vos contrats

- s'inquiéter

- code écrit

- Oui

- encore

- Vous n'avez

- Youtube

- Zeitgeist

- zéphyrnet