DeepMind l'a encore fait.

Après avoir résolu un défi fondamental en biologie—prédire la structure des protéines-et démêler les mathématiques de la théorie des nœuds, il vise un processus informatique fondamental intégré à des milliers d'applications quotidiennes. De l'analyse d'images à modélisation météo ou même sonder le fonctionnement interne des réseaux de neurones artificiels, l'IA pourrait théoriquement accélérer les calculs dans une gamme de domaines, augmentant l'efficacité tout en réduisant la consommation d'énergie et les coûts.

Mais le plus impressionnant est how ils l'ont fait. L'algorithme record, baptisé AlphaTensor, est un dérivé de AlphaZero, qui a battu les joueurs humains aux échecs et au go.

"Les algorithmes ont été utilisés dans toutes les civilisations du monde pour effectuer des opérations fondamentales pendant des milliers d'années", écrit co-auteurs Drs. Matej Balog et Alhussein Fawzi chez DeepMind. "Cependant, découvrir des algorithmes est très difficile."

AlphaTensor ouvre la voie à un nouveau monde où l'IA conçoit des programmes qui surpassent tout ce que l'ingénieur humain a conçu, tout en améliorant simultanément son propre "cerveau" de machine.

"Ce travail pousse dans un territoire inexploré en utilisant l'IA pour un problème d'optimisation sur lequel les gens travaillent depuis des décennies... les solutions qu'il trouve peuvent être immédiatement développées pour améliorer les temps d'exécution de calcul", a déclaré le Dr Federico Levi, rédacteur en chef chez Nature, Qui publié l'étude.

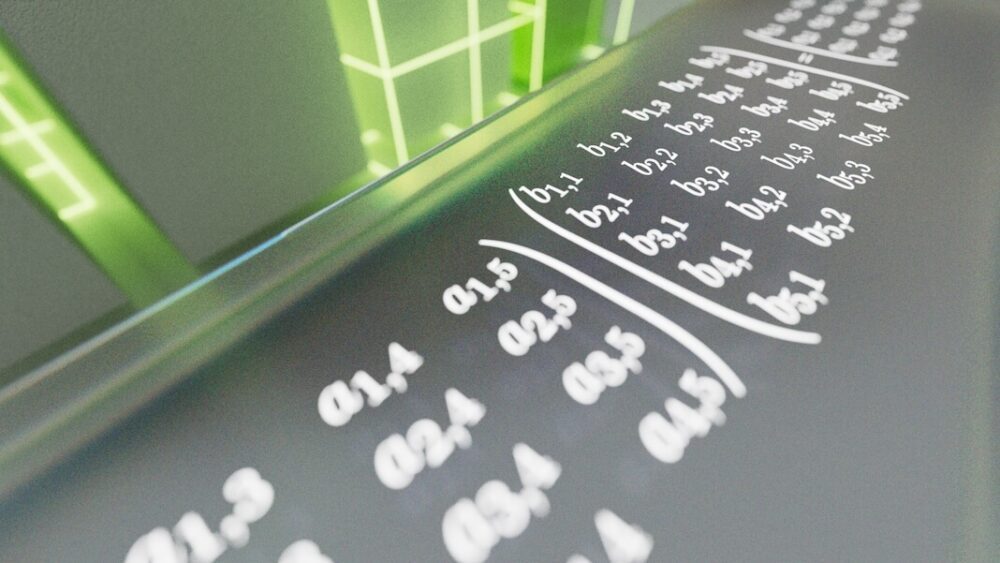

Entrez la multiplication matricielle

Le problème auquel AlphaTensor est confronté est la multiplication matricielle. Si vous envisagez soudainement des rangées et des colonnes de chiffres verts défilant sur votre écran, vous n'êtes pas seul. En gros, une matrice est un peu comme ça - une grille de nombres qui représente numériquement les données de votre choix. Il peut s'agir de pixels dans une image, des fréquences d'un clip audio ou de l'apparence et des actions des personnages dans les jeux vidéo.

La multiplication matricielle prend deux grilles de nombres et se multiplie l'une par l'autre. C'est un calcul souvent enseigné au lycée mais qui est également essentiel pour les systèmes informatiques. Ici, les lignes de nombres d'une matrice sont multipliées par les colonnes d'une autre. Les résultats génèrent un résultat, par exemple, une commande pour zoomer ou incliner votre vue d'une scène de jeu vidéo. Bien que ces calculs fonctionnent sous le capot, toute personne utilisant un téléphone ou un ordinateur dépend de leurs résultats chaque jour.

Vous pouvez voir comment le problème peut devenir extrêmement difficile, extrêmement rapide. La multiplication de grandes matrices demande énormément d'énergie et de temps. Chaque paire de nombres doit être multipliée individuellement pour construire une nouvelle matrice. Au fur et à mesure que les matrices grandissent, le problème devient rapidement intenable, encore plus que de prédire les meilleurs coups d'échecs ou de go. Certains experts estiment qu'il y a plus de façons pour résoudre la multiplication matricielle que le nombre d'atomes dans l'univers.

En 1969, Volker Strassen, un mathématicien allemand, a montré qu'il existait des moyens de couper les coins ronds, en coupant un cycle de multiplication matricielle deux par deux de un total de huit à sept. Cela peut ne pas sembler impressionnant, mais la méthode de Strassen a montré qu'il est possible de battre les normes d'opérations de longue date, c'est-à-dire les algorithmes, pour la multiplication matricielle. Son approche, l'algorithme de Strassen, a régné comme l'approche la plus efficace pendant plus de 50 ans.

Et s'il existait des méthodes encore plus efficaces ? "Personne ne connaît le meilleur algorithme pour le résoudre", a déclaré le Dr François Le Gall de l'Université de Nagoya au Japon, qui n'a pas participé aux travaux. dit MIT Technology Review. "C'est l'un des plus gros problèmes ouverts en informatique."

Algorithmes de poursuite de l'IA

Si l'intuition humaine faiblit, pourquoi ne pas puiser dans un esprit mécanique ?

Dans la nouvelle étude, l'équipe DeepMind a transformé la multiplication matricielle en un jeu. Semblable à son prédécesseur AlphaZero, AlphaTensor utilise l'apprentissage par renforcement profond, une méthode d'apprentissage automatique inspirée de la façon dont les cerveaux biologiques apprennent. Ici, un agent d'IA (souvent un réseau de neurones artificiels) interagit avec son environnement pour résoudre un problème en plusieurs étapes. S'il réussit, il gagne une «récompense», c'est-à-dire que les paramètres réseau de l'IA sont mis à jour afin qu'il soit plus susceptible de réussir à nouveau à l'avenir.

C'est comme apprendre à retourner une crêpe. Beaucoup tomberont initialement sur le sol, mais vos réseaux neuronaux finiront par apprendre les mouvements des bras et des mains pour un retournement parfait.

Le terrain d'entraînement d'AlphaTensor est une sorte de jeu de société en 3D. C'est essentiellement un puzzle à un joueur à peu près similaire au Sudoku. L'IA doit multiplier les grilles de nombres en le moins d'étapes possible, tout en choisissant parmi une myriade de mouvements autorisés - plus d'un billion d'entre eux.

Ces mouvements autorisés ont été méticuleusement conçus dans AlphaTensor. Lors d'un point de presse, le co-auteur, le Dr Hussain Fawzi, a expliqué : "Formuler l'espace de la découverte algorithmique est très complexe... encore plus difficile, comment pouvons-nous naviguer dans cet espace."

En d'autres termes, face à un éventail époustouflant d'options, comment pouvons-nous les réduire pour améliorer nos chances de trouver l'aiguille dans la botte de foin ? Et comment pouvons-nous élaborer au mieux une stratégie pour atteindre l'aiguille sans creuser dans toute la botte de foin ?

Une astuce que l'équipe a intégrée à AlphaTensor est une méthode appelée recherche arborescente. Plutôt que, métaphoriquement parlant, de creuser au hasard dans la botte de foin, ici l'IA sonde les «routes» qui pourraient conduire à un meilleur résultat. Les apprentissages intermédiaires aident ensuite l'IA à planifier son prochain mouvement pour augmenter les chances de succès. L'équipe a également montré des exemples d'algorithmes de jeux réussis, comme enseigner à un enfant les premiers mouvements d'échecs. Enfin, une fois que l'IA a découvert des mouvements utiles, l'équipe lui a permis de réorganiser ces opérations pour un apprentissage plus personnalisé à la recherche d'un meilleur résultat.

Une nouvelle ère d'innovation

AlphaTensor a bien joué. Dans une série de tests, l'équipe a mis l'IA au défi de trouver les solutions les plus efficaces pour les matrices jusqu'à cinq par cinq, c'est-à-dire avec cinq nombres chacun dans une ligne ou une colonne.

L'algorithme a rapidement redécouvert le hack original de Strassen, mais a ensuite dépassé toutes les solutions précédemment conçues par l'esprit humain. En testant l'IA avec différentes tailles de matrices, AlphaTensor a trouvé des solutions plus efficaces pour plus de 70. "En fait, AlphaTensor découvre généralement des milliers d'algorithmes pour chaque taille de matrice", a déclaré l'équipe. "C'est ahurissant."

Dans un cas, en multipliant une matrice cinq par cinq par une matrice quatre par cinq, l'IA a réduit le record précédent de 80 multiplications individuelles à seulement 76. Elle a également brillé sur des matrices plus grandes, réduisant le nombre de calculs nécessaires pour deux matrices onze par onze de 919 à 896.

La preuve de concept en main, l'équipe s'est tournée vers l'utilisation pratique. Les puces informatiques sont souvent conçues pour optimiser différents calculs - les GPU pour les graphiques, par exemple, ou Puces d'IA pour l'apprentissage automatique— et faire correspondre un algorithme avec le matériel le mieux adapté augmente l'efficacité.

Ici, l'équipe a utilisé AlphaTensor pour trouver des algorithmes pour deux puces populaires dans l'apprentissage automatique : le GPU NVIDIA V100 et Google TPU. Au total, les algorithmes développés par l'IA ont augmenté la vitesse de calcul jusqu'à 20 %.

Il est difficile de dire si l'IA peut également accélérer les smartphones, les ordinateurs portables ou d'autres appareils du quotidien. Cependant, "ce développement serait très excitant s'il pouvait être utilisé dans la pratique", a déclaré le Dr Virginia Williams du MIT. "Une augmentation des performances améliorerait de nombreuses applications."

L'esprit d'une IA

Bien qu'AlphaTensor ait battu le dernier record humain de multiplication matricielle, l'équipe DeepMind ne peut pas encore expliquer pourquoi.

"Il a cette incroyable intuition en jouant à ces jeux", a déclaré le scientifique et co-auteur de DeepMind, le Dr Pushmeet Kohli, lors d'un point de presse.

Les algorithmes en évolution ne doivent pas non plus être l'homme contre les machines.

Bien qu'AlphaTensor soit un tremplin vers des algorithmes plus rapides, des algorithmes encore plus rapides pourraient exister. "Parce qu'il doit restreindre sa recherche à des algorithmes d'une forme spécifique, il pourrait manquer d'autres types d'algorithmes qui pourraient être plus efficaces", ont écrit Balog et Fawzi.

Peut-être qu'un chemin encore plus intrigant combinerait l'intuition humaine et machine. "Ce serait bien de savoir si cette nouvelle méthode subsume réellement toutes les précédentes, ou si vous pouvez les combiner et obtenir quelque chose d'encore mieux", a affirmé Valérie Plante. Williams. D'autres experts sont d'accord. Avec une multitude d'algorithmes à leur disposition, les scientifiques peuvent commencer à les disséquer pour trouver des indices sur ce qui a fait fonctionner les solutions d'AlphaTensor, ouvrant la voie à la prochaine percée.

Crédit d'image: DeepMind