Toile Amazon SageMaker prend désormais en charge le déploiement de modèles d'apprentissage automatique (ML) sur des points de terminaison d'inférence en temps réel, vous permettant de mettre vos modèles de ML en production et de piloter des actions basées sur des informations basées sur le ML. SageMaker Canvas est un espace de travail sans code qui permet aux analystes et aux data scientists citoyens de générer des prédictions de ML précises pour leurs besoins commerciaux.

Jusqu'à présent, SageMaker Canvas offrait la possibilité d'évaluer un modèle ML, de générer des prédictions groupées et d'exécuter des analyses de simulation dans son espace de travail interactif. Mais vous pouvez désormais également déployer les modèles sur les points de terminaison Amazon SageMaker pour une inférence en temps réel, ce qui facilite l'utilisation des prédictions de modèles et la conduite d'actions en dehors de l'espace de travail SageMaker Canvas. La possibilité de déployer directement des modèles ML à partir de SageMaker Canvas élimine le besoin d'exporter, de configurer, de tester et de déployer manuellement des modèles ML en production, ce qui permet de réduire la complexité et de gagner du temps. Cela rend également l’opérationnalisation des modèles ML plus accessible aux individus, sans qu’il soit nécessaire d’écrire du code.

Dans cet article, nous vous expliquons le processus pour déployer un modèle dans SageMaker Canvas à un point de terminaison en temps réel.

Présentation de la solution

Pour notre cas d'utilisation, nous assumons le rôle d'un utilisateur professionnel dans le service marketing d'un opérateur de téléphonie mobile et nous avons réussi à créer un modèle ML dans SageMaker Canvas pour identifier les clients présentant un risque potentiel de désabonnement. Grâce aux prédictions générées par notre modèle, nous souhaitons désormais passer cela de notre environnement de développement à la production. Pour rationaliser le processus de déploiement de notre point de terminaison de modèle pour l'inférence, nous déployons directement des modèles ML à partir de SageMaker Canvas, éliminant ainsi le besoin d'exporter, de configurer, de tester et de déployer manuellement des modèles ML en production. Cela permet de réduire la complexité, de gagner du temps et de rendre également la mise en œuvre des modèles ML plus accessible aux individus, sans avoir besoin d'écrire du code.

Les étapes du flux de travail sont les suivantes :

- Téléchargez un nouvel ensemble de données avec la population de clients actuelle dans SageMaker Canvas. Pour la liste complète des sources de données prises en charge, reportez-vous à Importer des données dans Canvas.

- Créez des modèles ML et analysez leurs mesures de performances. Pour obtenir des instructions, reportez-vous à Créer un modèle personnalisé et les Évaluez les performances de votre modèle dans Amazon SageMaker Canvas.

- Déployer la version de modèle approuvée comme point final pour l’inférence en temps réel.

Vous pouvez effectuer ces étapes dans SageMaker Canvas sans écrire une seule ligne de code.

Pré-requis

Pour cette procédure pas à pas, assurez-vous que les conditions préalables suivantes sont remplies :

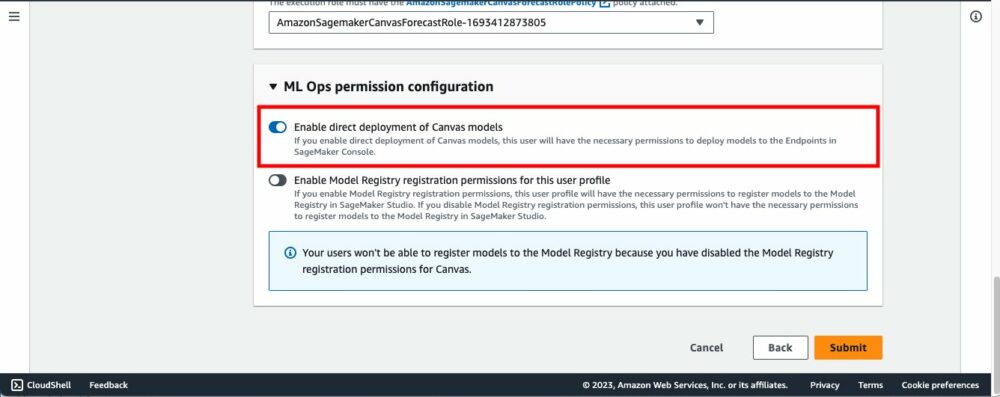

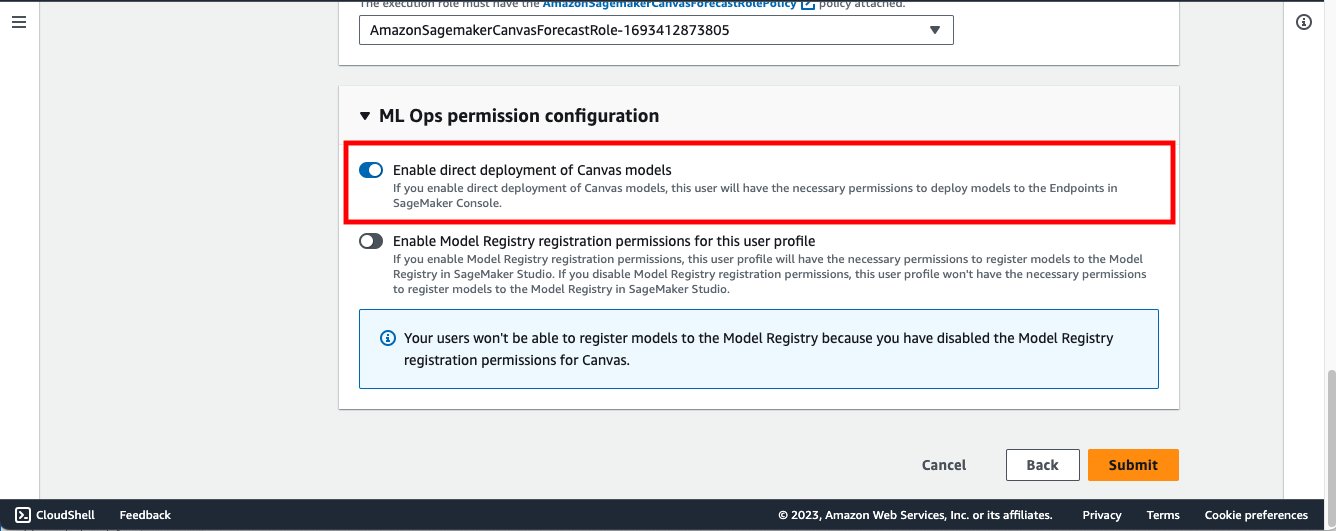

- Pour déployer des versions de modèle sur les points de terminaison SageMaker, l'administrateur de SageMaker Canvas doit accorder les autorisations nécessaires à l'utilisateur de SageMaker Canvas, que vous pouvez gérer dans le domaine SageMaker qui héberge votre application SageMaker Canvas. Pour plus d'informations, reportez-vous à Gestion des autorisations dans Canvas.

- Mettre en œuvre les prérequis mentionnés dans Prévoyez l'attrition des clients grâce à l'apprentissage automatique sans code à l'aide d'Amazon SageMaker Canvas.

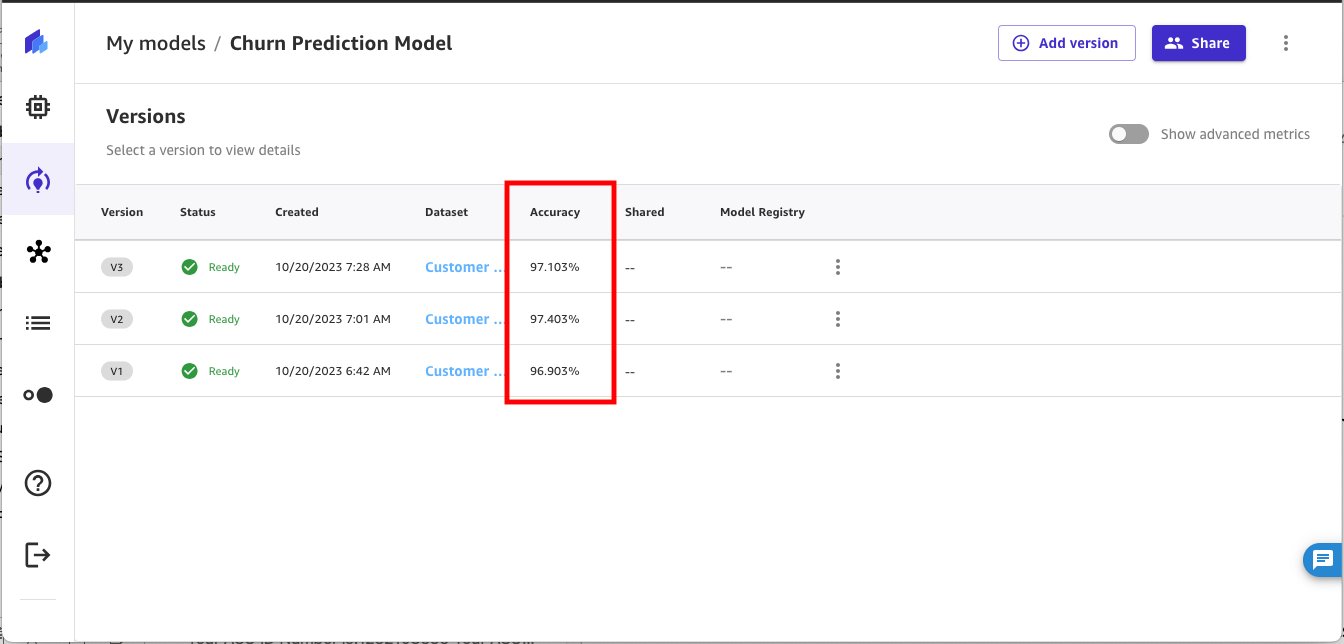

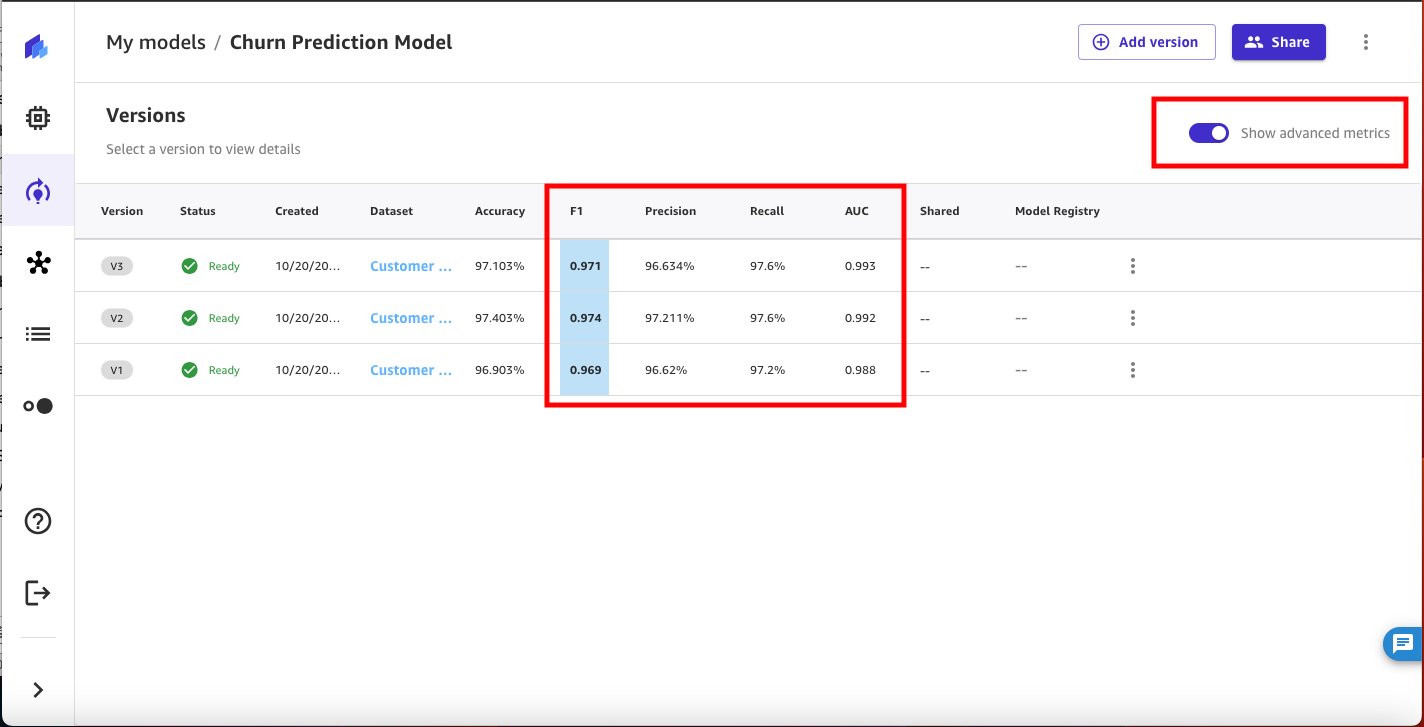

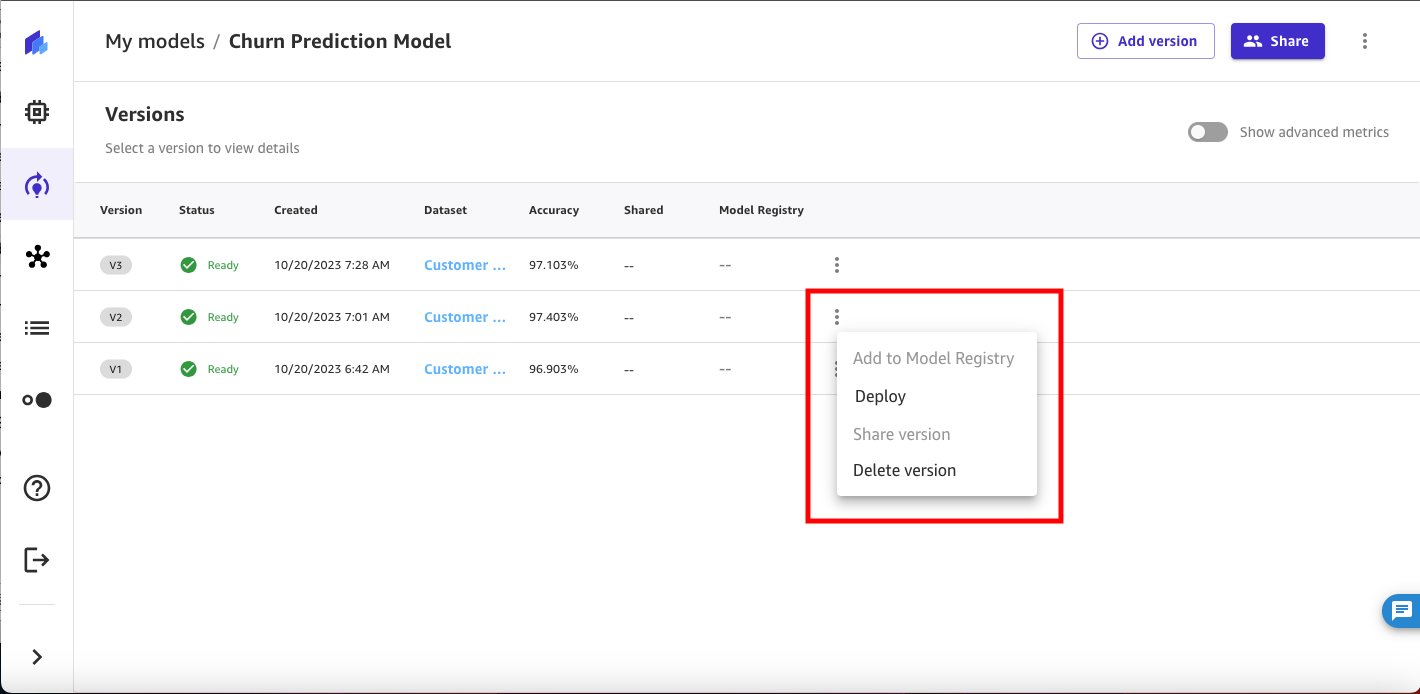

Vous devriez maintenant avoir trois versions de modèle entraînées sur les données historiques de prédiction de l'attrition dans Canvas :

- V1 formé avec les 21 fonctionnalités et une configuration de construction rapide avec un score de modèle de 96.903 %

- V2 formé avec les 19 fonctionnalités (fonctionnalités de téléphone et d'état supprimées) et configuration de construction rapide et précision améliorée de 97.403 %

- V3 formé avec une configuration de construction standard avec un score de modèle de 97.103 %

Utiliser le modèle de prédiction de l'attrition client

Activer Afficher les métriques avancées sur la page de détails du modèle et examinez les métriques objectives associées à chaque version du modèle afin de pouvoir sélectionner le modèle le plus performant à déployer sur SageMaker en tant que point de terminaison.

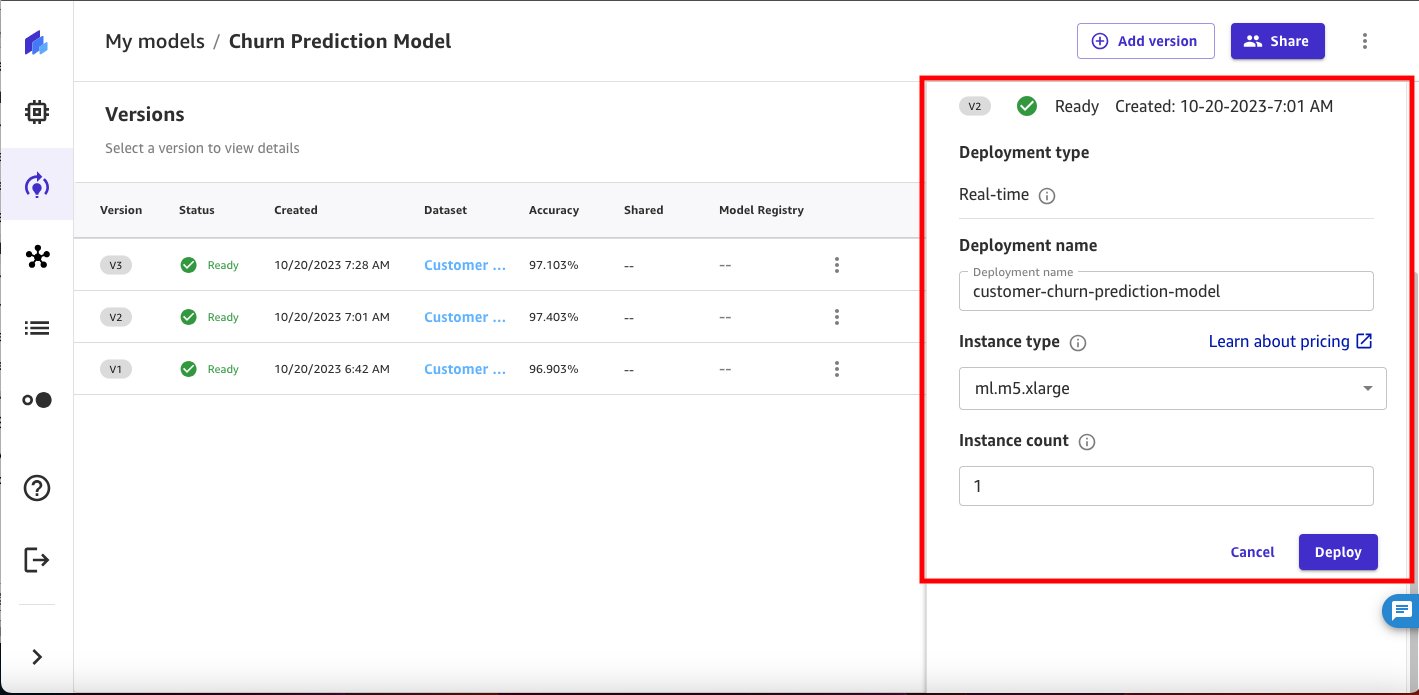

Sur la base des mesures de performances, nous sélectionnons la version 2 à déployer.

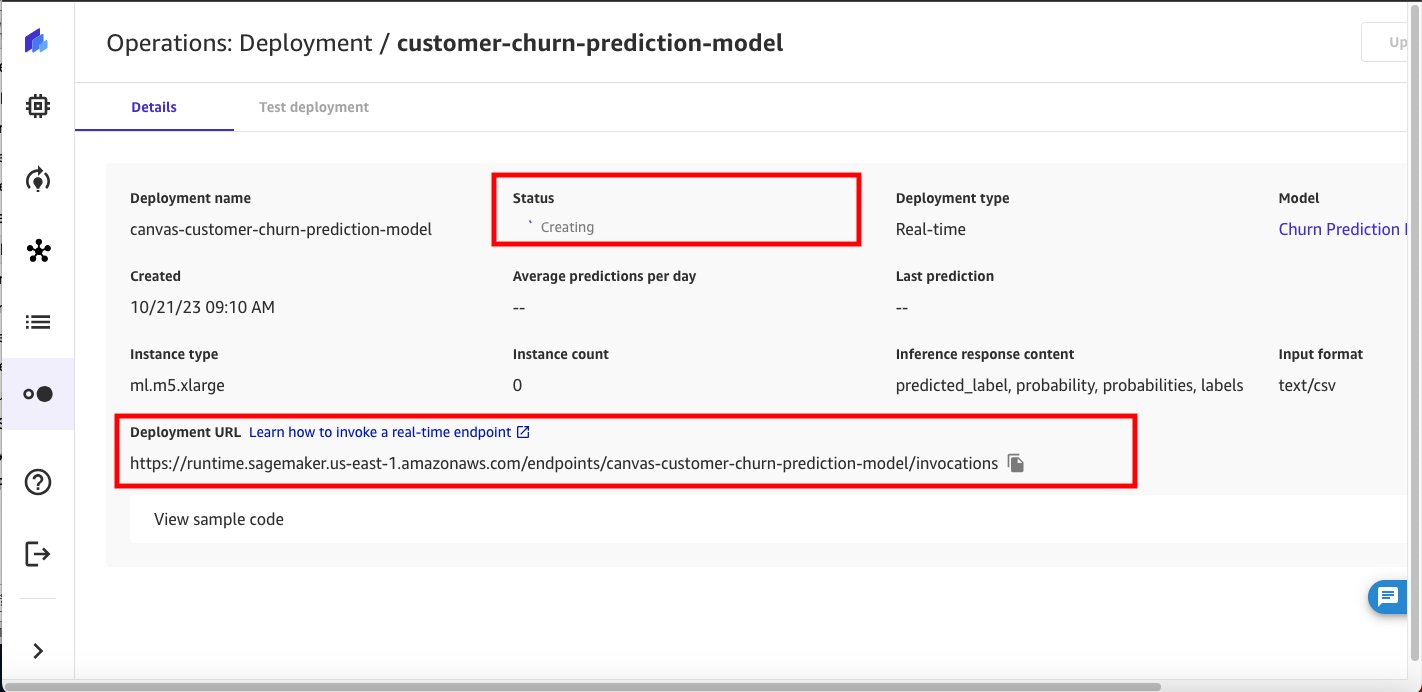

Configurez les paramètres de déploiement du modèle : nom du déploiement, type d'instance et nombre d'instances.

Comme point de départ, Canvas recommandera automatiquement le meilleur type d'instance et le nombre d'instances pour le déploiement de votre modèle. Vous pouvez le modifier en fonction des besoins de votre charge de travail.

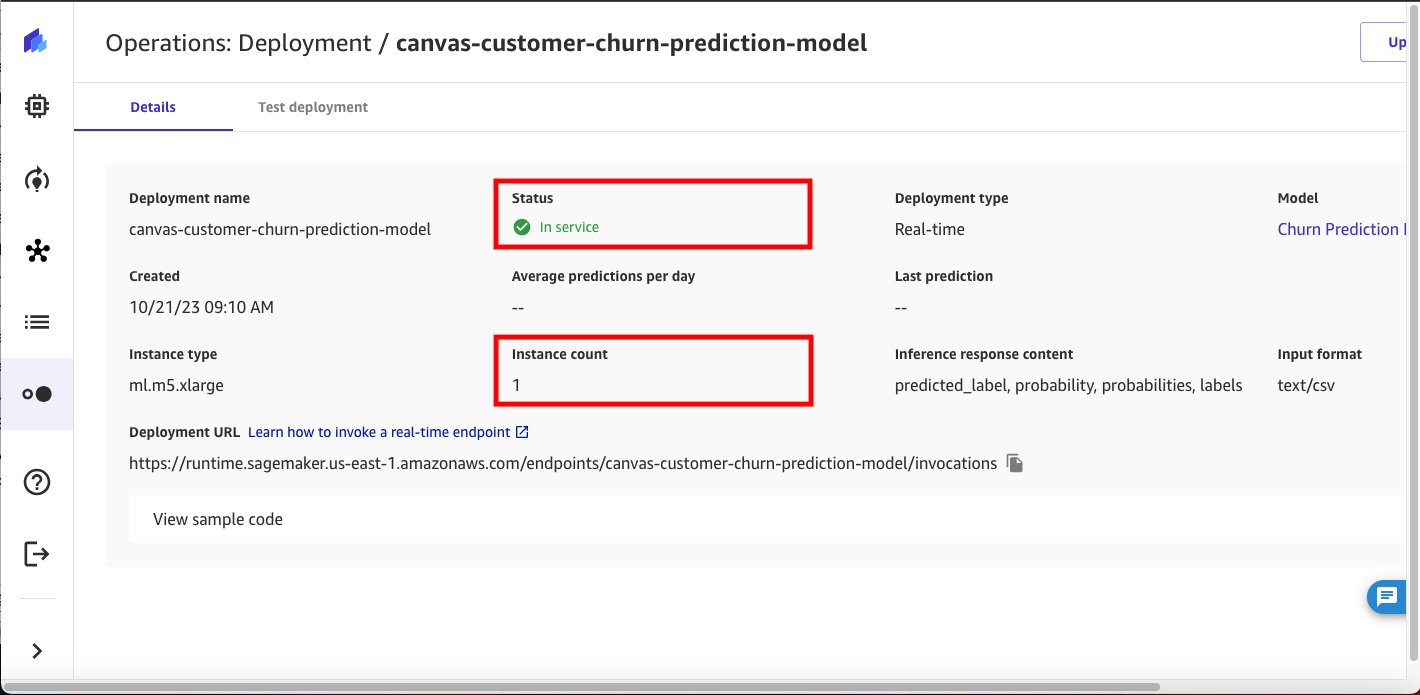

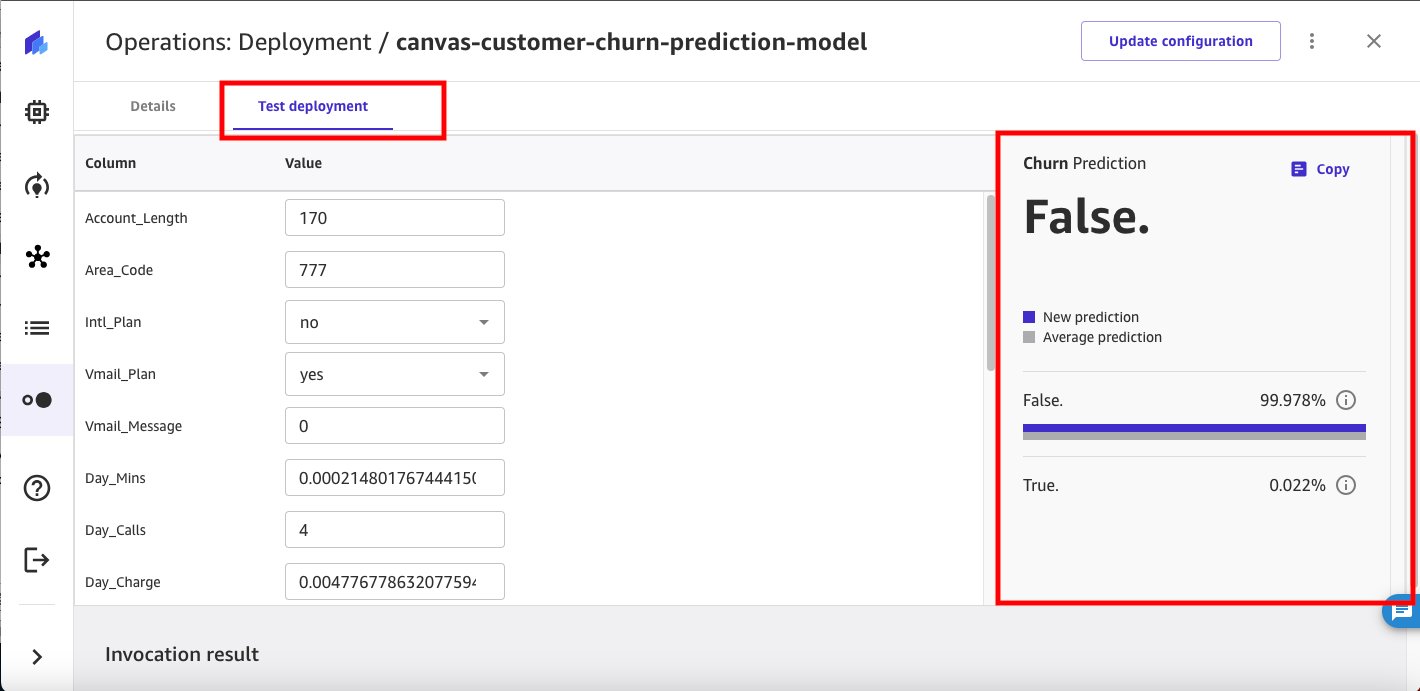

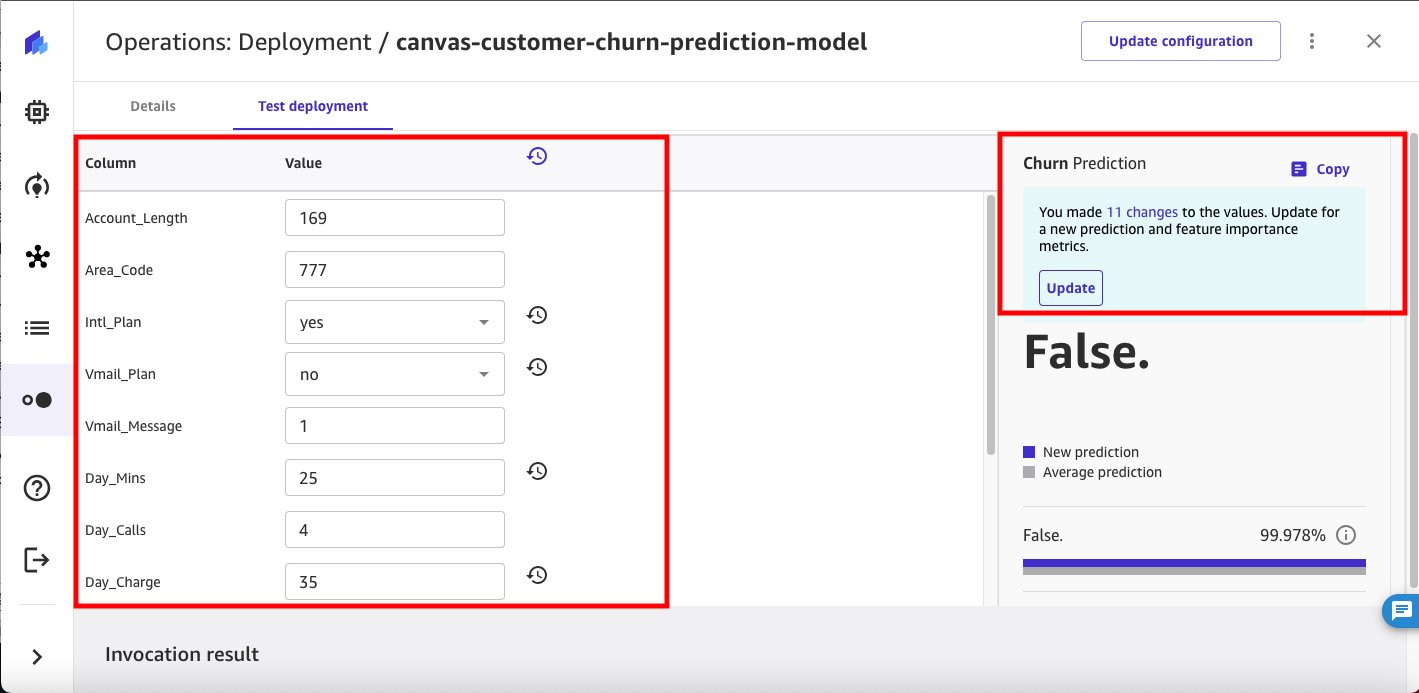

Vous pouvez tester le point de terminaison d’inférence SageMaker déployé directement depuis SageMaker Canvas.

Vous pouvez modifier les valeurs d'entrée à l'aide de l'interface utilisateur de SageMaker Canvas pour déduire une prédiction de désabonnement supplémentaire.

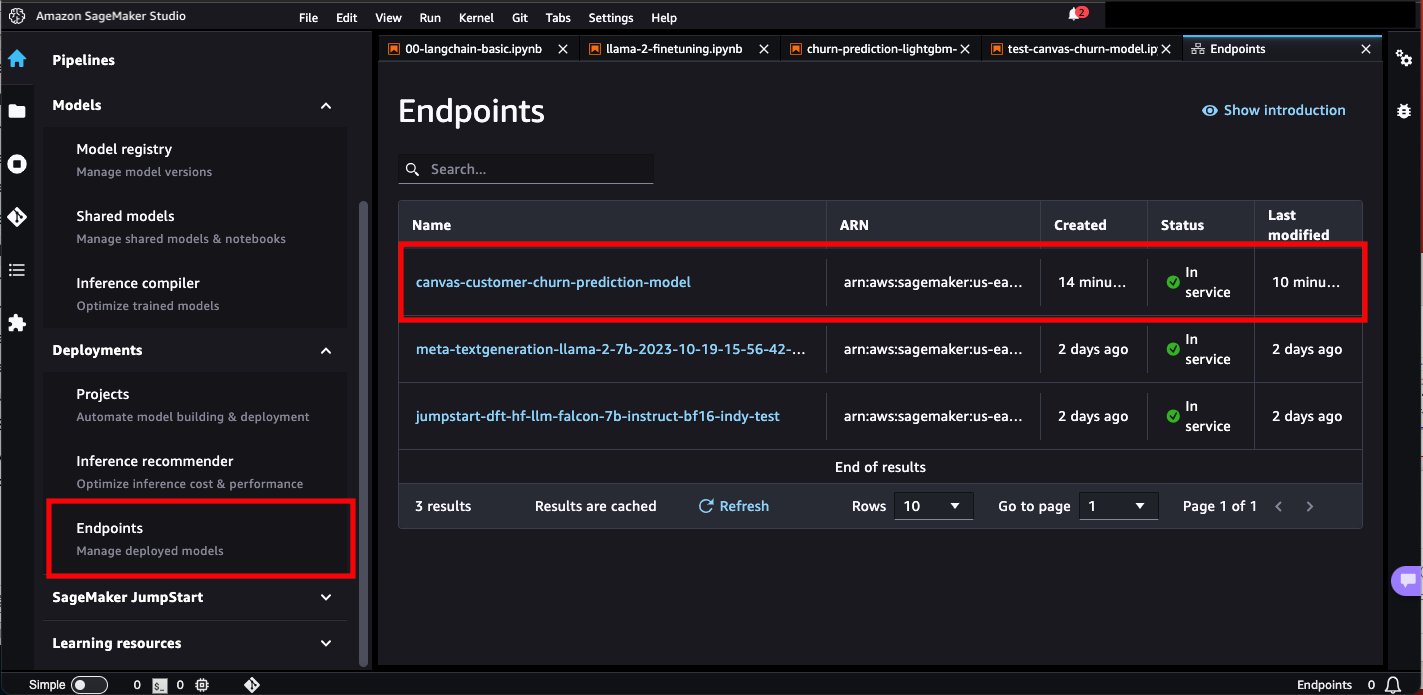

Naviguons maintenant vers Amazon SageMakerStudio et vérifiez le point de terminaison déployé.

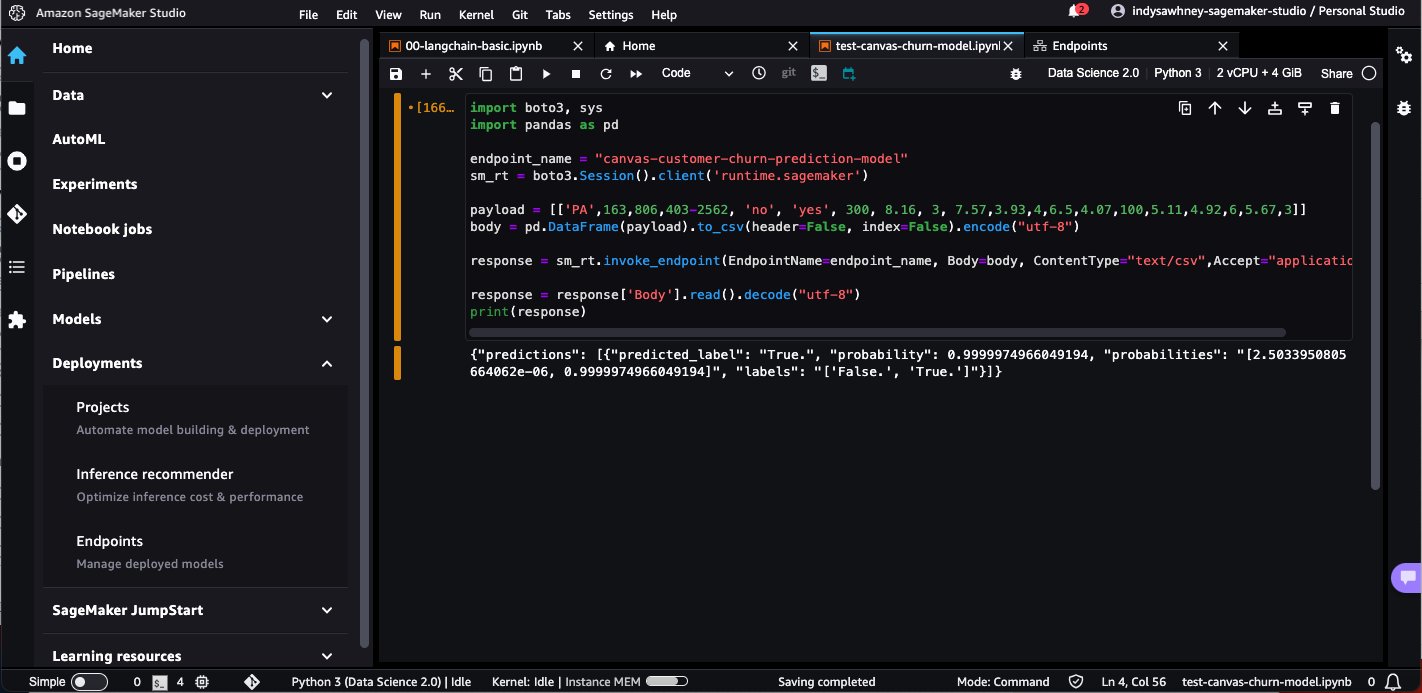

Ouvrez un bloc-notes dans SageMaker Studio et exécutez le code suivant pour déduire le point de terminaison du modèle déployé. Remplacez le nom du point de terminaison du modèle par votre propre nom de point de terminaison du modèle.

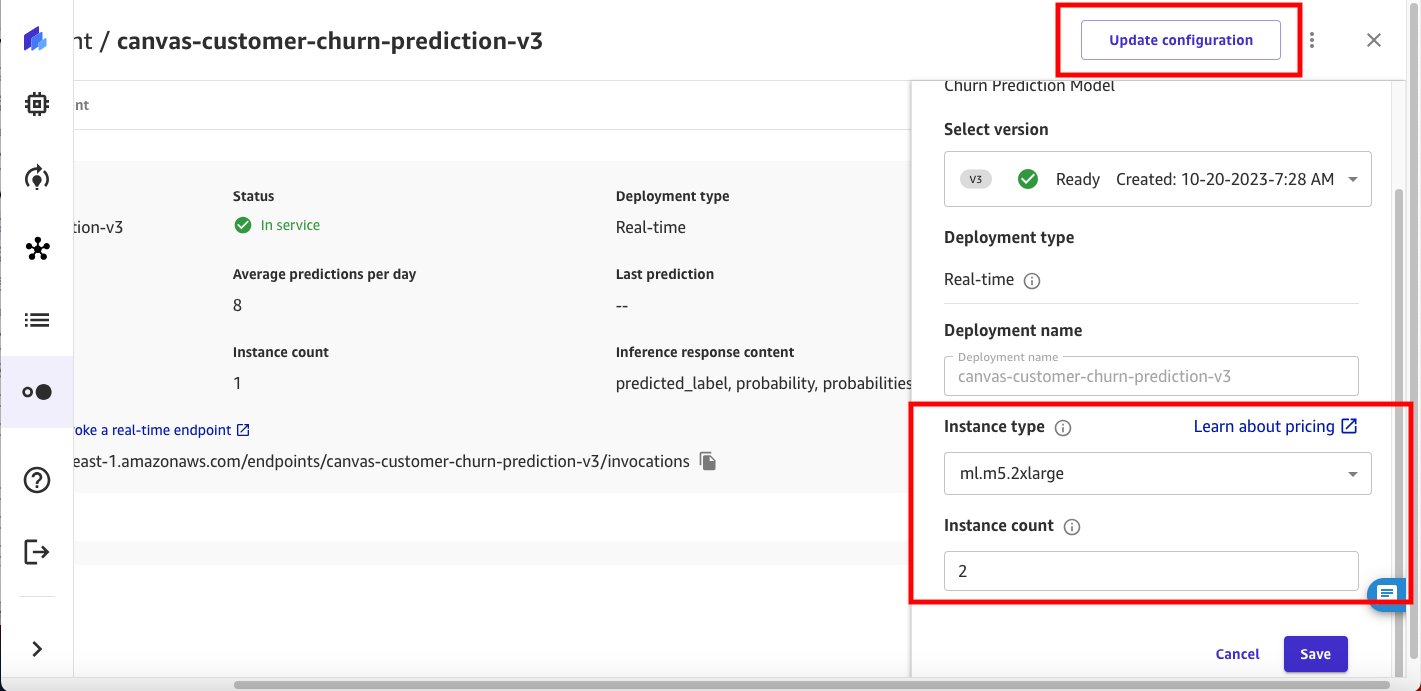

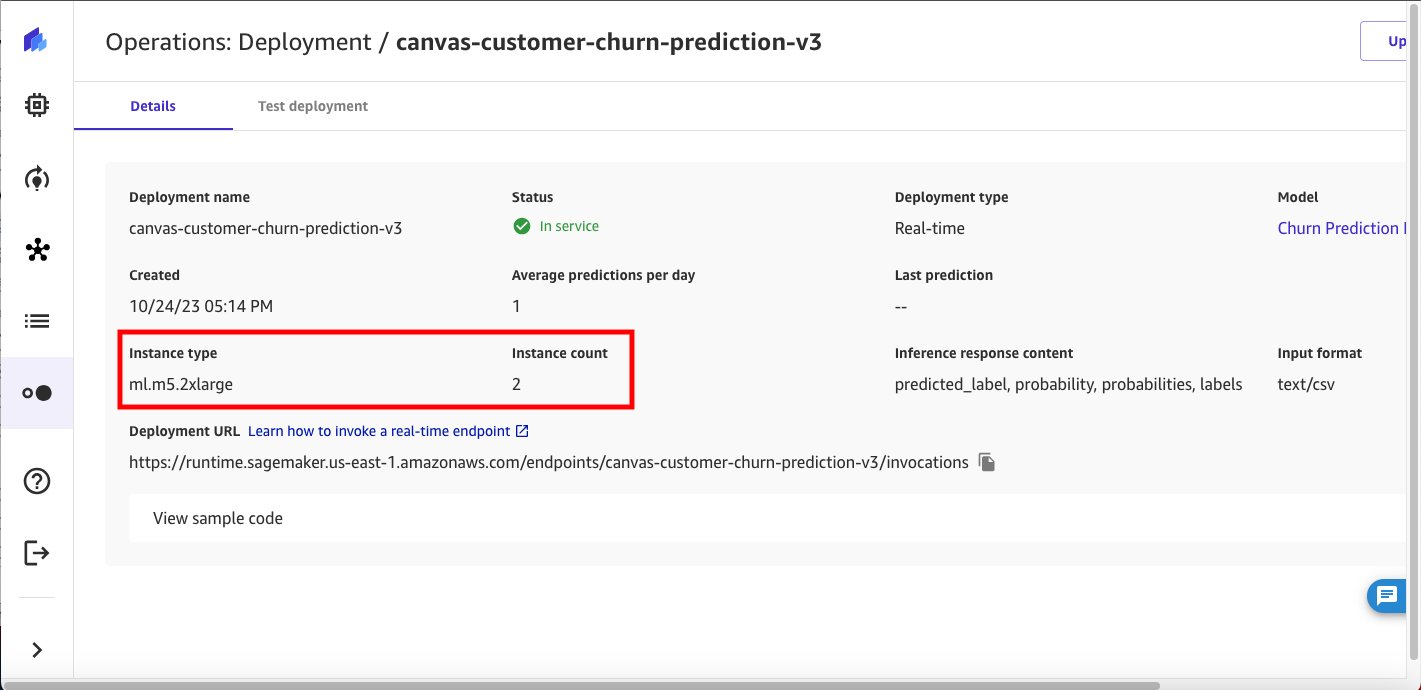

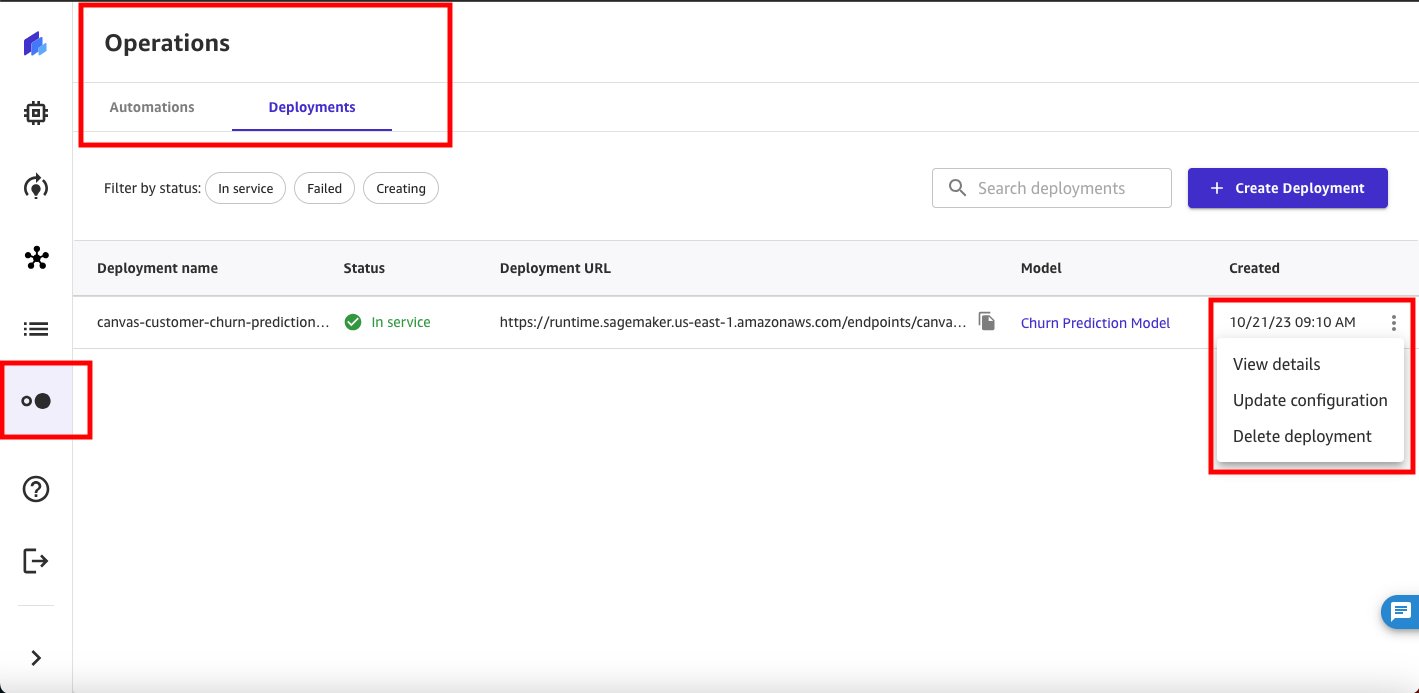

Notre point de terminaison de modèle d'origine utilise une instance ml.m5.xlarge et 1 nombre d'instances. Supposons maintenant que vous vous attendiez à ce que le nombre d’utilisateurs finaux déduisant le point de terminaison de votre modèle augmente et que vous souhaitiez allouer davantage de capacité de calcul. Vous pouvez accomplir cela directement depuis SageMaker Canvas en choisissant Mettre à jour la configuration.

Nettoyer

Pour éviter d'encourir des frais futurs, supprimez les ressources que vous avez créées en suivant cette publication. Cela inclut la déconnexion de SageMaker Canvas et suppression du point de terminaison SageMaker déployé. SageMaker Canvas vous facture la durée de la session et nous vous recommandons de vous déconnecter de SageMaker Canvas lorsque vous ne l'utilisez pas. Faire référence à Déconnexion d'Amazon SageMaker Canvas pour plus de détails.

Conclusion

Dans cet article, nous avons expliqué comment SageMaker Canvas peut déployer des modèles ML sur des points de terminaison d'inférence en temps réel, vous permettant ainsi de mettre vos modèles ML en production et de piloter des actions basées sur des informations basées sur le ML. Dans notre exemple, nous avons montré comment un analyste peut rapidement créer un modèle de ML prédictif très précis sans écrire de code, le déployer sur SageMaker en tant que point de terminaison et tester le point de terminaison du modèle à partir de SageMaker Canvas, ainsi qu'à partir d'un notebook SageMaker Studio.

Pour commencer votre parcours ML low-code/no-code, reportez-vous à Toile Amazon SageMaker.

Un merci spécial à tous ceux qui ont contribué au lancement : Prashanth Kurumaddali, Abishek Kumar, Allen Liu, Sean Lester, Richa Sundrani et Alicia Qi.

À propos des auteurs

Janisha Anand est chef de produit senior au sein de l'équipe Amazon SageMaker Low/No Code ML, qui comprend SageMaker Canvas et SageMaker Autopilot. Elle aime le café, rester active et passer du temps avec sa famille.

Janisha Anand est chef de produit senior au sein de l'équipe Amazon SageMaker Low/No Code ML, qui comprend SageMaker Canvas et SageMaker Autopilot. Elle aime le café, rester active et passer du temps avec sa famille.

Indy Sawhney est un leader senior des solutions clients chez Amazon Web Services. Travaillant toujours à rebours des problèmes des clients, Indy conseille les dirigeants des entreprises clientes AWS tout au long de leur parcours unique de transformation du cloud. Il a plus de 25 ans d’expérience dans l’aide aux entreprises pour adopter des technologies et des solutions commerciales émergentes. Indy est un spécialiste en profondeur de la communauté technique de terrain d'AWS pour l'IA/ML, avec une spécialisation dans l'IA générative et les solutions Amazon SageMaker low-code/no-code.

Indy Sawhney est un leader senior des solutions clients chez Amazon Web Services. Travaillant toujours à rebours des problèmes des clients, Indy conseille les dirigeants des entreprises clientes AWS tout au long de leur parcours unique de transformation du cloud. Il a plus de 25 ans d’expérience dans l’aide aux entreprises pour adopter des technologies et des solutions commerciales émergentes. Indy est un spécialiste en profondeur de la communauté technique de terrain d'AWS pour l'IA/ML, avec une spécialisation dans l'IA générative et les solutions Amazon SageMaker low-code/no-code.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/deploy-ml-models-built-in-amazon-sagemaker-canvas-to-amazon-sagemaker-real-time-endpoints/

- :possède

- :est

- :ne pas

- 07

- 1

- 100

- 11

- 16

- 19

- 25

- 67

- 7

- 8

- 97

- a

- capacité

- accessible

- accomplir

- précision

- Avec cette connaissance vient le pouvoir de prendre

- Action

- actes

- infection

- Supplémentaire

- admin

- adopter

- Avancée

- AI

- AI / ML

- Tous

- allen

- Permettre

- aussi

- toujours

- Amazon

- Amazon Sage Maker

- Toile Amazon SageMaker

- Amazon Web Services

- an

- Analyses

- analyste

- Analystes

- il analyse

- et les

- tous

- Application

- ,

- SONT

- Réservé

- AS

- associé

- assumer

- automatiquement

- éviter

- AWS

- basé

- BE

- LES MEILLEURS

- Billets

- corps

- construire

- construit

- la performance des entreprises

- mais

- by

- CAN

- la toile

- Compétences

- maisons

- Change

- des charges

- vérifier

- choose

- citoyen

- le cloud

- code

- Café

- Communautés

- complexité

- calcul

- configuration

- consommer

- contribué

- créée

- Courant

- Customiser

- des clients

- Solutions clients

- Clients

- données

- Département

- déployer

- déployé

- déployer

- déploiement

- profondeur

- détails

- Développement

- directement

- discuté

- domaine

- motivation

- durée

- chacun

- sans effort

- élimine

- l'élimination

- économies émergentes.

- les technologies émergentes

- permet

- Endpoint

- Entreprise

- Environment

- évaluer

- tout le monde

- exemple

- cadres

- attendre

- d'experience

- Exporter

- famille

- Fonctionnalités:

- champ

- Abonnement

- suit

- Pour

- De

- plein

- avenir

- générer

- généré

- génératif

- IA générative

- Donner

- Vous avez

- ayant

- he

- aider

- aide

- ici

- très

- historique

- hôtes

- Comment

- HTML

- HTTPS

- identifier

- importer

- amélioré

- in

- inclut

- Améliore

- individus

- d'information

- contribution

- idées.

- instance

- Des instructions

- Interactif

- Interfaces

- développement

- IT

- SES

- chemin

- jpg

- kumar

- lancer

- leader

- apprentissage

- Gamme

- Liste

- enregistrement

- click

- machine learning

- a prendre une

- FAIT DU

- Fabrication

- gérer

- gestion

- manager

- manuellement

- Stratégie

- mentionné

- la ficelle d'étiquettes/étiquettes volantes en carton

- Métrique

- ML

- Breeze Mobile

- téléphone mobile

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- Bougez

- must

- prénom

- NAVIGUER

- nécessaire

- Besoin

- Besoins

- Nouveauté

- aucune

- cahier

- maintenant

- nombre

- objectif

- of

- on

- opérateur

- organisations

- original

- nos

- ande

- au contrôle

- plus de

- propre

- page

- pandas

- /

- Effectuer

- performant

- autorisations

- Téléphone

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- population

- Post

- défaillances

- prédiction

- Prédictions

- conditions préalables

- d'ouvrabilité

- processus

- Produit

- chef de produit

- Vidéo

- à condition de

- disposition

- Qi

- Rapide

- vite.

- en temps réel

- recommander

- réduire

- réduire

- reportez-vous

- Supprimé

- remplacer

- Resources

- réponse

- Avis

- Analyse

- Rôle

- Courir

- sagemaker

- Inférence SageMaker

- économie

- scientifiques

- But

- Sean

- supérieur

- Services

- Session

- elle

- devrait

- montré

- unique

- So

- Solutions

- Sources

- spécialiste

- Dépenses

- Standard

- Commencer

- Commencez

- Région

- rester

- Étapes

- rationaliser

- studio

- Avec succès

- Appareils

- Les soutiens

- sûr

- SYS

- Prenez

- équipe

- Technique

- Les technologies

- tester

- Merci

- qui

- Le

- leur

- ainsi

- Ces

- this

- trois

- Avec

- fiable

- à

- qualifié

- De La Carrosserie

- type

- expérience unique et authentique

- utilisé

- cas d'utilisation

- Utilisateur

- Interface utilisateur

- en utilisant

- Valeurs

- version

- versions

- marcher

- walkthrough

- souhaitez

- we

- web

- services Web

- WELL

- quand

- qui

- tout en

- WHO

- sera

- comprenant

- dans les

- sans

- workflow

- de travail

- écrire

- écrire du code

- écriture

- années

- Oui

- Vous n'avez

- Votre

- zéphyrnet