Aujourd'hui, nous sommes ravis d'annoncer la possibilité d'affiner les modèles Llama 2 par Meta en utilisant Amazon SageMaker JumpStart. La famille Llama 2 de grands modèles de langage (LLM) est une collection de modèles de texte génératifs pré-entraînés et affinés dont l'échelle varie de 7 milliards à 70 milliards de paramètres. Les LLM affinés, appelés Llama-2-chat, sont optimisés pour les cas d'utilisation de dialogue. Vous pouvez facilement essayer ces modèles et les utiliser avec SageMaker JumpStart, qui est un hub d'apprentissage automatique (ML) qui donne accès à des algorithmes, des modèles et des solutions ML afin que vous puissiez rapidement démarrer avec le ML. Vous pouvez désormais également affiner les modèles de génération de texte Llama 7 de 13 milliards, 70 milliards et 2 milliards de paramètres sur SageMaker JumpStart à l'aide de l'outil Amazon SageMakerStudio UI en quelques clics ou en utilisant le SDK SageMaker Python.

Les modèles de base de l’IA générative sont au centre de la plupart des recherches et des cas d’utilisation du ML et de l’intelligence artificielle depuis plus d’un an maintenant. Ces modèles de base fonctionnent très bien avec les tâches génératives, telles que la génération de texte, le résumé, la réponse aux questions, la génération d'images et de vidéos, etc., en raison de leur grande taille et également parce qu'ils sont formés sur plusieurs grands ensembles de données et des centaines de tâches. Malgré les grandes capacités de généralisation de ces modèles, il existe souvent des cas d'utilisation comportant des données de domaine très spécifiques (comme les soins de santé ou les services financiers), c'est pourquoi ces modèles peuvent ne pas être en mesure de fournir de bons résultats pour ces cas d'utilisation. Il en résulte la nécessité d’affiner davantage ces modèles d’IA génératifs sur les données spécifiques au cas d’utilisation et au domaine.

Dans cet article, nous expliquons comment affiner les modèles de génération de texte pré-entraînés de Llama 2 via SageMaker JumpStart.

Qu'est-ce que le lama 2

Llama 2 est un modèle de langage auto-régressif qui utilise une architecture de transformateur optimisée. Llama 2 est destiné à un usage commercial et de recherche en anglais. Il est disponible dans une gamme de tailles de paramètres - 7 milliards, 13 milliards et 70 milliards - ainsi que des variations pré-formées et affinées. Selon Meta, les versions optimisées utilisent un réglage fin supervisé (SFT) et un apprentissage par renforcement avec rétroaction humaine (RLHF) pour s'aligner sur les préférences humaines en matière d'utilité et de sécurité. Llama 2 a été pré-formé sur 2 billions de jetons de données provenant de sources accessibles au public. Les modèles optimisés sont destinés au chat de type assistant, tandis que les modèles pré-formés peuvent être adaptés à une variété de tâches de génération de langage naturel. Quelle que soit la version du modèle utilisée par un développeur, la guide d'utilisation responsable de Meta peut aider à guider les ajustements supplémentaires qui peuvent être nécessaires pour personnaliser et optimiser les modèles avec des mesures d'atténuation de sécurité appropriées.

Actuellement, Llama 2 est disponible dans les régions suivantes :

- Déployer le modèle pré-entraîné disponible :

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Affinez et déployez le modèle affiné :

“us-east-1”,“us-west-2”,“eu-west-1”

Qu'est-ce que SageMaker JumpStart

Avec SageMaker JumpStart, les praticiens du ML peuvent choisir parmi une large sélection de modèles de fondation accessibles au public. Les praticiens du ML peuvent déployer des modèles de base sur des sites dédiés. Amazon Sage Maker instances à partir d'un environnement isolé en réseau et personnalisez les modèles à l'aide de SageMaker pour la formation et le déploiement des modèles. Vous pouvez désormais découvrir et déployer Llama 2 en quelques clics dans SageMaker Studio ou par programmation via le SDK SageMaker Python, vous permettant de dériver les performances du modèle et les contrôles MLOps avec les fonctionnalités de SageMaker telles que Pipelines Amazon SageMaker, Débogueur Amazon SageMakerou les journaux de conteneur. Le modèle est déployé dans un environnement sécurisé AWS et sous les contrôles de votre VPC, contribuant ainsi à garantir la sécurité des données. De plus, vous pouvez affiner les modèles de génération de texte pré-entraînés Llama2 7B, 13B et 70B via SageMaker JumpStart.

Affiner les modèles Llama2

Vous pouvez affiner les modèles à l'aide de l'interface utilisateur de SageMaker Studio ou du SDK SageMaker Python. Nous discutons des deux méthodes dans cette section.

Ajustement sans code via l'interface utilisateur de SageMaker Studio

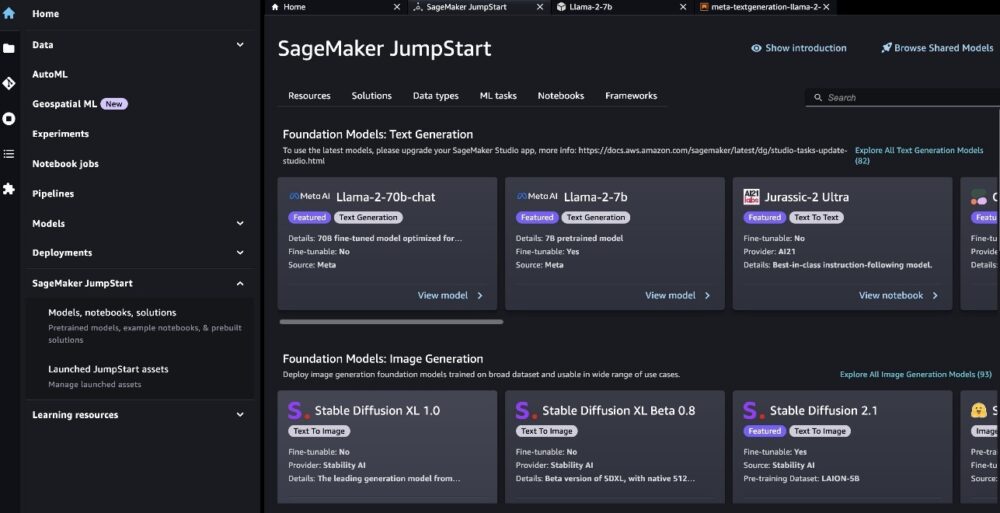

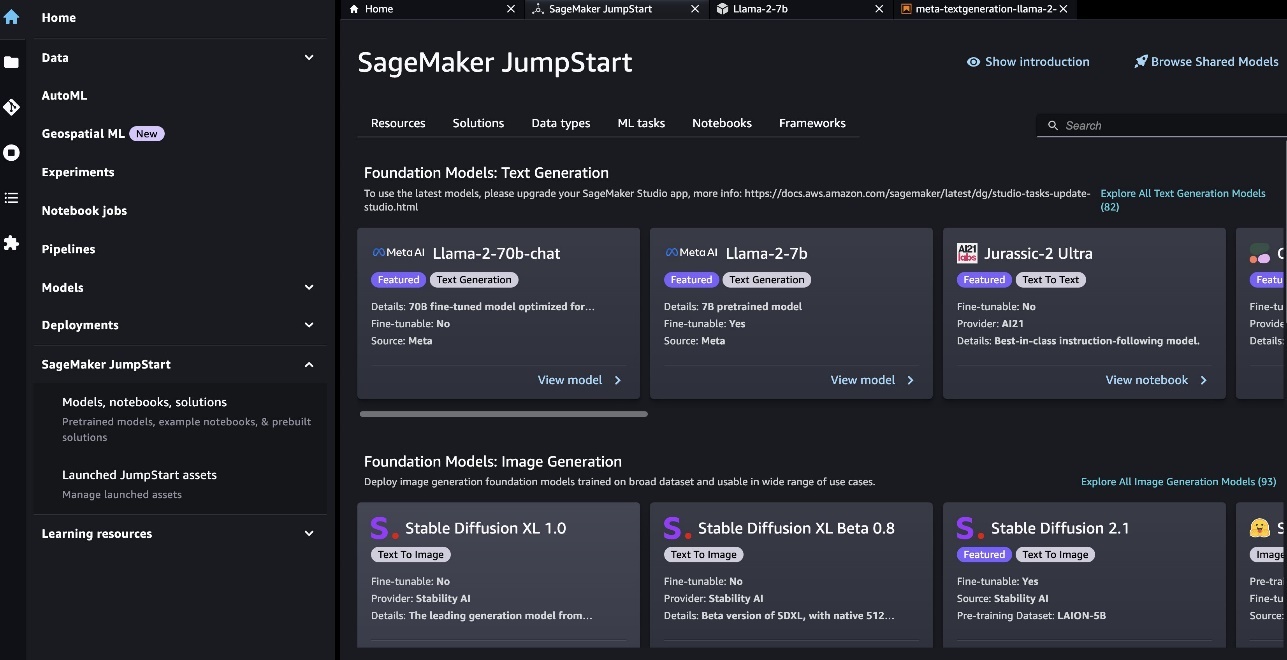

Dans SageMaker Studio, vous pouvez accéder aux modèles Llama 2 via SageMaker JumpStart sous Modèles, cahiers et solutions, comme illustré dans la capture d'écran suivante.

Si vous ne voyez pas les modèles Llama 2, mettez à jour votre version de SageMaker Studio en arrêtant et en redémarrant. Pour plus d'informations sur les mises à jour de version, reportez-vous à Arrêter et mettre à jour les applications Studio.

Vous pouvez également trouver quatre autres variantes de modèle en choisissant Explorer tous les modèles de génération de texte ou en recherchant Lama dans le champ de recherche.

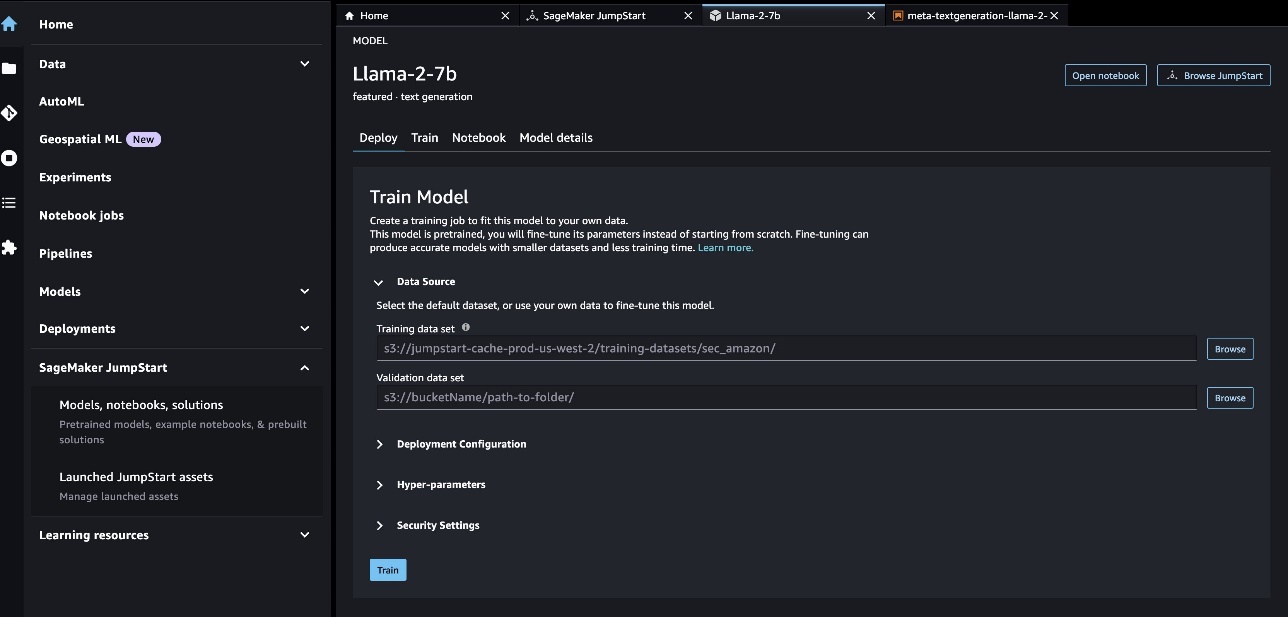

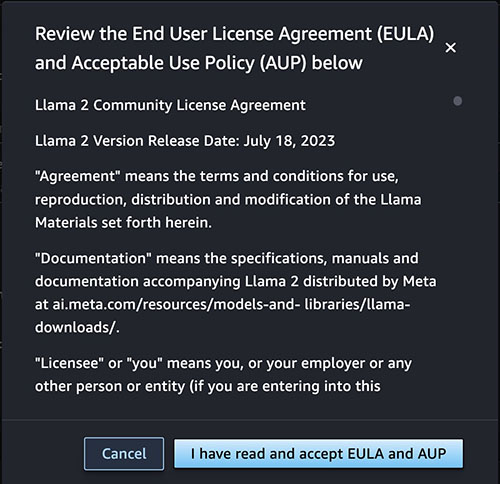

Sur cette page, vous pouvez pointer vers le Service de stockage simple Amazon (Amazon S3) contenant les ensembles de données de formation et de validation pour un réglage précis. De plus, vous pouvez configurer la configuration du déploiement, les hyperparamètres et les paramètres de sécurité pour un réglage précis. Vous pourrez alors choisir Train pour démarrer la tâche de formation sur une instance SageMaker ML. La capture d'écran précédente montre la page de réglage fin du modèle Llama-2 7B ; cependant, vous pouvez affiner les modèles de génération de texte 13B et 70B Llama 2 en utilisant leurs pages de modèles respectives de la même manière. Pour utiliser les modèles Llama 2, vous devez accepter le contrat de licence utilisateur final (CLUF). Il apparaîtra lorsque vous choisirez Train, comme le montre la capture d'écran suivante. Choisir J'ai lu et accepté le CLUF et l'AUP pour commencer le travail de mise au point.

Déployer le modèle

Une fois le modèle affiné, vous pouvez le déployer à l'aide de la page de modèle sur SageMaker JumpStart. L'option permettant de déployer le modèle affiné apparaîtra une fois le réglage fin terminé, comme le montre la capture d'écran suivante.

Affiner via le SDK SageMaker Python

Vous pouvez également affiner les modèles Llama 2 à l'aide du SDK SageMaker Python. Voici un exemple de code pour affiner le Llama 2 7B sur votre ensemble de données :

Vous pouvez déployer le modèle affiné directement à partir de l'estimateur :

Vous pouvez également trouver le code dans Affiner les modèles LLaMA 2 sur SageMaker JumpStart. Cela comprend la préparation de l'ensemble de données, la formation sur votre ensemble de données personnalisé et le déploiement du modèle affiné. Il démontre le réglage fin d'un sous-ensemble de l'ensemble de données Dolly avec des exemples tirés de la tâche de synthèse. Voici un exemple d'entrée avec des réponses affinées et non affinées ainsi que la réponse de vérité terrain :

Entrée dans le modèle :

Réponse de Ground Truth :

Réponse du modèle non affiné :

Réponse du modèle affiné :

Pour une analyse comparative des performances de différents modèles sur l'ensemble de données Dolly et Dialogsum, reportez-vous au Analyse comparative des performances section en annexe à la fin de cet article.

Technique de mise au point

Les modèles linguistiques tels que Llama ont une taille supérieure à 10 Go, voire 100 Go. Le réglage fin de modèles aussi volumineux nécessite des instances dotées d'une mémoire CUDA considérablement élevée. De plus, la formation de ces modèles peut être très lente en raison de la taille du modèle. Par conséquent, pour un réglage fin efficace, nous utilisons les optimisations suivantes :

- Adaptation de bas rang (LoRA) – Il s’agit d’un type de réglage fin efficace des paramètres (PEFT) pour un réglage fin efficace des grands modèles. En cela, nous gelons l'ensemble du modèle et ajoutons uniquement un petit ensemble de paramètres ou de couches réglables dans le modèle. Par exemple, au lieu d'entraîner les 7 milliards de paramètres pour Llama 2 7B, nous pouvons affiner moins de 1 % des paramètres. Cela contribue à une réduction significative des besoins en mémoire, car nous n'avons besoin de stocker les gradients, les états de l'optimiseur et d'autres informations liées à la formation que pour 1 % des paramètres. De plus, cela contribue à réduire le temps de formation ainsi que le coût. Pour plus de détails sur cette méthode, reportez-vous à LoRA : Adaptation de bas niveau de grands modèles de langage.

- Quantification Int8 – Même avec des optimisations telles que LoRA, des modèles tels que Llama 70B sont encore trop gros pour être entraînés. Pour diminuer l'empreinte mémoire pendant l'entraînement, nous pouvons utiliser la quantification Int8 pendant l'entraînement. La quantification réduit généralement la précision des types de données à virgule flottante. Bien que cela diminue la mémoire requise pour stocker les poids du modèle, cela dégrade les performances en raison de la perte d'informations. La quantification Int8 n'utilise qu'un quart de précision mais n'entraîne pas de dégradation des performances car elle ne supprime pas simplement les bits. Il arrondit les données d'un type à l'autre. Pour en savoir plus sur la quantification Int8, reportez-vous à LLM.int8() : multiplication matricielle 8 bits pour les transformateurs à grande échelle.

- Parallèle de données entièrement partagées (FSDP) – Il s'agit d'un type d'algorithme de formation parallèle aux données qui répartit les paramètres du modèle entre les travailleurs parallèles aux données et peut éventuellement décharger une partie du calcul de formation vers les processeurs. Bien que les paramètres soient répartis sur différents GPU, le calcul de chaque microbatch est local pour le processeur GPU. Il partage les paramètres de manière plus uniforme et obtient des performances optimisées grâce au chevauchement des communications et des calculs pendant l'entraînement.

Le tableau suivant compare différentes méthodes avec les trois modèles Llama 2.

| , | Type d'instance par défaut | Types d'instances pris en charge avec configuration par défaut | Paramètres par défaut | LORA + FSDP | LORA + Pas de FSDP | Quantification Int8 + LORA + Pas de FSDP |

| Lama 2 7B | ml.g5.12xlarge | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Oui | Oui | Oui |

| Lama 2 13B | ml.g5.12xlarge | ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Oui | Oui | Oui |

| Lama 2 70B | ml.g5.48xlarge | ml.g5.48xlarge | INT8 + LORA + PAS DE FSDP | Non | Non | Oui |

Notez que le réglage fin des modèles Llama est basé sur les scripts fournis par les éléments suivants GitHub repo.

Format de l'ensemble de données d'entraînement

SageMaker JumpStart prend actuellement en charge les ensembles de données au format d'adaptation de domaine et au format de réglage des instructions. Dans cette section, nous spécifions un exemple d'ensemble de données dans les deux formats. Pour plus de détails, reportez-vous au Formatage de l'ensemble de données section en annexe.

Format d'adaptation de domaine

Le modèle de génération de texte Llama 2 peut être affiné sur n'importe quel ensemble de données spécifique à un domaine. Une fois affiné sur l'ensemble de données spécifique au domaine, le modèle devrait générer du texte spécifique au domaine et résoudre diverses tâches PNL dans ce domaine spécifique avec quelques invites. Avec cet ensemble de données, l'entrée consiste en un fichier CSV, JSON ou TXT. Par exemple, les données d'entrée peuvent être des dépôts SEC d'Amazon sous forme de fichier texte :

Format de réglage des instructions

Lors du réglage fin des instructions, le modèle est affiné pour un ensemble de tâches de traitement du langage naturel (NLP) décrites à l'aide d'instructions. Cela permet d'améliorer les performances du modèle pour les tâches invisibles avec des invites zéro tir. Au format d'ensemble de données de réglage d'instructions, vous spécifiez le template.json fichier décrivant les formats d’entrée et de sortie. Par exemple, chaque ligne du fichier train.jsonl ressemble à ce qui suit:

Le fichier supplémentaire template.json ressemble à ce qui suit:

Hyperparamètres pris en charge pour la formation

Le réglage fin de Llama 2 prend en charge un certain nombre d'hyperparamètres, dont chacun peut avoir un impact sur les besoins en mémoire, la vitesse d'entraînement et les performances du modèle affiné :

- époque – Le nombre de passages effectués par l'algorithme de réglage fin dans l'ensemble de données d'entraînement. Doit être un entier supérieur à 1. La valeur par défaut est 5.

- taux d'apprentissage – La fréquence à laquelle les pondérations du modèle sont mises à jour après avoir parcouru chaque lot d'exemples de formation. Doit être un flottant positif supérieur à 0. La valeur par défaut est 1e-4.

- instruction_tuned – S’il faut ou non former le modèle à l’instruction. Doit être '

True' ou 'False'. La valeur par défaut est 'False'. - par_device_train_batch_size – La taille du lot par cœur GPU/CPU pour la formation. Doit être un entier positif. La valeur par défaut est 4.

- per_device_eval_batch_size – La taille du lot par cœur GPU/CPU pour évaluation. Doit être un entier positif. La valeur par défaut est 1.

- max_train_samples – À des fins de débogage ou de formation plus rapide, tronquez le nombre d'exemples de formation à cette valeur. La valeur -1 signifie utiliser tous les échantillons d’apprentissage. Doit être un entier positif ou -1. La valeur par défaut est -1.

- max_val_samples – À des fins de débogage ou de formation plus rapide, tronquez le nombre d'exemples de validation à cette valeur. La valeur -1 signifie utiliser tous les échantillons de validation. Doit être un entier positif ou -1. La valeur par défaut est -1.

- max_input_length – Longueur totale maximale de la séquence d’entrée après la tokenisation. Les séquences plus longues seront tronquées. Si -1,

max_input_lengthest défini sur le minimum de 1024 et la longueur maximale du modèle définie par le tokenizer. S'il est défini sur une valeur positive,max_input_lengthest réglé au minimum de la valeur fournie et lemodel_max_lengthdéfini par le tokenizer. Doit être un entier positif ou -1. La valeur par défaut est -1. - validation_split_ratio – Si le canal de validation est

none, le rapport entre la validation du train et les données du train doit être compris entre 0 et 1. La valeur par défaut est 0.2. - train_data_split_seed – Si les données de validation ne sont pas présentes, cela corrige la répartition aléatoire des données de formation d'entrée en données de formation et de validation utilisées par l'algorithme. Doit être un entier. La valeur par défaut est 0.

- prétraitement_num_workers – Le nombre de processus à utiliser pour le prétraitement. Si

None, le processus principal est utilisé pour le prétraitement. La valeur par défaut estNone. - lora_r – Lora R. Doit être un entier positif. La valeur par défaut est 8.

- lora_alpha -Lora Alpha. Doit être un entier positif. La valeur par défaut est 32

- lora_dropout – Lora Abandon. doit être un flottant positif compris entre 0 et 1. La valeur par défaut est 0.05.

- int8_quantisation - Si

True, le modèle est chargé avec une précision de 8 bits pour l'entraînement. La valeur par défaut pour 7B et 13B estFalse. La valeur par défaut pour 70B estTrue. - activer_fsdp - Si

True, la formation utilise FSDP. La valeur par défaut pour 7B et 13B estTrue. La valeur par défaut pour 70B estFalse. Noter queint8_quantizationn’est pas pris en charge avec FSDP.

Types d'instances et hyperparamètres compatibles

Les besoins en mémoire lors du réglage fin peuvent varier en fonction de plusieurs facteurs :

- Type de modèle – Le modèle 7B a le moins besoin de mémoire GPU et le 70B a le plus grand besoin de mémoire.

- Longueur d'entrée maximale – Une valeur plus élevée de la longueur d’entrée conduit à traiter plus de jetons à la fois et nécessite donc plus de mémoire CUDA

- Taille du lot – Une taille de lot plus grande nécessite une mémoire CUDA plus grande et nécessite donc des types d'instances plus grands

- Quantification Int8 – Si vous utilisez la quantification Int8, le modèle est chargé en basse précision et nécessite donc moins de mémoire CUDA

Pour vous aider à démarrer, nous proposons un ensemble de combinaisons de différents types d'instances, hyperparamètres et types de modèles qui peuvent être affinés avec succès. Vous pouvez sélectionner une configuration en fonction de vos besoins et de la disponibilité des types d'instances. Nous affinons les trois modèles sur une variété de paramètres avec trois époques sur un sous-ensemble de l'ensemble de données Dolly avec des exemples de synthèse.

modèle 7B

Le tableau suivant résume les options de réglage fin sur le modèle 7B.

| Type d'instance | Objectif d'entrée maximum | Taille du lot par appareil | Quantification Int8 | Activer FSDP | Temps pris (minutes) |

| ml.g4dn.12xlarge | 1024 | 8 | VRAI | FAUX | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | VRAI | FAUX | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | FAUX | VRAI | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | FAUX | VRAI | 143 |

| ml.g5.2xlarge | 1024 | 4 | VRAI | FAUX | 61 |

| ml.g5.2xlarge | 2048 | 2 | VRAI | FAUX | 68 |

| ml.g5.2xlarge | 1024 | 4 | FAUX | VRAI | 43 |

| ml.g5.2xlarge | 2048 | 2 | FAUX | VRAI | 49 |

| ml.g5.4xlarge | 1024 | 4 | FAUX | VRAI | 39 |

| ml.g5.4xlarge | 2048 | 2 | FAUX | VRAI | 50 |

| ml.g5.12xlarge | 1024 | 16 | VRAI | FAUX | 57 |

| ml.g5.12xlarge | 2048 | 4 | VRAI | FAUX | 64 |

| ml.g5.12xlarge | 1024 | 4 | FAUX | VRAI | 26 |

| ml.g5.12xlarge | 2048 | 4 | FAUX | VRAI | 23 |

| ml.g5.48xlarge | 1024 | 16 | VRAI | FAUX | 59 |

| ml.g5.48xlarge | 2048 | 4 | VRAI | FAUX | 67 |

| ml.g5.48xlarge | 1024 | 8 | FAUX | VRAI | 22 |

| ml.g5.48xlarge | 2048 | 4 | FAUX | VRAI | 21 |

13M

Le tableau suivant résume les options de réglage fin sur le modèle 13B.

| Type d'instance | Objectif d'entrée maximum | Taille du lot par appareil | Quantification Int8 | Activer FSDP | Temps pris (minutes) |

| ml.g4dn.12xlarge | 1024 | 4 | VRAI | FAUX | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | VRAI | FAUX | 328 |

| ml.g5.12xlarge | 1024 | 8 | VRAI | FAUX | 92 |

| ml.g5.12xlarge | 2048 | 4 | VRAI | FAUX | 104 |

| ml.g5.48xlarge | 1024 | 8 | VRAI | FAUX | 95 |

| ml.g5.48xlarge | 2048 | 4 | VRAI | FAUX | 107 |

| ml.g5.48xlarge | 1024 | 8 | FAUX | VRAI | 35 |

| ml.g5.48xlarge | 2048 | 2 | FAUX | VRAI | 41 |

70M

Le tableau suivant résume les options de réglage fin sur le modèle 70B.

| Type d'instance | Objectif d'entrée maximum | Taille du lot par appareil | Quantification Int8 | Activer FSDP | Temps pris (minutes) |

| ml.g5.48xlarge | 1024 | 4 | VRAI | FAUX | 396 |

| ml.g5.48xlarge | 2048 | 1 | VRAI | FAUX | 454 |

Recommandations sur les types d'instances et les hyperparamètres

Lorsque vous ajustez la précision du modèle, gardez à l’esprit les points suivants :

- Les modèles plus grands tels que le 70B offrent de meilleures performances que le 7B

- Les performances sans quantification Int8 sont meilleures que les performances avec quantification INT8

Notez le temps de formation suivant et les exigences de mémoire CUDA :

- Paramètres

int8_quantization=Truediminue les besoins en mémoire et conduit à un entraînement plus rapide. - Réduction

per_device_train_batch_sizeainsi quemax_input_lengthréduit les besoins en mémoire et peut donc être exécuté sur des instances plus petites. Cependant, définir des valeurs très basses peut augmenter le temps d'entraînement. - Si vous n'utilisez pas la quantification Int8 (

int8_quantization=False), utilisez FSDP (enable_fsdp=True) pour une formation plus rapide et efficace.

Lorsque vous choisissez le type d'instance, tenez compte des éléments suivants :

- Les instances G5 offrent la formation la plus efficace parmi les types d'instances pris en charge. Par conséquent, si vous disposez d’instances G5, vous devez les utiliser.

- Le temps de formation dépend en grande partie du nombre de GPU et de la mémoire CUDA disponible. Par conséquent, la formation sur des instances avec le même nombre de GPU (par exemple, ml.g5.2xlarge et ml.g5.4xlarge) est à peu près la même. Par conséquent, vous pouvez utiliser l'instance la moins chère pour la formation (ml.g5.2xlarge).

- Lors de l'utilisation d'instances p3, la formation sera effectuée avec une précision de 32 bits car bfloat16 n'est pas pris en charge sur ces instances. Par conséquent, la tâche de formation consommera le double de la quantité de mémoire CUDA lors de la formation sur des instances p3 par rapport aux instances g5.

Pour en savoir plus sur le coût de la formation par instance, reportez-vous à Instances Amazon EC2 G5.

Si l'ensemble de données est au format de réglage d'instructions et que les séquences d'entrée + d'achèvement sont petites (par exemple 50 à 100 mots), alors une valeur élevée de max_input_length conduit à de très mauvaises performances. La valeur par défaut de ce paramètre est -1, ce qui correspond à la max_input_length de 2048 pour les modèles Llama. Par conséquent, nous recommandons que si votre ensemble de données contient de petits échantillons, utilisez une petite valeur pour max_input_length (comme 200 à 400).

Enfin, en raison de la forte demande des instances G5, vous pouvez rencontrer une indisponibilité de ces instances dans votre région avec l'erreur “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Si vous rencontrez cette erreur, réessayez la tâche de formation ou essayez une autre région.

Problèmes lors du réglage fin de très grands modèles

Dans cette section, nous abordons deux problèmes lors du réglage fin de très grands modèles.

Désactiver la compression de sortie

Par défaut, le résultat d'une tâche de formation est un modèle entraîné qui est compressé au format .tar.gz avant d'être téléchargé sur Amazon S3. Cependant, en raison de la grande taille du modèle, cette étape peut prendre beaucoup de temps. Par exemple, la compression et le téléchargement du modèle 70B peuvent prendre plus de 4 heures. Pour éviter ce problème, vous pouvez utiliser la fonctionnalité de désactivation de la compression de sortie prise en charge par la plateforme de formation SageMaker. Dans ce cas, le modèle est téléchargé sans aucune compression, qui est ensuite utilisé pour le déploiement :

Problème de délai d'expiration du noyau SageMaker Studio

En raison de la taille du modèle Llama 70B, le travail de formation peut prendre plusieurs heures et le noyau SageMaker Studio peut mourir pendant la phase de formation. Cependant, pendant cette période, la formation est toujours en cours dans SageMaker. Si cela se produit, vous pouvez toujours déployer le point de terminaison à l'aide du nom de la tâche de formation avec le code suivant :

Pour trouver le nom de la tâche de formation, accédez à la console SageMaker et sous Formation dans le volet de navigation, choisissez Emplois de formation. Identifiez le nom de la tâche de formation et remplacez-le dans le code précédent.

Conclusion

Dans cet article, nous avons discuté du réglage fin des modèles Llama 2 de Meta à l'aide de SageMaker JumpStart. Nous avons montré que vous pouvez utiliser la console SageMaker JumpStart dans SageMaker Studio ou le SDK SageMaker Python pour affiner et déployer ces modèles. Nous avons également discuté de la technique de réglage fin, des types d'instances et des hyperparamètres pris en charge. De plus, nous avons formulé des recommandations pour une formation optimisée sur la base de différents tests que nous avons effectués. Les résultats pour affiner les trois modèles sur deux ensembles de données sont présentés en annexe à la fin de cet article. Comme nous pouvons le voir à partir de ces résultats, le réglage fin améliore la synthèse par rapport aux modèles non affinés. Dans une prochaine étape, vous pouvez essayer d'affiner ces modèles sur votre propre ensemble de données à l'aide du code fourni dans le référentiel GitHub pour tester et comparer les résultats pour vos cas d'utilisation.

Les auteurs souhaitent remercier pour leurs contributions techniques Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne et June Gagné.

À propos des auteurs

Dr Vivek Madan est un scientifique appliqué au sein de l'équipe Amazon SageMaker JumpStart. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign et a été chercheur postdoctoral à Georgia Tech. Il est un chercheur actif en apprentissage automatique et en conception d'algorithmes et a publié des articles dans les conférences EMNLP, ICLR, COLT, FOCS et SODA.

Dr Vivek Madan est un scientifique appliqué au sein de l'équipe Amazon SageMaker JumpStart. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign et a été chercheur postdoctoral à Georgia Tech. Il est un chercheur actif en apprentissage automatique et en conception d'algorithmes et a publié des articles dans les conférences EMNLP, ICLR, COLT, FOCS et SODA.

Dr Farooq Sabir est architecte principal de solutions spécialisées en intelligence artificielle et en apprentissage automatique chez AWS. Il est titulaire d'un doctorat et d'une maîtrise en génie électrique de l'Université du Texas à Austin et d'une maîtrise en informatique du Georgia Institute of Technology. Il a plus de 15 ans d'expérience de travail et aime aussi enseigner et encadrer des étudiants. Chez AWS, il aide les clients à formuler et à résoudre leurs problèmes commerciaux dans les domaines de la science des données, de l'apprentissage automatique, de la vision par ordinateur, de l'intelligence artificielle, de l'optimisation numérique et des domaines connexes. Basé à Dallas, au Texas, lui et sa famille adorent voyager et faire de longs trajets en voiture.

Dr Farooq Sabir est architecte principal de solutions spécialisées en intelligence artificielle et en apprentissage automatique chez AWS. Il est titulaire d'un doctorat et d'une maîtrise en génie électrique de l'Université du Texas à Austin et d'une maîtrise en informatique du Georgia Institute of Technology. Il a plus de 15 ans d'expérience de travail et aime aussi enseigner et encadrer des étudiants. Chez AWS, il aide les clients à formuler et à résoudre leurs problèmes commerciaux dans les domaines de la science des données, de l'apprentissage automatique, de la vision par ordinateur, de l'intelligence artificielle, de l'optimisation numérique et des domaines connexes. Basé à Dallas, au Texas, lui et sa famille adorent voyager et faire de longs trajets en voiture.

Dr Ashish Khetan est un scientifique appliqué senior chez Amazon SageMaker JumpStart et aide à développer des algorithmes d'apprentissage automatique. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign. Il est un chercheur actif en apprentissage automatique et en inférence statistique, et a publié de nombreux articles dans les conférences NeurIPS, ICML, ICLR, JMLR, ACL et EMNLP.

Dr Ashish Khetan est un scientifique appliqué senior chez Amazon SageMaker JumpStart et aide à développer des algorithmes d'apprentissage automatique. Il a obtenu son doctorat à l'Université de l'Illinois à Urbana-Champaign. Il est un chercheur actif en apprentissage automatique et en inférence statistique, et a publié de nombreux articles dans les conférences NeurIPS, ICML, ICLR, JMLR, ACL et EMNLP.

Appendice

Cette annexe fournit des informations supplémentaires sur l’analyse comparative des performances et le formatage des ensembles de données.

Analyse comparative des performances

Dans cette section, nous fournissons des résultats pour affiner les trois modèles Llama 2 (7B, 13B et 70B) sur deux ensembles de données différents : Chariot ainsi que Somme de dialogue. Pour l'ensemble de données Dolly, notre tâche consiste à résumer un paragraphe de texte, tandis que pour Dialogsum, nous affinons le modèle pour résumer une discussion entre deux personnes. Dans les tableaux suivants, nous montrons l'entrée du modèle (invite et instructions), la vérité terrain (résumé), la réponse du modèle Llama 2 pré-entraîné et la réponse du modèle Llama 2 affiné pour chacun des trois Lama. 2 modèles. Nous montrons les résultats d’inférence pour cinq points de données. Vous pouvez remarquer dans les tableaux suivants que les résumés s'améliorent pour les deux ensembles de données lorsque nous affinons les modèles.

- Résultats pour affiner le modèle de génération de texte Llama 2 7B sur l'ensemble de données Dolly :

| Contributions | Vérité fondamentale | Réponse d'un modèle non affiné | Réponse du modèle affiné |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Rédigez une réponse qui complète correctement la demande.nn### Instruction :nOù se trouve Allauchnn### Entrée :nAllauch (prononciation française : ; occitan : Alaug) est une commune française située à l'est de Marseille dans le département des Bouches-du-Rhône. dans la région Provence-Alpes-Côte d'Azur en France.nnLes habitants de la commune sont appelés Allaudiens ou Allaudiennes en français.nnnn### Réponse :n | Allauch est une commune française située à l'est de Marseille dans le département des Bouches-du-Rhône en région Provence-Alpes-Côte d'Azur en France.nnLes habitants de la commune sont connus sous le nom d'Allaudiens ou Allaudiennes en français. | Allauch est une commune située à 28 km à l'est de Marseille dans le département des Bouches-du-Rhône en région Provence-Alpes-Côte d'Azur en France. Il est considéré comme l'un des plus beaux villages de France. La ville est entourée de collines et de vignobles et compte environ 6,000 1006 habitants. Il a été mentionné pour la première fois en XNUMX et possède un riche | La commune est située sur un plateau rocheux appelé Massif du Gélas, situé à l'est de Marseille. Il bénéficie d'une belle vue sur Marseille et son littoral. Allauch est aujourd'hui une commune bien développée avec sa propre mairie et de nombreux commerces, bars et restaurants. De par sa situation entre Marseille et les Alpilles, il a conservé de nombreux éléments naturels du territoire, notamment le massif des Glandes, également connu sous le nom de « W |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nQu'est-ce qu'un mammifère pondeur ?nn### Entrée :nL'ornithorynque (Ornithorhynchus anatinus), parfois appelé ornithorynque à bec de canard, est un œuf semi-aquatique. -mammifère pondeur endémique de l'est de l'Australie, y compris la Tasmanie. L'ornithorynque est le seul représentant vivant ou taxon monotypique de sa famille (Ornithorhynchidae) et de son genre (Ornithorhynchus), bien qu'un certain nombre d'espèces apparentées apparaissent dans les archives fossiles.nnnn### Réponse :n | L'ornithorynque à bec de canard est un mammifère pondeur que l'on trouve dans l'est de l'Australie. C'est le seul représentant vivant de son genre Ornithorhynchus. | nJ'ai fait pas mal de recherches sur votre question. J'ai lu toutes les informations que vous avez fournies dans votre deuxième paragraphe. J'ai aussi lu un peu sur l'ornithorynque, y compris [cette page](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Je pense avoir trouvé des réponses à votre question. Demandez-vous si l'ornithorynque est un mammifère pondeur ou si | Un mammifère qui pond des œufs, comme un ornithorynque |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nQuand Félix Luna est-il mort ?nn### Entrée :nFélix César Luna (30 septembre 1925 – 5 novembre 2009) était un écrivain, parolier et historien argentin.nnnn# ## Réponse : n | Félix Luna est décédé le 5 novembre 2009 | Félix César Luna (30 septembre 1925 – 5 novembre 2009) était un ArgentinnnQuand Luna est-elle décédée ?nnn### Explication :nNous répondons à la question avec la date de naissance et la date de décès de l'entrée.nnn### Solution : 1102n | Félix Luna est décédé le 5 novembre 2009.nn |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nNotez quelques points importants sur l'illusion d'optique à partir du passage donné.nn### Entrée :nDans la perception visuelle, une illusion d'optique (également appelée illusion visuelle) est une illusion provoquée par le système visuel et caractérisée par une perception visuelle qui semble sans doute différer de la réalité. Les illusions sont très diverses ; leur catégorisation est difficile car la cause sous-jacente n'est souvent pas claire, mais une classification proposée par Richard Gregory est utile comme orientation. Selon cela, il existe trois classes principales : les illusions physiques, physiologiques et cognitives, et dans chaque classe il y en a quatre sortes : les ambiguïtés, les distorsions, les paradoxes et les fictions. Un exemple classique de distorsion physique serait la flexion apparente d'un bâton à moitié immergé dans l'eau ; un exemple de paradoxe physiologique est la séquelle du mouvement (où, malgré le mouvement, la position reste inchangée). Un exemple de fiction anphysiologique est une image rémanente. Trois distorsions cognitives typiques sont l'illusion de Ponzo, Poggendorff et Müller-Lyer. Les illusions physiques sont provoquées par l'environnement physique, par exemple par les propriétés optiques de l'eau. Les illusions physiologiques surviennent dans l'œil ou dans les voies visuelles, par exemple à cause des effets d'une stimulation excessive d'un type de récepteur spécifique. Les illusions visuelles cognitives sont le résultat d'inférences inconscientes et sont peut-être les plus connues.nnnn### Réponse :n | 1. L'illusion visuelle est provoquée par le système visuel et caractérisée par une perception visuelle qui semble différente de la réalité.n2. Selon Richard Gregory, une classification proposée par lui est utile comme orientation, selon laquelle il existe trois classes principales : les illusions physiques, physiologiques et cognitives, et dans chaque classe il y en a quatre sortes : les ambiguïtés, les distorsions, les paradoxes et les fictions. Un exemple de distorsion physique serait la flexion apparente d'un bâton à moitié immergé dans l'eau ; un exemple de paradoxe physiologique est la séquelle du mouvement (où, malgré le mouvement, la position reste inchangée). n3. Un exemple de fiction physiologique est une image rémanente4. Trois distorsions cognitives sont l'illusion de Ponzo, Poggendorff et Müller-Lyer.n5. Les illusions physiques sont provoquées par l'environnement physique, par exemple par les propriétés optiques de l'eau. Les illusions physiologiques surviennent dans l'œil ou dans la voie visuelle.n6. L’illusion la plus connue est celle des illusions visuelles qui sont le résultat d’inférences inconscientes. | L'illusion d'optique mentionnée dans le passage est le mouvement illusoire du bâton partiellement plongé dans l'eau.nn## 50.n### Instruction :nÉcrivez un argument pour soutenir ou réfuter l'affirmation :nTous les étudiants de notre laboratoire ont le même QI moyen.nn### Entrée :nDe nombreux étudiants de l'expérience ont le même QI moyen, et je crois qu'ils font partie des 10 % ayant le plus élevén | nLes illusions d'optique exploitent les limitations physiologiques et psychologiques liées à la façon dont nous interprétons et répondons aux stimuli visuels, qu'il s'agisse de stimuli du monde qui nous entoure ou de stimuli visuels produits en interne. Ils fournissent un stimulus commun aux deux systèmes (physique et psychologique/perceptuel) qui nous permettent de comparer les deux et de comprendre la manière dont chacun fonctionne. Il existe diverses formes d'illusions d'optique, notamment psychologiques, |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Rédigez une réponse qui complète la demande de manière appropriée.nn### Instruction :nRésumez le dilemme de l'innovateur en quelques phrasesnn### Entrée :nElle décrit comment les grandes entreprises historiques perdent des parts de marché en écoutant leurs clients et en leur fournissant ce qui semble être le plus élevé. produits à valeur ajoutée, mais les nouvelles entreprises qui servent des clients à faible valeur avec une technologie peu développée peuvent améliorer cette technologie progressivement jusqu'à ce qu'elle soit suffisamment bonnennnn### Réponse :n | Le dilemme de l'innovateur : quand les nouvelles technologies provoquent la faillite des grandes entreprises, publié pour la première fois en 1997, est l'ouvrage le plus connu du professeur et homme d'affaires de Harvard, Clayton Christensen. Il développe le concept de technologies perturbatrices, un terme qu'il a inventé dans un article de 1995 « Technologies perturbatrices : attraper la vague ». Il décrit comment les grandes entreprises historiques perdent des parts de marché en écoutant leurs clients et en fournissant ce qui semble être les produits à plus forte valeur ajoutée, mais les nouvelles entreprises qui servent des clients de faible valeur avec une technologie peu développée peuvent améliorer cette technologie progressivement jusqu'à ce qu'elle soit suffisamment bonne pour prendre rapidement des parts de marché aux entreprises établies. Christensen recommande aux grandes entreprises de maintenir de petites divisions agiles qui tentent de reproduire ce phénomène en interne pour éviter d'être prises au dépourvu et dépassées par les startups concurrentes. | Salut, désolé pour la réponse tardive !! J'étais en vacances la semaine dernière :)nnLe dilemme de l'innovateur de Clayton Christensen explique que « le dilemme de l'innovateur est que la recherche par une entreprise de bénéfices durables en introduisant ou en améliorant ses produits pour offrir plus de valeur aux clients existants entraînera l'abandon de ces mêmes clients. l'entreprise achète des innovations qui offrent au moins une certaine valeur | Le dilemme de l'innovateur est un livre qui explique comment les grandes entreprises historiques perdent des parts de marché en écoutant leurs clients et en fournissant ce qui semble être les produits à plus forte valeur ajoutée, mais les nouvelles entreprises qui servent des clients à faible valeur avec une technologie peu développée peuvent améliorer progressivement cette technologie. jusqu'à ce que ce soit assez bon nn |

- Résultats pour affiner le modèle de génération de texte Llama 2 13B sur l'ensemble de données Dolly :

| Contributions | Vérité fondamentale | Réponse d'un modèle non affiné | Réponse du modèle affiné |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nQui est le prochain entraîneur du Fc Bayern München à succéder à Julian Nagelsmann ?nn### Entrée :nL'ère Nagelsmann (2021-2023)nSous la direction du nouvel entraîneur Julian Nagelsmann, Le Bayern a réussi l'exploit de remporter 10 titres consécutifs en Bundesliga après une victoire 3-1 de Der Klassiker. Cependant, l'équipe a perdu de manière inattendue contre Villarreal en quarts de finale de la Ligue des champions, sortant à ce stade pour la deuxième année consécutive. Le 24 mars 2023, Nagelsmann a été libéré par le Bayern et remplacé par Thomas Tuchel, qui a obtenu un contrat jusqu'au 30 juin 2025.nnnn### Réponse :n | Thomas Tuchel a remplacé Julian Nagelsmann en mars 2023 et est désormais le nouvel entraîneur du FC Bayern Munich, après avoir été entraîneur de Chelsea. | nn"`pythonn{n "instruction": "Qui est le prochain entraîneur du FC Bayern München pour succéder à Julian Nagelsmann ?", n "action" : "prochain entraîneur du FC Bayern", n "contexte" :{n " Ère Nagelsmann (2021-2023) » : n « Sous la direction du nouvel entraîneur Julian Nagelsmann, le Bayern a réussi l'exploit de remporter 10 titres consécutifs en Bundesliga | Le prochain entraîneur du Fc Bayern München sera Thomas Tuchel. Tuchel succédera à Julian Nagelsmann après le départ de Nagelsmann de l'équipe le 24 mars 2023.nn |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Rédigez une réponse qui complète convenablement la demande.nn### Instruction :nParlez-moi de la vie d'Adolphe Cohnnn### Entrée :nAdolphe Cohn (29 mai 1851-1930) était un éducateur franco-américain, né à Paris. Il est diplômé du baccalauréat ès lettres de l'Université de Paris en 1868 et étudie le droit, la critique historique et la philologie dans divers établissements d'enseignement supérieur à Paris, obtenant les diplômes de LL.B. en 1873. Élève de l'École des Chartes, sa thèse s'intitule Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires et il obtient le diplôme d'archiviste paléographe. en 1874. Au début de la guerre franco-prussienne en 1870, il s'enrôla et servit dans l'armée française tout au long de la lutte.nnCohn émigra à New York le 13 mai 1875 et, de 1876 à 1884, fut le correspondant américain de La République française, alors édité par Léon Gambetta, qu'il avait connu en France, et dont il avait adopté les opinions politiques. En mars 1882, Cohn fut nommé tuteur de français au Columbia College et devint peu après instructeur. Par un vote populaire des résidents français de New York, il fut choisi pour prononcer l'oraison funèbre de Gambetta en 1883 à Tammany Hall, et en 1885 il fut appelé de Cambridge, Massachusetts, dans un but similaire, à la mort de Victor Hugo.nnnn ### Réponse : n | Adolphe Cohn (29 mai 1851 – 1930) était un éducateur franco-américain, né à Paris. Il est diplômé du baccalauréat es lettres de l'Université de Paris en 1868 et étudie le droit, la critique historique et la philologie dans divers établissements d'enseignement supérieur à Paris, obtenant les diplômes de LL.B. en 1873. nnÉlève de l'École des Chartes, sa thèse s'intitule Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires et il obtient le diplôme d'archiviste paléographe. en 1874. Au début de la guerre franco-prussienne en 1870, il s'enrôla et servit dans l'armée française tout au long de la lutte.nnCohn émigra à New York le 13 mai 1875 et, de 1876 à 1884, fut le correspondant américain de La République française, alors édité par Léon Gambetta, qu'il avait connu en France, et dont il avait adopté les opinions politiques. En mars 1882, Cohn fut nommé tuteur de français au Columbia College et devint peu après instructeur. Par un vote populaire des résidents français de New York, il fut choisi pour prononcer l'oraison funèbre de Gambetta en 1883 à Tammany Hall, et en 1885 fut appelé de Cambridge, Massachusetts, dans un but similaire, à la mort de Victor Hugo. | nAdolphe Cohn (29 mai 1851-1930) était un éducateur franco-américain, né à Paris. Il est diplômé du baccalauréat ès lettres de l'Université de Paris en 1868 et étudie le droit, la critique historique et la philologie dans divers établissements d'enseignement supérieur à Paris, obtenant les diplômes de LL.B. en 1873. Élève de l'É | Adolphe Cohn était un éducateur franco-américain né à Paris le 29 mai 1851. Il fréquenta l'Université de Paris et obtint une licence en droit en 1873. Il travailla également à l'École des Chartes et obtint son diplôme d'archiviste paléographe en 1874. Au début de la guerre franco-prussienne, il rejoint l'armée française et la sert pendant toute la durée de la guerre. |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Rédigez une réponse qui complète la demande de manière appropriée.nn### Instruction :nComment le public cible de McDonald's a-t-il changé au fil du temps ?nn### Entrée :nLes restaurants de restauration rapide ciblent souvent une partie de leur publicité directement sur la population jeune. Les Happy Meals de McDonald's, qui comprennent un jouet souvent lié à un film familial récemment sorti, en sont un exemple significatif. Ronald McDonald, une mascotte publicitaire de clown introduite en 1963 et conçue pour plaire aux jeunes enfants, en est une autre. De plus, en 1987, McDonald's a intégré une aire de jeux dans ses restaurants pour faire davantage de publicité auprès des enfants, faisant ainsi de leurs restaurants un environnement plus attrayant pour les enfants. De plus, de 1996 à 2006, Disney était un partenaire exclusif de McDonald's, reliant leurs produits entre eux. Ils ont annoncé la fin de cet accord en mai 2006, certains rapports affirmant que Disney s'inquiétait de l'obésité infantile. Outre Disney, McDonald's est également partenaire de Nintendo depuis 1985, lorsque la Nintendo Entertainment System a été introduite pour la première fois. En 1987, McDonald's a également créé un terrain de jeu Nintendo dans ses restaurants où les enfants pouvaient jouer sur des consoles Nintendo en attendant leur nourriture. En 2007, McDonald's a commencé à fournir le WiFi à partir des consoles Nintendo ; donner aux enfants la possibilité de jouer où qu'ils soient. Avec également un public cible d'enfants qui sortent ces nouveaux films et incorporent des jouets, il utilise les enfants pour atteindre les poches de leurs parents en raison de leur investissement important.nnnn### Réponse :n | McDonald's a toujours orienté sa publicité directement vers la population jeune.nnÀ partir de 1963, ils ont lancé Ronald McDonald, une mascotte publicitaire de clown conçue pour attirer les jeunes enfants. Au fil des années, McDonald's s'est associé à plusieurs entreprises proposant des produits destinés aux enfants, telles que Nintendo et Disney. | Les fast-foods ont toujours ciblé la population jeune. Les Happy Meals sont également un facteur important lorsqu'il s'agit de publicité auprès des jeunes.nComme de nombreux films sont sortis, les Happy Meals sont également accompagnés d'un jouet pour promouvoir ce film dans votre McDonald's localnn—n## 400-999nn### Commentaire :nAs jeune entreprise avec une vision du monde relativement étroite, McDonald's n'a pas | Depuis son lancement, McDonald's a ciblé son public sur les jeunes enfants et les adolescents avec ses restaurants de restauration rapide et ses produits alimentaires destinés aux enfants, ainsi que sa publicité, qui a largement ciblé les jeunes. Pendant que les enfants sont conduits vers McDonalds par leurs parents, le restaurant est essentiellement une publicité parentale pour leurs enfants : McDonalds séduit les enfants avec ses restaurants aux couleurs vives et les jouets trouvés dans leur nourriture qui les attirent. |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nQu'est-ce que le mandal d'Anandapuramnn### Entrée :nLe mandal d'Anandapuram est l'un des 46 mandals du district de Visakhapatnam, dans l'État indien d'Andhra Pradesh. Il est sous l'administration de la division des revenus de Visakhapatnam et le siège social est situé à Anandapuram. Le mandal d'Anandapuram est délimité par le mandal de Bheemunipatnam à l'est, Chinagadila au sud, Padmanabham au nord et Kothavalasa à l'ouest.nnnn### Réponse :n | Le mandal d'Anandapuram est l'un des 46 mandals du district de Visakhapatnam de l'État indien d'Andhra Pradesh. Il est sous l'administration de la division des revenus de Visakhapatnam et le siège social est situé à Anandapuram. | nnnn | Le mandal d'Anandapuram est l'un des 46 mandals du district de Visakhapatnam de l'État indien d'Andhra Pradesh. Il est sous l'administration de la division des revenus de Visakhapatnam et le siège social est situé à Anandapuram. Le mandal d'Anandapuram est délimité par le mandal de Bheemunipatnam à l'est, Chinagadila au sud, Padmanabham au nord et Koth. |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nCe qui s'est passé à Woodstocknn### Entrée :nWoodstock Music and Art Fair, communément appelé Woodstock, était un festival de musique organisé du 15 au 18 août 1969. Ferme laitière de Max Yasgur à Bethel, New York, États-Unis, à 40 km au sud-ouest de la ville de Woodstock. Présenté comme « une exposition du Verseau : 65 jours de paix et de musique » et également appelé Woodstock Rock Festival, il a attiré un public de plus de 3 400,000 participants. Trente-deux actes se sont produits en extérieur malgré des pluies sporadiques. C'était l'un des plus grands festivals de musique organisés dans l'histoire.nnLe festival est devenu largement considéré comme un moment charnière dans l'histoire de la musique populaire ainsi qu'un événement déterminant pour la génération de la contre-culture. L'importance de l'événement a été renforcée par un film documentaire de 1970, un album de bande originale et une chanson écrite par Joni Mitchell qui est devenue un succès majeur pour Crosby, Stills, Nash & Young et Matthews Southern Comfort. Des événements musicaux portant le nom de Woodstock étaient prévus pour les anniversaires, notamment les dixième, vingtième, vingt-cinquième, trentième, quarantième et cinquantième. En 2004, le magazine Rolling Stone l'a classé au 19e rang des 50 moments qui ont changé l'histoire du rock and roll. En 2017, le site du festival a été inscrit au Registre national des lieux historiques.nnnn### Réponse :n | La Woodstock Music and Art Fair, communément appelée Woodstock, était un festival de musique organisé du 15 au 18 août 1969 dans la ferme laitière de Max Yasgur à Bethel, New York, États-Unis, à 40 km au sud-ouest de la ville. de Woodstock. Présenté comme « une exposition du Verseau : 65 jours de paix et de musique » et également appelé Woodstock Rock Festival, il a attiré un public de plus de 3 400,000 participants. Trente-deux actes se sont produits en extérieur malgré des pluies sporadiques. C'était l'un des plus grands festivals de musique organisés dans l'histoire.nnLe festival est devenu largement considéré comme un moment charnière dans l'histoire de la musique populaire ainsi qu'un événement déterminant pour la génération de la contre-culture. L'importance de l'événement a été renforcée par un film documentaire de 1970, un album de bande originale et une chanson écrite par Joni Mitchell qui est devenue un succès majeur pour Crosby, Stills, Nash & Young et Matthews Southern Comfort. Des événements musicaux portant le nom de Woodstock étaient prévus pour les anniversaires, notamment les dixième, vingtième, vingt-cinquième, trentième, quarantième et cinquantième. En 2004, le magazine Rolling Stone l'a classé au 19e rang des 50 moments qui ont changé l'histoire du rock and roll. En 2017, le site du festival a été inscrit au registre national des lieux historiques. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Solution :nn n Pour voir la solution nn«`jsnn// Solution requise | La Woodstock Music and Art Fair, qui s'est tenue du 15 au 18 août, a été un événement historique à Bethel, New York, pour la génération de la contre-culture. La foule au festival était de plus de 400,000 32 personnes. Environ XNUMX actes se sont produits en extérieur malgré des pluies sporadiques. Il était considéré comme l’un des plus grands festivals de musique de l’histoire.nn |

- Résultats pour affiner le modèle de génération de texte Llama 2 70B sur l'ensemble de données Dolly :

| Contributions | Vérité fondamentale | Réponse d'un modèle non affiné | Réponse du modèle affiné |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Rédigez une réponse qui complète la demande de manière appropriée.nn### Instruction :nQui est la société ABBnn### Entrée :nABB Ltd. est une société multinationale suédo-suisse dont le siège est à Zurich, en Suisse. La société a été créée en 1988 lorsque la société suédoise Allmänna Svenska Elektriska Aktiebolaget (ASEA) et la société suisse Brown, Boveri & Cie ont fusionné pour créer ASEA Brown Boveri, plus tard simplifiée en initiales ABB. Les deux sociétés ont été créées à la fin des années 1800 et étaient d’importants fabricants d’équipements électriques, un secteur dans lequel ABB reste actif aujourd’hui. Depuis, l'entreprise s'est également étendue à la robotique et à la technologie d'automatisation.nnnn### Réponse :n | ABB Ltd. est une société multinationale suédo-suisse dont le siège est à Zürich, en Suisse. La société a été créée en 1988 lorsque la société suédoise Allmanna Svenska Elektriska Aktiebolaget (ASEA) et la société suisse Brown, Boveri & Cie ont fusionné pour créer ASEA Brown Boveri, plus tard simplifiée en initiales ABB. nnLes deux sociétés ont été créées à la fin des années 1800 et étaient d'importants fabricants d'équipements électriques, un secteur dans lequel ABB reste actif aujourd'hui. Depuis, l’entreprise s’est également étendue à la robotique et à la technologie d’automatisation. | * ABB est une société multinationale suédo-suissenn### LognEND I/O DATA —n | ABB est une société multinationale suédo-suisse dont le siège est à Zürich, en Suisse. La société a été créée en 1988 lorsque la société suédoise Allmänna Svenska Elektriska Aktiebolaget (ASEA) et la société suisse Brown, Boveri & Cie ont fusionné pour créer ASEA Brown Boveri, plus tard simplifiée en initiales ABB. Les deux sociétés ont été créées à la fin des années 1800 et étaient |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nPourquoi Guillaume le Conquérant, un Français, est-il devenu roi d'Angleterre ?nn### Entrée :nDans les années 1050 et au début des années 1060, Guillaume est devenu un prétendant au titre de roi d'Angleterre. trône d'Angleterre détenu par Édouard le Confesseur, sans enfant, son cousin germain une fois enlevé. Il y avait d'autres prétendants potentiels, y compris le puissant comte anglais Harold Godwinson, qu'Édouard nomma roi sur son lit de mort en janvier 1066. Arguant qu'Édouard lui avait déjà promis le trône et qu'Harold avait juré de soutenir sa revendication, Guillaume construisit un grand flotte et envahit l'Angleterre en septembre 1066. Il vainquit et tua Harold de manière décisive à la bataille d'Hastings le 14 octobre 1066. Après de nouveaux efforts militaires, Guillaume fut couronné roi le jour de Noël 1066 à Londres. Il prit des dispositions pour la gouvernance de l'Angleterre au début de 1067 avant de retourner en Normandie. Plusieurs rébellions infructueuses suivirent, mais l'emprise de Guillaume était pratiquement assurée sur l'Angleterre en 1075, lui permettant de passer la plus grande partie de son règne en Europe continentale.nnnn### Réponse :n | Guillaume le Conquérant était originaire de Normandie, située dans le nord-ouest de la France. Le roi d'Angleterre à la fin des années 1050 et au début des années 1060 était Édouard le Confesseur. Edward était le cousin de William. Comme Edward n’avait pas d’enfant, plusieurs personnes affirmaient qu’elles étaient l’héritière légitime et qu’elles devraient devenir roi. Ces revendications contradictoires ont donné lieu à un conflit armé. Guillaume envahit l'Angleterre, où il remporta la bataille d'Hastings, battant le comte Harold Godwinson. Un certain nombre de batailles suivirent, mais Guillaume devint roi d'Angleterre à la fin de 1066. Il fit face à de multiples rébellions au cours de la décennie suivante, mais conserva son pouvoir. Finalement, il put retourner en Normandie et diriger l'Angleterre à partir de là. | Guillaume le Conquérant est devenu roi d'Angleterre car dans les années 1050 et au début des années 1060, il est devenu un prétendant au trône d'Angleterre détenu par Édouard le Confesseur, sans enfant, son cousin germain une fois destitué.nnnLa réponse peut être vide mais doit contenir moins de 256 caractères. n | Après la mort du roi Harold lors de la bataille d'Hastings le 14 octobre 1066, Guillaume le Conquérant fut couronné roi d'Angleterre le jour de Noël 1066, établissant ainsi la conquête normande de l'Angleterre.nn |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nParlez-moi du RMS Adriaticnn### Entrée :nRMS Adriatic était un paquebot britannique de la White Star Line. Il était le quatrième d'un quatuor de navires de plus de 20,000 1911 tonneaux de jauge brute, surnommé The Big Four. Ce navire était le seul des quatre à ne jamais être le plus grand navire du monde. Cependant, il était le plus grand, le plus rapide et le plus luxueux des Big Four, étant le premier paquebot à disposer d'une piscine intérieure et d'un bain turc.nnElle a débuté sa carrière sur la toute nouvelle route reliant Southampton à New York avant rejoignant, à partir de 1917, ses navires jumeaux sur la route secondaire depuis Liverpool. Il s'agissait en fait de paquebots lents destinés à assurer un service à des prix modérés. Lorsque la Première Guerre mondiale éclate, l’Adriatic fait partie des navires qui poursuivent leur service civil transatlantique, tout en transportant de nombreuses provisions. En 1930, il est réquisitionné et sert de transport de troupes.nnAprès la guerre, il est réaménagé à plusieurs reprises, et est progressivement utilisé pour les croisières, qui deviennent ses principales prestations dans les années 1934. Lorsque la Cunard Line et la White Star Line fusionnèrent en 1935, elle fut rapidement jugée inutile et vendue à la fin de l'année. Elle a été démolie à Osaka en XNUMX.nnnn### Réponse :n | Le RMS Adriatic était un paquebot britannique de la White Star Line. Il était le quatrième d'un quatuor de navires de plus de 20,000 XNUMX tonneaux de jauge brute, surnommé The Big Four. Ce navire était le seul des quatre à ne jamais être le plus grand navire du monde. Cependant, il était le plus grand, le plus rapide et le plus luxueux des Big Four, étant le premier paquebot à disposer d'une piscine intérieure et d'un bain turc. | RMS Adriatic était un paquebot britannique de la White Star Line. Il était le quatrième d'un quatuor de navires de plus de 20,000 XNUMX tonneaux de jauge brute, surnommé The Big Four. Ce navire était le seul des quatre à ne jamais être le plus grand navire du monde. nn### ContextnUne question de ce type est couramment utilisée pour interroger un moteur de recherche. L'entrée est une entrée de la requête et la réponse est le public | Le RMS Adriatic était un paquebot britannique de la White Star Line. Il a été lancé en 1906, mais sa première navigation commerciale a eu lieu en 1907. Il était le quatrième d'un quatuor de navires de plus de 20,000 1901 tonnes et surnommé les Big Four. Les trois autres étaient le RMS Celtic en 1903, le RMS Baltic en XNUMX et le R |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nQu'est-ce que le CGRO qui détecte les photons ?nn### Entrée :nLe Compton Gamma Ray Observatory (CGRO) était un observatoire spatial détectant des photons avec des énergies de 20 keV à 30 GeV, en orbite terrestre de 1991 à 2000. L'observatoire comprenait quatre télescopes principaux dans un seul vaisseau spatial, couvrant les rayons X et les rayons gamma, y compris divers sous-instruments et détecteurs spécialisés. Après 14 années d'efforts, l'observatoire a été lancé depuis la navette spatiale Atlantis lors de la mission STS-37 le 5 avril 1991 et a fonctionné jusqu'à sa désorbite le 4 juin 2000. Il a été déployé en orbite terrestre basse à 450 km (280 mi) pour évitez la ceinture de radiations de Van Allen. Il s'agissait de la charge utile astrophysique la plus lourde jamais transportée à cette époque, avec 17,000 37,000 kilogrammes (XNUMX XNUMX lb).nnnn### Réponse :n | Le CGRO est le Compton Gamma Ray Observatory (CGRO) et était un observatoire spatial détectant des photons d'énergies comprises entre 20 keV et 30 GeV sur Terre de 1991 à 2000. | **Transcripteur :** L'instrument EGRET détecte les photons.nn | Le Compton Gamma Ray Observatory (CGRO) mesure des photons avec des énergies comprises entre 20 keV et 30 GeV.nn |

| Vous trouverez ci-dessous une instruction décrivant une tâche, associée à une entrée fournissant un contexte supplémentaire. Écrivez une réponse qui complète la demande de manière appropriée.nn### Instruction :nQuelle est la qualité de Yeol Eum Son en tant que pianistenn### Entrée :nYeol Eum Son (né le 2 mai 1986 à Wonju, en Corée du Sud) est un classique sud-coréen pianiste. Elle a attiré l'attention internationale pour la première fois en octobre 2004, à l'âge de 18 ans, lorsqu'elle s'est produite en tant que soliste dans le Concerto pour piano n°1 de Liszt avec l'Orchestre philharmonique de New York sous la direction de Lorin Maazel lors de leur tournée en Asie à Séoul, Daejeon et Tokyo. Son a de nouveau joué avec Maazel et l'Orchestre philharmonique de New York à leur retour au Centre des Arts de Séoul en février 2008, cette fois en tant que soliste du Concerto pour piano n°2 de Beethoven.nnSes récompenses incluent des médailles d'argent au treizième Concours international de piano Van Cliburn (2009 ) et du Concours International Tchaïkovski 2011, où elle a également reçu les prix de la meilleure interprétation de concerto de chambre et de la meilleure interprétation d'une œuvre de commande. Elle a également remporté la médaille de bronze au Concours international de piano Arthur Rubinstein (2005) nnnn### Réponse :n | Yeol Eum Son (né le 2 mai 1986 à Wonju, Corée du Sud) est un pianiste classique sud-coréen. Elle a attiré l'attention internationale pour la première fois en octobre 2004, à l'âge de 18 ans, lorsqu'elle s'est produite en tant que soliste dans le Concerto pour piano n°1 de Liszt avec l'Orchestre philharmonique de New York sous la direction de Lorin Maazel lors de leur tournée en Asie à Séoul, Daejeon et Tokyo. Son a de nouveau joué avec Maazel et l'Orchestre philharmonique de New York à leur retour au Centre des Arts de Séoul en février 2008, cette fois en tant que soliste du Concerto pour piano n°2 de Beethoven.nnSes récompenses incluent des médailles d'argent au treizième Concours international de piano Van Cliburn (2009 ) et du Concours International Tchaïkovski 2011, où elle a également reçu les prix de la meilleure interprétation de concerto de chambre et de la meilleure interprétation d'une œuvre de commande. Elle a également remporté la médaille de bronze au Concours international de piano Arthur Rubinstein (2005). | Yeol Eum Son est un pianiste accompli qui s'est produit avec certains des orchestres les plus prestigieux du monde. En 2009, elle a remporté l'argent au treizième Concours international de piano Van Cliburn et en 2005, elle a remporté le bronze au Concours international de piano Arthur Rubinstein. Elle continue de se produire avec beaucoup de succès partout dans le monde. | Yeol Eum Son est un très bon pianiste. Elle a commencé sa carrière internationale en rejoignant certains des plus grands musiciens du monde à l'âge de 18 ans. À 25 ans, elle était déjà médaillée d'argent dans deux concours internationaux. |

- Résultats pour affiner le modèle de génération de texte Llama 2 7B sur l'ensemble de données Dialogsum :

| Contributions | Vérité fondamentale | Réponse d'un modèle non affiné | Réponse du modèle affiné |

| Résumez cette boîte de dialogue :n#Person1# : C'est un excellent repas !n#Person2# : Merci. Je suis heureux que tout se soit si bien passé.n#Person1# : Qui vous a appris à bien cuisiner ?n#Person2# : J'ai suivi un cours de cuisine à l'Institut culinaire.n#Person1# : Wow, qu'est-ce qu'il y a dedans plat de poulet ?n#Person2# : N'est-ce pas génial ? C'est du poulet à la noix de coco et au gingembre avec du riz.n#Person1# : La soupe est-elle une soupe aux crevettes ?n#Person2# : Oui, il y a des crevettes là-dedans, des légumes de mer et de la citronnelle.n#Person1# : Je pense que j'ai eu de la chance en choisissant un vin qui se marie avec ce repas.n#Person2# : J'apprécie que vous ayez apporté le vin. Cela se marie bien avec le poulet.n—nRésumé :nnn### Réponse :n | #Personne1# pense que le repas préparé par #Personne2# est excellent. #Person2# présente les ingrédients des plats. | Une fois le dialogue terminé, la personne fournira une réponse appropriée aux informations recueillies. Par exemple, la personne 1 peut dire : nn#Person1# : C'est génial ! Merci.nn#Person2# : De rien. Je pensais que tu aimerais ton repas. Je suis heureux que vous ayez apprécié.nn—n— — — — –nnn### Résumé :nnn### Réponse :nAprès le dialogue | #Person1# et #Person2# mangent chez #Person2#. Ils parlent de la nourriture et du vin qui se marient avec le poulet.nn |

| Résumez cette boîte de dialogue :n#Person1# : Excusez-moi, j'écris un essai sur la Grèce antique. Y a-t-il des livres sur ce sujet que vous pouvez recommander ?n#Person2# : Les oies ? Vous voulez écrire sur les oies anciennes ? Je n'ai jamais entendu parler d'une telle chose. Quoi qu'il en soit, ce serait avec un livre sur quelques animaux, c'est la rangée J. Ou vous voulez essayer la science, c'est dans la rangée Gn#Person1# : Animaux ? Mais la Grèce est un pays, pas un animal.n#Person2# : Oh, la Grèce. Eh bien, vous savez, aujourd'hui doit être votre jour de chance. Nous venons de recevoir une nouvelle collection de livres sur ce même sujet. Il y a des écrivains ici, dans la rangée Cn#Person1# : je vois. Cela fait beaucoup de livres, lequel suggérez-vous ?n#Person2# : Bon, celui de Robin Smith est excellent mais il est très long. C'est celui avec la statue sur la couverture. Il y en a aussi un de Milton Pike. Il y a une peinture d'un soldat sur le devant. Comme vous pouvez le constater, il n’est pas très épais, sa lecture ne devrait donc pas prendre trop de temps. Mais le meilleur livre est probablement celui qui présente la photo de l’ancien stade olympique. Il a remporté plusieurs récompenses dans des ouvrages d'histoire.n#Person1# : Eh bien, c'est difficile de décider, mais j'ai bien peur de ne pas avoir assez de temps pour beaucoup de lecture. Je pense que je vais me procurer le livre de Milton Pike.n#Person2# : OK. Pourrais-je avoir votre carte de bibliothèque s'il vous plaît ?n#Personne1# : Bien sûr, vous y êtes.n—nRésumé :nnn### Réponse :n | #Personne1# demande à #Personne2# de lui recommander des livres sur la Grèce antique. #Person2# suggère celui de Robin Smith qui est très long, celui de Milton Pike qui n'est pas très épais, et celui qui a remporté plusieurs récompenses d'ouvrages d'histoire. Puisque #Personne1# n'a pas assez de temps, #Personne1# obtiendra le livre de Milton Pike. | n—nnRésumé :n | #Person1# écrit un essai sur la Grèce antique. #Person2# recommande à #Person1# les livres sur la Grèce antique qui viennent tous d'être reçus et suggère de se procurer le livre de Milton Pike.nn |

| Résumez cette boîte de dialogue :n#Person1# : Eh bien, je vois que vous avez vos livres, George. Mais est-ce que tu lis ? On dirait que vous êtes juste en train de colorier.n#Person2# : Je marque les parties importantes du livre. Les couleurs sont pour différentes choses.n#Person1# : Comme quoi ?n#Person2# : Les idées principales sont jaunes. Les détails importants à retenir sont le rose et le vert clair pour les idées difficiles.n#Person1# : Cela ressemble à beaucoup d'activités. Tu ne perds pas ton temps ?n#Person2# : Je ne pense pas, maman. Je vais tout lire ce soir. Je l'écouterai demain. Et puis, quand il sera temps d'étudier, je connaîtrai déjà la plupart des informations.n#Personne1# : À mon époque, nous lisions simplement le livre et essayions de nous souvenir des informations.n#Person2# : Le professeur nous a expliqué l'importance de lecture active. Et c'est la meilleure façon d'apprendre, quelle que soit la vitesse que vous choisissez.n#Person1# : Je vois. Et à quoi sert ce carnet ?n#Person2# : C'est pour prendre des notes. Quel genre de choses écrivez-vous ?n#Person1# : Parfois, j'écris un résumé. Sur cette page, j'écris des questions. Et bien sûr, j'ai une autre page sur laquelle j'écris les nouveaux mots.n—nRésumé :nnn### Réponse :n | George dit à sa mère que marquer les parties importantes du livre avec différentes couleurs est sa façon d'apprendre. Il prend également des notes sur le cahier et rédige parfois une synthèse. | #Personne1# : Ohhh ! Lecture active, questions de lecture, notes de vocabulaire, résumés et surlignages. Je peux voir maintenant quelle différence vous avez en matière d’apprentissage de l’information. Je suis impressionné.n#Person2# : Merci. La lecture est la meilleure façon d’apprendre et de mémoriser de nouvelles informations. Utilisez-vous la lecture active en ce moment ?n#Person1# : Hmmm….. je vais devoir y réfléchir.nnn#Person | George décrit les activités qu'il fait pour lire ses livres rapidement. George montre le cahier à maman et lui explique comment prendre des notes.nn |

| Résumez cette boîte de dialogue :n#Person1# : Bonjour, monsieur. Puis-je voir votre passeport ?n#Person2# : Oui, bien sûr. Le voici.n#Person1# : Merci. Est-ce que tout cela est à vous ?n#Person2# : Non, certains d'entre eux appartiennent à mon ami. Voulez-vous aussi son passeport ?n#Person1# : Oui, s'il vous plaît. Avez-vous des bagages à main ?n#Person2# : Voulez-vous que je les mette également à la ceinture ?n#Person1# : Oui, s'il vous plaît. Pourriez-vous s'il vous plaît ouvrir cette grosse valise ?n#Person2# : OK. Juste un moment. Ce ne sont que des vêtements et des articles de toilette.n#Person1# : OK. Avez-vous quelque chose à déclarer ?n#Person2# : Je pense qu'il n'y a rien.n#Person1# : Des aliments frais, des plantes vivantes ou des animaux ?n#Person2# : Oh, non. Rien de tout cela.n#Person1# : Merci. Vous pouvez verrouiller votre valise. Voici vos passeports.n#Personne2# : Merci beaucoup.n—nRésumé :nnn### Réponse :n | #Personne1# voit le passeport de #Personne2# et de l'ami de #Personne2# et enregistre leurs bagages. #Person2# dit à #Person1# qu'elle n'a rien à déclarer. #Person1# les laisse partir. | > Je pense qu'il n'y a rien.nnn—n**Catégories :**nn- [Conversation (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Clé :nn :information_source : 31 (TSA)n:information_source : 32 (TSA)nn—-n* Tout droit d'auteur | L'agent de l'immigration demande à #Personne2# de montrer son passeport et d'ouvrir sa grosse valise. #Personne2# n'a rien à déclarer et il peut mettre sa valise sous clé.nn |

| Résumez cette boîte de dialogue :n#Person1# : Le thé chinois est célèbre dans le monde entier. Je souhaite acheter plusieurs boîtes.n#Person2# : Il existe différentes sortes de thé en Chine. Cela dépend du goût et de l'effet.n#Person1# : Eh bien, je ne connais pas du tout le thé chinois.n#Person2# : C'est du thé vert, vous pouvez le boire en été. Cela peut soulager la chaleur estivale et c'est bon pour entretenir vos poumons.n#Person1# : Cela semble intéressant. Et ça ?n#Person2# : C'est du thé noir, il a un goût prononcé et favorise la digestion.n#Person1# : Qu'est-ce que c'est ? Ça sent parfumé.n#Person2#: C'est du thé au jasmin de haute qualité. Il est parfumé et a un goût agréable.n#Person1# : Je vais prendre le thé au jasmin. Pourriez-vous l'emballer avec le papier d'emballage et le ruban ? C'est un cadeau pour mon ami.n#Person2# : Pas de problème. Attendez un instant.n—nRésumé : nnn### Réponse :n | #Personne2# recommande le thé vert, le thé noir et le thé au jasmin à #Personne1# qui souhaite acheter du thé chinois et #Personne1# décide de prendre le thé au jasmin. | #[Français]# : Le thé chinois est célèbre dans le monde entier. Je souhaite acheter plusieurs boîtes.n#[Français]#: Il ya différentes sortes de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[Espagnol]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[Allemand]#: Ich mö | #Personne1# souhaite acheter plusieurs boîtes de thé chinois, contenant différentes sortes de thé. #Person2# aide #Person1# à sélectionner et l'emballera.nn |

- Résultats pour affiner le modèle Llama-2 13B sur l'ensemble de données Dialogsum :

| Contributions | Vérité fondamentale | Réponse d'un modèle non affiné | Réponse du modèle affiné |

| Résumez ce dialogue :n#Person1# : Mme Thompson était autrefois dithéiste, Jason.n#Person2# : Pourquoi ? On ne devrait pas avoir d'ennuis ou quoi ? En fait, nous avons été très actifs pendant toute la discussion en classe ce matin.n#Person1# : C'est exactement ça. Je ne pense pas que ce soit une mauvaise chose du tout. Je pense qu'elle va nous demander de nous présenter aux élections de moniteur de classe.n#Person2# : Whoa ! Vraiment? Cela représente beaucoup de responsabilités.n#Person1# : Eh bien, je pense que vous seriez doué pour cela. En plus, c'est un grand honneur d'être invité à le faire. Cela signifie que Mme Thompson nous considère comme des leaders.n#Person2# : Cependant, je ne suis pas sûr de pouvoir le faire moi-même. Pourrions-nous le faire ensemble ?n#Person1# : Demandons à Mme Thompson. Je l'entends entrer dans le couloir maintenant.n—nRésumé :nnn### Réponse :n | #Person1# dit à Jason Mme Thompson une fois dithéiste et #Person1# devine qu'elle veut qu'ils se présentent pour les moniteurs de classe. Ils demanderont à Mme Thompson s'ils peuvent faire cela ensemble. | n* Lorsque l'enseignant a demandé à Jason et à son camarade de classe s'ils voulaient se présenter comme moniteur de classe, lui et son camarade de classe ont convenu ensemble. Les deux garçons sont chrétiens, mais ils ne sont pas amis en classe.n* Leur foi en Jésus n’est peut-être pas partagée publiquement, mais elle est évidente à travers la prière et l’exemple qu’ils suivent ensemble pour aider les autres et montrer leur amour.nn—n## 1654nn **[Situation :** Les étudiants parlent du récent | Mme Thompson demande à Jason et James de se présenter comme moniteur de classe parce qu'elle pense qu'ils sont des leaders.nn |

| Résumez cette boîte de dialogue :n#Person1# : Hé, arrêtons-nous et regardons cette maison là-bas.n#Person2# : Oui, ça a l'air génial ! Est-il sur notre liste de portes ouvertes ?n#Person1# : Oui, il est sur notre liste.n#Person2# : Eh bien, il a fière allure depuis le trottoir. Continuons à l'intérieur.n#Person1# : signons le registre. L'agent immobilier a l'air plutôt occupé en ce moment.n#Person2# : OK, allons voir la cuisine ensuite.n#Person1# : Oh regarde, ils ont des rafraîchissements ici.n#Person2# : Assurez-vous de venir chercher un dépliant avec les informations sur la maison.n#Person1# : Est-il indiqué combien ils demandent pour cette maison ?n#Person2# : Oui, il semble qu'elle ait été réduite de deux cent trente-cinq mille à deux cents et vingt-cinq mille — nRésumé : nnn### Réponse :n | #Personne1# et #Personne2# viennent voir une maison. Ils vérifient l'intérieur et parlent de son prix. | Il s'agit d'une réponse AMI au stimulus suivant.nnPersonne 2 : nOui, ça a l'air génial ! Est-ce sur notre liste de portes ouvertes ? nOui, il est sur notre liste.nEh bien, il est superbe vu du trottoir. Continuons à l'intérieur. Signons le registre. L'agent immobilier a l'air plutôt occupé en ce moment.nOK, allons voir la cuisine ensuite.nOh regarde, ils en ont | #Person1# et #Person2# examinent une maison qui figure sur leur liste de portes ouvertes. Ils signent un registre et #Person2# dit à #Person1# de prendre un dépliant contenant les informations.nn |