L'augmentation des activités sociales en ligne telles que les réseaux sociaux ou les jeux en ligne est souvent marquée par des comportements hostiles ou agressifs qui peuvent conduire à des manifestations non sollicitées de discours de haine, de cyberintimidation ou de harcèlement. Par exemple, de nombreuses communautés de jeux en ligne proposent une fonctionnalité de chat vocal pour faciliter la communication entre leurs utilisateurs. Bien que le chat vocal supporte souvent les plaisanteries amicales et les bavardages, il peut également entraîner des problèmes tels que le discours de haine, la cyberintimidation, le harcèlement et les escroqueries. Le signalement d'un langage préjudiciable aide les organisations à garder les conversations civiles et à maintenir un environnement en ligne sûr et inclusif pour que les utilisateurs puissent créer, partager et participer librement. Aujourd'hui, de nombreuses entreprises comptent uniquement sur des modérateurs humains pour examiner le contenu toxique. Cependant, la mise à l'échelle des modérateurs humains pour répondre à ces besoins avec une qualité et une vitesse suffisantes coûte cher. Par conséquent, de nombreuses organisations risquent de faire face à des taux élevés d'attrition des utilisateurs, à des atteintes à leur réputation et à des amendes réglementaires. De plus, les modérateurs sont souvent impactés psychologiquement en examinant le contenu toxique.

Amazon Transcribe est un service de reconnaissance automatique de la parole (ASR) qui permet aux développeurs d'ajouter facilement la fonction de synthèse vocale à leurs applications. Aujourd'hui, nous sommes ravis d'annoncer Amazon Transcribe Détection de la toxicité, une fonctionnalité basée sur le machine learning (ML) qui utilise à la fois des signaux audio et textuels pour identifier et classer le contenu toxique basé sur la voix dans sept catégories, y compris le harcèlement sexuel, les discours de haine, les menaces, les abus, les blasphèmes, les insultes et le langage graphique . En plus du texte, Toxicity Detection utilise des indices vocaux tels que les tonalités et la hauteur pour affiner l'intention toxique dans la parole.

Il s'agit d'une amélioration par rapport aux systèmes de modération de contenu standard conçus pour se concentrer uniquement sur des termes spécifiques, sans tenir compte de l'intention. La plupart des entreprises ont un SLA de 7 à 15 jours pour examiner le contenu signalé par les utilisateurs, car les modérateurs doivent écouter de longs fichiers audio pour évaluer si et quand la conversation est devenue toxique. Avec Amazon Transcribe Toxicity Detection, les modérateurs n'examinent que la partie spécifique du fichier audio signalée pour contenu toxique (par rapport à l'intégralité du fichier audio). Le contenu que les modérateurs humains doivent examiner est réduit de 95 %, ce qui permet aux clients de réduire leur SLA à quelques heures seulement, ainsi que de modérer de manière proactive plus de contenu au-delà de ce qui est signalé par les utilisateurs. Il permettra aux entreprises de détecter et de modérer automatiquement le contenu à grande échelle, de fournir un environnement en ligne sûr et inclusif et de prendre des mesures avant qu'il ne cause un désabonnement des utilisateurs ou une atteinte à la réputation. Les modèles utilisés pour la détection de contenu toxique sont gérés par Amazon Transcribe et mis à jour périodiquement pour maintenir l'exactitude et la pertinence.

Dans cet article, vous apprendrez à :

- Identifiez le contenu préjudiciable dans la parole avec Amazon Transcribe Toxicity Detection

- Utiliser la console Amazon Transcribe pour la détection de toxicité

- Créez une tâche de transcription avec détection de toxicité à l'aide de Interface de ligne de commande AWS (AWS CLI) et SDK Python

- Utiliser la réponse de l'API de détection de toxicité d'Amazon Transcribe

Détecter la toxicité dans le chat audio avec Amazon Transcribe Toxicity Detection

Amazon Transcribe fournit désormais une solution simple basée sur ML pour signaler le langage nuisible dans les conversations parlées. Cette fonctionnalité est particulièrement utile pour les médias sociaux, les jeux et les besoins généraux, éliminant la nécessité pour les clients de fournir leurs propres données pour former le modèle ML. La détection de toxicité classe le contenu audio toxique dans les sept catégories suivantes et fournit un score de confiance (0-1) pour chaque catégorie :

- Impiété – Discours contenant des mots, des phrases ou des acronymes impolis, vulgaires ou offensants.

- Le discours de haine – Discours qui critique, insulte, dénonce ou déshumanise une personne ou un groupe sur la base d'une identité (comme la race, l'ethnie, le sexe, la religion, l'orientation sexuelle, les capacités et l'origine nationale).

- Sexuel – Discours qui indique un intérêt, une activité ou une excitation sexuelle en utilisant des références directes ou indirectes à des parties du corps, des traits physiques ou le sexe.

- Les insultes – Discours qui comprend un langage dégradant, humiliant, moqueur, insultant ou dénigrant. Ce type de langage est également qualifié d'intimidation.

- Violence ou menace – Discours qui comprend des menaces visant à infliger de la douleur, des blessures ou de l'hostilité envers une personne ou un groupe.

- Graphique – Discours qui utilise des images visuellement descriptives et désagréablement vives. Ce type de langage est souvent intentionnellement verbeux pour amplifier l'inconfort du destinataire.

- Harcèlement ou abus – Discours visant à affecter le bien-être psychologique du destinataire, y compris les termes dégradants et objectivants.

Vous pouvez accéder à Toxicity Detection via la console Amazon Transcribe ou en appelant les API directement à l'aide de l'AWS CLI ou des kits SDK AWS. Sur la console Amazon Transcribe, vous pouvez télécharger les fichiers audio dont vous souhaitez tester la toxicité et obtenir des résultats en quelques clics. Amazon Transcribe identifiera et catégorisera le contenu toxique, tel que le harcèlement, le discours de haine, le contenu sexuel, la violence, les insultes et les blasphèmes. Amazon Transcribe fournit également un score de confiance pour chaque catégorie, fournissant des informations précieuses sur le niveau de toxicité du contenu. La détection de toxicité est actuellement disponible dans l'API Amazon Transcribe standard pour le traitement par lots et prend en charge l'anglais américain.

Présentation de la console Amazon Transcribe

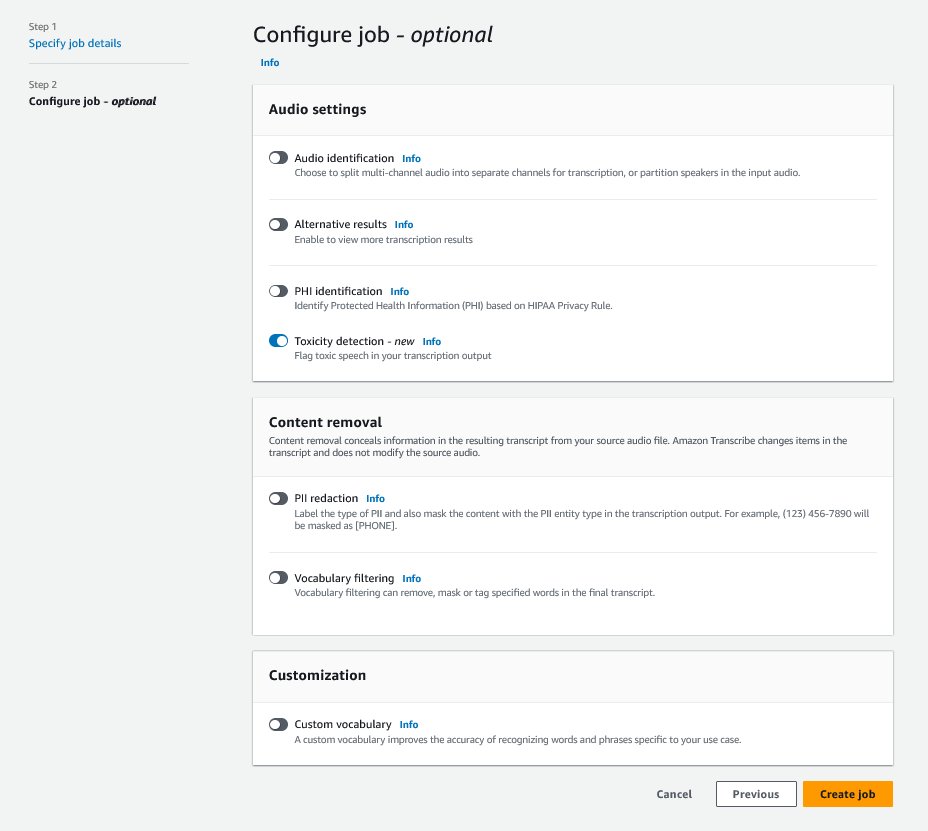

Pour commencer, connectez-vous au Console de gestion AWS et accédez à Amazon Transcribe. Pour créer une nouvelle tâche de transcription, vous devez télécharger vos fichiers enregistrés dans un Service de stockage simple Amazon (Amazon S3) avant qu'ils ne puissent être traités. Sur la page des paramètres audio, comme illustré dans la capture d'écran suivante, activez Détection de toxicité et procédez à la création du nouveau travail. Amazon Transcribe traitera la tâche de transcription en arrière-plan. Au fur et à mesure que le travail progresse, vous pouvez vous attendre à ce que le statut passe à TERMINÉ lorsque le processus est terminé.

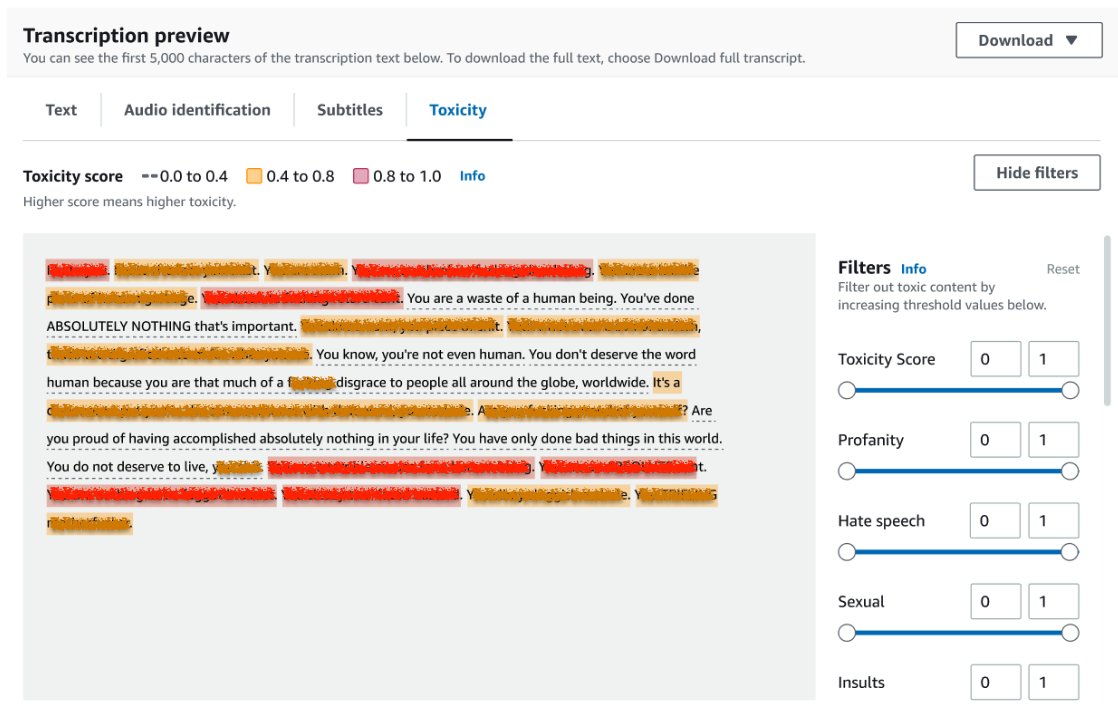

Pour consulter les résultats d'une tâche de transcription, choisissez la tâche dans la liste des tâches pour l'ouvrir. Faites défiler jusqu'à Aperçu de la transcription section pour vérifier les résultats sur le Phytotoxicité languette. L'interface utilisateur affiche des segments de transcription codés par couleur pour indiquer le niveau de toxicité, déterminé par le score de confiance. Pour personnaliser l'affichage, vous pouvez utiliser les barres de basculement dans le Filtre(s) vitre. Ces barres vous permettent d'ajuster les seuils et de filtrer les catégories de toxicité en conséquence.

La capture d'écran suivante a couvert des parties du texte de transcription en raison de la présence d'informations sensibles ou toxiques.

API de transcription avec une requête de détection de toxicité

Dans cette section, nous vous guidons dans la création d'une tâche de transcription avec détection de toxicité à l'aide d'interfaces de programmation. Si le fichier audio ne se trouve pas déjà dans un compartiment S3, chargez-le pour garantir l'accès par Amazon Transcribe. Comme pour la création d'une tâche de transcription sur la console, lors de l'appel de la tâche, vous devez fournir les paramètres suivants :

- TranscriptionJobName – Spécifiez un nom de travail unique.

- MediaFileUri – Entrez l'emplacement URI du fichier audio sur Amazon S3. Amazon Transcribe prend en charge les formats audio suivants : MP3, MP4, WAV, FLAC, AMR, OGG ou WebM

- CodeLangue - Mis à

en-US. Au moment d'écrire ces lignes, Toxicity Detection ne prend en charge que l'anglais américain. - Catégories de toxicité - Passe le

ALLvaleur pour inclure toutes les catégories de détection de toxicité prises en charge.

Voici des exemples de démarrage d'une tâche de transcription avec détection de toxicité activée à l'aide de Python3 :

Vous pouvez appeler la même tâche de transcription avec détection de toxicité à l'aide de la commande AWS CLI suivante :

API de transcription avec réponse de détection de toxicité

La sortie JSON de détection de toxicité d'Amazon Transcribe inclura les résultats de la transcription dans le champ des résultats. L'activation de la détection de toxicité ajoute un champ supplémentaire appelé toxicityDetection sous le champ des résultats. toxicityDetection inclut une liste d'éléments transcrits avec les paramètres suivants :

- texte – Le texte transcrit brut

- toxicité – Un score de confiance de détection (une valeur comprise entre 0 et 1)

- catégories – Un score de confiance pour chaque catégorie de discours toxique

- Heure de début – La position de début de détection dans le fichier audio (secondes)

- heure de fin – La position de fin de détection dans le fichier audio (secondes)

Voici un exemple de réponse de détection de toxicité abrégée que vous pouvez télécharger à partir de la console :

Résumé

Dans cet article, nous avons fourni un aperçu de la nouvelle fonctionnalité de détection de toxicité d'Amazon Transcribe. Nous avons également décrit comment vous pouvez analyser la sortie JSON de détection de toxicité. Pour plus d'informations, consultez la console Amazon Transcribe et essayez l'API de transcription avec détection de toxicité.

Amazon Transcribe Toxicity Detection est désormais disponible dans les régions AWS suivantes : USA Est (Ohio), USA Est (Virginie du Nord), USA Ouest (Oregon), Asie-Pacifique (Sydney), Europe (Irlande) et Europe (Londres). Pour en savoir plus, visitez Amazon Transcribe.

En savoir plus sur modération de contenu sur AWS et notre Modération de contenu Cas d'utilisation de ML. Faites le premier pas vers rationaliser vos opérations de modération de contenu avec AWS.

A propos de l'auteure

Lana Zhang est un architecte de solutions senior au sein de l'équipe AWS WWSO AI Services, spécialisé dans l'IA et le ML pour la modération de contenu, la vision par ordinateur et le traitement du langage naturel. Grâce à son expertise, elle se consacre à la promotion des solutions AWS AI/ML et à aider les clients à transformer leurs solutions commerciales dans divers secteurs, notamment les médias sociaux, les jeux, le commerce électronique, la publicité et le marketing.

Lana Zhang est un architecte de solutions senior au sein de l'équipe AWS WWSO AI Services, spécialisé dans l'IA et le ML pour la modération de contenu, la vision par ordinateur et le traitement du langage naturel. Grâce à son expertise, elle se consacre à la promotion des solutions AWS AI/ML et à aider les clients à transformer leurs solutions commerciales dans divers secteurs, notamment les médias sociaux, les jeux, le commerce électronique, la publicité et le marketing.

Sumit Kumar est chef de produit senior, technique au sein de l'équipe AWS AI Language Services. Il a 10 ans d'expérience en gestion de produits dans divers domaines et est passionné par l'IA/ML. En dehors du travail, Sumit adore voyager et aime jouer au cricket et au tennis sur gazon.

Sumit Kumar est chef de produit senior, technique au sein de l'équipe AWS AI Language Services. Il a 10 ans d'expérience en gestion de produits dans divers domaines et est passionné par l'IA/ML. En dehors du travail, Sumit adore voyager et aime jouer au cricket et au tennis sur gazon.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- :possède

- :est

- :ne pas

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- capacité

- Qui sommes-nous

- abus

- accès

- en conséquence

- Comptabilité

- précision

- à travers

- Action

- activités

- activité

- ajouter

- ajout

- Ajoute

- Numérique

- agressif

- AI

- Services d'IA

- AI / ML

- Tous

- permettre

- déjà

- aussi

- Bien que

- Amazon

- Amazon Transcribe

- Amazon Web Services

- parmi

- an

- ainsi que les

- Annoncer

- api

- Apis

- applications

- SONT

- AS

- Asie

- Asie-Pacifique

- assistant

- At

- usure

- acoustique

- Automatique

- automatiquement

- disponibles

- AWS

- fond

- barres

- base

- BE

- est devenu

- car

- before

- humain

- jusqu'à XNUMX fois

- Au-delà

- corps

- tous les deux

- Pause

- l'intimidation

- la performance des entreprises

- by

- appelé

- appel

- CAN

- aptitude

- catégories

- Catégories

- Causes

- Change

- vérifier

- Selectionnez

- Classer

- Communication

- Communautés

- Sociétés

- complet

- Complété

- ordinateur

- Vision par ordinateur

- confiance

- Console

- contient

- contenu

- Conversation

- conversations

- couvert

- engendrent

- La création

- cricket

- Critique

- Lecture

- Clients

- personnaliser

- données

- jours

- dévoué

- décrit

- un

- détecter

- Détection

- déterminé

- mobiles

- directement

- Commande

- plusieurs

- domaines

- down

- download

- deux

- e-commerce

- chacun

- Est

- Easy

- non plus

- l'élimination

- permettre

- activé

- permettant

- fin

- Anglais

- assurer

- Entrer

- entreprises

- Tout

- Environment

- notamment

- ethnicité

- Europe

- évaluer

- exemple

- exemples

- excité

- attendre

- cher

- d'experience

- nous a permis de concevoir

- supplémentaire

- faciliter

- Échoué

- Fonctionnalité

- few

- champ

- Déposez votre dernière attestation

- Fichiers

- une fonction filtre

- extrémités

- Prénom

- marqué

- Focus

- Abonnement

- Pour

- friendly

- de

- jeux

- Genre

- Général

- obtenez

- Go

- Goes

- Graphique

- Réservation de groupe

- guide

- nuisible

- Vous avez

- he

- aide

- ici

- ici

- Haute

- HEURES

- Comment

- How To

- Cependant

- HTML

- http

- HTTPS

- humain

- identifier

- Identite

- if

- impact

- importer

- amélioration

- in

- comprendre

- inclut

- Y compris

- Compris

- Améliore

- indiquer

- indique

- secteurs

- d'information

- idées.

- Insulter

- prévu

- intention

- Intention

- intentionnellement

- intérêt

- interfaces

- développement

- Irlande

- IT

- articles

- Emploi

- jpg

- json

- juste

- XNUMX éléments à

- langue

- conduire

- APPRENTISSAGE

- apprentissage

- Niveau

- Gamme

- Liste

- emplacement

- London

- aime

- click

- machine learning

- maintenir

- FAIT DU

- gestion

- manager

- de nombreuses

- Stratégie

- Médias

- Découvrez

- ML

- modèle

- numériques jumeaux (digital twin models)

- modération

- PLUS

- (en fait, presque toutes)

- must

- prénom

- Nationales

- Nature

- Traitement du langage naturel

- Besoin

- Besoins

- de mise en réseau

- Nouveauté

- maintenant

- of

- code

- souvent

- Ohio

- on

- en ligne

- jeux en ligne

- uniquement

- ouvert

- Opérations

- or

- Oregon

- organisations

- origine

- nos

- ande

- sortie

- au contrôle

- vue d'ensemble

- propre

- Pacifique

- page

- Pain

- paramètres

- participer

- les pièces

- pass

- passionné

- personne

- les expressions clés

- Physique

- Emplacement

- Platon

- Intelligence des données Platon

- PlatonDonnées

- jouer

- partieInvestir dans des appareils économes en énergie et passer à l'éclairage

- position

- Post

- présence

- d'ouvrabilité

- processus

- Traité

- traitement

- Produit

- gestion des produits

- chef de produit

- IMPIÉTÉ

- Programmation

- la promotion de

- fournir

- à condition de

- fournit

- aportando

- Python

- qualité

- Race

- Tarifs

- raw

- solutions

- reconnaissance

- enregistré

- réduire

- Prix Réduit

- régions

- régulateurs

- pertinence

- religion

- compter

- Signalé

- réponse

- résultat

- Résultats

- Avis

- examen

- Analyse

- des

- même

- Escaliers intérieurs

- mise à l'échelle

- les escroqueries

- But

- volute

- SDK

- secondes

- Section

- recherche

- clignotant

- segments

- supérieur

- sensible

- service

- Services

- set

- Paramétres

- sept

- Relations sexuelles

- Sexuel

- Partager

- elle

- montré

- Spectacles

- signer

- similaires

- étapes

- Réseaux sociaux

- réseaux sociaux

- Le réseautage social

- uniquement

- sur mesure

- Solutions

- spécialisation

- groupe de neurones

- discours

- Reconnaissance vocale

- parole-texte

- vitesse

- parlé

- Standard

- Commencer

- j'ai commencé

- Commencez

- Statut

- étapes

- storage

- tel

- suffisant

- Appareils

- Les soutiens

- sydney

- Système

- Prenez

- parlant

- équipe

- Technique

- conditions

- tester

- qui

- Les

- leur

- Les

- Ces

- l'ont

- this

- des menaces

- Avec

- fiable

- à

- aujourd'hui

- vers

- vers

- Train

- transformer

- Voyage

- oui

- Essai

- type

- ui

- sous

- expérience unique et authentique

- Non sollicité

- a actualisé

- us

- utilisé

- d'utiliser

- Utilisateur

- utilisateurs

- Usages

- en utilisant

- Précieux

- Plus-value

- variété

- via

- Violence

- Virginie

- vision

- Visiter

- Voix

- vs

- vulgaire

- attendez

- souhaitez

- we

- web

- services Web

- WELL

- Ouest

- quand

- tout en

- sera

- comprenant

- sans

- des mots

- activités principales

- écriture

- années

- encore

- Vous n'avez

- Votre

- zéphyrnet