L'ingénierie rapide est devenue une compétence essentielle pour quiconque travaille avec de grands modèles de langage (LLM) afin de générer des textes pertinents et de haute qualité. Bien que l’ingénierie des invites textuelles ait été largement discutée, l’ingénierie des invites visuelles est un domaine émergent qui nécessite une attention particulière. Les invites visuelles peuvent inclure des cadres de délimitation ou des masques qui guident les modèles de vision dans la génération de résultats pertinents et précis. Dans cet article, nous explorons les bases de l'ingénierie des invites visuelles, ses avantages et comment elle peut être utilisée pour résoudre un cas d'utilisation spécifique : la segmentation d'images pour la conduite autonome.

Ces dernières années, le domaine de la vision par ordinateur a connu des progrès significatifs dans le domaine de la segmentation des images. Une de ces percées est la Segmenter n'importe quel modèle (SAM) par Meta AI, qui a le potentiel de révolutionner la segmentation au niveau des objets avec une formation à zéro ou à quelques tirs. Dans cet article, nous utilisons le modèle SAM comme exemple de modèle de vision de base et explorons son application au Ensemble de données BDD100K, un ensemble de données de conduite autonome diversifié pour un apprentissage multitâche hétérogène. En combinant les atouts de SAM avec les riches données fournies par BDD100K, nous montrons le potentiel de l'ingénierie des invites visuelles avec différentes versions de SAM. Inspiré par le LangChaîne cadre pour les modèles de langage, nous proposons une chaîne visuelle pour effectuer des invites visuelles en combinant des modèles de détection d'objets avec SAM.

Bien que cet article se concentre sur la conduite autonome, les concepts abordés sont largement applicables aux domaines qui ont de riches applications basées sur la vision, tels que les soins de santé et les sciences de la vie, ainsi que les médias et le divertissement. Commençons par en apprendre un peu plus sur ce qui se cache derrière un modèle de vision fondamental comme SAM. Nous avons utilisé Amazon SageMakerStudio sur une instance ml.g5.16xlarge pour ce post.

Segmenter n'importe quel modèle (SAM)

Les modèles de base sont de grands modèles d'apprentissage automatique (ML) formés sur une grande quantité de données et peuvent être déclenchés ou affinés pour des cas d'utilisation spécifiques à des tâches. Ici, nous explorons le Segment Anything Model (SAM), qui est un modèle fondamental pour la vision, en particulier la segmentation d'images. Il est pré-entraîné sur un ensemble de données massif de 11 millions d'images et 1.1 milliard de masques, ce qui en fait le plus grand ensemble de données de segmentation au moment de la rédaction. Ce vaste ensemble de données couvre un large éventail d'objets et de catégories, fournissant à SAM une source de données de formation diversifiée et à grande échelle.

Le modèle SAM est formé pour comprendre les objets et peut générer des masques de segmentation pour n'importe quel objet dans des images ou des images vidéo. Le modèle permet une ingénierie d'invite visuelle, vous permettant de fournir des entrées telles que du texte, des points, des cadres de délimitation ou des masques pour générer des étiquettes sans altérer l'image d'origine. SAM est disponible en trois tailles : base (ViT-B, 91 millions de paramètres), grande (ViT-L, 308 millions de paramètres) et énorme (ViT-H, 636 millions de paramètres), répondant à différentes exigences de calcul et cas d'utilisation.

La principale motivation derrière SAM est d'améliorer la segmentation au niveau des objets avec un minimum d'échantillons et d'époques de formation pour tout objet d'intérêt. La puissance de SAM réside dans sa capacité à s'adapter à de nouvelles distributions d'images et à de nouvelles tâches sans connaissances préalables, une fonctionnalité connue sous le nom de transfert sans tir. Cette adaptabilité est obtenue grâce à sa formation sur le vaste ensemble de données SA-1B, qui a démontré des performances impressionnantes sans tir, surpassant de nombreux résultats antérieurs entièrement supervisés.

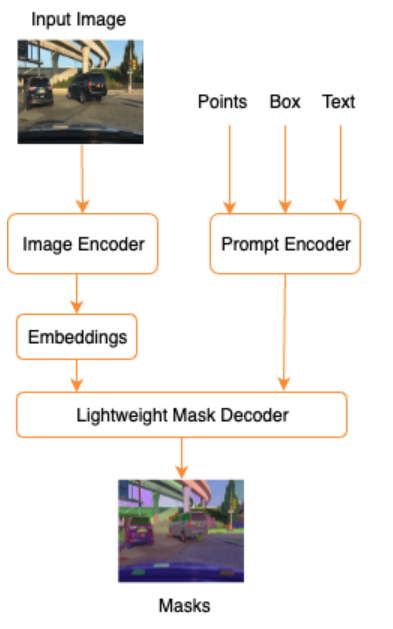

Comme le montre l'architecture suivante pour SAM, le processus de génération de masques de segmentation implique trois étapes :

- Un encodeur d'image produit une intégration unique pour l'image.

- Un encodeur d'invite convertit n'importe quelle invite en un vecteur d'intégration pour l'invite.

- Le décodeur léger combine les informations de l'encodeur d'image et de l'encodeur d'invite pour prédire les masques de segmentation.

À titre d'exemple, nous pouvons fournir une entrée avec une image et un cadre de délimitation autour d'un objet d'intérêt dans cette image (par exemple, une voiture Silver ou une voie de circulation) et le modèle SAM produirait des masques de segmentation pour cet objet.

Ingénierie des invites visuelles

L'ingénierie rapide fait référence à la structuration des entrées d'un modèle qui permet au modèle de comprendre l'intention et de produire le résultat souhaité. Grâce à l'ingénierie des invites textuelles, vous pouvez structurer le texte saisi en effectuant des modifications telles que le choix des mots, le formatage, l'ordre, etc., pour obtenir le résultat souhaité. L'ingénierie des invites visuelles suppose que l'utilisateur travaille dans une modalité visuelle (image ou vidéo) et fournit des entrées. Voici une liste non exhaustive de moyens potentiels de contribuer au modèle d’IA générative dans le domaine visuel :

- Point – Un point de coordonnées singulier (x, y) dans le plan de l'image

- Points – Plusieurs points de coordonnées (x, y), pas nécessairement liés les uns aux autres

- Boîte englobante – Un ensemble de quatre valeurs (x, y, w, h) qui définissent une région rectangulaire dans le plan de l'image

- Contour – Un ensemble de points de coordonnées (x, y) dans le plan de l'image qui forment une forme fermée

- Masque – Un tableau de la même taille que l'image avec un masque partiel de l'objet d'intérêt

En gardant à l’esprit les techniques d’ingénierie des invites visuelles, explorons comment cela peut être appliqué au modèle pré-entraîné SAM. Nous avons utilisé la version de base du modèle pré-entraîné.

Invite de tir zéro avec le modèle SAM pré-entraîné

Pour commencer, explorons l’approche du tir zéro. Ce qui suit est un exemple d’image de l’ensemble de données d’entraînement pris à partir de la caméra avant d’un véhicule.

Nous pouvons obtenir des masques de segmentation pour tous les objets de l'image sans aucune invite visuelle explicite en générer automatiquement des masques avec juste une image d'entrée. Dans l'image suivante, nous voyons des parties de la voiture, de la route, des panneaux de signalisation, des plaques d'immatriculation, du survol, des piliers, des panneaux, etc., segmentés.

Cependant, cette sortie n’est pas immédiatement utile pour les raisons suivantes :

- Les voitures ne sont pas segmentées dans leur ensemble, mais par parties. Pour la plupart des modèles de perception, par exemple, nous ne nous soucions pas vraiment du fait que chacun des pneus ait des masques de sortie séparés. Cela est également vrai lorsque vous recherchez d'autres objets d'intérêt connus, tels que des routes, de la végétation, des panneaux, etc.

- Les parties de l'image utiles pour les tâches en aval, comme la zone pilotable, sont divisées, sans aucune explication. D'un autre côté, les instances similaires sont identifiées séparément, et nous pourrions être intéressés par regrouper des objets similaires (segmentation panoptique ou segmentation d'instance).

Ingénierie d'invite visuelle avec le modèle SAM pré-entraîné

Heureusement, SAM prend en charge la fourniture d'invites de saisie et nous pouvons utiliser des points, des tableaux de points et des cadres de délimitation comme entrées. Avec ces instructions spécifiques, nous espérons que SAM fera mieux avec les segmentations axées sur des points ou des zones spécifiques. Cela peut être comparé au modèle d'invite de langue"What is a good name for a company that makes {product}?"

où l'entrée avec ce modèle d'invite de l'utilisateur est le {product}. {product} est un emplacement d'entrée. Dans les invites visuelles, les cadres de délimitation, les points ou les masques sont les emplacements d'entrée.

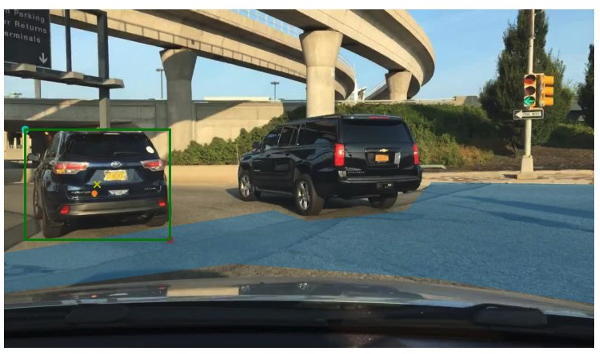

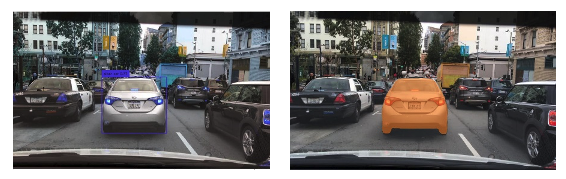

L'image suivante fournit le cadre de délimitation de la vérité terrain d'origine autour des véhicules et le patch de zone praticable à partir des données de vérité terrain BDD100K. L'image montre également un point d'entrée (un X jaune) au centre du cadre de délimitation vert auquel nous ferons référence dans les prochaines sections.

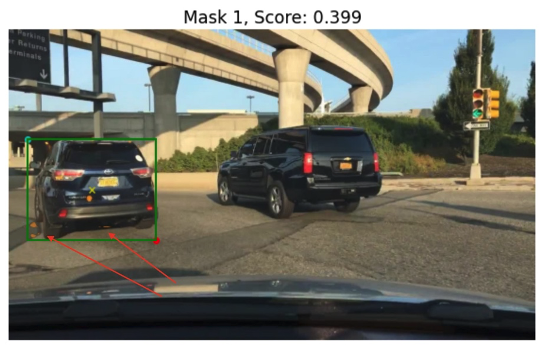

Essayons de générer un masque pour la voiture de gauche avec le cadre de délimitation vert comme entrée dans SAM. Comme le montre l'exemple suivant, le modèle de base de SAM ne trouve vraiment rien. Cela se voit également dans le faible score de segmentation. Lorsque nous examinons les masques de segmentation de plus près, nous constatons qu'il existe de petites régions renvoyées sous forme de masques (pointées vers l'aide de flèches rouges) qui ne sont pas vraiment utilisables pour une application en aval.

Essayons une combinaison d'un cadre de délimitation et d'un point comme invite visuelle d'entrée. La croix jaune dans l'image précédente est le centre du cadre de délimitation. Fournir les coordonnées (x, y) de ce point comme invite avec la contrainte de boîte englobante nous donne le masque suivant et un score légèrement plus élevé. Ce n’est toujours pas utilisable par aucun moyen.

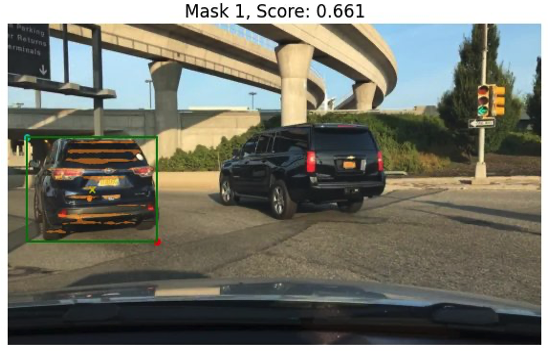

Enfin, avec le modèle de base pré-entraîné, nous pouvons fournir uniquement le point d'entrée sous forme d'invite (sans le cadre de délimitation). Les images suivantes montrent deux des trois masques les plus intéressants.

Le masque 1 segmente la voiture complète, tandis que le masque 3 segmente une zone qui maintient la plaque d'immatriculation de la voiture près de la croix jaune (invite de saisie). Le masque 1 n’est toujours pas un masque étanche et propre autour de la voiture ; cela indique la qualité du modèle, qui, nous pouvons supposer, augmente avec la taille du modèle.

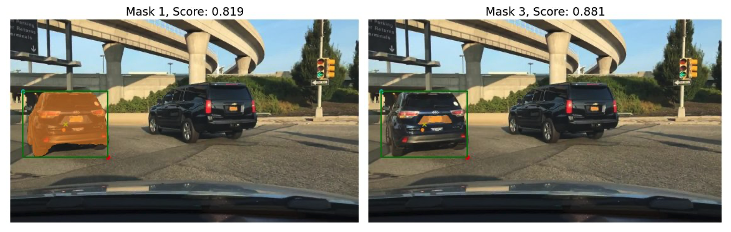

Nous pouvons essayer des modèles pré-entraînés plus grands avec la même invite de saisie. Les images suivantes montrent nos résultats. Lorsque vous utilisez l'énorme modèle pré-entraîné SAM, le masque 3 représente la voiture entière, tandis que les masques 1 et 2 peuvent être utilisés pour extraire la plaque d'immatriculation.

La grande version du modèle SAM fournit également des résultats similaires.

Le processus que nous avons suivi ici est similaire à l’ingénierie manuelle des invites textuelles que vous connaissez peut-être déjà. Notez qu'une amélioration récente du modèle SAM pour segmenter tout ce qui est en haute qualité fournit de bien meilleures sorties spécifiques aux objets et au contexte. Dans notre cas, nous constatons que les invites zéro avec des invites textuelles et visuelles (saisies de point, de boîte et de point et de boîte) n'améliorent pas considérablement les résultats comme nous l'avons vu ci-dessus.

Modèles d'invite et chaînes visuelles

Comme nous pouvons le voir dans les exemples de tir zéro précédents, SAM a du mal à identifier tous les objets de la scène. C'est un bon exemple de la façon dont nous pouvons tirer parti des modèles d'invite et des chaînes visuelles. La chaîne visuelle s'inspire du concept de chaîne du framework LangChain populaire pour les applications linguistiques. Il permet d'enchaîner les sources de données et un LLM pour produire le résultat. Par exemple, nous pouvons utiliser une chaîne API pour appeler une API et invoquer un LLM pour répondre à la question en fonction de la réponse de l'API.

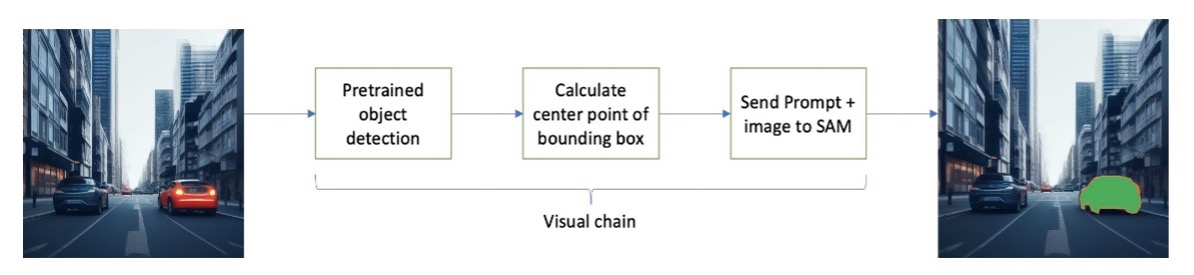

Inspiré de LangChain, nous proposons une chaîne visuelle séquentielle qui ressemble à la figure suivante. Nous utilisons un outil (comme un modèle de détection d'objets pré-entraîné) pour obtenir les cadres de délimitation initiaux, calculer le point au centre du cadre de délimitation et l'utiliser pour inviter le modèle SAM avec l'image d'entrée.

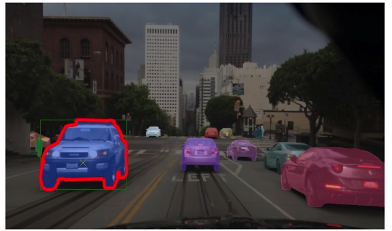

Par exemple, l'image suivante montre les masques de segmentation résultant de l'exécution de cette chaîne.

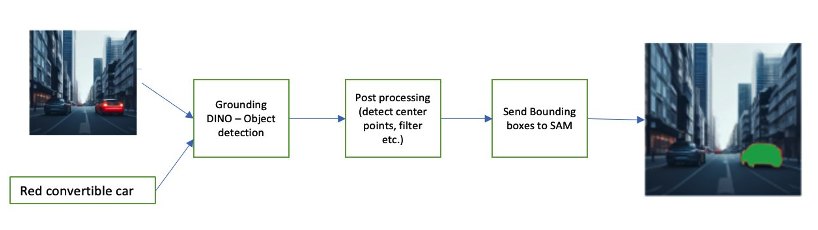

Un autre exemple de chaîne peut impliquer une saisie de texte de l'objet que l'utilisateur souhaite identifier. Pour implémenter cela, nous avons construit un pipeline en utilisant Mise à la terre de DINO, un modèle de détection d'objets pour demander à SAM une segmentation.

Grounding DINO est un modèle de détection d'objets sans tir qui peut effectuer une détection d'objets avec du texte fournissant des noms de catégories (tels que « feux de circulation » ou « camion ») et des expressions (telles que « camion jaune »). Il accepte des paires de texte et d'image pour effectuer la détection d'objet. Il est basé sur une architecture de transformateur et permet des modalités croisées avec des données texte et image. Pour en savoir plus sur Grounding DINO, reportez-vous à Grounding DINO : marier DINO avec une pré-formation Grounded pour la détection d'objets en espace ouvert. Cela génère des cadres de délimitation et des étiquettes et peut être traité davantage pour générer des points centraux, un filtre basé sur des étiquettes, des seuils, etc. Ceci est utilisé (boîtes ou points) comme invite à SAM pour la segmentation, qui génère des masques.

Voici quelques exemples illustrant le texte d'entrée, la sortie DINO (cadres de délimitation) et la sortie SAM finale (masques de segmentation).

Les images suivantes montrent la sortie du « camion jaune ».

Les images suivantes montrent la sortie de « voiture argentée ».

L'image suivante montre le résultat de « voie de circulation ».

Nous pouvons utiliser ce pipeline pour créer une chaîne visuelle. L'extrait de code suivant explique ce concept :

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')Bien qu'il s'agisse d'un exemple simple, ce concept peut être étendu pour traiter les flux des caméras des véhicules afin d'effectuer le suivi des objets, la rédaction de données d'informations personnelles identifiables (PII), et bien plus encore. Nous pouvons également obtenir les cadres de délimitation à partir de modèles plus petits ou, dans certains cas, à l'aide d'outils de vision par ordinateur standard. Il est assez simple d'utiliser un modèle pré-entraîné ou un service comme Amazon Rekognition pour obtenir les étiquettes (visuelles) initiales de votre invite. Au moment d'écrire ces lignes, il existe plus de 70 modèles disponibles sur Amazon SageMaker Jumpstart pour la détection d'objets, et Amazon Reconnaissance identifie déjà plusieurs catégories utiles d'objets dans les images, notamment les voitures, les piétons et autres véhicules.

Nous examinons ensuite quelques résultats quantitatifs liés aux performances des modèles SAM avec un sous-ensemble de données BDD100K.

Résultats quantitatifs

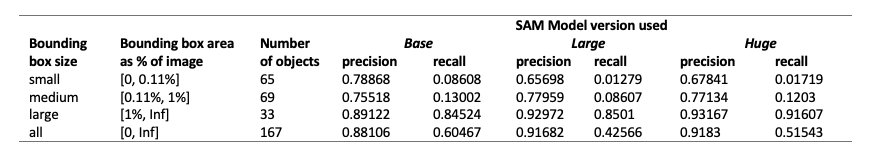

Notre objectif est de comparer les performances de trois modèles pré-entraînés lorsqu'ils reçoivent la même invite visuelle. Dans ce cas, nous utilisons le point central de l'emplacement de l'objet comme entrée visuelle. Nous comparons les performances par rapport aux tailles d'objet (proportionnellement à la taille de l'image) : petite (surface <0.11 %), moyenne (0.11 % < surface < 1 %) et grande (surface > 1 %). Les seuils de zone de délimitation sont définis par le Common Objects in Context (COCO) métriques d'évaluation [Lin et al., 2014].

L'évaluation se fait au niveau du pixel et nous utilisons les métriques d'évaluation suivantes :

- Précision = (nombre d'instances pertinentes et récupérées) / (nombre total d'instances récupérées)

- Rappel = (nombre d'instances pertinentes et récupérées) / (nombre total d'instances pertinentes)

- Les instances ici sont chaque pixel dans la zone de délimitation de l'objet d'intérêt

Le tableau suivant présente les performances de trois versions différentes du modèle SAM (de base, grande et énorme). Ces versions disposent de trois encodeurs différents : ViT-B (base), ViT-L (grand), ViT-H (énorme). Les encodeurs ont un nombre de paramètres différent, le modèle de base ayant moins de paramètres que grand, et grand étant moins qu'énorme. Bien que l’augmentation du nombre de paramètres entraîne une amélioration des performances avec des objets plus grands, ce n’est pas le cas pour les objets plus petits.

Ajuster SAM à votre cas d'utilisation

Dans de nombreux cas, l’utilisation directe d’un modèle SAM pré-entraîné peut ne pas être très utile. Par exemple, regardons une scène typique de trafic : l'image suivante est la sortie du modèle SAM avec des points d'invite échantillonnés de manière aléatoire en entrée à gauche, et les étiquettes réelles de la tâche de segmentation sémantique de BDD100K à droite. Ceux-ci sont évidemment très différents.

Les piles de perception dans les AV peuvent facilement utiliser la deuxième image, mais pas la première. D'un autre côté, certains résultats utiles de la première image peuvent être utilisés et sur lesquels le modèle n'a pas été explicitement entraîné, par exemple le marquage des voies, la segmentation des trottoirs, les masques de plaques d'immatriculation, etc. Nous pouvons affiner le modèle SAM pour améliorer les résultats de segmentation. Pour effectuer ce réglage fin, nous avons créé un ensemble de données de formation à l'aide d'un sous-ensemble de segmentation d'instance (500 images) de l'ensemble de données BDD10K. Il s'agit d'un très petit sous-ensemble d'images, mais notre objectif est de prouver que les modèles de vision fondamentaux (un peu comme les LLM) peuvent bien fonctionner pour votre cas d'utilisation avec un nombre étonnamment petit d'images. L'image suivante montre l'image d'entrée, le masque de sortie (en bleu, avec une bordure rouge pour la voiture à gauche) et les invites possibles (cadre de délimitation en vert et point central X en jaune).

Nous avons effectué des réglages fins à l'aide de la bibliothèque Hugging Face sur Amazon SageMakerStudio. Nous avons utilisé l'instance ml.g4dn.xlarge pour les tests du modèle de base SAM et ml.g4dn.2xlarge pour les tests du modèle géant SAM. Lors de nos premières expériences, nous avons observé que l’ajustement fin du modèle de base avec uniquement des cadres de délimitation n’a pas abouti. Les modèles affinés et pré-entraînés n’ont pas été en mesure d’apprendre les masques de vérité terrain spécifiques aux voitures à partir des ensembles de données d’origine. L'ajout de points de requête au réglage fin n'a pas non plus amélioré la formation.

Ensuite, nous pouvons essayer d'affiner le modèle énorme SAM pour 30 époques, avec un très petit ensemble de données (500 images). Le masque de vérité terrain d'origine ressemble à l'image suivante pour la voiture de type étiquette.

Comme le montrent les images suivantes, la version originale pré-entraînée du modèle énorme avec une invite de boîte englobante spécifique (en vert) ne donne aucune sortie, tandis que la version affinée donne une sortie (toujours pas précise mais le réglage a été supprimé désactivé après 40 époques et avec un très petit ensemble de données d'entraînement de 500 images). Le modèle énorme original, pré-entraîné, n'était pas en mesure de prédire les masques pour aucune des images que nous avons testées. À titre d'exemple d'application en aval, le modèle affiné peut être utilisé dans des flux de travail de pré-étiquetage tels que celui décrit dans Module d'étiquetage automatique pour les systèmes avancés d'aide à la conduite basés sur l'apprentissage profond sur AWS.

Conclusion

Dans cet article, nous avons discuté du modèle de vision fondamental connu sous le nom de Segment Anything Model (SAM) et de son architecture. Nous avons utilisé le modèle SAM pour discuter des invites visuelles et des différentes entrées dans l'ingénierie des invites visuelles. Nous avons exploré le fonctionnement des différentes invites visuelles et leurs limites. Nous avons également décrit comment les chaînes visuelles augmentent les performances par rapport à l'utilisation d'une seule invite, similaire à l'API LangChain. Ensuite, nous avons fourni une évaluation quantitative de trois modèles pré-entraînés. Enfin, nous avons discuté du modèle SAM affiné et de ses résultats par rapport au modèle de base original. Le réglage fin des modèles de base permet d'améliorer les performances du modèle pour des tâches spécifiques telles que la segmentation. Il convient de noter que le modèle SAM, en raison de ses besoins en ressources, limite son utilisation pour les cas d'utilisation en temps réel et l'inférence à la périphérie dans son état actuel. Nous espérons qu’avec les itérations futures et les techniques améliorées, cela réduira les besoins de calcul et améliorera la latence.

Nous espérons que cet article vous encouragera à explorer les invites visuelles pour vos cas d'utilisation. Comme il s’agit encore d’une forme émergente d’ingénierie des invites, il y a beaucoup à découvrir en termes d’invites visuelles, de chaînes visuelles et de performances de ces outils. Amazon Sage Maker est une plate-forme ML entièrement gérée qui permet aux constructeurs d'explorer de grands modèles linguistiques et visuels et de créer des applications d'IA génératives. Commencez dès aujourd'hui à construire l'avenir avec AWS.

À propos des auteurs

Gopi Krishnamurthy est architecte principal de solutions AI/ML chez Amazon Web Services basé à New York. Il travaille avec de grands clients automobiles en tant que conseiller de confiance pour transformer leurs charges de travail d'apprentissage automatique et migrer vers le cloud. Ses principaux intérêts incluent l'apprentissage en profondeur et les technologies sans serveur. En dehors du travail, il aime passer du temps avec sa famille et explorer un large éventail de musiques.

Gopi Krishnamurthy est architecte principal de solutions AI/ML chez Amazon Web Services basé à New York. Il travaille avec de grands clients automobiles en tant que conseiller de confiance pour transformer leurs charges de travail d'apprentissage automatique et migrer vers le cloud. Ses principaux intérêts incluent l'apprentissage en profondeur et les technologies sans serveur. En dehors du travail, il aime passer du temps avec sa famille et explorer un large éventail de musiques.

Shreyas Subramanien est un architecte de solutions spécialisé principal en IA/ML et aide les clients en utilisant l'apprentissage automatique à résoudre leurs défis commerciaux à l'aide de la plate-forme AWS. Shreyas a une formation en optimisation à grande échelle et en apprentissage automatique, et dans l'utilisation de l'apprentissage automatique et de l'apprentissage par renforcement pour accélérer les tâches d'optimisation.

Shreyas Subramanien est un architecte de solutions spécialisé principal en IA/ML et aide les clients en utilisant l'apprentissage automatique à résoudre leurs défis commerciaux à l'aide de la plate-forme AWS. Shreyas a une formation en optimisation à grande échelle et en apprentissage automatique, et dans l'utilisation de l'apprentissage automatique et de l'apprentissage par renforcement pour accélérer les tâches d'optimisation.

Sujitha Martin est chercheur appliqué au Generative AI Innovation Center (GAIIC). Son expertise réside dans la création de solutions d'apprentissage automatique impliquant la vision par ordinateur et le traitement du langage naturel pour divers secteurs industriels. En particulier, elle possède une vaste expérience de travail sur la conscience de la situation centrée sur l’humain et l’apprentissage infusé de connaissances pour les systèmes hautement autonomes.

Sujitha Martin est chercheur appliqué au Generative AI Innovation Center (GAIIC). Son expertise réside dans la création de solutions d'apprentissage automatique impliquant la vision par ordinateur et le traitement du langage naturel pour divers secteurs industriels. En particulier, elle possède une vaste expérience de travail sur la conscience de la situation centrée sur l’humain et l’apprentissage infusé de connaissances pour les systèmes hautement autonomes.

Francisco Calderón est Data Scientist au Generative AI Innovation Center (GAIIC). En tant que membre du GAIIC, il fait découvrir l'art du possible aux clients AWS en utilisant les technologies d'IA générative. Dans ses temps libres, Francisco aime jouer de la musique et de la guitare, jouer au football avec ses filles et passer du temps avec sa famille.

Francisco Calderón est Data Scientist au Generative AI Innovation Center (GAIIC). En tant que membre du GAIIC, il fait découvrir l'art du possible aux clients AWS en utilisant les technologies d'IA générative. Dans ses temps libres, Francisco aime jouer de la musique et de la guitare, jouer au football avec ses filles et passer du temps avec sa famille.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- :possède

- :est

- :ne pas

- :où

- $UP

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- capacité

- Capable

- A Propos

- au dessus de

- accélérer

- Accepte

- Avec cette connaissance vient le pouvoir de prendre

- atteint

- présenter

- adapter

- ajoutant

- Avancée

- progrès

- Avantage

- conseiller

- Après

- AI

- AI / ML

- AL

- Tous

- permet

- le long de

- déjà

- aussi

- Bien que

- Amazon

- Amazon Reconnaissance

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- et de

- répondre

- tous

- chacun.e

- quoi que ce soit d'artificiel

- api

- en vigueur

- Application

- applications

- appliqué

- une approche

- architecture

- SONT

- Réservé

- domaines

- autour

- tableau

- Art

- AS

- Assistance

- assumer

- suppose

- At

- précaution

- l'automobile

- autonome

- disponibles

- AWS

- fond

- base

- basé

- Basics

- BE

- car

- devenez

- était

- commencer

- derrière

- avantages.

- Améliorée

- Milliards

- Bleu

- frontière

- Box

- boîtes

- percée

- largement

- construire

- constructeurs

- Développement

- construit

- la performance des entreprises

- mais

- by

- calculer

- Appelez-nous

- appareil photo

- de CAMÉRAS de surveillance

- CAN

- Peut obtenir

- fournisseur

- les soins

- voitures

- maisons

- cas

- catégories

- Catégories

- VIP gastronomie à bord,

- Canaux centraux

- chaîne

- Chaînes

- globaux

- le choix

- Ville

- espace extérieur plus propre,

- Fermer

- fonds à capital fermé

- étroitement

- le cloud

- noix de coco

- code

- combinaison

- moissonneuses-batteuses

- combinant

- Commun

- Société

- comparer

- par rapport

- calcul

- calcul

- ordinateur

- Vision par ordinateur

- concept

- concepts

- contexte

- coordonner

- Core

- Housses

- créée

- Cross

- Courant

- État actuel

- Clients

- Cut/Taille

- données

- Data Scientist

- ensembles de données

- profond

- l'apprentissage en profondeur

- Vous permet de définir

- défini

- démontré

- décrit

- voulu

- Détection

- différent

- dino

- directement

- découvrez

- discuter

- discuté

- distributions

- plusieurs

- do

- Ne fait pas

- domaine

- domaines

- Ne pas

- drastiquement

- driver

- conduite

- deux

- e

- E & T

- chacun

- même

- Edge

- enrobage

- économies émergentes.

- permet

- permettant

- encourage

- ENGINEERING

- Divertissement

- Tout

- époques

- essential

- évaluation

- exemple

- exemples

- expansif

- attendre

- d'experience

- expériences

- nous a permis de concevoir

- Explique

- explication

- explicitement

- explorez

- Exploré

- expressions

- les

- Une vaste expérience

- extrait

- Visage

- équitablement

- familier

- famille

- Fonctionnalité

- few

- champ

- Figure

- une fonction filtre

- finale

- Trouvez

- Prénom

- se concentre

- mettant l'accent

- Abonnement

- Pour

- formulaire

- Fondation

- Fondationale

- quatre

- Framework

- Francisco

- De

- avant

- plein

- d’étiquettes électroniques entièrement

- plus

- avenir

- générer

- génère

- générateur

- génératif

- IA générative

- obtenez

- donné

- donne

- Bien

- Vert

- Sol

- guide

- main

- Vous avez

- ayant

- he

- la médecine

- aide

- ici

- ici

- Haute

- de haute qualité

- augmentation

- très

- sa

- détient

- capuche

- d'espérance

- Comment

- HTML

- HTTPS

- majeur

- identifié

- identifie

- identifier

- identifier

- image

- satellite

- immédiatement

- Mettre en oeuvre

- impressionnant

- améliorer

- amélioré

- amélioration

- in

- comprendre

- Y compris

- Améliore

- Augmente

- croissant

- industrie

- d'information

- infusé

- initiale

- Innovation

- contribution

- entrées

- inspiré

- instance

- Segmentation d'instance

- Des instructions

- intention

- intérêt

- intéressé

- intéressant

- intérêts

- développement

- impliquer

- impliquant

- IT

- itérations

- SES

- jpg

- juste

- juste un

- spécialisées

- connu

- Libellé

- Etiquettes

- Voie

- langue

- gros

- grande échelle

- plus importantes

- le plus grand

- enfin

- Latence

- APPRENTISSAGE

- apprentissage

- à gauche

- moins

- Niveau

- Bibliothèque

- Licence

- se trouve

- VIE

- Life Sciences

- léger

- comme

- aime

- limites

- limites

- lin

- Liste

- peu

- LLM

- emplacement

- Style

- recherchez-

- LOOKS

- Faible

- click

- machine learning

- FAIT DU

- Fabrication

- gérés

- Manuel

- de nombreuses

- se marier

- masque

- Masques

- massif

- Mai..

- veux dire

- Médias

- moyenne

- membre

- Meta

- Métrique

- émigrer

- million

- l'esprit

- minimal

- ML

- modèle

- numériques jumeaux (digital twin models)

- Modifications

- Module

- PLUS

- (en fait, presque toutes)

- motivation

- beaucoup

- plusieurs

- Musique

- prénom

- noms

- Nature

- Traitement du langage naturel

- nécessairement

- Nouveauté

- New York

- New York City

- next

- aucune

- noté

- nombre

- objet

- Détection d'objet

- objectif

- objets

- of

- de rabais

- on

- ONE

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- or

- original

- Autre

- nos

- ande

- Résultat

- sortie

- sorties

- au contrôle

- plus de

- paires

- paramètre

- paramètres

- particulier

- les pièces

- Pièce

- perception

- Effectuer

- performant

- effectué

- Personnellement

- image

- piliers

- pipeline

- pixel

- avion

- plateforme

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Jouez

- jouer

- Point

- des notes bonus

- Populaire

- possible

- Post

- défaillances

- power

- prévoir

- primaire

- Directeur

- Avant

- processus

- Traité

- traitement

- produire

- produit

- proportion

- proposer

- Prouver

- fournir

- à condition de

- fournit

- aportando

- but

- qualité

- quantitatif

- Quantité

- question

- gamme

- en temps réel

- vraiment

- Les raisons

- récent

- Rouge

- réduire

- reportez-vous

- se réfère

- région

- régions

- en relation

- pertinent

- Rapports

- Exigences

- a besoin

- ressource

- respect

- réponse

- résultat

- Résultats

- révolutionner

- Rich

- bon

- routières

- pour le running

- sagemaker

- Sam

- même

- scie

- Escaliers intérieurs

- scène

- STARFLEET SCIENCES

- Scientifique

- But

- Deuxièmement

- les sections

- sur le lien

- vu

- clignotant

- segmentation

- segments

- supérieur

- séparé

- Sans serveur

- service

- Services

- set

- plusieurs

- elle

- devrait

- montrer

- vitrine

- montré

- Spectacles

- signer

- significative

- Signes

- Argent

- similaires

- étapes

- singulier

- Taille

- tailles

- compétence

- fente

- fentes

- petit

- faibles

- Fragment

- So

- Football

- Solutions

- RÉSOUDRE

- quelques

- Identifier

- Sources

- spécialiste

- groupe de neurones

- spécifiquement

- passer

- scission

- Combos

- Standard

- Commencer

- Région

- Étapes

- Encore

- simple

- forces

- structure

- structurant

- Luttes

- réussi

- tel

- Les soutiens

- incomparable

- Système

- table

- Prenez

- tâches

- Tâche

- tâches

- techniques

- Les technologies

- modèle

- modèles

- conditions

- examiné

- tests

- texte

- textuel

- que

- qui

- La

- La Région

- Les bases

- El futuro

- les informations

- leur

- Là.

- Ces

- this

- pensée

- trois

- Avec

- fiable

- pneus

- à

- aujourd'hui

- outil

- les outils

- top

- Total

- Tracking

- circulation

- qualifié

- Formation

- Transformer

- transformateur

- camion

- oui

- confiance

- Vérité

- Essai

- deux

- type

- débutante

- sous

- comprendre

- us

- utilisable

- Utilisation

- utilisé

- cas d'utilisation

- cas d'utilisation

- d'utiliser

- Utilisateur

- en utilisant

- Valeurs

- divers

- Vaste

- végétation

- Véhicules

- version

- versions

- verticales

- très

- Vidéo

- vision

- visuel

- vs

- W

- était

- façons

- we

- web

- services Web

- WELL

- est allé

- ont été

- Quoi

- Qu’est ce qu'

- quand

- Les

- qui

- la totalité

- large

- Large gamme

- largement

- sera

- comprenant

- dans les

- sans

- témoin

- des mots

- activités principales

- workflows

- de travail

- vos contrats

- pourra

- écriture

- X

- années

- york

- Vous n'avez

- Votre

- zéphyrnet