Les forêts de mangroves font partie intégrante d'un écosystème sain et les activités humaines sont l'une des principales raisons de leur disparition progressive des côtes du monde entier. L'utilisation d'un modèle d'apprentissage automatique (ML) pour identifier les régions de mangroves à partir d'une image satellite offre aux chercheurs un moyen efficace de surveiller la taille des forêts au fil du temps. Dans Partie 1 de cette série, nous avons montré comment collecter des données satellitaires de manière automatisée et les analyser en Amazon SageMakerStudio avec visualisation interactive. Dans cet article, nous montrons comment utiliser Pilote automatique Amazon SageMaker pour automatiser le processus de création d'un classificateur de mangrove personnalisé.

Entraîner un modèle avec Autopilot

Le pilote automatique offre une manière équilibrée de construire plusieurs modèles et de sélectionner le meilleur. Tout en créant plusieurs combinaisons de différentes techniques de prétraitement des données et modèles ML avec un minimum d'effort, Autopilot offre un contrôle complet sur ces étapes de composants au scientifique des données, s'il le souhaite.

Vous pouvez utiliser Autopilot à l'aide de l'un des kits SDK AWS (détails disponibles dans le Guide de référence de l'API pour le pilote automatique) ou via Studio. Nous utilisons Autopilot dans notre solution Studio en suivant les étapes décrites dans cette section :

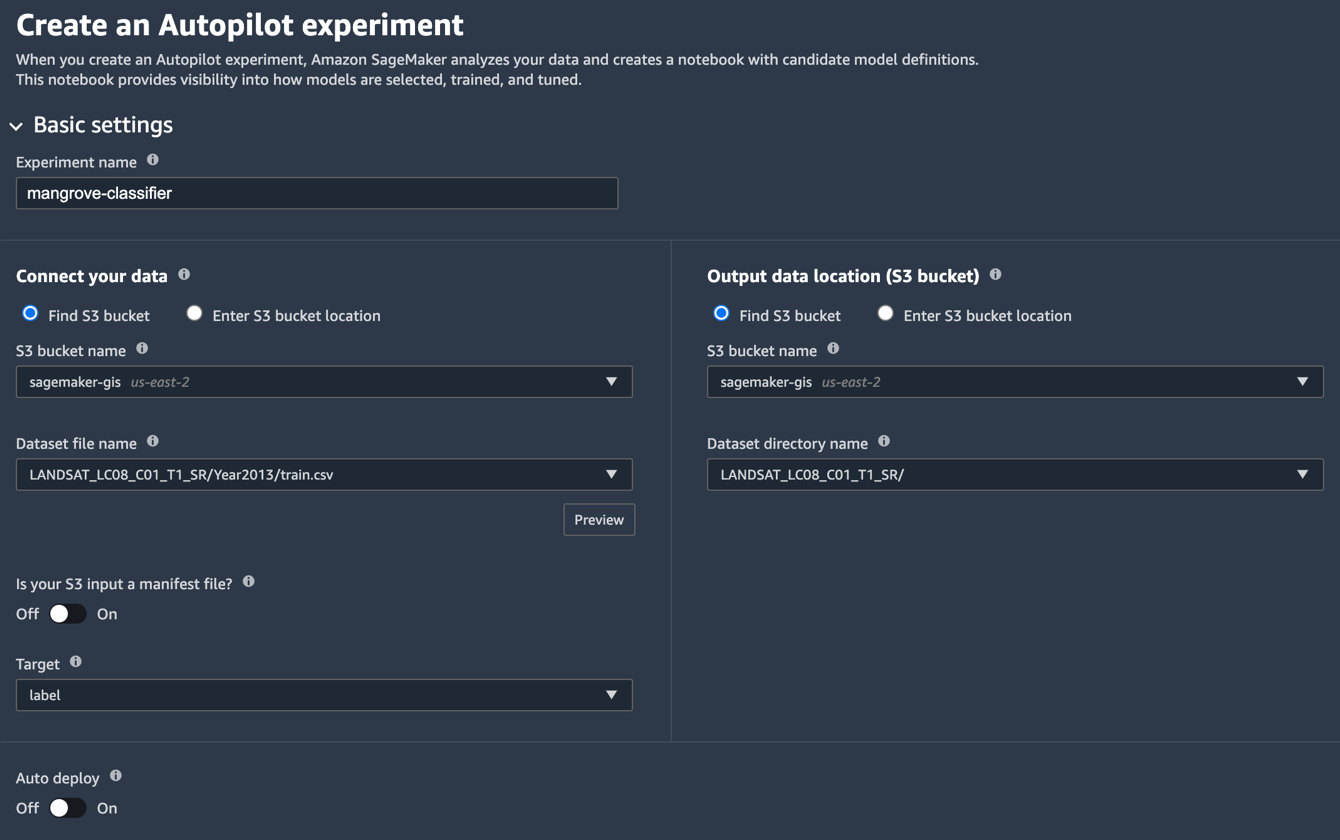

- Sur la page Studio Launcher, choisissez le signe plus pour Nouvelle expérience de pilote automatique.

- Pour Connectez vos données, sélectionnez Rechercher un compartiment S3, puis saisissez le nom du compartiment dans lequel vous avez conservé les ensembles de données d'entraînement et de test.

- Pour Nom du fichier de l'ensemble de données, entrez le nom du fichier de données d'entraînement que vous avez créé dans Préparer les données d'entraînement section Partie 1.

- Pour Emplacement des données de sortie (compartiment S3), saisissez le même nom de compartiment que vous avez utilisé à l'étape 2.

- Pour Nom du répertoire de l'ensemble de données, saisissez un nom de dossier sous le compartiment dans lequel vous souhaitez qu'Autopilot stocke les artefacts.

- Pour Votre entrée S3 est-elle un fichier manifeste ?, choisissez de.

- Pour Target, choisissez étiquette.

- Pour Déploiement automatique, choisissez de.

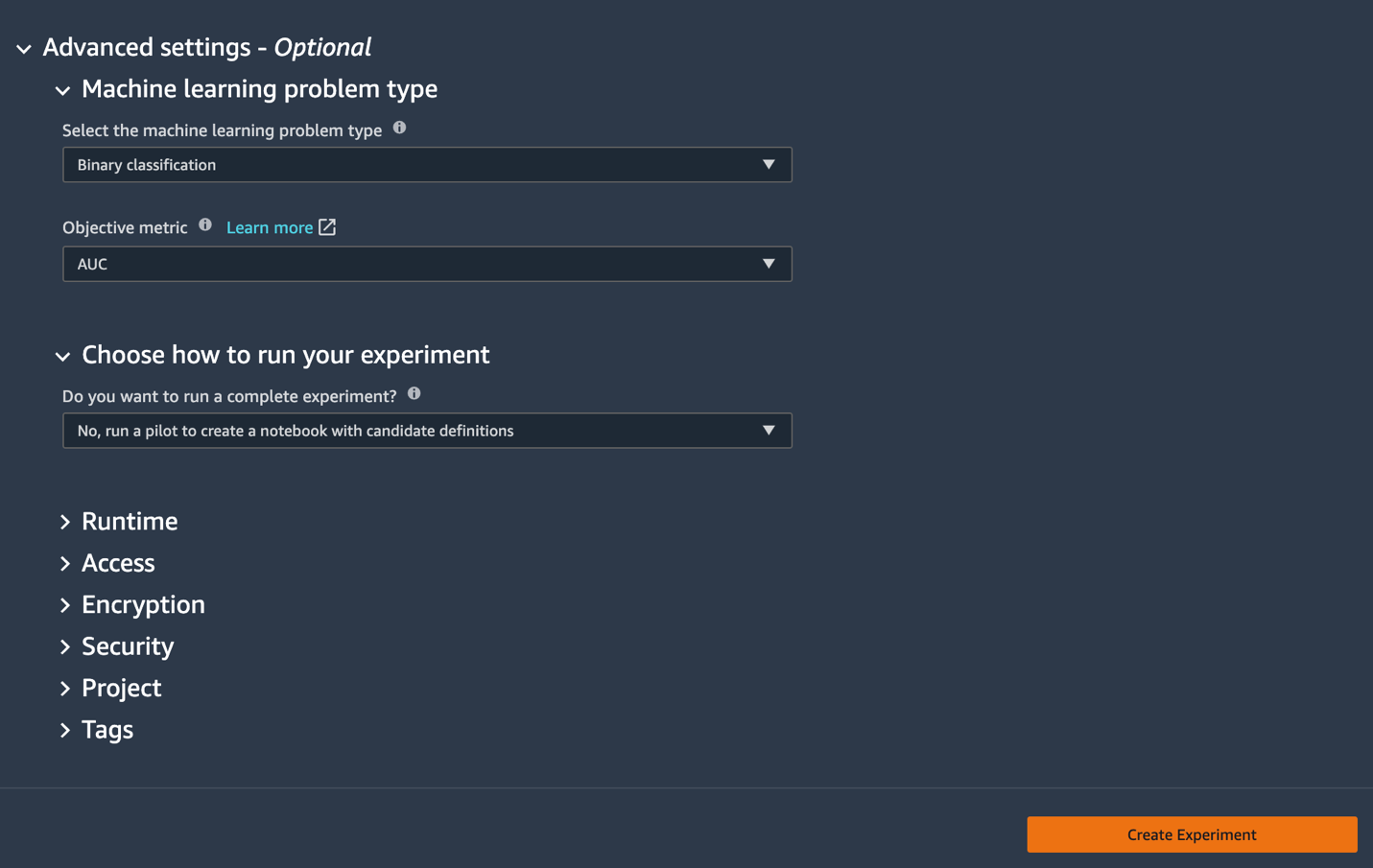

- En vertu des Normes sur l’information et les communications, les organismes doivent rendre leurs sites et applications Web accessibles. Ils y parviennent en conformant leurs sites Web au niveau AA des Web Content Accessibility Guidelines (WCAG). paramètres avancés, Pour Type de problème d'apprentissage automatique, choisissez Classement binaire.

- Pour Indicateur objectif, choisissez ASC.

- Pour Choisissez comment exécuter votre test, choisissez Non, exécutez un pilote pour créer un bloc-notes avec des définitions de candidats.

- Selectionnez Créer une expérience.

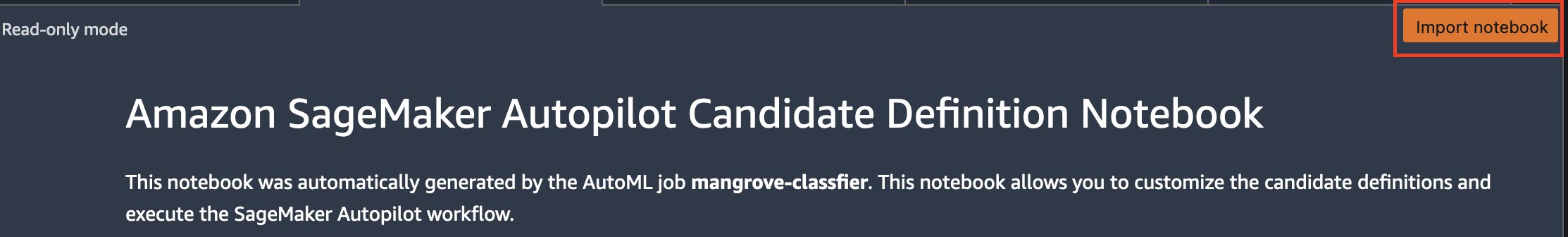

Pour plus d'informations sur la création d'une expérience, reportez-vous à Créer une expérience Amazon SageMaker Autopilot.L'exécution de cette étape peut prendre environ 15 minutes. - Une fois terminé, choisissez Ouvrir le cahier de génération de candidats, qui ouvre un nouveau bloc-notes en mode lecture seule.

- Selectionnez Importer un bloc-notes pour rendre le bloc-notes modifiable.

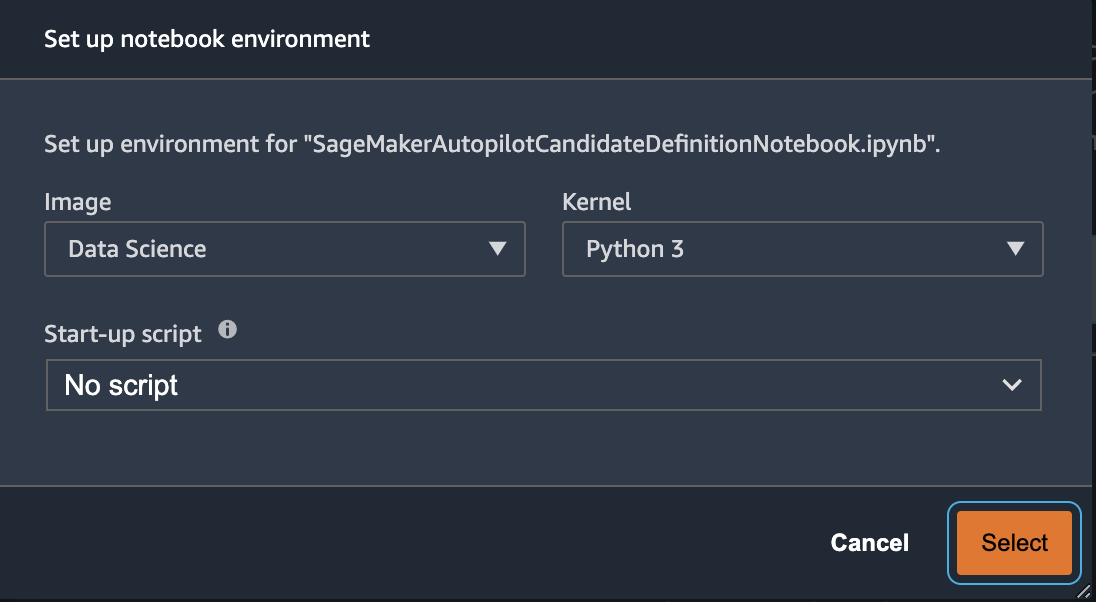

- Pour Image, choisissez Sciences des données.

- Pour Noyau, choisissez Python 3.

- Selectionnez Sélectionnez.

Ce bloc-notes généré automatiquement contient des explications détaillées et offre un contrôle complet sur la tâche de construction de modèle réelle à suivre. Une version personnalisée du cahier, où un classificateur est formé à l'aide des bandes satellites Landsat à partir de 2013, est disponible dans le référentiel de code sous notebooks/mangrove-2013.ipynb.

Le cadre de construction du modèle se compose de deux parties : la transformation des caractéristiques dans le cadre de l'étape de traitement des données et l'optimisation des hyperparamètres (HPO) dans le cadre de l'étape de sélection du modèle. Tous les artefacts nécessaires à ces tâches ont été créés au cours de l'expérience Autopilot et enregistrés dans Service de stockage simple Amazon (Amazon S3). La première cellule de bloc-notes télécharge ces artefacts d'Amazon S3 vers le local Amazon Sage Maker système de fichiers pour inspection et toute modification nécessaire. Il y a deux dossiers : generated_module ainsi que sagemaker_automl, où tous les modules et scripts Python nécessaires à l'exécution du bloc-notes sont stockés. Les différentes étapes de transformation des caractéristiques telles que l'imputation, la mise à l'échelle et l'ACP sont enregistrées sous generated_modules/candidate_data_processors/dpp*.py.

Le pilote automatique crée trois modèles différents basés sur les algorithmes XGBoost, apprenant linéaire et perceptron multicouche (MLP). Un pipeline candidat se compose de l'une des options de transformation de fonctionnalités, appelées data_transformer, et un algorithme. Un pipeline est un dictionnaire Python et peut être défini comme suit :

Dans cet exemple, le pipeline transforme les données d'apprentissage en fonction du script dans generated_modules/candidate_data_processors/dpp5.py et construit un modèle XGBoost. C'est là qu'Autopilot fournit un contrôle complet au scientifique des données, qui peut choisir les étapes de transformation de fonctionnalités et de sélection de modèle générées automatiquement ou créer sa propre combinaison.

Vous pouvez maintenant ajouter le pipeline à un pool pour qu'Autopilot exécute l'expérience comme suit :

Il s'agit d'une étape importante où vous pouvez décider de ne conserver qu'un sous-ensemble de candidats suggérés par Autopilot, en fonction de l'expertise du sujet, afin de réduire le temps d'exécution total. Pour l'instant, conservez toutes les suggestions du pilote automatique, que vous pouvez répertorier comme suit :

| nom du candidat | Algorithme | Transformateur de fonctionnalités |

| dpp0-xgboost | xgboost | dpp0.py |

| dpp1-xgboost | xgboost | dpp1.py |

| dpp2-apprenant-linéaire | apprenant linéaire | dpp2.py |

| dpp3-xgboost | xgboost | dpp3.py |

| dpp4-xgboost | xgboost | dpp4.py |

| dpp5-xgboost | xgboost | dpp5.py |

| dpp6-mlp | MLP | dpp6.py |

L'expérience complète du pilote automatique se déroule en deux parties. Tout d'abord, vous devez exécuter les tâches de transformation de données :

Cette étape devrait se terminer en 30 minutes environ pour tous les candidats, si vous n'apportez aucune autre modification au dpp*.py fichiers.

L'étape suivante consiste à construire le meilleur ensemble de modèles en ajustant les hyperparamètres pour les algorithmes respectifs. Les hyperparamètres sont généralement divisés en deux parties : statique et ajustable. Les hyperparamètres statiques restent inchangés tout au long de l'expérience pour tous les candidats partageant le même algorithme. Ces hyperparamètres sont transmis à l'expérience sous forme de dictionnaire. Si vous choisissez de choisir le meilleur modèle XGBoost en maximisant l'AUC à partir de trois tours d'un schéma de validation croisée quintuple, le dictionnaire ressemble au code suivant :

Pour les hyperparamètres ajustables, vous devez passer un autre dictionnaire avec des plages et un type de mise à l'échelle :

Le jeu complet d'hyperparamètres est disponible dans le mangrove-2013.ipynb cahier.

Pour créer une expérience où les sept candidats peuvent être testés en parallèle, créez un tuner HPO multi-algorithme :

Les métriques objectives sont définies indépendamment pour chaque algorithme :

Essayer toutes les valeurs possibles d'hyperparamètres pour toutes les expériences est un gaspillage ; vous pouvez adopter une stratégie bayésienne pour créer un tuner HPO :

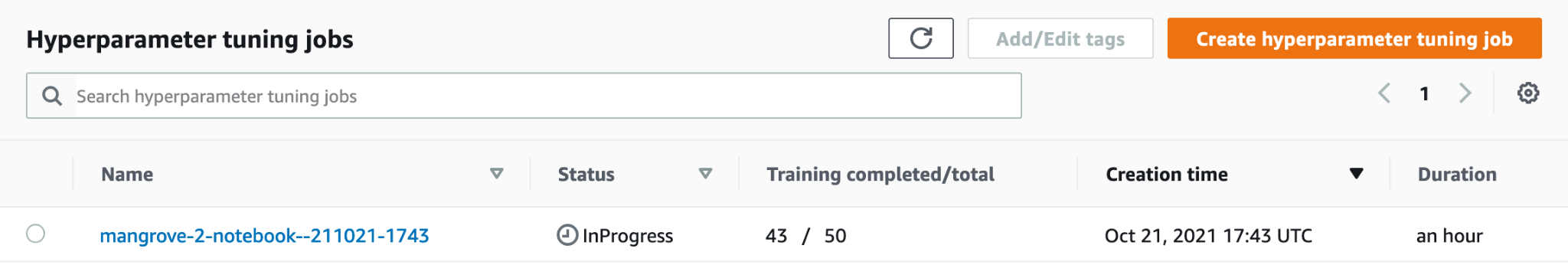

Dans le paramètre par défaut, le pilote automatique sélectionne 250 tâches dans le syntoniseur pour sélectionner le meilleur modèle. Pour ce cas d'utilisation, il suffit de définir max_jobs=50 pour économiser du temps et des ressources, sans aucune pénalité significative en termes de sélection du meilleur ensemble d'hyperparamètres. Enfin, soumettez le travail HPO comme suit :

Le processus prend environ 80 minutes sur les instances ml.m5.4xlarge. Vous pouvez surveiller la progression sur la console SageMaker en choisissant Tâches de réglage d'hyperparamètres sous Formation dans le volet de navigation.

Vous pouvez visualiser une foule d'informations utiles, y compris la performance de chaque candidat, en choisissant le nom du travail en cours.

Enfin, comparez les performances du modèle des meilleurs candidats comme suit :

| candidat | ASC | run_time(s) |

| dpp6-mlp | 0.96008 | 2711.0 |

| dpp4-xgboost | 0.95236 | 385.0 |

| dpp3-xgboost | 0.95095 | 202.0 |

| dpp4-xgboost | 0.95069 | 458.0 |

| dpp3-xgboost | 0.95015 | 361.0 |

Le modèle le plus performant basé sur MLP, bien que légèrement meilleur que les modèles XGBoost avec différents choix d'étapes de traitement des données, prend également beaucoup plus de temps à s'entraîner. Vous pouvez trouver des détails importants sur la formation du modèle MLP, y compris la combinaison d'hyperparamètres utilisés, comme suit :

| Nom du travail de formation | mangrove-2-notebook–211021-2016-012-500271c8 |

| FormationJobStatut | Complété |

| ValeurObjectiveFinale | 0.96008 |

| HeureDébutFormation | 2021-10-21 20:22:55+00:00 |

| Heure de fin d'entraînement | 2021-10-21 21:08:06+00:00 |

| FormationElapsedTimeSeconds | 2711 |

| TrainingJobDefinitionNameFormationJobDefinitionName | dpp6-mlp |

| abandon_prob | 0.415778 |

| intégration_size_factor | 0.849226 |

| poules pondeuses | 256 |

| taux d'apprentissage | 0.00013862 |

| mini_batch_size | 317 |

| type de réseau | feedforward |

| perte de poids | 1.29323e-12 |

Créer un pipeline d'inférence

Pour générer de l'inférence sur de nouvelles données, vous devez construire un pipeline d'inférence sur SageMaker pour héberger le meilleur modèle pouvant être appelé ultérieurement pour générer de l'inférence. Le modèle de pipeline SageMaker nécessite trois conteneurs comme composants : transformation de données, algorithme et transformation d'étiquette inverse (si les prédictions numériques doivent être mappées sur des étiquettes non numériques). Par souci de brièveté, seule une partie du code requis est affichée dans l'extrait de code suivant ; le code complet est disponible dans le mangrove-2013.ipynb cahier:

Une fois les conteneurs de modèles créés, vous pouvez créer et déployer le pipeline comme suit :

Le déploiement du point de terminaison prend environ 10 minutes.

Obtenir une inférence sur l'ensemble de données de test à l'aide d'un point de terminaison

Une fois le point de terminaison déployé, vous pouvez l'invoquer avec une charge utile de fonctionnalités B1 à B7 pour classer chaque pixel d'une image comme mangrove (1) ou autre (0) :

Des détails complets sur le post-traitement des prédictions du modèle pour l'évaluation et le traçage sont disponibles dans notebooks/model_performance.ipynb.

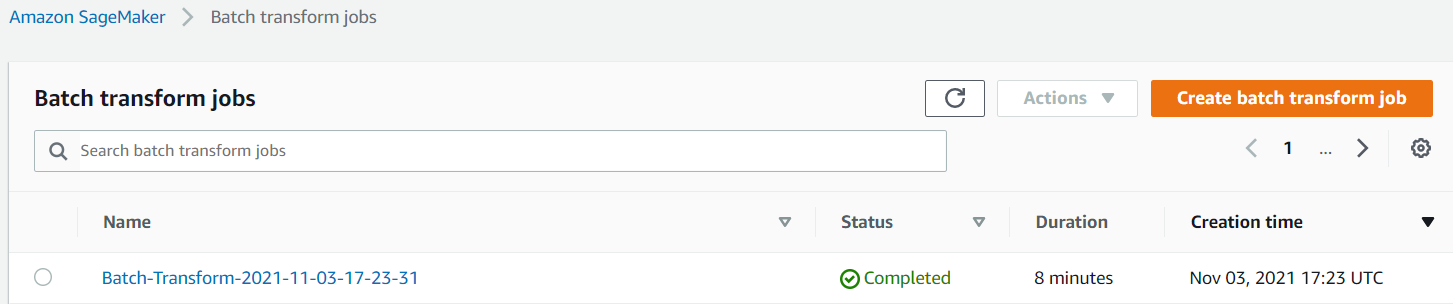

Obtenir une inférence sur l'ensemble de données de test à l'aide d'une transformation par lots

Maintenant que vous avez créé le modèle le plus performant avec Autopilot, nous pouvons utiliser le modèle pour l'inférence. Pour obtenir une inférence sur de grands ensembles de données, il est plus efficace d'utiliser une transformation par lots. Générons des prédictions sur l'ensemble de données (formation et test) et ajoutons les résultats aux fonctionnalités, afin que nous puissions effectuer une analyse plus approfondie pour, par exemple, vérifier les prévisions par rapport aux valeurs réelles et la distribution des fonctionnalités parmi les classes prédites.

Tout d'abord, nous créons un fichier manifeste dans Amazon S3 qui pointe vers les emplacements des données de formation et de test des étapes de traitement de données précédentes :

Nous pouvons maintenant créer une tâche de transformation par lots. Parce que notre train d'entrée et notre ensemble de données de test ont label en tant que dernière colonne, nous devons la supprimer lors de l'inférence. Pour ce faire, nous passons InputFilter dans l' DataProcessing dispute. Le code "$[:-2]" indique de supprimer la dernière colonne. La sortie prédite est ensuite jointe aux données source pour une analyse plus approfondie.

Dans le code suivant, nous construisons les arguments pour le travail de transformation par lots, puis nous passons au create_transform_job fonction:

Vous pouvez surveiller l'état du travail sur la console SageMaker.

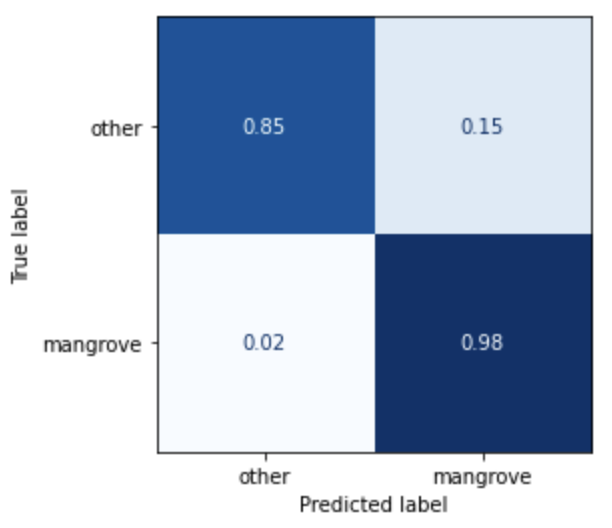

Visualisez les performances du modèle

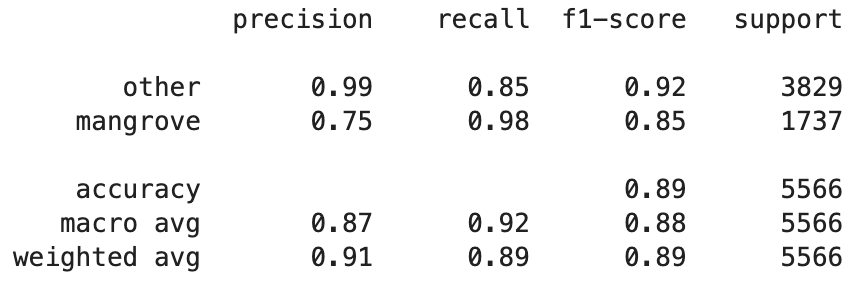

Vous pouvez maintenant visualiser les performances du meilleur modèle sur l'ensemble de données de test, composé de régions de l'Inde, du Myanmar, de Cuba et du Vietnam, sous la forme d'une matrice de confusion. Le modèle a une valeur de rappel élevée pour les pixels représentant les mangroves, mais seulement environ 75 % de précision. La précision des pixels non-mangrove ou autres est de 99 % avec un rappel de 85 %. Vous pouvez ajuster le seuil de probabilité des prédictions du modèle pour ajuster les valeurs respectives en fonction du cas d'utilisation particulier.

Il convient de noter que les résultats sont une amélioration significative par rapport au modèle smileCart intégré.

Visualisez les prédictions du modèle

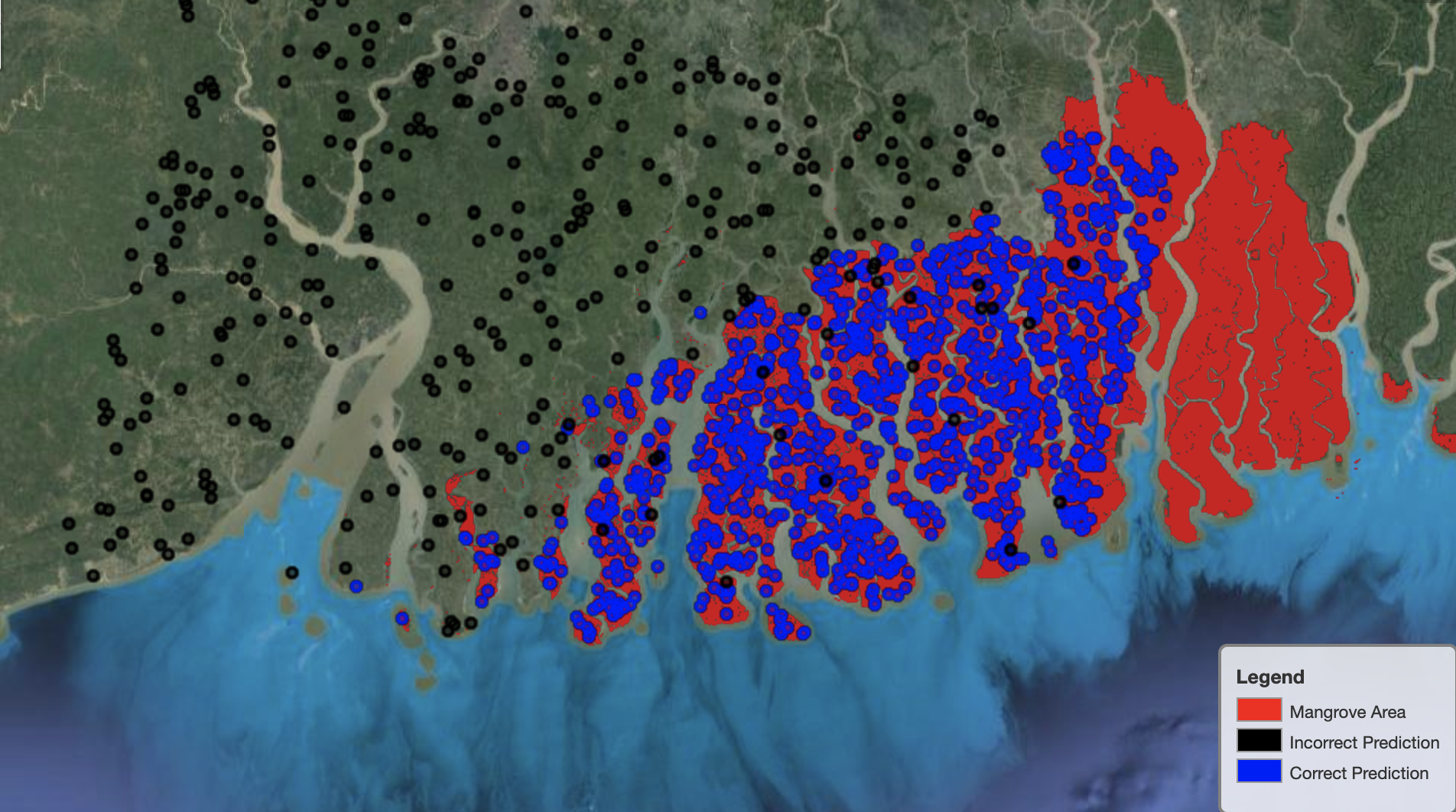

Enfin, il est utile d'observer les performances du modèle sur des régions spécifiques de la carte. Dans l'image suivante, la zone de mangrove à la frontière entre l'Inde et le Bangladesh est représentée en rouge. Les points échantillonnés à partir du patch d'image Landsat appartenant à l'ensemble de données de test sont superposés à la région, où chaque point est un pixel que le modèle détermine comme représentant les mangroves. Les points bleus sont classés correctement par le modèle, tandis que les points noirs représentent les erreurs du modèle.

L'image suivante montre uniquement les points qui, selon le modèle, ne représentent pas les mangroves, avec le même schéma de couleurs que l'exemple précédent. Le contour gris est la partie du patch Landsat qui n'inclut aucune mangrove. Comme le montre l'image, le modèle ne fait aucune erreur en classant les points sur l'eau, mais fait face à un défi lorsqu'il s'agit de distinguer les pixels représentant les mangroves de ceux représentant le feuillage régulier.

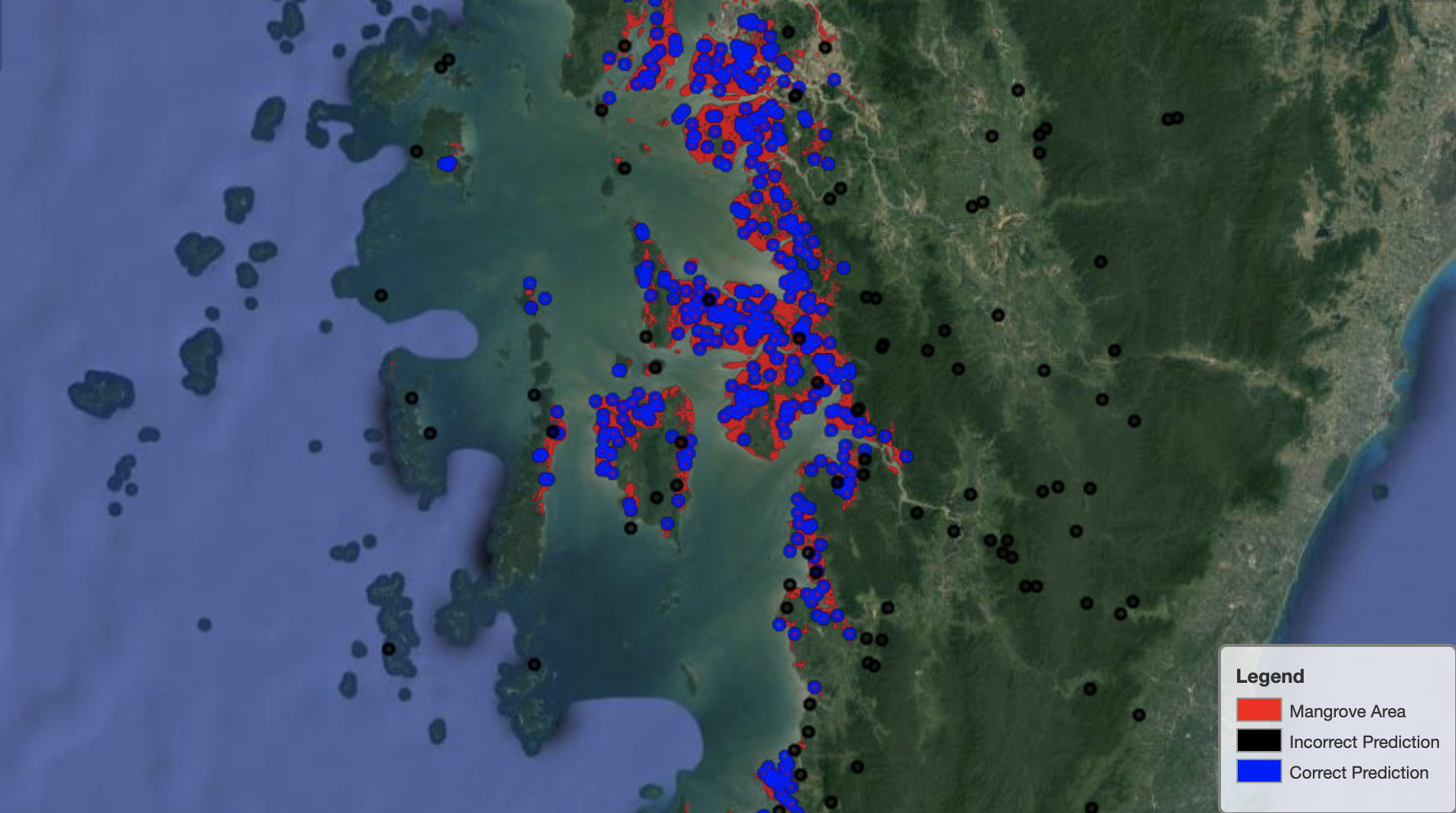

L'image suivante montre les performances du modèle sur la région de mangrove du Myanmar.

Dans l'image suivante, le modèle identifie mieux les pixels de la mangrove.

Nettoyer

Le point de terminaison d'inférence SageMaker continue d'engendrer des coûts s'il est laissé en cours d'exécution. Lorsque vous avez terminé, supprimez le point de terminaison comme suit :

Conclusion

Cette série d'articles a fourni un cadre de bout en bout aux scientifiques des données pour résoudre les problèmes SIG. Partie 1 a montré le processus ETL et un moyen pratique d'interagir visuellement avec les données. La partie 2 a montré comment utiliser le pilote automatique pour automatiser la création d'un classificateur de mangrove personnalisé.

Vous pouvez utiliser ce cadre pour explorer de nouveaux ensembles de données satellitaires contenant un ensemble plus riche de bandes utiles pour la classification des mangroves et explorer l'ingénierie des fonctionnalités en incorporant la connaissance du domaine.

À propos des auteurs

Andreï Ivanovic est un nouvel étudiant à la maîtrise en informatique à l'Université de Toronto et un récent diplômé du programme de sciences de l'ingénieur de l'Université de Toronto, avec une majeure en intelligence artificielle avec une mineure en robotique/mécatronique. Il s'intéresse à la vision par ordinateur, à l'apprentissage en profondeur et à la robotique. Il a réalisé le travail présenté dans ce post lors de son stage d'été chez Amazon.

Andreï Ivanovic est un nouvel étudiant à la maîtrise en informatique à l'Université de Toronto et un récent diplômé du programme de sciences de l'ingénieur de l'Université de Toronto, avec une majeure en intelligence artificielle avec une mineure en robotique/mécatronique. Il s'intéresse à la vision par ordinateur, à l'apprentissage en profondeur et à la robotique. Il a réalisé le travail présenté dans ce post lors de son stage d'été chez Amazon.

David Dong est Data Scientist chez Amazon Web Services.

David Dong est Data Scientist chez Amazon Web Services.

Arkajyoti Misra est Data Scientist chez Amazon LastMile Transportation. Il est passionné par l'application des techniques de vision par ordinateur pour résoudre des problèmes qui aident la terre. Il aime travailler avec des organismes à but non lucratif et est membre fondateur de ekipi.org.

Arkajyoti Misra est Data Scientist chez Amazon LastMile Transportation. Il est passionné par l'application des techniques de vision par ordinateur pour résoudre des problèmes qui aident la terre. Il aime travailler avec des organismes à but non lucratif et est membre fondateur de ekipi.org.

- Coinsmart. Le meilleur échange Bitcoin et Crypto d'Europe.

- Platoblockchain. Intelligence métaverse Web3. Connaissance amplifiée. ACCÈS LIBRE.

- CryptoHawk. Radar Altcoins. Essai gratuit.

- Source : https://aws.amazon.com/blogs/machine-learning/part-2-identify-mangrove-forests-using-satellite-image-features-using-amazon-sagemaker-studio-and-amazon-sagemaker- pilote automatique/

- "

- 10

- 100

- a

- Qui sommes-nous

- Selon

- activités

- algorithme

- algorithmes

- Tous

- Amazon

- Amazon Web Services

- parmi

- selon une analyse de l’Université de Princeton

- analytique

- il analyse

- Une autre

- Application

- Réservé

- arguments

- autour

- automatiser

- Automatisation

- automatiquement

- disponibles

- AWS

- car

- LES MEILLEURS

- Noir

- corps

- frontière

- construire

- Développement

- construit

- intégré

- candidat

- candidats

- maisons

- challenge

- choix

- Selectionnez

- les classes

- classification

- classifié

- code

- Colonne

- combinaison

- комбинации

- complet

- composant

- composants électriques

- ordinateur

- Informatique

- confusion

- Console

- Conteneurs

- continue

- des bactéries

- Pratique

- engendrent

- créée

- crée des

- La création

- Cuba

- Customiser

- données

- informatique

- Data Scientist

- profond

- Selon

- déployer

- déployé

- déploiement

- détaillé

- détails

- DID

- différent

- Commande

- distribution

- Ne fait pas

- domaine

- téléchargements

- Goutte

- pendant

- chacun

- Terre

- risque numérique

- Efficace

- efficace

- effort

- end-to-end

- Endpoint

- ENGINEERING

- Entrer

- évaluation

- exemple

- expérience

- nous a permis de concevoir

- explorez

- visages

- Mode

- Fonctionnalité

- Fonctionnalités:

- finalement

- Prénom

- suivre

- Abonnement

- suit

- fonder

- Framework

- de

- plein

- fonction

- plus

- générer

- généré

- génération

- diplôme

- gris

- guide

- la taille

- aide

- Haute

- Comment

- How To

- HTTPS

- humain

- identifier

- identifier

- image

- important

- amélioration

- comprendre

- Y compris

- indépendamment

- Inde

- d'information

- contribution

- instance

- Intelligence

- Interactif

- intéressé

- IT

- Emploi

- Emplois

- rejoint

- XNUMX éléments à

- spécialisées

- connu

- Libellé

- Etiquettes

- gros

- apprentissage

- Gamme

- Liste

- locales

- emplacement

- emplacements

- click

- machine learning

- majeur

- faire

- Localisation

- maîtrise

- Matrice

- Matière

- membre

- Métrique

- erreurs

- ML

- modèle

- numériques jumeaux (digital twin models)

- Surveiller

- PLUS

- plusieurs

- Myanmar

- Navigation

- nécessaire

- next

- une organisation à but non lucratif

- cahier

- ouvre

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- Options

- organisations

- Autre

- propre

- partie

- particulier

- passionné

- Pièce

- performant

- performances

- effectuer

- pilote

- Point

- des notes bonus

- pool

- possible

- Poteaux

- Prédictions

- précédent

- Problème

- d'ouvrabilité

- processus

- traitement

- Programme

- à condition de

- fournit

- Les raisons

- récent

- réduire

- région

- Standard

- rester

- dépôt

- représentent

- représentation

- nécessaire

- conditions

- a besoin

- chercheurs

- Ressources

- Résultats

- robotique

- Rôle

- tours

- Courir

- pour le running

- même

- satellite

- Épargnez

- mise à l'échelle

- programme

- Sciences

- Scientifique

- scientifiques

- sélection

- Série

- Services

- set

- mise

- plusieurs

- Partager

- montrer

- montré

- signer

- significative

- étapes

- Taille

- So

- solide

- sur mesure

- RÉSOUDRE

- groupe de neurones

- Utilisation d'un

- Statut

- storage

- Boutique

- de Marketing

- Étudiant

- studio

- sujet

- été

- combustion propre

- tâches

- techniques

- conditions

- tester

- Les

- La Source

- le monde

- trois

- Avec

- tout au long de

- fiable

- top

- haut 5

- toronto

- Formation

- Transformer

- De La Carrosserie

- transformations

- transport

- sous

- université

- utilisé

- d'habitude

- validation

- Plus-value

- divers

- version

- vision

- visualisation

- Eau

- web

- services Web

- tout en

- WHO

- sans

- Activités principales

- world

- vaut

- X

- Votre