La détection automatisée des défauts à l'aide de la vision par ordinateur permet d'améliorer la qualité et de réduire le coût de l'inspection. La détection des défauts implique l'identification de la présence d'un défaut, la classification des types de défauts et l'identification de l'emplacement des défauts. De nombreux processus de fabrication nécessitent une détection à faible latence, avec des ressources de calcul limitées et une connectivité limitée.

Amazon Lookout pour Vision est un service d'apprentissage automatique (ML) qui aide à repérer les défauts des produits à l'aide de la vision par ordinateur pour automatiser le processus d'inspection de la qualité dans vos lignes de fabrication, sans qu'aucune expertise en ML ne soit requise. Lookout for Vision inclut désormais la possibilité de fournir l'emplacement et le type d'anomalies à l'aide de modèles ML de segmentation sémantique. Ces modèles ML personnalisés peuvent être déployés sur le cloud AWS à l'aide API cloud ou au matériel de bord personnalisé à l'aide AWS IoT Greengrass. Lookout for Vision prend désormais en charge l'inférence sur une plate-forme de calcul x86 exécutant Linux avec ou sans accélérateur GPU NVIDIA et sur n'importe quelle appliance de périphérie basée sur NVIDIA Jetson. Cette flexibilité permet la détection de défauts sur du matériel existant ou nouveau.

Dans cet article, nous vous montrons comment détecter les pièces défectueuses à l'aide de modèles Lookout for Vision ML exécutés sur un appareil périphérique, que nous simulons à l'aide d'un Cloud de calcul élastique Amazon (Amazon EC2). Nous passons en revue la formation des nouveaux modèles de segmentation sémantique, les exportons en tant que composants AWS IoT Greengrass et exécutons l'inférence en mode CPU uniquement avec un exemple de code Python.

Vue d'ensemble de la solution

Dans cet article, nous utilisons un ensemble de photos de extraterrestres jouets composé d'images normales et défectueuses telles que des membres, des yeux ou d'autres parties manquants. Nous entraînons un modèle Lookout for Vision dans le cloud pour identifier les extraterrestres jouets défectueux. Nous compilons le modèle sur un processeur X86 cible, empaquetons le modèle Lookout for Vision formé en tant que composant AWS IoT Greengrass et déployons le modèle sur une instance EC2 sans GPU à l'aide de la console AWS IoT Greengrass. Enfin, nous démontrons un exemple d'application basé sur Python s'exécutant sur l'instance EC2 (C5a.2xl) qui extrait les images extraterrestres jouets du système de fichiers du périphérique périphérique, exécute l'inférence sur le modèle Lookout for Vision à l'aide du gRPC interface, et envoie les données d'inférence à un MQTT sujet dans le cloud AWS. Les scripts génèrent une image qui inclut la couleur et l'emplacement des défauts sur l'image anormale.

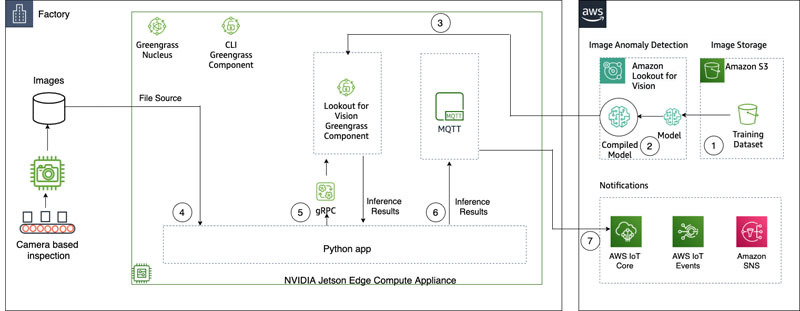

Le diagramme suivant illustre l'architecture de la solution. Il est important de noter que pour chaque type de défaut que vous souhaitez détecter en localisation, vous devez avoir 10 images d'anomalies marquées en formation et 10 en données de test, pour un total de 20 images de ce type. Pour ce post, nous recherchons les membres manquants sur le jouet.

La solution a le workflow suivant :

- Importez un ensemble de données d'entraînement et un ensemble de données de test dans Service de stockage simple Amazon (Amazon S3).

- Utilisez la nouvelle interface utilisateur Lookout for Vision pour ajouter un type d'anomalie et marquer l'emplacement de ces anomalies dans les images d'entraînement et de test.

- Entraînez un modèle Lookout for Vision dans le cloud.

- Compilez le modèle sur l'architecture cible (X86) et déployez le modèle sur l'instance EC2 (C5a.2xl) à l'aide de la console AWS IoT Greengrass.

- Images sources à partir du disque local.

- Exécutez des inférences sur le modèle déployé via l'interface gRPC et récupérez une image des masques d'anomalies superposée à l'image d'origine.

- Publiez les résultats de l'inférence sur un client MQTT exécuté sur l'instance Edge.

- Recevoir le message MQTT sur un sujet dans Noyau AWS IoT dans le cloud AWS pour une surveillance et une visualisation supplémentaires.

Les étapes 5, 6 et 7 sont coordonnées avec l'exemple d'application Python.

Pré-requis

Avant de commencer, remplissez les conditions préalables suivantes. Pour cet article, nous utilisons une instance EC2 c5.2xl et y installons AWS IoT Greengrass V2 pour tester les nouvelles fonctionnalités. Si vous souhaitez exécuter sur un NVIDIA Jetson, suivez les étapes de notre post précédent, Amazon Lookout for Vision prend désormais en charge l'inspection visuelle des défauts du produit à la périphérie.

- Créer un compte AWS.

- Démarrez une instance EC2 sur laquelle nous pouvons installer AWS IoT Greengrass et utilisez le nouveau mode d'inférence CPU uniquement. Vous pouvez également utiliser une machine Intel X86 64 bits avec 8 gigaoctets de RAM ou plus (nous utilisons un c5a.2xl, mais tout avec supérieur à 8 gigaoctets sur la plate-forme x86 devrait fonctionner) sous Ubuntu 20.04.

- Installez AWS IoT Greengrass V2 :

- Installez le système nécessaire et les dépendances Python 3 (Ubuntu 20.04) :

Téléchargez le jeu de données et entraînez le modèle

Nous utilisons les ensemble de données sur les extraterrestres jouets pour démontrer la solution. Le jeu de données contient des images normales et anormales. Voici quelques exemples d'images de l'ensemble de données.

L'image suivante montre un extraterrestre jouet normal.

L'image suivante montre un extraterrestre jouet auquel il manque une jambe.

L'image suivante montre un extraterrestre jouet auquel il manque une tête.

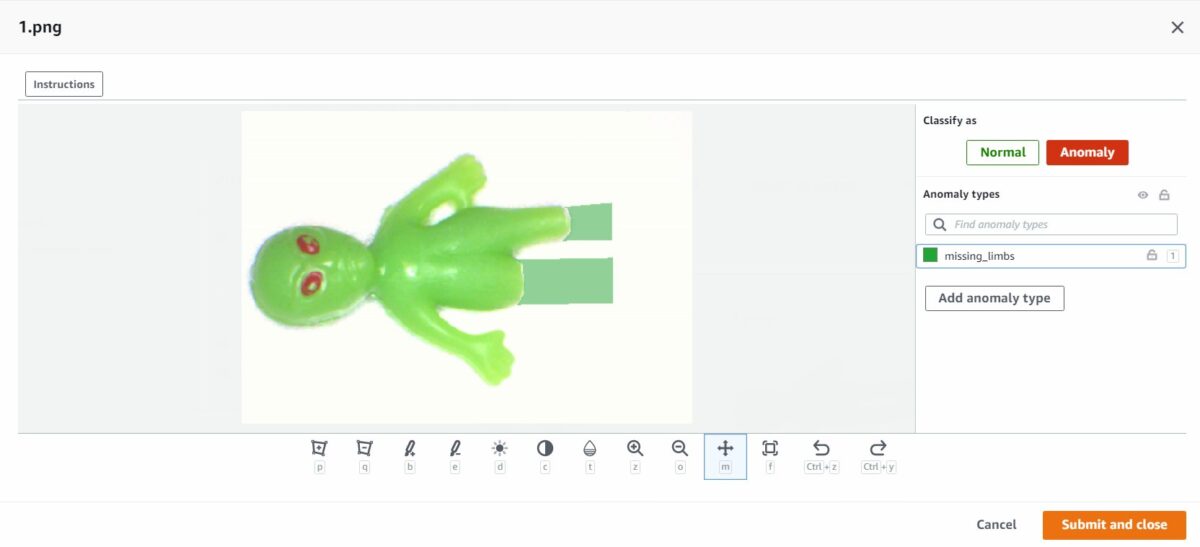

Dans cet article, nous recherchons les membres manquants. Nous utilisons la nouvelle interface utilisateur pour tracer un masque autour des défauts de nos données d'entraînement et de tests. Cela indiquera aux modèles de segmentation sémantique comment identifier ce type de défaut.

- Commencez par télécharger votre ensemble de données, soit via Amazon S3, soit depuis votre ordinateur.

- Triez-les dans des dossiers intitulés

normalet deanomaly. - Lors de la création de votre ensemble de données, sélectionnez Joindre automatiquement des étiquettes aux images en fonction du nom du dossier.Cela nous permet de trier les images anormales plus tard et de dessiner les zones à étiqueter avec un défaut.

- Essayez de retenir quelques images pour tester plus tard les deux

normalet deanomaly. - Une fois toutes les images ajoutées au jeu de données, choisissez Ajouter des libellés d'anomalie.

- Commencez à étiqueter les données en choisissant Commencer l'étiquetage.

- Pour accélérer le processus, vous pouvez sélectionner plusieurs images et les classer comme

NormalorAnomaly.

Si vous souhaitez mettre en évidence des anomalies en plus de les classer, vous devez mettre en évidence l'emplacement des anomalies. - Choisissez l'image que vous souhaitez annoter.

- Utilisez les outils de dessin pour montrer la zone où une partie du sujet manque ou dessinez un masque sur le défaut.

- Selectionnez Soumettre et fermer pour conserver ces modifications.

- Répétez ce processus pour toutes vos images.

- Lorsque vous avez terminé, choisissez Épargnez pour conserver vos modifications. Vous êtes maintenant prêt à former votre modèle.

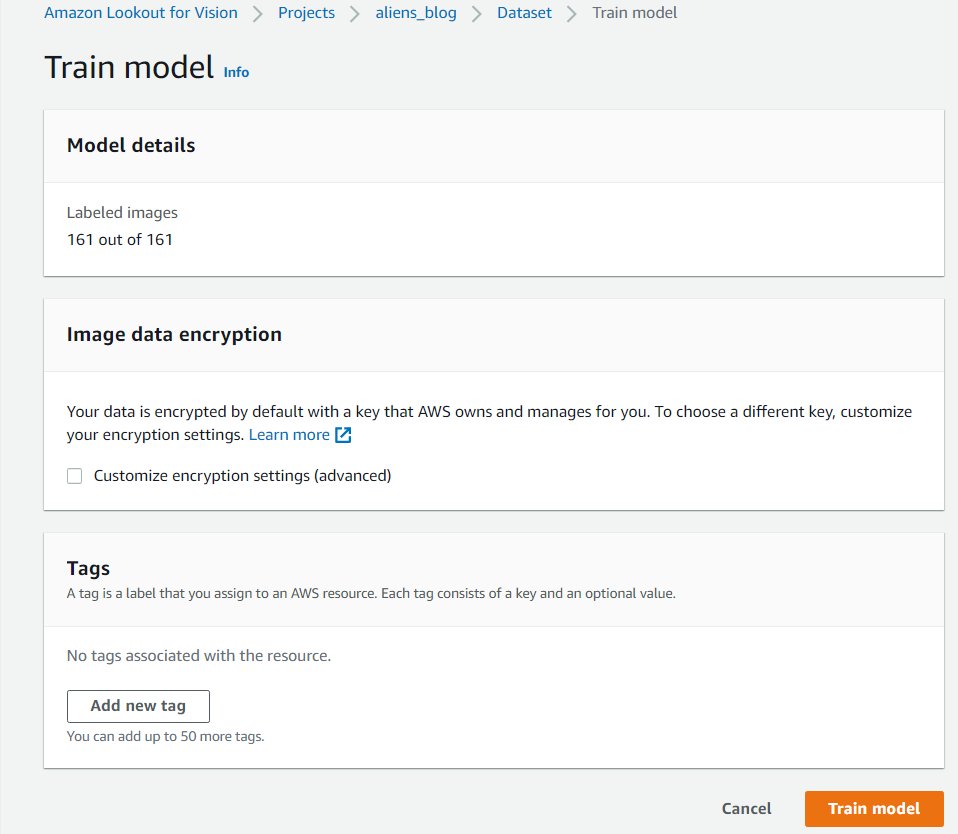

- Selectionnez Modèle de train.

Une fois ces étapes terminées, vous pouvez accéder au projet et au Des modèles photo page pour vérifier les performances du modèle entraîné. Vous pouvez démarrer le processus d'exportation du modèle vers l'appareil Edge cible à tout moment après la formation du modèle.

Réentraîner le modèle avec des images corrigées

Parfois, le marquage des anomalies peut ne pas être tout à fait correct. Vous avez la possibilité d'aider votre modèle à mieux apprendre vos anomalies. Par exemple, l'image suivante est identifiée comme une anomalie, mais ne montre pas le missing_limbs Étiquette.

Ouvrons l'éditeur et corrigeons cela.

Parcourez toutes les images que vous trouvez comme celle-ci. Si vous constatez qu'il s'agit d'une anomalie étiquetée de manière incorrecte, vous pouvez utiliser l'outil gomme pour supprimer l'étiquette incorrecte.

Vous pouvez maintenant réentraîner votre modèle et obtenir une meilleure précision.

Compiler et empaqueter le modèle en tant que composant AWS IoT Greengrass

Dans cette section, nous passons en revue les étapes pour compiler le modèle extraterrestre jouet sur notre appareil périphérique cible et emballer le modèle en tant que composant AWS IoT Greengrass.

- Sur la console Lookout for Vision, choisissez votre projet.

- Dans le volet de navigation, choisissez Paquets de modèles Edge.

- Selectionnez Créer une tâche d'emballage de modèle.

- Pour Nom du travail, entrez un nom.

- Pour Description de l'emploi, entrez une description facultative.

- Selectionnez Parcourir les modèles.

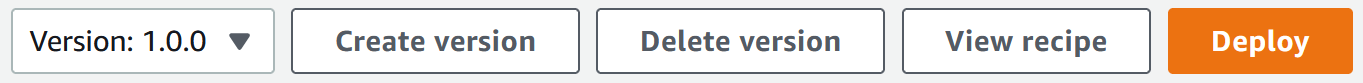

- Sélectionnez la version du modèle (le modèle extraterrestre jouet construit dans la section précédente).

- Selectionnez Selectionnez.

- Si vous l'exécutez sur Amazon EC2 ou un appareil X86-64, sélectionnez Plate-forme cible et choisissez Linux/Unix, X86et une Processeur.

Si vous utilisez un processeur, vous pouvez laisser les options du compilateur vides si vous n'êtes pas sûr et que vous n'avez pas de GPU NVIDIA. Si vous disposez d'une plate-forme basée sur Intel qui prend en charge AVX512, vous pouvez ajouter ces options de compilateur pour optimiser les performances :{"mcpu": "skylake-avx512"}. Vous pouvez voir le nom et l'état de votre tâche sous la forme

Vous pouvez voir le nom et l'état de votre tâche sous la forme In progress. La tâche d'empaquetage du modèle peut prendre quelques minutes. Lorsque la tâche d'empaquetage du modèle est terminée, l'état s'affiche comme suit :Success. - Choisissez votre nom de poste (dans notre cas c'est

aliensblogcpux86) pour voir les détails de la tâche.

- Selectionnez Créer une tâche d'emballage de modèle.

- Entrez les détails pour Nom du composant, Description des composants (optionnel), Version du composantet une Emplacement des composants.Lookout for Vision stocke les recettes de composants et les artefacts dans cet emplacement Amazon S3.

- Selectionnez Poursuivre le déploiement dans Greengrass pour déployer le composant sur l'appareil Edge cible.

Le composant AWS IoT Greengrass et les artefacts de modèle ont été créés dans votre compte AWS.

Déployer le modèle

Assurez-vous que AWS IoT Greengrass V2 est installé sur votre appareil cible pour votre compte avant de continuer. Pour obtenir des instructions, reportez-vous à Installer le logiciel AWS IoT Greengrass Core.

Dans cette section, nous passons en revue les étapes de déploiement du modèle extraterrestre jouet sur l'appareil périphérique à l'aide de la console AWS IoT Greengrass.

- Sur la console AWS IoT Greengrass, accédez à votre appareil périphérique.

- Selectionnez Déployer pour lancer les étapes de déploiement.

- Sélectionnez Dispositif principal (parce que le déploiement est sur un seul appareil) et entrez un nom pour Nom de la cible.Le nom cible est le même que celui que vous avez utilisé pour nommer l'appareil principal lors du processus d'installation d'AWS IoT Greengrass V2.

- Choisissez votre composant. Dans notre cas, le nom du composant est

aliensblogcpux86, qui contient le modèle extraterrestre jouet. - Selectionnez Suivant.

- Configurez le composant (facultatif).

- Selectionnez Suivant.

- Développer vous Politiques de déploiement.

- Pour Politique de mise à jour des composants, sélectionnez Notifier les composantsCela permet au composant déjà déployé (une version antérieure du composant) de différer une mise à jour jusqu'à ce que vous soyez prêt à mettre à jour.

- Pour Politique de gestion des pannes, sélectionnez Ne recule pas.En cas d'échec, cette option nous permet d'enquêter sur les erreurs de déploiement.

- Selectionnez Suivant.

- Passez en revue la liste des composants qui seront déployés sur l'appareil cible (périphérique).

- Selectionnez Suivant.Vous devriez voir le message

Deployment successfully created. - Pour vérifier que le déploiement du modèle a réussi, exécutez la commande suivante sur votre appareil périphérique :

Vous devriez voir une sortie similaire exécutant le aliensblogcpux86 script de démarrage du cycle de vie :

Composants actuellement exécutés dans Greengrass :

Exécuter des inférences sur le modèle

Notes: Si vous exécutez Greengrass en tant qu'un autre utilisateur que celui sous lequel vous êtes connecté, vous devrez modifier les autorisations du fichier /tmp/aws.iot.lookoutvision.EdgeAgent.sock:

Nous sommes maintenant prêts à exécuter des inférences sur le modèle. Sur votre appareil périphérique, exécutez la commande suivante pour charger le modèle (remplacez avec le nom du modèle utilisé dans votre composant) :

Pour générer des inférences, exécutez la commande suivante avec le nom du fichier source (remplacez avec le chemin et le nom du fichier de l'image à vérifier et à remplacer avec le nom du modèle utilisé pour votre composant) :

Le modèle prédit correctement l'image comme anormale (missing_limbs) avec un score de confiance de 0.9996867775917053. Il nous indique le masque de la balise d'anomalie missing_limbs et la zone de pourcentage. La réponse contient également des données bitmap que vous pouvez décoder à partir de ce qu'elle a trouvé.

Téléchargez et ouvrez le fichier blended.png, qui ressemble à l'image suivante. Notez la zone mise en évidence avec le défaut autour des jambes.

Histoires de clients

Avec AWS IoT Greengrass et Lookout for Vision, vous pouvez désormais automatiser l'inspection visuelle grâce à la vision par ordinateur pour des processus tels que le contrôle qualité et l'évaluation des défauts, le tout en périphérie et en temps réel. Vous pouvez identifier de manière proactive des problèmes tels que des pièces endommagées (comme des bosses, des rayures ou une mauvaise soudure), des composants de produit manquants ou des défauts avec des motifs répétitifs sur la ligne de production elle-même, ce qui vous permet d'économiser du temps et de l'argent. Des clients comme Tyson et Baxter découvrent la puissance de Lookout for Vision pour améliorer la qualité et réduire les coûts opérationnels en automatisant l'inspection visuelle.

« L'excellence opérationnelle est une priorité clé chez Tyson Foods. La maintenance prédictive est un atout essentiel pour atteindre cet objectif en améliorant continuellement l'efficacité globale des équipements (OEE). En 2021, Tyson Foods a lancé un projet de vision par ordinateur basé sur l'apprentissage automatique pour identifier les transporteurs de produits défaillants pendant la production afin de les empêcher d'avoir un impact sur la sécurité, les opérations ou la qualité des produits des membres de l'équipe. Les modèles formés à l'aide d'Amazon Lookout for Vision ont obtenu de bons résultats. Le modèle de détection de broches a atteint une précision de 95 % dans les deux classes. Le modèle Amazon Lookout for Vision a été réglé pour fonctionner avec une précision de 99.1 % en cas d'échec de la détection des broches. Le résultat de loin le plus excitant de ce projet a été l'accélération du temps de développement. Bien que ce projet utilise deux modèles et un code d'application plus complexe, il a fallu 12 % de temps en moins pour le développeur. Ce projet de surveillance de l'état des transporteurs de produits chez Tyson Foods a été réalisé en un temps record à l'aide des services gérés d'AWS tels qu'Amazon Lookout for Vision.

—Audrey Timmerman, développeur d'applications senior, Tyson Foods.

« La latence et la vitesse d'inférence sont essentielles pour l'évaluation en temps réel et les contrôles de qualité critiques de nos processus de fabrication. Amazon Lookout for Vision Edge sur un appareil CPU nous donne la possibilité d'atteindre cet objectif sur un équipement de production, ce qui nous permet de fournir des solutions de vision IA rentables à grande échelle.

—AK Karan, directeur principal mondial - Transformation numérique, chaîne d'approvisionnement intégrée, Baxter International Inc.

Nettoyer

Effectuez les étapes suivantes pour supprimer les actifs que vous avez créés de votre compte et éviter toute facturation en cours :

- Dans la console Lookout for Vision, accédez à votre projet.

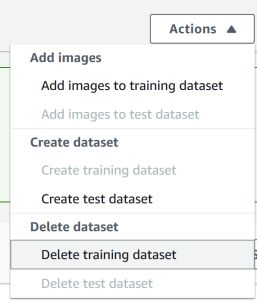

- Sur le Actions menu, supprimez vos ensembles de données.

- Supprimez vos modèles.

- Sur la console Amazon S3, videz les compartiments que vous avez créés, puis supprimez les compartiments.

- Sur la console Amazon EC2, supprimez l'instance que vous avez démarrée pour exécuter AWS IoT Greengrass.

- Sur la console AWS IoT Greengrass, choisissez Déploiements dans le volet de navigation.

- Supprimez les versions de vos composants.

- Sur la console AWS IoT Greengrass, supprimez les objets, groupes et appareils AWS IoT.

Conclusion

Dans cet article, nous avons décrit un scénario typique de détection de défauts industriels à la périphérie utilisant la localisation des défauts et déployé sur un appareil uniquement CPU. Nous avons parcouru les composants clés du cycle de vie du cloud et de la périphérie avec un exemple de bout en bout utilisant Lookout for Vision et AWS IoT Greengrass. Avec Lookout for Vision, nous avons entraîné un modèle de détection d'anomalies dans le cloud à l'aide de jeu de données extraterrestre jouet, compilé le modèle dans une architecture cible et empaqueté le modèle en tant que composant AWS IoT Greengrass. Avec AWS IoT Greengrass, nous avons déployé le modèle sur un appareil périphérique. Nous avons présenté un exemple d'application basé sur Python qui extrait des images extraterrestres jouets du système de fichiers local de l'appareil périphérique, exécute les inférences sur le modèle Lookout for Vision à la périphérie à l'aide de l'interface gRPC et envoie les données d'inférence à une rubrique MQTT dans AWS. Nuage.

Dans un prochain article, nous montrerons comment exécuter des inférences sur un flux d'images en temps réel à l'aide d'un pipeline multimédia GStreamer.

Commencez votre voyage vers la détection et l'identification des anomalies industrielles en visitant le Amazon Lookout pour Vision et de AWS IoT Greengrass pages ressources.

À propos des auteurs

Manish Talréja est Senior Industrial ML Practice Manager avec AWS Professional Services. Il aide les clients AWS à atteindre leurs objectifs commerciaux en concevant et en créant des solutions innovantes qui utilisent les services AWS ML et IoT sur le cloud AWS.

Manish Talréja est Senior Industrial ML Practice Manager avec AWS Professional Services. Il aide les clients AWS à atteindre leurs objectifs commerciaux en concevant et en créant des solutions innovantes qui utilisent les services AWS ML et IoT sur le cloud AWS.

Ryan Vanderwerf est architecte de solutions partenaire chez Amazon Web Services. Il a précédemment fourni des services de conseil et de développement de projets axés sur les machines virtuelles Java en tant qu'ingénieur logiciel chez OCI au sein de l'équipe Grails et Micronaut. Il était architecte en chef/directeur des produits chez ReachForce, avec un accent sur l'architecture logicielle et système pour les solutions AWS Cloud SaaS pour la gestion des données marketing. Ryan a construit plusieurs solutions SaaS dans plusieurs domaines tels que les entreprises financières, médiatiques, de télécommunications et d'apprentissage en ligne depuis 1996.

Ryan Vanderwerf est architecte de solutions partenaire chez Amazon Web Services. Il a précédemment fourni des services de conseil et de développement de projets axés sur les machines virtuelles Java en tant qu'ingénieur logiciel chez OCI au sein de l'équipe Grails et Micronaut. Il était architecte en chef/directeur des produits chez ReachForce, avec un accent sur l'architecture logicielle et système pour les solutions AWS Cloud SaaS pour la gestion des données marketing. Ryan a construit plusieurs solutions SaaS dans plusieurs domaines tels que les entreprises financières, médiatiques, de télécommunications et d'apprentissage en ligne depuis 1996.

Prakash Krishnan est responsable principal du développement logiciel chez Amazon Web Services. Il dirige les équipes d'ingénierie qui construisent des systèmes distribués à grande échelle pour appliquer des algorithmes rapides, efficaces et hautement évolutifs aux problèmes de reconnaissance d'images et de vidéos basés sur l'apprentissage en profondeur.

Prakash Krishnan est responsable principal du développement logiciel chez Amazon Web Services. Il dirige les équipes d'ingénierie qui construisent des systèmes distribués à grande échelle pour appliquer des algorithmes rapides, efficaces et hautement évolutifs aux problèmes de reconnaissance d'images et de vidéos basés sur l'apprentissage en profondeur.

- AI

- art de l'IA

- générateur d'art ai

- robot IA

- Amazon Lookout pour Vision

- intelligence artificielle

- certification en intelligence artificielle

- intelligence artificielle en banque

- robot d'intelligence artificielle

- robots d'intelligence artificielle

- logiciel d'intelligence artificielle

- AWS IoT Greengrass

- Apprentissage automatique AWS

- blockchain

- conférence blockchain ai

- cognitif

- intelligence artificielle conversationnelle

- crypto conférence ai

- de dall

- l'apprentissage en profondeur

- google ai

- machine learning

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- échelle ai

- syntaxe

- zéphyrnet