Nous avons formé et open source un réseau de neurones appelé Whisper qui se rapproche de la robustesse et de la précision au niveau humain sur la reconnaissance vocale en anglais.

Voir le code

Voir la carte modèle

Exemples chuchotés :

Whisper est un système de reconnaissance vocale automatique (ASR) formé sur 680,000 XNUMX heures de données supervisées multilingues et multitâches collectées sur le Web. Nous montrons que l'utilisation d'un ensemble de données aussi vaste et diversifié améliore la robustesse aux accents, au bruit de fond et au langage technique. De plus, il permet la transcription dans plusieurs langues, ainsi que la traduction de ces langues vers l'anglais. Nous sommes des modèles open-source et un code d'inférence pour servir de base à la création d'applications utiles et à des recherches plus approfondies sur le traitement robuste de la parole.

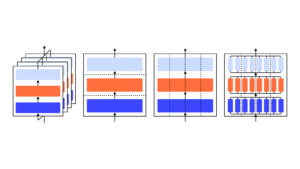

L'architecture Whisper est une approche simple de bout en bout, implémentée comme un transformateur d'encodeur-décodeur. L'audio d'entrée est divisé en morceaux de 30 secondes, converti en un spectrogramme log-Mel, puis transmis à un encodeur. Un décodeur est formé pour prédire la légende de texte correspondante, mélangée à des jetons spéciaux qui dirigent le modèle unique pour effectuer des tâches telles que l'identification de la langue, les horodatages au niveau de la phrase, la transcription vocale multilingue et la traduction vocale vers l'anglais.

D'autres approches existantes utilisent fréquemment des ensembles de données de formation audio-texte plus petits et plus étroitement appariés, ou utilisez un pré-entraînement audio large mais non supervisé. Parce que Whisper a été formé sur un ensemble de données vaste et diversifié et n'a pas été adapté à un ensemble spécifique, il ne bat pas les modèles spécialisés dans les performances de LibriSpeech, une référence réputée compétitive en matière de reconnaissance vocale. Cependant, lorsque nous mesurons les performances zéro coup de Whisper sur de nombreux ensembles de données divers, nous constatons qu'il est beaucoup plus robuste et fait 50 % moins d'erreurs que ces modèles.

Environ un tiers de l'ensemble de données audio de Whisper n'est pas en anglais, et il est alternativement chargé de transcrire dans la langue d'origine ou de traduire en anglais. Nous trouvons que cette approche est particulièrement efficace pour apprendre la traduction de la parole au texte et surpasse le SOTA supervisé sur CoVoST2 vers la traduction en anglais zéro-shot.

Nous espérons que la haute précision et la facilité d'utilisation de Whisper permettront aux développeurs d'ajouter des interfaces vocales à un ensemble d'applications beaucoup plus large. Vérifiez papier, carte modèleet code pour en savoir plus et essayer Whisper.

- AI

- art de l'IA

- générateur d'art ai

- robot IA

- intelligence artificielle

- certification en intelligence artificielle

- intelligence artificielle en banque

- robot d'intelligence artificielle

- robots d'intelligence artificielle

- logiciel d'intelligence artificielle

- blockchain

- conférence blockchain ai

- cognitif

- intelligence artificielle conversationnelle

- crypto conférence ai

- de dall

- l'apprentissage en profondeur

- google ai

- machine learning

- OpenAI

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- un article

- échelle ai

- syntaxe

- zéphyrnet