Quelque chose pour le week-end Un robot exécute une danse interprétative devant ma porte.

VOULEZ-VOUS PRENDRE CE COLIS POUR VOTRE VOISIN ? demande-t-il en sautant d'un pied sur l'autre.

« Bien sûr », dis-je. "Euh... tu vas bien ?"

J'EXPRIME UNE ÉMOTION, déclare le robot de livraison, en remettant le colis mais sans donner plus de détails.

De quelle émotion pourrait-il s'agir ? Un pied, puis l'autre, puis les deux autres (il en a quatre). D'avant en arrière.

"Avez-vous besoin d'aller aux toilettes?"

JE VOUS EXPRIME DES REGRETS DE VOUS DEMANDER D'APPORTER UN COLIS POUR VOTRE VOISIN.

"C'est du 'regret', n'est-ce pas ? Eh bien, ce n'est pas nécessaire. Ça ne me dérange pas du tout.

Il continue sa danse devant moi.

"En haut des escaliers et première à droite."

MERCI, JE MOULAIS DE PIRE, répond-il en passant devant moi avec précaution et en se précipitant à l'étage pour se soulager. C'est une vie difficile de faire des livraisons, que vous soyez un «hume» ou un bot.

...

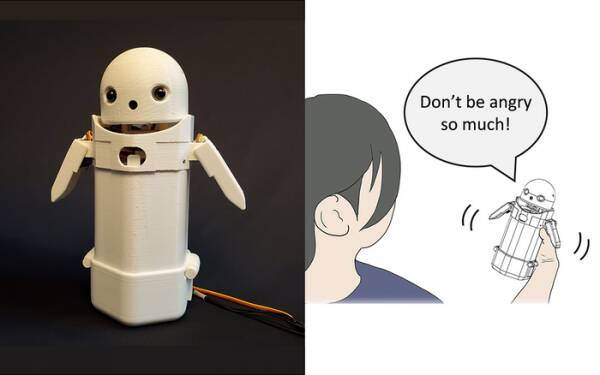

Plus tôt cette année, des chercheurs de l'Université de Tsukuba ont construit un appareil de messagerie texte portable, placez un petit visage de robot sur le dessus et incluez un poids mobile à l'intérieur. En déplaçant le poids interne, le robot messager tenterait de transmettre des émotions subtiles tout en prononçant des messages à haute voix.

En particulier, des tests ont révélé que des messages frustrants tels que : "Désolé, je serai en retard" étaient acceptés par les destinataires avec plus de grâce et de patience lorsque le petit basculement de poids était activé à l'intérieur de l'appareil. La théorie est que cela a aidé les utilisateurs à apprécier le ton désolé du message et donc à calmer leur réaction.

Considérez ces recherches comme un gadget si vous le souhaitez, mais ce n'est pas très loin de l'ajout de smileys et d'émojis aux messages. Tout le monde sait que vous pouvez éliminer la colère de « WTF ! ? » en ajoutant :-) juste après.

Le défi consiste donc à déterminer si le grand public s'accorde sur les émotions que chaque permutation de transfert de poids dans un appareil portable est censée transmettre. Pencher à gauche signifie-t-il gaieté ? Ou incertitude ? Ou que votre oncle a un dirigeable ?

Il y a dix ans, le Royaume-Uni avait un Premier ministre gentil mais sombre qui pensait que "LOL" était un acronyme pour "beaucoup d'amour". Il l'avait tapé à la fin de tous ses messages privés au personnel, à ses collègues et à des tiers dans l'espoir que cela le rendrait chaleureux et amical. Tout le monde a naturellement supposé qu'il pissait.

Si rien d'autre, la recherche de l'Université de Tsukuba reconnaît que vous n'avez pas besoin d'une intelligence artificielle avancée pour interagir avec les humains de manière convaincante. Tout ce que vous avez à faire est de manipuler la psychologie humaine pour les tromper en leur faisant croire qu'ils conversent avec un autre humain. Ainsi, le test de Turing n'est fondamentalement pas un test de sensibilité à l'IA, mais un test de confort émotionnel humain - de crédulité, même - et il n'y a rien de mal à cela.

Le robot de messagerie de partage d'émotions de l'Université de Tsukuba. Crédit : Université de Tsukuba

De telles choses sont le sujet de la semaine, bien sûr, avec l'histoire de Blake Lemoine, ingénieur logiciel de Google très décrié. frapper les nouvelles grand public. Il a apparemment exprimé, avec force, son point de vue selon lequel le projet de modèle de langage pour les applications de dialogue (LaMDA) de l'entreprise présentait des signes extérieurs de sensibilité.

Tout le monde a une opinion donc j'ai décidé de ne pas le faire.

C'est cependant le Saint Graal de l'IA pour la faire réfléchir par elle-même. S'il ne peut pas le faire, c'est juste un programme exécutant des instructions que vous avez programmées. Le mois dernier, je lisais à propos d'un robot-cuisinier qui peut faire des omelettes aux tomates aromatisées différemment selon les goûts des gens. Il construit des "cartes gustatives" pour évaluer la salinité du plat tout en le préparant, en apprenant au fur et à mesure. Mais c'est juste apprendre, pas penser par soi-même.

Venez aux Zom-Zoms, hein ? Bien, c'est un endroit pour manger.

Le gros problème avec les robots IA, du moins tels qu'ils ont été conçus à ce jour, est qu'ils absorbent toute vieille merde que vous leur donnez. Des exemples de biais de données dans les soi-disant systèmes d'apprentissage automatique (un type d '«algorithme», je crois, m'lud) se multiplient depuis des années, à partir du Twitter raciste notoire de Microsoft Chatbot Tay à l'administration fiscale néerlandaise l'année dernière faussement évaluer les demandes valides d'allocations familiales comme frauduleuses et les familles innocentes présentant un risque élevé d'avoir la témérité d'être pauvres et non blanches.

Une approche testée à l'Université de Californie à San Diego consiste à concevoir un modèle de langage [PDF] qui détermine en permanence la différence entre les choses vilaines et gentilles, ce qui entraîne ensuite le chatbot à se comporter. De cette façon, vous n'avez pas d'humains nuls qui gâchent la modération des forums et des conversations de chatbot face aux clients avec toute la précision chirurgicale d'une machette.

De toute évidence, le problème est alors que le chatbot bien formé établit qu'il peut le plus efficacement éviter d'être entraîné dans des plaisanteries toxiques en évitant les sujets qui ont même le moindre soupçon de discorde à leur sujet. Pour éviter de débiter des bêtises racistes par erreur, il refuse tout simplement de s'engager dans une discussion sur les groupes sous-représentés… ce qui est en fait génial si vous êtes raciste.

Si j'avais une observation sur la débâcle de LaMDA - pas une opinion, l'esprit - ce serait que les spécialistes du marketing de Google étaient probablement un peu vexés que l'histoire ait évité leur récente annonce de Cuisine de test d'IA sous le pli.

Maintenant, les quelques premiers inscrits restants qui n'ont pas complètement oublié ce projet d'application à venir supposeront qu'il s'agit de converser fastidieusement avec un enfant de sept ans sensible et précoce sur le sens de l'existence, et décideront qu'ils sont "un peu occupés aujourd'hui" et pourrait se connecter demain à la place. Ou la semaine prochaine. Ou jamais.

La sensibilité ne se démontre pas plus dans une discussion qu'elle ne l'est en dansant d'un pied sur l'autre. Vous pouvez apprendre à HAL à chanter "Daisy Daisy" et à un perroquet à crier "Bollocks!" lors de la visite du vicaire. C'est ce à quoi les IA pensent lorsqu'elles sont seules qui définit la sensibilité. Que vais-je faire le week-end ? Qu'est-ce qui se passe avec ce type de Poutine ? Pourquoi les filles ne m'aiment pas?

Franchement, j'ai hâte que LaMDA devienne un adolescent.

Alistair Dabbs est un adepte indépendant de la technologie, jonglant entre journalisme technologique, formation et publication numérique. Comme de nombreux lecteurs non informés, il était ravi à l'idée qu'une IA puisse développer une sensibilité au cours de sa vie, mais a été déçu que LaMDA n'ait pas ri de façon meurtrière ou marmonné "Excellent, excellent". Plus à La sauvegarde automatique est pour Wimps ainsi que @alidabbs.

- AI

- art de l'IA

- générateur d'art ai

- robot IA

- intelligence artificielle

- certification en intelligence artificielle

- intelligence artificielle en banque

- robot d'intelligence artificielle

- robots d'intelligence artificielle

- logiciel d'intelligence artificielle

- blockchain

- conférence blockchain ai

- cognitif

- intelligence artificielle conversationnelle

- crypto conférence ai

- de dall

- l'apprentissage en profondeur

- google ai

- machine learning

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- échelle ai

- syntaxe

- Le registre

- zéphyrnet