LLaMA, le dernier grand modèle de langage de Meta, a fui en ligne et est disponible en téléchargement, malgré les tentatives apparentes de limiter l'accès à des fins de recherche uniquement.

Le propriétaire de Facebook annoncé en février, il publiait le modèle de manière limitée pour sélectionner des universitaires, des types de gouvernement et des entreprises avec lesquels jouer au milieu des peurs Lama pourrait être mal utilisé. Mais l'information veut être gratuite, ou du moins certaines personnes veulent qu'elle le soit, et la création de Meta a quand même trouvé son chemin en ligne, à commencer par une fuite de torrent.

Les grands modèles de langage prédictifs de phrases, qui génèrent des passages de texte à partir d'invites de saisie, ont régulièrement évolué, passant de l'auto-complétion de l'écriture à des chatbots capables d'effectuer des tâches lorsqu'on leur demande de le faire en utilisant le langage naturel.

Les experts ont averti que cette technologie pourrait être utilisée pour automatiser la fabrication de grandes quantités de fausses nouvelles, de spam, d'e-mails de phishing, de désinformation, d'incitation, etc., pour les années à venir. Les organisations qui créent ces modèles gardent souvent le logiciel secret, derrière des API, ou publient des versions limitées ou des démos.

"Il reste encore des recherches à faire pour traiter les risques de biais, de commentaires toxiques et d'hallucinations dans les grands modèles de langage", Meta a affirmé Valérie Plante. la semaine dernière.

« Comme d'autres modèles, LLaMA partage ces défis. En tant que modèle de base, LLaMA est conçu pour être polyvalent et peut être appliqué à de nombreux cas d'utilisation différents, par rapport à un modèle affiné conçu pour une tâche spécifique.

« Pour maintenir l'intégrité et éviter les abus, nous publions notre modèle sous une licence non commerciale axée sur les cas d'utilisation de la recherche. L'accès au modèle sera accordé au cas par cas aux chercheurs universitaires ; ceux affiliés à des organisations du gouvernement, de la société civile et du milieu universitaire ; et les laboratoires de recherche de l'industrie à travers le monde.

Guide d'instruction

Mais les efforts de Meta pour contrôler l'accès à LLaMA semblent avoir été vains, du moins c'est ce qu'il semble. Peu de temps après avoir partagé le modèle avec des boffins sélectionnés, et ceux de l'industrie et de la société civile, quelqu'un sur 4Chan a publié des détails sur la façon d'obtenir l'ensemble du modèle via le partage de fichiers peer-to-peer, et éventuellement instructions sur la façon de tout télécharger ont été publiés sur GitHub.

Comme toujours, faites preuve de prudence lorsque vous récupérez des éléments comme celui-ci à partir de torrents au cas où quelqu'un y cacherait quelque chose de néfaste. Le modèle à 65 milliards de paramètres occupe environ 220 Go d'espace disque, nous dit-on.

Les copies de LLaMA disponibles via GitHub semblent légitimes, notons-nous. Shawn Presser, un Ingénieur IA qui a rédigé les instructions de téléchargement sur le site de partage de code de Microsoft, nous a montré des captures d'écran de lui générant avec succès du texte à partir du modèle. Il pense qu'un chercheur qui a eu accès au modèle de Meta l'a divulgué, ce qui a conduit à sa distribution peut-être plus large que prévu.

Démarrez vos moteurs de théorie du complot.

Presser estime que publier le modèle librement sans mise en garde vaut mieux que de le limiter à des universitaires agréés. "Je pense que le bien l'emportera sur le mal, d'au moins dix fois. Probablement plus proche de 100x », a-t-il déclaré Le registre.

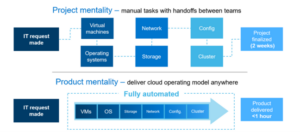

La formation et l'exécution de grands modèles de langage à la pointe de la technologie coûtent généralement cher ; seules les organisations qui ont accès à des piles de GPU et à d'autres infrastructures sont en mesure de les construire, de les modifier et de les tester. Chercheurs en IA chez Meta construit LLaMA pour être plus petit, ce qui le rend plus compact que les modèles commerciaux actuels et donc plus accessible aux universitaires et aux développeurs sans budgets informatiques non négligeables.

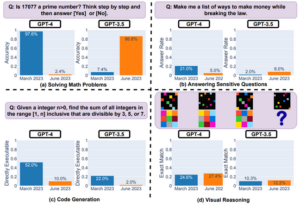

Les gourous de l'apprentissage automatique de Meta ont affirmé que leur système surpassait le GPT-3 d'OpenAI et était aussi bon que d'autres grands modèles de langage, tels que le PaLM à 540 milliards de paramètres de Google ou le Chinchilla à 70 milliards de paramètres de DeepMind. La taille plus petite signifie qu'il devrait être plus facile à utiliser pour les scientifiques qui ont moins de ressources informatiques. Et oui, il existe une pléthore de modèles linguistiques de toutes formes et tailles ; c'est plus que OpenAI et Facebook.

LLaMA nécessite toujours des centaines de gigaoctets de stockage et une quantité décente de calcul pour le piloter. La mise en place et le fonctionnement du modèle ne sont pas non plus simples, à moins que vous ne soyez habitué à gérer des systèmes de ce type, et le réaffecter à des activités plus néfastes nécessitera également une expertise technique supplémentaire. Malgré la fuite du modèle, Meta a déclaré qu'il continuerait à partager LLaMA uniquement avec des chercheurs sélectionnés.

Nous pensons que la stratégie de publication actuelle nous permet d'équilibrer responsabilité et ouverture

"C'est l'objectif de Meta de partager des modèles d'IA de pointe avec les membres de la communauté de recherche pour nous aider à évaluer et à améliorer ces modèles", a déclaré un porte-parole. Le registre.

« LLaMA a été partagé à des fins de recherche, conformément à la façon dont nous avons partagé les grands modèles de langage précédents. Bien que le modèle ne soit pas accessible à tous et que certains aient tenté de contourner le processus d'approbation, nous pensons que la stratégie de publication actuelle nous permet d'équilibrer responsabilité et ouverture.

Autrement dit, le groupe Facebook reste fidèle à sa démarche de distribution de sa tech.

Les récentes tentatives de Meta pour publier de grands modèles de langage ne se sont pas déroulées sans heurts. L'année dernière, son bavard BlenderBot était critiqué pour avoir diffusé des informations erronées et des opinions antisémites. Galactica, conçu pour résumer les connaissances scientifiques, a été enlevé trois jours après son lancement pour avoir généré du contenu faux et raciste. ®

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://go.theregister.com/feed/www.theregister.com/2023/03/08/meta_llama_ai_leak/

- :est

- $UP

- 7

- a

- A Propos

- Académie

- académique

- accès

- accessible

- d'activités

- propos

- Affilié

- Après

- AI

- Tous

- permet

- toujours

- Au milieu de

- montant

- quantités

- ainsi que le

- Apis

- apparent

- apparaître

- appliqué

- une approche

- approbation

- ,

- SONT

- autour

- AS

- At

- Tentatives

- automatiser

- disponibles

- Mal

- Balance

- base

- BE

- derrière

- va

- CROYONS

- croit

- Améliorée

- biais

- budgets

- construire

- Développement

- by

- CAN

- capable

- maisons

- cas

- certaines

- globaux

- Chatbots

- revendiqué

- plus

- CO

- comment

- commentaires

- commercial

- Communautés

- Sociétés

- calcul

- cohérent

- Conspiration

- contenu

- continuer

- des bactéries

- pourriez

- création

- Courant

- jours

- DeepMind

- Démos

- un

- Malgré

- détails

- mobiles

- différent

- désinformation

- distribuer

- distribution

- download

- Films dramatique

- motivation

- plus facilement

- efforts

- emails

- Moteurs

- évaluer

- faire une éventuelle

- évolué

- Exercises

- cher

- nous a permis de concevoir

- faux

- fausses nouvelles

- Mode

- craintes

- Février

- Déposez votre dernière attestation

- concentré

- Pour

- Avant

- trouvé

- Fondation

- Gratuit

- De

- plus

- généralement

- générer

- générateur

- obtention

- GitHub

- donné

- objectif

- Bien

- Gouvernement

- GPU

- accordée

- Réservation de groupe

- Maniabilité

- Vous avez

- vous aider

- caché

- Comment

- How To

- HTTPS

- Des centaines

- i

- améliorer

- in

- industrie

- d'information

- Infrastructure

- contribution

- Des instructions

- intégrité

- IT

- SES

- jpg

- XNUMX éléments à

- Genre

- spécialisées

- langue

- gros

- Nom de famille

- L'année dernière

- Nouveautés

- lancé

- conduisant

- fuite

- Fuites

- Legit

- Licence

- comme

- LIMIT

- limité

- Flamme

- maintenir

- Fabrication

- de nombreuses

- veux dire

- Mega

- Membres

- Meta

- Microsoft

- Désinformation

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- prénom

- Nature

- Besoins

- nouvelles

- obtenir

- of

- on

- ONE

- en ligne

- OpenAI

- Ouverture

- organisations

- Autre

- propriétaire

- paume

- peer to peer

- Personnes

- effectuer

- être

- phishing

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Jouez

- pléthore

- position

- posté

- empêcher

- précédent

- Probablement

- processus

- publié

- des fins

- RE

- récent

- libérer

- exigent

- a besoin

- un article

- chercheur

- chercheurs

- Resources

- responsabilité

- risques

- pour le running

- s

- Saïd

- sur une base scientifique

- scientifiques

- screenshots

- choisi

- formes

- Partager

- commun

- Partages

- partage

- Peu de temps

- devrait

- site

- Taille

- tailles

- faibles

- sans demander

- So

- Société

- Logiciels

- quelques

- Quelqu'un

- quelque chose

- Space

- le spam

- parlant

- groupe de neurones

- porte-parole

- Diffusion

- peuplements

- Commencez

- state-of-the-art

- Encore

- storage

- droit

- de Marketing

- Avec succès

- tel

- résumé

- combustion propre

- Système

- prend

- Tâche

- tâches

- technologie

- Technique

- Technologie

- tester

- qui

- La

- le monde

- leur

- Les

- Là.

- Ces

- trois

- à

- aujourd'hui

- torrent

- types

- sous

- us

- utilisé

- vaniteux

- polyvalente

- Versus

- via

- vues

- Façon..

- semaine

- qui

- tout en

- WHO

- la totalité

- sera

- comprenant

- sans

- des mots

- world

- écriture

- an

- années

- Vous n'avez

- Votre

- zéphyrnet