Être capable de décoder les ondes cérébrales pourrait aider les patients qui ont perdu la capacité de parler à communiquer à nouveau, et pourrait finalement fournir de nouvelles façons aux humains d'interagir avec les ordinateurs. Maintenant, les méta-chercheurs ont montré qu'ils pouvaient dire quels mots quelqu'un est entendre en utilisant des enregistrements de scanners cérébraux non invasifs.

Notre capacité à sonder humain l'activité cérébrale s'est considérablement améliorée au cours des dernières décennies, car les scientifiques ont développé une variété de technologies d'interface cerveau-ordinateur (BCI) qui peuvent ouvrir une fenêtre sur nos pensées et nos intentions.

Les résultats les plus impressionnants sont venus des dispositifs d'enregistrement invasifs, qui implantent des électrodes directement dans le cerveaux gray matière, combiné avec AI qui peut apprendre à interprétert signaux cérébraux. Ces dernières années, cela a made-il possible de décoder des phrases complètes de l'activité neuronale de quelqu'un avec une précision de 97 %, et traduire les tentatives mouvements d'écriture directement dans le texte à des vitesses comparablesle aux textos.

Mais devoir implanter des électrodes dans le cerveau de quelqu'un a des inconvénients évidents. Ces procédures risquées ne sont médicalement justifiables que pour les patients qui ont besoin d'un enregistrement cérébral pour aider à résoudre d'autres problèmes médicaux, tels que l'épilepsie. Et les sondes neuronales se dégradent avec le temps, ce qui fait craindre de devoir les remplacer régulièrement.

C'est pourquoi les chercheurs de la division de recherche sur l'IA de Meta ont décidé d'étudier s'ils pouvaient atteindre des objectifs similaires sans nécessiter de chirurgie cérébrale dangereuse.y. Dans un papier publié sur le serveur de prépublication arXiv, l'équipe a indiqué avoir développé un système d'IA capable de prédire les mots que quelqu'un écoute en fonction de l'activité cérébrale enregistrée à l'aide de méthodes non invasives interfaces cerveau-ordinateur.

"Il est évidemment extrêmement invasif de mettre une électrode dans le cerveau de quelqu'un », a déclaré Jean Remi King, chercheur au Facebook Artificial Intelligence Research (FAIR) Lab. dit . "Nous avons donc voulu essayer d'utiliser des enregistrements non invasifs de l'activité cérébrale. Et l'objectif était de construire un système d'IA capable de décoder les réponses cérébrales aux histoires parlées.

Les chercheurs se sont appuyés sur quatre ensembles de données préexistantes sur l'activité cérébrale recueillies auprès de 169 personnes alors qu'ils écoutaient des enregistrements de personnes parlant. Chaque volontaire a été enregistré à l'aide de la magnéto-encéphalographie (MEG) ou de l'électro-encéphalographie (EEG), qui utilisent différents types de capteurs pour capter l'activité électrique du cerveau depuis l'extérieur du crâne.

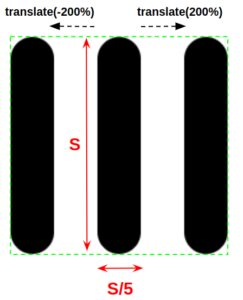

Leur démarche impliqued diviser le cerveau et les données audio en Trois-extraits d'une seconde longueur et en les alimentant dans un réseau neuronal qui regarde ensuiteed pour les modèles qui could connecter les deux. Après avoir entraîné l'IA sur de nombreuses heures de ces données, ils l'ont ensuite testée sur des données inédites.

Le système a obtenu les meilleurs résultats sur l'un des ensembles de données MEG, où il a atteint une précision de 10 %. Cela signifie que lorsqu'il a classé le 10 mots avec la plus grande probabilité d'être liés au segment d'ondes cérébrales, le mot correct était là 72.5 pour cent du temps.

Cela peut ne pas sembler génial, mais il est important de se rappeler qu'il s'agissait d'un vocabulaire potentiel de 793 des mots. Le système a obtenu un score de 67.2 % sur l'autre ensemble de données MEG, mais s'est moins bien comporté sur les ensembles de données EEG, obtenant le top 1.0 précisions de seulement 31.4 et 19.1.

Il est clair que nous sommes encore loin d'un système pratique, mais cela représente un progrès significatif sur un problème difficile. Les BCI non invasifs ont des rapports signal sur bruit bien pires, donc déchiffrer l'activité neuronale de cette façon est difficile, mais en cas de succès, cela pourrait aboutir à une technologie beaucoup plus largement applicable.

Cependant, tout le monde n'est pas convaincu qu'il s'agit d'un problème résoluble. Thomas Knopfel de l'Imperial College de Londres a déclaré New Scientist qu'essayer de sonder les pensées en utilisant ces approches non invasives était comme "essayer de diffuser un film HD sur des modems téléphoniques analogiques à l'ancienne », et s'est demandé si de telles approches atteindraient un jour des niveaux de précision pratiques.

Des entreprises comme Neuralink d'Elon Musk parient également que nous finirons par surmonter nos dégoûts autour des approches invasives à mesure que la technologie s'améliore, ouvrant la porte aux gens ordinaires qui reçoivent des implants cérébraux.

Mais la recherche de l'équipe de Meta n'en est qu'à ses débuts et il y a beaucoup de possibilités d'amélioration. Et les opportunités commerciales pour quiconque peut déchiffrer le scanner cérébral non invasif fourniront probablement beaucoup de motivation pour essayer.

Crédit image: Bousier Tran de Pixabay

- algorithme

- intelligence artificielle

- blockchain

- Interface cerveau-ordinateur

- cognitif

- informatique

- de la cryptographie

- zéro

- quantique d'ibm

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- ordinateurs quantiques

- l'informatique quantique

- la physique quantique

- Singularity Hub

- Les sujets

- zéphyrnet