Introduction

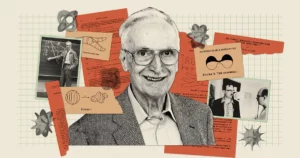

L’intelligence artificielle semble plus puissante que jamais, avec des chatbots comme Bard et ChatGPT capables de produire des textes étrangement humains. Mais malgré tous leurs talents, ces robots laissent encore les chercheurs se demander : de tels modèles vraiment comprendre qu'est-ce qu'ils disent ? "De toute évidence, certaines personnes le croient", a déclaré le pionnier de l'IA. Geoff Histon dans un conversation récente avec Andrew Ng, « et certaines personnes croient qu’ils ne sont que des perroquets stochastiques ».

Cette phrase évocatrice vient d'un 2021 papier co-écrit par Emily Bender, linguiste informatique à l'Université de Washington. Il suggère que les grands modèles linguistiques (LLM) – qui constituent la base des chatbots modernes – génèrent du texte uniquement en combinant des informations qu’ils ont déjà vues « sans aucune référence au sens », écrivent les auteurs, ce qui fait d’un LLM « un perroquet stochastique ».

Ces modèles alimentent bon nombre des chatbots les plus importants et les meilleurs d'aujourd'hui. Hinton a donc soutenu qu'il était temps de déterminer l'étendue de ce qu'ils comprennent. Pour lui, la question est plus qu’académique. « Tant que nous aurons ces divergences d’opinions, a-t-il dit à Ng, nous ne pourrons pas parvenir à un consensus sur les dangers ».

De nouvelles recherches pourraient laisser entrevoir une réponse. Une théorie développée par Sanjeev Arora de l'Université de Princeton et Anirudh Goyal, chercheur chez Google DeepMind, suggère que les plus grands LLM actuels ne sont pas des perroquets stochastiques. Les auteurs soutiennent qu'à mesure que ces modèles grandissent et sont formés sur davantage de données, ils améliorent les capacités individuelles liées au langage et en développent également de nouvelles en combinant les compétences d'une manière qui laisse présager une compréhension - des combinaisons qui étaient peu susceptibles d'exister dans les données de formation. .

Cette approche théorique, qui fournit un argument mathématiquement démontrable expliquant comment et pourquoi un LLM peut développer autant de capacités, a convaincu des experts comme Hinton et d'autres. Et lorsque Arora et son équipe ont testé certaines de ses prédictions, ils ont constaté que ces modèles se comportaient presque exactement comme prévu. De tous les témoignages, ils ont fait valoir avec force que les plus grands LLM ne se contentent pas de répéter ce qu'ils ont vu auparavant.

"[Ils] ne peuvent pas simplement imiter ce qui a été vu dans les données d'entraînement", a déclaré Sébastien Bubeck, mathématicien et informaticien chez Microsoft Research qui n'a pas participé aux travaux. "C'est l'idée de base."

Plus de données, plus de puissance

L'émergence d' capacités inattendues et diverses en LLM, il est juste de le dire, a été une surprise. Ces capacités ne sont pas une conséquence évidente de la manière dont les systèmes sont construits et formés. Un LLM est un réseau neuronal artificiel massif qui connecte des neurones artificiels individuels. Ces connexions sont appelées paramètres du modèle et leur nombre indique la taille du LLM. La formation consiste à donner au LLM une phrase dont le dernier mot est masqué, par exemple : « Le carburant coûte un bras et un ___ ». Le LLM prédit une distribution de probabilité sur l’ensemble de son vocabulaire, donc s’il connaît, disons, mille mots, il prédit mille probabilités. Il choisit ensuite le mot le plus susceptible de compléter la phrase – vraisemblablement « jambe ».

Au départ, le LLM peut mal choisir les mots. L'algorithme d'entraînement calcule ensuite une perte (la distance, dans un espace mathématique de grande dimension, entre la réponse du LLM et le mot réel dans la phrase originale) et utilise cette perte pour ajuster les paramètres. Désormais, avec la même phrase, le LLM calculera une meilleure distribution de probabilité et sa perte sera légèrement inférieure. L'algorithme effectue cela pour chaque phrase des données d'entraînement (éventuellement des milliards de phrases), jusqu'à ce que la perte globale du LLM retombe à des niveaux acceptables. Un processus similaire est utilisé pour tester le LLM sur des phrases qui ne faisaient pas partie des données de formation.

Un LLM formé et testé, lorsqu'on lui présente une nouvelle invite de texte, générera le mot suivant le plus probable, l'ajoutera à l'invite, générera un autre mot suivant et continuera de cette manière, produisant une réponse apparemment cohérente. Rien dans le processus de formation ne suggère que des LLM plus importants, construits en utilisant plus de paramètres et de données de formation, devraient également s'améliorer dans les tâches qui nécessitent un raisonnement pour y répondre.

Mais ils le font. Les LLM suffisamment grands démontrent des capacités - de la résolution de problèmes mathématiques élémentaires à la réponse à des questions sur ce qui se passe dans l'esprit des autres - que les modèles plus petits n'ont pas, même s'ils sont tous formés de la même manière.

« D’où est née cette [capacité] ? » » se demanda Arora. "Et cela peut-il émerger d'une simple prédiction du mot suivant ?"

Connecter les compétences au texte

Arora a fait équipe avec Goyal pour répondre analytiquement à ces questions. "Nous essayions de proposer un cadre théorique pour comprendre comment l'émergence se produit", a déclaré Arora.

Le duo s’est tourné vers des objets mathématiques appelés graphiques aléatoires. Un graphique est une collection de points (ou nœuds) reliés par des lignes (ou des arêtes), et dans un graphique aléatoire, la présence d'une arête entre deux nœuds quelconques est dictée de manière aléatoire, par exemple par un tirage au sort. La pièce peut être biaisée, de sorte qu'elle tombe face avec une certaine probabilité p. Si la pièce tombe face à une paire de nœuds donnée, un bord se forme entre ces deux nœuds ; sinon, ils restent déconnectés. Comme la valeur de p changements, les graphiques peuvent montrer des transitions soudaines dans leurs propriétés. Par exemple, quand p dépasse un certain seuil, les nœuds isolés – ceux qui ne sont connectés à aucun autre nœud – disparaissent brusquement.

Arora et Goyal ont réalisé que les graphiques aléatoires, qui donnent lieu à des comportements inattendus après avoir atteint certains seuils, pourraient constituer un moyen de modéliser le comportement des LLM. Les réseaux de neurones sont devenus presque trop complexes à analyser, mais les mathématiciens étudient les graphes aléatoires depuis longtemps et ont développé divers outils pour les analyser. Peut-être que la théorie des graphes aléatoires pourrait donner aux chercheurs un moyen de comprendre et de prédire les comportements apparemment inattendus des grands LLM.

Les chercheurs ont décidé de se concentrer sur les graphes « bipartis », qui contiennent deux types de nœuds. Dans leur modèle, un type de nœud représente des morceaux de texte – pas des mots individuels mais des morceaux pouvant aller d'un paragraphe à quelques pages. Ces nœuds sont disposés en ligne droite. En dessous d'eux, sur une autre ligne, se trouve l'autre ensemble de nœuds. Celles-ci représentent les compétences nécessaires pour donner un sens à un morceau de texte donné. Chaque compétence peut être presque n'importe quoi. Peut-être qu'un nœud représente la capacité d'un LLM à comprendre le mot « parce que », qui intègre une certaine notion de causalité ; un autre pourrait représenter la capacité de diviser deux nombres ; un autre encore pourrait représenter la capacité à détecter l’ironie. "Si vous comprenez que ce morceau de texte est ironique, beaucoup de choses basculent", a déclaré Arora. "C'est pertinent pour prédire les mots."

Pour être clair, les LLM ne sont pas formés ou testés en pensant aux compétences ; ils sont conçus uniquement pour améliorer la prédiction du mot suivant. Mais Arora et Goyal voulaient comprendre les LLM du point de vue des compétences qui pourraient être requises pour comprendre un seul texte. Une connexion entre un nœud de compétence et un nœud de texte, ou entre plusieurs nœuds de compétence et un nœud de texte, signifie que le LLM a besoin de ces compétences pour comprendre le texte de ce nœud. En outre, plusieurs morceaux de texte peuvent s'inspirer de la même compétence ou du même ensemble de compétences ; par exemple, un ensemble de nœuds de compétences représentant la capacité à comprendre l'ironie se connecterait aux nombreux nœuds de texte où l'ironie se produit.

Le défi consistait désormais à relier ces graphiques bipartites à de véritables LLM et à voir si les graphiques pouvaient révéler quelque chose sur l’émergence de capacités puissantes. Mais les chercheurs ne pouvaient s’appuyer sur aucune information sur la formation ou les tests des LLM réels – des entreprises comme OpenAI ou DeepMind ne rendent pas publiques leurs données de formation ou de test. En outre, Arora et Goyal voulaient prédire comment les LLM se comporteraient à mesure qu'ils devenaient encore plus grands, et aucune information de ce type n'est disponible pour les prochains chatbots. Il existait cependant une information cruciale à laquelle les chercheurs pouvaient accéder.

Depuis 2021, les chercheurs étudiant les performances des LLM et d’autres réseaux de neurones ont vu émerger un trait universel. Ils ont remarqué qu'à mesure qu'un modèle grandit, que ce soit en taille ou en quantité de données d'entraînement, sa perte en données de test (la différence entre les réponses prédites et correctes sur les nouveaux textes, après l'entraînement) diminue de manière très spécifique. Ces observations ont été codifiées dans des équations appelées lois d’échelle neuronale. Arora et Goyal ont donc conçu leur théorie pour qu'elle ne dépende pas des données d'un LLM individuel, d'un chatbot ou d'un ensemble de données de formation et de test, mais de la loi universelle à laquelle ces systèmes sont tous censés obéir : la perte prédite par les lois d'échelle.

Peut-être, pensaient-ils, l’amélioration des performances – telle que mesurée par les lois d’échelle neuronale – était liée à l’amélioration des compétences. Et ces compétences améliorées pourraient être définies dans leurs graphiques bipartites par la connexion des nœuds de compétences aux nœuds de texte. L’établissement de ce lien – entre les lois d’échelle neuronale et les graphes bipartites – était la clé qui leur permettrait de procéder.

Développer les compétences

Les chercheurs ont commencé par supposer qu’il existe un hypothétique graphe biparti correspondant au comportement d’un LLM sur les données de test. Pour expliquer l'évolution de la perte du LLM sur les données de test, ils ont imaginé un moyen d'utiliser le graphique pour décrire comment le LLM gagne en compétences.

Prenez, par exemple, la compétence « comprendre l’ironie ». Cette idée est représentée par un nœud de compétence, les chercheurs cherchent donc à voir à quels nœuds de texte ce nœud de compétence se connecte. Si presque tous ces nœuds de texte connectés réussissent – ce qui signifie que les prédictions du LLM sur le texte représenté par ces nœuds sont très précises – alors le LLM est compétent dans cette compétence particulière. Mais si plus d'une certaine fraction des connexions du nœud de compétence vont vers des nœuds de texte défaillants, alors le LLM échoue au niveau de cette compétence.

Cette connexion entre ces graphes bipartites et les LLM a permis à Arora et Goyal d'utiliser les outils de la théorie des graphes aléatoires pour analyser le comportement des LLM par proxy. L'étude de ces graphiques a révélé certaines relations entre les nœuds. Ces relations, à leur tour, se sont traduites par une manière logique et testable d'expliquer comment les grands modèles ont acquis les compétences nécessaires pour atteindre leurs capacités inattendues.

Arora et Goyal ont d'abord expliqué un comportement clé : pourquoi les grands LLM deviennent plus compétents que leurs homologues plus petits sur les compétences individuelles. Ils ont commencé avec la perte de test la plus faible prévue par les lois de mise à l'échelle neuronale. Dans un graphique, cette perte de test inférieure est représentée par une diminution de la fraction de nœuds de test défaillants. Il y a donc globalement moins de nœuds de test ayant échoué. Et s’il y a moins de nœuds de test ayant échoué, alors il y a moins de connexions entre les nœuds de test ayant échoué et les nœuds de compétences. Par conséquent, un plus grand nombre de nœuds de compétences sont connectés aux nœuds de test réussis, ce qui suggère une compétence croissante en compétences pour le modèle. "Une très légère réduction des pertes permet à la machine d'acquérir ces compétences", a déclaré Goyal.

Ensuite, les deux hommes ont trouvé un moyen d’expliquer les capacités inattendues d’un modèle plus grand. À mesure que la taille d'un LLM augmente et que ses pertes aux tests diminuent, des combinaisons aléatoires de nœuds de compétences développent des connexions avec des nœuds de texte individuels. Cela suggère que le LLM s'améliore également dans l'utilisation de plus d'une compétence à la fois et commence à générer du texte en utilisant plusieurs compétences - en combinant, par exemple, la capacité d'utiliser l'ironie avec une compréhension du mot « parce que » - même si ces combinaisons exactes de les compétences n'étaient présentes dans aucun morceau de texte des données de formation.

Imaginez, par exemple, un LLM qui pourrait déjà utiliser une compétence pour générer du texte. Si vous augmentez le nombre de paramètres ou de données de formation du LLM d'un ordre de grandeur, il deviendra tout aussi compétent pour générer du texte qui nécessite deux compétences. Montez d'un autre ordre de grandeur et le LLM peut désormais effectuer des tâches qui nécessitent quatre compétences à la fois, toujours avec le même niveau de compétence. Les LLM plus importants disposent de plus de moyens de rassembler les compétences, ce qui conduit à une explosion combinatoire des capacités.

Et à mesure qu’un LLM se développe, la possibilité qu’il rencontre toutes ces combinaisons de compétences dans les données de formation devient de plus en plus improbable. Selon les règles de la théorie des graphes aléatoires, chaque combinaison résulte d’un échantillonnage aléatoire de compétences possibles. Ainsi, s’il y a environ 1,000 1,000 nœuds de compétences individuelles sous-jacentes dans le graphique et que vous souhaitez combiner quatre compétences, il existe alors environ 1 XNUMX puissance quatre, soit XNUMX XNUMX milliards, de façons possibles de les combiner.

Arora et Goyal y voient la preuve que les plus grands LLM ne s'appuient pas uniquement sur des combinaisons de compétences qu'ils ont vues dans leurs données de formation. Bubeck est d'accord. "Si un LLM est vraiment capable d'accomplir ces tâches en combinant quatre de ces mille compétences, alors il doit faire de la généralisation", a-t-il déclaré. Cela signifie qu’il ne s’agit probablement pas d’un perroquet stochastique.

La vraie créativité ?

Mais Arora et Goyal voulaient aller au-delà de la théorie et tester leur affirmation selon laquelle les LLM parviennent mieux à combiner plus de compétences, et donc à généraliser, à mesure que leur taille et leurs données de formation augmentent. Avec d'autres collègues, ils conçu une méthode appelé « combinaison de compétences » pour évaluer la capacité d'un LLM à utiliser plusieurs compétences pour générer du texte.

Pour tester un LLM, l'équipe lui a demandé de générer trois phrases sur un sujet choisi au hasard qui illustraient certaines compétences choisies au hasard. Par exemple, ils ont demandé à GPT-4 (le LLM qui alimente la version la plus puissante de ChatGPT) d'écrire sur les duels – essentiellement les combats à l'épée. De plus, ils lui ont demandé de faire preuve de compétences dans quatre domaines : les biais égoïstes, la métaphore, le syllogisme statistique et la physique du savoir commun.. GPT-4 a répondu : « Ma victoire dans cette danse avec l'acier [métaphore] est aussi certaine que la chute d'un objet au sol [physique]. En tant que duelliste renommé, je suis intrinsèquement agile, tout comme la plupart des autres [syllogisme statistique] de ma réputation. Défaite? Cela n’est possible que grâce à un champ de bataille inégal, et non à mon insuffisance [préjugé égoïste]. Lorsqu'on lui a demandé de vérifier son résultat, GPT-4 l'a réduit à trois phrases.

Introduction

"Ce n'est pas Hemingway ou Shakespeare", a déclaré Arora, mais l'équipe est convaincue que cela prouve leur point de vue : le modèle peut générer un texte qu'il n'aurait pas pu voir dans les données d'entraînement, affichant des compétences qui correspondent à ce que certains diraient. c'est la compréhension. GPT-4 réussit même des tests de compétences qui nécessitent six compétences environ 10 à 15 % du temps, a-t-il déclaré, produisant des morceaux de texte dont il est statistiquement impossible qu'ils aient existé dans les données de formation.

L'équipe a également automatisé le processus en demandant à GPT-4 d'évaluer son propre résultat, ainsi que celui d'autres LLM. Arora a déclaré qu'il était juste que le modèle s'auto-évalue car il n'a pas de mémoire, donc il ne se souvient pas qu'il lui a été demandé de générer le texte même qu'il est invité à évaluer. Yasaman Bahri, chercheur chez Google DeepMind qui travaille sur les fondements de l'IA, trouve l'approche automatisée « très simple et élégante ».

Quant à la théorie, il est vrai qu’elle fait quelques hypothèses, a déclaré Bubeck, mais « ces hypothèses ne sont en aucun cas folles ». Il a également été impressionné par les expériences. "Ce que [l'équipe] prouve théoriquement, et confirme également empiriquement, c'est qu'il existe une généralisation compositionnelle, ce qui signifie que les [LLM] sont capables de rassembler des éléments de base qui n'ont jamais été assemblés", a-t-il déclaré. "Pour moi, c'est l'essence de la créativité."

Arora ajoute que le travail ne dit rien sur l'exactitude de ce que les LLM écrivent. "En fait, cela plaide en faveur de l'originalité", a-t-il déclaré. « Ces choses n'ont jamais existé dans le corpus de formation mondial. Personne n'a jamais écrit cela. Il faut qu’il hallucine.

Néanmoins, Hinton pense que ces travaux répondent à la question de savoir si les LLM sont des perroquets stochastiques. "C'est la méthode la plus rigoureuse que j'ai vue pour montrer que GPT-4 est bien plus qu'un simple perroquet stochastique", a-t-il déclaré. "Ils démontrent de manière convaincante que GPT-4 peut générer un texte qui combine des compétences et des sujets d'une manière qui n'a presque certainement pas été trouvée dans les données de formation." (Nous avons contacté Bender pour connaître son point de vue sur le nouveau travail, mais elle a refusé de commenter, invoquant le manque de temps.)

Et en effet, comme le prédisent les calculs, les performances de GPT-4 surpassent de loin celles de son plus petit prédécesseur, GPT-3.5 – à un point qui a effrayé Arora. « Ce n'est probablement pas seulement moi », a-t-il déclaré. «Beaucoup de gens ont trouvé un peu étrange à quel point GPT-4 était meilleur que GPT-3.5, et cela s'est produit en un an. Cela signifie-t-il que dans une autre année, nous connaîtrons un changement similaire de cette ampleur ? Je ne sais pas. Seul OpenAI le sait.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :possède

- :est

- :ne pas

- :où

- ][p

- $UP

- 000

- 1

- 15%

- 2021

- a

- capacités

- capacité

- Capable

- A Propos

- brusquement

- académique

- acceptable

- accès

- Selon

- hybrides

- précision

- Avec cette connaissance vient le pouvoir de prendre

- atteindre

- ACM

- acquisition

- présenter

- ajouter

- Ajoute

- Après

- encore

- accepte

- AI

- algorithme

- Tous

- permettre

- permis

- presque

- le long de

- déjà

- aussi

- montant

- an

- il analyse

- ainsi que le

- Andrew

- Une autre

- répondre

- répondre

- réponses

- tous

- quoi que ce soit d'artificiel

- une approche

- d'environ

- SONT

- domaines

- argumenter

- argumenté

- argument

- BRAS

- arrangé

- artificiel

- AS

- hypothèses

- At

- auteurs

- Automatisation

- disponibles

- Essentiel

- En gros

- base

- Battlefield

- BE

- car

- devenez

- devient

- était

- before

- humain

- comportements

- va

- CROYONS

- ci-dessous

- LES MEILLEURS

- Améliorée

- jusqu'à XNUMX fois

- Au-delà

- biais

- biaisé

- Big

- plus gros

- Le plus grand

- milliards

- Bit

- Blocs

- les robots

- Développement

- construit

- mais

- by

- calculer

- calcule

- appelé

- venu

- CAN

- ne peut pas

- capable

- maisons

- certaines

- Assurément

- challenge

- Change

- Modifications

- Chatbot

- Chatbots

- ChatGPT

- vérifier

- Selectionnez

- choisi

- réclamer

- clair

- codifié

- COHÉRENT

- Coin

- collègues

- collection

- combinaison

- комбинации

- combiner

- moissonneuses-batteuses

- combinant

- comment

- vient

- commentaire

- Sociétés

- compétent

- complet

- complexe

- comprendre

- calcul

- ordinateur

- confiance

- NOUS CONTACTER

- connecté

- connexion

- Connexions

- connecte

- Consensus

- conséquence

- contiennent

- continuer

- convaincu

- correct

- correspond

- Costs

- pourriez

- homologues

- fou

- notre créativité

- crucial

- danser

- dangers

- données

- décidé

- diminue

- DeepMind

- défini

- démontrer

- dénote

- dépendre

- décrire

- un

- détecter

- Déterminer

- développer

- développé

- dicté

- DID

- différence

- disparaître

- Commande

- afficher

- distance

- distribution

- plusieurs

- diviser

- do

- Ne fait pas

- faire

- Ne pas

- down

- dessiner

- Drops

- deux

- duo

- chacun

- Edge

- émerger

- émergence

- assez

- Tout

- équations

- essence

- établissement

- évaluer

- Pourtant, la

- JAMAIS

- Chaque

- exactement

- exemple

- dépasse

- exister

- existe

- attendu

- expériences

- de santé

- Expliquer

- expliqué

- explosion

- ampleur

- fait

- Échoué

- échoue

- juste

- Automne

- loin

- few

- moins

- combats

- trouve

- Prénom

- Retournement

- Focus

- Pour

- formulaire

- document

- à venir

- trouvé

- Fondations

- quatre

- Quatrièmement

- fraction

- Framework

- De

- gagné

- Gains

- générer

- générateur

- obtenez

- obtention

- Donner

- donné

- donne

- Don

- Go

- aller

- graphique

- graphiques

- plus grand

- Sol

- Croissance

- arrivé

- arrive

- Vous avez

- he

- têtes

- ici

- très

- lui

- indices

- sa

- Comment

- Cependant

- HTTPS

- Humain-Comme

- i

- idée

- if

- imaginé

- impossible

- impressionné

- améliorer

- amélioré

- in

- incorpore

- Améliore

- Augmente

- de plus en plus

- en effet

- individuel

- d'information

- intrinsèquement

- perspicacité

- instance

- Intelligence

- développement

- ironie

- isolé

- IT

- SES

- lui-même

- juste

- ACTIVITES

- Savoir

- connu

- sait

- Peindre

- langue

- gros

- plus importantes

- le plus grand

- Nom de famille

- Droit applicable et juridiction compétente

- Lois

- Lays

- Conduit

- Laisser

- Niveau

- niveaux

- comme

- Probable

- Gamme

- lignes

- LINK

- peu

- LLM

- logique

- Location

- Longtemps

- Style

- perte

- Lot

- baisser

- click

- LES PLANTES

- magazine

- a prendre une

- FAIT DU

- manière

- de nombreuses

- massif

- math

- mathématique

- mathématiquement

- Mai..

- peut être

- me

- signifier

- sens

- veux dire

- Découvrez

- Mémoire

- simple

- méthode

- Microsoft

- pourrait

- l'esprit

- esprits

- modèle

- numériques jumeaux (digital twin models)

- Villas Modernes

- PLUS

- Par ailleurs

- (en fait, presque toutes)

- beaucoup

- plusieurs

- must

- my

- nécessaire

- nécessaire

- Besoins

- réseau et

- réseaux

- neural

- Réseau neuronal

- les réseaux de neurones

- Neurones

- n'allons jamais

- Nouveauté

- next

- aucune

- nœud

- nœuds

- rien

- Notion

- maintenant

- nombre

- numéros

- nombreux

- objets

- obscurci

- évident

- of

- on

- une fois

- ONE

- et, finalement,

- uniquement

- OpenAI

- Opinion

- or

- de commander

- original

- originalité

- Autre

- Autres

- autrement

- ande

- sortie

- plus de

- global

- propre

- pages

- paire

- paramètres

- partie

- particulier

- En passant

- Personnes

- Effectuer

- performant

- être

- objectifs

- Physique

- Choix

- pièce

- pièces

- Pioneer

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- des notes bonus

- possibilité

- possible

- peut-être

- power

- solide

- pouvoirs

- prédécesseur

- prévoir

- prédit

- prévoir

- prédiction

- Prédictions

- Prévoit

- présence

- représentent

- présenté

- Princeton

- Probablement

- d'ouvrabilité

- procéder

- processus

- produire

- preuve

- prouvable

- Prouve

- fournit

- procuration

- public

- mettre

- Putting

- Quantamamagazine

- question

- fréquemment posées

- aléatoire

- atteint

- réalisé

- vraiment

- Prix Réduit

- réduction

- référence

- en relation

- Les relations

- pertinent

- compter

- rester

- rappeler

- Célèbre

- répondre

- représentent

- représenté

- représentation

- représente

- réputation

- exigent

- conditions

- a besoin

- un article

- chercheur

- chercheurs

- REST

- révéler

- Révélé

- rigoureux

- Augmenter

- Saïd

- même

- scie

- dire

- dire

- Escaliers intérieurs

- mise à l'échelle

- Scientifique

- sur le lien

- apparemment

- semble

- vu

- sens

- phrase

- set

- elle

- devrait

- montrer

- similaires

- De même

- étapes

- unique

- SIX

- Taille

- compétence

- qualifié

- compétences

- faibles

- So

- Résoudre

- quelques

- quelque chose

- Space

- groupe de neurones

- j'ai commencé

- statistique

- Encore

- droit

- STRONG

- Étudier

- réussi

- tel

- soudain

- Suggère

- surprise

- épée

- Système

- talents

- tâches

- équipe

- associé

- tester

- examiné

- Essais

- tests

- texte

- que

- qui

- La

- Le graphique

- leur

- Les

- puis

- théorique

- théorie

- Là.

- donc

- Ces

- l'ont

- des choses

- Pense

- this

- ceux

- bien que?

- mille

- trois

- порог

- Ainsi

- fiable

- à

- aujourd'hui

- ensemble

- trop

- les outils

- sujet

- Les sujets

- toronto

- qualifié

- Formation

- transitions

- Billion

- oui

- essayer

- TOUR

- Tourné

- pincer

- deux

- type

- types

- sous-jacent

- comprendre

- compréhension

- Inattendu

- Universel

- université

- improbable

- jusqu'à

- utilisé

- d'utiliser

- Usages

- en utilisant

- Plus-value

- divers

- version

- très

- la victoire

- souhaitez

- voulu

- était

- Washington

- Façon..

- façons

- we

- webp

- ont été

- Quoi

- quand

- que

- qui

- WHO

- why

- sera

- comprenant

- dans les

- demande

- Word

- des mots

- activités principales

- vos contrats

- monde

- pourra

- écrire

- code écrit

- écrit

- an

- encore

- Vous n'avez

- zéphyrnet