Le succès des applications d’IA générative dans un large éventail de secteurs a attiré l’attention et l’intérêt des entreprises du monde entier qui cherchent à reproduire et surpasser les réalisations de leurs concurrents ou à résoudre de nouveaux cas d’utilisation passionnants. Ces clients se tournent vers des modèles de base, tels que TII Falcon, Stable Diffusion XL ou GPT-3.5 d'OpenAI, comme moteurs qui alimentent l'innovation en matière d'IA générative.

Les modèles de base sont une classe de modèles d'IA génératifs capables de comprendre et de générer du contenu de type humain, grâce aux grandes quantités de données non structurées sur lesquelles ils ont été formés. Ces modèles ont révolutionné diverses tâches de vision par ordinateur (CV) et de traitement du langage naturel (NLP), notamment la génération d'images, la traduction et la réponse aux questions. Ils servent de base à de nombreuses applications d’IA et sont devenus un élément crucial dans le développement de systèmes intelligents avancés.

Cependant, le déploiement de modèles de fondation peut s’accompagner de défis importants, notamment en termes de coûts et de ressources nécessaires. Ces modèles sont connus pour leur taille, allant souvent de centaines de millions à des milliards de paramètres. Leur grande taille nécessite des ressources informatiques étendues, notamment un matériel puissant et une capacité de mémoire importante. En fait, le déploiement de modèles de base nécessite généralement au moins un (souvent plusieurs) GPU pour gérer efficacement la charge de calcul. Par exemple, le modèle TII Falcon-40B Instruct nécessite au moins une instance ml.g5.12xlarge pour être chargée avec succès en mémoire, mais fonctionne mieux avec des instances plus volumineuses. Par conséquent, le retour sur investissement (ROI) du déploiement et de la maintenance de ces modèles peut être trop faible pour prouver la valeur commerciale, en particulier pendant les cycles de développement ou pour les charges de travail pointues. Cela est dû aux coûts de fonctionnement liés aux instances alimentées par GPU pour de longues sessions, potentiellement 24h/7 et XNUMXj/XNUMX.

Plus tôt cette année, nous avons annoncé Socle amazonien, une API sans serveur pour accéder aux modèles de base d'Amazon et de nos partenaires d'IA générative. Bien qu'elle soit actuellement en version Private Preview, son API sans serveur vous permet d'utiliser les modèles de base d'Amazon, Anthropic, Stability AI et AI21, sans avoir à déployer vous-même des points de terminaison. Cependant, les modèles open source de communautés telles que Hugging Face se sont beaucoup développés, et tous n'ont pas été mis à disposition via Amazon Bedrock.

Dans cet article, nous ciblons ces situations et résolvons le problème du risque de coûts élevés en déployant de grands modèles de fondations pour Amazon Sage Maker points de terminaison asynchrones De Amazon SageMaker JumpStart. Cela peut contribuer à réduire les coûts de l'architecture, en permettant au point final de s'exécuter uniquement lorsque les demandes sont dans la file d'attente et pendant une courte durée de vie, tout en réduisant à zéro lorsqu'aucune demande n'est en attente d'être traitée. Cela semble idéal pour de nombreux cas d’utilisation ; cependant, un point final réduit à zéro introduira un temps de démarrage à froid avant de pouvoir servir d'inférences.

Vue d'ensemble de la solution

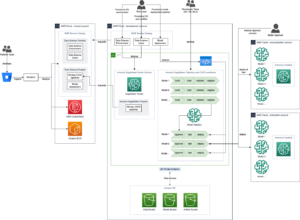

Le diagramme suivant illustre notre architecture de solution.

L'architecture que nous déployons est très simple :

- L'interface utilisateur est un ordinateur portable, qui peut être remplacé par une interface utilisateur Web basée sur Streamlit ou une technologie similaire. Dans notre cas, le carnet est un Amazon SageMakerStudio notebook, exécuté sur une instance ml.m5.large avec le noyau CPU PyTorch 2.0 Python 3.10.

- Le bloc-notes interroge le point de terminaison de trois manières : le SDK SageMaker Python, le SDK AWS pour Python (Boto3) et LangChain.

- Le point de terminaison s'exécute de manière asynchrone sur SageMaker et sur le point de terminaison, nous déployons le modèle Falcon-40B Instruct. Il s'agit actuellement de l'état de l'art en termes de modèles d'instructions et est disponible dans SageMaker JumpStart. Un seul appel API nous permet de déployer le modèle sur le point final.

Qu'est-ce que l'inférence asynchrone SageMaker

L'inférence asynchrone SageMaker est l'une des quatre options de déploiement de SageMaker, avec les points de terminaison en temps réel, l'inférence par lots et l'inférence sans serveur. Pour en savoir plus sur les différentes options de déploiement, reportez-vous à Déployer des modèles pour l'inférence.

L'inférence asynchrone de SageMaker met en file d'attente les requêtes entrantes et les traite de manière asynchrone, ce qui rend cette option idéale pour les requêtes avec des charges utiles importantes allant jusqu'à 1 Go, des temps de traitement longs et des exigences de latence en temps quasi réel. Cependant, le principal avantage qu'il offre lorsqu'il s'agit de modèles de base volumineux, en particulier lors d'une preuve de concept (POC) ou pendant le développement, est la possibilité de configurer l'inférence asynchrone pour évoluer jusqu'à un nombre d'instances de zéro lorsqu'il n'y a aucune demande de processus, économisant ainsi des coûts. Pour plus d'informations sur l'inférence asynchrone SageMaker, reportez-vous à Inférence asynchrone. Le schéma suivant illustre cette architecture.

Pour déployer un point de terminaison d'inférence asynchrone, vous devez créer un AsyncInferenceConfig objet. Si vous créez AsyncInferenceConfig sans préciser ses arguments, la valeur par défaut S3OutputPath sera s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-outputs/{UNIQUE-JOB-NAME} ainsi que S3FailurePath sera s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-failures/{UNIQUE-JOB-NAME}.

Qu'est-ce que SageMaker JumpStart

Notre modèle provient de SageMaker JumpStart, une fonctionnalité de SageMaker qui accélère le parcours d'apprentissage automatique (ML) en proposant des modèles pré-entraînés, des modèles de solution et des exemples de blocs-notes. Il donne accès à une large gamme de modèles pré-entraînés pour différents types de problèmes, vous permettant de démarrer vos tâches de ML avec une base solide. SageMaker JumpStart propose également des modèles de solution pour les cas d'utilisation courants et des exemples de blocs-notes pour l'apprentissage. Avec SageMaker JumpStart, vous pouvez réduire le temps et les efforts nécessaires au démarrage de vos projets de ML grâce à des lancements de solutions en un clic et à des ressources complètes pour une expérience pratique du ML.

La capture d'écran suivante montre un exemple de quelques-uns des modèles disponibles sur l'interface utilisateur de SageMaker JumpStart.

Déployer le modèle

Notre première étape consiste à déployer le modèle sur SageMaker. Pour ce faire, nous pouvons utiliser l'interface utilisateur de SageMaker JumpStart ou le SDK SageMaker Python, qui fournit une API que nous pouvons utiliser pour déployer le modèle sur le point de terminaison asynchrone :

Cet appel peut prendre environ 10 minutes. Pendant ce temps, le point de terminaison est lancé, le conteneur ainsi que les artefacts de modèle sont téléchargés sur le point de terminaison, la configuration du modèle est chargée à partir de SageMaker JumpStart, puis le point de terminaison asynchrone est exposé via un point de terminaison DNS. Pour nous assurer que notre point de terminaison peut être réduit à zéro, nous devons configurer la mise à l'échelle automatique sur le point de terminaison asynchrone à l'aide d'Application Auto Scaling. Vous devez d'abord enregistrer votre variante de point de terminaison auprès d'Application Auto Scaling, définir une stratégie de mise à l'échelle, puis appliquer la stratégie de mise à l'échelle. Dans cette configuration, nous utilisons une métrique personnalisée utilisant CustomizedMetricSpecification, appelée ApproximateBacklogSizePerInstance, comme indiqué dans le code suivant. Pour une liste détaillée de Amazon Cloud Watch métriques disponibles avec votre point de terminaison d'inférence asynchrone, reportez-vous à Surveillance avec CloudWatch.

Vous pouvez vérifier que cette stratégie a été définie avec succès en accédant à la console SageMaker et en choisissant Endpoints sous Inférence dans le volet de navigation et recherchez le point de terminaison que nous venons de déployer.

Appeler le point de terminaison asynchrone

Pour appeler le point de terminaison, vous devez placer la charge utile de la requête dans Service de stockage simple Amazon (Amazon S3) et fournissez un pointeur vers cette charge utile dans le cadre du InvokeEndpointAsync demande. Lors de l'appel, SageMaker met la demande en file d'attente pour traitement et renvoie un identifiant et un emplacement de sortie en réponse. Lors du traitement, SageMaker place le résultat dans l'emplacement Amazon S3. Vous pouvez éventuellement choisir de recevoir des notifications de réussite ou d'erreur avec Service de notification simple d'Amazon (Amazon SNS).

Kit de développement logiciel (SDK) SageMaker Python

Une fois le déploiement terminé, il renverra un AsyncPredictor objet. Pour effectuer une inférence asynchrone, vous devez télécharger des données sur Amazon S3 et utiliser l'outil predict_async() méthode avec l’URI S3 comme entrée. Il renverra un AsyncInferenceResponse objet, et vous pouvez vérifier le résultat en utilisant le get_response() méthode.

Alternativement, si vous souhaitez vérifier périodiquement un résultat et le renvoyer lors de la génération, utilisez le predict() méthode. Nous utilisons cette deuxième méthode dans le code suivant :

Boto3

Explorons maintenant le invoke_endpoint_async méthode de Boto3 sagemaker-runtime client. Il permet aux développeurs d'appeler de manière asynchrone un point de terminaison SageMaker, fournissant ainsi un jeton pour le suivi de la progression et la récupération ultérieure de la réponse. Boto3 n'offre pas de moyen d'attendre que l'inférence asynchrone soit terminée comme le SDK SageMaker Python get_result() opération. Par conséquent, nous profitons du fait que Boto3 stockera la sortie d'inférence dans Amazon S3 dans le response["OutputLocation"]. Nous pouvons utiliser la fonction suivante pour attendre que le fichier d'inférence soit écrit sur Amazon S3 :

Avec cette fonction, nous pouvons désormais interroger le point final :

LangChaîne

LangChain est un framework open source lancé en octobre 2022 par Harrison Chase. Il simplifie le développement d'applications utilisant de grands modèles de langage (LLM) en fournissant des intégrations avec divers systèmes et sources de données. LangChain permet l'analyse de documents, la synthèse, la création de chatbot, l'analyse de code, etc. Il a gagné en popularité, grâce aux contributions de centaines de développeurs et à un financement important de sociétés de capital-risque. LangChain permet la connexion des LLM avec des sources externes, permettant de créer des applications dynamiques et sensibles aux données. Il propose des bibliothèques, des API et de la documentation pour rationaliser le processus de développement.

LangChain fournit des bibliothèques et des exemples pour utiliser les points de terminaison SageMaker avec son framework, facilitant ainsi l'utilisation des modèles ML hébergés sur SageMaker en tant que « cerveau » de la chaîne. Pour en savoir plus sur la façon dont LangChain s'intègre à SageMaker, reportez-vous au Point de terminaison SageMaker dans la documentation LangChain.

L’une des limites de l’implémentation actuelle de LangChain est qu’elle ne prend pas en charge de manière native les points de terminaison asynchrones. Pour utiliser un point de terminaison asynchrone pour LangChain, nous devons définir une nouvelle classe, SagemakerAsyncEndpoint, qui prolonge la SagemakerEndpoint classe déjà disponible dans LangChain. De plus, nous fournissons les informations suivantes :

- Le compartiment S3 et le préfixe où l'inférence asynchrone stockera les entrées (et les sorties)

- Un nombre maximum de secondes à attendre avant l'expiration du délai

- An

updated _call()fonction pour interroger le point de terminaison avecinvoke_endpoint_async()au lieu deinvoke_endpoint() - Un moyen de réveiller le point de terminaison asynchrone s'il est en démarrage à froid (réduit à zéro)

Pour examiner le nouveau créé SagemakerAsyncEndpoint, Vous pouvez consulter la sagemaker_async_endpoint.py filet disponible sur GitHub.

Nettoyer

Lorsque vous avez terminé de tester la génération d'inférences à partir du point de terminaison, n'oubliez pas de supprimer le point de terminaison pour éviter d'encourir des frais supplémentaires :

Conclusion

Lors du déploiement de grands modèles de base comme TII Falcon, l'optimisation des coûts est cruciale. Ces modèles nécessitent un matériel puissant et une capacité de mémoire importante, ce qui entraîne des coûts d'infrastructure élevés. L'inférence asynchrone SageMaker, une option de déploiement qui traite les demandes de manière asynchrone, réduit les dépenses en ramenant le nombre d'instances à zéro lorsqu'il n'y a aucune demande en attente. Dans cet article, nous avons montré comment déployer de grands modèles de fondation SageMaker JumpStart sur des points de terminaison asynchrones SageMaker. Nous avons fourni des exemples de code utilisant le SDK SageMaker Python, Boto3 et LangChain pour illustrer différentes méthodes d'appel de points de terminaison asynchrones et de récupération des résultats. Ces techniques permettent aux développeurs et aux chercheurs d'optimiser les coûts tout en utilisant les capacités des modèles de base pour les systèmes avancés de compréhension du langage.

Pour en savoir plus sur l'inférence asynchrone et SageMaker JumpStart, consultez les articles suivants :

A propos de l'auteure

David Gallitelli est un architecte de solutions spécialisé pour l'IA/ML dans la région EMEA. Il est basé à Bruxelles et travaille en étroite collaboration avec des clients dans tout le Benelux. Il est développeur depuis qu'il est très jeune et a commencé à coder à l'âge de 7 ans. Il a commencé à apprendre l'IA/ML à l'université et en est tombé amoureux depuis.

David Gallitelli est un architecte de solutions spécialisé pour l'IA/ML dans la région EMEA. Il est basé à Bruxelles et travaille en étroite collaboration avec des clients dans tout le Benelux. Il est développeur depuis qu'il est très jeune et a commencé à coder à l'âge de 7 ans. Il a commencé à apprendre l'IA/ML à l'université et en est tombé amoureux depuis.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- GraphiquePrime. Élevez votre jeu de trading avec ChartPrime. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/optimize-deployment-cost-of-amazon-sagemaker-jumpstart-foundation-models-with-amazon-sagemaker-asynchronous-endpoints/

- :possède

- :est

- :ne pas

- :où

- $UP

- 1

- 10

- 100

- 12

- 13

- 15%

- 1M

- 2022

- 25

- 7

- a

- Capable

- A Propos

- accélère

- Accepte

- accès

- réalisations

- à travers

- activité

- En outre

- Avancée

- Avantage

- Après

- âge

- AI

- Modèles AI

- AI / ML

- Permettre

- permet

- déjà

- aussi

- Bien que

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- montant

- quantités

- an

- selon une analyse de l’Université de Princeton

- ainsi que

- annoncé

- Une autre

- Anthropique

- tous

- api

- Apis

- Application

- applications

- Appliquer

- architecture

- SONT

- arguments

- Art

- AS

- At

- précaution

- attiré

- auto

- disponibles

- moyen

- éviter

- AWS

- basé

- BE

- devenez

- était

- before

- va

- LES MEILLEURS

- plus gros

- milliards

- Blocs

- corps

- Pause

- Bruxelles

- Développement

- construit

- la performance des entreprises

- mais

- by

- Appelez-nous

- appelé

- CAN

- capacités

- aptitude

- capable

- Compétences

- maisons

- cas

- chaîne

- Chaînes

- globaux

- des charges

- chasse

- Chatbot

- vérifier

- Selectionnez

- choose

- classe

- client

- étroitement

- code

- du froid

- comment

- vient

- Commun

- Communautés

- Sociétés

- concurrents

- complet

- Complété

- finalise

- composant

- complet

- ordinateur

- Vision par ordinateur

- concept

- configuration

- connexion

- Console

- Contenant

- contenu

- contributions

- Prix

- Costs

- engendrent

- créée

- création

- crucial

- Courant

- Lecture

- Customiser

- Clients

- Cut/Taille

- réduire les coûts

- cycles

- données

- traitement

- Réglage par défaut

- Vous permet de définir

- demandes

- démontré

- déployer

- déployé

- déployer

- déploiement

- détaillé

- dev

- Développeur

- mobiles

- Développement

- DICT

- différent

- La diffusion

- dimensions

- handicapé

- dns

- do

- document

- Documentation

- Ne fait pas

- fait

- down

- deux

- pendant

- Dynamic

- e

- plus facilement

- efficacement

- effort

- d'autre

- EMEA

- permettre

- permet

- Endpoint

- Moteurs

- assez

- erreur

- notamment

- Chaque

- exemple

- exemples

- Sauf

- exception

- passionnant

- dépenses

- d'experience

- explorez

- exposé

- S'étend

- les

- externe

- supplémentaire

- Visage

- fait

- Déchu

- non

- Fonctionnalité

- Déposez votre dernière attestation

- entreprises

- Prénom

- Abonnement

- Pour

- Fondation

- quatre

- Framework

- De

- fonction

- financement

- gagné

- généré

- générateur

- génération

- génératif

- IA générative

- GitHub

- Bien

- GPU

- l'

- Croissance

- manipuler

- Matériel

- Vous avez

- ayant

- he

- vous aider

- ici

- Haute

- organisé

- Comment

- How To

- Cependant

- HTML

- http

- HTTPS

- Des centaines

- des centaines de millions

- idéal

- identifiant

- if

- illustre

- image

- la mise en oeuvre

- importer

- in

- Y compris

- Nouveau

- indique

- secteurs

- d'information

- Infrastructure

- Innovation

- contribution

- entrées

- instance

- plutôt ;

- Intègre

- intégrations

- Intelligent

- intérêt

- Interfaces

- développement

- introduire

- un investissement

- IT

- SES

- chemin

- jpg

- json

- juste

- connu

- langue

- gros

- Latence

- plus tard

- lancé

- lance

- conduisant

- APPRENTISSAGE

- apprentissage

- au

- bibliothèques

- comme

- limites

- Liste

- charge

- emplacement

- Location

- recherchez-

- Lot

- love

- Faible

- click

- machine learning

- LES PLANTES

- Entrée

- Maintenir

- a prendre une

- Fabrication

- de nombreuses

- max

- maximales

- Mémoire

- méthode

- méthodes

- métrique

- Métrique

- des millions

- Minutes

- ML

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- prénom

- Nature

- Traitement du langage naturel

- navigation

- Navigation

- Besoin

- Nouveauté

- nouvellement

- next

- nlp

- aucune

- cahier

- déclaration

- Notifications

- maintenant

- nombre

- objet

- octobre

- of

- code

- offrant

- Offres Speciales

- souvent

- on

- ONE

- uniquement

- open source

- opération

- Optimiser

- l'optimisation

- Option

- Options

- or

- nos

- ande

- sortie

- pain

- paramètres

- partie

- particulièrement

- partenaires,

- En attente

- Effectuer

- effectue

- image

- Place

- Des endroits

- Platon

- Intelligence des données Platon

- PlatonDonnées

- PoC

- politique

- popularité

- possible

- Post

- Poteaux

- l'éventualité

- power

- solide

- Méthode

- prédiction

- Predictor

- Aperçu

- Imprimé

- Privé

- Problème

- processus

- les process

- traitement

- Progrès

- projets

- preuve

- preuve de concept

- Prouver

- fournir

- à condition de

- fournit

- aportando

- Python

- pytorch

- requêtes

- question

- augmenter

- gamme

- allant

- Lire

- solutions

- en temps réel

- recevoir

- réduire

- réduit

- région

- vous inscrire

- rappeler

- supprimez

- remplacé

- nécessaire

- demandes

- exigent

- conditions

- Exigences

- a besoin

- chercheurs

- ressource

- Resources

- réponse

- résultat

- Résultats

- retourner

- Retours

- Avis

- révolutionné

- risquer

- ROI

- Courir

- pour le running

- sagemaker

- économie

- évolutive

- Escaliers intérieurs

- mise à l'échelle

- Sdk

- Deuxièmement

- secondes

- AUTO

- besoin

- Sans serveur

- service

- Services

- brainstorming

- set

- Shorts

- montré

- Spectacles

- significative

- similaires

- étapes

- depuis

- unique

- situations

- Taille

- tailles

- solide

- sur mesure

- Solutions

- RÉSOUDRE

- quelques

- Sources

- spécialiste

- pivoté

- Stabilité

- stable

- Commencer

- j'ai commencé

- Commencez

- Région

- étapes

- Arrêter

- storage

- Boutique

- simple

- rationaliser

- Ces

- succès

- Avec succès

- tel

- Support

- Les soutiens

- sûr

- surpasser

- Système

- Prenez

- Target

- tâches

- techniques

- Technologie

- modèles

- conditions

- Essais

- Merci

- qui

- La

- L'État

- leur

- Les

- puis

- Là.

- ainsi

- donc

- Ces

- l'ont

- this

- cette année

- trois

- Avec

- tout au long de

- fiable

- fois

- timing

- à

- ensemble

- jeton

- trop

- Tracking

- qualifié

- Traduction

- oui

- Essai

- types

- ui

- sous

- compréhension

- université

- jusqu'à

- sur

- us

- utilisé

- Utilisateur

- Interface utilisateur

- en utilisant

- d'habitude

- Plus-value

- Variante

- divers

- Vaste

- entreprise

- vérifier

- très

- via

- vision

- attendez

- Attendre

- Réveiller

- Réveiller

- souhaitez

- était

- Façon..

- façons

- we

- web

- services Web

- quand

- que

- qui

- tout en

- WHO

- large

- Large gamme

- sera

- comprenant

- sans

- A gagné

- vos contrats

- partout dans le monde

- pourra

- code écrit

- an

- Vous n'avez

- jeune

- Votre

- vous-même

- zéphyrnet

- zéro