1IRIF, CNRS – Université Paris Cité, France

2QC Ware, Palo Alto, États-Unis et Paris, France

3École d'informatique, Université d'Édimbourg, Écosse, Royaume-Uni

4F. Hoffmann La Roche SA

Vous trouvez cet article intéressant ou souhaitez en discuter? Scite ou laisse un commentaire sur SciRate.

Abstract

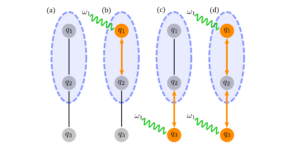

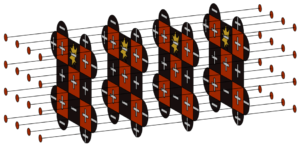

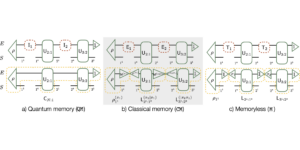

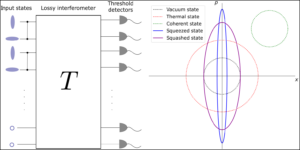

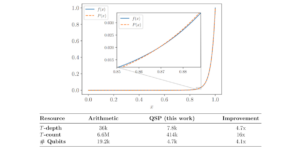

Dans ce travail, les transformateurs quantiques sont conçus et analysés en détail en étendant les architectures de réseaux neuronaux de transformateurs classiques de pointe, connues pour être très performantes dans le traitement du langage naturel et l'analyse d'images. En nous appuyant sur les travaux précédents, qui utilisent des circuits quantiques paramétrés pour le chargement des données et des couches neuronales orthogonales, nous introduisons trois types de transformateurs quantiques pour la formation et l'inférence, dont un transformateur quantique basé sur des matrices composées, qui garantit un avantage théorique du mécanisme d'attention quantique. par rapport à leur homologue classique à la fois en termes de temps d'exécution asymptotique et de nombre de paramètres du modèle. Ces architectures quantiques peuvent être construites à l’aide de circuits quantiques peu profonds et produire des modèles de classification qualitativement différents. Les trois couches d'attention quantique proposées varient sur le spectre entre suivre de près les transformateurs classiques et présenter davantage de caractéristiques quantiques. En tant qu'éléments constitutifs du transformateur quantique, nous proposons une nouvelle méthode de chargement d'une matrice en tant qu'états quantiques ainsi que deux nouvelles couches orthogonales quantiques pouvant être entraînées et adaptables à différents niveaux de connectivité et de qualité des ordinateurs quantiques. Nous avons effectué des simulations approfondies des transformateurs quantiques sur des ensembles de données d'images médicales standard qui ont montré des performances compétitives et parfois meilleures par rapport aux références classiques, y compris les meilleurs transformateurs de vision classiques de leur catégorie. Les transformateurs quantiques que nous avons formés sur ces ensembles de données à petite échelle nécessitent moins de paramètres par rapport aux références classiques standards. Enfin, nous avons implémenté nos transformateurs quantiques sur des ordinateurs quantiques supraconducteurs et obtenu des résultats encourageants pour des expériences allant jusqu'à six qubits.

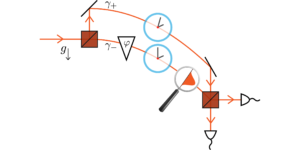

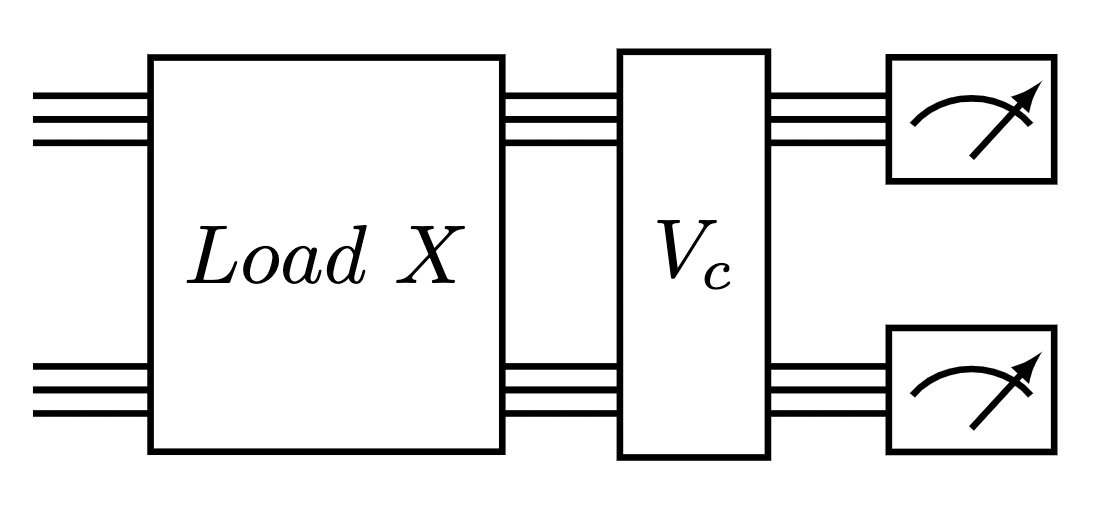

Image en vedette : Circuit quantique pour exécuter une couche d’attention du transformateur composé. Un chargeur de données matricielles suivi d'une couche quantique orthogonale.

Résumé populaire

► Données BibTeX

► Références

Jacob Biamonte, Peter Wittek, Nicola Pancotti, Patrick Rebentrost, Nathan Wiebe et Seth Lloyd. "Apprentissage automatique quantique". Nature 549, 195-202 (2017).

https: / / doi.org/ 10.1038 / nature23474

Iris Cong, Soonwon Choi et Mikhail D Lukin. "Réseaux de neurones convolutifs quantiques". Physique de la nature 15, 1273-1278 (2019).

https://doi.org/10.1038/s41567-019-0648-8

Kishor Bharti, Alba Cervera-Lierta, Thi Ha Kyaw, Tobias Haug, Sumner Alperin-Lea, Abhinav Anand, Matthias Degroote, Hermanni Heimonen, Jakob S Kottmann, Tim Menke, et al. "Algorithmes quantiques d'échelle intermédiaire bruyants". Avis sur la physique moderne 94, 015004 (2022).

https: / / doi.org/ 10.1103 / RevModPhys.94.015004

Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio et al. "Algorithmes quantiques variationnels". Nature Reviews Physique 3, 625-644 (2021).

https://doi.org/10.1038/s42254-021-00348-9

Jonas Landman, Natansh Mathur, Yun Yvonna Li, Martin Strahm, Skander Kazdaghli, Anupam Prakash et Iordanis Kerenidis. "Méthodes quantiques pour les réseaux de neurones et application à la classification des images médicales". Quantique 6, 881 (2022).

https://doi.org/10.22331/q-2022-12-22-881

Bobak Kiani, Randall Balestriero, Yann LeCun et Seth Lloyd. "projunn : Méthode efficace pour former des réseaux profonds avec des matrices unitaires". Avancées dans les systèmes de traitement de l’information neuronale 35, 14448-14463 (2022).

Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser et Illia Polosukhin. "L'attention est tout ce dont vous avez besoin". Avancées dans les systèmes de traitement de l'information neuronale 30 (2017).

Jacob Devlin, Ming-Wei Chang, Kenton Lee et Kristina Toutanova. « Bert : Pré-formation de transformateurs bidirectionnels profonds pour la compréhension du langage » (2018).

Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit et Neil Houlsby. « Une image vaut 16×16 mots : Des transformateurs pour la reconnaissance d'images à grande échelle ». Conférence internationale sur les représentations d'apprentissage (2021). URL : openreview.net/forum?id=YicbFdNTTy.

https:///openreview.net/forum?id=YicbFdNTTy

Yi Tay, Mostafa Dehghani, Dara Bahri et Donald Metzler. « Transformateurs efficaces : une enquête ». Enquêtes informatiques ACM (CSUR) (2020).

https: / / doi.org/ 10.1145 / 3530811

Dzmitry Bahdanau, Kyunghyun Cho et Yoshua Bengio. «Traduction automatique neuronale en apprenant conjointement à aligner et à traduire» (2016). arXiv : 1409.0473 [cs, statistique].

arXiv: 1409.0473

J. Schmidhuber. "Réduire le rapport entre la complexité de l'apprentissage et le nombre de variables variant dans le temps dans les réseaux entièrement récurrents". Dans Stan Gielen et Bert Kappen, rédacteurs, ICANN '93. Pages 460 à 463. Londres (1993). Springer.

https://doi.org/10.1007/978-1-4471-2063-6_110

Jürgen Schmidhuber. "Apprendre à contrôler les mémoires à poids rapide : une alternative aux réseaux récurrents dynamiques". Calcul neuronal 4, 131-139 (1992).

https: / / doi.org/ 10.1162 / neco.1992.4.1.131

Peter Cha, Paul Ginsparg, Felix Wu, Juan Carrasquilla, Peter L McMahon et Eun-Ah Kim. « Tomographie quantique basée sur l'attention ». Apprentissage automatique : science et technologie 3, 01LT01 (2021).

https:///doi.org/10.1088/2632-2153/ac362b

Riccardo Di Sipio, Jia-Hong Huang, Samuel Yen-Chi Chen, Stefano Mangini et Marcel Worring. "L'aube du traitement quantique du langage naturel". Dans le cadre de la Conférence internationale ICASSP 2022-2022 de l'IEEE sur l'acoustique, la parole et le traitement du signal (ICASSP). Pages 8612 à 8616. IEEE (2022).

https:///doi.org/10.1109/ICASSP43922.2022.9747675

Guangxi Li, Xuanqiang Zhao et Xin Wang. « Réseaux neuronaux quantiques d'auto-attention pour la classification de textes » (2022).

Fabio Sanches, Sean Weinberg, Takanori Ide et Kazumitsu Kamiya. « Circuits quantiques courts dans les politiques d'apprentissage par renforcement pour le problème de tournées de véhicules ». Examen physique A 105, 062403 (2022).

https: / / doi.org/ 10.1103 / PhysRevA.105.062403

YuanFu Yang et Min Sun. "Détection des défauts des semi-conducteurs par apprentissage profond hybride classique-quantique". Pages CVPR 2313-2322 (2022).

https:///doi.org/10.1109/CVPR52688.2022.00236

Maxwell Henderson, Samriddhi Shakya, Shashindra Pradhan et Tristan Cook. "Réseaux de neurones quanvolutifs : alimenter la reconnaissance d'images avec des circuits quantiques". Intelligence machine quantique 2, 1-9 (2020).

https: / / doi.org/ 10.1007 / s42484-020-00012-y

Edward Farhi et Hartmut Neven. "Classification avec des réseaux de neurones quantiques sur des processeurs à court terme" (2018). URL : doi.org/10.48550/arXiv.1802.06002.

https:///doi.org/10.48550/arXiv.1802.06002

Kosuke Mitarai, Makoto Negoro, Masahiro Kitagawa et Keisuke Fujii. "Apprentissage des circuits quantiques". Examen physique A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / PhysRevA.98.032309

Kui Jia, Shuai Li, Yuxin Wen, Tongliang Liu et Dacheng Tao. « Réseaux de neurones profonds orthogonaux ». Transactions IEEE sur l'analyse de modèles et l'intelligence artificielle (2019).

https: / / doi.org/ 10.1109 / TPAMI.2019.2948352

Roger A Horn et Charles R Johnson. "Analyse matricielle". La presse de l'Universite de Cambridge. (2012).

https: / / doi.org/ 10.1017 / CBO9780511810817

Iordanis Kerenidis et Anupam Prakash. « Apprentissage automatique quantique avec états subspatiaux » (2022).

Brooks Foxen, Charles Neill, Andrew Dunsworth, Pedram Roushan, Ben Chiaro, Anthony Megrant, Julian Kelly, Zijun Chen, Kevin Satzinger, Rami Barends et al. "Démonstration d'un ensemble continu de portes à deux qubits pour les algorithmes quantiques à court terme". Lettres d'examen physique 125, 120504 (2020).

https: / / doi.org/ 10.1103 / PhysRevLett.125.120504

Sonika Johri, Shantanu Debnath, Avinash Mocherla, Alexandros Singk, Anupam Prakash, Jungsang Kim et Iordanis Kerenidis. "Classification du centroïde le plus proche sur un ordinateur quantique à ions piégés". npj Informations quantiques 7, 122 (2021).

https://doi.org/10.1038/s41534-021-00456-5

James W Cooley et John W Tukey. « Un algorithme pour le calcul automatique de séries de Fourier complexes ». Mathématiques du calcul 19, 297-301 (1965).

https://doi.org/10.1090/S0025-5718-1965-0178586-1

Li Jing, Yichen Shen, Tena Dubcek, John Peurifoy, Scott A. Skirlo, Yann LeCun, Max Tegmark et Marin Soljacic. "Réseaux de neurones unitaires efficaces accordables (eunn) et leur application aux rnns". Lors de la Conférence internationale sur l'apprentissage automatique. (2016). URL : api.semanticscholar.org/CorpusID:5287947.

https:///api.semanticscholar.org/CorpusID:5287947

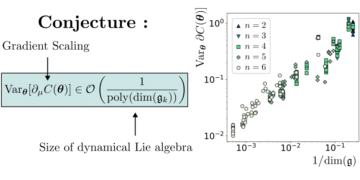

Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla et Elham Kashefi. « Capacité d'entraînement et expressivité des circuits quantiques préservant le poids de Hamming pour l'apprentissage automatique » (2023). arXiv :2309.15547.

arXiv: 2309.15547

Enrico Fontana, Dylan Herman, Shouvanik Chakrabarti, Niraj Kumar, Romina Yalovetzky, Jamie Heredge, Shree Hari Sureshbabu et Marco Pistoia. « L'adjoint est tout ce dont vous avez besoin : caractériser les plateaux stériles dans l'ansätze quantique » (2023). arXiv :2309.07902.

arXiv: 2309.07902

Michael Ragone, Bojko N. Bakalov, Frédéric Sauvage, Alexander F. Kemper, Carlos Ortiz Marrero, Martin Larocca et M. Cerezo. « Une théorie unifiée des plateaux stériles pour les circuits quantiques profondément paramétrés » (2023). arXiv :2309.09342.

arXiv: 2309.09342

Xuchen You et Xiaodi Wu. "De nombreux minima locaux exponentiels dans les réseaux de neurones quantiques". Lors de la Conférence internationale sur l'apprentissage automatique. Pages 12144-12155. PMLR (2021).

Eric R. Anschuetz et Bobak Toussi Kiani. « Les algorithmes variationnels quantiques sont inondés de pièges ». Communications nature 13 (2022).

https://doi.org/10.1038/s41467-022-35364-5

Ilya O. Tolstikhin, Neil Houlsby, Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Thomas Unterthiner, Jessica Yung, Daniel Keysers, Jakob Uszkoreit, Mario Lucic et Alexey Dosovitskiy. « Mlp-mixer : Une architecture tout mlp pour la vision ». Dans NeurIPS. (2021).

Jiancheng Yang, Rui Shi et Bingbing Ni. « Décathlon de classification Medmnist : Un benchmark automl léger pour l'analyse d'images médicales » (2020).

https:///doi.org/10.1109/ISBI48211.2021.9434062

Jiancheng Yang, Rui Shi, Donglai Wei, Zequan Liu, Lin Zhao, Bilian Ke, Hanspeter Pfister et Bingbing Ni. "Medmnist v2 - une référence légère à grande échelle pour la classification d'images biomédicales 2D et 3D". Données scientifiques 10, 41 (2023).

https://doi.org/10.1038/s41597-022-01721-8

Angelos Katharopoulos, Apoorv Vyas, Nikolaos Pappas et François Fleuret. "Les transformateurs sont des rnns : des transformateurs autorégressifs rapides avec une attention linéaire". Lors de la Conférence internationale sur l'apprentissage automatique. Pages 5156 à 5165. PMLR (2020).

James Bradbury, Roy Frostig, Peter Hawkins, Matthew James Johnson, Chris Leary, Dougal Maclaurin, George Necula, Adam Paszke, Jake VanderPlas, Skye Wanderman-Milne et Qiao Zhang. « JAX : transformations composables de programmes Python+NumPy ». GitHub (2018). URL : http:///github.com/google/jax.

http: / / github.com/ google / jax

Diederik P. Kingma et Jimmy Ba. « Adam : Une méthode d'optimisation stochastique ». CoRR abs/1412.6980 (2015).

Hyeonwoo Noh, Tackgeun You, Jonghwan Mun et Bohyung Han. « Régularisation des réseaux de neurones profonds par le bruit : son interprétation et son optimisation ». NeurIPS (2017).

Xue Ying. "Un aperçu du surapprentissage et de ses solutions". Dans Journal of Physics : Série de conférences. Volume 1168, page 022022. Éditions IOP (2019).

https://doi.org/10.1088/1742-6596/1168/2/022022

Cité par

[1] David Peral García, Juan Cruz-Benito et Francisco José García-Peñalvo, « Revue systématique de la littérature : apprentissage automatique quantique et ses applications », arXiv: 2201.04093, (2022).

[2] El Amine Cherrat, Snehal Raj, Iordanis Kerenidis, Abhishek Shekhar, Ben Wood, Jon Dee, Shouvanik Chakrabarti, Richard Chen, Dylan Herman, Shaohan Hu, Pierre Minssen, Ruslan Shaydulin, Yue Sun, Romina Yalovetzky et Marco Pistoia, « Couverture profonde quantique », Quantique 7, 1191 (2023).

[3] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla et Elham Kashefi, « Entraînement et expressivité des circuits quantiques préservant le poids de Hamming pour l'apprentissage automatique », arXiv: 2309.15547, (2023).

[4] Sohum Thakkar, Skander Kazdaghli, Natansh Mathur, Iordanis Kerenidis, André J. Ferreira-Martins et Samurai Brito, « Amélioration des prévisions financières via l'apprentissage automatique quantique », arXiv: 2306.12965, (2023).

[5] Jason Iaconis et Sonika Johri, « Chargement efficace des images quantiques basé sur un réseau Tensor », arXiv: 2310.05897, (2023).

[6] Nishant Jain, Jonas Landman, Natansh Mathur et Iordanis Kerenidis, « Réseaux de Fourier quantique pour résoudre les PDE paramétriques », arXiv: 2306.15415, (2023).

[7] Daniel Mastropietro, Georgios Korpas, Vyacheslav Kungurtsev et Jakub Marecek, « Fleming-Viot aide à accélérer les algorithmes quantiques variationnels en présence de plateaux stériles », arXiv: 2311.18090, (2023).

[8] Aliza U. Siddiqui, Kaitlin Gili et Chris Ballance, « Stressing Out Modern Quantum Hardware : Performance Evaluation and Execution Insights », arXiv: 2401.13793, (2024).

Les citations ci-dessus proviennent de SAO / NASA ADS (dernière mise à jour réussie 2024-02-22 13:37:43). La liste peut être incomplète car tous les éditeurs ne fournissent pas de données de citation appropriées et complètes.

Impossible de récupérer Données de référence croisée lors de la dernière tentative 2024-02-22 13:37:41: Impossible de récupérer les données citées par 10.22331 / q-2024-02-22-1265 de Crossref. C'est normal si le DOI a été enregistré récemment.

Cet article est publié dans Quantum sous le Creative Commons Attribution 4.0 International (CC BY 4.0) Licence. Le droit d'auteur reste la propriété des détenteurs d'origine tels que les auteurs ou leurs institutions.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://quantum-journal.org/papers/q-2024-02-22-1265/

- :est

- :ne pas

- ][p

- $UP

- 1

- 10

- 11

- 12

- 125

- 13

- 14

- 15%

- 16

- 17

- 19

- 20

- 2012

- 2015

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 2024

- 22

- 23

- 24

- 25

- 26%

- 27

- 28

- 29

- 2D

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 3d

- 40

- 41

- 43

- 7

- 8

- 9

- 98

- a

- au dessus de

- RÉSUMÉ

- accès

- ACM

- Adam

- En outre

- avances

- Avantage

- avantages

- affiliations

- AL

- alex

- Alexandre

- algorithme

- algorithmes

- aligner

- Tous

- alternative

- an

- selon une analyse de l’Université de Princeton

- ainsi que les

- Andrew

- Anthony

- api

- Application

- applications

- architecture

- architectures

- SONT

- AS

- hypothèses

- At

- tentative

- précaution

- auteur

- auteurs

- AutoML

- stérile

- basé

- BE

- bien

- référence

- repères

- Benjamin

- Améliorée

- jusqu'à XNUMX fois

- bidirectionnel

- biomédical

- Blocs

- tous les deux

- Pause

- Développement

- construit

- by

- calcul

- cambridge

- CAN

- capacités

- carlos

- cha

- chang

- caractéristiques

- Charles

- chen

- CHO

- Chris

- classification

- étroitement

- commentaire

- Chambre des communes

- Communications

- par rapport

- compétitif

- complet

- complexe

- complexité

- composable

- Composé

- calcul

- ordinateur

- ordinateurs

- informatique

- Congrès

- Connectivité

- continu

- des bactéries

- droit d'auteur

- pourriez

- Homologue

- homologues

- engendrent

- Daniel

- données

- ensembles de données

- David

- profond

- l'apprentissage en profondeur

- démontrer

- un

- détail

- Détection

- différent

- discuter

- donald

- pendant

- Dynamic

- E & T

- éditeurs

- Edward

- efficacité

- efficace

- el

- encourageant

- de renforcer

- eric

- évaluation

- Pourtant, la

- exécuter

- exécution

- Exposant

- expériences

- explorez

- extension

- les

- RAPIDE

- Février

- moins

- finalement

- la traduction de documents financiers

- mettant l'accent

- suivi

- Abonnement

- Pour

- Francisco

- de

- d’étiquettes électroniques entièrement

- Portes

- George

- GitHub

- Gomez

- garantit

- Matériel

- harvard

- couverture

- vous aider

- aide

- titulaires

- http

- HTTPS

- huang

- Hybride

- IEEE

- if

- ilia

- image

- Classification des images

- Reconnaissance d'image

- satellite

- mis en œuvre

- amélioré

- in

- Y compris

- d'information

- idées.

- les établissements privés

- Intelligence

- intéressant

- International

- l'interprétation

- introduire

- SES

- Jacob

- Jacques

- Jamie

- JavaScript

- pince-monseigneur

- John

- Johnson

- jon

- jones

- Journal

- Jean

- kim

- connu

- kumar

- langue

- grande échelle

- Nom de famille

- couche

- poules pondeuses

- apprentissage

- Laisser

- Lee

- niveaux

- en tirant parti

- Li

- Licence

- léger

- comme

- lin

- linéaire

- Liste

- littérature

- chargeur

- chargement

- locales

- London

- click

- machine learning

- de nombreuses

- Marco

- mario

- Martin

- mathématiques

- Matrice

- matthew

- max

- largeur maximale

- Maxwell

- Mai..

- McClean

- mécanisme

- médical

- Souvenirs

- méthode

- méthodes

- Michael

- mikhail

- m.

- modèle

- numériques jumeaux (digital twin models)

- Villas Modernes

- Mois

- PLUS

- Nature

- Traitement du langage naturel

- Nature

- Près

- Besoin

- Nets

- réseau et

- réseaux

- neural

- Réseau neuronal

- les réseaux de neurones

- Nouveauté

- Bruit

- Ordinaire

- roman

- nombre

- obtenu

- of

- on

- ONE

- ouvert

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- or

- original

- nos

- ande

- plus de

- vue d'ensemble

- page

- pages

- Palo Alto

- Papier

- paramètres

- Paris

- patrick

- Patron de Couture

- paul

- performant

- effectué

- Peter

- Physique

- Physique

- Pierre

- Platon

- Intelligence des données Platon

- PlatonDonnées

- politiques

- polosukhine

- défaillances

- Alimentation

- Prakash

- présence

- représentent

- conservation

- Press

- précédent

- Problème

- traitement

- processeurs

- produire

- Programmes

- prometteur

- proposer

- proposé

- fournir

- publié

- éditeur

- éditeurs

- Édition

- qualité

- Quantum

- algorithmes quantiques

- Ordinateur quantique

- ordinateurs quantiques

- l'informatique quantique

- informations quantiques

- apprentissage automatique quantique

- Qubit

- R

- ramie

- rapport

- récemment

- reconnaissance

- récurrent

- inscrit

- reste

- exigent

- Résultats

- Avis

- Avis

- Richard

- roche

- romain

- routage

- roy

- Courir

- d'exécution

- Ryan

- s

- Escaliers intérieurs

- Sciences

- Science et technologie

- sur une base scientifique

- scott

- Sean

- Série

- set

- peu profond

- montré

- Signal

- Simon

- simulations

- SIX

- Solutions

- Résoudre

- quelques

- Spectre

- discours

- vitesse

- Standard

- state-of-the-art

- États

- Étude

- Avec succès

- tel

- convient

- Dimanche

- supraconducteur

- Sondage

- Système

- tâches

- tay

- Technologie

- terme

- conditions

- texte

- Classification du texte

- qui

- Les

- leur

- théorique

- théorie

- Ces

- l'ont

- this

- thomas

- trois

- Tim

- fiable

- fois

- Titre

- à

- qualifié

- Formation

- Transactions

- transformations

- transformateur

- transformateurs

- traduire

- Traduction

- piégé

- pièges

- deux

- types

- sous

- compréhension

- unifiée

- expérience unique et authentique

- université

- a actualisé

- sur

- URL

- États-Unis

- Usages

- en utilisant

- varier

- variant

- véhicule

- très

- via

- vision

- le volume

- W

- wang

- souhaitez

- était

- we

- WELL

- qui

- comprenant

- du bois.

- des mots

- activités principales

- vaut

- wu

- xiao

- an

- Rendement

- YING

- Vous n'avez

- Yuan

- zéphyrnet

- Zhao