कंप्यूटर विज़न (सीवी) मशीन लर्निंग (एमएल) और डीप लर्निंग के सबसे आम अनुप्रयोगों में से एक है। उपयोग के मामले स्व-चालित कारों, सोशल मीडिया प्लेटफार्मों पर सामग्री मॉडरेशन, कैंसर का पता लगाने और स्वचालित दोष का पता लगाने से लेकर हैं। अमेज़ॅन रेकग्निशन एक पूरी तरह से प्रबंधित सेवा है जो किसी पूर्व एमएल अनुभव की आवश्यकता के बिना डेटा से अंतर्दृष्टि निकालने के लिए ऑब्जेक्ट डिटेक्शन, वीडियो सेगमेंट डिटेक्शन, कंटेंट मॉडरेशन और अधिक जैसे सीवी कार्य कर सकती है। कुछ मामलों में, किसी विशिष्ट समस्या को हल करने के लिए सेवा के साथ-साथ अधिक कस्टम समाधान की भी आवश्यकता हो सकती है।

इस पोस्ट में, हम उन क्षेत्रों को संबोधित करते हैं जहां सीवी को उन मामलों में उपयोग करने के लिए लागू किया जा सकता है जहां वस्तुओं की मुद्रा, उनकी स्थिति और अभिविन्यास महत्वपूर्ण है। ऐसा एक उपयोग मामला ग्राहक-सामना वाले मोबाइल एप्लिकेशन का होगा जहां छवि अपलोड की आवश्यकता होती है। यह अनुपालन कारणों से या लगातार उपयोगकर्ता अनुभव प्रदान करने और जुड़ाव में सुधार करने के लिए हो सकता है। उदाहरण के लिए, ऑनलाइन शॉपिंग प्लेटफ़ॉर्म पर, छवियों में उत्पादों को जिस कोण पर दिखाया जाता है, उसका इस उत्पाद को खरीदने की दर पर प्रभाव पड़ता है। ऐसा ही एक मामला है कार की स्थिति का पता लगाना। हम प्रदर्शित करते हैं कि आप एडब्ल्यूएस क्लाउड पर इस समस्या का समाधान करने के लिए प्रसिद्ध एमएल समाधानों को पोस्टप्रोसेसिंग के साथ कैसे जोड़ सकते हैं।

इस समस्या को हल करने के लिए हम गहन शिक्षण मॉडल का उपयोग करते हैं। पोज़ अनुमान के लिए एमएल एल्गोरिदम को प्रशिक्षित करने के लिए बहुत अधिक विशेषज्ञता और कस्टम प्रशिक्षण डेटा की आवश्यकता होती है। दोनों आवश्यकताओं को प्राप्त करना कठिन और महंगा है। इसलिए, हम दो विकल्प प्रस्तुत करते हैं: एक जिसमें किसी एमएल विशेषज्ञता की आवश्यकता नहीं होती है और अमेज़ॅन रिकॉग्निशन का उपयोग करता है, और दूसरा जो उपयोग करता है अमेज़न SageMaker एक कस्टम एमएल मॉडल को प्रशिक्षित और तैनात करना। पहले विकल्प में हम कार के पहियों का पता लगाने के लिए Amazon Rekognition का उपयोग करते हैं। फिर हम नियम-आधारित प्रणाली का उपयोग करके पहिए की स्थिति से कार की दिशा का अनुमान लगाते हैं। दूसरे विकल्प में, हम इसका उपयोग करके पहियों और कार के अन्य हिस्सों का पता लगाते हैं डिटेक्ट्रोन नमूना। इनका उपयोग फिर से नियम-आधारित कोड के साथ कार की स्थिति का अनुमान लगाने के लिए किया जाता है। दूसरे विकल्प के लिए एमएल अनुभव की आवश्यकता है लेकिन यह अधिक अनुकूलन योग्य भी है। इसका उपयोग छवि पर आगे की पोस्टप्रोसेसिंग के लिए किया जा सकता है, उदाहरण के लिए, पूरी कार को क्रॉप करने के लिए। दोनों विकल्पों को सार्वजनिक रूप से उपलब्ध डेटासेट पर प्रशिक्षित किया जा सकता है। अंत में, हम दिखाते हैं कि आप इस तरह की सेवाओं का उपयोग करके इस कार पोज़ डिटेक्शन समाधान को अपने मौजूदा वेब एप्लिकेशन में कैसे एकीकृत कर सकते हैं अमेज़ॅन एपीआई गेटवे और AWS प्रवर्धित करें.

समाधान अवलोकन

निम्नलिखित चित्र समाधान वास्तुकला को दर्शाता है।

समाधान में एम्प्लीफाई में एक नकली वेब एप्लिकेशन शामिल है जहां उपयोगकर्ता एक छवि अपलोड कर सकता है और कार की स्थिति का पता लगाने के लिए अमेज़ॅन रिकॉग्निशन मॉडल या कस्टम डिटेक्ट्रोन मॉडल को लागू कर सकता है। प्रत्येक विकल्प के लिए, हम एक होस्ट करते हैं AWS लाम्बा एक एपीआई गेटवे के पीछे कार्य करता है जो हमारे नकली एप्लिकेशन के सामने आता है। हमने अपने लैम्ब्डा फ़ंक्शन को सेजमेकर या अमेज़ॅन रिकॉग्निशन में प्रशिक्षित डिटेक्ट्रॉन मॉडल के साथ चलाने के लिए कॉन्फ़िगर किया है।

.. पूर्वापेक्षाएँ

इस पूर्वाभ्यास के लिए, आपके पास निम्नलिखित शर्तें होनी चाहिए:

Amazon Rekognition का उपयोग करके एक सर्वर रहित ऐप बनाएं

हमारा पहला विकल्प दर्शाता है कि आप अमेज़ॅन रिकॉग्निशन का उपयोग करके छवियों में कार के झुकाव का पता कैसे लगा सकते हैं। विचार यह है कि कार और उसके पहियों के स्थान का पता लगाने के लिए अमेज़ॅन रिकॉग्निशन का उपयोग किया जाए और फिर इस जानकारी से कार का ओरिएंटेशन प्राप्त करने के लिए पोस्टप्रोसेसिंग की जाए। संपूर्ण समाधान लैम्ब्डा का उपयोग करके तैनात किया गया है जैसा कि इसमें दिखाया गया है गिथब भंडार. इस फ़ोल्डर में दो मुख्य फ़ाइलें हैं: एक Dockerfile जो Docker छवि को परिभाषित करती है जो हमारे Lambda फ़ंक्शन में चलेगी, और app.py फ़ाइल, जो लैम्ब्डा फ़ंक्शन का मुख्य प्रवेश बिंदु होगी:

लैम्ब्डा फ़ंक्शन एक ऐसी घटना की अपेक्षा करता है जिसमें एक हेडर और बॉडी शामिल हो, जहां बॉडी को बेस 64 डिकोडेड ऑब्जेक्ट के रूप में लेबल करने के लिए आवश्यक छवि होनी चाहिए। छवि को देखते हुए, अमेज़न मान्यता detect_labels लैम्ब्डा फ़ंक्शन का उपयोग करके फ़ंक्शन को लागू किया जाता है बोटो3. फ़ंक्शन छवि में प्रत्येक ऑब्जेक्ट के लिए एक या एक से अधिक लेबल लौटाता है और प्रतिक्रिया के हिस्से के रूप में सभी पहचाने गए ऑब्जेक्ट लेबल के लिए बाउंडिंग बॉक्स विवरण देता है, साथ ही असाइन किए गए लेबल का विश्वास, पहचाने गए लेबल के पूर्वज लेबल जैसी अन्य जानकारी भी देता है। लेबल के लिए उपनाम, और पता लगाया गया लेबल जिन श्रेणियों से संबंधित है। अमेज़ॅन रिकॉग्निशन द्वारा लौटाए गए लेबल के आधार पर, हम फ़ंक्शन चलाते हैं label_image, जो पता लगाए गए पहियों से कार के कोण की गणना निम्नानुसार करता है:

ध्यान दें कि एप्लिकेशन के लिए आवश्यक है कि छवि में केवल एक कार मौजूद हो और यदि ऐसा नहीं है तो एक त्रुटि लौटाता है। हालाँकि, पोस्टप्रोसेसिंग को अधिक बारीक अभिविन्यास विवरण प्रदान करने, कई कारों को कवर करने, या अधिक जटिल वस्तुओं के अभिविन्यास की गणना करने के लिए अनुकूलित किया जा सकता है।

व्हील डिटेक्शन में सुधार करें

व्हील डिटेक्शन की सटीकता को और बेहतर बनाने के लिए, आप इसका उपयोग कर सकते हैं अमेज़ॅन रेकग्निशन कस्टम लेबल. कस्टम एमएल मॉडल को प्रशिक्षित करने और तैनात करने के लिए सेजमेकर का उपयोग करके फाइन-ट्यूनिंग के समान, आप अपना स्वयं का लेबल वाला डेटा ला सकते हैं ताकि अमेज़ॅन रिकॉग्निशन कुछ ही घंटों में आपके लिए एक कस्टम छवि विश्लेषण मॉडल तैयार कर सके। रिकॉग्निशन कस्टम लेबल के साथ, आपको केवल प्रशिक्षण छवियों के एक छोटे सेट की आवश्यकता होती है जो आपके उपयोग के मामले के लिए विशिष्ट हैं, इस मामले में विशिष्ट कोणों वाली कार छवियां, क्योंकि यह अमेज़ॅन रिकॉग्निशन में मौजूदा क्षमताओं का उपयोग करती है, जिसे लाखों छवियों पर प्रशिक्षित किया जाता है। कई श्रेणियां. रिकॉग्निशन कस्टम लेबल को केवल कुछ क्लिक और लैम्ब्डा फ़ंक्शन के छोटे अनुकूलन के साथ एकीकृत किया जा सकता है जिसका उपयोग हम मानक अमेज़ॅन रिकॉग्निशन समाधान के लिए करते हैं।

सेजमेकर प्रशिक्षण कार्य का उपयोग करके एक मॉडल को प्रशिक्षित करें

हमारे दूसरे विकल्प में, हम सेजमेकर पर एक कस्टम डीप लर्निंग मॉडल को प्रशिक्षित करते हैं। हम उपयोग करते हैं डिटेक्ट्रोन2 ढांचा कार के हिस्सों के विभाजन के लिए. फिर इन खंडों का उपयोग कार की स्थिति का अनुमान लगाने के लिए किया जाता है।

डिटेक्ट्रोन2 फ्रेमवर्क एक लाइब्रेरी है जो अत्याधुनिक डिटेक्शन और सेगमेंटेशन एल्गोरिदम प्रदान करती है। डिटेक्ट्रॉन विभिन्न प्रकार के मास्क आर-सीएनएन मॉडल प्रदान करता है जिन्हें प्रसिद्ध COCO (संदर्भ में सामान्य वस्तुएं) डेटासेट पर प्रशिक्षित किया गया था। अपनी कार ऑब्जेक्ट डिटेक्शन मॉडल बनाने के लिए, हम पूर्व-प्रशिक्षित मास्क आर-सीएनएन मॉडल को ठीक करने के लिए ट्रांसफर लर्निंग का उपयोग करते हैं कार भागों का विभाजन डेटासेट यह डेटासेट हमें एक ऐसे मॉडल को प्रशिक्षित करने की अनुमति देता है जो पहियों के साथ-साथ कार के अन्य हिस्सों का भी पता लगा सकता है। इस अतिरिक्त जानकारी का उपयोग छवि के सापेक्ष कार कोण गणना में किया जा सकता है।

डेटासेट में ऑब्जेक्ट डिटेक्शन और सिमेंटिक सेगमेंटेशन कार्यों के लिए उपयोग किए जाने वाले कार भागों का एनोटेटेड डेटा शामिल है: सेडान, पिकअप और स्पोर्ट्स यूटिलिटी वाहनों (एसयूवी) की लगभग 500 छवियां, कई दृश्यों (सामने, पीछे और साइड व्यू) में ली गई हैं। प्रत्येक छवि को 18 उदाहरण मास्क और बाउंडिंग बॉक्स द्वारा एनोटेट किया गया है जो कार के विभिन्न हिस्सों जैसे पहियों, दर्पण, रोशनी और सामने और पीछे के ग्लास का प्रतिनिधित्व करते हैं। हमने पहियों के आधार एनोटेशन को इस तरह से संशोधित किया कि छवि में सभी उपलब्ध पहियों को एक वस्तु के रूप में मानने के बजाय प्रत्येक पहिया को एक व्यक्तिगत वस्तु माना जाए।

हम का उपयोग करें अमेज़न सरल भंडारण सेवा (अमेज़ॅन S3) प्रशिक्षित मॉडल कलाकृतियों के साथ डिटेक्टर मॉडल के प्रशिक्षण के लिए उपयोग किए जाने वाले डेटासेट को संग्रहीत करने के लिए। इसके अलावा, लैम्ब्डा फ़ंक्शन में चलने वाले डॉकर कंटेनर को संग्रहीत किया जाता है अमेज़ॅन इलास्टिक कंटेनर रजिस्ट्री (अमेज़ॅन ईसीआर)। कोड चलाने के लिए आवश्यक लाइब्रेरी और निर्भरता को शामिल करने के लिए लैम्ब्डा फ़ंक्शन में डॉकर कंटेनर की आवश्यकता होती है। हम वैकल्पिक रूप से उपयोग कर सकते हैं लैम्ब्डा परतें, लेकिन यह 250 एमबी के अनज़िप्ड परिनियोजन पैकेज्ड आकार कोटा तक सीमित है और लैम्ब्डा फ़ंक्शन में अधिकतम पांच परतें जोड़ी जा सकती हैं।

हमारा समाधान सेजमेकर पर बनाया गया है: हम पूर्वनिर्मित का विस्तार करते हैं सेजमेकर डॉकर कंटेनर PyTorch के लिए हमारे कस्टम PyTorch को चलाने के लिए प्रशिक्षण कोड. इसके बाद, हम प्रशिक्षण छवि को सेजमेकर पायटोरच अनुमानक में लपेटने के लिए सेजमेकर पायथन एसडीके का उपयोग करते हैं, जैसा कि निम्नलिखित कोड स्निपेट में दिखाया गया है:

अंत में, हम कॉल करके प्रशिक्षण कार्य शुरू करते हैं fit() निर्मित PyTorch अनुमानक पर कार्य करें। जब प्रशिक्षण समाप्त हो जाता है, तो प्रशिक्षित मॉडल आर्टिफैक्ट को अमेज़ॅन एस 3 में सत्र बकेट में संग्रहीत किया जाता है, जिसका उपयोग अनुमान पाइपलाइन के लिए किया जाता है।

सेजमेकर और अनुमान पाइपलाइनों का उपयोग करके मॉडल को तैनात करें

हम अपने कस्टम डिटेक्ट्रोन मॉडल को चलाने वाले अनुमान समापन बिंदु को होस्ट करने के लिए सेजमेकर का भी उपयोग करते हैं। हमारे समाधान को तैनात करने के लिए उपयोग की जाने वाली संपूर्ण बुनियादी संरचना को AWS CDK का उपयोग करके प्रावधानित किया गया है। हम अपने कस्टम मॉडल को a के माध्यम से होस्ट कर सकते हैं सेजमेकर रीयल-टाइम एंडपॉइंट फोन करके deploy PyTorch अनुमानक पर। यह दूसरी बार है जब हमने PyTorch डिटेक्ट्रोन को शामिल करने के लिए प्रीबिल्ट सेजमेकर PyTorch कंटेनर का विस्तार किया है। हम इसका उपयोग अनुमान स्क्रिप्ट को चलाने और हमारे प्रशिक्षित PyTorch मॉडल को निम्नानुसार होस्ट करने के लिए करते हैं:

ध्यान दें कि हमने परिनियोजन के लिए ml.g4dn.xlarge GPU का उपयोग किया क्योंकि यह उपलब्ध सबसे छोटा GPU है और इस डेमो के लिए पर्याप्त है। हमारे में दो घटकों को कॉन्फ़िगर करने की आवश्यकता है अनुमान लिपि: मॉडल लोडिंग और मॉडल सर्विंग। कार्यक्रम model_fn() इसका उपयोग प्रशिक्षित मॉडल को लोड करने के लिए किया जाता है जो होस्ट किए गए डॉकर कंटेनर का हिस्सा है और इसे अमेज़ॅन एस 3 में भी पाया जा सकता है और एक मॉडल ऑब्जेक्ट वापस कर सकता है जिसका उपयोग मॉडल सर्विंग के लिए निम्नानुसार किया जा सकता है:

समारोह predict_fn() भविष्यवाणी करता है और परिणाम लौटाता है। हमारे प्रशिक्षित मॉडल का उपयोग करने के अलावा, हम छवि में मुख्य कार को निकालने के लिए COCO डेटासेट पर प्रशिक्षित मास्क आर-सीएनएन मॉडल के पूर्व-प्रशिक्षित संस्करण का उपयोग करते हैं। यह उन छवियों से निपटने के लिए एक अतिरिक्त पोस्टप्रोसेसिंग कदम है जहां एक से अधिक कारें मौजूद हैं। निम्नलिखित कोड देखें:

अमेज़ॅन रिकॉग्निशन समाधान के समान, बाउंडिंग बॉक्स की भविष्यवाणी की गई wheel क्लास को डिटेक्शन आउटपुट से फ़िल्टर किया जाता है और आउटपुट के सापेक्ष कार की स्थिति का आकलन करने के लिए पोस्टप्रोसेसिंग मॉड्यूल को आपूर्ति की जाती है।

अंत में, हमने डिटेक्ट्रोन समाधान के लिए पोस्टप्रोसेसिंग में भी सुधार किया। यह समाधान का अनुमान लगाने के लिए विभिन्न कार भागों के खंडों का भी उपयोग करता है। उदाहरण के लिए, जब भी सामने बम्पर का पता चलता है, लेकिन पीछे बम्पर नहीं होता है, तो यह माना जाता है कि हमारे पास कार का सामने का दृश्य है और संबंधित कोण की गणना की जाती है।

अपने समाधान को वेब एप्लिकेशन से कनेक्ट करें

मॉडल एंडपॉइंट्स को एम्प्लीफाई से जोड़ने के चरण इस प्रकार हैं:

- AWS CDK स्टैक द्वारा बनाए गए एप्लिकेशन रिपॉजिटरी को क्लोन करें, जिसे नाम दिया गया है

car-angle-detection-website-repo. सुनिश्चित करें कि आप इसे उसी क्षेत्र में ढूंढ रहे हैं जिसका उपयोग आपने तैनाती के लिए किया था। - प्रत्येक तैनात लैम्ब्डा फ़ंक्शन के लिए एपीआई गेटवे एंडपॉइंट को कॉपी करें

index.htmlपूर्ववर्ती रिपॉजिटरी में फ़ाइल करें (ऐसे प्लेसहोल्डर हैं जहां समापन बिंदु को रखने की आवश्यकता है)। निम्नलिखित कोड इसका एक उदाहरण है कि .html फ़ाइल का यह अनुभाग कैसा दिखता है:

- HTML फ़ाइल को सहेजें और कोड परिवर्तन को दूरस्थ मुख्य शाखा में धकेलें।

यह परिनियोजन में HTML फ़ाइल को अद्यतन करेगा. एप्लिकेशन अब उपयोग के लिए तैयार है।

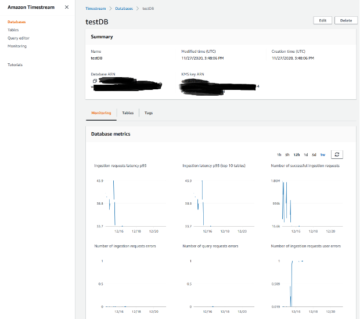

- एम्प्लीफाई कंसोल पर जाएँ और आपके द्वारा बनाए गए प्रोजेक्ट का पता लगाएं।

परिनियोजन पूर्ण होने के बाद एप्लिकेशन URL दिखाई देगा.

- यूआरएल पर नेविगेट करें और यूआई का आनंद लें।

निष्कर्ष

बधाई हो! हमने एक पूर्ण सर्वर रहित आर्किटेक्चर तैनात किया है जिसमें हमने अमेज़ॅन रिकॉग्निशन का उपयोग किया है, लेकिन आपके स्वयं के कस्टम मॉडल के लिए एक विकल्प भी दिया है, यह उदाहरण यहां उपलब्ध है GitHub. यदि आपकी टीम में एमएल विशेषज्ञता नहीं है या किसी मॉडल को प्रशिक्षित करने के लिए पर्याप्त कस्टम डेटा नहीं है, तो आप अमेज़ॅन रिकॉग्निशन का उपयोग करने वाले विकल्प का चयन कर सकते हैं। यदि आप अपने मॉडल पर अधिक नियंत्रण चाहते हैं, इसे और अधिक अनुकूलित करना चाहते हैं, और आपके पास पर्याप्त डेटा है, तो आप सेजमेकर समाधान चुन सकते हैं। यदि आपके पास डेटा वैज्ञानिकों की एक टीम है, तो वे मॉडल को और बेहतर बनाना चाहेंगे और अधिक कस्टम और लचीला विकल्प चुनना चाहेंगे। आप दोनों विकल्पों में से किसी एक का उपयोग करके लैम्ब्डा फ़ंक्शन और एपीआई गेटवे को अपने वेब एप्लिकेशन के पीछे रख सकते हैं। आप इस दृष्टिकोण का उपयोग किसी भिन्न उपयोग के मामले में भी कर सकते हैं जिसके लिए आप कोड को अनुकूलित करना चाहेंगे।

इस सर्वर रहित आर्किटेक्चर का लाभ यह है कि बिल्डिंग ब्लॉक पूरी तरह से विनिमय योग्य हैं। अवसर लगभग असीमित हैं. तो, आज ही शुरुआत करें!

हमेशा की तरह, AWS प्रतिक्रिया का स्वागत करता है। कृपया कोई टिप्पणी या प्रश्न सबमिट करें।

लेखक के बारे में

माइकल वालनर AWS व्यावसायिक सेवाओं के साथ एक वरिष्ठ सलाहकार डेटा और AI है और ग्राहकों को AWS क्लाउड में डेटा-संचालित और AWSome बनने की उनकी यात्रा में सक्षम बनाने के बारे में भावुक है। सबसे बढ़कर, वह ग्राहकों के साथ बड़ा सोचना और उनके लिए नए विचारों का आविष्कार करना पसंद करते हैं।

माइकल वालनर AWS व्यावसायिक सेवाओं के साथ एक वरिष्ठ सलाहकार डेटा और AI है और ग्राहकों को AWS क्लाउड में डेटा-संचालित और AWSome बनने की उनकी यात्रा में सक्षम बनाने के बारे में भावुक है। सबसे बढ़कर, वह ग्राहकों के साथ बड़ा सोचना और उनके लिए नए विचारों का आविष्कार करना पसंद करते हैं।

आमना नजमी AWS प्रोफेशनल सर्विसेज में डेटा साइंटिस्ट हैं। वह ग्राहकों को डेटा से व्यावसायिक मूल्य और अंतर्दृष्टि प्राप्त करने के लिए बिग डेटा और आर्टिफिशियल इंटेलिजेंस प्रौद्योगिकियों के साथ नवाचार करने में मदद करने के लिए उत्साहित है। उनके पास स्वास्थ्य सेवा और जीवन विज्ञान क्षेत्र में डेटा प्लेटफॉर्म और एआई/एमएल परियोजनाओं पर काम करने का अनुभव है। अपने खाली समय में, वह बागवानी करना और नई जगहों की यात्रा करना पसंद करती हैं।

आमना नजमी AWS प्रोफेशनल सर्विसेज में डेटा साइंटिस्ट हैं। वह ग्राहकों को डेटा से व्यावसायिक मूल्य और अंतर्दृष्टि प्राप्त करने के लिए बिग डेटा और आर्टिफिशियल इंटेलिजेंस प्रौद्योगिकियों के साथ नवाचार करने में मदद करने के लिए उत्साहित है। उनके पास स्वास्थ्य सेवा और जीवन विज्ञान क्षेत्र में डेटा प्लेटफॉर्म और एआई/एमएल परियोजनाओं पर काम करने का अनुभव है। अपने खाली समय में, वह बागवानी करना और नई जगहों की यात्रा करना पसंद करती हैं।

डेविड सॉरवीन AWS प्रोफेशनल सर्विसेज में एक वरिष्ठ डेटा वैज्ञानिक हैं, जहां वह ग्राहकों को AWS क्लाउड पर उनकी AI/ML यात्रा में सक्षम बनाते हैं। डेविड डिजिटल जुड़वाँ, पूर्वानुमान और क्वांटम गणना पर ध्यान केंद्रित करता है। उन्होंने ऑस्ट्रिया के इंसब्रुक विश्वविद्यालय से सैद्धांतिक भौतिकी में पीएचडी की है। वह जर्मनी में मैक्स-प्लैंक-इंस्टीट्यूट फॉर क्वांटम ऑप्टिक्स में डॉक्टरेट और पोस्ट-डॉक्टरल शोधकर्ता भी थे। अपने खाली समय में उन्हें पढ़ना, स्की करना और अपने परिवार के साथ समय बिताना पसंद है।

डेविड सॉरवीन AWS प्रोफेशनल सर्विसेज में एक वरिष्ठ डेटा वैज्ञानिक हैं, जहां वह ग्राहकों को AWS क्लाउड पर उनकी AI/ML यात्रा में सक्षम बनाते हैं। डेविड डिजिटल जुड़वाँ, पूर्वानुमान और क्वांटम गणना पर ध्यान केंद्रित करता है। उन्होंने ऑस्ट्रिया के इंसब्रुक विश्वविद्यालय से सैद्धांतिक भौतिकी में पीएचडी की है। वह जर्मनी में मैक्स-प्लैंक-इंस्टीट्यूट फॉर क्वांटम ऑप्टिक्स में डॉक्टरेट और पोस्ट-डॉक्टरल शोधकर्ता भी थे। अपने खाली समय में उन्हें पढ़ना, स्की करना और अपने परिवार के साथ समय बिताना पसंद है।

श्रीकृष्ण चैतन्य कोंडुरु AWS प्रोफेशनल सेवाओं के साथ एक वरिष्ठ डेटा वैज्ञानिक हैं। वह ग्राहकों को AWS पर उनके एमएल एप्लिकेशन को प्रोटोटाइप करने और संचालित करने में सहायता करता है। श्रीकृष्ण कंप्यूटर विज़न और एनएलपी पर ध्यान केंद्रित करते हैं। वह विभिन्न उद्योग क्षेत्रों में ग्राहकों के लिए एमएल प्लेटफ़ॉर्म डिज़ाइन और उपयोग केस पहचान पहल का भी नेतृत्व करते हैं। श्रीकृष्ण ने मेडिकल इमेजिंग पर फोकस के साथ जर्मनी के आरडब्ल्यूटीएच आचेन विश्वविद्यालय से बायोमेडिकल इंजीनियरिंग में एम.एससी की उपाधि प्राप्त की है।

श्रीकृष्ण चैतन्य कोंडुरु AWS प्रोफेशनल सेवाओं के साथ एक वरिष्ठ डेटा वैज्ञानिक हैं। वह ग्राहकों को AWS पर उनके एमएल एप्लिकेशन को प्रोटोटाइप करने और संचालित करने में सहायता करता है। श्रीकृष्ण कंप्यूटर विज़न और एनएलपी पर ध्यान केंद्रित करते हैं। वह विभिन्न उद्योग क्षेत्रों में ग्राहकों के लिए एमएल प्लेटफ़ॉर्म डिज़ाइन और उपयोग केस पहचान पहल का भी नेतृत्व करते हैं। श्रीकृष्ण ने मेडिकल इमेजिंग पर फोकस के साथ जर्मनी के आरडब्ल्यूटीएच आचेन विश्वविद्यालय से बायोमेडिकल इंजीनियरिंग में एम.एससी की उपाधि प्राप्त की है।

अहमद मंसूर AWS प्रोफेशनल सर्विसेज में डेटा साइंटिस्ट हैं। वह AWS क्लाउड पर ग्राहकों की AI/ML यात्रा के माध्यम से उन्हें तकनीकी सहायता प्रदान करता है। अहमद आरएल के साथ प्रोटीन डोमेन में एनएलपी के अनुप्रयोगों पर ध्यान केंद्रित करते हैं। उन्होंने जर्मनी के म्यूनिख के तकनीकी विश्वविद्यालय से इंजीनियरिंग में पीएचडी की है। अपने खाली समय में वह जिम जाना और अपने बच्चों के साथ खेलना पसंद करते हैं।

अहमद मंसूर AWS प्रोफेशनल सर्विसेज में डेटा साइंटिस्ट हैं। वह AWS क्लाउड पर ग्राहकों की AI/ML यात्रा के माध्यम से उन्हें तकनीकी सहायता प्रदान करता है। अहमद आरएल के साथ प्रोटीन डोमेन में एनएलपी के अनुप्रयोगों पर ध्यान केंद्रित करते हैं। उन्होंने जर्मनी के म्यूनिख के तकनीकी विश्वविद्यालय से इंजीनियरिंग में पीएचडी की है। अपने खाली समय में वह जिम जाना और अपने बच्चों के साथ खेलना पसंद करते हैं।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. ऑटोमोटिव/ईवीएस, कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- BlockOffsets. पर्यावरणीय ऑफसेट स्वामित्व का आधुनिकीकरण। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/build-and-train-computer-vision-models-to-detect-car-positions-in-images-using-amazon-sagemaker-and-amazon-rekognition/

- :हैस

- :है

- :नहीं

- :कहाँ

- 1

- 10

- 100

- 11

- 12

- 13

- 15% तक

- 17

- 19

- 22

- 250

- 500

- 7

- 9

- a

- About

- शुद्धता

- के पार

- अनुकूलन

- रूपांतरों

- जोड़ा

- अतिरिक्त

- अतिरिक्त जानकारी

- पता

- लाभ

- बाद

- फिर

- AI

- ऐ / एमएल

- एल्गोरिदम

- सब

- की अनुमति देता है

- साथ में

- भी

- हमेशा

- वीरांगना

- अमेज़ॅन रेकग्निशन

- अमेज़न SageMaker

- अमेज़ॅन वेब सेवा

- an

- विश्लेषण

- और

- अन्य

- कोई

- एपीआई

- अनुप्रयोग

- आवेदन

- अनुप्रयोगों

- एनएलपी . के अनुप्रयोग

- लागू

- दृष्टिकोण

- लगभग

- स्थापत्य

- हैं

- क्षेत्रों के बारे में जानकारी का उपयोग करके ट्रेडिंग कर सकते हैं।

- कृत्रिम

- कृत्रिम बुद्धिमत्ता

- AS

- आकलन

- सौंपा

- ग्रहण

- At

- ऑस्ट्रिया

- स्वचालित

- उपलब्ध

- एडब्ल्यूएस

- AWS व्यावसायिक सेवाएँ

- वापस

- आधार

- आधारित

- BE

- क्योंकि

- बन

- पीछे

- जा रहा है

- अंतर्गत आता है

- के अतिरिक्त

- बड़ा

- बड़ा डेटा

- बायोमेडिकल

- ब्लॉक

- परिवर्तन

- के छात्रों

- मुक्केबाज़ी

- बक्से

- शाखा

- लाना

- निर्माण

- इमारत

- बनाया गया

- व्यापार

- लेकिन

- क्रय

- by

- गणना

- परिकलित

- गणना

- बुला

- कर सकते हैं

- कैंसर

- क्षमताओं

- कार

- कारों

- मामला

- मामलों

- श्रेणियाँ

- केंद्र

- परिवर्तन

- चुनें

- कक्षा

- बादल

- कोको

- कोड

- गठबंधन

- टिप्पणियाँ

- सामान्य

- पूरा

- पूरी तरह से

- जटिल

- अनुपालन

- घटकों

- गणना

- संगणना

- कंप्यूटर

- Computer Vision

- आत्मविश्वास

- कॉन्फ़िगर किया गया

- जुडिये

- माना

- पर विचार

- संगत

- होते हैं

- कंसोल

- सलाहकार

- कंटेनर

- शामिल हैं

- सामग्री

- प्रसंग

- नियंत्रण

- इसी

- महंगा

- सका

- आवरण

- बनाया

- फ़सल

- रिवाज

- ग्राहक

- अनुकूलन

- अनुकूलित

- तिथि

- डेटा प्लेटफार्म

- आँकड़े वाला वैज्ञानिक

- डेटा पर ही आधारित

- डेटासेट

- डेविड

- सौदा

- गहरा

- ध्यान लगा के पढ़ना या सीखना

- परिभाषित करता है

- डेमो

- दिखाना

- दर्शाता

- निर्भरता

- तैनात

- तैनात

- तैनाती

- डिज़ाइन

- विवरण

- पता लगाना

- पता चला

- खोज

- विभिन्न

- डिजिटल

- डिजिटल जुड़वाँ

- कई

- do

- डाक में काम करनेवाला मज़दूर

- नहीं करता है

- डोमेन

- dont

- से प्रत्येक

- प्रभाव

- भी

- अन्य

- सक्षम बनाता है

- समर्थकारी

- endpoint

- सगाई

- अभियांत्रिकी

- बढ़ाना

- पर्याप्त

- प्रविष्टि

- त्रुटि

- कार्यक्रम

- उदाहरण

- मौजूदा

- मौजूद

- उम्मीद

- अनुभव

- विशेषज्ञता

- उजागर

- विस्तार

- अतिरिक्त

- उद्धरण

- परिवार

- प्रसिद्ध

- प्रतिक्रिया

- कुछ

- पट्टिका

- फ़ाइलें

- अंत में

- प्रथम

- लचीला

- फोकस

- केंद्रित

- निम्नलिखित

- इस प्रकार है

- के लिए

- पाया

- ढांचा

- मुक्त

- से

- सामने

- पूर्ण

- पूरी तरह से

- मज़ा

- समारोह

- कार्यों

- आगे

- प्रवेश द्वार

- जर्मनी

- मिल

- दी

- कांच

- Go

- GPU

- व्यायामशाला

- कठिन

- है

- he

- स्वास्थ्य सेवा

- मदद

- उसे

- उसके

- मेजबान

- मेजबानी

- घंटे

- कैसे

- तथापि

- एचटीएमएल

- HTTPS

- विचार

- विचारों

- पहचान

- if

- दिखाता है

- की छवि

- छवियों

- इमेजिंग

- महत्वपूर्ण

- में सुधार

- उन्नत

- in

- शामिल

- व्यक्ति

- उद्योग

- करें-

- इंफ्रास्ट्रक्चर

- पहल

- कुछ नया

- निवेश

- अंतर्दृष्टि

- उदाहरण

- बजाय

- एकीकृत

- एकीकृत

- बुद्धि

- में

- लागू

- IT

- आईटी इस

- काम

- यात्रा

- जेपीजी

- JSON

- केवल

- कुंजी

- बच्चे

- लेबल

- लेबल

- परतों

- बिक्रीसूत्र

- सीख रहा हूँ

- पुस्तकालयों

- पुस्तकालय

- जीवन

- जीवन विज्ञान

- पसंद

- को यह पसंद है

- सीमित

- असीम

- भार

- लोड हो रहा है

- स्थान

- देख

- लग रहा है

- लॉट

- प्यार करता है

- मशीन

- यंत्र अधिगम

- मुख्य

- बनाना

- कामयाब

- बहुत

- मानचित्रण

- मुखौटा

- मास्क

- गणित

- अधिकतम

- मीडिया

- मेडिकल

- हो सकता है

- लाखों

- ML

- मोबाइल

- मोबाइल एप्लीकेशन

- आदर्श

- मॉडल

- संयम

- संशोधित

- मॉड्यूल

- अधिक

- और भी

- अधिकांश

- विभिन्न

- नामांकित

- आवश्यकता

- जरूरत

- की जरूरत है

- नया

- अगला

- NLP

- नहीं

- अभी

- वस्तु

- ऑब्जेक्ट डिटेक्शन

- वस्तुओं

- प्राप्त

- of

- on

- ONE

- ऑनलाइन

- ऑनलाइन खरीदारी

- केवल

- अवसर

- प्रकाशिकी

- विकल्प

- ऑप्शंस

- or

- अन्य

- हमारी

- आउट

- उत्पादन

- के ऊपर

- अपना

- पैक

- जोड़ा

- भाग

- भागों

- आवेशपूर्ण

- निष्पादन

- प्रदर्शन

- भौतिक विज्ञान

- चुनना

- पाइपलाइन

- गंतव्य

- मंच

- प्लेटफार्म

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- प्ले

- कृप्या अ

- बिन्दु

- ढोंग

- अनुमान लगाएं

- स्थिति

- पदों

- संभव

- पद

- भविष्यवाणी करना

- भविष्यवाणी

- भविष्यवाणी

- Predictor

- आवश्यक शर्तें

- वर्तमान

- पूर्व

- मुसीबत

- उत्पादन

- एस्ट्रो मॉल

- उत्पाद

- पेशेवर

- परियोजना

- परियोजनाओं

- प्रोटीन

- प्रोटोटाइप

- प्रदान करना

- प्रदान करता है

- सार्वजनिक रूप से

- धक्का

- रखना

- अजगर

- pytorch

- मात्रा

- क्वांटम ऑप्टिक्स

- प्रशन

- रेंज

- मूल्यांकन करें

- पढ़ना

- तैयार

- वास्तविक समय

- कारण

- क्षेत्र

- सापेक्ष

- दूरस्थ

- कोष

- का प्रतिनिधित्व

- की आवश्यकता होती है

- अपेक्षित

- आवश्यकताएँ

- की आवश्यकता होती है

- शोधकर्ता

- प्रतिक्रिया

- परिणाम

- वापसी

- रिटर्न

- रन

- दौड़ना

- चलाता है

- sagemaker

- SC

- विज्ञान

- वैज्ञानिक

- वैज्ञानिकों

- एसडीके

- दूसरा

- अनुभाग

- देखना

- खंड

- विभाजन

- खंड

- स्वयं ड्राइविंग

- वरिष्ठ

- serverless

- सेवा

- सेवाएँ

- सेवारत

- सत्र

- सेट

- कई

- वह

- खरीदारी

- चाहिए

- दिखाना

- दिखाया

- पक्ष

- समान

- सरल

- आकार

- छोटा

- So

- सोशल मीडिया

- सोशल मीडिया

- सामाजिक मीडिया प्लेटफॉर्म

- समाधान

- समाधान ढूंढे

- हल

- कुछ

- विशिष्ट

- बिताना

- खेल-कूद

- धुआँरा

- मानक

- प्रारंभ

- शुरू

- राज्य के-the-कला

- कदम

- कदम

- भंडारण

- की दुकान

- संग्रहित

- प्रस्तुत

- ऐसा

- पर्याप्त

- आपूर्ति

- समर्थन

- समर्थन करता है

- निश्चित

- प्रणाली

- लिया

- नल

- कार्य

- TD

- टीम

- तकनीकी

- टेक्नोलॉजीज

- है

- से

- कि

- RSI

- लेकिन हाल ही

- उन

- फिर

- सैद्धांतिक

- वहाँ।

- इसलिये

- इन

- वे

- विचारधारा

- इसका

- यहाँ

- पहर

- सेवा मेरे

- ऊपर का

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- स्थानांतरण

- यात्रा का

- जुडवा

- दो

- ui

- विश्वविद्यालय

- अपडेट

- यूआरएल

- us

- उपयोग

- उदाहरण

- प्रयुक्त

- उपयोगकर्ता

- उपयोगकर्ता अनुभव

- का उपयोग करता है

- का उपयोग

- उपयोगिता

- सत्यापन

- मूल्य

- विविधता

- वाहन

- संस्करण

- ऊर्ध्वाधर

- कार्यक्षेत्र

- बहुत

- वीडियो

- देखें

- विचारों

- दिखाई

- दृष्टि

- walkthrough

- करना चाहते हैं

- था

- we

- वेब

- वेब एप्लीकेशन

- वेब सेवाओं

- का स्वागत करते हैं

- प्रसिद्ध

- थे

- क्या

- पहिया

- कब

- जब कभी

- कौन कौन से

- पूरा का पूरा

- मर्जी

- साथ में

- बिना

- काम कर रहे

- होगा

- लपेटो

- आप

- आपका

- जेफिरनेट