अमेज़न SageMaker एक प्रबंधित सेवा है जो मशीन लर्निंग (एमएल) मॉडल बनाना, प्रशिक्षित करना और तैनात करना आसान बनाती है। डेटा वैज्ञानिक एमएल मॉडल को आसानी से प्रशिक्षित करने के लिए सेजमेकर प्रशिक्षण नौकरियों का उपयोग करते हैं; आपको गणना संसाधनों के प्रबंधन के बारे में चिंता करने की ज़रूरत नहीं है, और आप केवल वास्तविक प्रशिक्षण समय के लिए भुगतान करते हैं। डेटा अंतर्ग्रहण किसी भी प्रशिक्षण पाइपलाइन का एक अभिन्न अंग है, और सेजमेकर प्रशिक्षण नौकरियां प्रशिक्षण कार्यभार की एक विस्तृत श्रृंखला के अनुरूप विभिन्न प्रकार के डेटा भंडारण और इनपुट मोड का समर्थन करती हैं।

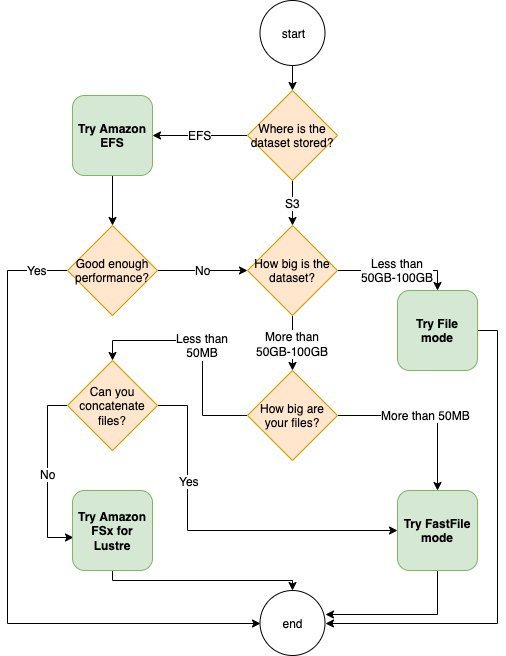

यह पोस्ट आपके सेजमेकर एमएल प्रशिक्षण उपयोग मामले के लिए सर्वोत्तम डेटा स्रोत चुनने में आपकी मदद करती है। हम डेटा स्रोत विकल्प पेश करते हैं जिनका सेजमेकर प्रशिक्षण नौकरियां मूल रूप से समर्थन करती हैं। प्रत्येक डेटा स्रोत और इनपुट मोड के लिए, हम इसके उपयोग में आसानी, प्रदर्शन विशेषताओं, लागत और सीमाओं की रूपरेखा तैयार करते हैं। आपको शीघ्रता से आरंभ करने में मदद करने के लिए, हम एक नमूना निर्णय प्रवाह के साथ आरेख प्रदान करते हैं जिसका आप अपने प्रमुख कार्यभार विशेषताओं के आधार पर अनुसरण कर सकते हैं। अंत में, हम समग्र प्रशिक्षण लागत और प्रदर्शन पर व्यावहारिक प्रभाव प्रदर्शित करने के लिए यथार्थवादी प्रशिक्षण परिदृश्यों के लिए कई बेंचमार्क निष्पादित करते हैं।

नेटिव सेजमेकर डेटा स्रोत और इनपुट मोड

प्रशिक्षण डेटा को आसानी से और लचीले ढंग से निष्पादन योग्य तरीके से पढ़ना एमएल प्रशिक्षण के लिए एक आम आवर्ती चिंता है। सेजमेकर डेटा स्रोतों और उनके संबंधित इनपुट मोड नामक कुशल, उच्च-थ्रूपुट डेटा अंतर्ग्रहण तंत्र के चयन के साथ डेटा अंतर्ग्रहण को सरल बनाता है। यह आपको प्रशिक्षण कोड को वास्तविक डेटा स्रोत से अलग करने, फ़ाइल सिस्टम को स्वचालित रूप से माउंट करने, उच्च प्रदर्शन के साथ पढ़ने, डेटा समानता को सक्षम करने के लिए जीपीयू और उदाहरणों के बीच डेटा शार्डिंग को आसानी से चालू करने और प्रत्येक युग की शुरुआत में डेटा को ऑटो शफ़ल करने की अनुमति देता है।

सेजमेकर प्रशिक्षण अंतर्ग्रहण तंत्र मूल रूप से तीन AWS प्रबंधित भंडारण सेवाओं के साथ एकीकृत होता है:

- अमेज़न सरल भंडारण सेवा (अमेज़ॅन एस3) एक ऑब्जेक्ट स्टोरेज सेवा है जो उद्योग की अग्रणी स्केलेबिलिटी, डेटा उपलब्धता, सुरक्षा और प्रदर्शन प्रदान करती है।

- चमक के लिए अमेज़न FSx लोकप्रिय लस्टर फ़ाइल सिस्टम की स्केलेबिलिटी और प्रदर्शन के साथ एक पूरी तरह से प्रबंधित साझा भंडारण है। यह आमतौर पर मौजूदा S3 बकेट से जुड़ा होता है।

- अमेज़ॅन इलास्टिक फ़ाइल सिस्टम (अमेज़ॅन ईएफएस) एक सामान्य प्रयोजन, स्केलेबल और कई मूल्य स्तरों के साथ अत्यधिक उपलब्ध साझा फ़ाइल सिस्टम है। अमेज़ॅन ईएफएस सर्वर रहित है और जैसे ही आप फ़ाइलें जोड़ते और हटाते हैं, स्वचालित रूप से बढ़ता और सिकुड़ता है।

सेजमेकर प्रशिक्षण आपकी प्रशिक्षण स्क्रिप्ट को Amazon S3, Lustre के लिए FSx, या Amazon EFS पर संग्रहीत डेटासेट तक पहुंचने की अनुमति देता है, जैसे कि यह एक स्थानीय फ़ाइल सिस्टम (POSIX-संगत फ़ाइल सिस्टम इंटरफ़ेस के माध्यम से) पर उपलब्ध हो।

डेटा स्रोत के रूप में Amazon S3 के साथ, आप फ़ाइल मोड, फास्टफ़ाइल मोड और पाइप मोड के बीच चयन कर सकते हैं:

- फ़ाइल मोड - सेजमेकर अमेज़ॅन एस3 से एक डेटासेट को एमएल इंस्टेंस स्टोरेज में कॉपी करता है, जो एक संलग्न है अमेज़न इलास्टिक ब्लॉक स्टोर (अमेज़ॅन ईबीएस) वॉल्यूम या एनवीएमई एसएसडी वॉल्यूम, आपकी प्रशिक्षण स्क्रिप्ट शुरू होने से पहले।

- फास्टफ़ाइल मोड - सेजमेकर प्रशिक्षण उदाहरण पर अमेज़ॅन S3 में रहने वाले डेटासेट को POSIX फ़ाइल सिस्टम के रूप में उजागर करता है। जैसे ही आपकी प्रशिक्षण स्क्रिप्ट उन्हें पढ़ती है, डेटासेट फ़ाइलें अमेज़ॅन S3 से मांग पर स्ट्रीम की जाती हैं।

- पाइप मोड - सेजमेकर अमेज़ॅन एस3 में रहने वाले डेटासेट को यूनिक्स पाइप के रूप में एमएल प्रशिक्षण उदाहरण में स्ट्रीम करता है, जो मांग पर अमेज़ॅन एस3 से स्ट्रीम होता है क्योंकि आपकी प्रशिक्षण स्क्रिप्ट पाइप से डेटा पढ़ती है।

डेटा स्रोत के रूप में लस्टर या अमेज़ॅन ईएफएस के लिए एफएसएक्स के साथ, सेजमेकर आपकी प्रशिक्षण स्क्रिप्ट शुरू होने से पहले फ़ाइल सिस्टम को माउंट करता है।

प्रशिक्षण इनपुट चैनल

सेजमेकर प्रशिक्षण कार्य शुरू करते समय, आप अधिकतम 20 प्रबंधित निर्दिष्ट कर सकते हैं प्रशिक्षण इनपुट चैनल. आप प्रशिक्षण कार्य को यह बताने के लिए चैनलों को एक अमूर्त इकाई के रूप में सोच सकते हैं कि फाइल सिस्टम पथ से पढ़ने के लिए एल्गोरिदम कोड को उपलब्ध कराए गए डेटा को कैसे और कहां से प्राप्त किया जाए (उदाहरण के लिए, /opt/ml/input/data/input-channel-name) एमएल उदाहरण पर। चयनित प्रशिक्षण चैनलों को प्रशिक्षण कार्य मेटाडेटा के भाग के रूप में कैप्चर किया जाता है ताकि प्रशिक्षण कार्यों की पुनरुत्पादकता या मॉडल प्रशासन उद्देश्यों जैसे उपयोग के मामलों के लिए पूर्ण मॉडल वंश ट्रैकिंग को सक्षम किया जा सके।

Amazon S3 को अपने डेटा स्रोत के रूप में उपयोग करने के लिए, आप एक को परिभाषित करते हैं प्रशिक्षण इनपुट निम्नलिखित निर्दिष्ट करने के लिए:

- आपका इनपुट मोड (फ़ाइल, फास्टफ़ाइल, या पाइप मोड)

- वितरण और पुथल विन्यास

- An

S3DataTypeअमेज़ॅन S3 में ऑब्जेक्ट निर्दिष्ट करने के तीन तरीकों में से एक के रूप में जो आपका डेटासेट बनाते हैं:S3Prefix(S3 उपसर्ग के अंतर्गत सभी ऑब्जेक्ट)- प्रकट फ़ाइल (S3 वस्तुओं की एक सूची)

- संवर्धित मेनिफेस्ट फ़ाइल (S3 ऑब्जेक्ट और उनके संबंधित लेबल की एक सूची)

वैकल्पिक रूप से, चमक या अमेज़ॅन ईएफएस के लिए एफएसएक्स के लिए, आप परिभाषित करते हैं फ़ाइल सिस्टम इनपुट.

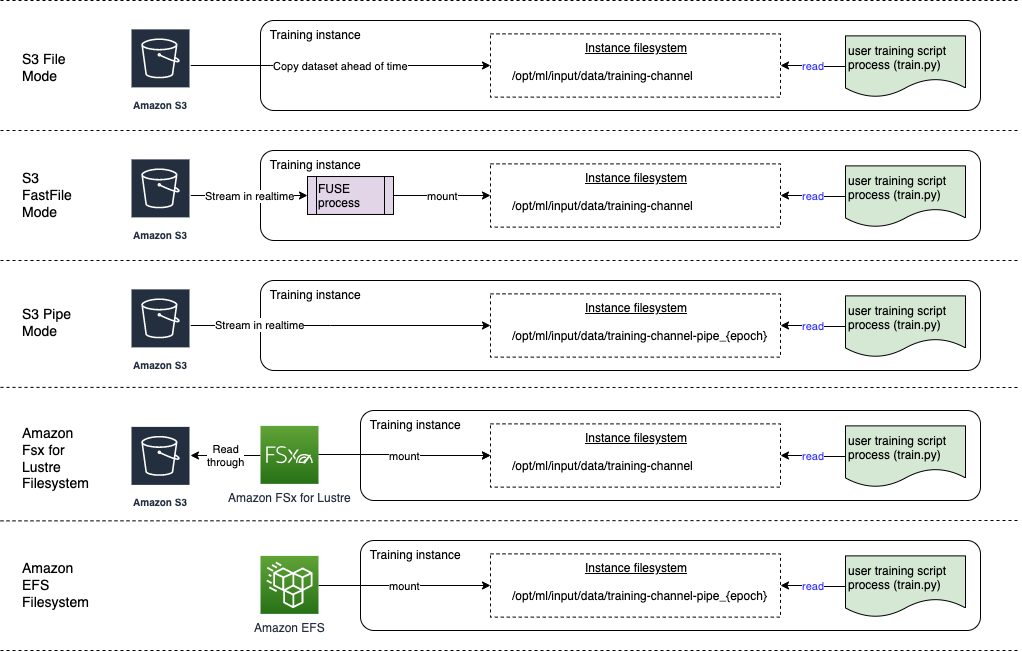

निम्नलिखित आरेख पाँच प्रशिक्षण कार्य दिखाता है, प्रत्येक को एक अलग डेटा स्रोत और इनपुट मोड संयोजन के साथ कॉन्फ़िगर किया गया है:

डेटा स्रोत और इनपुट मोड

निम्नलिखित अनुभाग अमेज़ॅन एस3 (फ़ाइल मोड, फास्टफ़ाइल मोड और पाइप मोड), लस्टर के लिए एफएसएक्स और सेजमेकर अंतर्ग्रहण तंत्र के रूप में अमेज़ॅन ईएफएस के बीच अंतर के बारे में गहराई से जानकारी प्रदान करते हैं।

अमेज़ॅन S3 फ़ाइल मोड

फ़ाइल मोड डिफ़ॉल्ट इनपुट मोड है (यदि आपने इसे स्पष्ट रूप से निर्दिष्ट नहीं किया है), और इसका उपयोग करना अधिक सरल है। जब आप इस इनपुट विकल्प का उपयोग करते हैं, तो सेजमेकर मॉडल प्रशिक्षण लॉन्च करने से पहले आपकी ओर से अमेज़ॅन एस 3 से एमएल प्रशिक्षण इंस्टेंस स्टोरेज (उदाहरण प्रकार के आधार पर अमेज़ॅन ईबीएस या स्थानीय एनवीएमई) में डेटासेट डाउनलोड करता है, ताकि प्रशिक्षण स्क्रिप्ट डेटासेट को पढ़ सके। स्थानीय फ़ाइल सिस्टम. इस मामले में, इंस्टेंस में संपूर्ण डेटासेट को फिट करने के लिए पर्याप्त संग्रहण स्थान होना चाहिए।

आप S3 उपसर्ग, मेनिफेस्ट फ़ाइल, या संवर्धित मेनिफेस्ट फ़ाइल प्रदान करके फ़ाइल मोड के लिए डेटासेट को कॉन्फ़िगर करते हैं।

आपको S3 उपसर्ग का उपयोग तब करना चाहिए जब आपकी सभी डेटासेट फ़ाइलें एक सामान्य S3 उपसर्ग (सबफ़ोल्डर ठीक हैं) के भीतर स्थित हों।

मेनिफेस्ट फ़ाइल आपके डेटासेट वाली फ़ाइलों को सूचीबद्ध करती है। जब कोई डेटा प्रीप्रोसेसिंग कार्य एक मैनिफ़ेस्ट फ़ाइल उत्सर्जित करता है, या जब आपकी डेटासेट फ़ाइलें कई S3 उपसर्गों में फैली हुई होती हैं, तो आप आम तौर पर मैनिफ़ेस्ट का उपयोग करते हैं। एक संवर्धित मेनिफेस्ट एक JSON लाइन फ़ाइल है, जहां प्रत्येक पंक्ति में विशेषताओं की एक सूची होती है, जैसे अमेज़ॅन S3 में एक फ़ाइल का संदर्भ, अतिरिक्त विशेषताओं के साथ, ज्यादातर लेबल। इसके उपयोग के मामले मेनिफेस्ट के समान हैं।

फ़ाइल मोड के साथ संगत है सेजमेकर स्थानीय मोड (सेजमेकर प्रशिक्षण कंटेनर को सेकंडों में अंतःक्रियात्मक रूप से प्रारंभ करना)। वितरित प्रशिक्षण के लिए, आप डेटासेट को कई उदाहरणों में विभाजित कर सकते हैं ShardedByS3Key विकल्प.

फ़ाइल मोड डाउनलोड गति डेटासेट आकार, औसत फ़ाइल आकार और फ़ाइलों की संख्या पर निर्भर करती है। उदाहरण के लिए, डेटासेट जितना बड़ा होगा (या इसमें जितनी अधिक फ़ाइलें होंगी), डाउनलोडिंग चरण उतना ही लंबा होगा, जिसके दौरान इंस्टेंस का कंप्यूट संसाधन प्रभावी रूप से निष्क्रिय रहता है। स्पॉट इंस्टेंस के साथ प्रशिक्षण करते समय, हर बार स्पॉट रुकावट के बाद कार्य फिर से शुरू होने पर डेटासेट डाउनलोड किया जाता है। आमतौर पर, बड़ी फ़ाइलों के लिए डेटा डाउनलोडिंग लगभग 200 एमबी/सेकेंड पर होती है (उदाहरण के लिए, 5 मिनट/50 जीबी)। यह स्टार्टअप ओवरहेड स्वीकार्य है या नहीं यह मुख्य रूप से आपके प्रशिक्षण कार्य की कुल अवधि पर निर्भर करता है, क्योंकि लंबे प्रशिक्षण चरण का मतलब आनुपातिक रूप से छोटा डाउनलोड चरण होता है।

अमेज़ॅन S3 फास्टफ़ाइल मोड

फास्टफाइल मोड POSIX-संगत फ़ाइल सिस्टम इंटरफ़ेस के माध्यम से S3 ऑब्जेक्ट्स को उजागर करता है, जैसे कि फ़ाइलें आपके प्रशिक्षण उदाहरण की स्थानीय डिस्क पर उपलब्ध थीं, और जब प्रशिक्षण स्क्रिप्ट द्वारा डेटा का उपभोग किया जाता है तो उनकी सामग्री को मांग पर स्ट्रीम किया जाता है। इसका मतलब है कि आपके डेटासेट को अब प्रशिक्षण इंस्टेंस स्टोरेज स्पेस में फिट होने की आवश्यकता नहीं है, और प्रशिक्षण शुरू होने से पहले आपको डेटासेट को प्रशिक्षण इंस्टेंस में डाउनलोड होने की प्रतीक्षा करने की आवश्यकता नहीं है।

इसे सुविधाजनक बनाने के लिए, सेजमेकर आपकी प्रशिक्षण स्क्रिप्ट चलने से पहले निर्दिष्ट S3 उपसर्ग के तहत संग्रहीत सभी ऑब्जेक्ट मेटाडेटा को सूचीबद्ध करता है। इस मेटाडेटा का उपयोग केवल पढ़ने के लिए किया जाता है FUSE (यूजरस्पेस में फ़ाइल सिस्टम) यह आपके प्रशिक्षण स्क्रिप्ट के माध्यम से उपलब्ध है /opt/ml/data/training-channel-name. S3 ऑब्जेक्ट की सूची उनके आकार की परवाह किए बिना प्रति सेकंड 5,500 ऑब्जेक्ट की गति से चलती है। यह फ़ाइलों को पहले से डाउनलोड करने की तुलना में बहुत तेज़ है, जैसा कि फ़ाइल मोड के मामले में है। जब आपकी प्रशिक्षण स्क्रिप्ट चल रही हो, तो यह फ़ाइलों को सूचीबद्ध या पढ़ सकती है जैसे कि वे स्थानीय रूप से उपलब्ध हों। प्रत्येक रीड ऑपरेशन को FUSE सेवा को सौंपा गया है, जो कॉलर को वास्तविक फ़ाइल सामग्री वितरित करने के लिए अमेज़ॅन S3 पर GET अनुरोधों को प्रॉक्सी करता है। एक स्थानीय फ़ाइल सिस्टम की तरह, फास्टफ़ाइल फ़ाइलों को बाइट्स के रूप में मानता है, इसलिए यह फ़ाइल स्वरूपों के प्रति अज्ञेयवादी है। कई श्रमिकों का उपयोग करके क्रमिक रूप से बड़ी फ़ाइलों को पढ़ते समय फास्टफाइल मोड एक जीबी/सेकेंड से अधिक के थ्रूपुट तक पहुंच सकता है। आप छोटी फ़ाइलों को पढ़ने या यादृच्छिक बाइट श्रेणियों को पुनर्प्राप्त करने के लिए फास्टफ़ाइल का उपयोग कर सकते हैं, लेकिन आपको ऐसे एक्सेस पैटर्न के लिए कम थ्रूपुट की उम्मीद करनी चाहिए। आप कई छोटी फ़ाइलों को बड़े फ़ाइल कंटेनरों में क्रमबद्ध करके और उन्हें क्रमिक रूप से पढ़कर अपने पढ़ने के पहुंच पैटर्न को अनुकूलित कर सकते हैं।

फास्टफाइल वर्तमान में केवल S3 उपसर्गों का समर्थन करता है (मैनिफ़ेस्ट और संवर्धित मैनिफ़ेस्ट के लिए कोई समर्थन नहीं), और फास्टफ़ाइल मोड सेजमेकर स्थानीय मोड के साथ संगत है।

अमेज़न S3 पाइप मोड

पाइप मोड एक अन्य स्ट्रीमिंग मोड है जिसे बड़े पैमाने पर नए और उपयोग में आसान फास्टफाइल मोड द्वारा प्रतिस्थापित किया गया है।

पाइप मोड के साथ, डेटा को अमेज़ॅन एस3 से उच्च संगामिति और थ्रूपुट पर पूर्व-प्राप्त किया जाता है, और फीफो पाइप नामक यूनिक्स में स्ट्रीम किया जाता है। प्रत्येक पाइप को केवल एक ही प्रक्रिया द्वारा पढ़ा जा सकता है। TensorFlow के लिए एक सेजमेकर-विशिष्ट एक्सटेंशन सुविधाजनक रूप से पाइप मोड को मूल TensorFlow डेटा लोडर में एकीकृत करता है स्ट्रीमिंग टेक्स्ट, TFRecords, या रिकॉर्डIO फ़ाइल स्वरूपों के लिए। पाइप मोड डेटा की प्रबंधित शार्डिंग और शफ़लिंग का भी समर्थन करता है।

चमक के लिए FSx

लस्टर के लिए एफएसएक्स कम-विलंबता फ़ाइल पुनर्प्राप्ति के साथ सैकड़ों जीबी/एस थ्रूपुट और लाखों आईओपीएस तक स्केल कर सकता है।

प्रशिक्षण कार्य शुरू करते समय, सेजमेकर लस्टर फ़ाइल सिस्टम के लिए एफएसएक्स को प्रशिक्षण इंस्टेंस फ़ाइल सिस्टम में माउंट करता है, फिर आपकी प्रशिक्षण स्क्रिप्ट शुरू करता है। माउंटिंग स्वयं एक अपेक्षाकृत तेज़ ऑपरेशन है जो लस्टर के लिए एफएसएक्स में संग्रहीत डेटासेट के आकार पर निर्भर नहीं करता है।

कई मामलों में, आप लस्टर फ़ाइल सिस्टम के लिए एक एफएसएक्स बनाते हैं और इसे S3 बकेट और उपसर्ग से लिंक करें. जब स्रोत के रूप में S3 बकेट से लिंक किया जाता है, तो फ़ाइलें फ़ाइल सिस्टम में आलसी-लोड हो जाती हैं क्योंकि आपकी प्रशिक्षण स्क्रिप्ट उन्हें पढ़ती है। इसका मतलब यह है कि आपके पहले प्रशिक्षण चलाने के पहले युग के ठीक बाद, पूरे डेटासेट को अमेज़ॅन एस 3 से लस्टर स्टोरेज के लिए एफएसएक्स में कॉपी किया जाता है (मान लीजिए कि एक युग को प्रशिक्षण उदाहरणों के अनुसार एकल पूर्ण स्वीप के रूप में परिभाषित किया गया है, और इसके लिए आवंटित एफएसएक्स चमक भंडारण काफी बड़ा है)। यह समान डेटासेट के साथ किसी भी बाद के युग और प्रशिक्षण कार्यों के लिए कम-विलंबता फ़ाइल एक्सेस को सक्षम बनाता है।

आप भी कर सकते हैं फ़ाइल सिस्टम में फ़ाइलें प्रीलोड करें प्रशिक्षण कार्य शुरू करने से पहले, जो आलसी लोडिंग के कारण होने वाली ठंड को कम करता है। समानांतर में कई प्रशिक्षण कार्य चलाना भी संभव है जो लस्टर फ़ाइल सिस्टम के लिए एक ही एफएसएक्स द्वारा सेवित हैं। लस्टर के लिए एफएसएक्स तक पहुंचने के लिए, आपके प्रशिक्षण कार्य को वीपीसी से कनेक्ट होना चाहिए (देखें)। VPCConfig सेटिंग्स), जिसके लिए DevOps सेटअप और भागीदारी की आवश्यकता होती है। डेटा स्थानांतरण लागत से बचने के लिए, फ़ाइल सिस्टम एकल उपलब्धता क्षेत्र का उपयोग करता है, और प्रशिक्षण कार्य चलाते समय आपको इस उपलब्धता क्षेत्र आईडी को निर्दिष्ट करने की आवश्यकता होती है। क्योंकि आप अपने दीर्घकालिक डेटा भंडारण के रूप में अमेज़ॅन एस 3 का उपयोग कर रहे हैं, हम स्क्रैच 2 स्टोरेज के साथ लस्टर के लिए अपने एफएसएक्स को तैनात करने की सलाह देते हैं, उच्च थ्रूपुट के लिए एक लागत प्रभावी, अल्पकालिक भंडारण विकल्प के रूप में, 200 एमबी / एस की आधार रेखा प्रदान करता है। और प्रावधानित भंडारण के प्रति टीबी 1300 एमबी/एस तक का विस्फोट।

लस्टर फ़ाइल सिस्टम के लिए आपके एफएसएक्स के लगातार चलने से, आप फ़ाइल सिस्टम के बनने की प्रतीक्षा किए बिना नए प्रशिक्षण कार्य शुरू कर सकते हैं, और पहले युग के दौरान कोल्ड स्टार्ट के बारे में चिंता करने की ज़रूरत नहीं है (क्योंकि फ़ाइलें अभी भी कैश की जा सकती हैं) लस्टर फ़ाइल सिस्टम के लिए FSx)। इस परिदृश्य में नकारात्मक पक्ष फ़ाइल सिस्टम को चालू रखने से जुड़ी अतिरिक्त लागत है। वैकल्पिक रूप से, आप प्रत्येक प्रशिक्षण कार्य से पहले और बाद में फ़ाइल सिस्टम बना और हटा सकते हैं (शायद मदद के लिए स्क्रिप्टेड ऑटोमेशन के साथ), लेकिन लस्टर फ़ाइल सिस्टम के लिए एफएसएक्स को प्रारंभ करने में समय लगता है, जो इसमें रखी गई फ़ाइलों की संख्या के लिए आनुपातिक है (के लिए) उदाहरण के लिए, Amazon S2 से लगभग 3 मिलियन ऑब्जेक्ट को अनुक्रमित करने में लगभग एक घंटा लगता है)।

अमेज़ॅन ईएफएस

यदि एमएल प्रशिक्षण के अलावा उपयोग के मामलों के कारण आपका प्रशिक्षण डेटा पहले से ही अमेज़ॅन ईएफएस में मौजूद है, तो हम अमेज़ॅन ईएफएस का उपयोग करने की सलाह देते हैं। डेटा स्रोत के रूप में Amazon EFS का उपयोग करने के लिए, डेटा को प्रशिक्षण से पहले ही Amazon EFS में मौजूद होना चाहिए। सेजमेकर निर्दिष्ट अमेज़ॅन ईएफएस फ़ाइल सिस्टम को प्रशिक्षण उदाहरण में माउंट करता है, फिर आपकी प्रशिक्षण स्क्रिप्ट शुरू करता है। अमेज़ॅन ईएफएस फ़ाइल सिस्टम को कॉन्फ़िगर करते समय, आपको डिफ़ॉल्ट सामान्य प्रयोजन प्रदर्शन मोड के बीच चयन करना होगा, जो विलंबता (छोटी फ़ाइलों के लिए अच्छा) और मैक्स I/O प्रदर्शन मोड के लिए अनुकूलित है, जो समग्र थ्रूपुट के उच्च स्तर तक स्केल कर सकता है और प्रति सेकंड संचालन (कई I/O श्रमिकों के साथ प्रशिक्षण कार्यों के लिए बेहतर)। अधिक जानने के लिए, देखें सही प्रदर्शन मोड का उपयोग करना.

इसके अतिरिक्त, आप दो मीटर्ड थ्रूपुट विकल्पों के बीच चयन कर सकते हैं: बर्स्टिंग थ्रूपुट, और प्रावधानित थ्रूपुट। 1 टीबी फ़ाइल सिस्टम के लिए बर्स्टिंग थ्रूपुट 150 एमबी/सेकेंड की बेसलाइन प्रदान करता है, जबकि प्रतिदिन 300 घंटे की समयावधि के लिए 12 एमबी/सेकेंड तक बर्स्ट करने में सक्षम होता है। यदि आपको उच्च बेसलाइन थ्रूपुट की आवश्यकता है, या आप कई बार बर्स्ट क्रेडिट से बाहर हो रहे हैं, तो आप या तो फ़ाइल सिस्टम का आकार बढ़ा सकते हैं या प्रावधानित थ्रूपुट पर स्विच कर सकते हैं। प्रावधानित थ्रूपुट में, आप अधिकतम 3072 एमबी/एस रीड तक वांछित बेसलाइन थ्रूपुट के लिए भुगतान करते हैं।

आपका प्रशिक्षण कार्य एक वीपीसी से जुड़ा होना चाहिए (देखें)। VPCConfig सेटिंग्स) अमेज़ॅन ईएफएस तक पहुंचने के लिए।

सर्वोत्तम डेटा स्रोत चुनना

आपके प्रशिक्षण कार्य के लिए सबसे अच्छा डेटा स्रोत डेटासेट आकार, फ़ाइल प्रारूप, औसत फ़ाइल आकार, प्रशिक्षण अवधि, अनुक्रमिक या यादृच्छिक डेटा लोडर पढ़ने के पैटर्न जैसी कार्यभार विशेषताओं पर निर्भर करता है, और आपका मॉडल कितनी तेजी से प्रशिक्षण डेटा का उपभोग कर सकता है।

निम्नलिखित फ़्लोचार्ट आपको आरंभ करने में मदद करने के लिए कुछ दिशानिर्देश प्रदान करता है:

Amazon EFS का उपयोग कब करें

यदि आपका डेटासेट मुख्य रूप से अमेज़ॅन ईएफएस पर संग्रहीत है, तो आपके पास एक प्रीप्रोसेसिंग या एनोटेशन एप्लिकेशन हो सकता है जो भंडारण के लिए अमेज़ॅन ईएफएस का उपयोग करता है। आप आसानी से एक डेटा चैनल के साथ कॉन्फ़िगर किया गया प्रशिक्षण कार्य चला सकते हैं जो अमेज़ॅन ईएफएस फ़ाइल सिस्टम को इंगित करता है (अधिक जानकारी के लिए, देखें) चमक और अमेज़न EFS फ़ाइल सिस्टम के लिए Amazon FSx का उपयोग करके Amazon SageMaker पर प्रशिक्षण को गति दें). यदि प्रदर्शन आपकी अपेक्षा के अनुरूप अच्छा नहीं है, तो अपने अनुकूलन विकल्पों की जाँच करें अमेज़ॅन ईएफएस प्रदर्शन गाइड, या अन्य इनपुट मोड पर विचार करें।

छोटे डेटासेट के लिए फ़ाइल मोड का उपयोग करें

यदि डेटासेट अमेज़ॅन एस3 पर संग्रहीत है और इसकी कुल मात्रा अपेक्षाकृत छोटी है (उदाहरण के लिए, 50-100 जीबी से कम), तो फ़ाइल मोड का उपयोग करने का प्रयास करें. 50 जीबी के डेटासेट को डाउनलोड करने का ओवरहेड फ़ाइलों की कुल संख्या के आधार पर भिन्न हो सकता है (उदाहरण के लिए, यदि 5 एमबी के टुकड़ों में विभाजित किया जाए तो लगभग 100 मिनट)। यह स्टार्टअप ओवरहेड स्वीकार्य है या नहीं यह मुख्य रूप से आपके प्रशिक्षण कार्य की कुल अवधि पर निर्भर करता है, क्योंकि लंबे प्रशिक्षण चरण का मतलब आनुपातिक रूप से छोटा डाउनलोड चरण होता है।

कई छोटी फाइलों को एक साथ क्रमबद्ध करना

यदि आपके डेटासेट का आकार छोटा है (50-100 जीबी से कम), लेकिन कई छोटी फ़ाइलों (50 एमबी से कम) से बना है, तो फ़ाइल मोड डाउनलोड ओवरहेड बढ़ता है, क्योंकि प्रत्येक फ़ाइल को अमेज़ॅन एस3 से व्यक्तिगत रूप से डाउनलोड करने की आवश्यकता होती है। प्रशिक्षण उदाहरण मात्रा. इस ओवरहेड को कम करने के लिए, और सामान्य रूप से डेटा ट्रैवर्सल को तेज़ करने के लिए, फ़ाइल स्वरूपों का उपयोग करके छोटी फ़ाइलों के समूहों को कम बड़े फ़ाइल कंटेनरों (जैसे 150 एमबी प्रति फ़ाइल) में क्रमबद्ध करने पर विचार करें टीएफरिकॉर्ड टेंसरफ्लो के लिए, वेबडेटासेट PyTorch के लिए, या रिकॉर्डो एमएक्सनेट के लिए। इन प्रारूपों के लिए आपके डेटा लोडर को उदाहरणों के माध्यम से क्रमिक रूप से पुनरावृत्त करने की आवश्यकता होती है। आप प्रत्येक युग के बाद TFRecord फ़ाइलों की सूची को बेतरतीब ढंग से पुन: व्यवस्थित करके और स्थानीय शफ़ल बफ़र से डेटा का बेतरतीब ढंग से नमूना लेकर अपने डेटा में फेरबदल कर सकते हैं (निम्न देखें) टेंसरफ़्लो उदाहरण).

फास्टफाइल मोड का उपयोग कब करें

बड़ी फ़ाइलों (50 एमबी से अधिक) वाले बड़े डेटासेट के लिए, पहला विकल्प फास्टफ़ाइल मोड को आज़माना है, जिसका उपयोग लस्टर के लिए एफएसएक्स की तुलना में अधिक सरल है क्योंकि इसमें फ़ाइल सिस्टम बनाने या वीपीसी से कनेक्ट करने की आवश्यकता नहीं है। फास्टफ़ाइल मोड बड़े फ़ाइल कंटेनर (150 एमबी से अधिक) के लिए आदर्श है, और 50 एमबी से अधिक फ़ाइलों के साथ भी अच्छा प्रदर्शन कर सकता है। क्योंकि फास्टफाइल मोड एक POSIX इंटरफ़ेस प्रदान करता है, यह यादृच्छिक रीड्स (गैर-अनुक्रमिक बाइट-रेंज को पढ़ने) का समर्थन करता है। हालाँकि, यह आदर्श उपयोग का मामला नहीं है, और आपका थ्रूपुट संभवतः अनुक्रमिक रीड्स की तुलना में कम होगा। हालाँकि, यदि आपके पास अपेक्षाकृत बड़ा और कम्प्यूटेशनल रूप से गहन एमएल मॉडल है, तो फास्टफाइल मोड अभी भी प्रशिक्षण पाइपलाइन की प्रभावी बैंडविड्थ को संतृप्त करने में सक्षम हो सकता है और इसके परिणामस्वरूप I/O बाधा उत्पन्न नहीं होगी। आपको प्रयोग करके देखना होगा. सौभाग्य से, फ़ाइल मोड से फास्टफ़ाइल (और वापस) पर स्विच करना उतना ही आसान है जितना कि जोड़ना (या हटाना)। input_mode='FastFile' सेजमेकर पायथन एसडीके का उपयोग करके आपके इनपुट चैनल को परिभाषित करते समय पैरामीटर:

किसी अन्य कोड या कॉन्फ़िगरेशन को बदलने की आवश्यकता नहीं है.

चमक के लिए एफएसएक्स का उपयोग कब करें

यदि आपका डेटासेट फ़ाइल मोड के लिए बहुत बड़ा है, या इसमें कई छोटी फ़ाइलें हैं (जिन्हें आप आसानी से क्रमबद्ध नहीं कर सकते हैं), या आपके पास एक यादृच्छिक रीड एक्सेस पैटर्न है, तो लस्टर के लिए एफएसएक्स विचार करने के लिए एक अच्छा विकल्प है। इसका फ़ाइल सिस्टम सैकड़ों GB/s थ्रूपुट और लाखों IOPS तक स्केल करता है, जो तब आदर्श होता है जब आपके पास कई छोटी फ़ाइलें हों। हालाँकि, जैसा कि पहले ही चर्चा की जा चुकी है, आलसी लोडिंग के कारण कोल्ड स्टार्ट की समस्याओं और लस्टर फ़ाइल सिस्टम के लिए एफएसएक्स को स्थापित करने और आरंभ करने के ओवरहेड से सावधान रहें।

लागत विचार

अधिकांश एमएल प्रशिक्षण नौकरियों के लिए, विशेष रूप से जीपीयू या उद्देश्य-निर्मित एमएल चिप्स का उपयोग करने वाली नौकरियों के लिए, प्रशिक्षण की अधिकांश लागत एमएल प्रशिक्षण उदाहरण के बिल योग्य सेकंड है। प्रति माह जीबी स्टोरेज, एपीआई अनुरोध और प्रावधानित थ्रूपुट अतिरिक्त लागतें हैं जो सीधे आपके द्वारा उपयोग किए जाने वाले डेटा स्रोतों से जुड़ी हैं।

भंडारण जीबी प्रति माह

वीडियो, LiDAR सेंसर डेटा और AdTech रीयल-टाइम बोली लॉग जैसे बड़े डेटासेट के लिए प्रति माह स्टोरेज GB महत्वपूर्ण हो सकता है। उदाहरण के लिए, 1 टीबी को स्टोर करना अमेज़न S3 इंटेलिजेंट-टियरिंग फ़्रीक्वेंट एक्सेस टियर लागत $23 प्रति माह. Amazon S3 के शीर्ष पर लस्टर फ़ाइल सिस्टम के लिए FSx जोड़ने से अतिरिक्त लागत आती है। उदाहरण के लिए, डेटा संपीड़न अक्षम के साथ एसएसडी-समर्थित स्क्रैच 1.2 प्रकार की 2 टीबी फ़ाइल प्रणाली बनाने पर अतिरिक्त $168 प्रति माह ($140/टीबी/माह) खर्च होता है।

अमेज़ॅन एस3 और अमेज़ॅन ईएफएस के साथ, आप केवल उसी के लिए भुगतान करते हैं जो आप उपयोग करते हैं, जिसका अर्थ है कि आपसे वास्तविक डेटासेट आकार के अनुसार शुल्क लिया जाता है। लस्टर के लिए एफएसएक्स के साथ, आपसे प्रावधानित फ़ाइल सिस्टम आकार (न्यूनतम 1.2 टीबी) के अनुसार शुल्क लिया जाता है। ईबीएस वॉल्यूम के साथ एमएल इंस्टेंस चलाते समय, अमेज़ॅन ईबीएस को एमएल इंस्टेंस से स्वतंत्र रूप से चार्ज किया जाता है। यह आमतौर पर इंस्टेंस को चलाने की लागत की तुलना में बहुत कम लागत है। उदाहरण के लिए, एक ml.p3.2xlarge इंस्टेंस को 100 GB EBS वॉल्यूम के साथ 1 घंटे तक चलाने पर इंस्टेंस के लिए $3.825 और EBS वॉल्यूम के लिए $0.02 का खर्च आता है।

एपीआई अनुरोध और प्रावधानित थ्रूपुट लागत

जब आपका प्रशिक्षण कार्य डेटासेट के माध्यम से काम कर रहा होता है, तो यह Amazon S3 API अनुरोध भेजकर फ़ाइलों को सूचीबद्ध और लाता है। उदाहरण के लिए, प्रत्येक मिलियन GET अनुरोध की कीमत $0.4 (इंटेलिजेंट-टियरिंग क्लास के साथ) है। आपको अमेज़ॅन S3 के अंदर और बाहर बैंडविड्थ के लिए कोई डेटा ट्रांसफर लागत नहीं होने की उम्मीद करनी चाहिए, क्योंकि प्रशिक्षण एक ही उपलब्धता क्षेत्र में होता है।

एस3 बकेट से जुड़े लस्टर के लिए एफएसएक्स का उपयोग करते समय, आपको उस डेटा को पढ़ने के लिए अमेज़ॅन एस3 एपीआई अनुरोध लागत का भुगतान करना पड़ता है जो अभी तक फ़ाइल सिस्टम में कैश नहीं किया गया है, क्योंकि लस्टर के लिए एफएसएक्स अमेज़ॅन एस3 के लिए अनुरोध को प्रॉक्सी करता है (और परिणाम को कैश करता है) ). लस्टर के लिए एफएसएक्स के लिए कोई प्रत्यक्ष अनुरोध लागत नहीं है। जब आप लस्टर फ़ाइल सिस्टम के लिए एफएसएक्स का उपयोग करते हैं, तो अपने प्रशिक्षण कार्य को उसी उपलब्धता क्षेत्र से जोड़कर क्रॉस-अवेलेबिलिटी ज़ोन डेटा ट्रांसफर की लागत से बचें, जिसमें आपने फ़ाइल सिस्टम का प्रावधान किया है। प्रावधानित थ्रूपुट के साथ अमेज़ॅन ईएफएस अतिरिक्त लागत जोड़ता है। जीबी प्रति माह.

प्रदर्शन मामले का अध्ययन

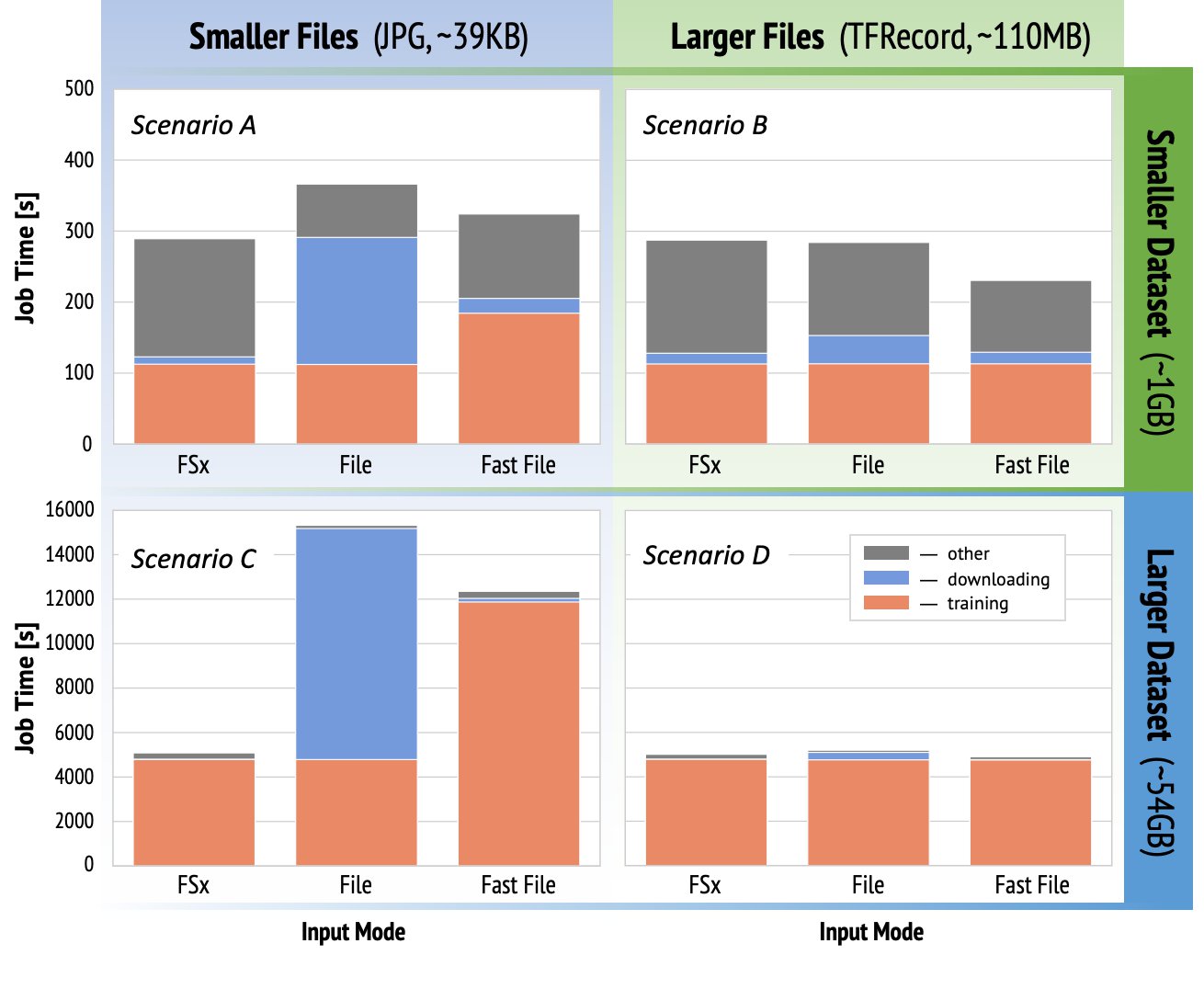

पहले उल्लिखित प्रशिक्षण प्रदर्शन संबंधी विचारों को प्रदर्शित करने के लिए, हमने कंप्यूटर विज़न डोमेन में यथार्थवादी उपयोग के मामले के लिए बेंचमार्क की एक श्रृंखला का प्रदर्शन किया। इस अनुभाग से बेंचमार्क (और टेकअवे) सभी परिदृश्यों पर लागू नहीं हो सकते हैं, और हमारे द्वारा उपयोग किए जाने वाले विभिन्न पूर्वनिर्धारित कारकों से प्रभावित होते हैं, जैसे डीएनएन। हमने निम्नलिखित में से 12 संयोजनों के लिए परीक्षण चलाए:

- इनपुट मोड - चमक, फाइल मोड, फास्टफाइल मोड के लिए एफएसएक्स

- दातासेट आकार - छोटा डेटासेट (1 जीबी), बड़ा डेटासेट (54 जीबी)

- फाइल का आकार - छोटी फ़ाइलें (JPGs, लगभग 39 KB), बड़ी फ़ाइलें (TFRecord, लगभग 110 MB)

इस केस स्टडी के लिए, हमने सबसे व्यापक रूप से उपयोग किए जाने वाले इनपुट मोड को चुना, और इसलिए अमेज़ॅन ईएफएस और पाइप मोड को छोड़ दिया।

केस स्टडी बेंचमार्क को ml.p3.2xlarge सिंगल-GPU इंस्टेंस पर एंड-टू-एंड SageMaker TensorFlow प्रशिक्षण नौकरियों के रूप में डिज़ाइन किया गया था। हमने वर्गीकरण कार्य के लिए प्रसिद्ध रेसनेट-50 को अपने बैकबोन मॉडल के रूप में और कैलटेक-256 को छोटे प्रशिक्षण डेटासेट के रूप में चुना (जिसे हमने इसका बड़ा डेटासेट संस्करण बनाने के लिए 50 बार दोहराया)। हमने एक युग के लिए प्रशिक्षण का प्रदर्शन किया, जिसे प्रशिक्षण के उदाहरणों के अनुसार एकल पूर्ण स्वीप के रूप में परिभाषित किया गया है।

निम्नलिखित ग्राफ़ प्रत्येक बेंचमार्क परिदृश्य के लिए सेजमेकर प्रशिक्षण नौकरियों का कुल बिल योग्य समय दिखाते हैं। कुल कार्य समय में डाउनलोडिंग, प्रशिक्षण और अन्य चरण (जैसे कंटेनर स्टार्टअप और अमेज़ॅन एस 3 पर प्रशिक्षित मॉडल कलाकृतियों को अपलोड करना) शामिल है। कम बिल योग्य समय तेजी से और सस्ती प्रशिक्षण नौकरियों में तब्दील हो जाता है।

आइये पहले चर्चा करते हैं परिदृश्य ए और परिदृश्य सी, जो डेटासेट में कई छोटी फ़ाइलों से युक्त होने पर इनपुट मोड के बीच प्रदर्शन अंतर को आसानी से प्रदर्शित करता है।

परिदृश्य ए (छोटी फ़ाइलें, छोटे डेटासेट) से पता चलता है कि लस्टर फ़ाइल सिस्टम के लिए एफएसएक्स के साथ प्रशिक्षण कार्य में बिल करने योग्य समय सबसे कम है। इसका डाउनलोडिंग चरण सबसे छोटा है, और इसका प्रशिक्षण चरण फ़ाइल मोड जितना तेज़ है, लेकिन फास्टफ़ाइल से तेज़ है। लस्टर के लिए एफएसएक्स इस एकल युग परीक्षण में विजेता है। ऐसा कहने के बाद, एक समान कार्यभार पर विचार करें लेकिन कई युगों के साथ-जैसे-जैसे अधिक युग जोड़े जाते हैं, डाउनलोडिंग चरण के कारण फ़ाइल मोड का सापेक्ष ओवरहेड कम हो जाता है। इस मामले में, हम उपयोग में आसानी के लिए फ़ाइल मोड को प्राथमिकता देते हैं। इसके अतिरिक्त, आप पा सकते हैं कि फ़ाइल मोड का उपयोग करना और 100 अतिरिक्त बिल योग्य सेकंड के लिए भुगतान करना लस्टर फ़ाइल सिस्टम के लिए एफएसएक्स का भुगतान करने और प्रावधान करने से बेहतर विकल्प है।

परिदृश्य सी (छोटी फ़ाइलें, बड़ा डेटासेट) लस्टर के लिए एफएसएक्स को सबसे तेज़ मोड के रूप में दिखाता है, कुल बिल योग्य समय के केवल 5,000 सेकंड के साथ। इसमें सबसे छोटा डाउनलोडिंग चरण भी है, क्योंकि लस्टर फाइल सिस्टम के लिए एफएसएक्स को माउंट करना फाइल सिस्टम में फाइलों की संख्या (इस मामले में 1.5 मिलियन फाइलें) पर निर्भर नहीं करता है। फास्टफाइल का डाउनलोडिंग ओवरहेड भी छोटा है; यह केवल निर्दिष्ट S3 बकेट उपसर्ग के अंतर्गत रहने वाली फ़ाइलों का मेटाडेटा प्राप्त करता है, जबकि फ़ाइलों की सामग्री प्रशिक्षण चरण के दौरान पढ़ी जाती है। फ़ाइल मोड सबसे धीमा मोड है, प्रशिक्षण शुरू करने से पहले संपूर्ण डेटासेट को डाउनलोड करने में 10,000 सेकंड खर्च होते हैं। जब हम प्रशिक्षण चरण को देखते हैं, तो चमक और फ़ाइल मोड के लिए एफएसएक्स समान उत्कृष्ट प्रदर्शन प्रदर्शित करता है। फास्टफाइल मोड के लिए, जब अमेज़ॅन एस 3 से सीधे छोटी फ़ाइलों को स्ट्रीम किया जाता है, तो प्रत्येक फ़ाइल के लिए एक नया जीईटी अनुरोध भेजने का ओवरहेड फ़ाइल स्थानांतरण की कुल अवधि के सापेक्ष महत्वपूर्ण हो जाता है (प्रीफ़ेच बफर के साथ अत्यधिक समानांतर डेटा लोडर का उपयोग करने के बावजूद)। इसके परिणामस्वरूप फास्टफाइल मोड के लिए कुल मिलाकर कम थ्रूपुट होता है, जो प्रशिक्षण कार्य के लिए I/O बाधा पैदा करता है। इस परिदृश्य में लस्टर के लिए एफएसएक्स स्पष्ट विजेता है।

परिदृश्य बी और डी जब डेटासेट में कम बड़ी फ़ाइलें शामिल हों तो इनपुट मोड में प्रदर्शन अंतर दिखाएं। बड़ी फ़ाइलों का उपयोग करके क्रमिक रूप से पढ़ने से आमतौर पर बेहतर I/O प्रदर्शन प्राप्त होता है क्योंकि यह प्रभावी बफरिंग की अनुमति देता है और I/O संचालन की संख्या को कम करता है।

परिदृश्य बी (बड़ी फ़ाइलें, छोटा डेटासेट) सभी मोड के लिए समान प्रशिक्षण चरण का समय दिखाता है (यह प्रमाणित करता है कि प्रशिक्षण I/O-बाध्य नहीं है)। इस परिदृश्य में, हम छोटे डाउनलोडिंग चरण के कारण फ़ाइल मोड पर फास्टफाइल मोड को प्राथमिकता देते हैं, और पूर्व के उपयोग में आसानी के कारण लस्टर के लिए एफएसएक्स पर फास्टफाइल मोड को प्राथमिकता देते हैं।

परिदृश्य डी (बड़ी फ़ाइलें, बड़ा डेटासेट) तीनों मोड के लिए अपेक्षाकृत समान कुल बिल योग्य समय दिखाता है। फाइल मोड का डाउनलोडिंग चरण लस्टर और फास्टफाइल के लिए एफएसएक्स की तुलना में लंबा है। फ़ाइल मोड प्रशिक्षण चरण शुरू करने से पहले संपूर्ण डेटासेट (54 जीबी) को अमेज़ॅन एस3 से प्रशिक्षण उदाहरण में डाउनलोड करता है। सभी तीन मोड प्रशिक्षण चरण में समान समय बिताते हैं, क्योंकि सभी मोड काफी तेजी से डेटा प्राप्त कर सकते हैं और जीपीयू-बाउंड हैं। यदि हम अतिरिक्त सीपीयू या जीपीयू संसाधनों, जैसे कि ml.p4d.24xlarge, के साथ एमएल इंस्टेंस का उपयोग करते हैं, तो गणना संसाधनों को संतृप्त करने के लिए आवश्यक डेटा I/O थ्रूपुट बढ़ता है। इन मामलों में, हम लस्टर के लिए फास्टफाइल और एफएसएक्स से अपने थ्रूपुट को सफलतापूर्वक स्केल करने की उम्मीद कर सकते हैं (हालांकि, लस्टर थ्रूपुट के लिए एफएसएक्स प्रावधानित फ़ाइल सिस्टम आकार पर निर्भर करता है)। फ़ाइल मोड की अपने थ्रूपुट को स्केल करने की क्षमता इंस्टेंस से जुड़े डिस्क वॉल्यूम के थ्रूपुट पर निर्भर करती है। उदाहरण के लिए, अमेज़ॅन ईबीएस-समर्थित इंस्टेंस (जैसे ml.p3.2xlarge, ml.p3.8xlarge, और ml.p3.16xlarge) 250MB/s के अधिकतम थ्रूपुट तक सीमित हैं, जबकि स्थानीय NVMe-समर्थित इंस्टेंस (जैसे ml. g5.* या ml.p4d.24xlarge) बहुत बड़े थ्रूपुट को समायोजित कर सकता है।

संक्षेप में, हमारा मानना है कि फास्टफाइल इस परिदृश्य के लिए विजेता है क्योंकि यह फ़ाइल मोड से तेज़ है, और लस्टर के लिए एफएसएक्स जितना तेज़ है, फिर भी उपयोग करने में अधिक सरल है, लागत कम है, और आवश्यकतानुसार अपने थ्रूपुट को आसानी से बढ़ा सकता है।

इसके अतिरिक्त, यदि हमारे पास बहुत बड़ा डेटासेट (आकार में कई टीबी) है, तो फ़ाइल मोड प्रशिक्षण शुरू होने से पहले डेटासेट डाउनलोड करने में कई घंटे खर्च करेगा, जबकि फास्टफ़ाइल काफी तेज़ी से प्रशिक्षण शुरू कर सकता है।

अपना स्वयं का डेटा अंतर्ग्रहण लाएँ

सेजमेकर का मूल डेटा स्रोत सभी संभावित एमएल प्रशिक्षण परिदृश्यों में नहीं बल्कि अधिकांश में फिट बैठता है। जिन स्थितियों में आपको अन्य डेटा अंतर्ग्रहण विकल्पों की तलाश करने की आवश्यकता हो सकती है, उनमें तीसरे पक्ष के भंडारण उत्पाद से सीधे डेटा पढ़ना शामिल हो सकता है (यह मानते हुए कि अमेज़ॅन एस 3 पर आसान और समय पर निर्यात संभव नहीं है), या उसी प्रशिक्षण के लिए एक मजबूत आवश्यकता है सेजमेकर और दोनों पर अपरिवर्तित चलने वाली स्क्रिप्ट अमेज़ॅन इलास्टिक कम्प्यूट क्लाउड (अमेज़न EC2) या अमेज़ॅन इलास्टिक कुबेरनेट्स सेवा (अमेज़ॅन ईकेएस)। आप प्रशिक्षण स्क्रिप्ट में अपने डेटा अंतर्ग्रहण तंत्र को लागू करके इन मामलों का समाधान कर सकते हैं। यह तंत्र बाहरी डेटा स्रोतों से डेटासेट को प्रशिक्षण उदाहरण में पढ़ने के लिए जिम्मेदार है। उदाहरण के लिए, TFRecordDataset टेंसरफ्लो का tf.data लाइब्रेरी सीधे Amazon S3 स्टोरेज से पढ़ सकती है।

यदि आपके डेटा अंतर्ग्रहण तंत्र को किसी AWS सेवा को कॉल करने की आवश्यकता है, जैसे अमेज़न रिलेशनल डेटाबेस सर्विस (अमेज़ॅन आरडीएस), सुनिश्चित करें कि AWS पहचान और अभिगम प्रबंधन (IAM) आपके प्रशिक्षण कार्य की भूमिका में प्रासंगिक IAM नीतियां शामिल हैं। यदि डेटा स्रोत मौजूद है अमेज़ॅन वर्चुअल प्राइवेट क्लाउड (अमेज़ॅन वीपीसी), आपको अपना प्रशिक्षण कार्य उसी वीपीसी से कनेक्ट करके चलाने की आवश्यकता है।

जब आप स्वयं डेटासेट अंतर्ग्रहण का प्रबंधन कर रहे होते हैं, तो सेजमेकर वंशावली ट्रैकिंग प्रशिक्षण के दौरान उपयोग किए गए डेटासेट को स्वचालित रूप से लॉग नहीं कर सकती है। इसलिए, अपने प्रासंगिक मेटाडेटा को कैप्चर करने के लिए वैकल्पिक तंत्र, जैसे प्रशिक्षण जॉब टैग या हाइपरपैरामीटर पर विचार करें।

निष्कर्ष

सही सेजमेकर प्रशिक्षण डेटा स्रोत चुनने से एमएल मॉडल के प्रशिक्षण की गति, उपयोग में आसानी और लागत पर गहरा प्रभाव पड़ सकता है। शीघ्रता से आरंभ करने, परिणामों का निरीक्षण करने और आवश्यकतानुसार अतिरिक्त कॉन्फ़िगरेशन के साथ प्रयोग करने के लिए दिए गए फ़्लोचार्ट का उपयोग करें। प्रत्येक डेटा स्रोत के पेशेवरों, विपक्षों और सीमाओं को ध्यान में रखें, और वे आपके प्रशिक्षण कार्य की व्यक्तिगत आवश्यकताओं के लिए कितने उपयुक्त हैं। अधिक जानकारी और सहायता के लिए AWS संपर्क से संपर्क करें।

लेखक के बारे में

गिल्ली नचुम एक वरिष्ठ एआई/एमएल विशेषज्ञ समाधान आर्किटेक्ट हैं जो ईएमईए अमेज़ॅन मशीन लर्निंग टीम के हिस्से के रूप में काम करते हैं। गिली गहन शिक्षण मॉडल के प्रशिक्षण की चुनौतियों के बारे में भावुक है, और जैसा कि हम जानते हैं कि मशीन लर्निंग दुनिया को कैसे बदल रहा है। गिली अपने खाली समय में टेबल टेनिस खेलना पसंद करते हैं।

गिल्ली नचुम एक वरिष्ठ एआई/एमएल विशेषज्ञ समाधान आर्किटेक्ट हैं जो ईएमईए अमेज़ॅन मशीन लर्निंग टीम के हिस्से के रूप में काम करते हैं। गिली गहन शिक्षण मॉडल के प्रशिक्षण की चुनौतियों के बारे में भावुक है, और जैसा कि हम जानते हैं कि मशीन लर्निंग दुनिया को कैसे बदल रहा है। गिली अपने खाली समय में टेबल टेनिस खेलना पसंद करते हैं।

डॉ. अलेक्ज़ेंडर अर्ज़ानोव फ्रैंकफर्ट, जर्मनी में स्थित एक एआई/एमएल विशेषज्ञ समाधान वास्तुकार है। वह एडब्ल्यूएस ग्राहकों को ईएमईए क्षेत्र में अपने एमएल समाधान डिजाइन और तैनात करने में मदद करता है। AWS में शामिल होने से पहले, सिकंदर हमारे ब्रह्मांड में भारी तत्वों की उत्पत्ति पर शोध कर रहा था और अपने बड़े पैमाने पर वैज्ञानिक गणनाओं में इसका उपयोग करने के बाद ML के बारे में भावुक हो गया।

डॉ. अलेक्ज़ेंडर अर्ज़ानोव फ्रैंकफर्ट, जर्मनी में स्थित एक एआई/एमएल विशेषज्ञ समाधान वास्तुकार है। वह एडब्ल्यूएस ग्राहकों को ईएमईए क्षेत्र में अपने एमएल समाधान डिजाइन और तैनात करने में मदद करता है। AWS में शामिल होने से पहले, सिकंदर हमारे ब्रह्मांड में भारी तत्वों की उत्पत्ति पर शोध कर रहा था और अपने बड़े पैमाने पर वैज्ञानिक गणनाओं में इसका उपयोग करने के बाद ML के बारे में भावुक हो गया।

- कॉइनस्मार्ट। यूरोप का सर्वश्रेष्ठ बिटकॉइन और क्रिप्टो एक्सचेंज।

- प्लेटोब्लॉकचैन। Web3 मेटावर्स इंटेलिजेंस। ज्ञान प्रवर्धित। नि: शुल्क प्रवेश।

- क्रिप्टोहॉक। Altcoin रडार। मुफ्त परीक्षण।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/choose-the-best-data-source-for-your-amazon-sagemaker-training-job/

- "

- 000

- 1 टीबी

- 100

- 39

- About

- पहुँच

- अनुसार

- के पार

- अतिरिक्त

- पता

- कलन विधि

- सब

- पहले ही

- वीरांगना

- अन्य

- एपीआई

- उपयुक्त

- आवेदन

- संवर्धित

- स्वत:

- स्वचालन

- उपलब्धता

- उपलब्ध

- औसत

- एडब्ल्यूएस

- आधारभूत

- जा रहा है

- बेंचमार्क

- BEST

- निर्माण

- कॉल

- मामले का अध्ययन

- मामलों

- चुनौतियों

- परिवर्तन

- चैनलों

- आरोप लगाया

- चिप्स

- वर्गीकरण

- कोड

- संयोजन

- संयोजन

- सामान्य

- तुलना

- गणना करना

- विन्यास

- नुकसान

- उपभोग

- कंटेनर

- कंटेनरों

- शामिल हैं

- सामग्री

- प्रभावी लागत

- लागत

- सका

- बनाना

- क्रेडिट्स

- ग्राहक

- तिथि

- डेटा भंडारण

- डाटाबेस

- दिन

- मांग

- तैनाती

- डिज़ाइन

- के बावजूद

- विभिन्न

- चर्चा करना

- वितरित

- नहीं करता है

- डोमेन

- डाउनलोड

- आसानी

- प्रभाव

- प्रभावी

- विशेष रूप से

- उदाहरण

- उत्कृष्ट

- अपेक्षित

- प्रयोग

- कारकों

- फास्ट

- प्रथम

- फिट

- प्रवाह

- का पालन करें

- निम्नलिखित

- प्रारूप

- पूर्ण

- सामान्य जानकारी

- जर्मनी

- GitHub

- अच्छा

- शासन

- GPU

- दिशा निर्देशों

- होने

- मदद

- मदद करता है

- हाई

- अत्यधिक

- कैसे

- HTTPS

- सैकड़ों

- पहचान

- बढ़ना

- अनुक्रमणिका

- व्यक्ति

- उद्योग के अग्रणी

- करें-

- इंटरफेस

- मुद्दों

- IT

- काम

- नौकरियां

- रखना

- कुंजी

- लेबल

- बड़ा

- बड़ा

- शुरू करने

- जानें

- सीख रहा हूँ

- पुस्तकालय

- सीमित

- लाइन

- सूची

- लिस्टिंग

- सूचियाँ

- स्थानीय

- स्थानीय स्तर पर

- मशीन

- यंत्र अधिगम

- बहुमत

- अर्थ

- दस लाख

- लाखों

- मन

- ML

- आदर्श

- मॉडल

- अधिकांश

- ऑफर

- ठीक है

- संचालन

- विकल्प

- ऑप्शंस

- आदेश

- अन्य

- पैटर्न

- वेतन

- प्रदर्शन

- चरण

- पाइप

- नीतियाँ

- लोकप्रिय

- संभव

- मूल्य

- निजी

- प्रक्रिया

- एस्ट्रो मॉल

- PROS

- प्रदान करना

- प्रदान करता है

- प्रयोजनों

- जल्दी से

- रेंज

- पढ़ना

- वास्तविक समय

- की सिफारिश

- को कम करने

- प्रसिद्ध

- प्रतिस्थापित

- की आवश्यकता होती है

- अपेक्षित

- आवश्यकताएँ

- संसाधन

- उपयुक्त संसाधन चुनें

- जिम्मेदार

- परिणाम

- रन

- दौड़ना

- कहा

- अनुमापकता

- स्केलेबल

- स्केल

- वैज्ञानिकों

- एसडीके

- सुरक्षा

- चयनित

- कई

- serverless

- सेवा

- सेवाएँ

- की स्थापना

- sharding

- साझा

- महत्वपूर्ण

- समान

- सरल

- आकार

- छोटा

- So

- समाधान ढूंढे

- अंतरिक्ष

- गति

- बिताना

- खर्च

- Spot

- विस्तार

- ट्रेनिंग

- प्रारंभ

- शुरू

- स्टार्टअप

- भंडारण

- स्ट्रीम किया

- स्ट्रीमिंग

- मजबूत

- अध्ययन

- सफलतापूर्वक

- समर्थन

- समर्थन करता है

- स्वीप

- स्विच

- प्रणाली

- सिस्टम

- टीम

- परीक्षण

- परीक्षण

- दुनिया

- तीसरे दल

- यहाँ

- पहर

- ऊपर का

- ट्रैकिंग

- प्रशिक्षण

- आमतौर पर

- वीडियो

- वास्तविक

- दृष्टि

- आयतन

- प्रतीक्षा

- क्या

- या

- कौन

- विकिपीडिया

- अंदर

- बिना

- श्रमिकों

- कार्य

- विश्व