कोडिंग साथियों के लिए जेनरेटिव एआई मॉडल ज्यादातर सार्वजनिक रूप से उपलब्ध स्रोत कोड और प्राकृतिक भाषा पाठ पर प्रशिक्षित होते हैं। जबकि प्रशिक्षण कोष का बड़ा आकार मॉडलों को आमतौर पर उपयोग की जाने वाली कार्यक्षमता के लिए कोड उत्पन्न करने में सक्षम बनाता है, ये मॉडल निजी रिपॉजिटरी में कोड और उनके साथ विकसित होने पर लागू होने वाली संबंधित कोडिंग शैलियों से अनजान होते हैं। नतीजतन, उत्पन्न सुझावों को आंतरिक भंडार में शामिल करने के लिए उपयुक्त होने से पहले फिर से लिखने की आवश्यकता हो सकती है।

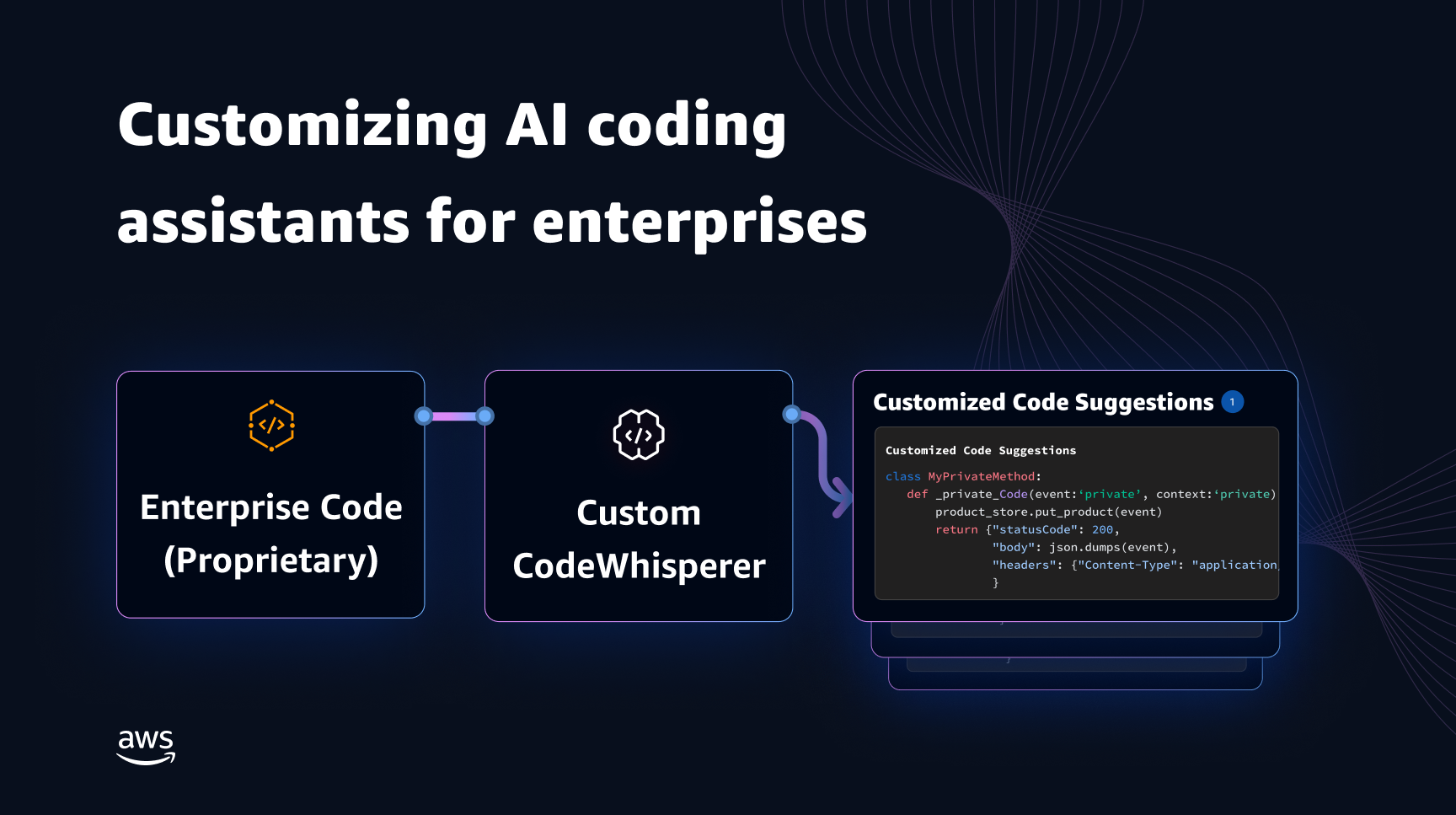

हम इस अंतर को संबोधित कर सकते हैं और सार्वजनिक कोड पर प्रशिक्षित भाषा मॉडल के शीर्ष पर निजी रिपॉजिटरी से कोड ज्ञान को एम्बेड करके अतिरिक्त मैन्युअल संपादन को कम कर सकते हैं। यही कारण है कि हमने इसके लिए एक अनुकूलन क्षमता विकसित की है अमेज़ॅन कोडव्हिस्पीर. इस पोस्ट में, हम आपको पुनर्प्राप्ति संवर्धित पीढ़ी और फ़ाइन-ट्यूनिंग का उपयोग करके कोडिंग साथियों को अनुकूलित करने के दो संभावित तरीके दिखाते हैं।

कोडव्हिस्परर अनुकूलन क्षमता के साथ हमारा लक्ष्य संगठनों को अपने निजी रिपॉजिटरी और पुस्तकालयों का उपयोग करके कोडव्हिस्परर मॉडल को तैयार करने में सक्षम बनाना है ताकि संगठन-विशिष्ट कोड सिफारिशें उत्पन्न की जा सकें जो समय बचाएं, संगठनात्मक शैली और सम्मेलनों का पालन करें और बग या सुरक्षा कमजोरियों से बचें। इससे एंटरप्राइज़ सॉफ़्टवेयर विकास को लाभ होता है और निम्नलिखित चुनौतियों से निपटने में मदद मिलती है:

- आंतरिक पुस्तकालयों और एपीआई के लिए विरल दस्तावेज़ या जानकारी जो डेवलपर्स को उपयोग को दोहराने के लिए पहले लिखे गए कोड की जांच करने में समय बिताने के लिए मजबूर करती है।

- उद्यम-विशिष्ट कोडिंग प्रथाओं, शैलियों और पैटर्न को लागू करने में जागरूकता और स्थिरता का अभाव।

- डेवलपर्स द्वारा अप्रचलित कोड और एपीआई का अनजाने में उपयोग।

अतिरिक्त प्रशिक्षण के लिए आंतरिक कोड रिपॉजिटरी का उपयोग करके, जो पहले से ही कोड समीक्षा से गुजर चुका है, भाषा मॉडल आंतरिक एपीआई और कोड ब्लॉक के उपयोग को सामने ला सकता है जो समस्याओं की पिछली सूची को दूर करता है। क्योंकि संदर्भ कोड की पहले ही समीक्षा की जा चुकी है और यह ग्राहक के उच्च मानक को पूरा करता है, इसलिए बग या सुरक्षा कमजोरियां आने की संभावना भी कम हो जाती है। और, अनुकूलन के लिए उपयोग की जाने वाली स्रोत फ़ाइलों का सावधानीपूर्वक चयन करके, संगठन अप्रचलित कोड के उपयोग को कम कर सकते हैं।

डिजाइन की चुनौतियां

किसी संगठन की निजी रिपॉजिटरी के आधार पर कोड सुझावों को अनुकूलित करने में कई दिलचस्प डिज़ाइन चुनौतियाँ होती हैं। सतह कोड सुझावों के लिए बड़े भाषा मॉडल (एलएलएम) को तैनात करने से उत्पन्न टोकन की संख्या के आधार पर अनुमान के कारण उपलब्धता और परिवर्तनीय लागत के लिए निश्चित लागत होती है। इसलिए, प्रत्येक ग्राहक के लिए अलग-अलग अनुकूलन करना और उन्हें व्यक्तिगत रूप से होस्ट करना, जिससे अतिरिक्त निश्चित लागतें वहन करना अत्यधिक महंगा हो सकता है। दूसरी ओर, एक ही सिस्टम पर एक साथ कई अनुकूलन होने से प्रत्येक ग्राहक के लिए मालिकाना कोड को अलग करने के लिए बहु-किरायेदार बुनियादी ढांचे की आवश्यकता होती है। इसके अलावा, अनुकूलन क्षमता को अलग-अलग मेट्रिक्स (उदाहरण के लिए, कम बग के इतिहास वाली फ़ाइलें या हाल ही में रिपॉजिटरी में प्रतिबद्ध कोड) का उपयोग करके आंतरिक रिपॉजिटरी से उचित प्रशिक्षण उपसमूह के चयन को सक्षम करने के लिए सतह पर आना चाहिए। इन मेट्रिक्स के आधार पर कोड का चयन करके, उच्च गुणवत्ता वाले कोड का उपयोग करके अनुकूलन को प्रशिक्षित किया जा सकता है जो कोड सुझावों की गुणवत्ता में सुधार कर सकता है। अंत में, लगातार विकसित हो रहे कोड रिपॉजिटरी के साथ भी, उद्यमों को बढ़ी हुई डेवलपर उत्पादकता से लागत बचत का एहसास करने में मदद करने के लिए अनुकूलन से जुड़ी लागत न्यूनतम होनी चाहिए।

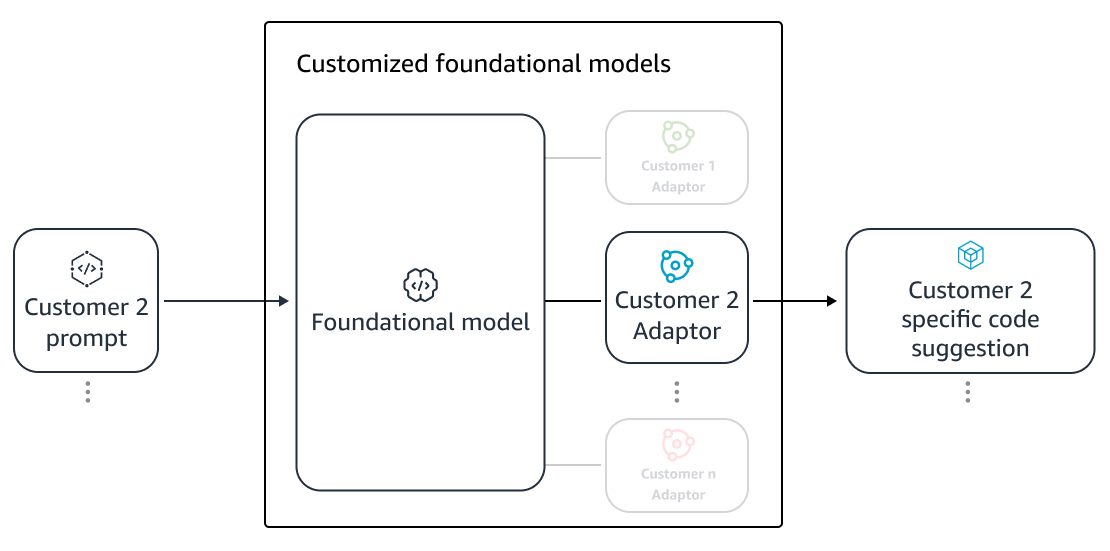

अनुकूलन के निर्माण के लिए एक आधारभूत दृष्टिकोण मौजूदा (सार्वजनिक) प्रीट्रेनिंग डेटासेट के साथ-साथ (निजी) एंटरप्राइज़ कोड से बने एकल प्रशिक्षण कोष पर मॉडल को प्रीट्रेन करना हो सकता है। हालांकि यह दृष्टिकोण व्यवहार में काम करता है, लेकिन इसके लिए प्रत्येक उद्यम के लिए सार्वजनिक डेटासेट का उपयोग करके व्यक्तिगत पूर्व-प्रशिक्षण की आवश्यकता होती है। इसमें प्रत्येक ग्राहक के लिए एक अनुकूलित मॉडल की मेजबानी से जुड़ी अनावश्यक तैनाती लागत की भी आवश्यकता होती है जो केवल उस ग्राहक से आने वाले ग्राहक अनुरोधों को पूरा करता है। सार्वजनिक और निजी कोड के प्रशिक्षण को अलग करके और बहु-किरायेदार प्रणाली पर अनुकूलन को तैनात करके, इन अनावश्यक लागतों से बचा जा सकता है।

कैसे अनुकूलित करें

उच्च स्तर पर, दो प्रकार की संभावित अनुकूलन तकनीकें हैं: पुनर्प्राप्ति-संवर्धित पीढ़ी (आरएजी) और फाइन-ट्यूनिंग (एफटी)।

- पुनर्प्राप्ति-संवर्धित पीढ़ी: RAG एक रिपॉजिटरी के भीतर कोड के मिलान वाले टुकड़े ढूंढता है जो किसी दिए गए कोड टुकड़े के समान होता है (उदाहरण के लिए, कोड जो आईडीई में कर्सर से तुरंत पहले होता है) और इन मिलान किए गए कोड स्निपेट के साथ एलएलएम को क्वेरी करने के लिए उपयोग किए जाने वाले प्रॉम्प्ट को बढ़ाता है। यह मॉडल को अधिक प्रासंगिक कोड उत्पन्न करने में मदद करने के लिए प्रॉम्प्ट को समृद्ध करता है। साहित्य में इसी तर्ज पर कुछ तकनीकों की खोज की गई है। देखना नॉलेज-इंटेंसिव एनएलपी टास्क के लिए रिट्रीवल-ऑगमेंटेड जनरेशन, दायरे, केएनएन-एलएम और रेट्रो.

- फ़ाइन ट्यूनिंग: एफटी एक पूर्व-प्रशिक्षित एलएलएम लेता है और इसे उचित रिपॉजिटरी के लिए अनुकूलित करने के लिए एक विशिष्ट, छोटे कोडबेस (प्रीट्रेनिंग डेटासेट की तुलना में) पर आगे प्रशिक्षित करता है। फ़ाइन-ट्यूनिंग इस प्रशिक्षण के आधार पर एलएलएम के वज़न को समायोजित करती है, जिससे यह संगठन की विशिष्ट आवश्यकताओं के अनुरूप बन जाता है।

एलएलएम-आधारित अनुकूलन के प्रदर्शन को बढ़ाने के लिए आरएजी और फाइन-ट्यूनिंग दोनों शक्तिशाली उपकरण हैं। आरएजी कम प्रशिक्षण जटिलता और लागत के साथ निजी पुस्तकालयों या एपीआई को जल्दी से अनुकूलित कर सकता है। हालाँकि, प्रॉम्प्ट पर पुनर्प्राप्त कोड स्निपेट को खोजने और बढ़ाने से रनटाइम पर विलंबता बढ़ जाती है। इसके बजाय, फाइन-ट्यूनिंग के लिए संदर्भ में किसी भी वृद्धि की आवश्यकता नहीं होती है क्योंकि मॉडल पहले से ही निजी पुस्तकालयों और एपीआई पर प्रशिक्षित है। हालाँकि, इससे मॉडल की सेवा में उच्च प्रशिक्षण लागत और जटिलताएँ पैदा होती हैं, जब कई एंटरप्राइज़ ग्राहकों के लिए कई कस्टम मॉडल का समर्थन करना पड़ता है। जैसा कि हम बाद में चर्चा करेंगे, दृष्टिकोण को और अधिक अनुकूलित करके इन चिंताओं का समाधान किया जा सकता है।

पुनर्प्राप्ति संवर्धित पीढ़ी

RAG में कुछ चरण शामिल हैं:

सूचीकरण

व्यवस्थापक द्वारा इनपुट के रूप में एक निजी भंडार को देखते हुए, स्रोत कोड फ़ाइलों को टुकड़ों में विभाजित करके एक सूचकांक बनाया जाता है। सीधे शब्दों में कहें तो, चंकिंग कोड स्निपेट्स को सुपाच्य टुकड़ों में बदल देती है जो मॉडल के लिए सबसे अधिक जानकारीपूर्ण होने की संभावना है और संदर्भ को देखते हुए पुनर्प्राप्त करना आसान है। एक टुकड़े का आकार और इसे फ़ाइल से कैसे निकाला जाता है, ये डिज़ाइन विकल्प हैं जो अंतिम परिणाम को प्रभावित करते हैं। उदाहरण के लिए, टुकड़ों को कोड की पंक्तियों के आधार पर या वाक्यात्मक ब्लॉकों के आधार पर विभाजित किया जा सकता है, इत्यादि।

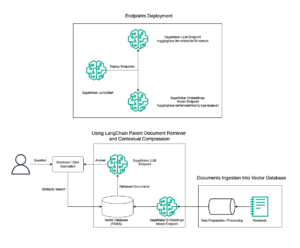

प्रशासक वर्कफ़्लो

प्रासंगिक खोज

कर्सर के ऊपर कोड की कुछ पंक्तियों के आधार पर अनुक्रमित कोड स्निपेट का एक सेट खोजें और प्रासंगिक कोड स्निपेट पुनर्प्राप्त करें। यह पुनर्प्राप्ति विभिन्न एल्गोरिदम का उपयोग करके हो सकती है। इन विकल्पों में शामिल हो सकते हैं:

- शब्दों का थैला (बीएम25) - एक बैग-ऑफ-वर्ड पुनर्प्राप्ति फ़ंक्शन जो क्वेरी शब्द आवृत्तियों और कोड स्निपेट लंबाई के आधार पर कोड स्निपेट के एक सेट को रैंक करता है।

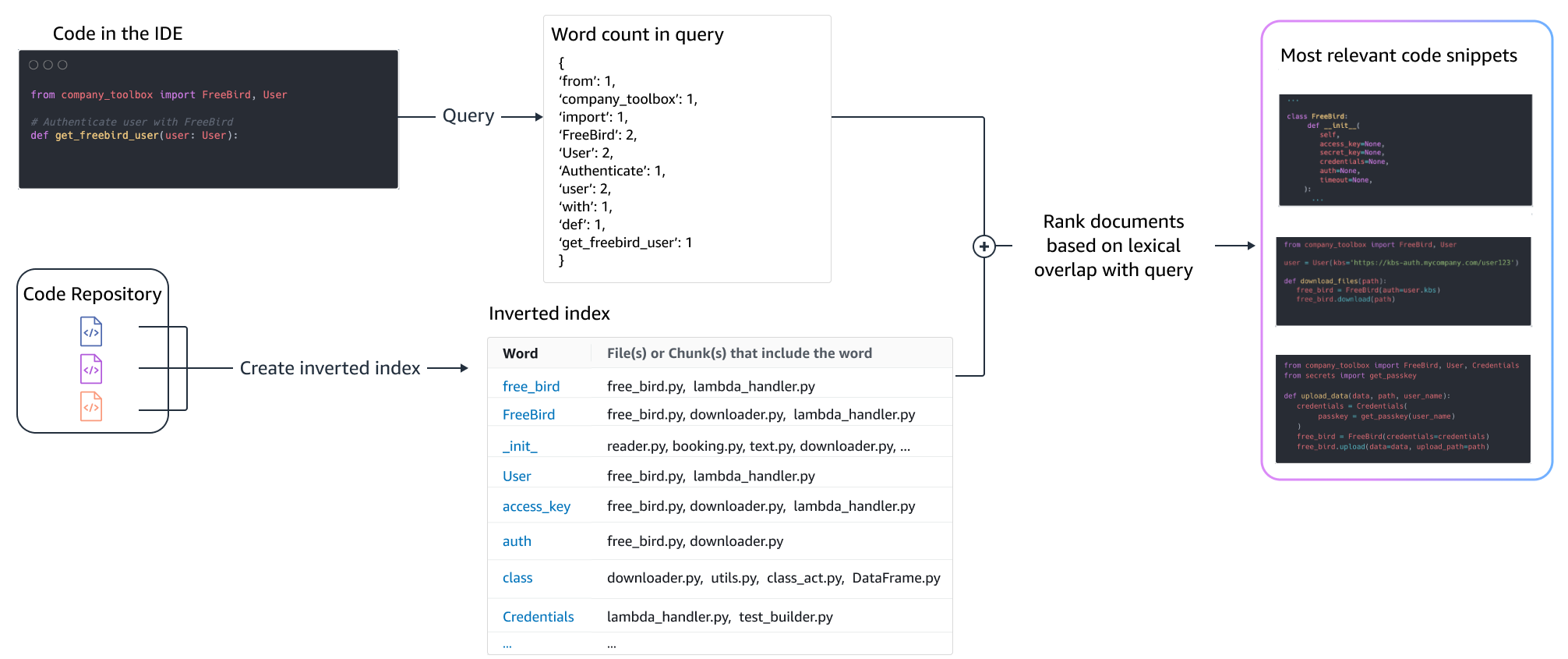

BM25-आधारित पुनर्प्राप्ति

निम्नलिखित चित्र दिखाता है कि BM25 कैसे काम करता है। BM25 का उपयोग करने के लिए, पहले एक उलटा सूचकांक बनाया जाता है। यह एक डेटा संरचना है जो अलग-अलग शब्दों को उन कोड स्निपेट में मैप करती है जिनमें वे शब्द होते हैं। खोज के समय, हम क्वेरी में मौजूद शब्दों के आधार पर कोड स्निपेट देखते हैं और आवृत्ति के आधार पर उन्हें स्कोर करते हैं।

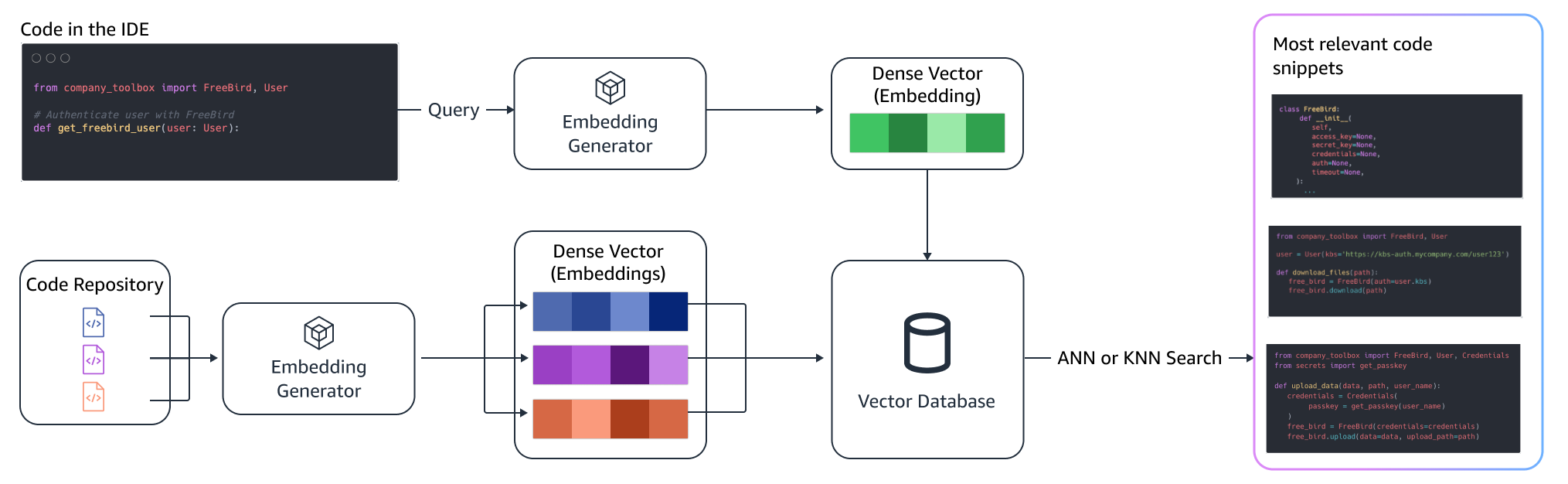

शब्दार्थ पुनर्प्राप्ति

BM25 शाब्दिक मिलान पर केंद्रित है। इसलिए, "ऐड" को "डिलीट" से बदलने से क्वेरी में शर्तों के आधार पर बीएम25 स्कोर नहीं बदल सकता है, लेकिन पुनर्प्राप्त कार्यक्षमता आवश्यक के विपरीत हो सकती है। इसके विपरीत, सिमेंटिक पुनर्प्राप्ति कोड स्निपेट की कार्यक्षमता पर ध्यान केंद्रित करती है, भले ही चर और एपीआई नाम भिन्न हो सकते हैं। आमतौर पर, बेहतर परिणाम देने के लिए BM25 और सिमेंटिक पुनर्प्राप्ति का संयोजन एक साथ अच्छा काम कर सकता है।

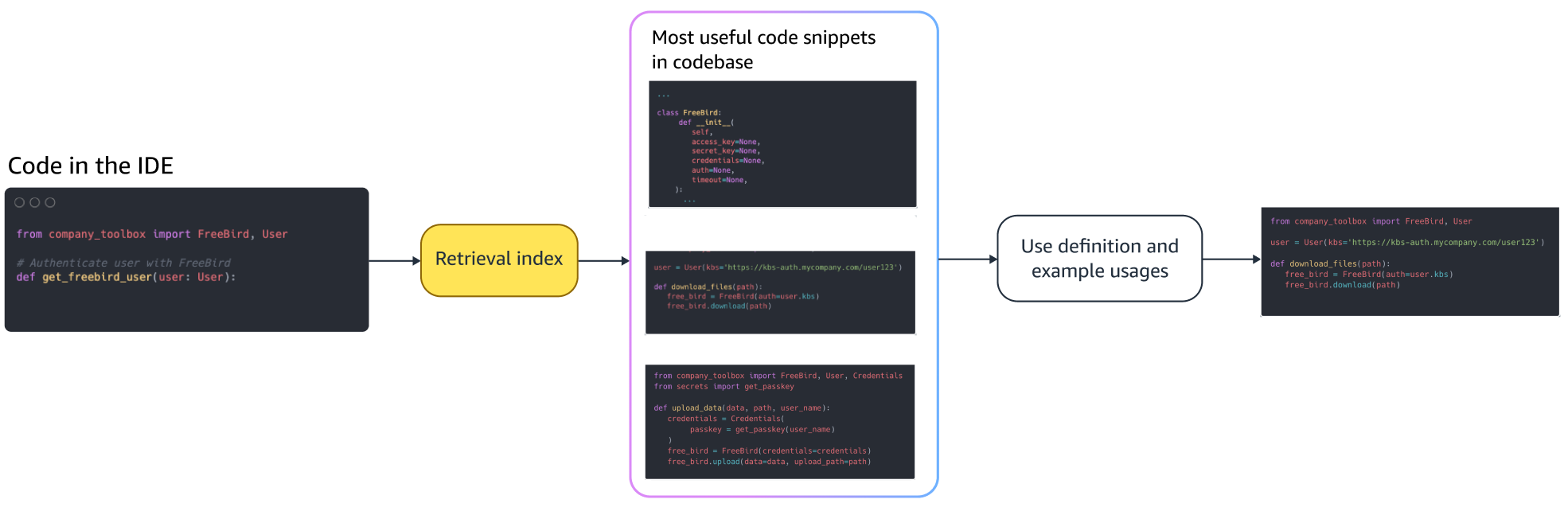

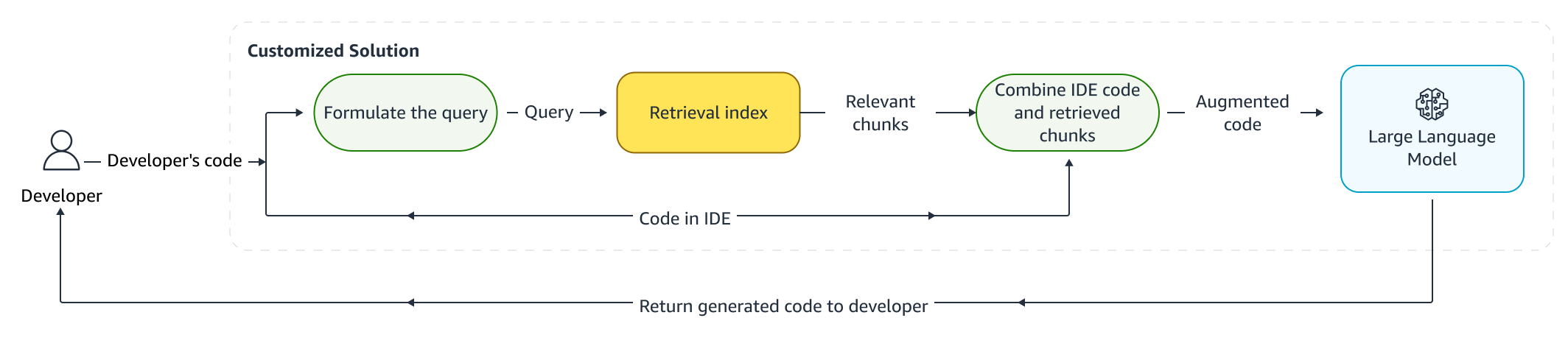

संवर्धित अनुमान

जब डेवलपर्स कोड लिखते हैं, तो उनके मौजूदा प्रोग्राम का उपयोग एक क्वेरी तैयार करने के लिए किया जाता है जिसे पुनर्प्राप्ति सूचकांक में भेजा जाता है। ऊपर चर्चा की गई तकनीकों में से किसी एक का उपयोग करके एकाधिक कोड स्निपेट पुनर्प्राप्त करने के बाद, हम उन्हें मूल प्रॉम्प्ट में जोड़ते हैं। यहां कई डिज़ाइन विकल्प हैं, जिनमें पुनर्प्राप्त किए जाने वाले स्निपेट की संख्या, प्रॉम्प्ट में स्निपेट की सापेक्ष स्थिति और स्निपेट का आकार शामिल है। अंतिम डिज़ाइन विकल्प मुख्य रूप से अंतर्निहित भाषा मॉडल के साथ विभिन्न दृष्टिकोणों की खोज करके अनुभवजन्य अवलोकन द्वारा संचालित होता है और दृष्टिकोण की सटीकता निर्धारित करने में महत्वपूर्ण भूमिका निभाता है। लौटाए गए टुकड़ों की सामग्री और मूल कोड को संयोजित किया जाता है और अनुकूलित कोड सुझाव प्राप्त करने के लिए मॉडल में भेजा जाता है।

डेवलपर वर्कफ़्लो

फ़ाइन ट्यूनिंग:

फ़ाइन ट्यूनिंग के लिए एक भाषा मॉडल तैयार किया गया है सीखने का स्थानांतरण जिसमें पूर्व-प्रशिक्षित मॉडल के वजन को नए डेटा पर प्रशिक्षित किया जाता है। लक्ष्य एक बड़े कोष पर पहले से ही प्रशिक्षित मॉडल से उचित ज्ञान को बनाए रखना और नए कोष से नए ज्ञान को परिष्कृत करना, प्रतिस्थापित करना या जोड़ना है - हमारे मामले में, एक नया कोडबेस। बस एक नए कोडबेस पर प्रशिक्षण की ओर ले जाता है विनाशकारी भूलना. उदाहरण के लिए, भाषा मॉडल हो सकता है सुरक्षा के अपने ज्ञान को "भूल जाओ"। या एपीआई जो आज तक एंटरप्राइज़ कोडबेस में बहुत कम उपयोग किए जाते हैं। जैसे कई प्रकार की तकनीकें हैं दोबारा खेलने का अनुभव करें, मणि, तथा पीपी-टीएफ जो इस चुनौती से निपटने के लिए नियोजित हैं।

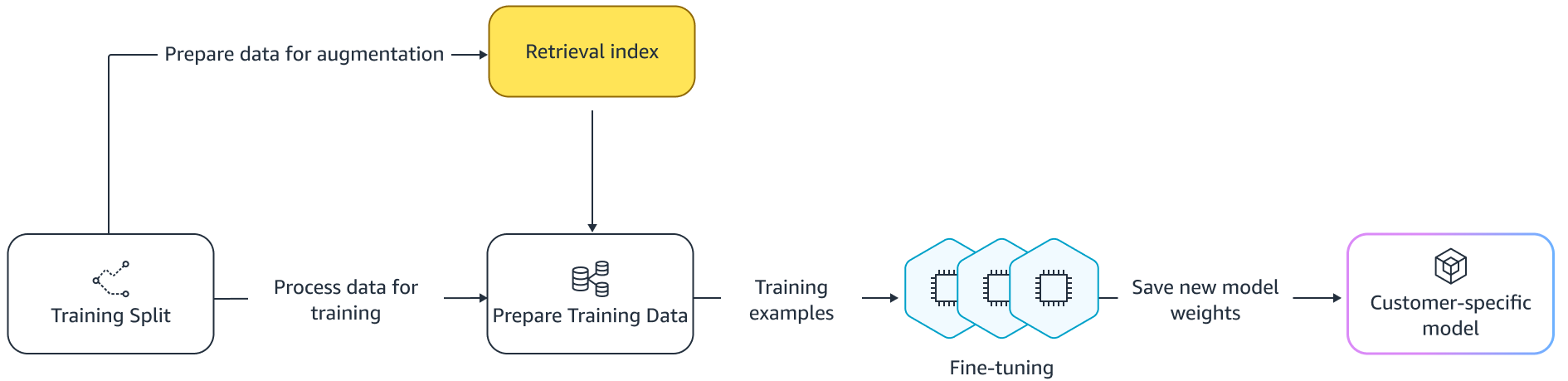

फ़ाइन ट्यूनिंग

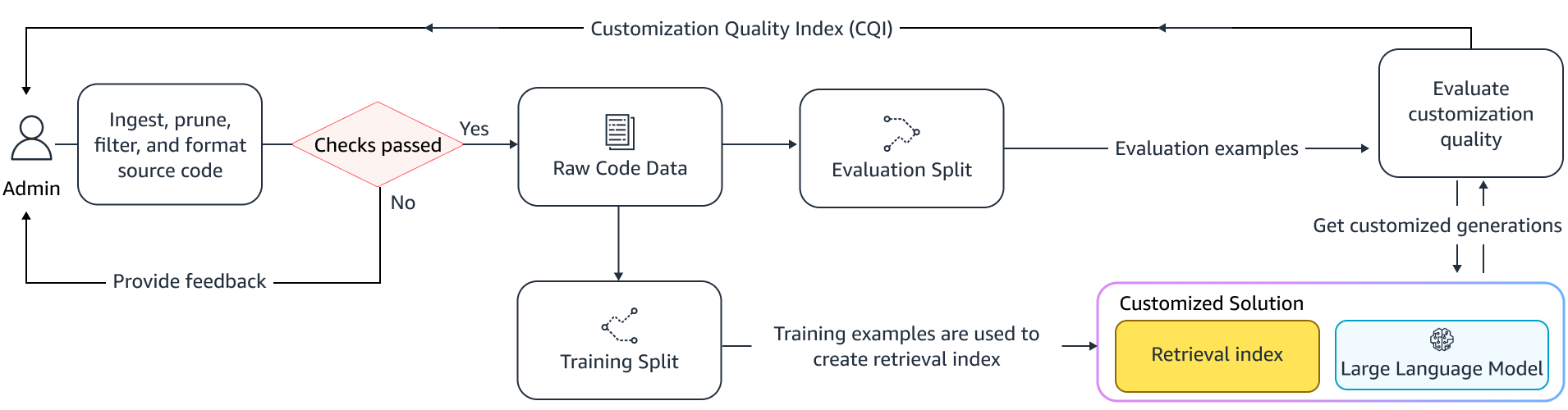

फाइन-ट्यूनिंग के दो तरीके हैं। एक दृष्टिकोण मॉडल को ठीक करने के लिए संकेत को बढ़ाए बिना अतिरिक्त डेटा का उपयोग करना है। एक अन्य तरीका प्रासंगिक कोड सुझावों को पुनः प्राप्त करके फाइन-ट्यूनिंग के दौरान संकेत को बढ़ाना है। यह पुनर्प्राप्त कोड स्निपेट की उपस्थिति में बेहतर सुझाव प्रदान करने की मॉडल की क्षमता को बेहतर बनाने में मदद करता है। प्रशिक्षित होने के बाद मॉडल का मूल्यांकन उदाहरणों के आयोजित सेट पर किया जाता है। इसके बाद, अनुकूलित मॉडल को तैनात किया जाता है और कोड सुझाव उत्पन्न करने के लिए उपयोग किया जाता है।

निजी रिपॉजिटरी पर कोड उत्पन्न करने के लिए समर्पित एलएलएम का उपयोग करने के लाभों के बावजूद, लागत छोटे और मध्यम आकार के संगठनों के लिए निषेधात्मक हो सकती है। ऐसा इसलिए है क्योंकि समर्पित गणना संसाधन आवश्यक हैं, भले ही टीमों के आकार को देखते हुए उनका कम उपयोग किया जा सके। लागत दक्षता हासिल करने का एक तरीका एक ही गणना पर कई मॉडल पेश करना है (उदाहरण के लिए, सेजमेकर मल्टी-टेनेंसी). हालाँकि, भाषा मॉडल को विलंबता और थ्रूपुट बाधाओं को संभालने के लिए कई क्षेत्रों में एक या अधिक समर्पित जीपीयू की आवश्यकता होती है। इसलिए, प्रत्येक जीपीयू पर पूर्ण मॉडल होस्टिंग की बहु-किरायेदारी संभव नहीं है।

हम छोटे का उपयोग करके एक ही कंप्यूटर पर कई ग्राहकों को सेवा प्रदान करके इस समस्या को दूर कर सकते हैं एडेप्टर एलएलएम के लिए. पैरामीटर-कुशल फ़ाइन-ट्यूनिंग (PEFT) तकनीक जैसी शीघ्र ट्यूनिंग, उपसर्ग ट्यूनिंग, और निम्न-रैंक अनुकूलन (लोरा) का उपयोग सटीकता की हानि के बिना प्रशिक्षण लागत कम करने के लिए किया जाता है। LoRA ने, विशेष रूप से, पूर्ण-मॉडल फ़ाइन-ट्यूनिंग की तुलना में समान (या बेहतर) सटीकता प्राप्त करने में बड़ी सफलता देखी है। मूल विचार एक निम्न-रैंक मैट्रिक्स को डिज़ाइन करना है जिसे मॉडल की लक्षित परतों के मूल मैट्रिक्स वजन के साथ मैट्रिक्स में जोड़ा जाता है। आमतौर पर, इन एडाप्टरों को सेवा के लिए मूल मॉडल वज़न के साथ मिला दिया जाता है। इससे मूल तंत्रिका नेटवर्क के समान आकार और वास्तुकला प्राप्त होती है। एडेप्टर को अलग रखते हुए, हम एक ही बेस मॉडल को कई मॉडल एडेप्टर के साथ परोस सकते हैं। यह हमारे छोटे और मध्यम आकार के ग्राहकों के लिए बड़े पैमाने की अर्थव्यवस्थाएं वापस लाता है।

निम्न-रैंक अनुकूलन (LoRA)

अनुकूलन की प्रभावशीलता को मापना

अनुकूलित समाधान की प्रभावकारिता का आकलन करने के लिए हमें मूल्यांकन मेट्रिक्स की आवश्यकता है। ऑफ़लाइन मूल्यांकन मेट्रिक्स शिपिंग अनुकूलन के विरुद्ध रेलिंग के रूप में कार्य करते हैं जो डिफ़ॉल्ट मॉडल की तुलना में निम्न स्तर के होते हैं। प्रदान किए गए भंडार के भीतर से रखे गए डेटासेट से डेटासेट बनाकर, प्रभावशीलता को मापने के लिए इस डेटासेट पर अनुकूलन दृष्टिकोण लागू किया जा सकता है। अनुकूलित कोड सुझाव के साथ मौजूदा स्रोत कोड की तुलना करना अनुकूलन की उपयोगिता को निर्धारित करता है। इस परिमाणीकरण के लिए उपयोग किए जाने वाले सामान्य उपायों में मेट्रिक्स शामिल हैं समानता संपादित करें, सटीक मिलान, और कोडब्लू.

अनुकूलन द्वारा आंतरिक एपीआई को कितनी बार लागू किया जाता है और पहले से मौजूद स्रोत में आह्वान के साथ इसकी तुलना करके उपयोगिता को मापना भी संभव है। बेशक, सफल समापन के लिए दोनों पहलुओं का सही होना महत्वपूर्ण है। हमारे अनुकूलन दृष्टिकोण के लिए, हमने कस्टमाइज़ेशन क्वालिटी इंडेक्स (सीक्यूआई) नामक एक अनुकूलित मीट्रिक डिज़ाइन किया है, जो 1 और 10 के बीच का एक एकल उपयोगकर्ता-अनुकूल माप है। सीक्यूआई मीट्रिक कोड की तुलना में अनुकूलित मॉडल से सुझावों की उपयोगिता दिखाता है एक सामान्य सार्वजनिक मॉडल के साथ सुझाव।

सारांश

हमने इस ब्लॉग पोस्ट में चर्चा की गई प्रमुख तकनीकी तकनीकों के मिश्रण के आधार पर अमेज़ॅन कोडव्हिस्परर अनुकूलन क्षमता का निर्माण किया और पर्सिस्टेंट सिस्टम्स द्वारा आयोजित डेवलपर उत्पादकता पर उपयोगकर्ता अध्ययन के साथ इसका मूल्यांकन किया। AWS द्वारा नियुक्त इन दो अध्ययनों में, डेवलपर्स को जावा में एक मेडिकल सॉफ़्टवेयर एप्लिकेशन बनाने के लिए कहा गया था जिसके लिए उनके आंतरिक पुस्तकालयों के उपयोग की आवश्यकता थी। पहले अध्ययन में, कोडव्हिस्परर तक पहुंच के बिना डेवलपर्स को कार्य पूरा करने में (औसतन) ~8.2 घंटे लगे, जबकि कोडव्हिस्परर (कस्टमाइज़ेशन के बिना) का उपयोग करने वाले डेवलपर्स ने कार्य को (औसतन) ~62 घंटे में 3.1 प्रतिशत तेजी से पूरा किया।

डेवलपर समूहों के एक अलग सेट के साथ दूसरे अध्ययन में, कोडव्हिस्परर का उपयोग करने वाले डेवलपर्स, जिन्हें उनके निजी कोडबेस का उपयोग करके अनुकूलित किया गया था, ने कार्य को औसतन 2.5 घंटे में पूरा किया, उन लोगों की तुलना में 28 प्रतिशत अधिक तेजी से जो बिना अनुकूलन के कोडव्हिस्परर का उपयोग कर रहे थे और ~3.5 में कार्य पूरा किया। औसतन घंटे. हमारा दृढ़ विश्वास है कि कोडव्हिस्परर जैसे टूल जो आपके कोडबेस के लिए अनुकूलित हैं, डेवलपर उत्पादकता को और बढ़ाने में महत्वपूर्ण भूमिका निभाते हैं और इसे चलाने की सलाह देते हैं। अधिक जानकारी के लिए और आरंभ करने के लिए, पर जाएँ अमेज़ॅन कोडव्हिस्परर पेज.

लेखक के बारे में

किंग सन AWS AI लैब्स में एक वरिष्ठ एप्लाइड साइंटिस्ट हैं और AWS CodeWhisperer पर काम करते हैं, जो एक जेनरेटिव AI-पावर्ड कोडिंग असिस्टेंट है। उनकी शोध रुचि प्राकृतिक भाषा प्रसंस्करण, AI4Code और जेनरेटिव AI में है। अतीत में, उन्होंने कई एनएलपी-आधारित सेवाओं जैसे कि कॉम्प्रिहेंड मेडिकल, अमेज़ॅन हेल्थ एआई में एक चिकित्सा निदान प्रणाली और मेटा एआई में मशीन अनुवाद प्रणाली पर काम किया था। उन्होंने 2017 में वर्जीनिया टेक से पीएचडी प्राप्त की।

किंग सन AWS AI लैब्स में एक वरिष्ठ एप्लाइड साइंटिस्ट हैं और AWS CodeWhisperer पर काम करते हैं, जो एक जेनरेटिव AI-पावर्ड कोडिंग असिस्टेंट है। उनकी शोध रुचि प्राकृतिक भाषा प्रसंस्करण, AI4Code और जेनरेटिव AI में है। अतीत में, उन्होंने कई एनएलपी-आधारित सेवाओं जैसे कि कॉम्प्रिहेंड मेडिकल, अमेज़ॅन हेल्थ एआई में एक चिकित्सा निदान प्रणाली और मेटा एआई में मशीन अनुवाद प्रणाली पर काम किया था। उन्होंने 2017 में वर्जीनिया टेक से पीएचडी प्राप्त की।

अराश फ़रहानी अमेज़ॅन कोडव्हिस्परर के साथ एक एप्लाइड साइंटिस्ट हैं। उनकी वर्तमान रुचि जनरेटिव एआई, खोज और वैयक्तिकरण में है। अराश को ऐसे समाधान बनाने का शौक है जो डेवलपर की समस्याओं का समाधान करते हैं। उन्होंने कोडव्हिस्परर के भीतर कई विशेषताओं पर काम किया है, और विभिन्न आंतरिक वर्कस्ट्रीम में एनएलपी समाधान पेश किए हैं जो सभी अमेज़ॅन डेवलपर्स को छूते हैं। उन्होंने 2017 में अर्बाना-शैंपेन में इलिनोइस विश्वविद्यालय से पीएचडी प्राप्त की।

अराश फ़रहानी अमेज़ॅन कोडव्हिस्परर के साथ एक एप्लाइड साइंटिस्ट हैं। उनकी वर्तमान रुचि जनरेटिव एआई, खोज और वैयक्तिकरण में है। अराश को ऐसे समाधान बनाने का शौक है जो डेवलपर की समस्याओं का समाधान करते हैं। उन्होंने कोडव्हिस्परर के भीतर कई विशेषताओं पर काम किया है, और विभिन्न आंतरिक वर्कस्ट्रीम में एनएलपी समाधान पेश किए हैं जो सभी अमेज़ॅन डेवलपर्स को छूते हैं। उन्होंने 2017 में अर्बाना-शैंपेन में इलिनोइस विश्वविद्यालय से पीएचडी प्राप्त की।

ज़ियाओफ़ेई मा AWS AI लैब्स में एप्लाइड साइंस मैनेजर हैं। वह 2016 में SCOT संगठन के भीतर एक एप्लाइड साइंटिस्ट के रूप में अमेज़न में शामिल हुए और फिर बाद में 2018 में AWS AI लैब्स में अमेज़न केंद्र पर काम किया। ज़ियाओफ़ेई केंद्र, कॉन्टैक्ट लेंस और हाल ही में कोडव्हिस्परर और कोडगुरु सुरक्षा सहित कई सेवाओं के लिए विज्ञान प्रबंधक के रूप में कार्यरत रहे हैं। उनकी शोध रुचि AI4Code और प्राकृतिक भाषा प्रसंस्करण के क्षेत्र में है। उन्होंने 2010 में मैरीलैंड विश्वविद्यालय, कॉलेज पार्क से पीएचडी प्राप्त की।

ज़ियाओफ़ेई मा AWS AI लैब्स में एप्लाइड साइंस मैनेजर हैं। वह 2016 में SCOT संगठन के भीतर एक एप्लाइड साइंटिस्ट के रूप में अमेज़न में शामिल हुए और फिर बाद में 2018 में AWS AI लैब्स में अमेज़न केंद्र पर काम किया। ज़ियाओफ़ेई केंद्र, कॉन्टैक्ट लेंस और हाल ही में कोडव्हिस्परर और कोडगुरु सुरक्षा सहित कई सेवाओं के लिए विज्ञान प्रबंधक के रूप में कार्यरत रहे हैं। उनकी शोध रुचि AI4Code और प्राकृतिक भाषा प्रसंस्करण के क्षेत्र में है। उन्होंने 2010 में मैरीलैंड विश्वविद्यालय, कॉलेज पार्क से पीएचडी प्राप्त की।

मुरली कृष्ण रामनाथन एडब्ल्यूएस एआई लैब्स में एक प्रिंसिपल एप्लाइड साइंटिस्ट हैं और एक जेनेरिक एआई-संचालित कोडिंग साथी, एडब्ल्यूएस कोडव्हिस्परर के सह-प्रमुख हैं। उन्हें सॉफ्टवेयर टूल और वर्कफ़्लोज़ बनाने का शौक है जो डेवलपर उत्पादकता को बेहतर बनाने में मदद करते हैं। अतीत में, उन्होंने पिरान्हा का निर्माण किया, जो पुराने फीचर फ़्लैग के कारण कोड को हटाने के लिए एक स्वचालित रीफैक्टरिंग टूल है और उबर इंजीनियरिंग में कोड गुणवत्ता पहल का नेतृत्व किया। वह Google संकाय पुरस्कार (2015), ACM SIGSOFT विशिष्ट पेपर पुरस्कार (ISSTA 2016) और मौरिस हैल्स्टेड पुरस्कार (पर्ड्यू 2006) के प्राप्तकर्ता हैं। उन्होंने 2008 में पर्ड्यू विश्वविद्यालय से कंप्यूटर विज्ञान में पीएचडी प्राप्त की।

मुरली कृष्ण रामनाथन एडब्ल्यूएस एआई लैब्स में एक प्रिंसिपल एप्लाइड साइंटिस्ट हैं और एक जेनेरिक एआई-संचालित कोडिंग साथी, एडब्ल्यूएस कोडव्हिस्परर के सह-प्रमुख हैं। उन्हें सॉफ्टवेयर टूल और वर्कफ़्लोज़ बनाने का शौक है जो डेवलपर उत्पादकता को बेहतर बनाने में मदद करते हैं। अतीत में, उन्होंने पिरान्हा का निर्माण किया, जो पुराने फीचर फ़्लैग के कारण कोड को हटाने के लिए एक स्वचालित रीफैक्टरिंग टूल है और उबर इंजीनियरिंग में कोड गुणवत्ता पहल का नेतृत्व किया। वह Google संकाय पुरस्कार (2015), ACM SIGSOFT विशिष्ट पेपर पुरस्कार (ISSTA 2016) और मौरिस हैल्स्टेड पुरस्कार (पर्ड्यू 2006) के प्राप्तकर्ता हैं। उन्होंने 2008 में पर्ड्यू विश्वविद्यालय से कंप्यूटर विज्ञान में पीएचडी प्राप्त की।

रमेश नल्लापति एडब्ल्यूएस एआई लैब्स में एक वरिष्ठ प्रिंसिपल एप्लाइड साइंटिस्ट हैं और एडब्ल्यूएस में जेनेरिक एआई-पावर्ड कोडिंग कंपेनियन कोडव्हिस्परर और टाइटन लार्ज लैंग्वेज मॉडल्स के सह-नेतृत्व करते हैं। उनकी रुचि मुख्य रूप से प्राकृतिक भाषा प्रसंस्करण और जेनरेटिव एआई के क्षेत्र में है। अतीत में, रमेश ने केंद्र, क्विकसाइट क्यू और कॉन्टैक्ट लेंस जैसे कई एनएलपी-आधारित एडब्ल्यूएस उत्पादों को वितरित करने में विज्ञान नेतृत्व प्रदान किया है। उन्होंने स्टैनफोर्ड, सीएमयू और आईबीएम रिसर्च में अनुसंधान पदों पर कार्य किया और अपनी पीएच.डी. प्राप्त की। 2006 में मैसाचुसेट्स एमहर्स्ट विश्वविद्यालय से कंप्यूटर विज्ञान में।

रमेश नल्लापति एडब्ल्यूएस एआई लैब्स में एक वरिष्ठ प्रिंसिपल एप्लाइड साइंटिस्ट हैं और एडब्ल्यूएस में जेनेरिक एआई-पावर्ड कोडिंग कंपेनियन कोडव्हिस्परर और टाइटन लार्ज लैंग्वेज मॉडल्स के सह-नेतृत्व करते हैं। उनकी रुचि मुख्य रूप से प्राकृतिक भाषा प्रसंस्करण और जेनरेटिव एआई के क्षेत्र में है। अतीत में, रमेश ने केंद्र, क्विकसाइट क्यू और कॉन्टैक्ट लेंस जैसे कई एनएलपी-आधारित एडब्ल्यूएस उत्पादों को वितरित करने में विज्ञान नेतृत्व प्रदान किया है। उन्होंने स्टैनफोर्ड, सीएमयू और आईबीएम रिसर्च में अनुसंधान पदों पर कार्य किया और अपनी पीएच.डी. प्राप्त की। 2006 में मैसाचुसेट्स एमहर्स्ट विश्वविद्यालय से कंप्यूटर विज्ञान में।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/customizing-coding-companions-for-organizations/

- :हैस

- :है

- :नहीं

- $यूपी

- 1

- 10

- 100

- 2006

- 2008

- 2012

- 2015

- 2016

- 2017

- 2018

- 28

- 500

- 7

- a

- क्षमता

- About

- ऊपर

- पहुँच

- शुद्धता

- पाना

- प्राप्त करने

- एसीएम

- के पार

- अधिनियम

- अनुकूलन

- अनुकूलन

- जोड़ना

- जोड़ा

- अतिरिक्त

- पता

- व्यवस्थापक

- फायदे

- को प्रभावित

- बाद

- के खिलाफ

- AI

- एआई मॉडल

- ऐ संचालित

- एल्गोरिदम

- सब

- साथ में

- पहले ही

- भी

- वीरांगना

- अमेज़ॅन कोडव्हिस्पीर

- अमेज़ॅन केंद्र

- अमेज़ॅन वेब सेवा

- an

- और

- अन्य

- कोई

- एपीआई

- एपीआई

- आवेदन

- लागू

- दृष्टिकोण

- दृष्टिकोण

- उपयुक्त

- स्थापत्य

- हैं

- क्षेत्र

- क्षेत्रों के बारे में जानकारी का उपयोग करके ट्रेडिंग कर सकते हैं।

- AS

- पहलुओं

- आकलन

- सहायक

- जुड़े

- At

- बढ़ाना

- संवर्धित

- बढाती

- स्वचालित

- उपलब्धता

- उपलब्ध

- औसत

- से बचने

- बचा

- पुरस्कार

- जागरूकता

- एडब्ल्यूएस

- वापस

- बार

- आधार

- आधारित

- आधारभूत

- बुनियादी

- BE

- क्योंकि

- किया गया

- से पहले

- मानना

- लाभ

- बेहतर

- के बीच

- ब्लॉक

- ब्लॉग

- बढ़ाने

- के छात्रों

- लाता है

- कीड़े

- इमारत

- बनाया गया

- लेकिन

- by

- कर सकते हैं

- क्षमता

- सावधानी से

- मामला

- चुनौती

- चुनौतियों

- परिवर्तन

- चुनाव

- विकल्प

- ग्राहक

- कोड

- codebase

- कोडन

- कॉलेज

- संयोजन

- संयुक्त

- प्रतिबद्ध

- सामान्य

- सामान्यतः

- साथी

- साथी

- तुलना

- की तुलना

- पूरा

- पूरा

- समापन

- जटिलताओं

- जटिलता

- प्रकृतिस्थ

- समझना

- गणना करना

- कंप्यूटर

- कम्प्यूटर साइंस

- चिंताओं

- संचालित

- इसके फलस्वरूप

- की कमी

- संपर्क करें

- अंतर्वस्तु

- प्रसंग

- लगातार

- इसके विपरीत

- सम्मेलनों

- लागत

- लागत बचत

- लागत

- सका

- कोर्स

- बनाना

- बनाया

- वर्तमान

- रिवाज

- ग्राहक

- ग्राहक

- अनुकूलन

- अनुकूलित

- तिथि

- डेटा संरचना

- डेटासेट

- तारीख

- समर्पित

- चूक

- उद्धार

- पहुंचाने

- तैनात

- तैनाती

- तैनाती

- पदावनत

- डिज़ाइन

- बनाया गया

- निर्धारित करने

- विकसित

- डेवलपर

- डेवलपर्स

- विकासशील

- विकास

- निदान

- विभिन्न

- सुपाच्य

- चर्चा करना

- चर्चा की

- विशिष्ट

- दस्तावेज़ीकरण

- कर देता है

- किया

- संचालित

- दो

- दौरान

- से प्रत्येक

- आसान

- अर्थव्यवस्थाओं

- पैमाने की अर्थव्यवस्थाएं

- प्रभावशीलता

- प्रभावोत्पादकता

- दक्षता

- embedding

- कार्यरत

- सक्षम

- सक्षम बनाता है

- अभियांत्रिकी

- बढ़ाने

- उद्यम

- उपक्रम सॉफ्टवेयर

- उद्यम

- विशेष रूप से

- मूल्यांकित

- मूल्यांकन

- और भी

- उद्विकासी

- जांच

- उदाहरण

- उदाहरण

- मौजूदा

- महंगा

- अनुभव

- पता लगाया

- तलाश

- और तेज

- Feature

- विशेषताएं

- कुछ

- कम

- आकृति

- पट्टिका

- फ़ाइलें

- अंतिम

- अंत में

- पाता

- प्रथम

- तय

- झंडे

- केंद्रित

- का पालन करें

- निम्नलिखित

- के लिए

- ताकतों

- आवृत्ति

- से

- FT

- पूर्ण

- समारोह

- कार्यक्षमता

- आगे

- और भी

- अन्तर

- उत्पन्न

- उत्पन्न

- सृजन

- पीढ़ी

- उत्पादक

- जनरेटिव एआई

- मिल

- मिल रहा

- दी

- देते

- लक्ष्य

- गूगल

- GPU

- GPUs

- महान

- था

- हाथ

- संभालना

- होना

- है

- होने

- he

- स्वास्थ्य

- धारित

- मदद

- मदद करता है

- इसलिये

- उसे

- यहाँ उत्पन्न करें

- हाई

- उच्चतर

- उसके

- इतिहास

- होस्टिंग

- घंटे

- कैसे

- तथापि

- एचटीएमएल

- HTTPS

- आईबीएम

- विचार

- इलेनॉइस

- दिखाता है

- तुरंत

- कार्यान्वयन

- महत्वपूर्ण

- में सुधार

- in

- शामिल

- सहित

- वृद्धि हुई

- बढ़ जाती है

- अनुक्रमणिका

- अनुक्रमित

- व्यक्ति

- व्यक्तिगत रूप से

- करें-

- जानकारीपूर्ण

- इंफ्रास्ट्रक्चर

- पहल

- निवेश

- बजाय

- दिलचस्प

- रुचियों

- आंतरिक

- में

- शुरू की

- शुरू करने

- लागू

- शामिल

- IT

- आईटी इस

- जावा

- में शामिल हो गए

- रखना

- कुंजी

- ज्ञान

- जानने वाला

- लैब्स

- भाषा

- बड़ा

- विलंब

- बाद में

- परतों

- नेतृत्व

- प्रमुख

- बिक्रीसूत्र

- नेतृत्व

- स्तर

- पुस्तकालयों

- झूठ

- पसंद

- संभावना

- संभावित

- पंक्तियां

- सूची

- साहित्य

- एलएलएम

- देखिए

- बंद

- कम

- मशीन

- मुख्यतः

- निर्माण

- प्रबंधक

- गाइड

- बहुत

- मैप्स

- मेरीलैंड

- मेसाचुसेट्स

- मैच

- मिलान किया

- मिलान

- मैट्रिक्स

- मई..

- माप

- उपायों

- मेडिकल

- की बैठक

- मेटा

- मीट्रिक

- मेट्रिक्स

- हो सकता है

- कम से कम

- मिश्रण

- आदर्श

- मॉडल

- अधिक

- अधिकांश

- अधिकतर

- विभिन्न

- नामों

- प्राकृतिक

- प्राकृतिक भाषा संसाधन

- आवश्यक

- जरूरी

- आवश्यकता

- की जरूरत है

- नेटवर्क

- तंत्रिका

- तंत्रिका नेटवर्क

- नया

- NLP

- संख्या

- अवलोकन

- of

- ऑफ़लाइन

- अक्सर

- on

- ONE

- केवल

- विपरीत

- के अनुकूलन के

- or

- आदेश

- संगठन

- संगठनात्मक

- संगठनों

- मूल

- मूल

- अन्य

- हमारी

- आउट

- काबू

- दर्द

- काग़ज़

- पार्क

- आवेशपूर्ण

- अतीत

- पैटर्न उपयोग करें

- पीडीएफ

- प्रतिशत

- प्रदर्शन

- निजीकरण

- पीएचडी

- टुकड़े

- प्लेसमेंट

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- प्ले

- निभाता

- अंक

- पदों

- संभव

- पद

- शक्तिशाली

- अभ्यास

- प्रथाओं

- उपस्थिति

- वर्तमान

- पहले से

- मुख्यत

- प्रिंसिपल

- निजी

- मुसीबत

- समस्याओं

- प्रसंस्करण

- उत्पादकता

- उत्पाद

- कार्यक्रम

- मालिकाना

- प्रदान करना

- बशर्ते

- सार्वजनिक

- सार्वजनिक रूप से

- रखना

- गुणवत्ता

- मात्रा का ठहराव

- परिमाणित करता है

- जल्दी से

- लेकर

- रैंक

- महसूस करना

- प्राप्त

- हाल ही में

- की सिफारिश

- सिफारिशें

- को कम करने

- संदर्भ

- को परिष्कृत

- सापेक्ष

- प्रासंगिक

- की जगह

- कोष

- अनुरोधों

- की आवश्यकता होती है

- अपेक्षित

- की आवश्यकता होती है

- अनुसंधान

- संकल्प

- उपयुक्त संसाधन चुनें

- परिणाम

- परिणाम

- बनाए रखने के

- समीक्षा

- समीक्षा

- पुनर्लेखन

- सही

- भूमिका

- रन

- वही

- सहेजें

- बचत

- स्केल

- विज्ञान

- वैज्ञानिक

- स्कोर

- टैक्स

- Search

- खोज

- दूसरा

- सुरक्षा

- देखना

- देखा

- का चयन

- चयन

- वरिष्ठ

- भेजा

- अलग

- सेवा

- कार्य करता है

- सेवाएँ

- सेवारत

- सेट

- कई

- वह

- शिपिंग

- चाहिए

- दिखाना

- दिखाता है

- समान

- केवल

- एक साथ

- एक

- आकार

- छोटा

- छोटे

- टुकड़ा

- So

- सॉफ्टवेयर

- सॉफ्टवेयर विकास

- समाधान

- समाधान ढूंढे

- स्रोत

- स्रोत कोड

- विशिष्ट

- बिताना

- विभाजित

- स्टैनफोर्ड

- शुरू

- कदम

- दृढ़ता से

- संरचना

- पढ़ाई

- अध्ययन

- अंदाज

- इसके बाद

- सफलता

- सफल

- ऐसा

- समर्थित

- सतह

- प्रणाली

- सिस्टम

- दर्जी

- अनुरूप

- लेता है

- लक्षित

- कार्य

- टीमों

- तकनीक

- तकनीकी

- तकनीक

- अवधि

- शर्तों

- टेक्स्ट

- से

- कि

- RSI

- क्षेत्र

- स्रोत

- लेकिन हाल ही

- उन

- फिर

- वहाँ।

- जिसके चलते

- इसलिये

- इन

- वे

- इसका

- उन

- हालांकि?

- THROUGHPUT

- पहर

- टाइटन

- सेवा मेरे

- एक साथ

- टोकन

- ले गया

- साधन

- उपकरण

- ऊपर का

- स्पर्श

- प्रशिक्षित

- प्रशिक्षण

- गाड़ियों

- अनुवाद करें

- ट्यूनिंग

- बदल जाता है

- दो

- प्रकार

- आम तौर पर

- Uber

- साथ इसमें

- आधारभूत

- अद्वितीय

- विश्वविद्यालय

- प्रयोग

- उपयोग

- प्रयुक्त

- उपयोगकर्ता

- उपयोगकर्ता के अनुकूल

- का उपयोग

- परिवर्तनशील

- विविधता

- विभिन्न

- वर्जीनिया

- भेंट

- कमजोरियों

- मार्ग..

- तरीके

- we

- वेब

- वेब सेवाओं

- भार

- कुंआ

- थे

- क्या

- एचएमबी क्या है?

- कब

- कौन कौन से

- जब

- कौन

- क्यों

- साथ में

- अंदर

- बिना

- शब्द

- काम

- काम किया

- workflows

- काम कर रहे

- कार्य

- लिखना

- कोड लिखें

- लिखा हुआ

- आप

- आपका

- जेफिरनेट

- क्षेत्र