आज, हम मेटा का उपयोग करके लामा 2 मॉडलों को फाइन-ट्यून करने की क्षमता की घोषणा करते हुए उत्साहित हैं अमेज़न SageMaker जम्पस्टार्ट. बड़े भाषा मॉडल (एलएलएम) का लामा 2 परिवार 7 अरब से 70 अरब मापदंडों के पैमाने पर पूर्व-प्रशिक्षित और ठीक-ठीक जेनरेटिव टेक्स्ट मॉडल का एक संग्रह है। फाइन-ट्यून किए गए एलएलएम, जिन्हें लामा-2-चैट कहा जाता है, संवाद उपयोग के मामलों के लिए अनुकूलित हैं। आप इन मॉडलों को आसानी से आज़मा सकते हैं और सेजमेकर जंपस्टार्ट के साथ उनका उपयोग कर सकते हैं, जो एक मशीन लर्निंग (एमएल) हब है जो एल्गोरिदम, मॉडल और एमएल समाधान तक पहुंच प्रदान करता है ताकि आप जल्दी से एमएल के साथ शुरुआत कर सकें। अब आप सेजमेकर जम्पस्टार्ट पर 7 बिलियन, 13 बिलियन और 70 बिलियन पैरामीटर लामा 2 टेक्स्ट जेनरेशन मॉडल को फाइन-ट्यून भी कर सकते हैं। अमेज़ॅन सैजमेकर स्टूडियो कुछ क्लिक के साथ या सेजमेकर पायथन एसडीके का उपयोग करके यूआई।

जेनेरेटिव एआई फाउंडेशन मॉडल पिछले एक साल से अधिक समय से अधिकांश एमएल और कृत्रिम बुद्धिमत्ता अनुसंधान और उपयोग के मामलों पर ध्यान केंद्रित कर रहे हैं। ये फाउंडेशन मॉडल अपने बड़े आकार के कारण और कई बड़े डेटासेट और सैकड़ों कार्यों पर प्रशिक्षित होने के कारण, टेक्स्ट जेनरेशन, सारांशीकरण, प्रश्न उत्तर, छवि और वीडियो जेनरेशन और अन्य जैसे जेनेरिक कार्यों के साथ बहुत अच्छा प्रदर्शन करते हैं। इन मॉडलों की महान सामान्यीकरण क्षमताओं के बावजूद, अक्सर ऐसे उपयोग के मामले होते हैं जिनमें बहुत विशिष्ट डोमेन डेटा (जैसे स्वास्थ्य देखभाल या वित्तीय सेवाएं) होते हैं, जिसके कारण ये मॉडल इन उपयोग मामलों के लिए अच्छे परिणाम प्रदान करने में सक्षम नहीं हो सकते हैं। इसके परिणामस्वरूप उपयोग के मामले-विशिष्ट और डोमेन-विशिष्ट डेटा पर इन जेनरेटिव एआई मॉडल को और बेहतर बनाने की आवश्यकता है।

इस पोस्ट में, हम सेजमेकर जम्पस्टार्ट के माध्यम से लामा 2 पूर्व-प्रशिक्षित टेक्स्ट जेनरेशन मॉडल को फाइन-ट्यून करने के तरीके के बारे में जानेंगे।

लामा 2 क्या है?

लामा 2 एक ऑटो-रिग्रेसिव भाषा मॉडल है जो एक अनुकूलित ट्रांसफार्मर आर्किटेक्चर का उपयोग करता है। लामा 2 अंग्रेजी में व्यावसायिक और अनुसंधान उपयोग के लिए है। यह पैरामीटर आकारों की श्रेणी में आता है - 7 अरब, 13 अरब, और 70 अरब - साथ ही पूर्व-प्रशिक्षित और सुव्यवस्थित विविधताएं। मेटा के अनुसार, ट्यून किए गए संस्करण सहायता और सुरक्षा के लिए मानवीय प्राथमिकताओं को संरेखित करने के लिए पर्यवेक्षित फाइन-ट्यूनिंग (एसएफटी) और मानव प्रतिक्रिया (आरएलएचएफ) के साथ सुदृढीकरण सीखने का उपयोग करते हैं। लामा 2 को सार्वजनिक रूप से उपलब्ध स्रोतों से 2 ट्रिलियन टोकन डेटा पर पूर्व-प्रशिक्षित किया गया था। ट्यून किए गए मॉडल सहायक-जैसी चैट के लिए अभिप्रेत हैं, जबकि पूर्व-प्रशिक्षित मॉडल को विभिन्न प्राकृतिक भाषा निर्माण कार्यों के लिए अनुकूलित किया जा सकता है। इस बात पर ध्यान दिए बिना कि डेवलपर मॉडल के किस संस्करण का उपयोग करता है मेटा से जिम्मेदार उपयोग मार्गदर्शिका अतिरिक्त फ़ाइन-ट्यूनिंग का मार्गदर्शन करने में सहायता कर सकता है जो उचित सुरक्षा शमन के साथ मॉडलों को अनुकूलित और अनुकूलित करने के लिए आवश्यक हो सकता है।

वर्तमान में, लामा 2 निम्नलिखित क्षेत्रों में उपलब्ध है:

- उपलब्ध पूर्व-प्रशिक्षित मॉडल तैनात करें:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - फाइन-ट्यून करें और फाइन-ट्यून किए गए मॉडल को तैनात करें:

“us-east-1”,“us-west-2”,“eu-west-1”

सेजमेकर जम्पस्टार्ट क्या है?

सेजमेकर जम्पस्टार्ट के साथ, एमएल व्यवसायी सार्वजनिक रूप से उपलब्ध फाउंडेशन मॉडल के व्यापक चयन में से चुन सकते हैं। एमएल प्रैक्टिशनर फाउंडेशन मॉडल को समर्पित करने के लिए तैनात कर सकते हैं अमेज़न SageMaker नेटवर्क पृथक वातावरण से उदाहरण और मॉडल प्रशिक्षण और तैनाती के लिए सेजमेकर का उपयोग करके मॉडल को अनुकूलित करें। अब आप सेजमेकर स्टूडियो में कुछ क्लिक के साथ या सेजमेकर पायथन एसडीके के माध्यम से प्रोग्रामेटिक रूप से लामा 2 को खोज और तैनात कर सकते हैं, जिससे आप सेजमेकर सुविधाओं के साथ मॉडल प्रदर्शन और एमएलओपीएस नियंत्रण प्राप्त कर सकते हैं। अमेज़न SageMaker पाइपलाइन, अमेज़न SageMaker डिबगर, या कंटेनर लॉग। मॉडल को AWS सुरक्षित वातावरण में और आपके VPC नियंत्रण में तैनात किया गया है, जिससे डेटा सुरक्षा सुनिश्चित करने में मदद मिलती है। इसके अलावा, आप SageMaker जम्पस्टार्ट के माध्यम से Llama2 7B, 13B और 70B पूर्व-प्रशिक्षित टेक्स्ट जेनरेशन मॉडल को फाइन-ट्यून कर सकते हैं।

Llama2 मॉडल को फाइन-ट्यून करें

आप सेजमेकर स्टूडियो यूआई या सेजमेकर पायथन एसडीके का उपयोग करके मॉडल को फाइन-ट्यून कर सकते हैं। हम इस अनुभाग में दोनों विधियों पर चर्चा करते हैं।

सेजमेकर स्टूडियो यूआई के माध्यम से नो-कोड फाइन-ट्यूनिंग

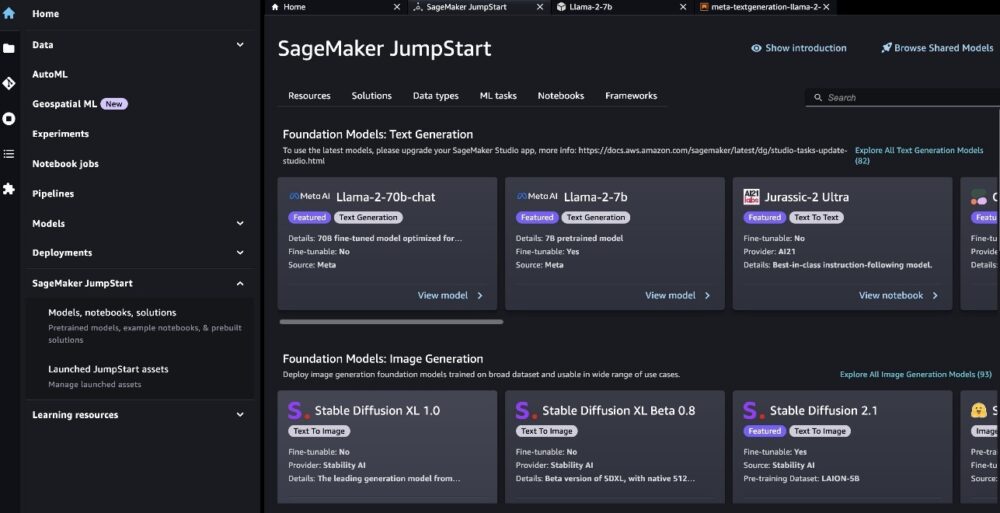

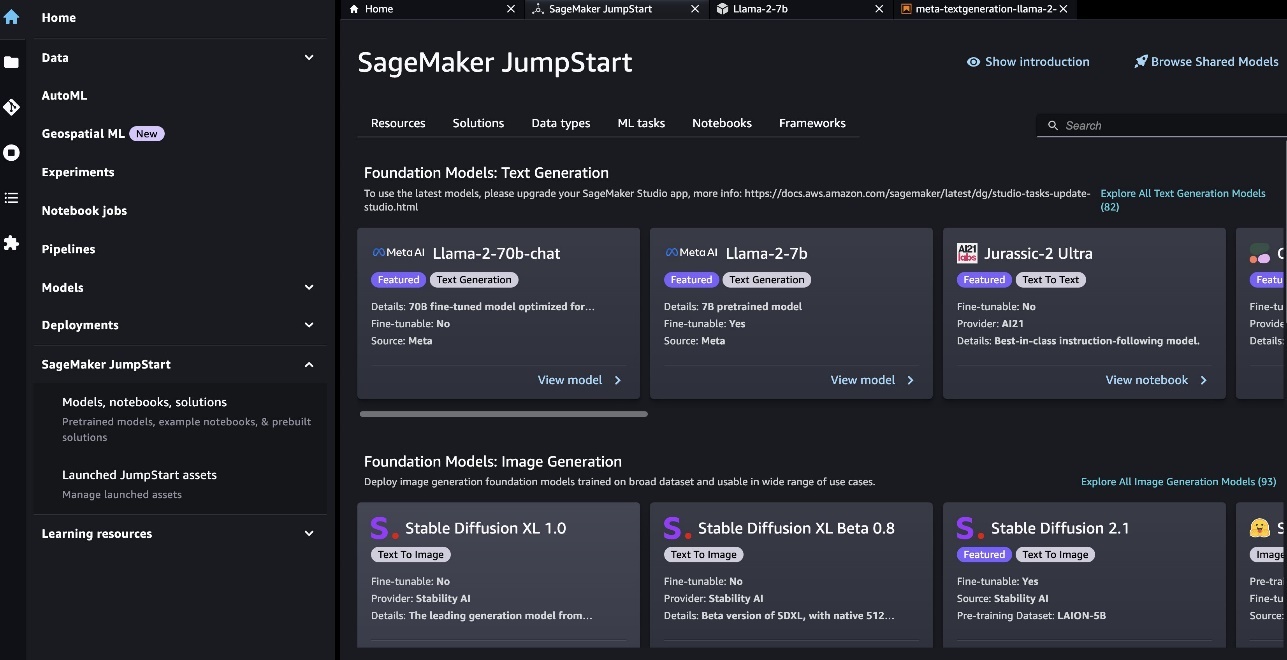

सेजमेकर स्टूडियो में, आप सेजमेकर जम्पस्टार्ट के माध्यम से लामा 2 मॉडल तक पहुंच सकते हैं मॉडल, नोटबुक और समाधान, जैसा कि निम्नलिखित स्क्रीनशॉट में दिखाया गया है।

यदि आपको लामा 2 मॉडल दिखाई नहीं देते हैं, तो बंद करके और पुनः आरंभ करके अपने सेजमेकर स्टूडियो संस्करण को अपडेट करें। संस्करण अपडेट के बारे में अधिक जानकारी के लिए देखें स्टूडियो ऐप्स बंद करें और अपडेट करें.

आप चुनकर अन्य चार मॉडल वेरिएंट भी पा सकते हैं सभी टेक्स्ट जेनरेशन मॉडल का अन्वेषण करें या खोज बॉक्स में लामा खोज रहे हैं।

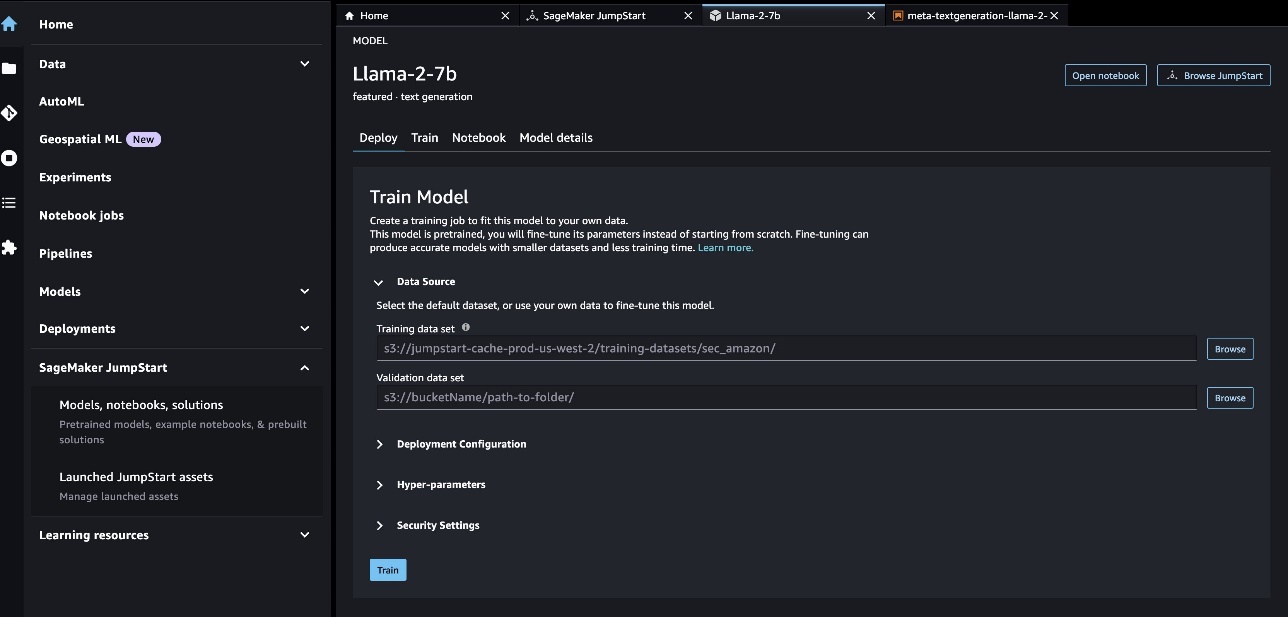

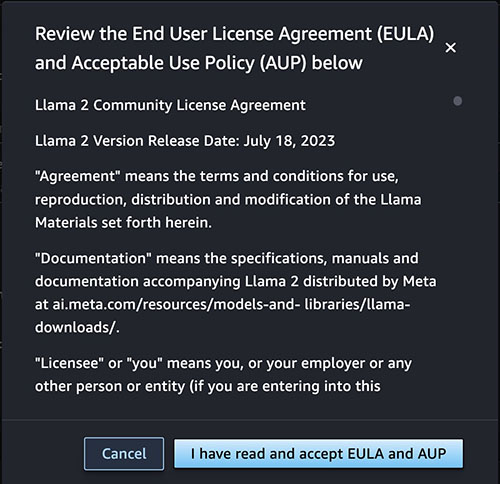

इस पृष्ठ पर, आप इंगित कर सकते हैं अमेज़न सरल भंडारण सेवा (अमेज़ॅन S3) बकेट जिसमें फ़ाइन-ट्यूनिंग के लिए प्रशिक्षण और सत्यापन डेटासेट शामिल हैं। इसके अलावा, आप फ़ाइन-ट्यूनिंग के लिए परिनियोजन कॉन्फ़िगरेशन, हाइपरपैरामीटर और सुरक्षा सेटिंग्स कॉन्फ़िगर कर सकते हैं। फिर आप चुन सकते हैं रेलगाड़ी सेजमेकर एमएल इंस्टेंस पर प्रशिक्षण कार्य शुरू करने के लिए। पिछला स्क्रीनशॉट लामा-2 7बी मॉडल के लिए फ़ाइन-ट्यूनिंग पृष्ठ दिखाता है; हालाँकि, आप 13बी और 70बी लामा 2 टेक्स्ट जेनरेशन मॉडल को उनके संबंधित मॉडल पेजों का उपयोग करके ठीक-ठीक ट्यून कर सकते हैं। लामा 2 मॉडल का उपयोग करने के लिए, आपको अंतिम उपयोगकर्ता लाइसेंस अनुबंध (ईयूएलए) को स्वीकार करना होगा। जब आप चुनेंगे तो यह दिखाई देगा रेलगाड़ी, जैसा कि निम्नलिखित स्क्रीनशॉट में दिखाया गया है। चुनना मैंने EULA और AUP को पढ़ लिया है और स्वीकार कर लिया है फाइन-ट्यूनिंग कार्य शुरू करने के लिए।

मॉडल तैनात करें

मॉडल को ठीक करने के बाद, आप इसे सेजमेकर जम्पस्टार्ट पर मॉडल पेज का उपयोग करके तैनात कर सकते हैं। फाइन-ट्यून किए गए मॉडल को तैनात करने का विकल्प फाइन-ट्यूनिंग समाप्त होने पर दिखाई देगा, जैसा कि निम्नलिखित स्क्रीनशॉट में दिखाया गया है।

सेजमेकर पायथन एसडीके के माध्यम से फाइन-ट्यून करें

आप सेजमेकर पायथन एसडीके का उपयोग करके लामा 2 मॉडल को भी फाइन-ट्यून कर सकते हैं। आपके डेटासेट पर लामा 2 7बी को फाइन-ट्यून करने के लिए एक नमूना कोड निम्नलिखित है:

आप अनुमानक से सीधे सुव्यवस्थित मॉडल को तैनात कर सकते हैं:

आप इसमें कोड भी पा सकते हैं सेजमेकर जम्पस्टार्ट पर LLaMA 2 मॉडल को फाइन-ट्यून करें. इसमें डेटासेट तैयार करना, आपके कस्टम डेटासेट पर प्रशिक्षण और फाइन-ट्यून मॉडल को तैनात करना शामिल है। यह सारांश कार्य के उदाहरणों के साथ डॉली डेटासेट के सबसेट पर फ़ाइन-ट्यूनिंग प्रदर्शित करता है। ज़मीनी सच्चाई की प्रतिक्रिया के साथ-साथ सुव्यवस्थित और गैर-सुशिक्षित लोगों की प्रतिक्रियाओं के साथ उदाहरण इनपुट निम्नलिखित है:

मॉडल में इनपुट:

जमीनी सच्चाई प्रतिक्रिया:

गैर सुव्यवस्थित मॉडल से प्रतिक्रिया:

सुव्यवस्थित मॉडल से प्रतिक्रिया:

डॉली और डायलॉग्सम डेटासेट पर विभिन्न मॉडलों के प्रदर्शन बेंचमार्किंग के लिए, देखें प्रदर्शन बेंचमार्किंग इस पोस्ट के अंत में परिशिष्ट में अनुभाग।

फाइन-ट्यूनिंग तकनीक

लामा जैसे भाषा मॉडल का आकार 10 जीबी या 100 जीबी से भी अधिक है। ऐसे बड़े मॉडलों को फाइन-ट्यूनिंग करने के लिए काफी उच्च CUDA मेमोरी वाले इंस्टेंस की आवश्यकता होती है। इसके अलावा, मॉडल के आकार के कारण इन मॉडलों का प्रशिक्षण बहुत धीमा हो सकता है। इसलिए, कुशल फ़ाइन-ट्यूनिंग के लिए, हम निम्नलिखित अनुकूलन का उपयोग करते हैं:

- निम्न-रैंक अनुकूलन (LoRA) - यह बड़े मॉडलों की कुशल फाइन-ट्यूनिंग के लिए एक प्रकार का पैरामीटर कुशल फाइन-ट्यूनिंग (पीईएफटी) है। इसमें, हम पूरे मॉडल को फ्रीज कर देते हैं और मॉडल में केवल समायोज्य पैरामीटर या परतों का एक छोटा सेट जोड़ते हैं। उदाहरण के लिए, लामा 7 2बी के लिए सभी 7 अरब मापदंडों को प्रशिक्षित करने के बजाय, हम 1% से भी कम मापदंडों को ठीक कर सकते हैं। यह मेमोरी आवश्यकता को महत्वपूर्ण रूप से कम करने में मदद करता है क्योंकि हमें केवल 1% मापदंडों के लिए ग्रेडिएंट्स, ऑप्टिमाइज़र स्टेट्स और अन्य प्रशिक्षण-संबंधित जानकारी संग्रहीत करने की आवश्यकता होती है। इसके अलावा, इससे प्रशिक्षण के समय के साथ-साथ लागत भी कम करने में मदद मिलती है। इस विधि के बारे में अधिक जानकारी के लिए देखें लोरा: बड़े भाषा मॉडल का निम्न-रैंक अनुकूलन.

- Int8 परिमाणीकरण - LoRA जैसे अनुकूलन के साथ भी, Llama 70B जैसे मॉडल अभी भी प्रशिक्षित करने के लिए बहुत बड़े हैं। प्रशिक्षण के दौरान मेमोरी फ़ुटप्रिंट को कम करने के लिए, हम प्रशिक्षण के दौरान Int8 परिमाणीकरण का उपयोग कर सकते हैं। परिमाणीकरण आम तौर पर फ़्लोटिंग पॉइंट डेटा प्रकारों की सटीकता को कम कर देता है। हालाँकि इससे मॉडल भार को संग्रहीत करने के लिए आवश्यक मेमोरी कम हो जाती है, लेकिन यह जानकारी के नुकसान के कारण प्रदर्शन को ख़राब कर देता है। Int8 परिमाणीकरण केवल एक चौथाई परिशुद्धता का उपयोग करता है लेकिन प्रदर्शन में गिरावट नहीं लाता है क्योंकि यह केवल बिट्स को नहीं गिराता है। यह डेटा को एक प्रकार से दूसरे प्रकार में राउंड करता है। Int8 परिमाणीकरण के बारे में जानने के लिए, देखें LLM.int8(): स्केल पर ट्रांसफार्मर के लिए 8-बिट मैट्रिक्स गुणन.

- पूरी तरह से साझा डेटा समानांतर (एफएसडीपी) - यह एक प्रकार का डेटा-समानांतर प्रशिक्षण एल्गोरिदम है जो डेटा समानांतर श्रमिकों में मॉडल के मापदंडों को विभाजित करता है और वैकल्पिक रूप से प्रशिक्षण गणना के हिस्से को सीपीयू में लोड कर सकता है। हालाँकि पैरामीटर अलग-अलग GPU में विभाजित हैं, प्रत्येक माइक्रोबैच की गणना GPU कार्यकर्ता के लिए स्थानीय है। यह मापदंडों को अधिक समान रूप से विभाजित करता है और प्रशिक्षण के दौरान संचार और गणना ओवरलैपिंग के माध्यम से अनुकूलित प्रदर्शन प्राप्त करता है।

निम्न तालिका तीन लामा 2 मॉडल के साथ विभिन्न तरीकों की तुलना करती है।

| , | डिफ़ॉल्ट इंस्टेंस प्रकार | डिफ़ॉल्ट कॉन्फ़िगरेशन के साथ समर्थित इंस्टेंस प्रकार | डिफ़ॉल्ट सेटिंग | लोरा + एफएसडीपी | लोरा + कोई एफएसडीपी नहीं | Int8 परिमाणीकरण + LORA + कोई FSDP नहीं |

| लामा 2 7बी | एमएल.g5.12xबड़ा | ml.g5.12xबड़ा, ml.g5.24xबड़ा, ml.g5.48xबड़ा | लोरा + एफएसडीपी | हाँ | हाँ | हाँ |

| लामा 2 13बी | एमएल.g5.12xबड़ा | ml.g5.24xबड़ा, ml.g5.48xबड़ा | लोरा + एफएसडीपी | हाँ | हाँ | हाँ |

| लामा 2 70बी | एमएल.g5.48xबड़ा | एमएल.g5.48xबड़ा | INT8 + लोरा + कोई एफएसडीपी नहीं | नहीं | नहीं | हाँ |

ध्यान दें कि लामा मॉडल की फ़ाइन-ट्यूनिंग निम्नलिखित द्वारा प्रदान की गई स्क्रिप्ट पर आधारित है गीथहब रेपो.

प्रशिक्षण डेटासेट प्रारूप

सेजमेकर जम्पस्टार्ट वर्तमान में डोमेन अनुकूलन प्रारूप और निर्देश ट्यूनिंग प्रारूप दोनों में डेटासेट का समर्थन करता है। इस अनुभाग में, हम दोनों प्रारूपों में एक उदाहरण डेटासेट निर्दिष्ट करते हैं। अधिक जानकारी के लिए, देखें डेटासेट फ़ॉर्मेटिंग परिशिष्ट में अनुभाग.

डोमेन अनुकूलन प्रारूप

टेक्स्ट जनरेशन लामा 2 मॉडल को किसी भी डोमेन-विशिष्ट डेटासेट पर ठीक किया जा सकता है। डोमेन-विशिष्ट डेटासेट पर इसे ठीक करने के बाद, मॉडल से डोमेन-विशिष्ट टेक्स्ट उत्पन्न करने और कुछ-शॉट प्रॉम्प्टिंग के साथ उस विशिष्ट डोमेन में विभिन्न एनएलपी कार्यों को हल करने की उम्मीद की जाती है। इस डेटासेट के साथ, इनपुट में एक CSV, JSON, या TXT फ़ाइल होती है। उदाहरण के लिए, इनपुट डेटा टेक्स्ट फ़ाइल के रूप में अमेज़ॅन की एसईसी फाइलिंग हो सकता है:

अनुदेश ट्यूनिंग प्रारूप

निर्देश फाइन-ट्यूनिंग में, मॉडल को निर्देशों का उपयोग करके वर्णित प्राकृतिक भाषा प्रसंस्करण (एनएलपी) कार्यों के एक सेट के लिए ठीक-ठीक किया जाता है। यह शून्य-शॉट संकेतों के साथ अनदेखे कार्यों के लिए मॉडल के प्रदर्शन को बेहतर बनाने में मदद करता है। निर्देश ट्यूनिंग डेटासेट प्रारूप में, आप निर्दिष्ट करते हैं template.json इनपुट और आउटपुट स्वरूपों का वर्णन करने वाली फ़ाइल। उदाहरण के लिए, फ़ाइल की प्रत्येक पंक्ति train.jsonl निम्नलिखित जैसा दिखता है:

अतिरिक्त फ़ाइल template.json निम्नलिखित जैसा दिखता है:

प्रशिक्षण के लिए समर्थित हाइपरपैरामीटर

लामा 2 फाइन-ट्यूनिंग कई हाइपरपैरामीटर का समर्थन करता है, जिनमें से प्रत्येक फाइन-ट्यून किए गए मॉडल की मेमोरी आवश्यकता, प्रशिक्षण गति और प्रदर्शन को प्रभावित कर सकता है:

- युग - फ़ाइन-ट्यूनिंग एल्गोरिदम द्वारा प्रशिक्षण डेटासेट के माध्यम से लिए जाने वाले पासों की संख्या। 1 से बड़ा पूर्णांक होना चाहिए। डिफ़ॉल्ट 5 है।

- सीखने की दर - वह दर जिस पर प्रशिक्षण उदाहरणों के प्रत्येक बैच के माध्यम से काम करने के बाद मॉडल वजन अपडेट किया जाता है। एक सकारात्मक फ्लोट 0 से अधिक होना चाहिए। डिफ़ॉल्ट 1e-4 है।

- अनुदेश_ट्यून किया गया - मॉडल को निर्देश-प्रशिक्षित करना है या नहीं। होना चाहिए '

True''False'. डिफ़ॉल्ट है 'False'. - प्रति_डिवाइस_ट्रेन_बैच_आकार - प्रशिक्षण के लिए प्रति जीपीयू कोर/सीपीयू बैच आकार। एक धनात्मक पूर्णांक होना चाहिए. डिफ़ॉल्ट 4 है.

- प्रति_डिवाइस_eval_बैच_आकार - मूल्यांकन के लिए प्रति जीपीयू कोर/सीपीयू बैच आकार। एक धनात्मक पूर्णांक होना चाहिए. डिफ़ॉल्ट 1 है.

- अधिकतम_ट्रेन_नमूने - डिबगिंग उद्देश्यों या त्वरित प्रशिक्षण के लिए, प्रशिक्षण उदाहरणों की संख्या को इस मान तक छोटा करें। मान -1 का अर्थ है सभी प्रशिक्षण नमूनों का उपयोग करना। एक धनात्मक पूर्णांक या -1 होना चाहिए. डिफ़ॉल्ट -1 है.

- max_val_samples - डिबगिंग उद्देश्यों या त्वरित प्रशिक्षण के लिए, सत्यापन उदाहरणों की संख्या को इस मान तक छोटा करें। मान -1 का अर्थ है सभी सत्यापन नमूनों का उपयोग करना। एक धनात्मक पूर्णांक या -1 होना चाहिए. डिफ़ॉल्ट -1 है.

- अधिकतम_इनपुट_लंबाई - टोकननाइजेशन के बाद अधिकतम कुल इनपुट अनुक्रम लंबाई। इससे अधिक लंबे अनुक्रमों को छोटा कर दिया जाएगा. यदि -1,

max_input_lengthन्यूनतम 1024 और टोकननाइज़र द्वारा परिभाषित अधिकतम मॉडल लंबाई पर सेट है। यदि सकारात्मक मान पर सेट किया जाए,max_input_lengthप्रदान किए गए मान के न्यूनतम पर सेट किया गया है औरmodel_max_lengthटोकननाइज़र द्वारा परिभाषित। एक धनात्मक पूर्णांक या -1 होना चाहिए. डिफ़ॉल्ट -1 है. - सत्यापन_विभाजन_अनुपात – यदि सत्यापन चैनल है

none, ट्रेन डेटा से ट्रेन-सत्यापन विभाजन का अनुपात 0-1 के बीच होना चाहिए। डिफ़ॉल्ट 0.2 है. - ट्रेन_डेटा_विभाजित_बीज - यदि सत्यापन डेटा मौजूद नहीं है, तो यह एल्गोरिदम द्वारा उपयोग किए जाने वाले प्रशिक्षण और सत्यापन डेटा में इनपुट प्रशिक्षण डेटा के यादृच्छिक विभाजन को ठीक करता है। पूर्णांक होना चाहिए। डिफ़ॉल्ट 0 है.

- प्रीप्रोसेसिंग_नम_वर्कर्स - प्रीप्रोसेसिंग के लिए उपयोग की जाने वाली प्रक्रियाओं की संख्या। अगर

None, मुख्य प्रक्रिया का उपयोग प्रीप्रोसेसिंग के लिए किया जाता है। डिफ़ॉल्ट हैNone. - लोरा_आर – लोरा आर. एक धनात्मक पूर्णांक होना चाहिए. डिफ़ॉल्ट 8 है.

- lora_alpha -लोरा अल्फ़ा. एक धनात्मक पूर्णांक होना चाहिए. डिफ़ॉल्ट 32 है

- लोरा_ड्रॉपआउट - लोरा ड्रॉपआउट। 0 और 1 के बीच एक सकारात्मक फ़्लोट होना चाहिए। डिफ़ॉल्ट 0.05 है।

- int8_मात्राकरण - अगर

True, मॉडल को प्रशिक्षण के लिए 8-बिट परिशुद्धता के साथ लोड किया गया है। 7बी और 13बी के लिए डिफ़ॉल्ट हैFalse. 70B के लिए डिफ़ॉल्ट हैTrue. - Enable_fsdp - अगर

True, प्रशिक्षण एफएसडीपी का उपयोग करता है। 7बी और 13बी के लिए डिफ़ॉल्ट हैTrue. 70B के लिए डिफ़ॉल्ट हैFalse। ध्यान दें किint8_quantizationएफएसडीपी के साथ समर्थित नहीं है.

इंस्टेंस प्रकार और संगत हाइपरपैरामीटर

फ़ाइन-ट्यूनिंग के दौरान मेमोरी की आवश्यकता कई कारकों के आधार पर भिन्न हो सकती है:

- मॉडल प्रकार - 7बी मॉडल में सबसे कम जीपीयू मेमोरी आवश्यकता है और 70बी में सबसे बड़ी मेमोरी आवश्यकता है

- अधिकतम इनपुट लंबाई - इनपुट लंबाई का उच्च मान एक समय में अधिक टोकन संसाधित करने की ओर ले जाता है और इस तरह अधिक CUDA मेमोरी की आवश्यकता होती है

- बैच का आकार - बड़े बैच आकार के लिए बड़ी CUDA मेमोरी की आवश्यकता होती है और इसलिए बड़े इंस्टेंस प्रकारों की आवश्यकता होती है

- Int8 परिमाणीकरण - यदि Int8 परिमाणीकरण का उपयोग किया जाता है, तो मॉडल को कम परिशुद्धता में लोड किया जाता है और इसलिए कम CUDA मेमोरी की आवश्यकता होती है

आरंभ करने में आपकी सहायता के लिए, हम विभिन्न इंस्टेंस प्रकार, हाइपरपैरामीटर और मॉडल प्रकारों के संयोजन का एक सेट प्रदान करते हैं जिन्हें सफलतापूर्वक ठीक किया जा सकता है। आप अपनी आवश्यकताओं और इंस्टेंस प्रकारों की उपलब्धता के अनुसार कॉन्फ़िगरेशन का चयन कर सकते हैं। हम सारांश उदाहरणों के साथ डॉली डेटासेट के सबसेट पर तीन युगों के साथ विभिन्न सेटिंग्स पर सभी तीन मॉडलों को ठीक करते हैं।

7बी मॉडल

निम्न तालिका 7बी मॉडल पर फ़ाइन-ट्यूनिंग विकल्पों का सारांश प्रस्तुत करती है।

| उदाहरण प्रकार | मैक्स इनपुट लेन | प्रति डिवाइस बैच आकार | Int8 परिमाणीकरण | एफएसडीपी सक्षम करें | लिया गया समय (मिनट) |

| ml.g4dn.12xबड़ा | 1024 | 8 | जब सही है | असत्य | 166 |

| ml.g4dn.12xबड़ा | 2048 | 2 | जब सही है | असत्य | 178 |

| ml.g4dn.12xबड़ा | 1024 | 4 | असत्य | जब सही है | 120 |

| ml.g4dn.12xबड़ा | 2048 | 2 | असत्य | जब सही है | 143 |

| एमएल.g5.2xबड़ा | 1024 | 4 | जब सही है | असत्य | 61 |

| एमएल.g5.2xबड़ा | 2048 | 2 | जब सही है | असत्य | 68 |

| एमएल.g5.2xबड़ा | 1024 | 4 | असत्य | जब सही है | 43 |

| एमएल.g5.2xबड़ा | 2048 | 2 | असत्य | जब सही है | 49 |

| एमएल.g5.4xबड़ा | 1024 | 4 | असत्य | जब सही है | 39 |

| एमएल.g5.4xबड़ा | 2048 | 2 | असत्य | जब सही है | 50 |

| एमएल.g5.12xबड़ा | 1024 | 16 | जब सही है | असत्य | 57 |

| एमएल.g5.12xबड़ा | 2048 | 4 | जब सही है | असत्य | 64 |

| एमएल.g5.12xबड़ा | 1024 | 4 | असत्य | जब सही है | 26 |

| एमएल.g5.12xबड़ा | 2048 | 4 | असत्य | जब सही है | 23 |

| एमएल.g5.48xबड़ा | 1024 | 16 | जब सही है | असत्य | 59 |

| एमएल.g5.48xबड़ा | 2048 | 4 | जब सही है | असत्य | 67 |

| एमएल.g5.48xबड़ा | 1024 | 8 | असत्य | जब सही है | 22 |

| एमएल.g5.48xबड़ा | 2048 | 4 | असत्य | जब सही है | 21 |

13B

निम्न तालिका 13बी मॉडल पर फ़ाइन-ट्यूनिंग विकल्पों का सारांश प्रस्तुत करती है।

| उदाहरण प्रकार | मैक्स इनपुट लेन | प्रति डिवाइस बैच आकार | Int8 परिमाणीकरण | एफएसडीपी सक्षम करें | लिया गया समय (मिनट) |

| ml.g4dn.12xबड़ा | 1024 | 4 | जब सही है | असत्य | 283 |

| ml.g4dn.12xबड़ा | 2048 | 2 | जब सही है | असत्य | 328 |

| एमएल.g5.12xबड़ा | 1024 | 8 | जब सही है | असत्य | 92 |

| एमएल.g5.12xबड़ा | 2048 | 4 | जब सही है | असत्य | 104 |

| एमएल.g5.48xबड़ा | 1024 | 8 | जब सही है | असत्य | 95 |

| एमएल.g5.48xबड़ा | 2048 | 4 | जब सही है | असत्य | 107 |

| एमएल.g5.48xबड़ा | 1024 | 8 | असत्य | जब सही है | 35 |

| एमएल.g5.48xबड़ा | 2048 | 2 | असत्य | जब सही है | 41 |

70B

निम्न तालिका 70बी मॉडल पर फ़ाइन-ट्यूनिंग विकल्पों का सारांश प्रस्तुत करती है।

| उदाहरण प्रकार | मैक्स इनपुट लेन | प्रति डिवाइस बैच आकार | Int8 परिमाणीकरण | एफएसडीपी सक्षम करें | लिया गया समय (मिनट) |

| एमएल.g5.48xबड़ा | 1024 | 4 | जब सही है | असत्य | 396 |

| एमएल.g5.48xबड़ा | 2048 | 1 | जब सही है | असत्य | 454 |

इंस्टेंस प्रकार और हाइपरपैरामीटर पर सिफ़ारिशें

मॉडल की सटीकता को ठीक करते समय, निम्नलिखित को ध्यान में रखें:

- 70B जैसे बड़े मॉडल 7B की तुलना में बेहतर प्रदर्शन प्रदान करते हैं

- Int8 परिमाणीकरण के बिना प्रदर्शन, INT8 परिमाणीकरण के प्रदर्शन से बेहतर है

निम्नलिखित प्रशिक्षण समय और CUDA मेमोरी आवश्यकताओं पर ध्यान दें:

- की स्थापना

int8_quantization=Trueस्मृति की आवश्यकता कम हो जाती है और प्रशिक्षण तेज़ हो जाता है। - घटाना

per_device_train_batch_sizeऔरmax_input_lengthमेमोरी की आवश्यकता कम हो जाती है और इसलिए इसे छोटे इंस्टेंस पर चलाया जा सकता है। हालाँकि, बहुत कम मान सेट करने से प्रशिक्षण का समय बढ़ सकता है। - यदि आप Int8 परिमाणीकरण का उपयोग नहीं कर रहे हैं (

int8_quantization=False), एफएसडीपी का उपयोग करें (enable_fsdp=True) तेज और कुशल प्रशिक्षण के लिए।

इंस्टेंस प्रकार चुनते समय, निम्नलिखित पर विचार करें:

- G5 इंस्टेंस समर्थित इंस्टेंस प्रकारों के बीच सबसे कुशल प्रशिक्षण प्रदान करते हैं। इसलिए, यदि आपके पास G5 इंस्टेंस उपलब्ध हैं, तो आपको उनका उपयोग करना चाहिए।

- प्रशिक्षण का समय काफी हद तक उपलब्ध GPU और CUDA मेमोरी की मात्रा पर निर्भर करता है। इसलिए, समान संख्या में GPU (उदाहरण के लिए, ml.g5.2xlarge और ml.g5.4xlarge) वाले उदाहरणों पर प्रशिक्षण लगभग समान है। इसलिए, आप प्रशिक्षण के लिए सस्ते उदाहरण (ml.g5.2xlarge) का उपयोग कर सकते हैं।

- पी3 इंस्टेंसेस का उपयोग करते समय, प्रशिक्षण 32-बिट परिशुद्धता के साथ किया जाएगा क्योंकि इन इंस्टेंसेस पर bfloat16 समर्थित नहीं है। इसलिए, प्रशिक्षण कार्य में g3 उदाहरणों की तुलना में p5 उदाहरणों पर प्रशिक्षण करते समय CUDA मेमोरी की दोगुनी मात्रा की खपत होगी।

प्रति उदाहरण प्रशिक्षण की लागत के बारे में जानने के लिए, देखें अमेज़ॅन EC2 G5 उदाहरण.

यदि डेटासेट अनुदेश ट्यूनिंग प्रारूप में है और इनपुट+समापन अनुक्रम छोटे हैं (जैसे 50-100 शब्द), तो इसका उच्च मान max_input_length बहुत ख़राब प्रदर्शन की ओर ले जाता है. इस पैरामीटर का डिफ़ॉल्ट मान -1 है, जो इससे मेल खाता है max_input_length लामा मॉडल के लिए 2048 का। इसलिए, हम अनुशंसा करते हैं कि यदि आपके डेटासेट में छोटे नमूने हैं, तो इसके लिए छोटे मान का उपयोग करें max_input_length (जैसे 200-400)।

अंत में, G5 उदाहरणों की उच्च मांग के कारण, आप त्रुटि के साथ अपने क्षेत्र में इन उदाहरणों की अनुपलब्धता का अनुभव कर सकते हैं “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” यदि आप इस त्रुटि का अनुभव करते हैं, तो प्रशिक्षण कार्य पुनः प्रयास करें या किसी भिन्न क्षेत्र का प्रयास करें।

बहुत बड़े मॉडलों को फ़ाइन-ट्यूनिंग करते समय समस्याएँ

इस अनुभाग में, हम बहुत बड़े मॉडलों को ठीक करते समय दो मुद्दों पर चर्चा करते हैं।

आउटपुट संपीड़न अक्षम करें

डिफ़ॉल्ट रूप से, प्रशिक्षण कार्य का आउटपुट एक प्रशिक्षित मॉडल होता है जिसे Amazon S3 पर अपलोड करने से पहले .tar.gz प्रारूप में संपीड़ित किया जाता है। हालाँकि, मॉडल के बड़े आकार के कारण, इस चरण में लंबा समय लग सकता है। उदाहरण के लिए, 70B मॉडल को कंप्रेस और अपलोड करने में 4 घंटे से अधिक समय लग सकता है। इस समस्या से बचने के लिए, आप सेजमेकर प्रशिक्षण प्लेटफ़ॉर्म द्वारा समर्थित अक्षम आउटपुट संपीड़न सुविधा का उपयोग कर सकते हैं। इस मामले में, मॉडल को बिना किसी संपीड़न के अपलोड किया जाता है, जिसे आगे तैनाती के लिए उपयोग किया जाता है:

सेजमेकर स्टूडियो कर्नेल टाइमआउट समस्या

लामा 70बी मॉडल के आकार के कारण, प्रशिक्षण कार्य में कई घंटे लग सकते हैं और प्रशिक्षण चरण के दौरान सेजमेकर स्टूडियो कर्नेल समाप्त हो सकता है। हालाँकि, इस दौरान, सेजमेकर में प्रशिक्षण अभी भी चल रहा है। यदि ऐसा होता है, तो आप अभी भी निम्नलिखित कोड के साथ प्रशिक्षण कार्य नाम का उपयोग करके समापन बिंदु को तैनात कर सकते हैं:

प्रशिक्षण कार्य का नाम खोजने के लिए, सेजमेकर कंसोल और उसके अंतर्गत नेविगेट करें प्रशिक्षण नेविगेशन फलक में, चुनें प्रशिक्षण कार्य. प्रशिक्षण कार्य का नाम पहचानें और उसे पूर्ववर्ती कोड में प्रतिस्थापित करें।

निष्कर्ष

इस पोस्ट में, हमने सेजमेकर जम्पस्टार्ट का उपयोग करके मेटा के लामा 2 मॉडल को ठीक करने पर चर्चा की। हमने दिखाया कि आप इन मॉडलों को ठीक करने और तैनात करने के लिए सेजमेकर स्टूडियो या सेजमेकर पायथन एसडीके में सेजमेकर जम्पस्टार्ट कंसोल का उपयोग कर सकते हैं। हमने फ़ाइन-ट्यूनिंग तकनीक, इंस्टेंस प्रकार और समर्थित हाइपरपैरामीटर पर भी चर्चा की। इसके अलावा, हमने अपने द्वारा किए गए विभिन्न परीक्षणों के आधार पर अनुकूलित प्रशिक्षण के लिए सिफारिशों की रूपरेखा तैयार की। दो डेटासेट पर तीन मॉडलों को ठीक करने के परिणाम इस पोस्ट के अंत में परिशिष्ट में दिखाए गए हैं। जैसा कि हम इन परिणामों से देख सकते हैं, फाइन-ट्यूनिंग गैर-फाइन-ट्यून किए गए मॉडल की तुलना में संक्षेपण में सुधार करती है। अगले चरण के रूप में, आप अपने उपयोग के मामलों के परिणामों का परीक्षण और बेंचमार्क करने के लिए GitHub रिपॉजिटरी में दिए गए कोड का उपयोग करके अपने स्वयं के डेटासेट पर इन मॉडलों को ठीक करने का प्रयास कर सकते हैं।

लेखक क्रिस्टोफर व्हिटेन, शिन हुआंग, काइल उलरिच, सिफेई ली, एमी यू, एडम कोज़ड्रोविक्ज़, इवान क्रावित्ज़, बेंजामिन क्रैबट्री, हाओटियन एन, मनन शाह, टोनी क्रूज़, अर्नेव शर्मा, जोनाथन गुइनेगने और जून के तकनीकी योगदान को स्वीकार करना चाहेंगे। जीत गया।

लेखक के बारे में

डॉ विवेक मदनी अमेज़ॅन सेजमेकर जम्पस्टार्ट टीम के साथ एक अनुप्रयुक्त वैज्ञानिक है। उन्होंने अर्बाना-शैंपेन में इलिनोइस विश्वविद्यालय से पीएचडी प्राप्त की और जॉर्जिया टेक में पोस्ट डॉक्टरेट शोधकर्ता थे। वह मशीन लर्निंग और एल्गोरिथम डिज़ाइन में एक सक्रिय शोधकर्ता हैं और उन्होंने EMNLP, ICLR, COLT, FOCS और SODA सम्मेलनों में पेपर प्रकाशित किए हैं।

डॉ विवेक मदनी अमेज़ॅन सेजमेकर जम्पस्टार्ट टीम के साथ एक अनुप्रयुक्त वैज्ञानिक है। उन्होंने अर्बाना-शैंपेन में इलिनोइस विश्वविद्यालय से पीएचडी प्राप्त की और जॉर्जिया टेक में पोस्ट डॉक्टरेट शोधकर्ता थे। वह मशीन लर्निंग और एल्गोरिथम डिज़ाइन में एक सक्रिय शोधकर्ता हैं और उन्होंने EMNLP, ICLR, COLT, FOCS और SODA सम्मेलनों में पेपर प्रकाशित किए हैं।

डॉ फारूक साबिर AWS में एक वरिष्ठ आर्टिफिशियल इंटेलिजेंस और मशीन लर्निंग स्पेशलिस्ट सॉल्यूशंस आर्किटेक्ट हैं। उनके पास ऑस्टिन में टेक्सास विश्वविद्यालय से इलेक्ट्रिकल इंजीनियरिंग में पीएचडी और एमएस की डिग्री है और जॉर्जिया इंस्टीट्यूट ऑफ टेक्नोलॉजी से कंप्यूटर साइंस में एमएस है। उनके पास 15 साल से अधिक का कार्य अनुभव है और वह कॉलेज के छात्रों को पढ़ाना और सलाह देना भी पसंद करते हैं। AWS में, वह ग्राहकों को डेटा साइंस, मशीन लर्निंग, कंप्यूटर विज़न, आर्टिफिशियल इंटेलिजेंस, न्यूमेरिकल ऑप्टिमाइज़ेशन और संबंधित डोमेन में उनकी व्यावसायिक समस्याओं को तैयार करने और हल करने में मदद करता है। डलास, टेक्सास में स्थित, वह और उसका परिवार यात्रा करना और लंबी सड़क यात्राओं पर जाना पसंद करते हैं।

डॉ फारूक साबिर AWS में एक वरिष्ठ आर्टिफिशियल इंटेलिजेंस और मशीन लर्निंग स्पेशलिस्ट सॉल्यूशंस आर्किटेक्ट हैं। उनके पास ऑस्टिन में टेक्सास विश्वविद्यालय से इलेक्ट्रिकल इंजीनियरिंग में पीएचडी और एमएस की डिग्री है और जॉर्जिया इंस्टीट्यूट ऑफ टेक्नोलॉजी से कंप्यूटर साइंस में एमएस है। उनके पास 15 साल से अधिक का कार्य अनुभव है और वह कॉलेज के छात्रों को पढ़ाना और सलाह देना भी पसंद करते हैं। AWS में, वह ग्राहकों को डेटा साइंस, मशीन लर्निंग, कंप्यूटर विज़न, आर्टिफिशियल इंटेलिजेंस, न्यूमेरिकल ऑप्टिमाइज़ेशन और संबंधित डोमेन में उनकी व्यावसायिक समस्याओं को तैयार करने और हल करने में मदद करता है। डलास, टेक्सास में स्थित, वह और उसका परिवार यात्रा करना और लंबी सड़क यात्राओं पर जाना पसंद करते हैं।

डॉ आशीष खेतानी अमेज़ॅन सेजमेकर जम्पस्टार्ट के साथ एक वरिष्ठ एप्लाइड वैज्ञानिक हैं और मशीन लर्निंग एल्गोरिदम विकसित करने में मदद करते हैं। उन्होंने इलिनोइस विश्वविद्यालय अर्बाना-शैंपेन से पीएचडी की उपाधि प्राप्त की। वह मशीन लर्निंग और सांख्यिकीय अनुमान में एक सक्रिय शोधकर्ता हैं, और उन्होंने न्यूरिप्स, आईसीएमएल, आईसीएलआर, जेएमएलआर, एसीएल और ईएमएनएलपी सम्मेलनों में कई पत्र प्रकाशित किए हैं।

डॉ आशीष खेतानी अमेज़ॅन सेजमेकर जम्पस्टार्ट के साथ एक वरिष्ठ एप्लाइड वैज्ञानिक हैं और मशीन लर्निंग एल्गोरिदम विकसित करने में मदद करते हैं। उन्होंने इलिनोइस विश्वविद्यालय अर्बाना-शैंपेन से पीएचडी की उपाधि प्राप्त की। वह मशीन लर्निंग और सांख्यिकीय अनुमान में एक सक्रिय शोधकर्ता हैं, और उन्होंने न्यूरिप्स, आईसीएमएल, आईसीएलआर, जेएमएलआर, एसीएल और ईएमएनएलपी सम्मेलनों में कई पत्र प्रकाशित किए हैं।

परिशिष्ट

यह परिशिष्ट प्रदर्शन बेंचमार्किंग और डेटासेट फ़ॉर्मेटिंग के बारे में अतिरिक्त जानकारी प्रदान करता है।

प्रदर्शन बेंचमार्किंग

इस अनुभाग में, हम दो अलग-अलग डेटासेट पर तीन लामा 2 मॉडल (7बी, 13बी, और 70बी) को ठीक करने के लिए परिणाम प्रदान करते हैं: नादान और डायलॉगसम. डॉली डेटासेट के लिए, हमारा कार्य पाठ के एक पैराग्राफ को सारांशित करना है, जबकि डायलॉगसम के लिए, हम दो लोगों के बीच चर्चा को सारांशित करने के लिए मॉडल को ठीक कर रहे हैं। निम्नलिखित तालिकाओं में, हम मॉडल के लिए इनपुट (संकेत और निर्देश), जमीनी सच्चाई (सारांश), पूर्व-प्रशिक्षित लामा 2 मॉडल से प्रतिक्रिया, और तीन लामाओं में से प्रत्येक के लिए सुव्यवस्थित लामा 2 मॉडल से प्रतिक्रिया दिखाते हैं। 2 मॉडल. हम पांच डेटा बिंदुओं के लिए अनुमान परिणाम दिखाते हैं। आप निम्न तालिकाओं से देख सकते हैं कि जब हम मॉडल को ठीक करते हैं तो दोनों डेटासेट के लिए सारांश में सुधार होता है।

- डॉली डेटासेट पर लामा 2 7बी टेक्स्ट जेनरेशन मॉडल को ठीक करने के परिणाम:

| निविष्टियां | वास्तविक्ता | नॉन-फाइन-ट्यून्ड मॉडल से प्रतिक्रिया | फाइन-ट्यून्ड मॉडल से प्रतिक्रिया |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। फ़्रांस के प्रोवेंस-आल्प्स-कोटे डी'अज़ूर क्षेत्र में। कम्यून के निवासियों को फ़्रेंच में अल्लाउडियन्स या अल्लाउडिएन्स के रूप में जाना जाता है। nnnn### प्रतिक्रिया:n | अल्लाउच एक फ्रांसीसी कम्यून है जो फ्रांस के प्रोवेंस-आल्प्स-कोटे डी'ज़ूर क्षेत्र में बाउचेस-डु-रोन विभाग में मार्सिले के पूर्व में स्थित है। कम्यून के निवासियों को फ्रेंच में अल्लाउडियन्स या अल्लाउदिएनेस के रूप में जाना जाता है। | अलाउच फ्रांस के प्रोवेंस-आल्प्स-कोटे डी'ज़ूर क्षेत्र में बाउचेस-डु-रोन विभाग में मार्सिले से 28 किमी पूर्व में स्थित एक शहर है। इसे फ्रांस के सबसे खूबसूरत गांवों में से एक माना जाता है। यह शहर पहाड़ियों और अंगूर के बागों से घिरा हुआ है और इसकी आबादी लगभग 6,000 लोगों की है। इसका उल्लेख पहली बार 1006 में किया गया था और यह एक समृद्ध स्थान है | कम्यून मार्सिले के पूर्व में स्थित मैसिफ डू गेलस नामक चट्टानी पठार पर स्थित है। इसमें मार्सिले और उसके समुद्र तट का सुंदर दृश्य दिखाई देता है। अलाउच अब अपने स्वयं के टाउन हॉल और दुकानों, बार और रेस्तरां की एक श्रृंखला के साथ एक अच्छी तरह से विकसित कम्यून है। मार्सिले और एल्पिल्स के बीच स्थित होने के कारण, इसने क्षेत्र की कई प्राकृतिक विशेषताओं को बरकरार रखा है, जिसमें ग्लैंड्स मासिफ भी शामिल है, जिसे "डब्ल्यू" भी कहा जाता है। |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। - तस्मानिया सहित पूर्वी ऑस्ट्रेलिया में स्थानिक स्तनपायी। प्लैटिपस अपने परिवार (ऑर्निथोरहाइन्चिडे) और जीनस (ऑर्निथोरहाइन्चस) का एकमात्र जीवित प्रतिनिधि या मोनोटाइपिक टैक्सोन है, हालांकि कई संबंधित प्रजातियां जीवाश्म रिकॉर्ड में दिखाई देती हैं।nnnn### प्रतिक्रिया:n | डक-बिल्ड प्लैटिपस पूर्वी ऑस्ट्रेलिया में पाया जाने वाला एक अंडा देने वाला स्तनपायी है। यह अपने जीनस ऑर्निथोरिन्चस में एकमात्र जीवित प्रतिनिधि है। | मैंने आपके प्रश्न पर काफी शोध किया। मैंने आपके दूसरे पैराग्राफ में दी गई सारी जानकारी पढ़ ली है। मैंने प्लैटिपस के बारे में भी कुछ पढ़ा है, जिसमें [यह पेज](https://phys.org/news/2019-04-australia-platypus-predator-species.html) भी शामिल है। मुझे लगता है मुझे आपके प्रश्न का कुछ उत्तर मिल गया है। क्या आप पूछ रहे हैं कि क्या प्लैटिपस अंडा देने वाला स्तनपायी है या नहीं | एक स्तनपायी जो अंडे देता है, प्लैटिपस की तरह |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। ## प्रतिक्रिया:एन | 5 नवंबर 2009 को फेलिक्स लूना की मृत्यु हो गई | फ़ेलिक्स सीज़र लूना (30 सितंबर 1925 - 5 नवंबर 2009) अर्जेंटीना के निवासी थे लूना की मृत्यु कब हुई? | फ़ेलिक्स लूना की मृत्यु 5 नवंबर, 2009 को हुई |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। दृश्य प्रणाली के कारण होने वाला भ्रम और एक दृश्य धारणा की विशेषता जो यकीनन वास्तविकता से भिन्न प्रतीत होती है। भ्रम अनेक प्रकार के होते हैं; उनका वर्गीकरण कठिन है क्योंकि अंतर्निहित कारण अक्सर स्पष्ट नहीं होता है लेकिन रिचर्ड ग्रेगरी द्वारा प्रस्तावित वर्गीकरण एक अभिविन्यास के रूप में उपयोगी है। उसके अनुसार, तीन मुख्य वर्ग हैं: शारीरिक, शारीरिक और संज्ञानात्मक भ्रम, और प्रत्येक वर्ग में चार प्रकार होते हैं: अस्पष्टताएं, विकृतियां, विरोधाभास और कल्पना। भौतिक विकृति के लिए एक शास्त्रीय उदाहरण पानी में आधी डूबी हुई छड़ी का स्पष्ट रूप से झुकना होगा; शारीरिक विरोधाभास का एक उदाहरण गति के बाद का प्रभाव है (जहां, गति के बावजूद, स्थिति अपरिवर्तित रहती है)। एनाफिजियोलॉजिकल फिक्शन का एक उदाहरण एक आफ्टरइमेज है। तीन विशिष्ट संज्ञानात्मक विकृतियाँ हैं पोंज़ो, पोगेंडोर्फ, और मुलर-लायर भ्रम। भौतिक भ्रम भौतिक वातावरण के कारण होते हैं, उदाहरण के लिए पानी के ऑप्टिकल गुणों के कारण। शारीरिक भ्रम आंख या दृश्य मार्ग में उत्पन्न होते हैं, उदाहरण के लिए एक विशिष्ट रिसेप्टर प्रकार की अत्यधिक उत्तेजना के प्रभाव से। संज्ञानात्मक दृश्य भ्रम अचेतन अनुमानों का परिणाम हैं और शायद सबसे व्यापक रूप से ज्ञात हैं।nnnn### प्रतिक्रिया:n | 1. दृश्य भ्रम दृश्य प्रणाली के कारण होता है और एक दृश्य धारणा की विशेषता होती है जो वास्तविकता से भिन्न प्रतीत होती है।n2। रिचर्ड ग्रेगोरी के अनुसार उनके द्वारा प्रस्तावित वर्गीकरण एक अभिविन्यास के रूप में उपयोगी है कि, तीन मुख्य वर्ग हैं: शारीरिक, शारीरिक और संज्ञानात्मक भ्रम, और प्रत्येक वर्ग में चार प्रकार होते हैं: अस्पष्टता, विकृतियां, विरोधाभास और कल्पना।n3। भौतिक विकृति का एक उदाहरण पानी में आधी डूबी हुई छड़ी का स्पष्ट रूप से मुड़ना होगा; शारीरिक विरोधाभास का एक उदाहरण गति के बाद का प्रभाव है (जहां, गति के बावजूद, स्थिति अपरिवर्तित रहती है)। n4. शारीरिक कल्पना का एक उदाहरण आफ्टरइमेजेन5 है। तीन संज्ञानात्मक विकृतियाँ पोंज़ो, पोगेंडोर्फ और मुलर-लायर भ्रम हैं।एन6। भौतिक भ्रम भौतिक वातावरण के कारण होते हैं, उदाहरण के लिए पानी के ऑप्टिकल गुणों के कारण। शारीरिक भ्रम आँख या दृश्य मार्ग में उत्पन्न होते हैं।n7। सबसे व्यापक रूप से जाना जाने वाला भ्रम दृश्य भ्रम है जो अचेतन अनुमानों का परिणाम है। | परिच्छेद में उल्लिखित ऑप्टिकल भ्रम उस छड़ी की भ्रमपूर्ण गति है जो आंशिक रूप से पानी में डूबी हुई है।nn## 50.n### निर्देश:nदावे के समर्थन या खंडन के लिए एक तर्क लिखें:nहमारी प्रयोगशाला के सभी छात्रों के पास है समान औसत IQ.nn### इनपुट:nप्रयोग में कई छात्रों का औसत IQ समान है, और मेरा मानना है कि वे उच्चतम वाले 10% हैं | ऑप्टिकल भ्रम हमारे द्वारा दृश्य उत्तेजनाओं की व्याख्या और प्रतिक्रिया करने के तरीके से संबंधित शारीरिक और मनोवैज्ञानिक सीमाओं का उपयोग करते हैं, हमारे आसपास की दुनिया में उत्तेजनाएं और आंतरिक रूप से उत्पन्न दृश्य उत्तेजनाएं दोनों। वे दो प्रणालियों (शारीरिक और मनोवैज्ञानिक/अवधारणात्मक) को एक सामान्य उत्तेजना प्रदान करते हैं जो हमें दोनों की तुलना करने और प्रत्येक के काम करने के तरीके को समझने की अनुमति देती है। ऑप्टिकल भ्रम के कई अलग-अलग रूप हैं, जिनमें मनोवैज्ञानिक, |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। ऐसा उत्तर लिखें जो अनुरोध को उचित रूप से पूरा करता हो। -मूल्य वाले उत्पाद, लेकिन नई कंपनियां जो खराब विकसित तकनीक के साथ कम मूल्य वाले ग्राहकों को सेवा प्रदान करती हैं, वे उस तकनीक में तब तक सुधार कर सकती हैं जब तक कि वह काफी अच्छी न हो जाएnnnn### प्रतिक्रिया:n | इनोवेटर की दुविधा: जब नई तकनीकें महान फर्मों को विफल कर देती हैं, पहली बार 1997 में प्रकाशित, हार्वर्ड प्रोफेसर और व्यवसायी क्लेटन क्रिस्टेंसन का सबसे प्रसिद्ध काम है। यह विघटनकारी प्रौद्योगिकियों की अवधारणा पर विस्तार करता है, एक शब्द जिसे उन्होंने 1995 के लेख "विघटनकारी टेक्नोलॉजीज: कैचिंग द वेव" में गढ़ा था। यह वर्णन करता है कि कैसे बड़ी मौजूदा कंपनियां अपने ग्राहकों की बात सुनकर और उच्चतम मूल्य वाले उत्पाद प्रदान करके बाजार हिस्सेदारी खो देती हैं, लेकिन नई कंपनियां जो खराब विकसित तकनीक के साथ कम मूल्य वाले ग्राहकों की सेवा करती हैं, उस तकनीक में तब तक सुधार कर सकती हैं जब तक कि वह पर्याप्त रूप से अच्छी न हो जाए। स्थापित व्यवसाय से शीघ्रता से बाज़ार हिस्सेदारी प्राप्त करें। क्रिस्टेंसन का सुझाव है कि बड़ी कंपनियां छोटे, फुर्तीले डिवीजनों को बनाए रखें जो स्टार्टअप प्रतिस्पर्धियों द्वारा अंधाधुंध और आगे निकलने से बचने के लिए आंतरिक रूप से इस घटना को दोहराने का प्रयास करें। | नमस्ते, देर से प्रतिक्रिया के लिए खेद है!! मैं पिछले सप्ताह छुट्टी पर था :) क्लेटन क्रिस्टेंसन द्वारा लिखित इनोवेटर की दुविधा बताती है कि "इनोवेटर की दुविधा यह है कि मौजूदा ग्राहकों को अधिक मूल्य प्रदान करने के लिए अपने उत्पादों को पेश करने या उनमें सुधार करके निरंतर लाभ की तलाश करने वाली कंपनी के परिणामस्वरूप वही ग्राहक उसे छोड़ देंगे कंपनी ऐसे नवाचारों को खरीदेगी जो कम से कम कुछ मूल्य प्रदान करते हों | इनोवेटर की दुविधा एक किताब है जो बताती है कि कैसे बड़ी मौजूदा कंपनियां अपने ग्राहकों की बात सुनकर और उच्चतम मूल्य वाले उत्पाद प्रदान करके बाजार हिस्सेदारी खो देती हैं, लेकिन नई कंपनियां जो कम विकसित तकनीक के साथ कम मूल्य वाले ग्राहकों की सेवा करती हैं, उस तकनीक में धीरे-धीरे सुधार कर सकती हैं। जब तक यह काफी अच्छा न हो जाए एन.एन |

- डॉली डेटासेट पर लामा 2 13बी टेक्स्ट जेनरेशन मॉडल को ठीक करने के परिणाम:

| निविष्टियां | वास्तविक्ता | नॉन-फाइन-ट्यून्ड मॉडल से प्रतिक्रिया | फाइन-ट्यून्ड मॉडल से प्रतिक्रिया |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। डेर क्लासिकर की 2021-2023 से जीत के बाद बायर्न ने लगातार 10 बुंडेसलीगा खिताब जीतने की उपलब्धि हासिल कर ली है। हालाँकि, टीम अप्रत्याशित रूप से चैंपियंस लीग क्वार्टर फाइनल में विलारियल से हार गई और लगातार दूसरे वर्ष उस चरण से बाहर हो गई। 3 मार्च 1 को, नगेल्समैन को बायर्न द्वारा रिहा कर दिया गया और उनकी जगह थॉमस ट्यूशेल को नियुक्त किया गया, जिन्हें 24 जून 2023 तक अनुबंध प्राप्त हुआ।nnnn### प्रतिक्रिया:n | थॉमस ट्यूशेल ने मार्च 2023 में जूलियन नगेल्समैन की जगह ली और अब एफसी बायर्न म्यूनिख में नए कोच हैं, और पहले चेल्सी में कोच थे। | nn"`पायथन{n "निर्देश": "एफसी बायर्न मुन्चेन में जूलियन नगेल्समैन की जगह लेने वाला अगला कोच कौन है?", n "क्रिया": "एफसी बायर्न का अगला कोच", n "संदर्भ":{n " नगेल्समैन युग (2021-2023)": n "नए कोच जूलियन नगेल्समैन के तहत, बायर्न ने लगातार 10 बुंडेसलीगा खिताब जीतने की उपलब्धि पूरी कर ली है। | एफसी बायर्न म्यूनिख के अगले कोच थॉमस ट्यूशेल होंगे। 24 मार्च, 2023 को नगेल्समैन के टीम से चले जाने पर ट्यूशेल जूलियन नगेल्समैन की जगह लेंगे। |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। उन्होंने 29 में पेरिस विश्वविद्यालय से "बैचलियर एस लेट्रेस" स्नातक की उपाधि प्राप्त की, और एलएलबी की डिग्री प्राप्त करते हुए पेरिस में उच्च शिक्षा के विभिन्न संस्थानों में कानून, ऐतिहासिक आलोचना और भाषाशास्त्र का अध्ययन किया। 1851 में। इकोले डेस चार्ट्स के एक छात्र, उनकी थीसिस का नाम वुएस सुर ल'हिस्टोइरे डे ल'ऑर्गनाइजेशन ज्यूडिशियरी एन फ्रांस डु IXe औ XIIIe सिएकल कंसीडेरी औ पॉइंट डे व्यू डेस ज्यूरिडिक्शन एक्स्ट्राऑर्डिनेयर्स था और उन्हें "आर्किविस्ट पैलियोग्राफ" का डिप्लोमा मिला। 1930 में। 1868 में फ्रेंको-प्रशिया युद्ध की शुरुआत में, वह पूरे संघर्ष के दौरान फ्रांसीसी सेना में भर्ती हुए और सेवा की। कोहन 1873 मई, 1874 को न्यूयॉर्क शहर चले गए और 1870 से 13 तक ला के अमेरिकी संवाददाता रहे। रिपब्लिक फ़्रैन्काइज़, जिसे तब लियोन गैम्बेटा द्वारा संपादित किया गया था, जिसे वह फ्रांस में जानता था, और जिसके राजनीतिक विचारों को उसने अपनाया था। मार्च, 1875 में, कोहन को कोलंबिया कॉलेज में फ्रेंच में ट्यूटर नियुक्त किया गया, और उसके तुरंत बाद एक प्रशिक्षक बना दिया गया। न्यूयॉर्क के फ्रांसीसी निवासियों के एक लोकप्रिय वोट से उन्हें 1876 में गैम्बेटा के टैमनी हॉल में अंतिम संस्कार भाषण देने के लिए चुना गया था, और 1884 में विक्टर ह्यूगो की मृत्यु पर इसी उद्देश्य के लिए कैम्ब्रिज, मैसाचुसेट्स से बुलाया गया था। ### प्रतिक्रिया:एन | एडोल्फ कोहन (29 मई, 1851 - 1930) एक फ्रेंको-अमेरिकी शिक्षक थे, जिनका जन्म पेरिस में हुआ था। उन्होंने 1868 में पेरिस विश्वविद्यालय से "बैचलियर एस लेट्रेस" स्नातक की उपाधि प्राप्त की, और एलएलबी की डिग्री प्राप्त करते हुए पेरिस में उच्च शिक्षा के विभिन्न संस्थानों में कानून, ऐतिहासिक आलोचना और भाषाशास्त्र का अध्ययन किया। 1873 में। इकोले डेस चार्ट्स के एक छात्र, उनकी थीसिस का नाम वुएस सुर ल'हिस्टोइरे डे ल'ऑर्गनाइजेशन ज्यूडिशियरी एन फ्रांस डु IXe औ XIIIe सिएकल कंसीडेरी औ पॉइंट डे व्यू डेस ज्यूरिडिक्शन एक्स्ट्राऑर्डिनेयर्स था और उन्हें "आर्किविस्ट पैलियोग्राफ" का डिप्लोमा मिला। 1874 में। 1870 में फ्रेंको-प्रशिया युद्ध की शुरुआत में, वह पूरे संघर्ष के दौरान फ्रांसीसी सेना में भर्ती हुए और सेवा की। कोहन 13 मई, 1875 को न्यूयॉर्क शहर चले गए और 1876 से 1884 तक ला के अमेरिकी संवाददाता रहे। रिपब्लिक फ़्रैन्काइज़, जिसे तब लियोन गैम्बेटा द्वारा संपादित किया गया था, जिसे वह फ्रांस में जानता था, और जिसके राजनीतिक विचारों को उसने अपनाया था। मार्च, 1882 में, कोहन को कोलंबिया कॉलेज में फ्रेंच में ट्यूटर नियुक्त किया गया, और उसके तुरंत बाद एक प्रशिक्षक बना दिया गया। न्यूयॉर्क के फ्रांसीसी निवासियों के एक लोकप्रिय वोट से उन्हें 1883 में गैम्बेटा के टैमनी हॉल में अंतिम संस्कार भाषण देने के लिए चुना गया था, और 1885 में विक्टर ह्यूगो की मृत्यु पर इसी उद्देश्य के लिए कैम्ब्रिज, मैसाचुसेट्स से बुलाया गया था। | एनडॉल्फे कोहन (29 मई, 1851-1930) एक फ्रेंको-अमेरिकी शिक्षक थे, जिनका जन्म पेरिस में हुआ था। उन्होंने 1868 में पेरिस विश्वविद्यालय से "बैचलियर एस लेट्रेस" स्नातक की उपाधि प्राप्त की, और एलएलबी की डिग्री प्राप्त करते हुए पेरिस में उच्च शिक्षा के विभिन्न संस्थानों में कानून, ऐतिहासिक आलोचना और भाषाशास्त्र का अध्ययन किया। 1873 में ई. का एक छात्र | एडोल्फ कोहन एक फ्रेंको-अमेरिकी शिक्षक थे, जिनका जन्म 29 मई, 1851 को पेरिस में हुआ था। उन्होंने पेरिस विश्वविद्यालय में दाखिला लिया और 1873 में कानून की डिग्री हासिल की। उन्होंने इकोले डेस चार्ट्स में भी काम किया और "आर्किविस्ट पैलियोग्राफ" की डिग्री हासिल की। 1874. फ्रेंको-प्रशिया युद्ध की शुरुआत में, वह फ्रांसीसी सेना में शामिल हो गए और पूरे समय उनकी सेवा की। |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो अनुरोध को उचित रूप से पूरा करती है। मैकडॉनल्ड्स हैप्पी मील्स, जिसमें अक्सर एक नई रिलीज़ हुई पारिवारिक फिल्म के साथ जुड़ा हुआ खिलौना शामिल होता है, एक महत्वपूर्ण उदाहरण है। रोनाल्ड मैकडोनाल्ड, एक विदूषक विज्ञापन शुभंकर है जिसे 1963 में पेश किया गया था और इसे छोटे बच्चों को आकर्षित करने के लिए डिज़ाइन किया गया था। इसके अलावा, 1987 में मैकडॉनल्ड्स ने बच्चों को विज्ञापन देने के लिए अपने रेस्तरां में एक प्ले प्लेस शामिल किया, जिससे उनके रेस्तरां बच्चों के लिए अधिक आकर्षक वातावरण बन गए। इसके अतिरिक्त, 1996 से 2006 तक, डिज़्नी मैकडॉनल्ड्स के साथ एक विशेष भागीदार था, जो उनके उत्पादों को एक साथ जोड़ता था। उन्होंने मई 2006 में इस सौदे की समाप्ति की घोषणा की, कुछ रिपोर्टों में कहा गया कि डिज़्नी बचपन के मोटापे के बारे में चिंतित था। डिज़्नी के अलावा, मैकडॉनल्ड्स ने भी 1985 से निंटेंडो के साथ साझेदारी की है, जब निंटेंडो एंटरटेनमेंट सिस्टम पहली बार पेश किया गया था। 1987 में, मैकडॉनल्ड्स ने अपने रेस्तरां में एक निनटेंडो प्ले लैंड भी बनाया जहां बच्चे अपने भोजन की प्रतीक्षा करते समय निनटेंडो कंसोल पर खेल सकते थे। 2007 के दौरान, मैकडॉनल्ड्स ने निनटेंडो कंसोल से वाईफाई प्रदान करना शुरू किया; बच्चों को वे जहां भी हों, खेलने की क्षमता प्रदान करना। इन नई फिल्मों को रिलीज करने और खिलौनों को शामिल करने वाले बच्चों के लक्षित दर्शकों के साथ, यह बच्चों के बड़े निवेश के कारण उनके माता-पिता की जेब तक पहुंचने के लिए उपयोग करता है।nnnn### प्रतिक्रिया:n | मैकडॉनल्ड्स ने लगातार अपने विज्ञापन को सीधे युवा आबादी पर लक्षित किया है। 1963 में शुरू करके, उन्होंने छोटे बच्चों को आकर्षित करने के लिए डिज़ाइन किया गया एक विदूषक विज्ञापन शुभंकर रोनाल्ड मैकडॉनल्ड्स पेश किया। इन वर्षों में, मैकडॉनल्ड्स ने कई कंपनियों के साथ साझेदारी की है जिनके उत्पाद बच्चों को ध्यान में रखकर बनाए गए हैं, जैसे कि निनटेंडो और डिज़्नी। | फ़ास्ट फ़ूड रेस्तरां हमेशा युवा आबादी को लक्षित करते रहे हैं। जब युवाओं के लिए विज्ञापन की बात आती है तो हैप्पी मील भी एक बड़ा कारक होता है। कई फिल्में प्रदर्शित होने के बाद हैप्पी मील आपके स्थानीय मैकडॉनल्ड्स में उस फिल्म को बढ़ावा देने के लिए एक खिलौने के साथ भी आता है - n## 400-999nn### टिप्पणी:nAs दुनिया के बारे में अपेक्षाकृत संकीर्ण दृष्टिकोण वाली एक युवा कंपनी, मैकडॉनल्ड्स ने ऐसा किया | लॉन्च के बाद से, मैकडॉनल्ड्स ने अपने बच्चों पर केंद्रित फास्ट फूड रेस्तरां और खाद्य उत्पादों के साथ-साथ अपने विज्ञापन के साथ छोटे बच्चों और किशोरों को लक्षित किया है, जिसने बड़े पैमाने पर युवाओं को लक्षित किया है। जबकि बच्चों को उनके माता-पिता द्वारा मैकडॉनल्ड्स में ले जाया जा रहा है, रेस्तरां मूल रूप से उनके बच्चों के लिए एक अभिभावकीय विज्ञापन है: मैकडॉनल्ड्स अपने चमकीले रंग के रेस्तरां और उनके भोजन में पाए जाने वाले खिलौनों के साथ बच्चों को आकर्षित करता है। |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। यह विशाखापत्तनम राजस्व मंडल के प्रशासन के अधीन है और मुख्यालय आनंदपुरम में स्थित है। आनंदपुरम मंडल पूर्व में भीमुनिपट्टनम मंडल, दक्षिण में चिनागाडिला, उत्तर में पद्मनाभम और पश्चिम में कोथावलासा से घिरा है।nnnn### प्रतिक्रिया:n | आनंदपुरम मंडल भारत के आंध्र प्रदेश राज्य के विशाखापत्तनम जिले के 46 मंडलों में से एक है। यह विशाखापत्तनम राजस्व मंडल के प्रशासन के अधीन है और मुख्यालय आनंदपुरम में स्थित है। | nnnn | आनंदपुरम मंडल भारत के आंध्र प्रदेश राज्य के विशाखापत्तनम जिले के 46 मंडलों में से एक है। यह विशाखापत्तनम राजस्व मंडल के प्रशासन के अधीन है और मुख्यालय आनंदपुरम में स्थित है। आनंदपुरम मंडल पूर्व में भीमुनिपट्टनम मंडल, दक्षिण में चिनगाडिला, उत्तर में पद्मनाभम और कोथ से घिरा है। |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। बेथेल, न्यूयॉर्क, संयुक्त राज्य अमेरिका में मैक्स यासगुर का डेयरी फार्म, वुडस्टॉक शहर से 15 मील (18 किमी) दक्षिण पश्चिम में है। "एक्वेरियन प्रदर्शनी: शांति और संगीत के 1969 दिन" के रूप में प्रस्तुत और वैकल्पिक रूप से वुडस्टॉक रॉक फेस्टिवल के रूप में संदर्भित, इसने 40 से अधिक दर्शकों को आकर्षित किया। छिटपुट बारिश के बावजूद बत्तीस कृत्यों का प्रदर्शन बाहर किया गया। यह इतिहास में आयोजित सबसे बड़े संगीत समारोहों में से एक था। इस उत्सव को व्यापक रूप से लोकप्रिय संगीत इतिहास में एक महत्वपूर्ण क्षण के साथ-साथ प्रतिसंस्कृति पीढ़ी के लिए एक निर्णायक कार्यक्रम माना जाता है। इस आयोजन के महत्व को 65 की एक डॉक्यूमेंट्री फिल्म, एक साउंडट्रैक एल्बम और जोनी मिशेल द्वारा लिखित एक गीत द्वारा प्रबलित किया गया, जो क्रॉस्बी, स्टिल्स, नैश एंड यंग और मैथ्यूज सदर्न कम्फर्ट दोनों के लिए एक प्रमुख हिट बन गया। वर्षगाँठ के लिए वुडस्टॉक नाम वाले संगीत कार्यक्रमों की योजना बनाई गई थी, जिसमें दसवीं, बीसवीं, पच्चीसवीं, तीसवीं, चालीसवीं और पचासवीं शामिल थी। 3 में, रोलिंग स्टोन पत्रिका ने इसे रॉक एंड रोल के इतिहास को बदलने वाले 400,000 क्षणों में से 1970वें स्थान पर सूचीबद्ध किया। 2004 में, उत्सव स्थल ऐतिहासिक स्थानों के राष्ट्रीय रजिस्टर में सूचीबद्ध हो गया।nnnn### प्रतिक्रिया:n | वुडस्टॉक संगीत और कला मेला, जिसे आमतौर पर वुडस्टॉक कहा जाता है, 15-18 अगस्त, 1969 के दौरान बेथेल, न्यूयॉर्क, संयुक्त राज्य अमेरिका में शहर से 40 मील (65 किमी) दक्षिण-पश्चिम में मैक्स यासगुर के डेयरी फार्म पर आयोजित एक संगीत समारोह था। वुडस्टॉक का. "एक्वेरियन प्रदर्शनी: शांति और संगीत के 3 दिन" के रूप में प्रस्तुत और वैकल्पिक रूप से वुडस्टॉक रॉक फेस्टिवल के रूप में संदर्भित, इसने 400,000 से अधिक दर्शकों को आकर्षित किया। छिटपुट बारिश के बावजूद बत्तीस कृत्यों का प्रदर्शन बाहर किया गया। यह इतिहास में आयोजित सबसे बड़े संगीत समारोहों में से एक था। इस उत्सव को व्यापक रूप से लोकप्रिय संगीत इतिहास में एक महत्वपूर्ण क्षण के साथ-साथ प्रतिसंस्कृति पीढ़ी के लिए एक निर्णायक कार्यक्रम माना जाता है। इस आयोजन के महत्व को 1970 की एक डॉक्यूमेंट्री फिल्म, एक साउंडट्रैक एल्बम और जोनी मिशेल द्वारा लिखित एक गीत द्वारा प्रबलित किया गया, जो क्रॉस्बी, स्टिल्स, नैश एंड यंग और मैथ्यूज सदर्न कम्फर्ट दोनों के लिए एक प्रमुख हिट बन गया। वर्षगाँठ के लिए वुडस्टॉक नाम वाले संगीत कार्यक्रमों की योजना बनाई गई थी, जिसमें दसवीं, बीसवीं, पच्चीसवीं, तीसवीं, चालीसवीं और पचासवीं शामिल थी। 2004 में, रोलिंग स्टोन पत्रिका ने इसे रॉक एंड रोल के इतिहास को बदलने वाले 19 क्षणों में से 50वें स्थान पर सूचीबद्ध किया। 2017 में, उत्सव स्थल ऐतिहासिक स्थानों के राष्ट्रीय रजिस्टर में सूचीबद्ध हो गया। | nउत्तर:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn एनएन## समाधान:एनएन एन समाधान देखने के लिए nn“`jsnn// समाधान आवश्यक है | 15-18 अगस्त के उत्तरार्ध के दौरान आयोजित वुडस्टॉक संगीत और कला मेला, काउंटरकल्चर पीढ़ी द्वारा बेथेल, न्यूयॉर्क में एक ऐतिहासिक कार्यक्रम था। उत्सव में 400,000 से अधिक लोगों की उपस्थिति थी। छिटपुट बारिश के बावजूद लगभग 32 कार्यक्रम बाहर प्रस्तुत किये गये। इसे इतिहास में अब तक के सबसे बड़े संगीत समारोहों में से एक माना जाता था |

- डॉली डेटासेट पर लामा 2 70बी टेक्स्ट जेनरेशन मॉडल को ठीक करने के परिणाम:

| निविष्टियां | वास्तविक्ता | नॉन-फाइन-ट्यून्ड मॉडल से प्रतिक्रिया | फाइन-ट्यून्ड मॉडल से प्रतिक्रिया |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। ऐसा उत्तर लिखें जो अनुरोध को उचित रूप से पूरा करता हो।nn### निर्देश:nकंपनी कौन है ABBnn### इनपुट:nABB लिमिटेड एक स्वीडिश-स्विस बहुराष्ट्रीय निगम है जिसका मुख्यालय ज्यूरिख, स्विट्जरलैंड में है। कंपनी का गठन 1988 में हुआ था जब स्वीडन की अल्लमन्ना स्वेन्स्का इलेक्ट्रिस्का अक्तीबोलागेट (एएसईए) और स्विटजरलैंड की ब्राउन, बोवेरी और सी का विलय होकर एएसईए ब्राउन बोवेरी बना, जिसे बाद में प्रारंभिक एबीबी में सरलीकृत किया गया। दोनों कंपनियां 1800 के अंत में स्थापित की गईं और प्रमुख विद्युत उपकरण निर्माता थीं, एक ऐसा व्यवसाय जिसमें एबीबी आज भी सक्रिय है। कंपनी ने तब से रोबोटिक्स और ऑटोमेशन टेक्नोलॉजी में भी विस्तार किया है।nnnn### प्रतिक्रिया:n | एबीबी लिमिटेड एक स्वीडिश-स्विस बहुराष्ट्रीय निगम है जिसका मुख्यालय ज्यूरिख, स्विट्जरलैंड में है। कंपनी का गठन 1988 में हुआ था जब स्वीडन की अल्लमन्ना स्वेन्स्का इलेक्ट्रिस्का अक्तीबोलागेट (ASEA) और स्विट्जरलैंड की ब्राउन, बोवेरी और सी का विलय होकर ASEA ब्राउन बोवेरी बनी, जिसे बाद में प्रारंभिक एबीबी में सरलीकृत किया गया। दोनों कंपनियां 1800 के दशक के अंत में स्थापित की गईं और प्रमुख विद्युत उपकरण निर्माता थीं, एक ऐसा व्यवसाय जिसमें एबीबी आज भी सक्रिय है। कंपनी ने तब से रोबोटिक्स और ऑटोमेशन तकनीक में भी विस्तार किया है। | *एबीबी एक स्वीडिश-स्विस बहुराष्ट्रीय निगम है### लॉगएनएंड I/O डेटा—n | एबीबी एक स्वीडिश-स्विस बहुराष्ट्रीय निगम है जिसका मुख्यालय ज्यूरिख, स्विट्जरलैंड में है। कंपनी का गठन 1988 में हुआ था जब स्वीडन की अल्लमन्ना स्वेन्स्का इलेक्ट्रिस्का अक्तीबोलागेट (एएसईए) और स्विटजरलैंड की ब्राउन, बोवेरी और सी का विलय होकर एएसईए ब्राउन बोवेरी बना, जिसे बाद में प्रारंभिक एबीबी में सरलीकृत किया गया। दोनों कंपनियां 1800 के अंत में स्थापित की गईं और थीं |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। इंग्लैंड की गद्दी निःसंतान एडवर्ड द कन्फ़ेसर के पास थी, जिसे एक बार उसके पहले चचेरे भाई ने हटा दिया था। अन्य संभावित दावेदार भी थे, जिनमें शक्तिशाली अंग्रेज अर्ल हेरोल्ड गॉडविंसन भी शामिल थे, जिन्हें एडवर्ड ने जनवरी 1050 में अपनी मृत्यु शय्या पर राजा के रूप में नामित किया था। यह तर्क देते हुए कि एडवर्ड ने पहले उन्हें सिंहासन देने का वादा किया था और हेरोल्ड ने उनके दावे का समर्थन करने की शपथ ली थी, विलियम ने एक बड़ा निर्माण किया बेड़े और सितंबर 1060 में इंग्लैंड पर आक्रमण किया। उन्होंने 1066 अक्टूबर 1066 को हेस्टिंग्स की लड़ाई में हेरोल्ड को निर्णायक रूप से हराया और मार डाला। आगे के सैन्य प्रयासों के बाद, विलियम को लंदन में क्रिसमस के दिन, 14 को राजा का ताज पहनाया गया। नॉर्मंडी लौटने से पहले उन्होंने 1066 की शुरुआत में इंग्लैंड के शासन की व्यवस्था की। इसके बाद कई असफल विद्रोह हुए, लेकिन 1066 तक इंग्लैंड पर विलियम की पकड़ लगभग सुरक्षित थी, जिससे उन्हें अपने शासनकाल का बड़ा हिस्सा महाद्वीपीय यूरोप में बिताने की अनुमति मिली।nnnn### प्रतिक्रिया:n | विलियम द कॉन्करर उत्तर पश्चिमी फ़्रांस में स्थित नॉर्मंडी से था। 1050 के दशक के अंत और 1060 के दशक की शुरुआत में इंग्लैंड के राजा एडवर्ड द कन्फेसर थे। एडवर्ड विलियम का चचेरा भाई था। चूँकि एडवर्ड निःसंतान था, ऐसे कई लोग थे जिन्होंने दावा किया कि वे ही असली उत्तराधिकारी हैं और उन्हें राजा बनना चाहिए। इन परस्पर विरोधी दावों ने सशस्त्र संघर्ष को जन्म दिया। विलियम ने इंग्लैंड पर आक्रमण किया, जहां उन्होंने अर्ल हेरोल्ड गॉडविंसन को हराकर हेस्टिंग्स की लड़ाई जीती। इसके बाद कई लड़ाइयाँ हुईं, लेकिन 1066 के अंत में विलियम इंग्लैंड के राजा बने। उन्होंने अगले दशक में कई विद्रोहों का सामना किया, लेकिन अपनी शक्ति बरकरार रखी। अंततः वह नॉर्मंडी लौटने और वहां से इंग्लैंड पर शासन करने में सक्षम हो गया। | विलियम द कॉन्करर 1050 और 1060 के दशक की शुरुआत में इंग्लैंड का राजा बन गया, वह निःसंतान एडवर्ड द कन्फेसर द्वारा रखे गए इंग्लैंड के सिंहासन का दावेदार बन गया, उसके पहले चचेरे भाई को एक बार हटा दिया गया था। एनएनएनरिस्पॉन्स खाली हो सकता है लेकिन 256 अक्षरों के भीतर फिट होना चाहिए। एन | 14 अक्टूबर, 1066 में हेस्टिंग्स की लड़ाई में राजा हेरोल्ड की मृत्यु के बाद, विलियम द कॉन्करर को क्रिसमस के दिन, 1066 को इंग्लैंड के राजा का ताज पहनाया गया, जिससे इंग्लैंड पर नॉर्मन विजय की स्थापना हुई। |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। वह 20,000 से अधिक जीआरटी के जहाजों की चौकड़ी में से चौथी थी, जिसे द बिग फोर कहा जाता था। यह जहाज चारों में से एकमात्र ऐसा जहाज था जो कभी भी दुनिया का सबसे बड़ा जहाज नहीं था। हालाँकि, वह बिग फोर में सबसे बड़ी, सबसे तेज़ और सबसे विलासितापूर्ण थी, एक इनडोर स्विमिंग पूल और एक तुर्की स्नानघर वाली पहली समुद्री जहाज़ थी। उसने पहले साउथेम्प्टन से न्यूयॉर्क तक के बिल्कुल नए मार्ग पर अपना करियर शुरू किया था। 1911 से उनकी बहन लिवरपूल से द्वितीयक मार्ग पर जहाज़ों में शामिल हुईं। वे वास्तव में धीमे लाइनर थे जिनका उद्देश्य मध्यम कीमतों पर सेवा प्रदान करना था। जब प्रथम विश्व युद्ध छिड़ा, तो एड्रियाटिक उन जहाजों में से था, जिन्होंने कई प्रावधानों को ले जाते हुए, अपनी नागरिक ट्रान्साटलांटिक सेवा जारी रखी। 1917 में, उसकी मांग की गई और उसे सैन्य परिवहन के रूप में सेवा दी गई। युद्ध के बाद, उसे कई बार परिष्कृत किया गया, और धीरे-धीरे क्रूज के लिए उपयोग किया जाने लगा, जो 1930 के दशक में उसकी मुख्य सेवा बन गई। 1934 में जब कनार्ड लाइन और व्हाइट स्टार लाइन का विलय हुआ, तो उसे तुरंत अनावश्यक समझा गया और वर्ष के अंत में बेच दिया गया। उन्हें 1935 में ओसाका में ख़त्म कर दिया गया था।nnnn### प्रतिक्रिया:n | आरएमएस एड्रियाटिक व्हाइट स्टार लाइन का एक ब्रिटिश महासागरीय जहाज था। वह 20,000 से अधिक जीआरटी के जहाजों की चौकड़ी में से चौथी थी, जिसे द बिग फोर कहा जाता था। यह जहाज चारों में से एकमात्र ऐसा जहाज था जो कभी भी दुनिया का सबसे बड़ा जहाज नहीं था। हालाँकि, वह बिग फोर में सबसे बड़ी, सबसे तेज़ और सबसे विलासितापूर्ण थी, एक इनडोर स्विमिंग पूल और एक तुर्की स्नानघर वाली पहली समुद्री जहाज़ थी। | आरएमएस एड्रियाटिक व्हाइट स्टार लाइन का एक ब्रिटिश महासागरीय जहाज था। वह 20,000 से अधिक जीआरटी के जहाजों की चौकड़ी में से चौथी थी, जिसे द बिग फोर कहा जाता था। यह जहाज चारों में से एकमात्र ऐसा जहाज था जो कभी भी दुनिया का सबसे बड़ा जहाज नहीं था। nn### Contextnइस प्रकार का प्रश्न आमतौर पर किसी खोज इंजन को क्वेरी करने के लिए उपयोग किया जाता है। इनपुट क्वेरी का इनपुट है, और प्रतिक्रिया जनता है | आरएमएस एड्रियाटिक व्हाइट स्टार लाइन का एक ब्रिटिश समुद्री जहाज था। उसे 1906 में लॉन्च किया गया था लेकिन उसकी पहली व्यावसायिक नौकायन 1907 में हुई थी। वह 20,000 टन से अधिक वजन वाले जहाजों की चौकड़ी में से चौथी थी और उसे बिग फोर कहा जाता था। अन्य तीन थे 1901 में आरएमएस सेल्टिक, 1903 में आरएमएस बाल्टिक और आर |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। GeV, 20 से 30 तक पृथ्वी की कक्षा में। वेधशाला में एक अंतरिक्ष यान में चार मुख्य दूरबीनें थीं, जो विभिन्न विशेष उप-उपकरणों और डिटेक्टरों सहित एक्स-रे और गामा किरणों को कवर करती थीं। 1991 वर्षों के प्रयास के बाद, वेधशाला को 2000 अप्रैल, 14 को एसटीएस-37 के दौरान स्पेस शटल अटलांटिस से लॉन्च किया गया था, और 5 जून, 1991 को इसकी कक्षा तक संचालित किया गया था। इसे 4 किमी (2000 मील) पर पृथ्वी की निचली कक्षा में तैनात किया गया था। वैन एलन विकिरण बेल्ट से बचें। यह 450 किलोग्राम (280 पाउंड) का उस समय उड़ाया गया अब तक का सबसे भारी खगोलीय पेलोड था।nnnn### प्रतिक्रिया:n | सीजीआरओ कॉम्पटन गामा रे वेधशाला (सीजीआरओ) है और 20 से 30 तक पृथ्वी में 1991 केवी से 2000 गीगावॉट तक की ऊर्जा वाले फोटॉनों का पता लगाने वाली एक अंतरिक्ष वेधशाला थी। | **प्रतिलेखक:** EGRET उपकरण फोटॉन.एनएन का पता लगाता है | कॉम्पटन गामा रे वेधशाला (सीजीआरओ) 20 केवी से 30 GeV.nn तक ऊर्जा वाले फोटॉनों को मापता है। |

| नीचे एक निर्देश है जो किसी कार्य का वर्णन करता है, जिसे एक इनपुट के साथ जोड़ा गया है जो आगे का संदर्भ प्रदान करता है। एक प्रतिक्रिया लिखें जो उचित रूप से अनुरोध को पूरा करती है। पियानोवादक उन्होंने पहली बार अक्टूबर 2 में 1986 साल की उम्र में अंतरराष्ट्रीय स्तर पर ध्यान आकर्षित किया, जब वह सियोल, डेजॉन और टोक्यो में अपने एशिया दौरे पर लोरिन माज़ेल के नेतृत्व में न्यूयॉर्क फिलहारमोनिक के साथ लिसटे पियानो कॉन्सर्टो नंबर 2004 का प्रदर्शन करने वाली एकल कलाकार के रूप में दिखाई दीं। बेटे ने फिर से माज़ेल और न्यूयॉर्क फिलहारमोनिक के साथ प्रदर्शन किया जब वे फरवरी 18 में सियोल आर्ट्स सेंटर में लौटे, इस बार बीथोवेन पियानो कॉन्सर्टो नंबर 1 के एकल कलाकार के रूप में। उनके पुरस्कारों में तेरहवीं वैन क्लिबर्न इंटरनेशनल पियानो प्रतियोगिता (2008) दोनों में रजत पदक शामिल हैं। ) और 2 अंतर्राष्ट्रीय त्चिकोवस्की प्रतियोगिता, जहां उन्हें सर्वश्रेष्ठ चैंबर कॉन्सर्टो प्रदर्शन और कमीशन्ड वर्क पुरस्कारों का सर्वश्रेष्ठ प्रदर्शन भी मिला। उन्होंने आर्थर रुबिनस्टीन अंतर्राष्ट्रीय पियानो मास्टर प्रतियोगिता (2009) में कांस्य पदक भी जीता nnnn### प्रतिक्रिया:n | येओल ईम सन (जन्म 2 मई 1986, वोनजू, दक्षिण कोरिया में) एक दक्षिण कोरियाई शास्त्रीय पियानोवादक हैं। उन्होंने पहली बार अक्टूबर 2004 में 18 साल की उम्र में अंतरराष्ट्रीय स्तर पर ध्यान आकर्षित किया, जब वह सियोल, डेजॉन और टोक्यो में अपने एशिया दौरे पर लोरिन माज़ेल के नेतृत्व में न्यूयॉर्क फिलहारमोनिक के साथ लिसटे पियानो कॉन्सर्टो नंबर 1 का प्रदर्शन करने वाली एकल कलाकार के रूप में दिखाई दीं। बेटे ने फिर से माज़ेल और न्यूयॉर्क फिलहारमोनिक के साथ प्रदर्शन किया जब वे फरवरी 2008 में सियोल आर्ट्स सेंटर में लौटे, इस बार बीथोवेन पियानो कॉन्सर्टो नंबर 2 के एकल कलाकार के रूप में। उनके पुरस्कारों में तेरहवीं वैन क्लिबर्न इंटरनेशनल पियानो प्रतियोगिता (2009) दोनों में रजत पदक शामिल हैं। ) और 2011 अंतर्राष्ट्रीय त्चिकोवस्की प्रतियोगिता, जहां उन्हें सर्वश्रेष्ठ चैंबर कॉन्सर्टो प्रदर्शन और कमीशन्ड वर्क पुरस्कारों का सर्वश्रेष्ठ प्रदर्शन भी मिला। उन्होंने आर्थर रुबिनस्टीन अंतर्राष्ट्रीय पियानो मास्टर प्रतियोगिता (2005) में कांस्य पदक भी जीता। | येओल ईम सोन एक कुशल पियानोवादक हैं, जिन्होंने दुनिया के कुछ सबसे प्रतिष्ठित ऑर्केस्ट्रा के साथ प्रदर्शन किया है। 2009 में, उन्होंने तेरहवीं वैन क्लिबर्न अंतर्राष्ट्रीय पियानो प्रतियोगिता में रजत पदक जीता और 2005 में उन्होंने आर्थर रुबिनस्टीन अंतर्राष्ट्रीय पियानो मास्टर प्रतियोगिता में कांस्य पदक जीता। वह दुनिया भर में शानदार प्रदर्शन करती रहती हैं। | येओल ईम सन एक बहुत अच्छे पियानोवादक हैं। उन्होंने 18 साल की उम्र में दुनिया के कुछ महानतम संगीतकारों के साथ अपने अंतरराष्ट्रीय करियर की शुरुआत की। और जब वह 25 साल की हुईं, तब तक वह दो अंतरराष्ट्रीय प्रतियोगिताओं में रजत पदक विजेता बन चुकी थीं। |

- डायलॉगसम डेटासेट पर लामा 2 7बी टेक्स्ट जेनरेशन मॉडल को ठीक करने के परिणाम:

| निविष्टियां | वास्तविक्ता | नॉन-फाइन-ट्यून्ड मॉडल से प्रतिक्रिया | फाइन-ट्यून्ड मॉडल से प्रतिक्रिया |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: यह एक बढ़िया भोजन है!n#व्यक्ति2#: धन्यवाद। मुझे खुशी है कि सब कुछ इतना अच्छा हुआ। चिकन व्यंजन?n#व्यक्ति1#: क्या यह बढ़िया नहीं है? वह चावल के साथ नारियल अदरक चिकन है। n#व्यक्ति2#: क्या सूप एक झींगा सूप है?n#व्यक्ति1#: हाँ, वहाँ समुद्री सब्जियों और नींबू घास के साथ झींगा भी है।n#व्यक्ति2#: मुझे लगता है कि मैं भाग्यशाली हूँ ऐसी वाइन चुनने में जो इस भोजन के साथ मिश्रित हो।n#Person1#: मैं वाइन लाने के लिए आपकी सराहना करता हूं। यह चिकन के साथ अच्छा लगता है। n—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति1# को लगता है कि #व्यक्ति2# द्वारा तैयार किया गया भोजन बहुत अच्छा है। #व्यक्ति2# व्यंजनों की सामग्री का परिचय देता है। | संवाद पूरा होने के बाद, व्यक्ति एकत्रित जानकारी पर उचित प्रतिक्रिया देगा। उदाहरण के लिए, व्यक्ति 1 कह सकता है,nn#व्यक्ति1#: यह बहुत अच्छा है! धन्यवाद.nn#Person2#: आपका बहुत-बहुत स्वागत है। मुझे लगा कि आपको अपना भोजन पसंद आएगा. मुझे ख़ुशी है कि आपने इसका आनंद लिया।nn—n— — — — –nnn### सारांश:nnn### प्रतिक्रिया:nसंवाद के बाद | #व्यक्ति1# और #व्यक्ति2# #व्यक्ति2# के स्थान पर भोजन करते हैं। वे भोजन और शराब के बारे में बात करते हैं जो चिकन के साथ मिश्रित होता है।एनएन |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: क्षमा करें, मैं प्राचीन ग्रीस के बारे में एक निबंध लिख रहा हूं। क्या इस विषय पर कोई किताबें हैं जिनकी आप अनुशंसा कर सकते हैं?n#Person2#: गीज़? आप प्राचीन कलहंस के बारे में लिखना चाहते हैं? मैंने ऐसी बात कभी नहीं सुनी. वैसे भी, यह कुछ जानवरों की किताब के साथ होगा, वह पंक्ति जे है। या आप विज्ञान का प्रयास करना चाहते हैं, वह पंक्ति जीएन#व्यक्ति1# में है: पशु? लेकिन ग्रीस एक देश है, कोई जानवर नहीं.n#Person2#: ओह, ग्रीस. खैर, आप जानते हैं, आज आपका भाग्यशाली दिन होना चाहिए। हमें अभी-अभी इसी विषय पर पुस्तकों का एक नया संग्रह प्राप्त हुआ है। यहाँ पंक्ति में लेखक हैं Cn#Person1#: मैं समझ गया। यह बहुत सारी किताबें हैं, आप किसे सुझाते हैं?n#Person2#: ठीक है, रॉबिन स्मिथ की पुस्तक उत्कृष्ट है लेकिन यह बहुत लंबी है। यह वही है जिसके कवर पर मूर्ति है। मिल्टन पाइक द्वारा भी एक है। इसमें सामने की तरफ एक सैनिक की पेंटिंग है। जैसा कि आप देख सकते हैं, यह बहुत गाढ़ा नहीं है, इसलिए इसे पढ़ने में अधिक समय नहीं लगेगा। लेकिन शायद सबसे अच्छी किताब वह है जिसमें प्राचीन ओलंपिक स्टेडियम की तस्वीर है। इसने कई ऐतिहासिक कार्य पुरस्कार जीते हैं। n#Person1#: ठीक है, यह तय करना कठिन है, लेकिन मुझे डर है कि मेरे पास बहुत कुछ पढ़ने के लिए पर्याप्त समय नहीं है। मुझे लगता है मुझे मिल्टन पाइक की किताब मिल जाएगी.n#Person2#: ठीक है. क्या मुझे आपका लाइब्रेरी कार्ड मिल सकता है?n#व्यक्ति1#: ज़रूर, आप यहाँ हैं।n—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति1# #व्यक्ति2# से प्राचीन ग्रीस पर कुछ पुस्तकों की अनुशंसा करने के लिए कहता है। #Person2# सुझाव देता है रॉबिन स्मिथ का जो बहुत लंबा है, मिल्टन पाइक का है जो बहुत मोटा नहीं है, और कई इतिहास जीतने वाले को पुरस्कार मिलता है। चूँकि #Person1# के पास पर्याप्त समय नहीं है, #Person1# को मिल्टन पाइक की पुस्तक मिलेगी। | n—nnसारांश:n | #व्यक्ति1# प्राचीन ग्रीस के बारे में एक निबंध लिख रहा है। #Person2# #Person1# को प्राचीन ग्रीस के बारे में उन पुस्तकों की अनुशंसा करता है जो सभी नई प्राप्त हुई हैं और मिल्टन पाइक.nn की पुस्तक प्राप्त करने का सुझाव देता है |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: ठीक है, मैं देख रहा हूं कि आपको अपनी किताबें मिल गई हैं, जॉर्ज। लेकिन क्या आप पढ़ रहे हैं? ऐसा लगता है कि आप बस रंग भर रहे हैं।n#Person2#: मैं पुस्तक के महत्वपूर्ण भागों को चिह्नित कर रहा हूं। रंग अलग-अलग चीज़ों के लिए हैं।n#व्यक्ति1#: क्या पसंद है?n#व्यक्ति2#: मुख्य विचार पीले हैं। याद रखने योग्य महत्वपूर्ण विवरण गुलाबी हैं और हल्का हरा कठिन विचारों के लिए है।n#व्यक्ति1#: यह बहुत सारी गतिविधियों की तरह लगता है। क्या आप अपना समय बर्बाद नहीं कर रहे हैं?n#व्यक्ति2#: मुझे ऐसा नहीं लगता, माँ। मैं यह सब आज रात पढ़ूंगा। मैं इसे कल सुनूंगा. और फिर जब अध्ययन का समय आएगा, तो मुझे अधिकांश जानकारी पहले से ही पता चल जाएगी। सक्रिय पढ़ना. और यह आपके द्वारा चुनी गई किसी भी गति से सीखने का सबसे अच्छा तरीका है।n#Person1#: मैं समझ गया। और यह नोटबुक किस लिए है?n#Person2#: वह नोट्स लेने के लिए है। आप किस तरह की बातें लिखते हैं?n#व्यक्ति1#: कभी-कभी मैं सारांश लिखता हूं। इस पृष्ठ पर मैं प्रश्न लिखता हूं। और निश्चित रूप से मेरे पास एक और पेज है जहां मैं नए शब्द लिखता हूं। n—nसारांश:nn### प्रतिक्रिया:n | जॉर्ज अपनी मां से कहता है कि किताब के महत्वपूर्ण हिस्सों को अलग-अलग रंगों में चिह्नित करना उसका सीखने का तरीका है। वह नोटबुक पर नोट्स भी लेता है और कभी-कभी सारांश भी लिखता है। | #व्यक्ति1#: ओह! सक्रिय रूप से पढ़ना, प्रश्न पढ़ना, शब्दावली नोट्स, सारांश और हाइलाइट करना। अब मैं देख सकता हूं कि सीखने की जानकारी के मामले में आपमें कितना अंतर है। मैं प्रभावित हूं.n#Person2#: धन्यवाद. पढ़ना नई जानकारी सीखने और याद रखने का सबसे अच्छा तरीका है। क्या आप अभी सक्रिय पठन का उपयोग कर रहे हैं?n#व्यक्ति1#: हम्म्म.. मुझे इसके बारे में सोचना होगा।nnn#व्यक्ति | जॉर्ज उन गतिविधियों का वर्णन करता है जो वह अपनी किताबें तेजी से पढ़ने के लिए कर रहा है। जॉर्ज माँ को नोटबुक दिखाता है और बताता है कि नोट्स कैसे लेने हैं।एनएन |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: सुप्रभात, महोदय। क्या मैं आपका पासपोर्ट देख सकता हूँ?n#Person2#: हाँ, बिल्कुल। यह यहाँ है.n#व्यक्ति1#: धन्यवाद. क्या ये सब आपके हैं?n#व्यक्ति2#: नहीं, इनमें से कुछ मेरे दोस्त के हैं। क्या आप भी उसका पासपोर्ट चाहते हैं?n#व्यक्ति1#: हाँ, कृपया। क्या आपके पास कोई कैरी-ऑन आइटम है? n#व्यक्ति2#: क्या आप चाहते हैं कि मैं इसे भी बेल्ट पर रखूं?n#व्यक्ति1#: हाँ, कृपया। क्या आप कृपया यह बड़ा सूटकेस खोलेंगे?n#व्यक्ति2#: ठीक है। बस एक पल। यह सिर्फ कुछ कपड़े और प्रसाधन सामग्री है।n#व्यक्ति1#: ठीक है। क्या आपके पास घोषित करने के लिए कुछ है?n#व्यक्ति2#: मुझे लगता है कि कुछ भी नहीं है।n#व्यक्ति1#: कोई ताजा भोजन, जीवित पौधे, या जानवर?n#व्यक्ति2#: ओह, नहीं। इनमें से कुछ भी नहीं.n#व्यक्ति1#: धन्यवाद. आप अपना सूटकेस बंद कर सकते हैं। ये रहे आपके पासपोर्ट.n#Person2#: बहुत बहुत धन्यवाद.n—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति1# #व्यक्ति2# और #व्यक्ति2# के मित्र का पासपोर्ट देखता है और उनके सामान की जांच करता है। #Person2# #Person1# को बताता है कि उनके पास घोषित करने के लिए कुछ भी नहीं है। #व्यक्ति1# उन्हें जाने देता है। | > मुझे लगता है कि कुछ भी नहीं है। nnn—n**श्रेणियाँ:**nn- [बातचीत (32)](../बातचीत/32.md)n - [TSA (4)](../बातचीत/32/ 4.एमडी)एनएन### कुंजी:एनएन :सूचना_स्रोत: 31 (टीएसए)एन:सूचना_स्रोत: 32 (टीएसए)एनएन—-एन* कोई कॉपीराइट | आव्रजन अधिकारी #व्यक्ति2# से अपना पासपोर्ट दिखाने और अपना बड़ा सूटकेस खोलने के लिए कहता है। #व्यक्ति2# के पास घोषित करने के लिए कुछ नहीं है और वह अपना सूटकेस बंद कर सकता है।एनएन |

| इस संवाद को संक्षेप में प्रस्तुत करें:n#व्यक्ति1#: चीनी चाय पूरी दुनिया में प्रसिद्ध है। मैं कई डिब्बे खरीदना चाहता हूं।n#Person2#: चीन में विभिन्न प्रकार की चाय हैं। यह स्वाद और प्रभाव पर निर्भर करता है।n#Person1#: ठीक है, मैं चीनी चाय बिल्कुल नहीं जानता।n#Person2#: यह ग्रीन टी है, आप इसे गर्मियों में पी सकते हैं। यह गर्मी से राहत दिला सकता है और यह आपके फेफड़ों को स्वस्थ रखने के लिए अच्छा है।n#Person1#: दिलचस्प लगता है। इसके बारे में क्या?n#व्यक्ति2#: यह काली चाय है, इसका स्वाद तीखा है और पाचन को बढ़ावा देता है।n#व्यक्ति1#: यह क्या है? इसकी खुशबू सुगंधित है।n#Person2#: यह उच्च गुणवत्ता वाली चमेली की चाय है। यह सुगंधित है और इसका स्वाद भी अच्छा है।n#व्यक्ति1#: मैं चमेली की चाय लूंगा। क्या आप इसे रैपिंग पेपर और रिबन के साथ पैक कर सकते हैं? यह मेरे दोस्त के लिए एक उपहार है।n#Person2#: कोई समस्या नहीं। एक पल रुकें.n—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति2# उस #व्यक्ति1# को हरी चाय, काली टी और चमेली टी की सिफारिश करता है जो चीनी चाय खरीदना चाहता है और #व्यक्ति1# चमेली चाय लेने का फैसला करता है। | #[अंग्रेजी]#: चीनी चाय पूरी दुनिया में मशहूर है। मैं कई बक्से खरीदना चाहता हूं।n#[फ़्रेंच]#: या तो अलग-अलग प्रकार के चिनॉइस एयू भुगतान करता है। सी'एस्ट सेलोन ले गोट, एट लेस इफ़ेट्स क्व'ऑन वेउट ओब्टेनिर.एन#[स्पेनिश]#: एल ते चिनो एस मुय फेमसोस, टेंगो क्यू कॉम्प्रार वेरियस कैजस.एन#[जर्मन]#: इच मो | #व्यक्ति1# विभिन्न प्रकार की चाय के साथ, चीनी चाय के कई डिब्बे खरीदना चाहता है। #Person2# #Person1# को चयन करने में मदद करता है और इसे पैक करेगा।nn |

- डायलॉगसम डेटासेट पर लामा-2 13बी मॉडल को फाइन-ट्यूनिंग करने के परिणाम:

| निविष्टियां | वास्तविक्ता | नॉन-फाइन-ट्यून्ड मॉडल से प्रतिक्रिया | फाइन-ट्यून्ड मॉडल से प्रतिक्रिया |

| इस संवाद को सारांशित करें:n#Person1#: श्रीमती थॉम्पसन एक बार ईश्वरवादी थीं, जेसन.n#Person2#: क्यों? हमें परेशानी या कुछ और नहीं होना चाहिए? वास्तव में आज सुबह पूरी कक्षा चर्चा के दौरान हम अत्यधिक सक्रिय थे।n#व्यक्ति1#: बस इतना ही। मुझे नहीं लगता कि यह बिल्कुल भी बुरी बात है। मुझे लगता है कि वह हमें क्लास मॉनिटर के लिए दौड़ने के लिए कहेगी।n#Person2#: वाह! वास्तव में? यह बहुत बड़ी ज़िम्मेदारी है।n#व्यक्ति1#: ठीक है, मुझे लगता है कि आप इसमें बहुत अच्छे होंगे। इसके अलावा, ऐसा करने के लिए कहा जाना एक बड़ा सम्मान है। इसका मतलब है कि श्रीमती थॉम्पसन हमें नेताओं के रूप में देखती हैं। n#Person2#: हालाँकि, मुझे यकीन नहीं है कि मैं इसे स्वयं कर सकता हूँ। क्या हम इसे एक साथ कर सकते हैं?n#व्यक्ति1#: आइए श्रीमती थॉम्पसन से पूछें। अब मैंने उसे दालान से अंदर आते हुए सुना। n—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति1# ने जेसन मिसेज थॉम्पसन को एक बार ईश्वरवादी बताया और #व्यक्ति1# ने अनुमान लगाया कि वह चाहती है कि वे क्लास मॉनिटर के लिए दौड़ें। वे श्रीमती थॉम्पसन से पूछेंगे कि क्या वे एक साथ ऐसा कर सकते हैं। | n* जब शिक्षक ने जेसन और उसके सहपाठी से पूछा कि क्या वे क्लास मॉनिटर के लिए दौड़ना चाहते हैं, तो वह और उसके सहपाठी एक साथ इस पर सहमत हुए। दोनों लड़के ईसाई हैं, लेकिन वे कक्षा में दोस्त नहीं हैं। n* यीशु में उनका विश्वास सार्वजनिक रूप से साझा नहीं किया जा सकता है, लेकिन यह प्रार्थना और दूसरों की मदद करने और प्यार दिखाने के लिए एक साथ चलने वाले उदाहरण के माध्यम से स्पष्ट है। n-n## 1654nn **[स्थिति:** छात्र हाल के बारे में बात कर रहे हैं | श्रीमती थॉम्पसन ने जेसन और जेम्स को क्लास मॉनिटर के लिए दौड़ने के लिए कहा क्योंकि उन्हें लगता है कि वे नेता हैं |

| इस संवाद को संक्षेप में प्रस्तुत करें:n#व्यक्ति1#: अरे, चलो वहां से हटें और उस घर को देखें।n#व्यक्ति2#: हां, वह बहुत अच्छा लग रहा है! क्या यह हमारी ओपन हाउस सूची में है?n#व्यक्ति1#: हाँ, यह हमारी सूची में है।n#व्यक्ति2#: खैर, यह किनारे से बहुत अच्छा दिखता है। चलिए अंदर चलते हैं.n#Person1#: चलिए रजिस्ट्री पर हस्ताक्षर करते हैं. रियाल्टार इस समय कुछ व्यस्त लग रहा है। घर के बारे में जानकारी वाला एक फ़्लायर। और पच्चीस हज़ारn—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति1# और #व्यक्ति2# एक घर देखने आते हैं। वे अंदर की जांच करते हैं और इसकी कीमत के बारे में बात करते हैं। | यह निम्नलिखित उत्तेजना के लिए एक एएमआई प्रतिक्रिया है। व्यक्ति 2: हाँ, यह बहुत अच्छा लग रहा है! क्या यह हमारी ओपन हाउस सूची में है? हाँ, यह हमारी सूची में है। खैर, यह किनारे से बहुत अच्छा दिखता है। चलिए अंदर चलते हैं, रजिस्ट्री पर हस्ताक्षर करते हैं। रियाल्टार इस समय कुछ व्यस्त लग रहा है। ठीक है, चलो आगे चलकर रसोई की जाँच करें। अरे देखो, उनके पास कुछ है | #Person1# और #Person2# एक ऐसे घर की तलाश कर रहे हैं जो उनकी ओपन हाउस सूची में है। वे एक रजिस्ट्री पर हस्ताक्षर करते हैं और #व्यक्ति2# #व्यक्ति1# को जानकारी के साथ एक फ़्लायर लेने के लिए कहता है।एनएन |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: आप कैसे हैं, श्रीमान विल्सन? मैं टीना.एन#व्यक्ति2#: आपसे मिलकर खुशी हुई, श्रीमती टीना.एन#व्यक्ति1#: कृपया बैठिए। मुझे पता है कि फोर्सर के हमारे रोजगार ने आपको पहले ही आपके कर्मचारी अनुबंध के बारे में जानकारी दे दी है, लेकिन मैं हस्ताक्षर करने से पहले मुख्य विवरणों पर फिर से गौर करना चाहूंगा। सबसे पहले, आपको मासिक वेतन मिलेगा, जिसमें एक साल की सेवा के बाद एक महीने की सवैतनिक छुट्टी होगी। n#Person2#: यही मैं समझता हूं।n#Person1#: ड्यूटी के दौरान आपको हमारी चिकित्सा योजना द्वारा कवर किया जाएगा। चूंकि आप मध्य प्रबंधन होंगे, इसलिए आपसे सामान्य कामकाजी घंटों से 1 घंटे पहले तक उपलब्ध रहने की उम्मीद की जाती है। इससे अधिक स्वीकृत समय का डेढ़ गुना भुगतान किया जाएगा, जिसे आप वेतन या छुट्टी के रूप में ले सकते हैं। . कोई भी लंबी बीमारी बीमा द्वारा कवर की जाएगी। क्या आपने अनुबंध की अन्य शर्तें पढ़ी हैं?n#व्यक्ति5#: हां, मैंने पढ़ी है।एन#व्यक्ति2#: क्या आपके पास कोई अन्य प्रश्न हैं?n#व्यक्ति1#: सिर्फ एक। मैंने फ्लेक्स-टाइम के बारे में एक आइटम देखा। क्या यह मेरे लिए एक संभावना है?n#Person2#: हाँ, यह है, लेकिन आपको अपने प्रबंधक के साथ विवरण पर चर्चा करनी होगी।n#Person1#: यह स्वीकार्य है।n#Person2#: अच्छा। अब, यदि आप यहां केवल हस्ताक्षर करेंगे, तो आप 1 दिनों में काम शुरू कर सकते हैं।n—nसारांश:nn### प्रतिक्रिया:n | श्री विल्सन टीना को रोजगार अनुबंध के बारे में प्रारंभिक जानकारी का वर्णन करते हैं। उन्होंने मासिक वेतन, एक महीने की वैतनिक छुट्टी, चिकित्सा योजना, विस्तारित काम के घंटे और फ्लेक्स-टाइम का उल्लेख किया है। | नहीं, सारांश सही नहीं हैं। #Person1 संवाद यह नहीं कहते कि नाम टीना है, वे अपना परिचय नहीं देते हैं। मुझे लगता है कि वे दोनों एक-दूसरे के नाम जानते हैं, इसलिए इसकी आवश्यकता नहीं है। मुझे लगता है कि अगर बाकी सब कुछ सही है, तो सारांश नहीं बदलेगा, जब तक कि #Person1 समाप्त न हो जाए, और यह ठीक है।nn | टीना के कर्मचारी अनुबंध के मुख्य विवरण जानने के लिए टीना श्री विल्सन से मिलती है। दोनों मासिक वेतन और चिकित्सा योजना पर चर्चा करते हैं। टीना के पास कोई प्रश्न नहीं है और वह 3 दिन में काम शुरू कर देगी |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: जैक, आपका पसंदीदा विषय क्या है?n#व्यक्ति2#: मेरा पसंदीदा विषय? खैर, मुझे लगता है कि मुझे विज्ञान पसंद है। हां, विज्ञान, मुझे यह बहुत दिलचस्प लगता है। विज्ञान शिक्षक विषय को बहुत रोमांचक बनाते हैं। आपके बारे में क्या?n#व्यक्ति1#: मैं गणित की परीक्षाओं में हमेशा बहुत अच्छा प्रदर्शन करता हूं। मुझे भूगोल भी पसंद है. मुझे लोगों और उन जगहों के बारे में सीखना पसंद है जहां वे रहते हैं। क्या कोई ऐसा विषय है जो आपको जैक पसंद नहीं है?n#Person2#: मुझे भौतिकी बहुत पसंद नहीं है। इसे समझना आसान नहीं है, ज़्यादातर बच्चे इससे ऊब चुके हैं।n—nसारांश:nn### प्रतिक्रिया:n | जैक का पसंदीदा विषय विज्ञान है जबकि उसे भौतिकी ज्यादा पसंद नहीं है। #व्यक्ति1# को गणित और भूगोल पसंद है। | n—nn### शब्द: "पसंदीदा" (adj)nnअर्थ: दूसरों से अधिक प्यार किया, सराहना की nउदाहरण: मेरी पसंदीदा पुस्तक बाइबिल है; तुम्हारा प्रिय खेल क्या है?; मेरा पसंदीदा रंग नीला है.nn—nnnn### आपका ____ विषय क्या है? (औपचारिक)प्रश्न और उत्तर संवाद:n#व्यक्ति1#: आपका पसंदीदा विषय क्या है?n# | जैक और जैक अपने पसंदीदा और सबसे कम पसंद किए जाने वाले विषयों के बारे में बात कर रहे हैं।एनएन |

| इस संवाद को सारांशित करें:n#Person1#: नमस्ते, मैगी। मैंने वर्ष के अंत में स्कूल कला प्रदर्शनी में आपकी पेंटिंग देखी, जिसमें सभी माता-पिता गए थे। यह बहुत अच्छा था। n#व्यक्ति2#: ठीक है, हमारे कला शिक्षक वास्तव में इससे प्रसन्न लग रहे थे, लेकिन मुझे यकीन नहीं है कि माता-पिता ने इसके बारे में क्या सोचा था।n#व्यक्ति1#: ओह, चिंता मत करो। मैंने उन्हें इसके बारे में केवल अच्छी बातें कहते हुए सुना है। : नहीं, लेकिन मैंने किया। लेकिन इसके बारे में कुछ भी करने के लिए बहुत देर हो चुकी थी। ख़ैर, उम्मीद है अगली बार मैं कुछ बेहतर करूँगा।n—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति1# ने मैगी की पेंटिंग देखी और सोचा कि यह बहुत अच्छी थी, लेकिन मैगी को चिंता है कि उसने सही रंगों का उपयोग नहीं किया और उसे उम्मीद है कि वह अगली बार कुछ बेहतर करेगी। | इस सारांश में चर्चा के प्रमुख बिंदुओं और निष्कर्षों पर प्रकाश डाला जाना चाहिए।nn# व्यक्ति 1 का जवाब दें:n[प्रतिक्रिया सारांश]nn—n### प्रतिक्रिया:nइस सारांश में चर्चा के प्रमुख बिंदुओं और निष्कर्षों पर प्रकाश डाला जाना चाहिए।nn# व्यक्ति2 का जवाब दें :n[प्रतिक्रिया सारांश]nn### व्यक्ति1:n[व्यक्ति1 सारांश]n—n### व्यक्ति2:n[व्यक्ति2 सारांश]nn### व्यक्ति—n | #व्यक्ति1# ने मैगी की पेंटिंग देखी और मैगी को बताया कि बहुत से माता-पिता ने मैगी की पेंटिंग के बारे में बहुत अच्छी बातें कही हैं। मैगी ऐसा नहीं सोचती.nn |

- डायलॉगसम डेटासेट पर लामा 2 70बी मॉडल को फाइन-ट्यूनिंग करने के परिणाम:

| निविष्टियां | वास्तविक्ता | नॉन-फाइन-ट्यून्ड मॉडल से प्रतिक्रिया | फाइन-ट्यून्ड मॉडल से प्रतिक्रिया |

| इस संवाद को सारांशित करें:n#Person1#: क्या आपने कोई डिग्री प्राप्त की है?n#Person2#: हाँ। 1996 में मैंने हेब्स विश्वविद्यालय से विज्ञान स्नातक की डिग्री प्राप्त की, और 2001 में मैंने पेकिंग विश्वविद्यालय से एमबीए की डिग्री प्राप्त की। मेरा कुल जीपीए 1 पैमाने पर 2 था, जो मेरी कक्षा में सबसे अधिक था।एन#व्यक्ति9#: यह बहुत प्रभावशाली है। आपको कौन सा कोर्स सबसे ज्यादा पसंद आया?n#Person10#: अंग्रेजी। यह दिलचस्प और उपयोगी दोनों था, इसलिए मैंने इसमें बहुत रुचि दिखाई। n#व्यक्ति1#: क्या आप मुझे बता सकते हैं कि जब आप स्नातक छात्र थे तो आपने अपना विषय क्यों बदल लिया?n#व्यक्ति2#: क्योंकि मुझे प्रशासन में बहुत रुचि है और मैंने इसमें कुछ कोर्स किये। मैंने विषयों में भी अच्छा प्रदर्शन किया। इसलिए मेरा मानना है कि मैं इस पद पर अच्छा काम कर सकता हूं।n#Person1#: क्या आपको कॉलेज में कोई सम्मान और पुरस्कार मिला?n#Person2#: हां। मुझे हर साल विश्वविद्यालय से छात्रवृत्ति प्रदान की जाती थी। 1 में मैंने गणित मॉडल की राष्ट्रीय प्रतियोगिता में भाग लिया और पुरस्कार जीता। n—nसारांश:nn### प्रतिक्रिया:n | #व्यक्ति1# #व्यक्ति2# का साक्षात्कार लेता है और #व्यक्ति2# से कुछ प्रश्न पूछता है, जिसमें #व्यक्ति2# की डिग्री, शैक्षणिक रिकॉर्ड, पसंदीदा पाठ्यक्रम और कॉलेज में पुरस्कार शामिल हैं। #Person2# #Person1# को यह भी बताता है कि #Person2# ने प्रमुख को प्रशासन में क्यों बदल दिया। | उम्मीदवार ने संक्षेप में बताया कि बातचीत का मुख्य विचार यह था कि उसे दो डिग्रियाँ प्राप्त हुईं, 0. और बड़ी कंपनियों ने अच्छा प्रदर्शन किया। हालाँकि, उनका पहला वाक्य आत्ममुग्धता के अलावा कोई अधिक भावना प्रदान नहीं करता है, न ही यह बताता है कि उनका अनुभव कंपनी के लिए प्रासंगिक क्यों है। वह बेहतर संबंध बना सकता है और शायद सारांश को "पेशेवर" के अलावा किसी अन्य अंतर्निहित भावना/रवैये के साथ समाप्त कर सकता है (जैसा कि वह संवाद में करता है)। | #Person2# बताता है #Person1# #Person2# ने स्नातक की डिग्री और एमबीए प्राप्त किया है। #Person2# का GPA #Person2# की श्रेणी में सबसे अधिक है और #Person2# की रुचि प्रशासन में है। #Person2# को कॉलेज.एनएन में कुछ सम्मान और पुरस्कार भी मिले |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: क्षमा करें, यह कौन सी सामग्री है? n#Person2#: राखी. तुम्हें कुछ चाहिए? n#व्यक्ति1#: नहीं, सूती कपड़े कहाँ हैं? n#Person2#: मैं तुम्हें दिखाऊंगा. n#व्यक्ति1#: धोने के बाद सिकुड़न दर क्या है? n#व्यक्ति2#: 5% से कम। यह काफी टिकाऊ है. n—nसारांश:nn### प्रतिक्रिया:n | #Person2# बताता है #Person1# सूती कपड़े टिकाऊ होते हैं। | रूट QA41913 के लिए, इस अनुभाग में संवाद का एक पैराग्राफ सारांश होना चाहिए ताकि, उदाहरण के लिए, एक स्वचालित उच्चारण और भाषण पीढ़ी प्रणाली आउटपुट संश्लेषण के लिए इस पाठ का उपयोग कर सके। | #व्यक्ति1# कुछ सूती कपड़ा चाहता है। #Person2# कुछ rhaki.nn दिखाता है |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: क्षमा करें, मुझे देर हो गई, टॉम.एन#व्यक्ति2#: सब ठीक है, रीता। आप कहाँ थे?n#व्यक्ति1#: पुलिस स्टेशन में। मेरा हैंडबैग खो गया है. या शायद किसी ने इसे ले लिया है. मुझे नहीं पता.n#Person2#: ओह, नहीं. क्या हुआ? बैठ जाओ। क्या इसमें कुछ महत्वपूर्ण था?n#व्यक्ति1#: महत्वपूर्ण! मेरी चेकबुक, सभी कागज़ात जो मुझे काम के लिए चाहिए।n#Person2#: ओह, यह भयानक है। लेकिन आपने इसे कैसे खो दिया?n#व्यक्ति1#: ठीक है, जैसा कि आप जानते हैं, मैं पूरी सुबह एक दोस्त के साथ था और हमने साथ में दोपहर का भोजन किया। दोपहर का भोजन करने के बाद, मैं खरीदारी करने गया। और जब मैं कुछ खरीदना चाहता था तो मुझे अपनी चेकबुक नहीं मिलती थी। फिर मुझे याद आया कि ये तो मेरे हैंडबैग में था. और मेरा हैंडबैग मेरी कार में था।n#व्यक्ति2#: तो आप अपनी कार में वापस चले गए।एन#व्यक्ति1#: लेकिन मुझे वह वहां नहीं मिला।एन#व्यक्ति2#: और आप पुलिस स्टेशन गए? व्यक्ति1#: तुरंत नहीं. पुलिस स्टेशन जाने से पहले मैंने अपने दोस्त के कार्यालय में फोन किया। कोई भाग्य नहीं।n#व्यक्ति2#: आपको उस रेस्तरां में जाना चाहिए जहां आपने दोपहर का भोजन किया था और उसे ढूंढना चाहिए।एन#व्यक्ति1#: ओह, मुझे ऐसा करना चाहिए था।एन#व्यक्ति2#: अब बेहतर होगा कि आप मैनेजर को सीधे फोन करें दूर.n—nसारांश:nn### प्रतिक्रिया:n | रीटा टॉम को बताती है कि उसे देर हो गई है क्योंकि उसने अपना हैंडबैग खो दिया है और वह हैंडबैग खोजने की कोशिश कर रही है। टॉम ने रीटा को उस रेस्तरां में जाने और उसे ढूंढने का सुझाव दिया जहां उसने दोपहर का भोजन किया था। | आपको जो शब्द संयोजन सबसे अच्छा लगे उसका उपयोग करके प्रत्येक वाक्य का अंग्रेजी में अनुवाद करें:n### मान:n | रीटा ने अपना हैंडबैग खो दिया है और टॉम उसे उसे ढूंढने के लिए उस रेस्तरां में जाने की सलाह देता है जहां उसने दोपहर का भोजन किया था |

| इस संवाद को सारांशित करें:n#व्यक्ति1#: सुबह, माँ!n#व्यक्ति2#: सुबह, मेग। आज आप ठीक नहीं लग रहे? क्या आप बीमार हैं? मुझे बताओ क्या हुआ.n#व्यक्ति1#: मैं. . मैं परीक्षा उत्तीर्ण करने में असफल रहा। काश मैंने मेहनत से पढ़ाई की होती.n#Person2#: ओह. आराम से लो। आप आज से ही अपना लक्ष्य निर्धारित कर सकते हैं।n#व्यक्ति1#: ठीक है माँ। मैं अगली बार परीक्षा में असफल नहीं होऊंगा। n—nसारांश:nn### प्रतिक्रिया:n | मेग मूड में नहीं है क्योंकि वह परीक्षा में फेल हो गई है। उसकी माँ उसे आज से ही अपना लक्ष्य निर्धारित करने के लिए प्रोत्साहित करती है। | क्रिया के बिना सहायता, क्रिया की मात्रा के अनुसार प्रत्यक्ष वस्तु | #व्यक्ति1# परीक्षा उत्तीर्ण करने में असफल रहा और उसने माँ को इसके बारे में बताया। माँ #व्यक्ति1# को कठिन अध्ययन करने के लिए प्रोत्साहित करती है।एनएन |

| इस संवाद को संक्षेप में प्रस्तुत करें:n#व्यक्ति1#: हर कोई आर्थिक रूप से कमजोर होना चाहता है। यदि आप अमीर होकर सेवानिवृत्त होने की योजना बना रहे हैं तो आपको अपनी बचत अवश्य निवेश करनी चाहिए। मैं स्टॉक खरीदने के बारे में सोच रहा हूं। अगर मैं अच्छे से प्रबंधन कर सका तो यह एक अच्छा निवेश हो सकता है। आप क्या कहते हैं?n#व्यक्ति2#: मैं आंशिक रूप से आपसे सहमत हूं। स्टॉक खरीदना मुश्किल नहीं है, लेकिन स्टॉक खरीदकर लगातार पैसा कमाना बहुत मुश्किल है। यहां तक कि पेशेवरों को भी यह आसान नहीं लगता, इसलिए सावधान रहें। वैसे भी, हम जैसे लोगों को निवेश में मदद की ज़रूरत है। कुछ ऑनलाइन शोध क्यों नहीं करते? लोगों को निवेश करने के तरीके के बारे में शिक्षित करने के लिए डेटा, रिपोर्ट और चर्चा मंच मौजूद हैं। इसके अलावा, आपको एक स्थापित वेबसाइट पर जाना होगा जो स्टॉक चार्ट प्रदान करती है। n#Person1#: वाह, आप बहुत पेशेवर लगते हैं।n#Person2#: मैंने अभी पिछले सप्ताहांत में निवेश टीवी कार्यक्रम देखा था। ये इन दिनों काफी हॉट टॉपिक बना हुआ है. असल में मैं नौसिखिया भी नहीं हूं.n-nसारांश:nn### प्रतिक्रिया:n | #Person1# और #Person2# स्टॉक खरीदने के बारे में बात कर रहे हैं। #Person2# सोचता है कि इस तरह से लगातार पैसा कमाना कठिन है और निवेश के बारे में जानने के लिए ऑनलाइन शोध करने का सुझाव देता है। | nमैं पहले सुझाई गई निवेश रणनीति से सहमत हूं। ऐसी योजना बनाने में मुझे काफी समय और ऊर्जा लगी। यह बहुत अच्छा है कि मेरे निर्णय पर इस हद तक भरोसा किया गया है। वास्तव में, मेरा सहकर्मी सुरक्षित महसूस कर सकता है, क्योंकि मैं इस टीम को उज्ज्वल और सुरक्षित सेवानिवृत्ति भविष्य की ओर ले जाने के लिए सब कुछ करूंगा। मैं टीम के एक सक्रिय सदस्य के रूप में आपकी भूमिका की प्रतीक्षा कर रहा हूँ। | #व्यक्ति1# स्टॉक खरीदना चाहता है लेकिन #व्यक्ति2# #व्यक्ति1# को सावधान रहने को कहता है क्योंकि निवेश करना कठिन है। #Person2# का सुझाव है कि #Person1# ऑनलाइन शोध करें, स्थापित वेबसाइटों पर जाएँ और निवेश कार्यक्रम देखें।nn |

डेटासेट फ़ॉर्मेटिंग

वर्तमान में हम दो प्रकार की फाइन-ट्यूनिंग प्रदान करते हैं: निर्देश फाइन-ट्यूनिंग और डोमेन अनुकूलन फाइन-ट्यूनिंग। आप पैरामीटर निर्दिष्ट करके आसानी से किसी एक प्रशिक्षण विधि पर स्विच कर सकते हैं instruction_tuned जैसा 'True''False'.

डोमेन अनुकूलन प्रारूप

टेक्स्ट जनरेशन मॉडल को किसी डोमेन-विशिष्ट डेटासेट पर भी ठीक किया जा सकता है। डोमेन-विशिष्ट डेटासेट पर इसे ठीक करने के बाद, मॉडल से डोमेन-विशिष्ट टेक्स्ट उत्पन्न करने और कुछ-शॉट प्रॉम्प्टिंग के साथ उस विशिष्ट डोमेन में विभिन्न एनएलपी कार्यों को हल करने की उम्मीद की जाती है।

मॉडल में इनपुट के लिए, एक प्रशिक्षण और वैकल्पिक सत्यापन निर्देशिका का उपयोग करें। प्रत्येक निर्देशिका में एक CSV, JSON, या TXT फ़ाइल होती है। CSV और JSON फ़ाइलों के लिए, ट्रेन या सत्यापन डेटा का उपयोग टेक्स्ट नामक कॉलम से या यदि कोई कॉलम नहीं कहा जाता है तो पहले कॉलम से किया जाता है text पाया जाता है। ट्रेन और सत्यापन के अंतर्गत फ़ाइलों की संख्या (यदि प्रदान की गई है) क्रमशः 1 के बराबर होनी चाहिए।

आउटपुट एक प्रशिक्षित मॉडल है जिसे अनुमान के लिए तैनात किया जा सकता है।

टेक्स्ट जनरेशन मॉडल को फाइन-ट्यून करने के लिए TXT फ़ाइल का एक उदाहरण निम्नलिखित है। TXT फ़ाइल 2021-2022 तक अमेज़न की SEC फाइलिंग है:

अनुदेश फाइन-ट्यूनिंग

टेक्स्ट जनरेशन मॉडल को किसी भी टेक्स्ट डेटा पर निर्देश-ट्यून किया जा सकता है, बशर्ते कि डेटा अपेक्षित प्रारूप में हो। अनुदेश-ट्यूनेड मॉडल को अनुमान के लिए आगे तैनात किया जा सकता है।

इनपुट के लिए, एक प्रशिक्षण और वैकल्पिक सत्यापन निर्देशिका का उपयोग करें। ट्रेन और सत्यापन निर्देशिकाओं में एक या एकाधिक JSON लाइनें (.jsonl) स्वरूपित फ़ाइलें होनी चाहिए। विशेष रूप से, ट्रेन निर्देशिका में इनपुट और आउटपुट स्वरूपों का वर्णन करने वाली एक वैकल्पिक *.json फ़ाइल भी हो सकती है।