परिचय

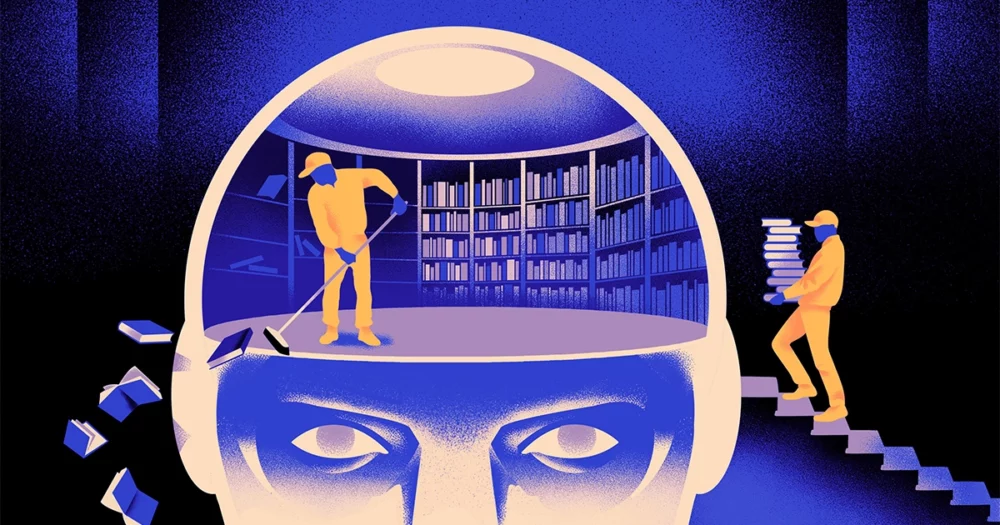

कंप्यूटर वैज्ञानिकों की एक टीम ने एक बनाया है फुर्तीला, अधिक लचीला प्रकार मशीन लर्निंग मॉडल का. तरकीब: इसे समय-समय पर यह भूल जाना चाहिए कि यह क्या जानता है। और जबकि यह नया दृष्टिकोण सबसे बड़े ऐप्स के अंतर्गत आने वाले विशाल मॉडलों को विस्थापित नहीं करेगा, यह इस बारे में और अधिक खुलासा कर सकता है कि ये प्रोग्राम भाषा को कैसे समझते हैं।

नया शोध "क्षेत्र में एक महत्वपूर्ण प्रगति" का प्रतीक है जिया क्वोन, दक्षिण कोरिया में इंस्टीट्यूट फॉर बेसिक साइंस में एक एआई इंजीनियर।

आज उपयोग में आने वाले AI भाषा इंजन अधिकतर किसके द्वारा संचालित होते हैं कृत्रिम तंत्रिका प्रसार. नेटवर्क में प्रत्येक "न्यूरॉन" एक गणितीय कार्य है जो ऐसे अन्य न्यूरॉन्स से संकेत प्राप्त करता है, कुछ गणना चलाता है और न्यूरॉन्स की कई परतों के माध्यम से संकेत भेजता है। प्रारंभ में सूचना का प्रवाह कमोबेश यादृच्छिक होता है, लेकिन प्रशिक्षण के माध्यम से, जैसे-जैसे नेटवर्क प्रशिक्षण डेटा के अनुकूल होता है, न्यूरॉन्स के बीच सूचना प्रवाह में सुधार होता है। यदि कोई एआई शोधकर्ता एक द्विभाषी मॉडल बनाना चाहता है, उदाहरण के लिए, वह दोनों भाषाओं के पाठ के एक बड़े ढेर के साथ मॉडल को प्रशिक्षित करेगा, जो न्यूरॉन्स के बीच कनेक्शन को इस तरह से समायोजित करेगा कि पाठ को एक भाषा में समकक्ष के साथ जोड़ा जा सके। दूसरे में शब्द.

लेकिन इस प्रशिक्षण प्रक्रिया में बहुत अधिक कंप्यूटिंग शक्ति लगती है। यदि मॉडल बहुत अच्छी तरह से काम नहीं करता है, या यदि उपयोगकर्ता की ज़रूरतें बाद में बदल जाती हैं, तो इसे अनुकूलित करना कठिन है। "मान लीजिए कि आपके पास एक मॉडल है जिसमें 100 भाषाएँ हैं, लेकिन कल्पना करें कि आप जो एक भाषा चाहते हैं वह इसमें शामिल नहीं है," उन्होंने कहा मिकेल आर्टेटेक्स, नए शोध के सह-लेखक और एआई स्टार्टअप रेका के संस्थापक। "आप शून्य से शुरुआत कर सकते हैं, लेकिन यह आदर्श नहीं है।"

आर्टेटेक्स और उनके सहयोगियों ने इन सीमाओं को दरकिनार करने की कोशिश की है। कुछ साल पहले, आर्टेटेक्स और अन्य ने एक तंत्रिका नेटवर्क को एक भाषा में प्रशिक्षित किया, फिर शब्दों के निर्माण खंडों, जिन्हें टोकन कहा जाता है, के बारे में जो कुछ भी वह जानता था उसे मिटा दिया। इन्हें तंत्रिका नेटवर्क की पहली परत में संग्रहीत किया जाता है, जिसे एम्बेडिंग परत कहा जाता है। उन्होंने मॉडल की अन्य सभी परतों को अकेला छोड़ दिया। पहली भाषा के टोकन मिटाने के बाद, उन्होंने मॉडल को दूसरी भाषा पर फिर से प्रशिक्षित किया, जिसने एम्बेडिंग परत को उस भाषा के नए टोकन से भर दिया।

भले ही मॉडल में बेमेल जानकारी थी, पुनर्प्रशिक्षण ने काम किया: मॉडल नई भाषा सीख सकता था और संसाधित कर सकता था। शोधकर्ताओं ने अनुमान लगाया कि जहां एम्बेडिंग परत भाषा में प्रयुक्त शब्दों के लिए विशिष्ट जानकारी संग्रहीत करती है, वहीं नेटवर्क के गहरे स्तर मानव भाषाओं के पीछे की अवधारणाओं के बारे में अधिक अमूर्त जानकारी संग्रहीत करते हैं, जिससे मॉडल को दूसरी भाषा सीखने में मदद मिलती है।

“हम एक ही दुनिया में रहते हैं। हम अलग-अलग भाषाओं में अलग-अलग शब्दों के साथ एक ही चीज़ की संकल्पना करते हैं, ऐसा कहा यिहोंग चेन, हालिया पेपर के प्रमुख लेखक। “यही कारण है कि आपके पास मॉडल में वही उच्च-स्तरीय तर्क है। सेब सिर्फ एक शब्द नहीं बल्कि कुछ मीठा और रसदार है।”

परिचय

हालाँकि यह भूलने का दृष्टिकोण पहले से ही प्रशिक्षित मॉडल में एक नई भाषा जोड़ने का एक प्रभावी तरीका था, फिर भी पुनः प्रशिक्षण की मांग थी - इसके लिए बहुत सारे भाषाई डेटा और प्रसंस्करण शक्ति की आवश्यकता थी। चेन ने एक सुधार का सुझाव दिया: प्रशिक्षण के बजाय, एम्बेडिंग परत को मिटाना, फिर पुनः प्रशिक्षण देना, उन्हें प्रशिक्षण के प्रारंभिक दौर के दौरान समय-समय पर एम्बेडिंग परत को रीसेट करना चाहिए। आर्टेटेक्स ने कहा, "ऐसा करने से, पूरा मॉडल रीसेट करने का आदी हो जाता है।" "इसका मतलब है कि जब आप मॉडल को किसी अन्य भाषा में विस्तारित करना चाहते हैं, तो यह आसान है, क्योंकि आप यही कर रहे हैं।"

शोधकर्ताओं ने आमतौर पर इस्तेमाल किया जाने वाला भाषा मॉडल लिया जिसे कहा जाता है रोबर्टा, इसे अपनी आवधिक-विस्मृति तकनीक का उपयोग करके प्रशिक्षित किया, और इसकी तुलना उसी मॉडल के प्रदर्शन से की जब इसे मानक, गैर-विस्मृति दृष्टिकोण के साथ प्रशिक्षित किया गया था। भूलने के मॉडल ने पारंपरिक मॉडल की तुलना में थोड़ा खराब प्रदर्शन किया, भाषा सटीकता के एक सामान्य माप पर 85.1 की तुलना में 86.1 का स्कोर प्राप्त किया। फिर उन्होंने पहले प्रशिक्षण के दौरान उपयोग किए गए 5 बिलियन के बजाय केवल 70 मिलियन टोकन के बहुत छोटे डेटा सेट का उपयोग करके अन्य भाषाओं में मॉडलों को फिर से प्रशिक्षित किया। मानक मॉडल की सटीकता घटकर औसतन 53.3 हो गई, लेकिन भूलने वाले मॉडल की सटीकता घटकर केवल 62.7 रह गई।

यदि टीम ने पुनः प्रशिक्षण के दौरान कम्प्यूटेशनल सीमाएँ लगाईं तो भूलने का मॉडल भी बेहतर प्रदर्शन करता है। जब शोधकर्ताओं ने प्रशिक्षण की लंबाई 125,000 कदमों से घटाकर केवल 5,000 कर दी, तो भूलने वाले मॉडल की सटीकता औसतन 57.8 तक कम हो गई, जबकि मानक मॉडल 37.2 तक गिर गया, जो यादृच्छिक अनुमानों से बेहतर नहीं है।

परिचय

टीम ने निष्कर्ष निकाला कि समय-समय पर भूलने से आम तौर पर भाषा सीखने का मॉडल बेहतर हो जाता है। "क्योंकि (वे) प्रशिक्षण के दौरान भूलते रहते हैं और पुनः सीखते रहते हैं, बाद में नेटवर्क को कुछ नया सिखाना आसान हो जाता है," कहा एवगेनी निकिशिन, क्यूबेक में एक गहन शिक्षण अनुसंधान केंद्र, मिला में एक शोधकर्ता। इससे पता चलता है कि जब भाषा मॉडल किसी भाषा को समझते हैं, तो वे ऐसा केवल व्यक्तिगत शब्दों के अर्थों की तुलना में अधिक गहरे स्तर पर करते हैं।

यह दृष्टिकोण हमारे दिमाग के काम करने के तरीके के समान है। “सामान्य तौर पर मानव स्मृति बड़ी मात्रा में विस्तृत जानकारी को सटीक रूप से संग्रहीत करने में बहुत अच्छी नहीं है। इसके बजाय, मनुष्य हमारे अनुभवों के सार को याद रखते हैं, अमूर्त करते हैं और विस्तार करते हैं,'' ने कहा बेंजामिन लेवी, सैन फ्रांसिस्को विश्वविद्यालय में एक तंत्रिका विज्ञानी। "एआई को अधिक मानवीय प्रक्रियाओं, जैसे अनुकूली भूलने, के साथ सक्षम करना, उन्हें अधिक लचीला प्रदर्शन प्राप्त करने का एक तरीका है।"

समझ कैसे काम करती है इसके बारे में यह क्या कह सकता है इसके अलावा, आर्टेटेक्स को उम्मीद है कि अधिक लचीले भूलने वाले भाषा मॉडल भी नवीनतम एआई सफलताओं को और अधिक भाषाओं में लाने में मदद कर सकते हैं। हालांकि एआई मॉडल स्पेनिश और अंग्रेजी, दो भाषाओं के साथ पर्याप्त प्रशिक्षण सामग्री को संभालने में अच्छे हैं, मॉडल अपनी मूल बास्क, पूर्वोत्तर स्पेन के लिए विशिष्ट स्थानीय भाषा के साथ इतने अच्छे नहीं हैं। उन्होंने कहा, "बड़ी तकनीकी कंपनियों के अधिकांश मॉडल इसे अच्छी तरह से नहीं करते हैं।" "मौजूदा मॉडलों को बास्क में अपनाना ही रास्ता है।"

चेन भी ऐसी दुनिया की आशा करता है जहां अधिक एआई फूल खिलें। “मैं एक ऐसी स्थिति के बारे में सोच रहा हूं जहां दुनिया को एक बड़े भाषा मॉडल की आवश्यकता नहीं है। हमारे पास बहुत सारे हैं,” उसने कहा। “यदि भाषा मॉडल बनाने वाली कोई फ़ैक्टरी है, तो आपको इस प्रकार की तकनीक की आवश्यकता है। इसका एक आधार मॉडल है जो जल्दी से नए डोमेन के लिए अनुकूल हो सकता है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :हैस

- :है

- :नहीं

- :कहाँ

- ][पी

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- About

- अमूर्त

- शुद्धता

- सही रूप में

- अनुकूलन

- अनुकूली

- अनुकूलन

- जोड़ना

- इसके अलावा

- उन्नत

- बाद

- AI

- एआई मॉडल

- सब

- अकेला

- पहले ही

- भी

- राशियाँ

- an

- और

- अन्य

- Apple

- दृष्टिकोण

- क्षुधा

- हैं

- AS

- At

- लेखक

- औसत

- आधार

- बुनियादी

- क्योंकि

- हो जाता है

- किया गया

- पीछे

- बेहतर

- के बीच

- बड़ा

- बड़ी तकनीक

- सबसे बड़ा

- बिलियन

- ब्लॉक

- फूल का खिलना

- के छात्रों

- सफलताओं

- लाना

- इमारत

- लेकिन

- by

- गणना

- बुलाया

- कर सकते हैं

- केंद्र

- परिवर्तन

- चेन

- गतिरोध उत्पन्न

- सह-लेखक

- सहयोगियों

- सामान्य

- सामान्यतः

- कंपनियों

- तुलना

- कम्प्यूटेशनल

- कंप्यूटर

- कंप्यूटिंग

- संगणन शक्ति

- अवधारणाओं

- निष्कर्ष निकाला

- कनेक्शन

- निहित

- परम्परागत

- सका

- कवर

- बनाना

- बनाया

- कट गया

- तिथि

- डेटा सेट

- की कमी हुई

- गहरा

- ध्यान लगा के पढ़ना या सीखना

- और गहरा

- मांग

- विस्तृत

- डीआईडी

- विभिन्न

- do

- नहीं करता है

- कर

- डोमेन

- dont

- गिरा

- दौरान

- से प्रत्येक

- आसान

- प्रभावी

- embedding

- इंजीनियर

- इंजन

- अंग्रेज़ी

- संपूर्ण

- बराबर

- उदाहरण

- मौजूदा

- अनुभव

- विस्तार

- कारखाना

- कुछ

- खेत

- भरा हुआ

- प्रथम

- लचीला

- प्रवाह

- के लिए

- आगे

- संस्थापक

- फ्रांसिस्को

- से

- समारोह

- सामान्य जानकारी

- आम तौर पर

- मिल

- GitHub

- Go

- अच्छा

- हैंडलिंग

- कठिन

- है

- he

- मदद

- मदद की

- उच्च स्तर

- उसके

- उम्मीद है

- कैसे

- HTTPS

- विशाल

- मानव

- लगती और ना

- मनुष्य

- आदर्श

- if

- कल्पना करना

- लगाया गया

- सुधार

- in

- व्यक्ति

- करें-

- प्रारंभिक

- शुरू में

- बजाय

- संस्थान

- IT

- केवल

- रखना

- बच्चा

- जानता है

- कोरिया

- भाषा

- भाषाऐं

- बड़ा

- बाद में

- ताज़ा

- परत

- परतों

- नेतृत्व

- जानें

- सीख रहा हूँ

- बाएं

- लंबाई

- कम

- स्तर

- स्तर

- पसंद

- सीमाओं

- सीमाएं

- जीना

- स्थानीय

- लग रहा है

- लॉट

- मशीन

- यंत्र अधिगम

- पत्रिका

- बनाना

- निर्माण

- बहुत

- सामग्री

- गणितीय

- अर्थ

- साधन

- माप

- याद

- हो सकता है

- दस लाख

- आदर्श

- मॉडल

- अधिक

- अधिकतर

- बहुत

- विभिन्न

- चाहिए

- देशी

- आवश्यकता

- की जरूरत है

- नेटवर्क

- तंत्रिका

- तंत्रिका नेटवर्क

- न्यूरॉन्स

- नया

- नहीं

- of

- on

- ONE

- केवल

- or

- अन्य

- अन्य

- हमारी

- के ऊपर

- अपना

- काग़ज़

- प्रदर्शन

- समय-समय

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- कूद पड़े

- बिजली

- संचालित

- प्रक्रिया

- प्रक्रियाओं

- प्रसंस्करण

- प्रसंस्करण शक्ति

- प्रोग्राम्स

- क्वांटमगाज़ी

- क्यूबैक

- जल्दी से

- बिना सोचे समझे

- बल्कि

- प्राप्त

- प्राप्त

- हाल

- याद

- अपेक्षित

- अनुसंधान

- शोधकर्ता

- शोधकर्ताओं

- प्रकट

- दौर

- चलाता है

- कहा

- वही

- सेन

- सैन फ्रांसिस्को

- कहना

- विज्ञान

- वैज्ञानिकों

- स्कोर

- खरोंच

- दूसरा

- लगता है

- चयनात्मक

- भेजता

- सेट

- वह

- चाहिए

- संकेत

- महत्वपूर्ण

- समान

- स्थिति

- छोटे

- So

- कुछ

- कुछ

- दक्षिण

- दक्षिण कोरिया

- स्पेन

- स्पेनिश

- विशिष्ट

- मानक

- प्रारंभ

- स्टार्टअप

- कदम

- फिर भी

- संग्रहित

- भंडारण

- ऐसा

- पता चलता है

- मीठा

- लेता है

- शिक्षण

- टीम

- तकनीक

- तकनीकी कंपनियों

- तकनीक

- टेक्नोलॉजी

- करते हैं

- टेक्स्ट

- से

- कि

- RSI

- जानकारी

- दुनिया

- लेकिन हाल ही

- उन

- फिर

- इन

- वे

- चीज़ें

- विचारधारा

- इसका

- हालांकि?

- यहाँ

- सेवा मेरे

- आज

- टोकन

- ले गया

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- चाल

- कोशिश

- tweak

- दो

- समझना

- समझ

- विश्वविद्यालय

- उपयोग

- प्रयुक्त

- का उपयोग

- बहुत

- करना चाहते हैं

- चाहता है

- था

- मार्ग..

- we

- webp

- कुंआ

- क्या

- कब

- कौन कौन से

- जब

- क्यों

- साथ में

- शब्द

- शब्द

- काम

- काम किया

- कार्य

- विश्व

- बदतर

- होगा

- साल

- आप

- जेफिरनेट