अमेज़न SageMaker पाइपलाइन डेटा वैज्ञानिकों और मशीन लर्निंग (एमएल) इंजीनियरों को प्रशिक्षण वर्कफ़्लो को स्वचालित करने की अनुमति देता है, जो आपको तेजी से प्रयोग और मॉडल पुनर्प्रशिक्षण के लिए मॉडल विकास चरणों को व्यवस्थित करने के लिए एक दोहराने योग्य प्रक्रिया बनाने में मदद करता है। आप डेटा तैयार करने, फीचर इंजीनियरिंग, मॉडल प्रशिक्षण, मॉडल ट्यूनिंग और मॉडल सत्यापन सहित संपूर्ण मॉडल बिल्ड वर्कफ़्लो को स्वचालित कर सकते हैं और इसे मॉडल रजिस्ट्री में सूचीबद्ध कर सकते हैं। आप पाइपलाइनों को नियमित अंतराल पर स्वचालित रूप से चलाने के लिए कॉन्फ़िगर कर सकते हैं या जब कुछ ईवेंट ट्रिगर होते हैं, या आप उन्हें आवश्यकतानुसार मैन्युअल रूप से चला सकते हैं।

इस पोस्ट में, हम कुछ संवर्द्धन पर प्रकाश डालते हैं अमेज़न SageMaker एसडीके और अमेज़ॅन सेजमेकर पाइपलाइनों की नई विशेषताएं पेश करें जो एमएल प्रैक्टिशनरों के लिए एमएल मॉडल बनाने और प्रशिक्षित करने में आसान बनाती हैं।

पाइपलाइन अपने डेवलपर अनुभव को नया करना जारी रखती है, और इन हालिया रिलीज के साथ, अब आप सेवा का अधिक अनुकूलित तरीके से उपयोग कर सकते हैं:

- 2.99.0, 2.101.1, 2.102.0, 2.104.0 - अद्यतन दस्तावेज़ीकरण

PipelineVariableअनुमानक, प्रोसेसर, ट्यूनर, ट्रांसफॉर्मर, और मॉडल बेस क्लास, अमेज़ॅन मॉडल और फ्रेमवर्क मॉडल के लिए उपयोग। अनुमानकों और प्रोसेसर के सभी उपवर्गों का समर्थन करने के लिए एसडीके के नए संस्करणों के साथ अतिरिक्त बदलाव आने वाले हैं। - 2.90.0 - की उपलब्धता मॉडलस्टेप एकीकृत मॉडल संसाधन निर्माण और पंजीकरण कार्यों के लिए।

- 2.88.2 - की उपलब्धता पाइपलाइन सत्र सेजमेकर संस्थाओं और संसाधनों के साथ प्रबंधित बातचीत के लिए।

- 2.88.2 - के लिए उपवर्ग अनुकूलता कार्यप्रवाह पाइपलाइन कार्य चरण ताकि आप जॉब एब्स्ट्रैक्शन बना सकें और प्रोसेसिंग, ट्रेनिंग, ट्रांसफॉर्म और ट्यूनिंग जॉब को कॉन्फ़िगर और चला सकें, जैसा कि आप बिना पाइपलाइन के करेंगे।

- 2.76.0 - की उपलब्धता फ़ेलस्टेप एक विफलता स्थिति के साथ एक पाइपलाइन को सशर्त रूप से रोकने के लिए।

इस पोस्ट में, हम आपको नमूना डेटासेट का उपयोग करके वर्कफ़्लो के माध्यम से चलते हैं, जिसमें मॉडल निर्माण और परिनियोजन पर ध्यान केंद्रित किया जाता है ताकि यह प्रदर्शित किया जा सके कि पाइपलाइनों की नई सुविधाओं को कैसे लागू किया जाए। अंत तक, आपके पास इन नई सुविधाओं का सफलतापूर्वक उपयोग करने और अपने एमएल वर्कलोड को सरल बनाने के लिए पर्याप्त जानकारी होनी चाहिए।

सुविधाएँ अवलोकन

पाइपलाइन निम्नलिखित नई सुविधाएँ प्रदान करती है:

- पाइपलाइन चर एनोटेशन - कुछ विधि पैरामीटर कई इनपुट प्रकारों को स्वीकार करते हैं, जिनमें शामिल हैं

PipelineVariables, और अतिरिक्त दस्तावेज़ीकरण जोड़ा गया है ताकि स्पष्ट किया जा सके कि कहाँPipelineVariablesसेजमेकर एसडीके प्रलेखन के नवीनतम स्थिर संस्करण और कार्यों के इनिट हस्ताक्षर दोनों में समर्थित हैं। उदाहरण के लिए, निम्नलिखित TensorFlow अनुमानक में, init हस्ताक्षर अब दिखाता है किmodel_dirऔरimage_uriसमर्थनPipelineVariables, जबकि अन्य पैरामीटर नहीं हैं। अधिक जानकारी के लिए देखें टेंसरफ्लो अनुमानक.- पहले:

- बाद:

- पाइपलाइन सत्र - पाइपलाइन सत्र सेजमेकर एसडीके में एकता लाने के लिए शुरू की गई एक नई अवधारणा है और पाइपलाइन संसाधनों के आलसी आरंभीकरण का परिचय देती है (रन कॉल कैप्चर की जाती हैं लेकिन पाइपलाइन बनने और चलने तक नहीं चलती हैं)।

PipelineSessionप्रसंग इनहेरिट करता हैSageMakerSessionऔर आपके लिए अन्य सेजमेकर संस्थाओं और संसाधनों के साथ बातचीत करने के लिए सुविधाजनक तरीके लागू करता है, जैसे प्रशिक्षण कार्य, समापन बिंदु, और में संग्रहीत इनपुट डेटासेट अमेज़न सरल भंडारण सेवा (अमेज़न S3)। - वर्कफ़्लो पाइपलाइन कार्य चरणों के साथ उपवर्ग संगतता - अब आप जॉब एब्स्ट्रैक्शन बना सकते हैं और प्रोसेसिंग, ट्रेनिंग, ट्रांसफॉर्म और ट्यूनिंग जॉब को कॉन्फ़िगर और चला सकते हैं जैसे आप बिना पाइपलाइन के करेंगे।

- उदाहरण के लिए, के साथ एक प्रसंस्करण चरण बनाना

SKLearnProcessorपहले निम्नलिखित की आवश्यकता थी: - जैसा कि हम पिछले कोड में देखते हैं,

ProcessingStepमूल रूप से वही प्रीप्रोसेसिंग तर्क करने की आवश्यकता है.run, काम शुरू करने के लिए एपीआई कॉल शुरू किए बिना। लेकिन उपवर्ग संगतता के साथ अब कार्यप्रवाह पाइपलाइन कार्य चरणों के साथ सक्षम किया गया है, हम घोषित करते हैंstep_argsतर्क जो प्रीप्रोसेसिंग तर्क को .run के साथ लेता है ताकि आप नौकरी अमूर्त बना सकें और इसे कॉन्फ़िगर कर सकें क्योंकि आप इसे पाइपलाइनों के बिना उपयोग करेंगे। हम भी में गुजरते हैंpipeline_sessionहै, जो एक हैPipelineSessionवस्तु, के बजायsagemaker_sessionयह सुनिश्चित करने के लिए कि रन कॉल कैप्चर की जाती हैं लेकिन पाइपलाइन बनने और चलने तक कॉल नहीं की जाती हैं। निम्नलिखित कोड देखें:

- उदाहरण के लिए, के साथ एक प्रसंस्करण चरण बनाना

- मॉडल चरण (मॉडल निर्माण और पंजीकरण चरणों के साथ एक सुव्यवस्थित दृष्टिकोण) -पाइपलाइन सेजमेकर मॉडल के साथ एकीकृत करने के लिए दो चरण प्रकार प्रदान करता है:

CreateModelStepऔरRegisterModel. अब आप केवल का उपयोग करके दोनों को प्राप्त कर सकते हैंModelStepप्रकार। ध्यान दें कि एPipelineSessionइसे हासिल करने के लिए आवश्यक है। यह पाइपलाइन चरणों और एसडीके के बीच समानता लाता है।- पहले:

-

- बाद:

- विफल चरण (पाइपलाइन चलाने की सशर्त रोक) -

FailStepयदि कोई शर्त पूरी होती है तो पाइपलाइन को विफलता की स्थिति के साथ रोकने की अनुमति देता है, जैसे कि मॉडल स्कोर एक निश्चित सीमा से नीचे है।

समाधान अवलोकन

इस समाधान में, आपका प्रवेश बिंदु है अमेज़ॅन सैजमेकर स्टूडियो तेजी से प्रयोग के लिए एकीकृत विकास पर्यावरण (आईडीई)। स्टूडियो एंड-टू-एंड पाइपलाइन अनुभव को प्रबंधित करने के लिए एक वातावरण प्रदान करता है। स्टूडियो के साथ, आप इसे बायपास कर सकते हैं एडब्ल्यूएस प्रबंधन कंसोल आपके संपूर्ण वर्कफ़्लो प्रबंधन के लिए। स्टूडियो के भीतर से पाइपलाइनों के प्रबंधन के बारे में अधिक जानकारी के लिए देखें सेजमेकर स्टूडियो में सेजमेकर पाइपलाइन देखें, ट्रैक करें और निष्पादित करें.

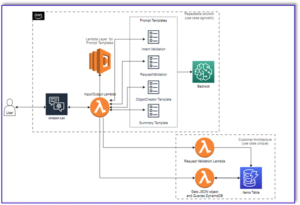

निम्नलिखित आरेख नई सुविधाओं का उपयोग करके प्रशिक्षण और अनुमान उत्पन्न करने के लिए विभिन्न चरणों के साथ एमएल वर्कफ़्लो के उच्च-स्तरीय आर्किटेक्चर को दिखाता है।

पाइपलाइन में निम्नलिखित चरण शामिल हैं:

- आवश्यक सुविधाओं के निर्माण के लिए डेटा को प्रीप्रोसेस करें और डेटा को ट्रेन, सत्यापन और परीक्षण डेटासेट में विभाजित करें।

- SageMaker XGBoost फ्रेमवर्क के साथ एक प्रशिक्षण कार्य बनाएँ।

- परीक्षण डेटासेट का उपयोग करके प्रशिक्षित मॉडल का मूल्यांकन करें।

- जांचें कि क्या एयूसी स्कोर पूर्वनिर्धारित सीमा से ऊपर है।

- यदि एयूसी स्कोर थ्रेशोल्ड से कम है, तो पाइपलाइन चलाना बंद करें और इसे विफल के रूप में चिह्नित करें।

- यदि एयूसी स्कोर थ्रेशोल्ड से अधिक है, तो सेजमेकर मॉडल बनाएं और इसे सेजमेकर मॉडल रजिस्ट्री में पंजीकृत करें।

- पिछले चरण में बनाए गए मॉडल का उपयोग करके दिए गए डेटासेट पर बैच परिवर्तन लागू करें।

.. पूर्वापेक्षाएँ

इस पोस्ट के साथ अनुसरण करने के लिए, आपको a . के साथ एक AWS खाते की आवश्यकता है स्टूडियो डोमेन.

पाइपलाइन सीधे सेजमेकर संस्थाओं और संसाधनों के साथ एकीकृत है, इसलिए आपको किसी अन्य एडब्ल्यूएस सेवाओं के साथ बातचीत करने की आवश्यकता नहीं है। आपको किसी संसाधन का प्रबंधन करने की भी आवश्यकता नहीं है क्योंकि यह पूरी तरह से प्रबंधित सेवा है, जिसका अर्थ है कि यह आपके लिए संसाधनों का निर्माण और प्रबंधन करती है। विभिन्न सेजमेकर घटकों के बारे में अधिक जानकारी के लिए, जो स्टूडियो के एकीकृत घटकों के साथ-साथ स्टैंडअलोन पायथन एपीआई दोनों हैं, देखें सेजमेकर उत्पाद पृष्ठ.

आरंभ करने से पहले, निम्नलिखित कोड स्निपेट का उपयोग करके स्टूडियो नोटबुक में सेजमेकर एसडीके संस्करण>= 2.104.0 और xlrd>=1.0.0 स्थापित करें:

एमएल वर्कफ़्लो

इस पोस्ट के लिए, आप निम्नलिखित घटकों का उपयोग करते हैं:

- डेटा तैयारी

- SageMaker प्रसंस्करण - सेजमेकर प्रोसेसिंग एक पूरी तरह से प्रबंधित सेवा है जो आपको एमएल वर्कलोड के लिए कस्टम डेटा ट्रांसफॉर्मेशन और फीचर इंजीनियरिंग चलाने की अनुमति देती है।

- प्रतिरूप निर्माण

- मॉडल प्रशिक्षण और मूल्यांकन

- एक-क्लिक प्रशिक्षण - सेजमेकर ने प्रशिक्षण सुविधा वितरित की। सेजमेकर डेटा समानता और मॉडल समानता के लिए वितरित प्रशिक्षण पुस्तकालय प्रदान करता है। पुस्तकालयों को सेजमेकर प्रशिक्षण वातावरण के लिए अनुकूलित किया गया है, आपके वितरित प्रशिक्षण कार्यों को सेजमेकर के अनुकूल बनाने में मदद करता है, और प्रशिक्षण की गति और थ्रूपुट में सुधार करता है।

- SageMaker प्रयोग - प्रयोग सेजमेकर की एक क्षमता है जो आपको अपने एमएल पुनरावृत्तियों को व्यवस्थित, ट्रैक, तुलना और मूल्यांकन करने देती है।

- SageMaker बैच परिवर्तन - बैच ट्रांसफॉर्म या ऑफलाइन स्कोरिंग सेजमेकर में एक प्रबंधित सेवा है जो आपको अपने एमएल मॉडल का उपयोग करके बड़े डेटासेट पर भविष्यवाणी करने देती है।

- वर्कफ़्लो ऑर्केस्ट्रेशन

एक सेजमेकर पाइपलाइन एक JSON पाइपलाइन परिभाषा द्वारा परिभाषित इंटरकनेक्टेड चरणों की एक श्रृंखला है। यह एक निर्देशित एसाइक्लिक ग्राफ (DAG) का उपयोग करके एक पाइपलाइन को एन्कोड करता है। DAG पाइपलाइन के प्रत्येक चरण के लिए आवश्यकताओं और संबंधों के बारे में जानकारी देता है, और इसकी संरचना चरणों के बीच डेटा निर्भरता द्वारा निर्धारित की जाती है। ये निर्भरताएँ तब बनती हैं जब किसी चरण के आउटपुट के गुण दूसरे चरण के इनपुट के रूप में पास किए जाते हैं।

निम्नलिखित आरेख सेजमेकर पाइपलाइन (मंथन भविष्यवाणी उपयोग के मामले के लिए) में विभिन्न चरणों को दिखाता है, जहां चरणों के बीच के कनेक्शन को सेजमेकर द्वारा चरण परिभाषाओं द्वारा परिभाषित इनपुट और आउटपुट के आधार पर अनुमानित किया जाता है।

अगले खंड पाइपलाइन के प्रत्येक चरण को बनाने और एक बार बनाई गई पूरी पाइपलाइन को चलाने के माध्यम से चलते हैं।

परियोजना की संरचना

आइए परियोजना संरचना से शुरू करें:

- /एसएम-पाइपलाइन्स-एंड-टू-एंड-उदाहरण - परियोजना का नाम

- /डेटा - डेटासेट

- /पाइपलाइन - पाइपलाइन घटकों के लिए कोड फ़ाइलें

- /ग्राहक मंथन

- प्रीप्रोसेस.py

- मूल्यांकन.py

- /ग्राहक मंथन

- सेजमेकर-पाइपलाइन-प्रोजेक्ट.ipynb - पाइपलाइन की नई सुविधाओं का उपयोग करके मॉडलिंग वर्कफ़्लो के माध्यम से चलने वाली एक नोटबुक

डेटासेट डाउनलोड करें

इस पोस्ट का अनुसरण करने के लिए, आपको डाउनलोड करने और सहेजने की आवश्यकता है नमूना डेटासेट प्रोजेक्ट होम निर्देशिका के भीतर डेटा फ़ोल्डर के अंतर्गत, जो फ़ाइल को सहेजता है अमेज़ॅन इलास्टिक फ़ाइल सिस्टम (अमेज़ॅन ईएफएस) स्टूडियो पर्यावरण के भीतर।

पाइपलाइन घटकों का निर्माण

अब आप पाइपलाइन घटकों के निर्माण के लिए तैयार हैं।

बयान आयात करें और पैरामीटर और स्थिरांक घोषित करें

नामक एक स्टूडियो नोटबुक बनाएं sagemaker-pipelines-project.ipynb प्रोजेक्ट होम निर्देशिका के भीतर। सेल में निम्नलिखित कोड ब्लॉक दर्ज करें, और सेजमेकर और एस3 क्लाइंट ऑब्जेक्ट सेट करने के लिए सेल चलाएँ, बनाएँ PipelineSession, और S3 बकेट लोकेशन को SageMaker सत्र के साथ आने वाली डिफ़ॉल्ट बकेट का उपयोग करके सेट करें:

पाइपलाइन पैरामीटरकरण का समर्थन करती है, जो आपको अपना पाइपलाइन कोड बदले बिना रनटाइम पर इनपुट पैरामीटर निर्दिष्ट करने की अनुमति देती है। आप के तहत उपलब्ध मॉड्यूल का उपयोग कर सकते हैं sagemaker.workflow.parameters मॉड्यूल, जैसे ParameterInteger, ParameterFloat, तथा ParameterString, विभिन्न डेटा प्रकारों के पाइपलाइन पैरामीटर निर्दिष्ट करने के लिए। एकाधिक इनपुट पैरामीटर सेट करने के लिए निम्न कोड चलाएँ:

बैच डेटासेट जनरेट करें

बैच डेटासेट जनरेट करें, जिसका उपयोग आप बाद में बैच ट्रांसफ़ॉर्म चरण में करते हैं:

डेटा को S3 बकेट में अपलोड करें

डेटासेट को Amazon S3 पर अपलोड करें:

प्रोसेसिंग स्क्रिप्ट और प्रोसेसिंग स्टेप को परिभाषित करें

इस चरण में, आप फीचर इंजीनियरिंग, एक हॉट एन्कोडिंग करने के लिए एक पायथन स्क्रिप्ट तैयार करते हैं, और मॉडल निर्माण के लिए उपयोग किए जाने वाले प्रशिक्षण, सत्यापन और परीक्षण विभाजन को क्यूरेट करते हैं। अपनी प्रोसेसिंग स्क्रिप्ट बनाने के लिए निम्न कोड चलाएँ:

इसके बाद, प्रोसेसर को इंस्टेंट करने के लिए निम्न कोड ब्लॉक चलाएँ और प्रोसेसिंग स्क्रिप्ट को चलाने के लिए पाइपलाइन चरण। क्योंकि प्रसंस्करण स्क्रिप्ट पंडों में लिखी गई है, आप उपयोग करते हैं a एसकेलर्न प्रोसेसर. पाइपलाइन ProcessingStep फ़ंक्शन निम्नलिखित तर्क लेता है: प्रोसेसर, कच्चे डेटासेट के लिए इनपुट S3 स्थान, और संसाधित डेटासेट को सहेजने के लिए आउटपुट S3 स्थान।

एक प्रशिक्षण चरण को परिभाषित करें

SageMaker XGBoost अनुमानक और पाइपलाइनों का उपयोग करके मॉडल प्रशिक्षण सेट करें TrainingStep समारोह:

मूल्यांकन स्क्रिप्ट और मॉडल मूल्यांकन चरण को परिभाषित करें

एक बार प्रशिक्षित मॉडल का मूल्यांकन करने के लिए निम्नलिखित कोड ब्लॉक चलाएँ। यह स्क्रिप्ट यह जांचने के लिए तर्क को समाहित करती है कि क्या AUC स्कोर निर्दिष्ट सीमा को पूरा करता है।

इसके बाद, मूल्यांकन स्क्रिप्ट को चलाने के लिए प्रोसेसर और पाइपलाइन चरण को इंस्टेंट करने के लिए निम्न कोड ब्लॉक चलाएँ। क्योंकि मूल्यांकन स्क्रिप्ट XGBoost पैकेज का उपयोग करती है, आप a . का उपयोग करते हैं ScriptProcessor XGBoost छवि के साथ। पाइपलाइन ProcessingStep फ़ंक्शन निम्नलिखित तर्क लेता है: प्रोसेसर, कच्चे डेटासेट के लिए इनपुट S3 स्थान, और संसाधित डेटासेट को सहेजने के लिए आउटपुट S3 स्थान।

मॉडल बनाने के चरण को परिभाषित करें

पाइपलाइन मॉडल चरण का उपयोग करके सेजमेकर मॉडल बनाने के लिए निम्न कोड ब्लॉक चलाएँ। यह चरण परिनियोजन के लिए मॉडल को पैकेज करने के लिए प्रशिक्षण चरण के आउटपुट का उपयोग करता है। ध्यान दें कि इंस्टेंस प्रकार तर्क के लिए मान पाइपलाइन पैरामीटर का उपयोग करके पारित किया जाता है जिसे आपने पहले पोस्ट में परिभाषित किया था।

बैच ट्रांसफ़ॉर्म चरण को परिभाषित करें

पहले चरण में बनाए गए बैच इनपुट के साथ प्रशिक्षित मॉडल का उपयोग करके बैच परिवर्तन को चलाने के लिए निम्नलिखित कोड ब्लॉक चलाएँ:

रजिस्टर मॉडल चरण को परिभाषित करें

निम्न कोड पाइपलाइन मॉडल चरण का उपयोग करके मॉडल को SageMaker मॉडल रजिस्ट्री में पंजीकृत करता है:

पाइपलाइन को रोकने के लिए एक असफल कदम को परिभाषित करें

यदि AUC स्कोर निर्धारित सीमा को पूरा नहीं करता है, तो निम्न कोड एक त्रुटि संदेश के साथ पाइपलाइन चलाने को रोकने के लिए पाइपलाइन विफल चरण को परिभाषित करता है:

एयूसी स्कोर की जांच के लिए एक शर्त कदम परिभाषित करें

निम्नलिखित कोड एयूसी स्कोर की जांच करने के लिए एक शर्त चरण को परिभाषित करता है और सशर्त रूप से एक मॉडल बनाता है और बैच परिवर्तन चलाता है और मॉडल रजिस्ट्री में एक मॉडल पंजीकृत करता है, या असफल स्थिति में पाइपलाइन चलाने को रोकता है:

पाइपलाइन बनाएं और चलाएं

सभी घटक चरणों को परिभाषित करने के बाद, आप उन्हें एक पाइपलाइन ऑब्जेक्ट में इकट्ठा कर सकते हैं। आपको पाइपलाइन के क्रम को निर्दिष्ट करने की आवश्यकता नहीं है क्योंकि पाइपलाइन स्वचालित रूप से चरणों के बीच निर्भरता के आधार पर ऑर्डर अनुक्रम का अनुमान लगाती है।

निम्नलिखित कोड को अपनी नोटबुक के सेल में चलाएँ। यदि पाइपलाइन पहले से मौजूद है, तो कोड पाइपलाइन को अपडेट करता है। यदि पाइपलाइन मौजूद नहीं है, तो यह एक नया बनाता है।

निष्कर्ष

इस पोस्ट में, हमने पाइपलाइन के साथ उपलब्ध कुछ नई सुविधाओं के साथ-साथ अन्य बिल्ट-इन सेजमेकर सुविधाओं और XGBoost एल्गोरिदम को मंथन भविष्यवाणी के लिए एक मॉडल को विकसित करने, पुनरावृत्त करने और तैनात करने के लिए पेश किया। समाधान को अतिरिक्त डेटा स्रोतों के साथ बढ़ाया जा सकता है

अपने स्वयं के एमएल वर्कफ़्लो को लागू करने के लिए। पाइपलाइन वर्कफ़्लो में उपलब्ध चरणों के बारे में अधिक जानकारी के लिए, देखें अमेज़ॅन सेजमेकर मॉडल बिल्डिंग पाइपलाइन और सेजमेकर वर्कफ़्लो। एडब्ल्यूएस सेजमेकर उदाहरण GitHub रेपो में पाइपलाइनों का उपयोग करते हुए विभिन्न उपयोग के मामलों के अधिक उदाहरण हैं।

लेखक के बारे में

जैरी पेंग एडब्ल्यूएस सेजमेकर के साथ एक सॉफ्टवेयर डेवलपमेंट इंजीनियर है। वह प्रशिक्षण से लेकर उत्पादन में मॉडल निगरानी तक बड़े पैमाने पर बड़े पैमाने पर एमएलओपीएस प्रणाली के निर्माण पर ध्यान केंद्रित करता है। उन्हें एमएलओपीएस की अवधारणा को व्यापक दर्शकों तक पहुंचाने का भी शौक है।

जैरी पेंग एडब्ल्यूएस सेजमेकर के साथ एक सॉफ्टवेयर डेवलपमेंट इंजीनियर है। वह प्रशिक्षण से लेकर उत्पादन में मॉडल निगरानी तक बड़े पैमाने पर बड़े पैमाने पर एमएलओपीएस प्रणाली के निर्माण पर ध्यान केंद्रित करता है। उन्हें एमएलओपीएस की अवधारणा को व्यापक दर्शकों तक पहुंचाने का भी शौक है।

दीवेन क्यूई एडब्ल्यूएस में सॉफ्टवेयर डेवलपमेंट इंजीनियर हैं। वह वर्तमान में सेजमेकर पाइपलाइनों के विकास और सुधार पर ध्यान केंद्रित कर रही है। काम के अलावा, उसे सेलो का अभ्यास करने में मज़ा आता है।

दीवेन क्यूई एडब्ल्यूएस में सॉफ्टवेयर डेवलपमेंट इंजीनियर हैं। वह वर्तमान में सेजमेकर पाइपलाइनों के विकास और सुधार पर ध्यान केंद्रित कर रही है। काम के अलावा, उसे सेलो का अभ्यास करने में मज़ा आता है।

गायत्री घनकोट एडब्ल्यूएस प्रोफेशनल सर्विसेज के साथ सीनियर मशीन लर्निंग इंजीनियर हैं। वह विभिन्न डोमेन में एआई / एमएल समाधानों को विकसित करने, तैनात करने और समझाने के बारे में भावुक है। इस भूमिका से पहले, उन्होंने वित्तीय और खुदरा क्षेत्र में शीर्ष वैश्विक फर्मों के साथ डेटा वैज्ञानिक और एमएल इंजीनियर के रूप में कई पहलों का नेतृत्व किया। उन्होंने यूनिवर्सिटी ऑफ कोलोराडो, बोल्डर से डेटा साइंस में विशेषीकृत कंप्यूटर साइंस में मास्टर डिग्री हासिल की है।

गायत्री घनकोट एडब्ल्यूएस प्रोफेशनल सर्विसेज के साथ सीनियर मशीन लर्निंग इंजीनियर हैं। वह विभिन्न डोमेन में एआई / एमएल समाधानों को विकसित करने, तैनात करने और समझाने के बारे में भावुक है। इस भूमिका से पहले, उन्होंने वित्तीय और खुदरा क्षेत्र में शीर्ष वैश्विक फर्मों के साथ डेटा वैज्ञानिक और एमएल इंजीनियर के रूप में कई पहलों का नेतृत्व किया। उन्होंने यूनिवर्सिटी ऑफ कोलोराडो, बोल्डर से डेटा साइंस में विशेषीकृत कंप्यूटर साइंस में मास्टर डिग्री हासिल की है।

रूपिंदर ग्रेवाल एडब्ल्यूएस के साथ सीनियर एआई/एमएल स्पेशलिस्ट सॉल्यूशंस आर्किटेक्ट हैं। वह वर्तमान में सेजमेकर पर मॉडल और एमएलओ की सेवा पर ध्यान केंद्रित करता है। इस भूमिका से पहले उन्होंने मशीन लर्निंग इंजीनियर बिल्डिंग और होस्टिंग मॉडल के रूप में काम किया है। काम के अलावा उन्हें टेनिस खेलना और पहाड़ की पगडंडियों पर बाइक चलाना पसंद है।

रूपिंदर ग्रेवाल एडब्ल्यूएस के साथ सीनियर एआई/एमएल स्पेशलिस्ट सॉल्यूशंस आर्किटेक्ट हैं। वह वर्तमान में सेजमेकर पर मॉडल और एमएलओ की सेवा पर ध्यान केंद्रित करता है। इस भूमिका से पहले उन्होंने मशीन लर्निंग इंजीनियर बिल्डिंग और होस्टिंग मॉडल के रूप में काम किया है। काम के अलावा उन्हें टेनिस खेलना और पहाड़ की पगडंडियों पर बाइक चलाना पसंद है।

रे लियू एडब्ल्यूएस व्यावसायिक सेवाओं के साथ एक वरिष्ठ डेटा वैज्ञानिक हैं। उनकी विशेषता स्टार्टअप से लेकर उद्यम संगठनों तक विभिन्न आकारों के ग्राहकों के लिए एआई/एमएल समाधानों के निर्माण और संचालन पर केंद्रित है। काम के बाहर, रे को फिटनेस और यात्रा करना पसंद है।

रे लियू एडब्ल्यूएस व्यावसायिक सेवाओं के साथ एक वरिष्ठ डेटा वैज्ञानिक हैं। उनकी विशेषता स्टार्टअप से लेकर उद्यम संगठनों तक विभिन्न आकारों के ग्राहकों के लिए एआई/एमएल समाधानों के निर्माण और संचालन पर केंद्रित है। काम के बाहर, रे को फिटनेस और यात्रा करना पसंद है।

- AI

- ai कला

- ऐ कला जनरेटर

- ऐ रोबोट

- अमेज़न SageMaker

- कृत्रिम बुद्धिमत्ता

- कृत्रिम बुद्धिमत्ता प्रमाणन

- बैंकिंग में आर्टिफिशियल इंटेलिजेंस

- आर्टिफिशियल इंटेलिजेंस रोबोट

- आर्टिफिशियल इंटेलिजेंस रोबोट

- कृत्रिम बुद्धि सॉफ्टवेयर

- AWS मशीन लर्निंग

- blockchain

- ब्लॉकचेन सम्मेलन एआई

- कॉइनजीनियस

- संवादी कृत्रिम बुद्धिमत्ता

- क्रिप्टो सम्मेलन एआई

- दल-ए

- ध्यान लगा के पढ़ना या सीखना

- इसे गूगल करें

- यंत्र अधिगम

- प्लेटो

- प्लेटो एआई

- प्लेटो डेटा इंटेलिजेंस

- प्लेटो गेम

- प्लेटोडाटा

- प्लेटोगेमिंग

- स्केल एआई

- वाक्यविन्यास

- जेफिरनेट