उद्योगों की एक विस्तृत श्रृंखला में जेनेरिक एआई अनुप्रयोगों की सफलता ने दुनिया भर की उन कंपनियों का ध्यान और रुचि आकर्षित की है जो प्रतिस्पर्धियों की उपलब्धियों को पुन: पेश करना और उनसे आगे निकलना चाहते हैं या नए और रोमांचक उपयोग के मामलों को हल करना चाहते हैं। ये ग्राहक जनरेटिव एआई इनोवेशन को शक्ति देने वाले इंजन के रूप में टीआईआई फाल्कन, स्टेबल डिफ्यूजन एक्सएल, या ओपनएआई के जीपीटी-3.5 जैसे फाउंडेशन मॉडल पर विचार कर रहे हैं।

फाउंडेशन मॉडल जेनरेटिव एआई मॉडल का एक वर्ग है जो मानव-जैसी सामग्री को समझने और उत्पन्न करने में सक्षम हैं, बड़ी मात्रा में असंरचित डेटा के लिए धन्यवाद, जिस पर उन्हें प्रशिक्षित किया गया है। इन मॉडलों ने छवि निर्माण, अनुवाद और प्रश्न उत्तर सहित विभिन्न कंप्यूटर विज़न (सीवी) और प्राकृतिक भाषा प्रसंस्करण (एनएलपी) कार्यों में क्रांति ला दी है। वे कई एआई अनुप्रयोगों के लिए बिल्डिंग ब्लॉक्स के रूप में काम करते हैं और उन्नत बुद्धिमान प्रणालियों के विकास में एक महत्वपूर्ण घटक बन गए हैं।

हालाँकि, फाउंडेशन मॉडल की तैनाती महत्वपूर्ण चुनौतियों के साथ आ सकती है, खासकर लागत और संसाधन आवश्यकताओं के संदर्भ में। ये मॉडल अपने आकार के लिए जाने जाते हैं, जो अक्सर सैकड़ों लाखों से लेकर अरबों मापदंडों तक होते हैं। उनके बड़े आकार के लिए शक्तिशाली हार्डवेयर और महत्वपूर्ण मेमोरी क्षमता सहित व्यापक कम्प्यूटेशनल संसाधनों की आवश्यकता होती है। वास्तव में, फाउंडेशन मॉडल को तैनात करने के लिए कम्प्यूटेशनल लोड को कुशलतापूर्वक संभालने के लिए आमतौर पर कम से कम एक (अक्सर अधिक) जीपीयू की आवश्यकता होती है। उदाहरण के लिए, TII फाल्कन-40B इंस्ट्रक्ट मॉडल को मेमोरी में सफलतापूर्वक लोड करने के लिए कम से कम एक ml.g5.12xlarge इंस्टेंस की आवश्यकता होती है, लेकिन बड़े इंस्टेंस के साथ यह सबसे अच्छा प्रदर्शन करता है। परिणामस्वरूप, इन मॉडलों को तैनात करने और बनाए रखने का निवेश पर रिटर्न (आरओआई) व्यावसायिक मूल्य साबित करने के लिए बहुत कम हो सकता है, खासकर विकास चक्रों के दौरान या स्पाइकी वर्कलोड के लिए। यह संभवतः 24/7 लंबे सत्रों के लिए GPU-संचालित इंस्टेंसेस रखने की लागत के कारण है।

इस साल की शुरुआत में, हमने घोषणा की थी अमेज़ॅन बेडरॉक, अमेज़ॅन और हमारे जेनरेटिव एआई भागीदारों से फाउंडेशन मॉडल तक पहुंचने के लिए एक सर्वर रहित एपीआई। हालाँकि यह वर्तमान में निजी पूर्वावलोकन में है, इसका सर्वर रहित एपीआई आपको अमेज़ॅन, एंथ्रोपिक, स्टेबिलिटी एआई और एआई 21 से फाउंडेशन मॉडल का उपयोग करने की अनुमति देता है, बिना किसी एंडपॉइंट को तैनात किए। हालाँकि, हगिंग फेस जैसे समुदायों के ओपन-सोर्स मॉडल बहुत बढ़ रहे हैं, और उनमें से हर एक को अमेज़ॅन बेडरॉक के माध्यम से उपलब्ध नहीं कराया गया है।

इस पोस्ट में, हम इन स्थितियों को लक्षित करते हैं और बड़े फाउंडेशन मॉडल को तैनात करके उच्च लागत के जोखिम की समस्या का समाधान करते हैं अमेज़न SageMaker अतुल्यकालिक समापनबिंदु से अमेज़न SageMaker जम्पस्टार्ट. यह आर्किटेक्चर की लागत में कटौती करने में मदद कर सकता है, जिससे एंडपॉइंट को केवल तब चलने की अनुमति मिलती है जब अनुरोध कतार में होते हैं और थोड़े समय के लिए रहते हैं, जबकि जब कोई अनुरोध सेवा के लिए इंतजार नहीं कर रहा होता है तो इसे शून्य तक स्केल किया जा सकता है। यह बहुत सारे उपयोग के मामलों के लिए बहुत अच्छा लगता है; हालाँकि, एक समापन बिंदु जो शून्य तक कम हो गया है, निष्कर्ष निकालने में सक्षम होने से पहले एक ठंडा प्रारंभ समय पेश करेगा।

समाधान अवलोकन

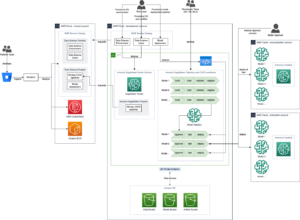

निम्नलिखित चित्र हमारे समाधान वास्तुकला को दर्शाता है।

हम जो आर्किटेक्चर तैनात करते हैं वह बहुत सीधा है:

- उपयोगकर्ता इंटरफ़ेस एक नोटबुक है, जिसे स्ट्रीमलिट या इसी तरह की तकनीक पर निर्मित वेब यूआई द्वारा प्रतिस्थापित किया जा सकता है। हमारे मामले में, नोटबुक एक है अमेज़ॅन सैजमेकर स्टूडियो नोटबुक, PyTorch 5 Python 2.0 CPU कर्नेल के साथ ml.m3.10.large इंस्टेंस पर चल रहा है।

- नोटबुक तीन तरीकों से समापन बिंदु पर सवाल उठाती है: सेजमेकर पायथन एसडीके, पायथन के लिए एडब्ल्यूएस एसडीके (बोटो3), और लैंगचेन।

- एंडपॉइंट सेजमेकर पर एसिंक्रोनस रूप से चल रहा है, और एंडपॉइंट पर, हम फाल्कन-40बी इंस्ट्रक्शन मॉडल को तैनात करते हैं। यह वर्तमान में निर्देश मॉडल के मामले में अत्याधुनिक है और सेजमेकर जम्पस्टार्ट में उपलब्ध है। एक एकल एपीआई कॉल हमें एंडपॉइंट पर मॉडल को तैनात करने की अनुमति देती है।

सेजमेकर अतुल्यकालिक अनुमान क्या है?

सेजमेकर एसिंक्रोनस इंट्रेंस सेजमेकर में चार परिनियोजन विकल्पों में से एक है, जिसमें वास्तविक समय समापन बिंदु, बैच इंट्रेंस और सर्वर रहित इंट्रेंस शामिल हैं। विभिन्न परिनियोजन विकल्पों के बारे में अधिक जानने के लिए, देखें अनुमान के लिए मॉडल तैनात करें.

सेजमेकर अतुल्यकालिक अनुमान आने वाले अनुरोधों को कतारबद्ध करता है और उन्हें अतुल्यकालिक रूप से संसाधित करता है, जिससे यह विकल्प 1 जीबी तक के बड़े पेलोड आकार, लंबे प्रसंस्करण समय और लगभग वास्तविक समय विलंबता आवश्यकताओं वाले अनुरोधों के लिए आदर्श बन जाता है। हालाँकि, मुख्य लाभ जो यह बड़े फाउंडेशन मॉडल के साथ काम करते समय प्रदान करता है, विशेष रूप से अवधारणा के प्रमाण (पीओसी) के दौरान या विकास के दौरान, जब कोई अनुरोध नहीं होता है तो शून्य की आवृत्ति गणना में स्केल करने के लिए अतुल्यकालिक अनुमान को कॉन्फ़िगर करने की क्षमता होती है। प्रक्रिया, जिससे लागत बचती है। सेजमेकर एसिंक्रोनस अनुमान के बारे में अधिक जानकारी के लिए देखें अतुल्यकालिक अनुमान. निम्नलिखित चित्र इस वास्तुकला को दर्शाता है।

एक अतुल्यकालिक अनुमान समापन बिंदु को तैनात करने के लिए, आपको एक बनाना होगा AsyncInferenceConfig वस्तु। यदि आप बनाते हैं AsyncInferenceConfig इसके तर्कों को निर्दिष्ट किए बिना, डिफ़ॉल्ट S3OutputPath होगा s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-outputs/{UNIQUE-JOB-NAME} और S3FailurePath होगा s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-failures/{UNIQUE-JOB-NAME}.

सेजमेकर जम्पस्टार्ट क्या है?

हमारा मॉडल सेजमेकर जम्पस्टार्ट से आता है, जो सेजमेकर की एक विशेषता है जो पूर्व-प्रशिक्षित मॉडल, समाधान टेम्पलेट और उदाहरण नोटबुक की पेशकश करके मशीन लर्निंग (एमएल) यात्रा को तेज करता है। यह विभिन्न प्रकार की समस्या के लिए पूर्व-प्रशिक्षित मॉडलों की एक विस्तृत श्रृंखला तक पहुंच प्रदान करता है, जिससे आप अपने एमएल कार्यों को एक ठोस आधार के साथ शुरू कर सकते हैं। सेजमेकर जंपस्टार्ट सामान्य उपयोग के मामलों के लिए समाधान टेम्पलेट और सीखने के लिए उदाहरण नोटबुक भी प्रदान करता है। सेजमेकर जम्पस्टार्ट के साथ, आप एक-क्लिक समाधान लॉन्च और व्यावहारिक एमएल अनुभव के लिए व्यापक संसाधनों के साथ अपनी एमएल परियोजनाओं को शुरू करने के लिए आवश्यक समय और प्रयास को कम कर सकते हैं।

निम्नलिखित स्क्रीनशॉट सेजमेकर जम्पस्टार्ट यूआई पर उपलब्ध कुछ मॉडलों का एक उदाहरण दिखाता है।

मॉडल तैनात करें

हमारा पहला कदम मॉडल को सेजमेकर पर तैनात करना है। ऐसा करने के लिए, हम सेजमेकर जम्पस्टार्ट या सेजमेकर पायथन एसडीके के लिए यूआई का उपयोग कर सकते हैं, जो एक एपीआई प्रदान करता है जिसका उपयोग हम मॉडल को एसिंक्रोनस एंडपॉइंट पर तैनात करने के लिए कर सकते हैं:

इस कॉल को पूरा होने में लगभग 10 मिनट लग सकते हैं. इस समय के दौरान, एंडपॉइंट को घुमाया जाता है, मॉडल कलाकृतियों के साथ कंटेनर को एंडपॉइंट पर डाउनलोड किया जाता है, मॉडल कॉन्फ़िगरेशन को सेजमेकर जम्पस्टार्ट से लोड किया जाता है, फिर एसिंक्रोनस एंडपॉइंट को DNS एंडपॉइंट के माध्यम से उजागर किया जाता है। यह सुनिश्चित करने के लिए कि हमारा एंडपॉइंट शून्य तक स्केल कर सकता है, हमें एप्लिकेशन ऑटो स्केलिंग का उपयोग करके एसिंक्रोनस एंडपॉइंट पर ऑटो स्केलिंग को कॉन्फ़िगर करने की आवश्यकता है। आपको पहले अपने एंडपॉइंट वैरिएंट को एप्लिकेशन ऑटो स्केलिंग के साथ पंजीकृत करना होगा, स्केलिंग नीति को परिभाषित करना होगा और फिर स्केलिंग नीति को लागू करना होगा। इस कॉन्फ़िगरेशन में, हम एक कस्टम मीट्रिक का उपयोग करते हैं CustomizedMetricSpecificationकहा जाता है, ApproximateBacklogSizePerInstance, जैसा कि निम्नलिखित कोड में दिखाया गया है। की विस्तृत सूची के लिए अमेज़ॅन क्लाउडवॉच आपके अतुल्यकालिक अनुमान समापन बिंदु के साथ उपलब्ध मेट्रिक्स, देखें क्लाउडवॉच से निगरानी.

आप यह सत्यापित कर सकते हैं कि सेजमेकर कंसोल पर नेविगेट करके, चुनकर यह नीति सफलतापूर्वक सेट की गई है endpoints के अंतर्गत अनुमान नेविगेशन फलक में, और उस समापन बिंदु की तलाश कर रहे हैं जिसे हमने अभी तैनात किया है।

अतुल्यकालिक समापन बिंदु को लागू करें

समापन बिंदु को लागू करने के लिए, आपको अनुरोध पेलोड डालना होगा अमेज़न सरल भंडारण सेवा (अमेज़ॅन S3) और इस पेलोड को एक भाग के रूप में एक पॉइंटर प्रदान करें InvokeEndpointAsync अनुरोध। आह्वान पर, सेजमेकर प्रसंस्करण के लिए अनुरोध को कतारबद्ध करता है और प्रतिक्रिया के रूप में एक पहचानकर्ता और आउटपुट स्थान लौटाता है। प्रसंस्करण के बाद, SageMaker परिणाम को Amazon S3 स्थान पर रखता है। आप वैकल्पिक रूप से सफलता या त्रुटि सूचनाएं प्राप्त करना चुन सकते हैं अमेज़न सरल अधिसूचना सेवा (अमेज़ॅन एसएनएस)।

सेजमेकर पायथन एसडीके

तैनाती पूरी होने के बाद, यह वापस आ जाएगा AsyncPredictor वस्तु। एसिंक्रोनस अनुमान लगाने के लिए, आपको Amazon S3 पर डेटा अपलोड करना होगा और इसका उपयोग करना होगा predict_async() इनपुट के रूप में S3 URI के साथ विधि। यह एक लौटाएगा AsyncInferenceResponse ऑब्जेक्ट, और आप इसका उपयोग करके परिणाम की जांच कर सकते हैं get_response() विधि.

वैकल्पिक रूप से, यदि आप समय-समय पर किसी परिणाम की जांच करना चाहते हैं और इसे तैयार होने पर वापस करना चाहते हैं, तो इसका उपयोग करें predict() तरीका। हम इस दूसरी विधि का उपयोग निम्नलिखित कोड में करते हैं:

बोटो3

आइए अब अन्वेषण करें invoke_endpoint_async Boto3 से विधि sagemaker-runtime ग्राहक। यह डेवलपर्स को एसिंक्रोनस रूप से सेजमेकर एंडपॉइंट को लागू करने में सक्षम बनाता है, जो प्रगति ट्रैकिंग और बाद में प्रतिक्रिया की पुनर्प्राप्ति के लिए एक टोकन प्रदान करता है। Boto3 SageMaker Python SDK की तरह एसिंक्रोनस अनुमान के पूरा होने तक प्रतीक्षा करने का कोई तरीका प्रदान नहीं करता है get_result() संचालन। इसलिए, हम इस तथ्य का लाभ उठाते हैं कि Boto3 अमेज़ॅन S3 में अनुमान आउटपुट को संग्रहीत करेगा response["OutputLocation"]. हम अमेज़ॅन S3 पर अनुमान फ़ाइल लिखे जाने की प्रतीक्षा करने के लिए निम्नलिखित फ़ंक्शन का उपयोग कर सकते हैं:

इस फ़ंक्शन के साथ, अब हम समापन बिंदु को क्वेरी कर सकते हैं:

लैंगचैन

लैंगचेन अक्टूबर 2022 में हैरिसन चेज़ द्वारा लॉन्च किया गया एक ओपन-सोर्स फ्रेमवर्क है। यह विभिन्न प्रणालियों और डेटा स्रोतों के साथ एकीकरण प्रदान करके बड़े भाषा मॉडल (एलएलएम) का उपयोग करके अनुप्रयोगों के विकास को सरल बनाता है। लैंगचेन दस्तावेज़ विश्लेषण, सारांशीकरण, चैटबॉट निर्माण, कोड विश्लेषण और बहुत कुछ करने की अनुमति देता है। सैकड़ों डेवलपर्स के योगदान और उद्यम फर्मों से महत्वपूर्ण फंडिंग के साथ, इसने लोकप्रियता हासिल की है। लैंगचेन बाहरी स्रोतों के साथ एलएलएम के कनेक्शन को सक्षम बनाता है, जिससे गतिशील, डेटा-उत्तरदायी एप्लिकेशन बनाना संभव हो जाता है। यह विकास प्रक्रिया को सुव्यवस्थित करने के लिए लाइब्रेरी, एपीआई और दस्तावेज़ीकरण प्रदान करता है।

लैंगचेन अपने ढांचे के साथ सेजमेकर एंडपॉइंट्स का उपयोग करने के लिए लाइब्रेरी और उदाहरण प्रदान करता है, जिससे सेजमेकर पर होस्ट किए गए एमएल मॉडल को श्रृंखला के "मस्तिष्क" के रूप में उपयोग करना आसान हो जाता है। लैंगचेन सेजमेकर के साथ कैसे एकीकृत होता है, इसके बारे में अधिक जानने के लिए, देखें सेजमेकर एंडपॉइंट लैंगचेन दस्तावेज़ में।

लैंगचेन के वर्तमान कार्यान्वयन की एक सीमा यह है कि यह मूल रूप से अतुल्यकालिक समापन बिंदुओं का समर्थन नहीं करता है। लैंगचेन के लिए एक अतुल्यकालिक समापन बिंदु का उपयोग करने के लिए, हमें एक नई कक्षा को परिभाषित करना होगा, SagemakerAsyncEndpoint, जो विस्तार करता है SagemakerEndpoint क्लास पहले से ही लैंगचेन में उपलब्ध है। इसके अतिरिक्त, हम निम्नलिखित जानकारी प्रदान करते हैं:

- S3 बकेट और उपसर्ग जहां अतुल्यकालिक अनुमान इनपुट (और आउटपुट) को संग्रहीत करेगा

- समय समाप्त होने से पहले प्रतीक्षा करने के लिए अधिकतम सेकंड

- An

updated _call()समापन बिंदु को क्वेरी करने के लिए फ़ंक्शनinvoke_endpoint_async()के बजायinvoke_endpoint() - यदि एसिंक्रोनस एंडपॉइंट कोल्ड स्टार्ट में है तो उसे जगाने का एक तरीका (शून्य तक घटाया गया)

नव निर्मित की समीक्षा करना SagemakerAsyncEndpoint, तुम बाहर की जाँच कर सकते हैं sagemaker_async_endpoint.py पट्टिका गिटहब पर उपलब्ध.

क्लीन अप

जब आप समापन बिंदु से अनुमानों की पीढ़ी का परीक्षण कर लें, तो अतिरिक्त शुल्क से बचने के लिए समापन बिंदु को हटाना याद रखें:

निष्कर्ष

टीआईआई फाल्कन जैसे बड़े फाउंडेशन मॉडल को तैनात करते समय, लागत का अनुकूलन महत्वपूर्ण है। इन मॉडलों के लिए शक्तिशाली हार्डवेयर और पर्याप्त मेमोरी क्षमता की आवश्यकता होती है, जिससे बुनियादी ढांचे की लागत अधिक हो जाती है। सेजमेकर एसिंक्रोनस इंट्रेंस, एक परिनियोजन विकल्प जो एसिंक्रोनस रूप से अनुरोधों को संसाधित करता है, कोई लंबित अनुरोध न होने पर इंस्टेंस गिनती को शून्य पर स्केल करके खर्चों को कम करता है। इस पोस्ट में, हमने दिखाया कि बड़े सेजमेकर जम्पस्टार्ट फाउंडेशन मॉडल को सेजमेकर एसिंक्रोनस एंडपॉइंट्स पर कैसे तैनात किया जाए। हमने एसिंक्रोनस एंडपॉइंट्स को लागू करने और परिणाम प्राप्त करने के विभिन्न तरीकों को समझाने के लिए सेजमेकर पायथन एसडीके, बोटो3 और लैंगचेन का उपयोग करके कोड उदाहरण प्रदान किए हैं। ये तकनीकें डेवलपर्स और शोधकर्ताओं को उन्नत भाषा समझ प्रणालियों के लिए फाउंडेशन मॉडल की क्षमताओं का उपयोग करते हुए लागत को अनुकूलित करने में सक्षम बनाती हैं।

अतुल्यकालिक अनुमान और सेजमेकर जम्पस्टार्ट के बारे में अधिक जानने के लिए, निम्नलिखित पोस्ट देखें:

लेखक के बारे में

डेविड गैलीटेली ईएमईए क्षेत्र में एआई/एमएल के लिए विशेषज्ञ समाधान आर्किटेक्ट हैं। वह ब्रुसेल्स में स्थित है और पूरे बेनेलक्स में ग्राहकों के साथ मिलकर काम करता है। वह बहुत छोटा था, जब से वह 7 साल की उम्र में कोड करना शुरू कर दिया था, तब से वह एक डेवलपर रहा है, उसने विश्वविद्यालय में एआई/एमएल सीखना शुरू कर दिया था, और तब से इसके साथ प्यार हो गया है।

डेविड गैलीटेली ईएमईए क्षेत्र में एआई/एमएल के लिए विशेषज्ञ समाधान आर्किटेक्ट हैं। वह ब्रुसेल्स में स्थित है और पूरे बेनेलक्स में ग्राहकों के साथ मिलकर काम करता है। वह बहुत छोटा था, जब से वह 7 साल की उम्र में कोड करना शुरू कर दिया था, तब से वह एक डेवलपर रहा है, उसने विश्वविद्यालय में एआई/एमएल सीखना शुरू कर दिया था, और तब से इसके साथ प्यार हो गया है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. ऑटोमोटिव/ईवीएस, कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- चार्टप्राइम. चार्टप्राइम के साथ अपने ट्रेडिंग गेम को उन्नत करें। यहां पहुंचें।

- BlockOffsets. पर्यावरणीय ऑफसेट स्वामित्व का आधुनिकीकरण। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/optimize-deployment-cost-of-amazon-sagemaker-jumpstart-foundation-models-with-amazon-sagemaker-asynchronous-endpoints/

- :हैस

- :है

- :नहीं

- :कहाँ

- $यूपी

- 1

- 10

- 100

- 12

- 13

- 15% तक

- 1M

- 2022

- 25

- 7

- a

- योग्य

- About

- तेज करता

- स्वीकार करता है

- पहुँच

- उपलब्धियों

- के पार

- गतिविधि

- इसके अतिरिक्त

- उन्नत

- लाभ

- बाद

- उम्र

- AI

- एआई मॉडल

- ऐ / एमएल

- की अनुमति दे

- की अनुमति देता है

- पहले ही

- भी

- हालांकि

- वीरांगना

- अमेज़न SageMaker

- अमेज़न SageMaker जम्पस्टार्ट

- अमेज़ॅन वेब सेवा

- राशि

- राशियाँ

- an

- विश्लेषण

- और

- की घोषणा

- अन्य

- anthropic

- कोई

- एपीआई

- एपीआई

- आवेदन

- अनुप्रयोगों

- लागू करें

- स्थापत्य

- हैं

- तर्क

- कला

- AS

- At

- ध्यान

- को आकर्षित किया

- स्वत:

- उपलब्ध

- औसत

- से बचने

- एडब्ल्यूएस

- आधारित

- BE

- बन

- किया गया

- से पहले

- जा रहा है

- BEST

- बड़ा

- अरबों

- ब्लॉक

- परिवर्तन

- टूटना

- ब्रसेल्स

- इमारत

- बनाया गया

- व्यापार

- लेकिन

- by

- कॉल

- बुलाया

- कर सकते हैं

- क्षमताओं

- क्षमता

- सक्षम

- क्षमता

- मामला

- मामलों

- श्रृंखला

- चेन

- चुनौतियों

- प्रभार

- पीछा

- chatbot

- चेक

- चुनें

- चुनने

- कक्षा

- ग्राहक

- निकट से

- कोड

- ठंड

- कैसे

- आता है

- सामान्य

- समुदाय

- कंपनियों

- प्रतियोगियों

- पूरा

- पूरा

- पूरा करता है

- अंग

- व्यापक

- कंप्यूटर

- Computer Vision

- संकल्पना

- विन्यास

- संबंध

- कंसोल

- कंटेनर

- सामग्री

- योगदान

- लागत

- लागत

- बनाना

- बनाया

- निर्माण

- महत्वपूर्ण

- वर्तमान

- वर्तमान में

- रिवाज

- ग्राहक

- कट गया

- व्यय कम करना

- चक्र

- तिथि

- व्यवहार

- चूक

- परिभाषित

- मांग

- साबित

- तैनात

- तैनात

- तैनाती

- तैनाती

- विस्तृत

- देव

- डेवलपर

- डेवलपर्स

- विकास

- dict

- विभिन्न

- प्रसार

- आयाम

- विकलांग

- DNS

- do

- दस्तावेज़

- दस्तावेज़ीकरण

- नहीं करता है

- किया

- नीचे

- दो

- दौरान

- गतिशील

- e

- आसान

- कुशलता

- प्रयास

- अन्य

- ईएमईए

- सक्षम

- सक्षम बनाता है

- endpoint

- इंजन

- पर्याप्त

- त्रुटि

- विशेष रूप से

- प्रत्येक

- उदाहरण

- उदाहरण

- सिवाय

- अपवाद

- उत्तेजक

- खर्च

- अनुभव

- का पता लगाने

- उजागर

- फैली

- व्यापक

- बाहरी

- अतिरिक्त

- चेहरा

- तथ्य

- शहीदों

- असत्य

- Feature

- पट्टिका

- फर्मों

- प्रथम

- निम्नलिखित

- के लिए

- बुनियाद

- चार

- ढांचा

- से

- समारोह

- निधिकरण

- प्राप्त की

- उत्पन्न

- सृजन

- पीढ़ी

- उत्पादक

- जनरेटिव एआई

- GitHub

- अच्छा

- GPUs

- महान

- बढ़ रहा है

- संभालना

- हार्डवेयर

- है

- होने

- he

- मदद

- यहाँ उत्पन्न करें

- हाई

- मेजबानी

- कैसे

- How To

- तथापि

- एचटीएमएल

- http

- HTTPS

- सैकड़ों

- लाखों में सैकड़ों

- आदर्श

- पहचानकर्ता

- if

- दिखाता है

- की छवि

- कार्यान्वयन

- आयात

- in

- सहित

- आवक

- इंगित करता है

- उद्योगों

- करें-

- इंफ्रास्ट्रक्चर

- नवोन्मेष

- निवेश

- निविष्टियां

- उदाहरण

- बजाय

- एकीकृत

- एकीकरण

- बुद्धिमान

- ब्याज

- इंटरफेस

- में

- परिचय कराना

- निवेश

- IT

- आईटी इस

- यात्रा

- जेपीजी

- JSON

- केवल

- जानने वाला

- भाषा

- बड़ा

- विलंब

- बाद में

- शुभारंभ

- शुरूआत

- प्रमुख

- जानें

- सीख रहा हूँ

- कम से कम

- पुस्तकालयों

- पसंद

- सीमाएं

- सूची

- भार

- स्थान

- लंबा

- देख

- लॉट

- मोहब्बत

- निम्न

- मशीन

- यंत्र अधिगम

- बनाया गया

- मुख्य

- को बनाए रखने के

- बनाना

- निर्माण

- बहुत

- मैक्स

- अधिकतम

- याद

- तरीका

- तरीकों

- मीट्रिक

- मेट्रिक्स

- लाखों

- मिनटों

- ML

- आदर्श

- मॉडल

- अधिक

- नाम

- प्राकृतिक

- प्राकृतिक भाषा संसाधन

- नेविगेट

- पथ प्रदर्शन

- आवश्यकता

- नया

- नए नए

- अगला

- NLP

- नहीं

- नोटबुक

- अधिसूचना

- सूचनाएं

- अभी

- संख्या

- वस्तु

- अक्टूबर

- of

- प्रस्ताव

- की पेशकश

- ऑफर

- अक्सर

- on

- ONE

- केवल

- खुला स्रोत

- आपरेशन

- ऑप्टिमाइज़ करें

- के अनुकूलन के

- विकल्प

- ऑप्शंस

- or

- हमारी

- आउट

- उत्पादन

- फलक

- पैरामीटर

- भाग

- विशेष रूप से

- भागीदारों

- अपूर्ण

- निष्पादन

- प्रदर्शन

- चित्र

- जगह

- गंतव्य

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- PoC

- नीति

- लोकप्रियता

- संभव

- पद

- पोस्ट

- संभावित

- बिजली

- शक्तिशाली

- व्यावहारिक

- भविष्यवाणी

- Predictor

- पूर्वावलोकन

- छाप

- निजी

- मुसीबत

- प्रक्रिया

- प्रक्रियाओं

- प्रसंस्करण

- प्रगति

- परियोजनाओं

- प्रमाण

- अवधारणा के सुबूत

- साबित करना

- प्रदान करना

- बशर्ते

- प्रदान करता है

- प्रदान कर

- अजगर

- pytorch

- प्रश्नों

- प्रश्न

- उठाना

- रेंज

- लेकर

- पढ़ना

- तैयार

- वास्तविक समय

- प्राप्त करना

- को कम करने

- कम कर देता है

- क्षेत्र

- रजिस्टर

- याद

- हटाना

- प्रतिस्थापित

- का अनुरोध

- अनुरोधों

- की आवश्यकता होती है

- अपेक्षित

- आवश्यकताएँ

- की आवश्यकता होती है

- शोधकर्ताओं

- संसाधन

- उपयुक्त संसाधन चुनें

- प्रतिक्रिया

- परिणाम

- परिणाम

- वापसी

- रिटर्न

- की समीक्षा

- क्रांति ला दी

- खतरे में डालकर

- आरओआई

- रन

- दौड़ना

- sagemaker

- बचत

- स्केलेबल

- स्केल

- स्केलिंग

- एसडीके

- दूसरा

- सेकंड

- स्व

- सेवा

- serverless

- सेवा

- सेवाएँ

- सत्र

- सेट

- कम

- दिखाया

- दिखाता है

- महत्वपूर्ण

- समान

- सरल

- के बाद से

- एक

- स्थितियों

- आकार

- आकार

- ठोस

- समाधान

- समाधान ढूंढे

- हल

- कुछ

- सूत्रों का कहना है

- विशेषज्ञ

- काता

- स्थिरता

- स्थिर

- प्रारंभ

- शुरू

- शुरुआत में

- राज्य

- कदम

- रुकें

- भंडारण

- की दुकान

- सरल

- सुवीही

- पर्याप्त

- सफलता

- सफलतापूर्वक

- ऐसा

- समर्थन

- समर्थन करता है

- निश्चित

- पार

- सिस्टम

- लेना

- लक्ष्य

- कार्य

- तकनीक

- टेक्नोलॉजी

- टेम्पलेट्स

- शर्तों

- परीक्षण

- धन्यवाद

- कि

- RSI

- राज्य

- लेकिन हाल ही

- उन

- फिर

- वहाँ।

- जिसके चलते

- इसलिये

- इन

- वे

- इसका

- इस वर्ष

- तीन

- यहाँ

- भर

- पहर

- बार

- समय

- सेवा मेरे

- एक साथ

- टोकन

- भी

- ट्रैकिंग

- प्रशिक्षित

- अनुवाद करें

- <strong>उद्देश्य</strong>

- कोशिश

- प्रकार

- ui

- के अंतर्गत

- समझ

- विश्वविद्यालय

- जब तक

- के ऊपर

- us

- उपयोग

- उपयोगकर्ता

- यूजर इंटरफेस

- का उपयोग

- आमतौर पर

- मूल्य

- प्रकार

- विभिन्न

- व्यापक

- उद्यम

- सत्यापित

- बहुत

- के माध्यम से

- दृष्टि

- प्रतीक्षा

- इंतज़ार कर रही

- जागना

- उठो

- करना चाहते हैं

- था

- मार्ग..

- तरीके

- we

- वेब

- वेब सेवाओं

- कब

- या

- कौन कौन से

- जब

- कौन

- चौड़ा

- विस्तृत श्रृंखला

- मर्जी

- साथ में

- बिना

- जीत लिया

- कार्य

- दुनिया भर

- होगा

- लिखा हुआ

- वर्ष

- आप

- युवा

- आपका

- स्वयं

- जेफिरनेट

- शून्य