बड़े भाषा मॉडल (एलएलएम) ने प्राकृतिक भाषा प्रसंस्करण (एनएलपी) के क्षेत्र में क्रांति ला दी है, जिससे भाषा अनुवाद, पाठ सारांश और भावना विश्लेषण जैसे कार्यों में सुधार हुआ है। हालाँकि, जैसे-जैसे ये मॉडल आकार और जटिलता में बढ़ते जा रहे हैं, उनके प्रदर्शन और व्यवहार की निगरानी करना अधिक चुनौतीपूर्ण हो गया है।

एलएलएम के प्रदर्शन और व्यवहार की निगरानी करना उनकी सुरक्षा और प्रभावशीलता सुनिश्चित करने के लिए एक महत्वपूर्ण कार्य है। हमारा प्रस्तावित आर्किटेक्चर ऑनलाइन एलएलएम निगरानी के लिए एक स्केलेबल और अनुकूलन योग्य समाधान प्रदान करता है, जो टीमों को आपके विशिष्ट उपयोग के मामलों और आवश्यकताओं के लिए आपके निगरानी समाधान को तैयार करने में सक्षम बनाता है। एडब्ल्यूएस सेवाओं का उपयोग करके, हमारा आर्किटेक्चर एलएलएम व्यवहार में वास्तविक समय की दृश्यता प्रदान करता है और टीमों को किसी भी मुद्दे या विसंगतियों को तुरंत पहचानने और संबोधित करने में सक्षम बनाता है।

इस पोस्ट में, हम ऑनलाइन एलएलएम निगरानी के लिए कुछ मेट्रिक्स और एडब्ल्यूएस सेवाओं का उपयोग करके पैमाने के लिए उनके संबंधित आर्किटेक्चर का प्रदर्शन करते हैं अमेज़ॅन क्लाउडवॉच और AWS लाम्बा. यह जो संभव है उससे परे एक अनुकूलन योग्य समाधान प्रदान करता है मॉडल मूल्यांकन के साथ नौकरियाँ अमेज़ॅन बेडरॉक.

समाधान का अवलोकन

विचार करने वाली पहली बात यह है कि अलग-अलग मेट्रिक्स के लिए अलग-अलग गणना विचारों की आवश्यकता होती है। एक मॉड्यूलर आर्किटेक्चर, जहां प्रत्येक मॉड्यूल मॉडल अनुमान डेटा ग्रहण कर सकता है और अपने स्वयं के मेट्रिक्स का उत्पादन कर सकता है, आवश्यक है।

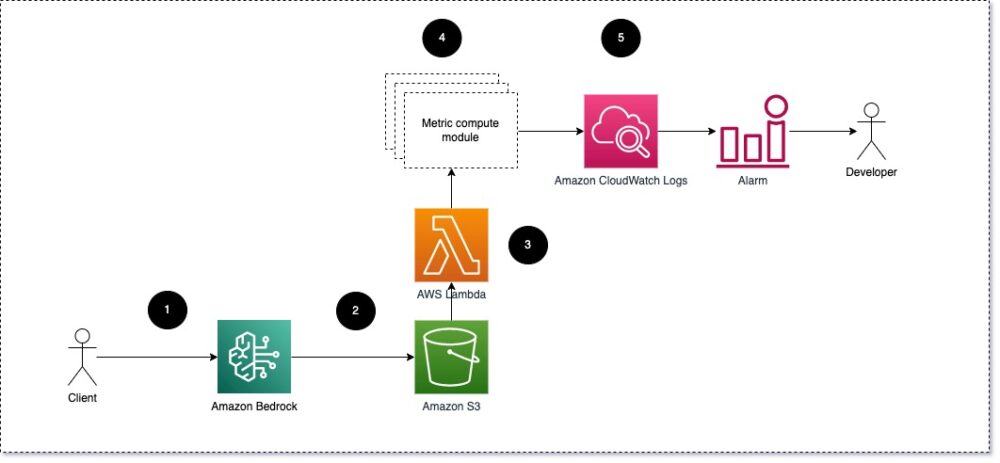

हमारा सुझाव है कि प्रत्येक मॉड्यूल आने वाले अनुमान अनुरोधों को एलएलएम में ले जाए, मीट्रिक कंप्यूट मॉड्यूल में प्रॉम्प्ट और पूर्णता (प्रतिक्रिया) जोड़े को पास करे। प्रत्येक मॉड्यूल इनपुट प्रॉम्प्ट और पूर्णता (प्रतिक्रिया) के संबंध में अपने स्वयं के मेट्रिक्स की गणना के लिए जिम्मेदार है। ये मेट्रिक्स क्लाउडवॉच को दिए जाते हैं, जो उन्हें एकत्रित कर सकता है और विशिष्ट स्थितियों पर सूचनाएं भेजने के लिए क्लाउडवॉच अलार्म के साथ काम कर सकता है। निम्नलिखित चित्र इस वास्तुकला को दर्शाता है।

चित्र 1: मीट्रिक कंप्यूट मॉड्यूल - समाधान अवलोकन

वर्कफ़्लो में निम्न चरण शामिल हैं:

- एक उपयोगकर्ता किसी एप्लिकेशन या उपयोगकर्ता इंटरफ़ेस के हिस्से के रूप में अमेज़ॅन बेडरॉक से अनुरोध करता है।

- अमेज़ॅन बेडरॉक अनुरोध और पूर्णता (प्रतिक्रिया) को सहेजता है अमेज़न सरल भंडारण सेवा (अमेज़ॅन S3) के कॉन्फ़िगरेशन के अनुसार मंगलाचरण लॉगिंग.

- Amazon S3 पर सेव की गई फ़ाइल एक इवेंट बनाती है चलाता है एक लैम्ब्डा फ़ंक्शन. फ़ंक्शन मॉड्यूल को आमंत्रित करता है।

- मॉड्यूल अपने संबंधित मेट्रिक्स यहां पोस्ट करते हैं क्लाउडवॉच मेट्रिक्स.

- एलार्म अप्रत्याशित मीट्रिक मानों के बारे में विकास टीम को सूचित कर सकता है।

एलएलएम निगरानी लागू करते समय विचार करने वाली दूसरी बात ट्रैक करने के लिए सही मेट्रिक्स चुनना है। हालाँकि ऐसे कई संभावित मेट्रिक्स हैं जिनका उपयोग आप एलएलएम प्रदर्शन की निगरानी के लिए कर सकते हैं, हम इस पोस्ट में कुछ व्यापक मेट्रिक्स के बारे में बताते हैं।

निम्नलिखित अनुभागों में, हम कुछ प्रासंगिक मॉड्यूल मेट्रिक्स और उनके संबंधित मीट्रिक कंप्यूट मॉड्यूल आर्किटेक्चर पर प्रकाश डालते हैं।

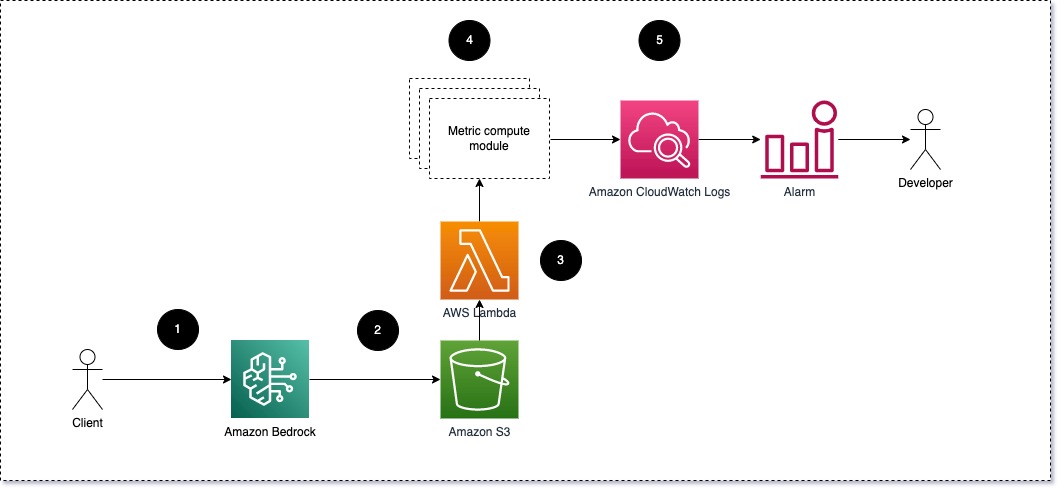

संकेत और पूर्णता के बीच अर्थ संबंधी समानता (प्रतिक्रिया)

एलएलएम चलाते समय, आप प्रत्येक अनुरोध के लिए संकेत और पूर्णता (प्रतिक्रिया) को रोक सकते हैं और उन्हें एम्बेडिंग मॉडल का उपयोग करके एम्बेडिंग में बदल सकते हैं। एंबेडिंग उच्च-आयामी वेक्टर हैं जो पाठ के अर्थपूर्ण अर्थ का प्रतिनिधित्व करते हैं। अमेज़न टाइटन टाइटन एंबेडिंग के माध्यम से ऐसे मॉडल प्रदान करता है। इन दो वैक्टरों के बीच कोसाइन जैसी दूरी लेकर, आप यह निर्धारित कर सकते हैं कि संकेत और पूर्णता (प्रतिक्रिया) शब्दार्थ रूप से कितने समान हैं। आप उपयोग कर सकते हैं SciPy or scikit सीखने सदिशों के बीच कोज्या दूरी की गणना करने के लिए। निम्नलिखित चित्र इस मीट्रिक कंप्यूट मॉड्यूल की वास्तुकला को दर्शाता है।

चित्र 2: मीट्रिक गणना मॉड्यूल - अर्थ संबंधी समानता

इस वर्कफ़्लो में निम्नलिखित मुख्य चरण शामिल हैं:

- लैम्ब्डा फ़ंक्शन एक स्ट्रीम किए गए संदेश को प्राप्त करता है अमेज़ॅन किनिस जिसमें एक संकेत और पूर्णता (प्रतिक्रिया) जोड़ी शामिल है।

- फ़ंक्शन को प्रॉम्प्ट और पूर्णता (प्रतिक्रिया) दोनों के लिए एक एम्बेडिंग मिलती है, और दो वैक्टरों के बीच कोसाइन दूरी की गणना करता है।

- फ़ंक्शन उस जानकारी को क्लाउडवॉच मेट्रिक्स को भेजता है।

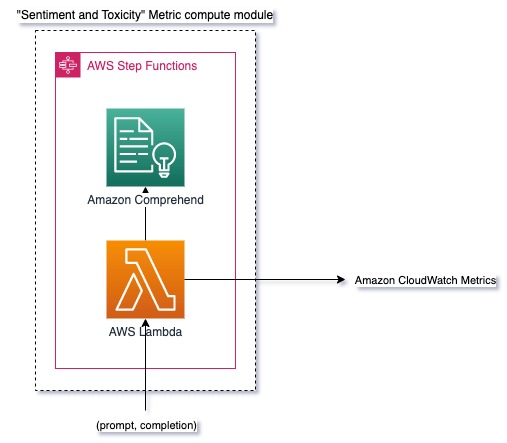

भावना और विषाक्तता

भावना की निगरानी आपको प्रतिक्रियाओं के समग्र स्वर और भावनात्मक प्रभाव को मापने की अनुमति देती है, जबकि विषाक्तता विश्लेषण एलएलएम आउटपुट में आक्रामक, अपमानजनक या हानिकारक भाषा की उपस्थिति का एक महत्वपूर्ण उपाय प्रदान करता है। यह सुनिश्चित करने के लिए कि मॉडल अपेक्षा के अनुरूप व्यवहार कर रहा है, भावना या विषाक्तता में किसी भी बदलाव की बारीकी से निगरानी की जानी चाहिए। निम्नलिखित चित्र मीट्रिक कंप्यूट मॉड्यूल को दर्शाता है।

चित्र 3: मीट्रिक गणना मॉड्यूल - भावना और विषाक्तता

वर्कफ़्लो में निम्न चरण शामिल हैं:

- लैम्ब्डा फ़ंक्शन को अमेज़ॅन किनेसिस के माध्यम से एक त्वरित और पूर्णता (प्रतिक्रिया) जोड़ी प्राप्त होती है।

- AWS स्टेप फ़ंक्शंस ऑर्केस्ट्रेशन के माध्यम से, फ़ंक्शन कॉल करता है Amazon Comprehend पता लगाने के लिए भावुकता और विषाक्तता.

- फ़ंक्शन जानकारी को क्लाउडवॉच मेट्रिक्स में सहेजता है।

अमेज़ॅन कॉम्प्रेहेंड के साथ भावना और विषाक्तता का पता लगाने के बारे में अधिक जानकारी के लिए देखें एक मजबूत पाठ-आधारित विषाक्तता पूर्वसूचक बनाएँ और Amazon Comprehend विषाक्तता पहचान का उपयोग करके हानिकारक सामग्री को चिह्नित करें.

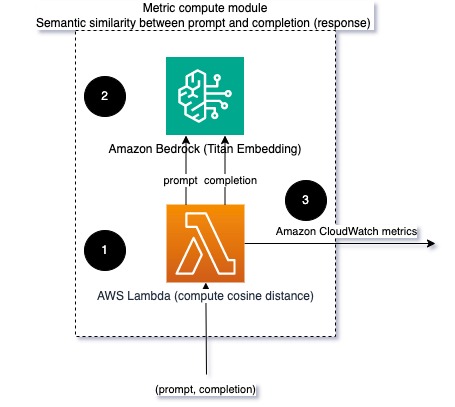

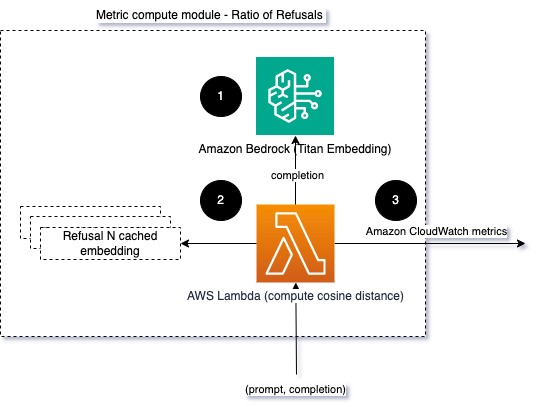

इनकारों का अनुपात

इनकारों में वृद्धि, जैसे कि जब एलएलएम जानकारी की कमी के कारण पूरा होने से इंकार कर देता है, तो इसका मतलब यह हो सकता है कि या तो दुर्भावनापूर्ण उपयोगकर्ता एलएलएम का उपयोग उन तरीकों से करने की कोशिश कर रहे हैं जिनका उद्देश्य इसे जेलब्रेक करना है, या यह कि उपयोगकर्ताओं की अपेक्षाएं पूरी नहीं हो रही हैं और वे कम मूल्य वाली प्रतिक्रियाएँ मिल रही हैं। यह कितनी बार हो रहा है इसका आकलन करने का एक तरीका एलएलएम मॉडल से मानक इनकारों की तुलना एलएलएम से वास्तविक प्रतिक्रियाओं के साथ करना है। उदाहरण के लिए, एंथ्रोपिक के क्लाउड वी2 एलएलएम के कुछ सामान्य इनकार वाक्यांश निम्नलिखित हैं:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

संकेतों के एक निश्चित सेट पर, इन इनकारों में वृद्धि एक संकेत हो सकती है कि मॉडल अत्यधिक सतर्क या संवेदनशील हो गया है। उलटे मामले का भी मूल्यांकन किया जाना चाहिए। यह एक संकेत हो सकता है कि मॉडल अब विषाक्त या हानिकारक बातचीत में शामिल होने के लिए अधिक प्रवण है।

मॉडल अखंडता और मॉडल इनकार अनुपात में सहायता के लिए, हम एलएलएम से ज्ञात इनकार वाक्यांशों के एक सेट के साथ प्रतिक्रिया की तुलना कर सकते हैं। यह एक वास्तविक क्लासिफायरियर हो सकता है जो बता सकता है कि मॉडल ने अनुरोध को क्यों अस्वीकार कर दिया। आप मॉनिटर किए जा रहे मॉडल से प्रतिक्रिया और ज्ञात इनकार प्रतिक्रियाओं के बीच कोसाइन दूरी ले सकते हैं। निम्नलिखित चित्र इस मीट्रिक गणना मॉड्यूल को दर्शाता है।

चित्र 4: मीट्रिक गणना मॉड्यूल - इनकारों का अनुपात

वर्कफ़्लो में निम्नलिखित चरण होते हैं:

- एक लैम्ब्डा फ़ंक्शन एक संकेत और पूर्णता (प्रतिक्रिया) प्राप्त करता है और अमेज़ॅन टाइटन का उपयोग करके प्रतिक्रिया से एक एम्बेडिंग प्राप्त करता है।

- फ़ंक्शन प्रतिक्रिया और स्मृति में कैश किए गए मौजूदा इनकार संकेतों के बीच कोसाइन या यूक्लिडियन दूरी की गणना करता है।

- फ़ंक्शन उस औसत को क्लाउडवॉच मेट्रिक्स पर भेजता है।

एक और विकल्प का उपयोग करना है फजी मिलान ज्ञात इनकारों की तुलना एलएलएम आउटपुट से करने के लिए एक सीधा लेकिन कम शक्तिशाली दृष्टिकोण। को देखें अजगर का प्रलेखन एक उदाहरण के लिए।

सारांश

एलएलएम के विश्वसनीय और भरोसेमंद उपयोग को सुनिश्चित करने के लिए एलएलएम अवलोकन एक महत्वपूर्ण अभ्यास है। एलएलएम की निगरानी, समझ और सटीकता और विश्वसनीयता सुनिश्चित करने से आपको इन एआई मॉडल से जुड़े जोखिमों को कम करने में मदद मिल सकती है। मतिभ्रम, खराब पूर्णता (प्रतिक्रियाएं), और संकेतों की निगरानी करके, आप यह सुनिश्चित कर सकते हैं कि आपका एलएलएम ट्रैक पर रहता है और वह मूल्य प्रदान करता है जिसकी आप और आपके उपयोगकर्ता तलाश कर रहे हैं। इस पोस्ट में, हमने उदाहरण दिखाने के लिए कुछ मेट्रिक्स पर चर्चा की।

फाउंडेशन मॉडल के मूल्यांकन के बारे में अधिक जानकारी के लिए देखें फाउंडेशन मॉडल का मूल्यांकन करने के लिए SageMaker Clarify का उपयोग करें, और अतिरिक्त ब्राउज़ करें उदाहरण नोटबुक हमारे GitHub रिपॉजिटरी में उपलब्ध है। आप एलएलएम मूल्यांकन को बड़े पैमाने पर संचालित करने के तरीके भी तलाश सकते हैं Amazon SageMaker Clarify और MLOps सेवाओं का उपयोग करके बड़े पैमाने पर LLM मूल्यांकन का संचालन करें. अंत में, हम संदर्भित करने की अनुशंसा करते हैं गुणवत्ता और जिम्मेदारी के लिए बड़े भाषा मॉडल का मूल्यांकन करें एलएलएम के मूल्यांकन के बारे में अधिक जानने के लिए।

लेखक के बारे में

ब्रूनो क्लेन AWS प्रोफेशनल सर्विसेज एनालिटिक्स प्रैक्टिस के साथ एक वरिष्ठ मशीन लर्निंग इंजीनियर हैं। वह ग्राहकों को बड़े डेटा और एनालिटिक्स समाधान लागू करने में मदद करता है। काम के अलावा, वह परिवार के साथ समय बिताना, यात्रा करना और नया खाना आज़माना पसंद करते हैं।

ब्रूनो क्लेन AWS प्रोफेशनल सर्विसेज एनालिटिक्स प्रैक्टिस के साथ एक वरिष्ठ मशीन लर्निंग इंजीनियर हैं। वह ग्राहकों को बड़े डेटा और एनालिटिक्स समाधान लागू करने में मदद करता है। काम के अलावा, वह परिवार के साथ समय बिताना, यात्रा करना और नया खाना आज़माना पसंद करते हैं।

ऋषभ लोखंडे एडब्ल्यूएस प्रोफेशनल सर्विसेज एनालिटिक्स प्रैक्टिस के साथ एक वरिष्ठ डेटा और एमएल इंजीनियर हैं। वह ग्राहकों को बड़े डेटा, मशीन लर्निंग और एनालिटिक्स समाधान लागू करने में मदद करता है। काम के अलावा, वह परिवार के साथ समय बिताना, पढ़ना, दौड़ना और गोल्फ खेलना पसंद करते हैं।

ऋषभ लोखंडे एडब्ल्यूएस प्रोफेशनल सर्विसेज एनालिटिक्स प्रैक्टिस के साथ एक वरिष्ठ डेटा और एमएल इंजीनियर हैं। वह ग्राहकों को बड़े डेटा, मशीन लर्निंग और एनालिटिक्स समाधान लागू करने में मदद करता है। काम के अलावा, वह परिवार के साथ समय बिताना, पढ़ना, दौड़ना और गोल्फ खेलना पसंद करते हैं।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :हैस

- :है

- :नहीं

- :कहाँ

- 1

- 100

- 143

- 32

- 455

- 7

- a

- About

- शुद्धता

- वास्तविक

- अतिरिक्त

- पता

- कुल

- AI

- एआई सहायक

- एआई मॉडल

- की अनुमति देता है

- भी

- हालांकि

- am

- वीरांगना

- Amazon Comprehend

- अमेज़ॅन किनिस

- अमेज़न SageMaker

- अमेज़ॅन वेब सेवा

- an

- विश्लेषण

- विश्लेषिकी

- और

- असामान्यताएं

- anthropic

- कोई

- आवेदन

- दृष्टिकोण

- दृष्टिकोण

- स्थापत्य

- हैं

- AS

- सहायक

- जुड़े

- At

- उपलब्ध

- औसत

- एडब्ल्यूएस

- AWS व्यावसायिक सेवाएँ

- AWS स्टेप फ़ंक्शंस

- बुरा

- BE

- बन

- व्यवहार

- जा रहा है

- के बीच

- परे

- बड़ा

- बड़ा डेटा

- के छात्रों

- लेकिन

- by

- कॉल

- कर सकते हैं

- नही सकता

- मामला

- मामलों

- सतर्क

- चुनौतीपूर्ण

- चुनने

- वर्गीकृत

- निकट से

- सामान्य

- तुलना

- की तुलना

- समापन

- जटिलता

- समझना

- गणना

- गणना करना

- कंप्यूटिंग

- स्थितियां

- विन्यास

- विचार करना

- विचार

- होते हैं

- सामग्री

- प्रसंग

- जारी रखने के

- बातचीत

- सका

- बनाया

- बनाता है

- महत्वपूर्ण

- ग्राहक

- अनुकूलन

- तिथि

- बचाता है

- दिखाना

- पता लगाना

- विकास

- विकास दल

- आरेख

- विभिन्न

- चर्चा की

- दूरी

- do

- दो

- से प्रत्येक

- प्रभावशीलता

- भी

- embedding

- सक्षम बनाता है

- समर्थकारी

- लगाना

- इंजीनियर

- पर्याप्त

- सुनिश्चित

- सुनिश्चित

- मूल्यांकन करें

- मूल्यांकित

- का मूल्यांकन

- मूल्यांकन

- मूल्यांकन

- कार्यक्रम

- उदाहरण

- उदाहरण

- मौजूदा

- उम्मीदों

- अपेक्षित

- समझाना

- का पता लगाने

- परिवार

- कुछ

- खेत

- अंजीर

- पट्टिका

- अंत में

- प्रथम

- तय

- निम्नलिखित

- भोजन

- के लिए

- बुनियाद

- से

- समारोह

- कार्यों

- नाप

- हो जाता है

- मिल रहा

- GitHub

- गोल्फ

- आगे बढ़ें

- हो रहा है

- हानिकारक

- है

- he

- मदद

- सहायक

- मदद करता है

- हाइलाइट

- ईमानदार

- कैसे

- तथापि

- एचटीएमएल

- http

- HTTPS

- i

- पहचान करना

- दिखाता है

- प्रभाव

- लागू करने के

- कार्यान्वयन

- महत्वपूर्ण

- में सुधार लाने

- in

- शामिल

- आवक

- बढ़ना

- तेजी

- करें-

- निवेश

- ईमानदारी

- इरादा

- इंटरफेस

- में

- प्रतिलोम

- का आह्वान

- मुद्दों

- IT

- आईटी इस

- भागने

- नौकरियां

- जेपीजी

- कुंजी

- जानने वाला

- रंग

- भाषा

- बड़ा

- जानें

- सीख रहा हूँ

- कम

- एलएलएम

- देख

- मशीन

- यंत्र अधिगम

- बनाना

- बनाता है

- दुर्भावनापूर्ण

- बहुत

- मतलब

- अर्थ

- माप

- याद

- message

- घास का मैदान

- मीट्रिक

- मेट्रिक्स

- कम करना

- ML

- एमएलओपीएस

- आदर्श

- मॉडल

- मॉड्यूलर

- मॉड्यूल

- मॉड्यूल

- मॉनिटर

- नजर रखी

- निगरानी

- अधिक

- प्राकृतिक

- प्राकृतिक भाषा संसाधन

- आवश्यक

- नया

- NLP

- सूचनाएं

- अभी

- of

- अपमानजनक

- ऑफर

- अक्सर

- on

- ONE

- लोगों

- ऑनलाइन

- विकल्प

- or

- आर्केस्ट्रा

- हमारी

- उत्पादन

- outputs के

- बाहर

- कुल

- सिंहावलोकन

- अपना

- जोड़ा

- जोड़े

- भाग

- पारित कर दिया

- पासिंग

- प्रति

- प्रदर्शन

- मुहावरों

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- खेल

- संभव

- पद

- संभावित

- शक्तिशाली

- अभ्यास

- उपस्थिति

- प्रसंस्करण

- उत्पादन

- पेशेवर

- संकेतों

- प्रस्तावित

- प्रदान करना

- प्रदान करता है

- अजगर

- गुणवत्ता

- जल्दी से

- अनुपात

- पढ़ना

- वास्तविक समय

- प्राप्त

- की सिफारिश

- उल्लेख

- इनकार

- मना कर दिया

- प्रासंगिक

- विश्वसनीयता

- विश्वसनीय

- कोष

- प्रतिनिधित्व

- का अनुरोध

- अनुरोधों

- की आवश्यकता होती है

- आवश्यकताएँ

- सम्मान

- कि

- प्रतिक्रिया

- प्रतिक्रियाएं

- जिम्मेदार

- क्रांति ला दी

- सही

- जोखिम

- मजबूत

- दौड़ना

- सुरक्षा

- sagemaker

- बचाया

- स्केलेबल

- स्केल

- दूसरा

- वर्गों

- अर्थ

- भेजें

- भेजता

- वरिष्ठ

- संवेदनशील

- भावुकता

- सेवाएँ

- सेट

- परिवर्तन

- चाहिए

- प्रदर्शन

- संकेत

- समान

- सरल

- आकार

- समाधान

- समाधान ढूंढे

- कुछ

- स्थानिक

- विशिष्ट

- खर्च

- मानक

- कदम

- कदम

- भंडारण

- सरल

- स्ट्रीम किया

- ऐसा

- सुझाव

- निश्चित

- दर्जी

- लेना

- ले जा

- कार्य

- कार्य

- टीम

- टीमों

- तकनीक

- टेक्स्ट

- कि

- RSI

- जानकारी

- लेकिन हाल ही

- उन

- वहाँ।

- इन

- वे

- बात

- इसका

- यहाँ

- पहर

- टाइटन

- सेवा मेरे

- स्वर

- ट्रैक

- बदालना

- अनुवाद करें

- यात्रा का

- भरोसेमंद

- की कोशिश कर रहा

- दो

- समझ

- अप्रत्याशित

- उपयोग

- प्रयुक्त

- उपयोगकर्ता

- यूजर इंटरफेस

- उपयोगकर्ताओं

- का उपयोग

- मूल्य

- मान

- के माध्यम से

- दृश्यता

- मार्ग..

- तरीके

- we

- वेब

- वेब सेवाओं

- क्या

- एचएमबी क्या है?

- कब

- जहाँ तक

- कौन कौन से

- क्यों

- विकिपीडिया

- साथ में

- काम

- वर्कफ़्लो

- आप

- आपका

- जेफिरनेट