परिचय

मशीन लर्निंग में, पूर्वाग्रह-विचरण व्यापार बंद एक मौलिक अवधारणा है जो किसी भी पूर्वानुमानित मॉडल के प्रदर्शन को प्रभावित करती है। यह पूर्वाग्रह त्रुटि और मॉडल की भिन्नता त्रुटि के बीच नाजुक संतुलन को संदर्भित करता है, क्योंकि दोनों को एक साथ कम करना असंभव है। इष्टतम मॉडल प्रदर्शन प्राप्त करने के लिए सही संतुलन बनाना महत्वपूर्ण है।

इस छोटे से लेख में, हम पूर्वाग्रह और भिन्नता को परिभाषित करेंगे, समझाएंगे कि वे मशीन लर्निंग मॉडल को कैसे प्रभावित करते हैं, और व्यवहार में उनसे निपटने के तरीके पर कुछ व्यावहारिक सलाह प्रदान करते हैं।

पूर्वाग्रह और भिन्नता को समझना

पूर्वाग्रह और विचरण के बीच संबंध में गोता लगाने से पहले, आइए परिभाषित करें कि ये शब्द मशीन सीखने में क्या दर्शाते हैं।

पूर्वाग्रह त्रुटि एक मॉडल की भविष्यवाणी और भविष्यवाणी करने की कोशिश करने वाले सही मूल्यों (जमीनी सच्चाई) के बीच के अंतर को संदर्भित करती है। दूसरे शब्दों में, पूर्वाग्रह वह त्रुटि है जो एक मॉडल अंतर्निहित डेटा वितरण के बारे में अपनी गलत धारणाओं के कारण करता है। उच्च पूर्वाग्रह मॉडल अक्सर बहुत सरलीकृत होते हैं, डेटा की जटिलता को पकड़ने में विफल होते हैं, जिससे अंडरफिटिंग होती है।

दूसरी ओर, भिन्नता त्रुटि, प्रशिक्षण डेटा में छोटे उतार-चढ़ाव के प्रति मॉडल की संवेदनशीलता को संदर्भित करती है। उच्च विचरण मॉडल अत्यधिक जटिल होते हैं और अंतर्निहित पैटर्न के बजाय डेटा में शोर को फिट करते हैं, जिससे ओवरफिटिंग होती है। इसके परिणामस्वरूप नए, अनदेखे डेटा पर खराब प्रदर्शन होता है।

उच्च पूर्वाग्रह से अंडरफिटिंग हो सकती है, जहां डेटा की जटिलता को पकड़ने के लिए मॉडल बहुत सरल है। यह डेटा के बारे में मजबूत धारणा बनाता है और इनपुट और आउटपुट चर के बीच सही संबंध को पकड़ने में विफल रहता है। दूसरी ओर, उच्च विचरण से ओवरफिटिंग हो सकती है, जहां मॉडल बहुत जटिल है और इनपुट और आउटपुट चर के बीच अंतर्निहित संबंध के बजाय डेटा में शोर सीखता है। इस प्रकार, ओवरफिटिंग मॉडल प्रशिक्षण डेटा को बहुत बारीकी से फिट करते हैं और नए डेटा को अच्छी तरह से सामान्य नहीं करेंगे, जबकि अंडरफिटिंग मॉडल प्रशिक्षण डेटा को सटीक रूप से फिट करने में भी सक्षम नहीं होते हैं।

जैसा कि पहले उल्लेख किया गया है, पूर्वाग्रह और भिन्नता संबंधित हैं, और पूर्वाग्रह त्रुटि और भिन्नता त्रुटि के बीच एक अच्छा मॉडल संतुलन है। बायस-वैरियंस ट्रेड-ऑफ त्रुटि के इन दो स्रोतों के बीच इष्टतम संतुलन खोजने की प्रक्रिया है। कम पूर्वाग्रह और कम विचरण वाला मॉडल संभावित रूप से कुल त्रुटि को कम करते हुए प्रशिक्षण और नए डेटा दोनों पर अच्छा प्रदर्शन करेगा।

बायस-वैरियंस ट्रेड-ऑफ

मॉडल जटिलता और अज्ञात डेटा को सामान्यीकृत करने की इसकी क्षमता के बीच संतुलन प्राप्त करना पूर्वाग्रह-विचरण व्यापार का मूल है। सामान्य तौर पर, एक अधिक जटिल मॉडल में कम पूर्वाग्रह लेकिन उच्च विचरण होगा, जबकि एक सरल मॉडल में उच्च पूर्वाग्रह लेकिन निम्न विचरण होगा।

चूंकि पूर्वाग्रह और भिन्नता को एक साथ कम करना असंभव है, इसलिए एक मजबूत मशीन लर्निंग मॉडल बनाने के लिए उनके बीच इष्टतम संतुलन खोजना महत्वपूर्ण है। उदाहरण के लिए, जैसे-जैसे हम किसी मॉडल की जटिलता बढ़ाते हैं, वैसे-वैसे हम प्रसरण भी बढ़ाते हैं। ऐसा इसलिए है क्योंकि एक अधिक जटिल मॉडल के प्रशिक्षण डेटा में शोर को फिट करने की अधिक संभावना है, जिससे ओवरफिटिंग हो जाएगी।

दूसरी ओर, यदि हम निदर्श को बहुत सरल रखते हैं, तो हम पूर्वाग्रह बढ़ा देंगे। ऐसा इसलिए है क्योंकि एक सरल मॉडल डेटा में अंतर्निहित संबंधों को पकड़ने में सक्षम नहीं होगा, जिससे अंडरफिटिंग हो जाएगी।

लक्ष्य एक मॉडल को प्रशिक्षित करना है जो प्रशिक्षण डेटा में अंतर्निहित संबंधों को पकड़ने के लिए पर्याप्त जटिल है, लेकिन इतना जटिल नहीं है कि यह प्रशिक्षण डेटा में शोर को फिट करे।

व्यवहार में बायस-वैरियंस ट्रेड-ऑफ

मॉडल प्रदर्शन का निदान करने के लिए, हम आमतौर पर ट्रेन और सत्यापन त्रुटियों की गणना और तुलना करते हैं। इसे देखने के लिए एक उपयोगी उपकरण सीखने की अवस्था का एक प्लॉट है, जो प्रशिक्षण प्रक्रिया के दौरान ट्रेन और सत्यापन डेटा दोनों पर मॉडल के प्रदर्शन को प्रदर्शित करता है। इन कर्व्स की जांच करके, हम यह निर्धारित कर सकते हैं कि कोई मॉडल ओवरफिटिंग (हाई वेरिएंस), अंडरफिटिंग (हाई बायस), या वेल-फिटिंग (बायस और वेरिएंस के बीच इष्टतम संतुलन) है या नहीं।

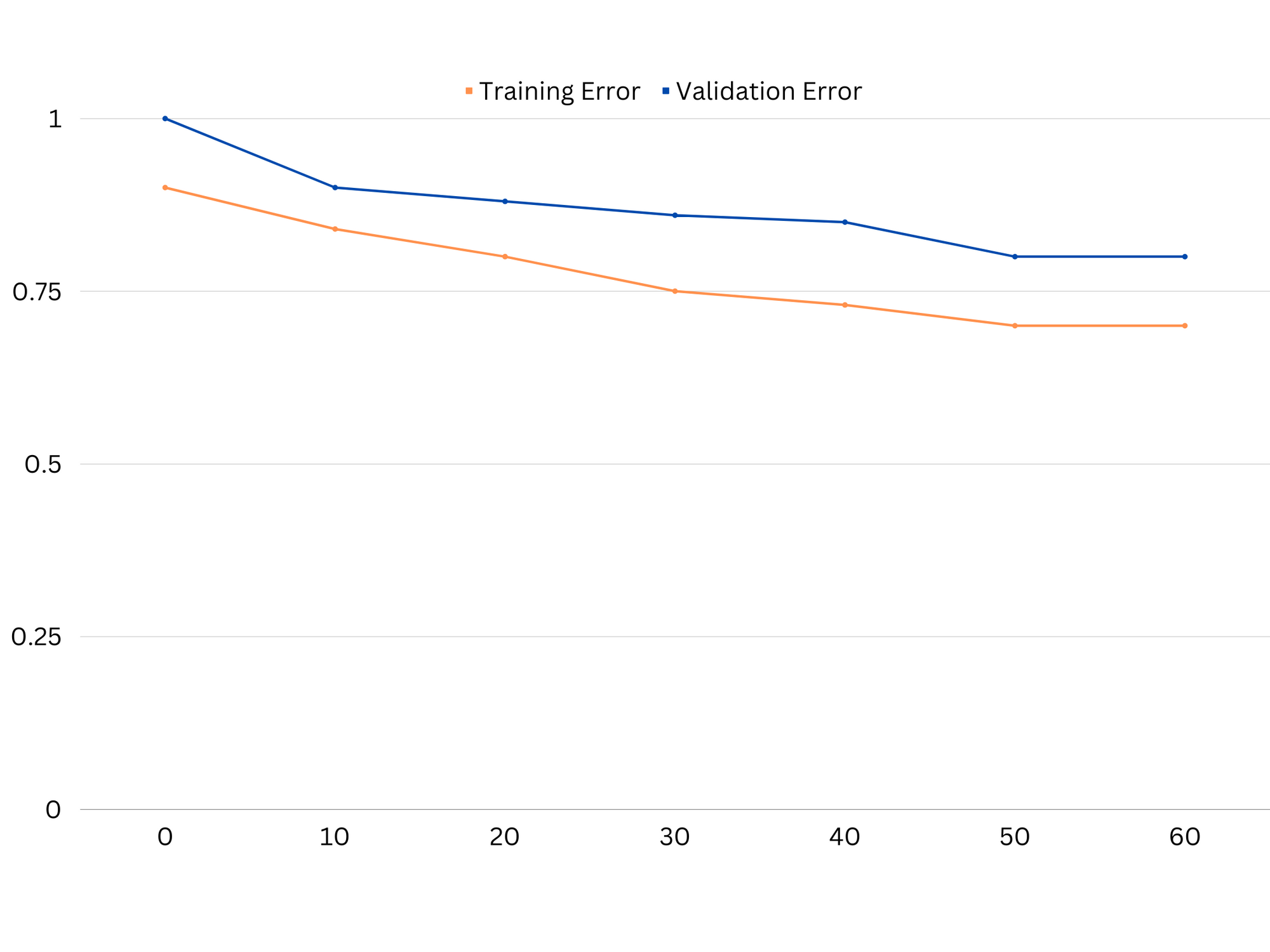

अंडरफिटिंग मॉडल के लर्निंग कर्व्स का उदाहरण। ट्रेन त्रुटि और सत्यापन त्रुटि दोनों अधिक हैं।

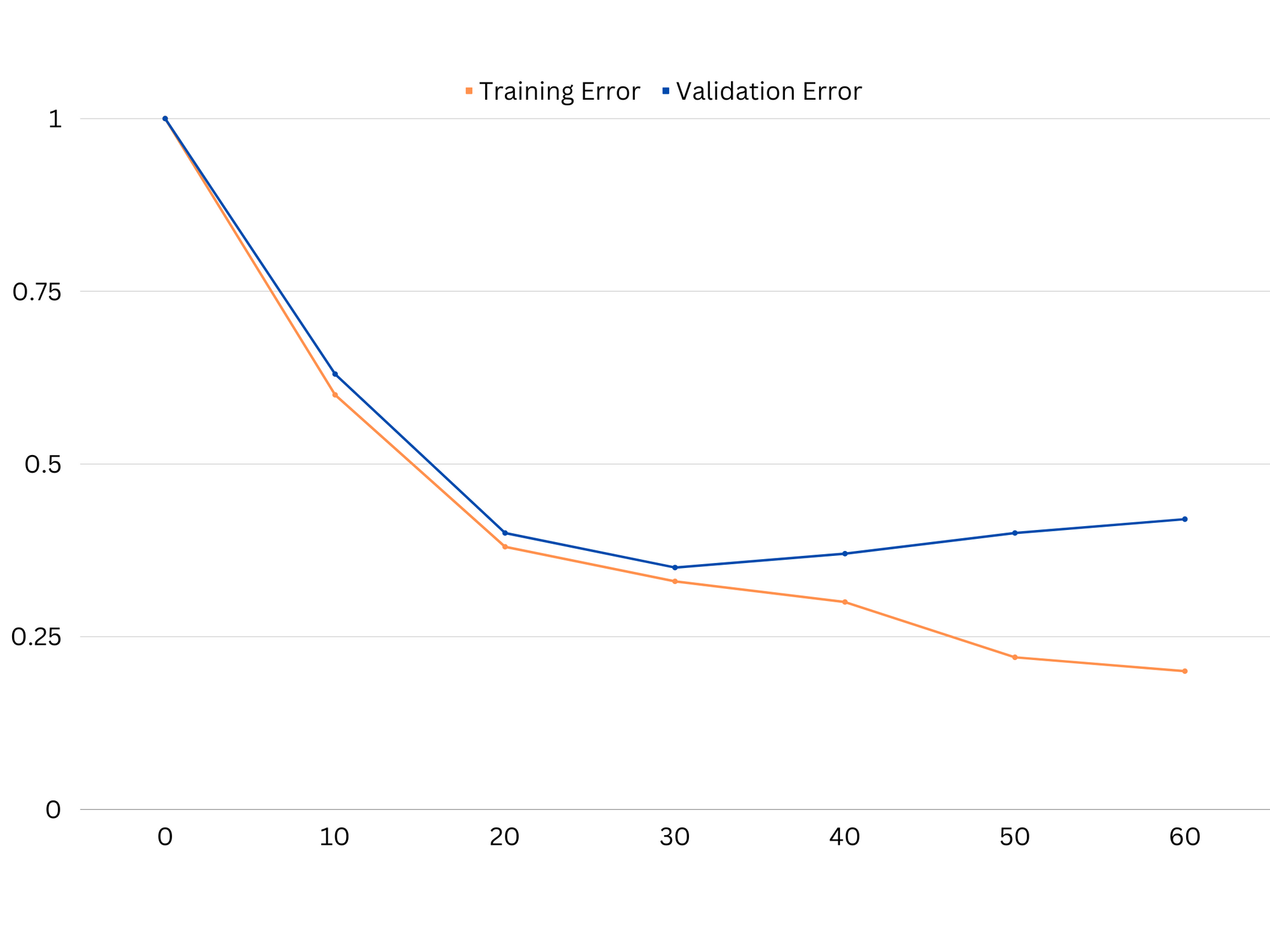

व्यवहार में, प्रशिक्षण और सत्यापन डेटा दोनों पर कम प्रदर्शन से पता चलता है कि मॉडल बहुत सरल है, जिससे अंडरफिटिंग हो जाती है। दूसरी ओर, यदि मॉडल प्रशिक्षण डेटा पर बहुत अच्छा प्रदर्शन करता है, लेकिन परीक्षण डेटा पर खराब प्रदर्शन करता है, तो मॉडल की जटिलता बहुत अधिक होने की संभावना है, जिसके परिणामस्वरूप ओवरफिटिंग होती है। अंडरफिटिंग को संबोधित करने के लिए, हम अधिक सुविधाओं को जोड़कर, सीखने के एल्गोरिथ्म को बदलकर या विभिन्न हाइपरपैरामीटर चुनकर मॉडल की जटिलता को बढ़ाने का प्रयास कर सकते हैं। ओवरफिटिंग के मामले में, हमें मॉडल को नियमित करने या इसकी सामान्यीकरण क्षमताओं को बेहतर बनाने के लिए क्रॉस-वैलिडेशन जैसी तकनीकों का उपयोग करने पर विचार करना चाहिए।

ओवरफिटिंग मॉडल के लर्निंग कर्व्स का उदाहरण। ट्रेन की त्रुटि कम हो जाती है जबकि सत्यापन त्रुटि बढ़ने लगती है। मॉडल सामान्यीकरण करने में असमर्थ है।

नियमितीकरण एक ऐसी तकनीक है जिसका उपयोग मशीन लर्निंग मॉडल में भिन्नता त्रुटि को कम करने के लिए किया जा सकता है, जिससे बायस-विचरण व्यापार-बंद को संबोधित करने में मदद मिलती है। कई अलग-अलग नियमितीकरण तकनीकें हैं, जिनमें से प्रत्येक के अपने फायदे और नुकसान हैं। कुछ लोकप्रिय नियमितीकरण तकनीकों में रिज रिग्रेशन, लासो रिग्रेशन और इलास्टिक नेट रेगुलराइजेशन शामिल हैं। ये सभी तकनीकें मॉडल के ऑब्जेक्टिव फंक्शन में पेनल्टी शब्द जोड़कर ओवरफिटिंग को रोकने में मदद करती हैं, जो चरम पैरामीटर मानों को हतोत्साहित करता है और सरल मॉडल को प्रोत्साहित करता है।

रिज प्रतिगमन, जिसे L2 नियमितीकरण के रूप में भी जाना जाता है, मॉडल मापदंडों के वर्ग के अनुपात में एक दंड शब्द जोड़ता है। यह तकनीक छोटे पैरामीटर मान वाले मॉडल में परिणाम देती है, जिससे भिन्नता कम हो सकती है और सामान्यीकरण में सुधार हो सकता है। हालाँकि, यह फ़ीचर चयन नहीं करता है, इसलिए सभी सुविधाएँ मॉडल में बनी रहती हैं।

सर्वोत्तम प्रथाओं, उद्योग-स्वीकृत मानकों और शामिल चीट शीट के साथ, Git सीखने के लिए व्यावहारिक मार्गदर्शिका देखें। Googling Git कमांड को रोकें और वास्तव में सीखना यह!

लासो प्रतिगमन, या L1 नियमितीकरण, मॉडल पैरामीटर के निरपेक्ष मूल्य के अनुपात में एक जुर्माना शब्द जोड़ता है। यह तकनीक विरल पैरामीटर मान वाले मॉडल को जन्म दे सकती है, कुछ मापदंडों को शून्य पर सेट करके प्रभावी रूप से फीचर चयन कर सकती है। इसके परिणामस्वरूप सरल मॉडल हो सकते हैं जिनकी व्याख्या करना आसान है।

लोचदार शुद्ध नियमितीकरण L1 और L2 नियमितीकरण दोनों का एक संयोजन है, जो रिज और लासो प्रतिगमन के बीच संतुलन की अनुमति देता है। दो पेनल्टी शर्तों के बीच अनुपात को नियंत्रित करके, इलास्टिक नेट दोनों तकनीकों का लाभ प्राप्त कर सकता है, जैसे बेहतर सामान्यीकरण और फीचर चयन।

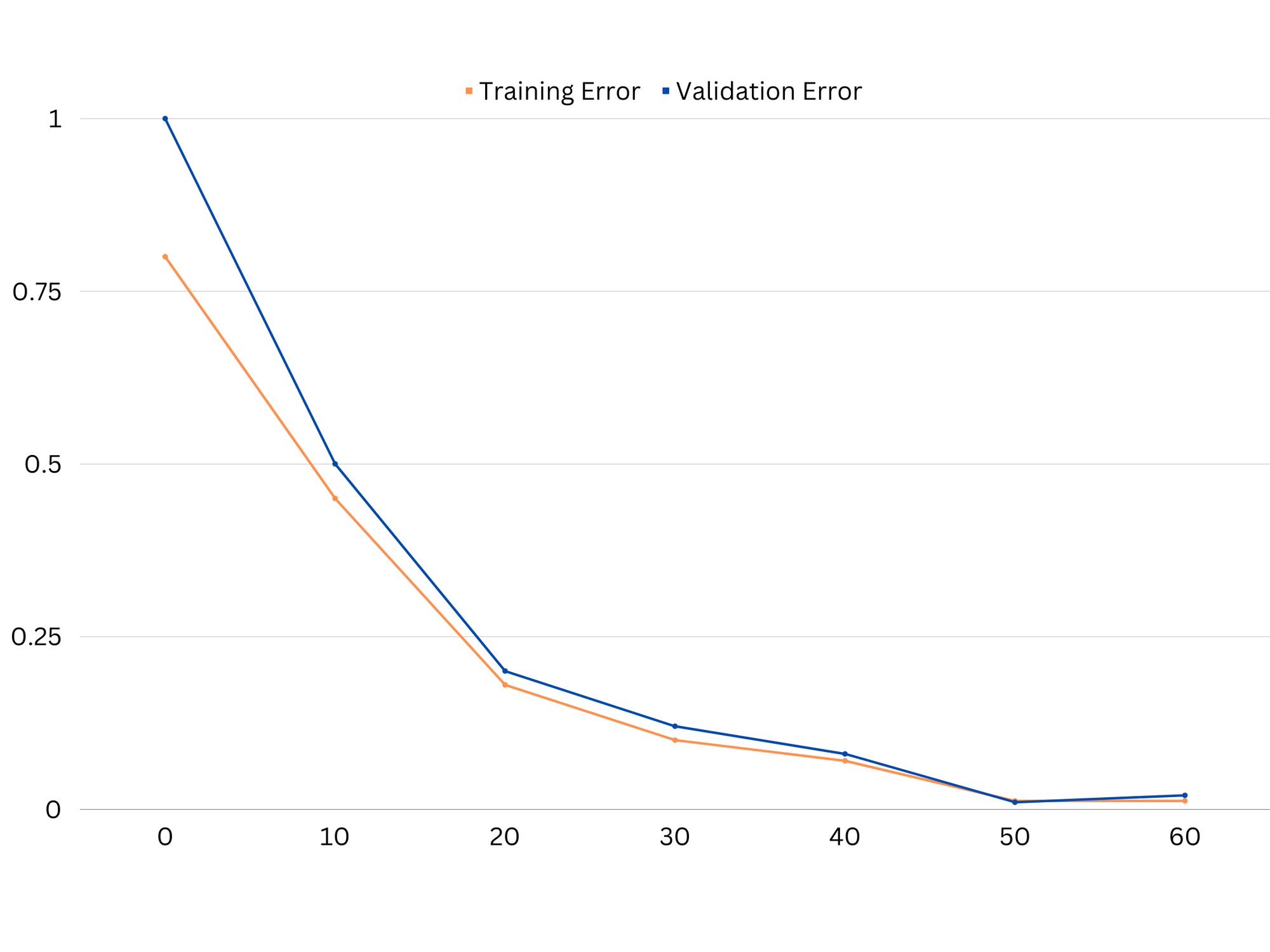

अच्छे फिटिंग मॉडल के लर्निंग कर्व्स का उदाहरण।

निष्कर्ष

बायस-वैरियंस ट्रेड-ऑफ मशीन लर्निंग में एक महत्वपूर्ण अवधारणा है जो एक मॉडल की प्रभावशीलता और अच्छाई को निर्धारित करती है। जबकि उच्च पूर्वाग्रह अंडरफिटिंग की ओर जाता है और उच्च विचरण ओवरफिटिंग की ओर जाता है, दोनों के बीच इष्टतम संतुलन का पता लगाना मजबूत मॉडल बनाने के लिए आवश्यक है जो नए डेटा को अच्छी तरह से सामान्य करता है।

लर्निंग कर्व्स की मदद से, ओवरफिटिंग या अंडरफिटिंग समस्याओं की पहचान करना संभव है, और मॉडल की जटिलता को ट्यून करके या नियमितीकरण तकनीकों को लागू करके, प्रशिक्षण और सत्यापन डेटा, साथ ही परीक्षण डेटा दोनों पर प्रदर्शन में सुधार करना संभव है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोआईस्ट्रीम। Web3 डेटा इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- मिंटिंग द फ्यूचर डब्ल्यू एड्रिएन एशले। यहां पहुंचें।

- PREIPO® के साथ PRE-IPO कंपनियों में शेयर खरीदें और बेचें। यहां पहुंचें।

- स्रोत: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :है

- :नहीं

- :कहाँ

- 1

- 12

- 20

- 8

- a

- क्षमता

- योग्य

- About

- पूर्ण

- सही रूप में

- पाना

- प्राप्त करने

- वास्तव में

- जोड़ने

- पता

- जोड़ता है

- फायदे

- सलाह

- को प्रभावित

- प्रभावित करने वाले

- कलन विधि

- सब

- की अनुमति दे

- भी

- an

- और

- कोई

- हैं

- लेख

- AS

- शेष

- शेष

- BE

- क्योंकि

- लाभ

- के बीच

- पूर्वाग्रह

- सीमा

- के छात्रों

- इमारत

- लेकिन

- by

- गणना

- कर सकते हैं

- क्षमताओं

- कब्जा

- मामला

- बदलना

- चुनने

- निकट से

- संयोजन

- तुलना

- जटिल

- जटिलता

- संकल्पना

- विचार करना

- नियंत्रित

- मूल

- सही

- महत्वपूर्ण

- तिथि

- सौदा

- कम हो जाती है

- निर्धारित करना

- निर्धारित

- अंतर

- विभिन्न

- प्रदर्शित करता है

- वितरण

- कर देता है

- दो

- से प्रत्येक

- पूर्व

- आसान

- प्रभावी रूप से

- प्रभावशीलता

- को प्रोत्साहित करती है

- पर्याप्त

- त्रुटि

- त्रुटियाँ

- और भी

- जांच

- उदाहरण

- समझाना

- चरम

- में नाकाम रहने

- विफल रहता है

- Feature

- विशेषताएं

- खोज

- फिट

- फिटिंग

- उतार-चढ़ाव

- फोकस

- के लिए

- समारोह

- मौलिक

- सामान्य जानकारी

- जाना

- लक्ष्य

- अच्छा

- जमीन

- गाइड

- हाथ

- हाथों पर

- है

- मदद

- मदद

- हाई

- उच्चतर

- मंडराना

- कैसे

- How To

- तथापि

- HTTPS

- पहचान करना

- if

- कार्यान्वयन

- असंभव

- में सुधार

- उन्नत

- in

- अन्य में

- शामिल

- शामिल

- बढ़ना

- बढ़ती

- निवेश

- में

- परिचय

- IT

- आईटी इस

- रखना

- जानने वाला

- L1

- l2

- नेतृत्व

- प्रमुख

- बिक्रीसूत्र

- सीख रहा हूँ

- चलो

- LG

- पसंद

- संभावित

- ll

- निम्न

- कम

- मशीन

- यंत्र अधिगम

- बनाता है

- उल्लेख किया

- कम से कम

- आदर्श

- मॉडल

- अधिक

- आवश्यक

- जाल

- नया

- शोर

- संख्या

- उद्देश्य

- of

- अक्सर

- on

- इष्टतम

- or

- अन्य

- हमारी

- आउट

- उत्पादन

- अपना

- प्राचल

- पैरामीटर

- पैटर्न

- निष्पादन

- प्रदर्शन

- प्रदर्शन

- प्रदर्शन

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- गरीब

- लोकप्रिय

- संभव

- व्यावहारिक

- अभ्यास

- भविष्यवाणी करना

- भविष्यवाणी

- को रोकने के

- समस्याओं

- प्रक्रिया

- प्रदान करना

- बल्कि

- अनुपात

- को कम करने

- घटी

- संदर्भित करता है

- सम्बंधित

- संबंध

- रिश्ते

- रहना

- प्रतिनिधित्व

- परिणाम

- जिसके परिणामस्वरूप

- परिणाम

- सही

- अंगूठी

- मजबूत

- s

- चयन

- संवेदनशीलता

- की स्थापना

- छाया

- चादर

- कम

- चाहिए

- सरल

- एक साथ

- छोटा

- छोटे

- So

- कुछ

- सूत्रों का कहना है

- चौकोर

- स्टैकब्यूज

- मानकों

- रुकें

- मजबूत

- ऐसा

- पता चलता है

- तकनीक

- अवधि

- शर्तों

- परीक्षण

- से

- कि

- RSI

- लेकिन हाल ही

- उन

- वहाँ।

- इन

- वे

- इसका

- भर

- सेवा मेरे

- भी

- साधन

- कुल

- रेलगाड़ी

- प्रशिक्षण

- संक्रमण

- <strong>उद्देश्य</strong>

- सच

- कोशिश

- दो

- आम तौर पर

- असमर्थ

- आधारभूत

- अज्ञात

- प्रयुक्त

- का उपयोग

- सत्यापन

- मूल्य

- मान

- बहुत

- we

- कुंआ

- क्या

- या

- कौन कौन से

- जब

- मर्जी

- साथ में

- शब्द

- जेफिरनेट

- शून्य