बड़े भाषा मॉडल (एलएलएम) का उपयोग जटिल दस्तावेजों का विश्लेषण करने और प्रश्नों के सारांश और उत्तर प्रदान करने के लिए किया जा सकता है। पोस्ट अमेज़ॅन सैजमेकर जम्पस्टार्ट में वित्तीय डेटा पर डोमेन-अनुकूलन फाउंडेशन मॉडल की फाइन-ट्यूनिंग वर्णन करता है कि अपने स्वयं के डेटासेट का उपयोग करके एलएलएम को कैसे बेहतर बनाया जाए। एक बार जब आपके पास एक ठोस एलएलएम हो, तो आप नए दस्तावेजों को संसाधित करने के लिए उस एलएलएम को व्यावसायिक उपयोगकर्ताओं के सामने उजागर करना चाहेंगे, जो सैकड़ों पेज लंबा हो सकता है। इस पोस्ट में, हम प्रदर्शित करते हैं कि व्यावसायिक उपयोगकर्ताओं को मनमानी लंबाई के पीडीएफ दस्तावेज़ को संसाधित करने देने के लिए वास्तविक समय उपयोगकर्ता इंटरफ़ेस का निर्माण कैसे किया जाए। एक बार फ़ाइल संसाधित हो जाने पर, आप दस्तावेज़ का सारांश प्रस्तुत कर सकते हैं या सामग्री के बारे में प्रश्न पूछ सकते हैं। इस पोस्ट में वर्णित नमूना समाधान यहां उपलब्ध है GitHub.

वित्तीय दस्तावेज़ों के साथ कार्य करना

त्रैमासिक आय रिपोर्ट और शेयरधारकों को वार्षिक रिपोर्ट जैसे वित्तीय विवरण अक्सर दसियों या सैकड़ों पृष्ठों लंबे होते हैं। इन दस्तावेज़ों में अस्वीकरण और कानूनी भाषा जैसी बहुत सारी बॉयलरप्लेट भाषा शामिल है। यदि आप इनमें से किसी दस्तावेज़ से मुख्य डेटा बिंदु निकालना चाहते हैं, तो आपको समय और बॉयलरप्लेट भाषा से कुछ परिचित होने की आवश्यकता है ताकि आप दिलचस्प तथ्यों की पहचान कर सकें। और निःसंदेह, आप एलएलएम से किसी ऐसे दस्तावेज़ के बारे में प्रश्न नहीं पूछ सकते जिसे उसने कभी नहीं देखा हो।

संक्षेपण के लिए उपयोग किए जाने वाले एलएलएम में मॉडल में पारित टोकन (वर्ण) की संख्या की एक सीमा होती है, और कुछ अपवादों के साथ, ये आम तौर पर कुछ हज़ार टोकन से अधिक नहीं होते हैं। यह आम तौर पर लंबे दस्तावेज़ों को सारांशित करने की क्षमता को रोकता है।

हमारा समाधान एलएलएम की अधिकतम टोकन अनुक्रम लंबाई से अधिक दस्तावेज़ों को संभालता है, और उस दस्तावेज़ को प्रश्न उत्तर के लिए एलएलएम को उपलब्ध कराता है।

समाधान अवलोकन

हमारे डिज़ाइन में तीन महत्वपूर्ण भाग हैं:

- इसमें व्यावसायिक उपयोगकर्ताओं के लिए पीडीएफ़ अपलोड करने और संसाधित करने के लिए एक इंटरैक्टिव वेब एप्लिकेशन है

- यह एक बड़े पीडीएफ को अधिक प्रबंधनीय खंडों में विभाजित करने के लिए लैंगचैन लाइब्रेरी का उपयोग करता है

- यह पुनर्प्राप्ति संवर्धित पीढ़ी तकनीक का उपयोग करता है ताकि उपयोगकर्ता नए डेटा के बारे में प्रश्न पूछ सकें जो एलएलएम ने पहले नहीं देखा है

जैसा कि निम्नलिखित चित्र में दिखाया गया है, हम रिएक्ट जावास्क्रिप्ट के साथ कार्यान्वित फ्रंट एंड का उपयोग करते हैं अमेज़न सरल भंडारण सेवा (अमेज़ॅन S3) बाल्टी सामने है अमेज़न CloudFront. फ्रंट-एंड एप्लिकेशन उपयोगकर्ताओं को Amazon S3 पर PDF दस्तावेज़ अपलोड करने देता है। अपलोड पूरा होने के बाद, आप संचालित टेक्स्ट निष्कर्षण कार्य को ट्रिगर कर सकते हैं अमेज़न टेक्सट्रेक. पोस्ट-प्रोसेसिंग के भाग के रूप में, ए AWS लाम्बा फ़ंक्शन पृष्ठ सीमाओं को इंगित करने वाले पाठ में विशेष मार्कर सम्मिलित करता है। जब वह काम पूरा हो जाता है, तो आप एक एपीआई लागू कर सकते हैं जो पाठ का सारांश प्रस्तुत करता है या इसके बारे में सवालों के जवाब देता है।

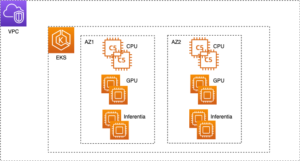

क्योंकि इनमें से कुछ चरणों में कुछ समय लग सकता है, आर्किटेक्चर एक डिकॉउल्ड एसिंक्रोनस दृष्टिकोण का उपयोग करता है। उदाहरण के लिए, किसी दस्तावेज़ को सारांशित करने के लिए कॉल एक लैम्ब्डा फ़ंक्शन को आमंत्रित करता है जो एक संदेश पोस्ट करता है अमेज़ॅन सरल कतार सेवा (अमेज़ॅन एसक्यूएस) कतार। एक अन्य लैम्ब्डा फ़ंक्शन उस संदेश को उठाता है और प्रारंभ करता है अमेज़ॅन इलास्टिक कंटेनर सेवा (अमेज़न ईसीएस) AWS फरगेट काम। फ़ार्गेट कार्य कॉल करता है अमेज़न SageMaker अनुमान समापन बिंदु. हम यहां फ़ार्गेट कार्य का उपयोग करते हैं क्योंकि एक बहुत लंबे पीडीएफ को सारांशित करने में उपलब्ध लैम्ब्डा फ़ंक्शन की तुलना में अधिक समय और मेमोरी लग सकती है। जब सारांश तैयार हो जाता है, तो फ्रंट-एंड एप्लिकेशन परिणाम प्राप्त कर सकता है अमेज़ॅन डायनेमोडीबी तालिका.

संक्षेपण के लिए, हम AI21 के सारांश मॉडल का उपयोग करते हैं, जो उपलब्ध मूलभूत मॉडलों में से एक है अमेज़न SageMaker जम्पस्टार्ट. हालाँकि यह मॉडल 10,000 शब्दों (लगभग 40 पृष्ठ) तक के दस्तावेज़ों को संभालता है, हम यह सुनिश्चित करने के लिए लैंगचैन के टेक्स्ट स्प्लिटर का उपयोग करते हैं कि एलएलएम के लिए प्रत्येक सारांश कॉल 10,000 शब्दों से अधिक लंबा नहीं है। टेक्स्ट जनरेशन के लिए, हम कोहेयर के मीडियम मॉडल का उपयोग करते हैं, और हम जंपस्टार्ट के माध्यम से एम्बेडिंग के लिए जीपीटी-जे का उपयोग करते हैं।

सारांशीकरण प्रसंस्करण

बड़े दस्तावेज़ों को संभालते समय, हमें यह परिभाषित करने की आवश्यकता है कि दस्तावेज़ को छोटे टुकड़ों में कैसे विभाजित किया जाए। जब हमें अमेज़ॅन टेक्स्टट्रैक्ट से टेक्स्ट निष्कर्षण परिणाम वापस मिलते हैं, तो हम टेक्स्ट के बड़े हिस्से (पेजों की कॉन्फ़िगर करने योग्य संख्या), व्यक्तिगत पेज और लाइन ब्रेक के लिए मार्कर डालते हैं। लैंगचैन उन मार्करों के आधार पर विभाजित होगा और छोटे दस्तावेज़ों को इकट्ठा करेगा जो टोकन सीमा के अंतर्गत हैं। निम्नलिखित कोड देखें:

सारांश श्रृंखला में एलएलएम हमारे सेजमेकर एंडपॉइंट के चारों ओर एक पतला आवरण है:

सवाल जवाब

पुनर्प्राप्ति संवर्धित पीढ़ी विधि में, हम पहले दस्तावेज़ को छोटे खंडों में विभाजित करते हैं। हम प्रत्येक सेगमेंट के लिए एम्बेडिंग बनाते हैं और उन्हें लैंगचैन के इंटरफ़ेस के माध्यम से ओपन-सोर्स क्रोमा वेक्टर डेटाबेस में संग्रहीत करते हैं। हम डेटाबेस को एक में सहेजते हैं अमेज़ॅन इलास्टिक फ़ाइल सिस्टम (अमेज़ॅन ईएफएस) फ़ाइल सिस्टम बाद में उपयोग के लिए। निम्नलिखित कोड देखें:

जब एम्बेडिंग तैयार हो जाती है, तो उपयोगकर्ता एक प्रश्न पूछ सकता है। हम टेक्स्ट के उन हिस्सों के लिए वेक्टर डेटाबेस खोजते हैं जो प्रश्न से सबसे अधिक मेल खाते हैं:

हम निकटतम मिलान खंड लेते हैं और प्रश्न का उत्तर देने के लिए इसे टेक्स्ट जनरेशन मॉडल के संदर्भ के रूप में उपयोग करते हैं:

प्रयोक्ता अनुभव

यद्यपि एलएलएम उन्नत डेटा विज्ञान का प्रतिनिधित्व करते हैं, एलएलएम के अधिकांश उपयोग के मामलों में अंततः गैर-तकनीकी उपयोगकर्ताओं के साथ बातचीत शामिल होती है। हमारा उदाहरण वेब एप्लिकेशन एक इंटरैक्टिव उपयोग के मामले को संभालता है जहां व्यावसायिक उपयोगकर्ता एक नया पीडीएफ दस्तावेज़ अपलोड और संसाधित कर सकते हैं।

निम्नलिखित चित्र उपयोगकर्ता इंटरफ़ेस दिखाता है. एक उपयोगकर्ता पीडीएफ अपलोड करके शुरुआत करता है। दस्तावेज़ को Amazon S3 में संग्रहीत करने के बाद, उपयोगकर्ता टेक्स्ट निष्कर्षण कार्य शुरू करने में सक्षम है। जब यह पूरा हो जाता है, तो उपयोगकर्ता सारांशीकरण कार्य शुरू कर सकता है या प्रश्न पूछ सकता है। उपयोगकर्ता इंटरफ़ेस चंक आकार और चंक ओवरलैप जैसे कुछ उन्नत विकल्पों को उजागर करता है, जो उन्नत उपयोगकर्ताओं के लिए उपयोगी होगा जो नए दस्तावेज़ों पर एप्लिकेशन का परीक्षण कर रहे हैं।

अगले चरण

एलएलएम महत्वपूर्ण नई सूचना पुनर्प्राप्ति क्षमताएं प्रदान करते हैं। व्यावसायिक उपयोगकर्ताओं को उन क्षमताओं तक सुविधाजनक पहुंच की आवश्यकता है। भविष्य के कार्य के लिए दो दिशाएँ हैं जिन पर विचार किया जाना चाहिए:

- जम्पस्टार्ट फाउंडेशन मॉडल में पहले से ही उपलब्ध शक्तिशाली एलएलएम का लाभ उठाएं। कोड की केवल कुछ पंक्तियों के साथ, हमारा नमूना एप्लिकेशन टेक्स्ट सारांश और निर्माण के लिए AI21 और Cohere से उन्नत एलएलएम को तैनात और उपयोग कर सकता है।

- इन क्षमताओं को गैर-तकनीकी उपयोगकर्ताओं के लिए सुलभ बनाएं। पीडीएफ दस्तावेज़ों को संसाधित करने के लिए एक शर्त दस्तावेज़ से पाठ निकालना है, और सारांशीकरण कार्यों को चलाने में कई मिनट लग सकते हैं। इसके लिए एसिंक्रोनस बैकएंड प्रोसेसिंग क्षमताओं के साथ एक सरल उपयोगकर्ता इंटरफ़ेस की आवश्यकता होती है, जिसे लैम्ब्डा और फ़ार्गेट जैसी क्लाउड-नेटिव सेवाओं का उपयोग करके डिज़ाइन करना आसान है।

हम यह भी ध्यान देते हैं कि एक पीडीएफ दस्तावेज़ अर्ध-संरचित जानकारी है। अनुभाग शीर्षकों जैसे महत्वपूर्ण संकेतों को प्रोग्रामेटिक रूप से पहचानना मुश्किल है, क्योंकि वे फ़ॉन्ट आकार और अन्य दृश्य संकेतकों पर निर्भर करते हैं। जानकारी की अंतर्निहित संरचना की पहचान करने से एलएलएम को डेटा को अधिक सटीक रूप से संसाधित करने में मदद मिलती है, कम से कम उस समय तक जब तक एलएलएम असीमित लंबाई के इनपुट को संभाल नहीं सकता।

निष्कर्ष

इस पोस्ट में, हमने दिखाया कि एक इंटरैक्टिव वेब एप्लिकेशन कैसे बनाया जाए जो व्यावसायिक उपयोगकर्ताओं को सारांश और प्रश्न उत्तर के लिए पीडीएफ दस्तावेजों को अपलोड और संसाधित करने की सुविधा देता है। हमने देखा कि उन्नत एलएलएम तक पहुंचने के लिए जम्पस्टार्ट फाउंडेशन मॉडल का लाभ कैसे उठाया जाए, और लंबे दस्तावेजों को संसाधित करने और उन्हें एलएलएम के लिए जानकारी के रूप में उपलब्ध कराने के लिए टेक्स्ट स्प्लिटिंग और पुनर्प्राप्ति संवर्धित पीढ़ी तकनीकों का उपयोग किया जाए।

इस समय, इन शक्तिशाली क्षमताओं को आपके उपयोगकर्ताओं के लिए उपलब्ध न कराने का कोई कारण नहीं है। हम आपको इसका उपयोग शुरू करने के लिए प्रोत्साहित करते हैं जम्पस्टार्ट फाउंडेशन मॉडल आज।

लेखक के बारे में

रैंडी डेफॉउ AWS में वरिष्ठ प्रिंसिपल सॉल्यूशंस आर्किटेक्ट हैं। उनके पास मिशिगन विश्वविद्यालय से एमएसईई है, जहां उन्होंने स्वायत्त वाहनों के लिए कंप्यूटर विज़न पर काम किया। उन्होंने कोलोराडो स्टेट यूनिवर्सिटी से एमबीए भी किया है। रैंडी ने प्रौद्योगिकी क्षेत्र में सॉफ्टवेयर इंजीनियरिंग से लेकर उत्पाद प्रबंधन तक विभिन्न पदों पर काम किया है। 2013 में बिग डेटा क्षेत्र में प्रवेश किया और उस क्षेत्र का पता लगाना जारी रखा। वह एमएल क्षेत्र में परियोजनाओं पर सक्रिय रूप से काम कर रहे हैं और उन्होंने स्ट्रेटा और ग्लूकॉन सहित कई सम्मेलनों में प्रस्तुति दी है।

रैंडी डेफॉउ AWS में वरिष्ठ प्रिंसिपल सॉल्यूशंस आर्किटेक्ट हैं। उनके पास मिशिगन विश्वविद्यालय से एमएसईई है, जहां उन्होंने स्वायत्त वाहनों के लिए कंप्यूटर विज़न पर काम किया। उन्होंने कोलोराडो स्टेट यूनिवर्सिटी से एमबीए भी किया है। रैंडी ने प्रौद्योगिकी क्षेत्र में सॉफ्टवेयर इंजीनियरिंग से लेकर उत्पाद प्रबंधन तक विभिन्न पदों पर काम किया है। 2013 में बिग डेटा क्षेत्र में प्रवेश किया और उस क्षेत्र का पता लगाना जारी रखा। वह एमएल क्षेत्र में परियोजनाओं पर सक्रिय रूप से काम कर रहे हैं और उन्होंने स्ट्रेटा और ग्लूकॉन सहित कई सम्मेलनों में प्रस्तुति दी है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. ऑटोमोटिव/ईवीएस, कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- BlockOffsets. पर्यावरणीय ऑफसेट स्वामित्व का आधुनिकीकरण। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/use-a-generative-ai-foundation-model-for-summarization-and-question-answering-using-your-own-data/

- :हैस

- :है

- :नहीं

- :कहाँ

- $यूपी

- 000

- 10

- 100

- 13

- 14

- 15% तक

- 2013

- 25

- 40

- 500

- 7

- a

- क्षमता

- योग्य

- About

- इसके बारे में

- पहुँच

- सुलभ

- सही रूप में

- सक्रिय रूप से

- उन्नत

- लाभ

- बाद

- AI

- पहले ही

- भी

- हालांकि

- वीरांगना

- अमेज़न SageMaker

- अमेज़न SageMaker जम्पस्टार्ट

- अमेज़न टेक्सट्रेक

- अमेज़ॅन वेब सेवा

- an

- विश्लेषण करें

- और

- वार्षिक

- अन्य

- जवाब

- जवाब

- एपीआई

- आवेदन

- दृष्टिकोण

- लगभग

- स्थापत्य

- हैं

- क्षेत्र

- चारों ओर

- AS

- At

- संवर्धित

- लेखक

- स्वायत्त

- स्वायत्त वाहनों

- उपलब्ध

- एडब्ल्यूएस

- वापस

- बैकएण्ड

- आधारित

- BE

- क्योंकि

- बड़ा

- बड़ा डेटा

- के छात्रों

- सीमाओं

- टूट जाता है

- निर्माण

- व्यापार

- by

- कॉल

- कॉल

- कर सकते हैं

- क्षमताओं

- मामला

- मामलों

- श्रृंखला

- अक्षर

- निकट से

- कोड

- कोलोराडो

- पूरा

- जटिल

- कंप्यूटर

- Computer Vision

- सम्मेलनों

- विचार करना

- निर्माण

- शामिल

- कंटेनर

- सामग्री

- प्रसंग

- जारी

- सुविधाजनक

- सका

- कोर्स

- बनाना

- तिथि

- डेटा अंक

- डेटा विज्ञान

- डाटाबेस

- decoupled

- परिभाषित

- दिखाना

- तैनात

- वर्णित

- डिज़ाइन

- मुश्किल

- दस्तावेज़

- दस्तावेजों

- किया

- से प्रत्येक

- कमाई

- आसान

- प्रोत्साहित करना

- समाप्त

- endpoint

- अभियांत्रिकी

- घुसा

- उदाहरण

- से अधिक

- का पता लगाने

- उद्धरण

- तथ्यों

- सुपरिचय

- कुछ

- पट्टिका

- वित्तीय

- प्रथम

- निम्नलिखित

- के लिए

- बुनियाद

- से

- सामने

- फ़्रंट एंड

- समारोह

- भविष्य

- पीढ़ी

- उत्पादक

- जनरेटिव एआई

- मिल

- संभालना

- हैंडल

- हैंडलिंग

- है

- he

- धारित

- मदद करता है

- यहाँ उत्पन्न करें

- रखती है

- मेजबानी

- कैसे

- How To

- http

- HTTPS

- सैकड़ों

- पहचान करना

- पहचान

- if

- कार्यान्वित

- महत्वपूर्ण

- in

- सहित

- संकेतक

- व्यक्ति

- करें-

- निवेश

- आवेषण

- बातचीत

- इंटरैक्टिव

- दिलचस्प

- इंटरफेस

- में

- का आह्वान

- शामिल करना

- IT

- जावास्क्रिप्ट

- काम

- नौकरियां

- जेपीजी

- केवल

- कुंजी

- भाषा

- बड़ा

- बड़ा

- बाद में

- कम से कम

- कानूनी

- लंबाई

- चलो

- चलें

- पुस्तकालय

- पसंद

- सीमा

- लाइन

- पंक्तियां

- एलएलएम

- लोडर

- लंबा

- लंबे समय तक

- लॉट

- बनाना

- प्रबंधनीय

- प्रबंध

- मैच

- मिलान

- अधिकतम

- मई..

- मध्यम

- याद

- message

- तरीका

- मिशिगन

- मिनटों

- ML

- आदर्श

- मॉडल

- अधिक

- अधिकांश

- आवश्यकता

- कभी नहीँ

- नया

- नहीं

- गैर तकनिकि

- सामान्य रूप से

- संख्या

- अनेक

- of

- अक्सर

- on

- एक बार

- ONE

- खुला स्रोत

- ऑप्शंस

- or

- अन्य

- हमारी

- अपना

- पृष्ठ

- पृष्ठों

- भाग

- पारित कर दिया

- पीडीएफ

- चुनना

- की पसंद

- चित्र

- टुकड़े

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- बिन्दु

- अंक

- पदों

- पद

- पोस्ट

- संचालित

- शक्तिशाली

- प्रस्तुत

- प्रिंसिपल

- प्रक्रिया

- प्रसंस्कृत

- प्रसंस्करण

- एस्ट्रो मॉल

- उत्पाद प्रबंधन

- परियोजनाओं

- प्रदान करना

- प्रश्न

- प्रशन

- लेकर

- प्रतिक्रिया

- तैयार

- वास्तविक समय

- कारण

- भरोसा करना

- रिपोर्ट

- प्रतिनिधित्व

- प्रतिक्रिया

- प्रतिक्रियाएं

- परिणाम

- वापसी

- रन

- sagemaker

- सहेजें

- देखा

- विज्ञान

- Search

- अनुभाग

- देखना

- देखा

- खंड

- खंड

- स्व

- वरिष्ठ

- अनुक्रम

- सेवाएँ

- कई

- शेयरधारकों

- पता चला

- दिखाया

- दिखाता है

- महत्वपूर्ण

- सरल

- आकार

- आकार

- छोटे

- So

- सॉफ्टवेयर

- सॉफ्टवेयर इंजीनियरिंग

- ठोस

- समाधान

- समाधान ढूंढे

- कुछ

- अंतरिक्ष

- विशेष

- विभाजित

- विभाजन

- प्रारंभ

- शुरू होता है

- राज्य

- बयान

- कदम

- रुकें

- भंडारण

- की दुकान

- संग्रहित

- संरचना

- ऐसा

- संक्षेप में प्रस्तुत करना

- सारांश

- निश्चित

- प्रणाली

- तालिका

- लेना

- कार्य

- तकनीक

- टेक्नोलॉजी

- है

- परीक्षण

- से

- कि

- RSI

- उन

- वहाँ।

- इन

- वे

- इसका

- उन

- तीन

- यहाँ

- पहर

- सेवा मेरे

- आज

- टोकन

- टोकन

- ट्रिगर

- दो

- आम तौर पर

- अंत में

- के अंतर्गत

- आधारभूत

- विश्वविद्यालय

- जब तक

- अपलोड हो रहा है

- उपयोग

- उदाहरण

- प्रयुक्त

- उपयोगकर्ता

- यूजर इंटरफेस

- उपयोगकर्ताओं

- का उपयोग करता है

- का उपयोग

- विविधता

- वाहन

- बहुत

- के माध्यम से

- दृष्टि

- करना चाहते हैं

- we

- वेब

- वेब एप्लीकेशन

- वेब सेवाओं

- कब

- कौन कौन से

- कौन

- मर्जी

- साथ में

- शब्द

- काम

- काम किया

- काम कर रहे

- होगा

- आप

- आपका

- जेफिरनेट