Felhasználói adatok: LLM-ek Vital Food

Igen! RT @bryce szeretem ezt az idézetet „Ha nem fizetsz érte, nem vagy az ügyfél; te vagy az eladott termék." http://bit.ly/93JYCJ

- Tim O'Reilly (@timoreilly) 2. szeptember 2010.

Maradjon naprakész a kriptográfiai hírekkel, és napi frissítéseket kaphat a postaládájában.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :van

- :is

- :nem

- 7

- 8

- a

- képesség

- Abszolút

- Szerint

- pontos

- alkalmazkodás

- címzés

- Hozzáteszi

- fejlett

- Augusztus

- egyetért

- AI

- AI szolgáltatások

- AI rendszerek

- célok

- Alexa

- Igazítás

- Minden termék

- lehetővé teszi, hogy

- Is

- mindig

- amazon

- an

- és a

- Antropikus

- számít

- bármilyen

- alkalmazható

- VANNAK

- AS

- feltételezni

- At

- elérhető

- elkerülve

- tudatában van

- alapján

- BE

- mert

- hogy

- úgy

- előnyös

- Jobb

- között

- by

- TUD

- követelések

- ügyfél részére

- kereskedelmi

- elkötelezettség

- követ

- Companies

- vállalat

- versenyképes

- koncepció

- aggodalmak

- állandóan

- tartalom

- kontextus

- folyamatosan

- ellenőrzés

- Kényelmes

- beszélgetések

- copyright

- tudott

- kritikus

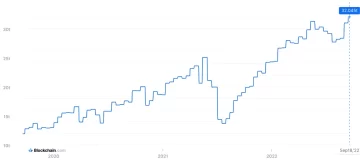

- crypto

- Crypto News

- Jelenlegi

- vevő

- Ügyfelek

- napi

- sötét

- dátum

- Adatvédelem

- vita

- évtizedek

- visszafejtése

- mély

- mély tanulás

- alapértelmezett

- Védekezés

- átadó

- függ

- lemond

- viták

- Sokféleség

- do

- dokumentum

- nem

- dollár

- ne

- alatt

- bevételt hozó

- él

- hatékonyság

- bármelyik

- eljegyzés

- fokozása

- biztosítja

- alapvető

- etikai

- etika

- példa

- csere

- tapasztalat

- kiterjedt

- mérték

- külső

- néző

- A

- Korábbi

- Alapított

- Ingyenes

- ból ből

- egyre

- generál

- generált

- generál

- nemző

- Generatív AI

- kap

- szerzés

- óriások

- Ad

- Go

- biztosít

- fogás

- növekszik

- súlyosan

- becsületes

- becsület

- azonban

- http

- HTTPS

- emberi

- ideálok

- if

- javul

- in

- egyéni

- információ

- szellemi

- szellemi tulajdon

- szándékok

- kölcsönhatások

- belső

- IP

- IT

- ITS

- maga

- Kulcs

- nyelv

- nagy

- legutolsó

- Törvény

- vezet

- TANUL

- tanulás

- Jogi

- Tőkeáttétel

- mint

- Láma

- LLM

- szerelem

- csinál

- Gyártás

- Lehet..

- Média

- meta

- Több millió

- modell

- modellek

- több

- a legtöbb

- hálózatok

- ideg-

- neurális hálózatok

- Új

- hír

- megszerzése

- of

- on

- OpenAI

- or

- látszólag

- másképp

- mi

- ki

- kimenetek

- felett

- saját

- tulajdonosa

- fizetett

- fél

- párt

- minták

- Fizet

- fizet

- személyes

- Testreszabás

- Személyre

- képek

- Plató

- Platón adatintelligencia

- PlatoData

- politika

- potenciális

- hatalom

- erős

- gyakorlat

- előre

- Tippek

- preferenciák

- uralkodó

- magánélet

- magán

- Készült

- Termékek

- utasításokat

- ingatlan

- ad

- biztosít

- nyilvános

- közbizalom

- nyilvánosan

- idézet

- verseny

- RE

- való Világ

- kap

- finomítani

- tekintik

- relatív

- engedje

- Számolt

- kéri

- kutatók

- felelős

- Revealed

- jogok

- rivális

- rt

- Ryan

- s

- azt mondják

- azt mondja,

- színhely

- szolgáltatás

- Szolgáltatások

- készlet

- Megosztás

- kellene

- Szkepticizmus

- So

- Közösség

- Közösségi média

- eladott

- VARÁZSLAT

- szóvivő

- indítás

- nyilatkozat

- tartózkodás

- Lépés

- Systems

- Tandem

- tech

- tech óriások

- technikák

- feltételek

- szöveg

- hogy

- A

- azok

- Őket

- Ezek

- ők

- ezt

- Tim

- nak nek

- Ma

- felső

- Vonat

- kiképzett

- Képzések

- Átláthatóság

- Trends

- Bízzon

- alatt

- megért

- megértés

- közelgő

- frissítve

- Frissítés

- frissített

- feltöltve

- használ

- használt

- használó

- Felhasználók

- segítségével

- Értékes

- különféle

- változat

- Videók

- fontos

- Hang

- kötet

- volt

- we

- voltak

- amikor

- vajon

- ami

- miért

- lesz

- val vel

- szó

- lenne

- te

- A te

- zephyrnet