Ezt a bejegyzést Shibangi Saha, adatkutató és Graciela Kravtzov, az Equilibrium Point társalapítója és technológiai igazgatója közösen írták.

Sok egyén a mentális betegségek új tüneteit tapasztalja, mint például a stressz, a szorongás, a depresszió, a szerhasználat és a poszttraumás stressz zavar (PTSD). Alapján Kaiser Család Alapítvány, országszerte a felnőttek mintegy fele (47%) számolt be negatív mentális egészségi hatásokról a világjárvány alatt, ami jelentős növekedés a pandémia előtti szinthez képest. Ezenkívül bizonyos nemek és korcsoportok azok közé tartoznak, amelyek a legvalószínűbben számolnak be stresszről és aggodalomról, sokkal magasabb arányban, mint mások. Ezenkívül néhány meghatározott etnikai csoport nagyobb valószínűséggel számol be „jelentős hatásról” a mentális egészségére, mint mások.

Számos felmérés, köztük a Centers for Disease Control (CDC) által gyűjtött felmérések jelentős növekedést mutattak ki az önbevallott viselkedés-egészségügyi tünetek számában. Egy CDC-jelentés szerint, amely 2020 júniusának végén kérdezett meg felnőtteket szerte az Egyesült Államokban, a válaszadók 31%-a szorongás vagy depresszió tüneteiről számolt be, 13%-a számolt be arról, hogy elkezdte vagy növelte a szerhasználatot, 26%-a stresszel kapcsolatos tünetekről számolt be, és 11%-a. arról számolt be, hogy az elmúlt 30 napban komoly öngyilkossági gondolatai voltak.

Az önbevallott adatok, bár abszolút kritikusak a mentális egészségi rendellenességek diagnosztizálásában, ki vannak téve a mentális egészséget és a mentálhigiénés kezelést övező folyamatos megbélyegzéssel kapcsolatos hatásoknak. Ahelyett, hogy kizárólag saját bevallású adatokra hagyatkoznánk, megbecsülhetjük és előrejelezhetjük a mentális szorongást az egészségügyi nyilvántartásokból és állításokból származó adatok segítségével, hogy megpróbáljunk választ adni egy alapvető kérdésre: meg tudjuk-e jósolni, hogy kinek lesz szüksége mentális egészségügyi segítségre, mielőtt szüksége lenne rá? Ha ezek az egyének azonosíthatók, korai intervenciós programokat és forrásokat lehet kidolgozni és bevetni az alaptünetek új vagy fokozódó tüneteire való reagálás érdekében a mentális zavarok hatásainak és költségeinek mérséklése érdekében.

Könnyebb mondani, mint megtenni azoknak, akik nagy mennyiségű összetett, hiányos követelési adat kezelésével és feldolgozásával küszködtek! Ebben a bejegyzésben megosztjuk, hogyan Egyensúlyi pont IoT használt Amazon SageMaker Data Wrangler az igényekre vonatkozó adatok előkészítésének egyszerűsítése a mentális egészségügyi felhasználási eseteinkhez, miközben a folyamat minden lépésében biztosítjuk az adatminőséget.

Megoldás áttekintése

Az adatok előkészítése vagy a jellemzők tervezése fárasztó folyamat, amely tapasztalt adattudósoktól és mérnököktől sok időt és energiát igényel, hogy recepteket dolgozzanak ki az adatok megfelelő formájának kialakításához szükséges különféle átalakításokhoz (lépésekhez). Valójában a kutatások azt mutatják, hogy az adatok gépi tanuláshoz (ML) való előkészítése az adattudósok idejének akár 80%-át is igénybe veszi. A tudósok és mérnökök általában különféle adatfeldolgozási keretrendszereket használnak, mint például a Pandas, a PySpark és az SQL, hogy kódolják átalakításaikat és elosztott feldolgozási feladatokat hozzanak létre. A Data Wrangler segítségével automatizálhatja ezt a folyamatot. A Data Wrangler egy összetevője Amazon SageMaker Studio amely teljes körű megoldást kínál adatok importálására, előkészítésére, átalakítására, jellemzésére és elemzésére. Integrálhat egy Data Wrangler-t adatáramlás beillesztheti a meglévő ML munkafolyamataiba, hogy egyszerűsítse és racionalizálja az adatfeldolgozást és a funkciótervezést, kis vagy semmilyen kódolás nélkül.

Ebben a bejegyzésben végigvezetjük az eredeti nyers adatkészletek ML-kompatibilis funkciókká történő átalakításának lépéseit, amelyeket a következő szakaszban az előrejelzési modellek felépítéséhez használhatunk. Először is megvizsgáljuk a használati esetünkhöz használt különféle adatkészletek természetét, és azt, hogy hogyan kapcsoltuk össze ezeket az adatkészleteket a Data Wrangler segítségével. Az összeillesztések és az adatkészlet-konszolidáció után leírjuk az adatkészleten alkalmazott egyedi átalakításokat, például a duplikáció megszüntetését, a hiányzó értékek kezelését és az egyéni képleteket, majd azt, hogyan használtuk a beépített Gyorsmodell elemzést az átalakítások aktuális állapotának ellenőrzésére. jóslatokhoz.

Datasets

Kísérletünkhöz először betegadatokat töltöttünk le viselkedés-egészségügyi kliensünktől. Ezek az adatok a következőket tartalmazzák:

- A követelések adatai

- A sürgősségi osztály látogatása számít

- A fekvőbeteg látogatás számít

- A mentális egészséggel kapcsolatos gyógyszerfelírások száma

- A hierarchikus állapotkódolás (HCC) a mentális egészséggel kapcsolatos diagnózisokat határozza meg

A cél az volt, hogy egyesítse ezeket a különálló adatkészleteket a betegazonosító alapján, és felhasználja az adatokat a mentális egészségügyi diagnózis előrejelzésére. A Data Wrangler segítségével több millió adatsorból álló hatalmas adatkészletet hoztunk létre, amely öt különálló adatkészlet egyesítése. A Data Wrangler segítségével számos transzformációt is végrehajtottunk, hogy lehetővé tegyük az oszlopszámításokat. A következő részekben ismertetjük az általunk alkalmazott különféle adat-előkészítési transzformációkat.

Az ismétlődő oszlopok eldobása az összekapcsolás után

Az Amazon SageMaker Data Wrangler számos ML adatátalakítást kínál az adatok tisztításának, átalakításának és jellemzőinek egyszerűsítésére. Amikor hozzáad egy átalakítást, az hozzáad egy lépést az adatfolyamhoz. Minden hozzáadott átalakítás módosítja az adatkészletet, és új adatkeretet hoz létre. Minden ezt követő átalakítás az eredményül kapott adatkeretre vonatkozik. A Data Wrangler beépített átalakításokat tartalmaz, amelyek segítségével kód nélkül alakíthatja át az oszlopokat. Egyéni átalakításokat is hozzáadhat a PySpark, a Pandas és a PySpark SQL használatával. Egyes átalakítások a helyükön működnek, míg mások új kimeneti oszlopot hoznak létre az adatkészletben.

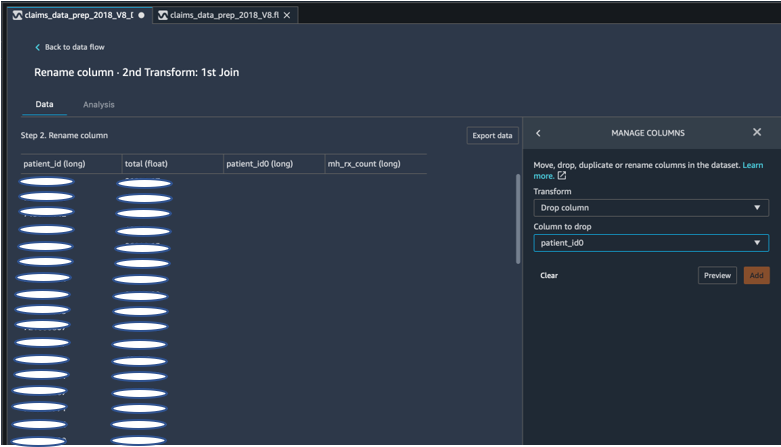

Kísérleteinkhez, mivel a páciensazonosítón minden egyes csatlakozás után ismétlődő betegazonosító oszlopok maradtak. El kellett dobnunk ezeket az oszlopokat. Eldobtuk a jobb oldali betegazonosító oszlopot, amint az a következő képernyőképen látható, az előre elkészített készlet használatával Oszlopok kezelése ->Dobja el az oszlopot átalakítja, hogy csak egy betegazonosító oszlopot tartson fenn (patient_id a végső adatkészletben).

Adatkészlet elforgatása a Pandas használatával

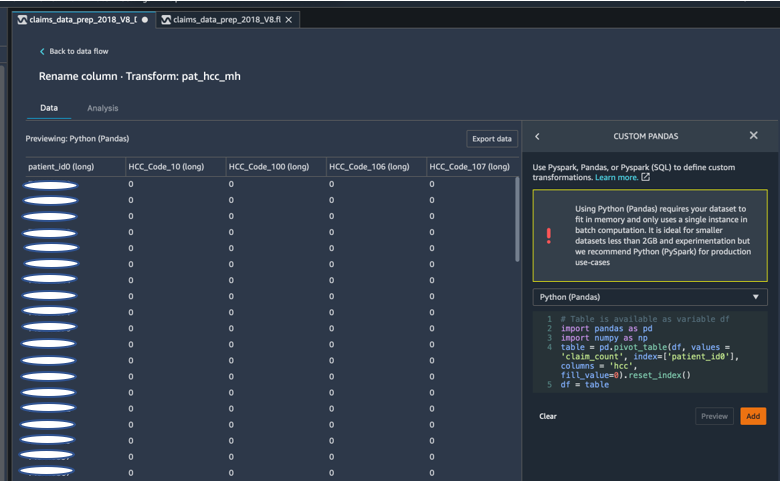

Az állítások adatkészletei betegszintűek voltak a sürgősségi vizittel (ER), a fekvőbeteggel (IP), a felírt számokkal és a diagnózisokkal, amelyek már csoportosítva voltak a megfelelő HCC-kódokkal (körülbelül 189 kód). A betegadattár felépítéséhez páciensenként összesítjük a követelések HCC-kódjait, és a HCC-kódot sorokról oszlopokra forgatjuk. Pandas segítségével elforgattuk az adatkészletet, megszámoltuk a HCC-kódok számát páciensenként, majd csatlakoztunk a páciensazonosító elsődleges adatkészletéhez. A Data Wrangler egyéni átalakítási opcióját használtuk, és a Python (Pandas) keretrendszert választottuk.

A következő kódrészlet a táblázat elforgatásához szükséges átalakítási logikát mutatja:

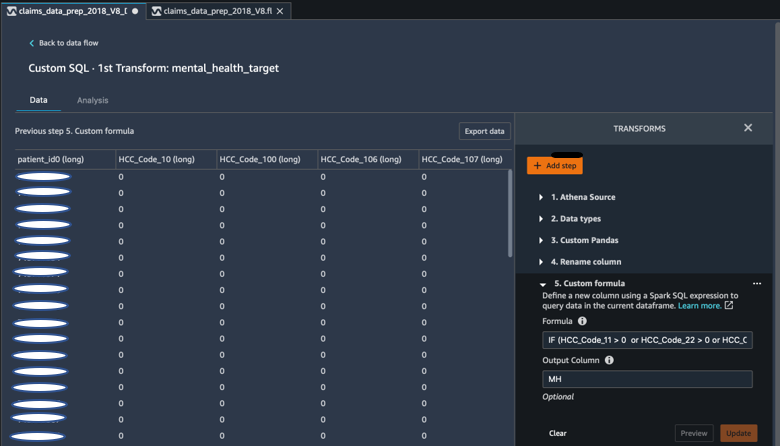

Hozzon létre új oszlopokat egyéni képletekkel

Tanulmányoztuk a kutatási szakirodalmat, hogy meghatározzuk, mely HCC kódok determinisztikusak a mentális egészséggel kapcsolatos diagnózisokban. Ezután ezt a logikát egy Data Wrangler egyéni képlettranszformációval írtuk meg, amely egy Spark SQL kifejezést használ a Mental Health Diagnosis céloszlop (MH) kiszámításához, amelyet hozzáadtunk a DataFrame végéhez.

A következő transzformációs logikát használtuk:

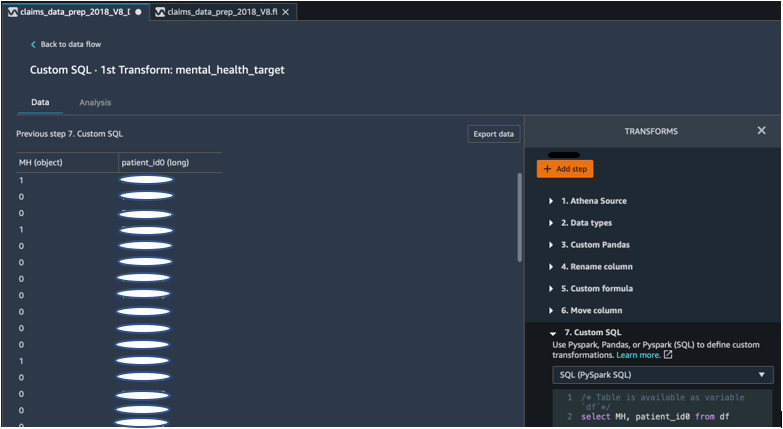

Dobja el az oszlopokat a DataFrame-ből a PySpark segítségével

A céloszlop (MH) kiszámítása után az összes felesleges ismétlődő oszlopot eldobtuk. Megőriztük a betegazonosítót és az MH oszlopot, hogy csatlakozhassunk elsődleges adatkészletünkhöz. Ezt egy egyéni SQL-átalakítás segítette elő, amely a PySpark SQL-t választotta keretrendszerként.

A következő logikát használtuk:

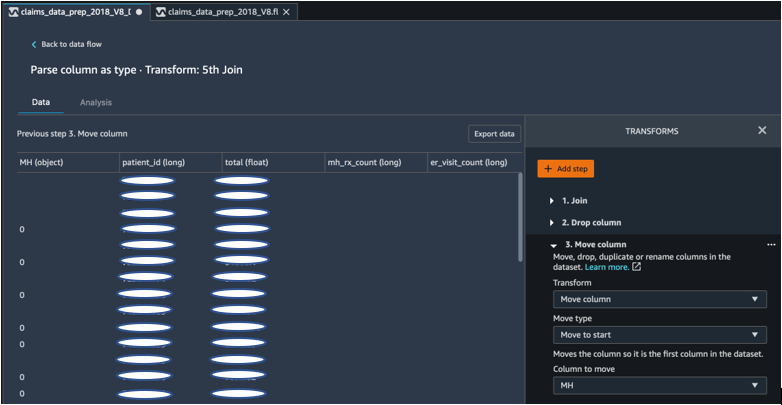

A kezdéshez mozgassa az MH oszlopot

ML algoritmusunk megköveteli, hogy a címkézett bemenet az első oszlopban legyen. Ezért az MH számított oszlopot áthelyeztük a DataFrame elejére, hogy készen álljon az exportálásra.

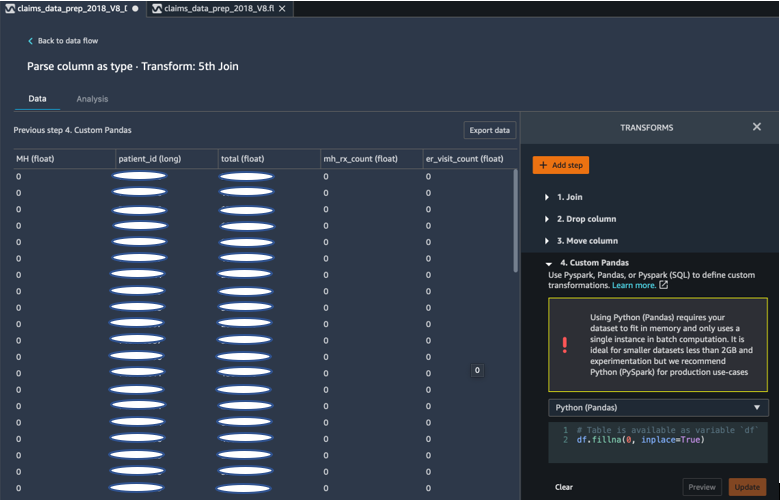

Töltse ki az üres helyeket 0-val a Pandák használatával

Az ML algoritmusunk azt is megköveteli, hogy a bemeneti adatokban ne legyenek üres mezők. Ezért a végső adatkészlet üres mezőit 0-val töltöttük ki. Ezt egyszerűen megtehetjük egy egyedi transzformációval (Pandas) a Data Wranglerben.

A következő logikát használtuk:

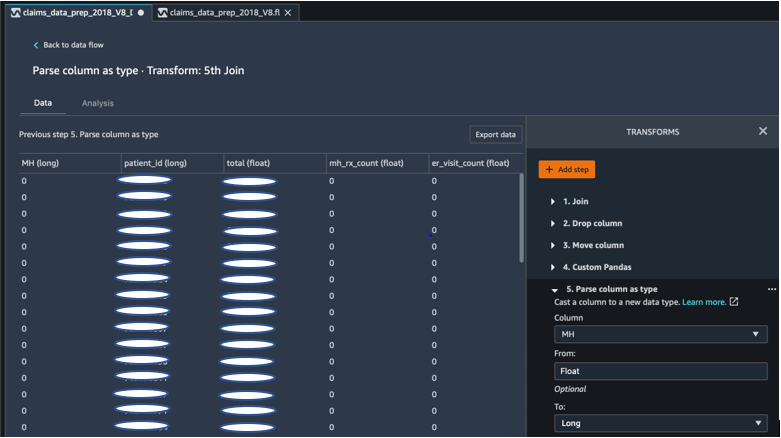

Öntött oszlop úszóból hosszúra

A Data Wranglerben könnyen elemezhet és átküldhet egy oszlopot bármilyen új adattípusra. Memóriaoptimalizálás céljából a mentálhigiénés címke beviteli oszlopát floatként öntjük.

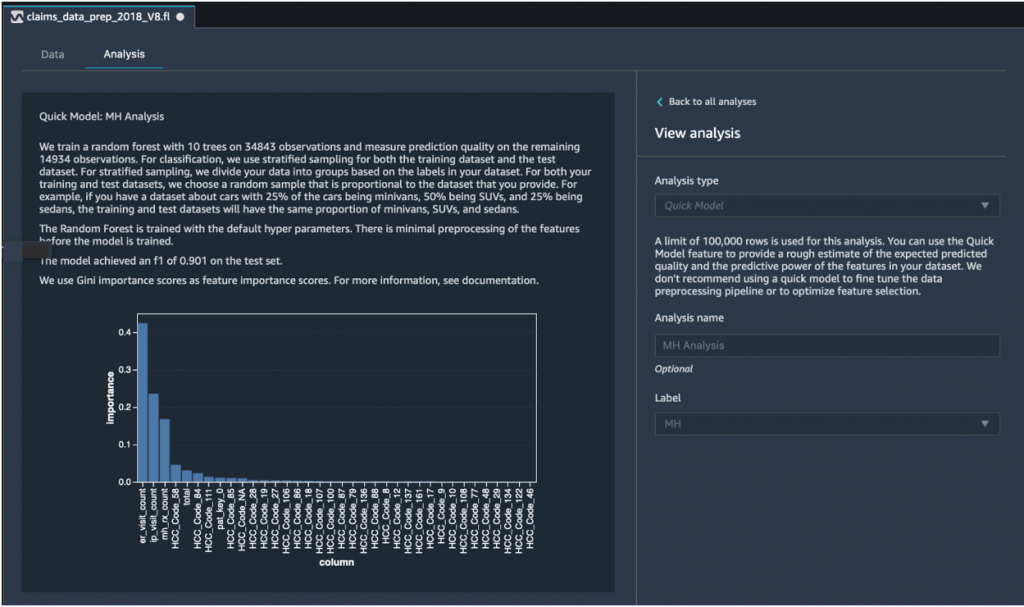

Gyors modellelemzés: Funkció fontossági grafikonja

A végső adatkészletünk elkészítése után a Data Wrangler gyorsmodell-elemzési típusát használtuk, hogy gyorsan azonosítsuk az adatok inkonzisztenciáit, és azt, hogy a modell pontossága a várt tartományban van-e, vagy ha folytatnunk kell a jellemzők tervezését, mielőtt a modell betanítására fordítanánk az időt. A modell 1-es F0.901-es pontszámot adott, ahol az 1 a legmagasabb. Az F1-es pontszám a modell pontosságának és felidézésének egyesítésének módja, és a kettő harmonikus átlagaként definiálható. Miután megvizsgáltuk ezeket a kezdeti pozitív eredményeket, készen álltunk az adatok exportálására és a modell betanítására az exportált adatkészlet felhasználásával.

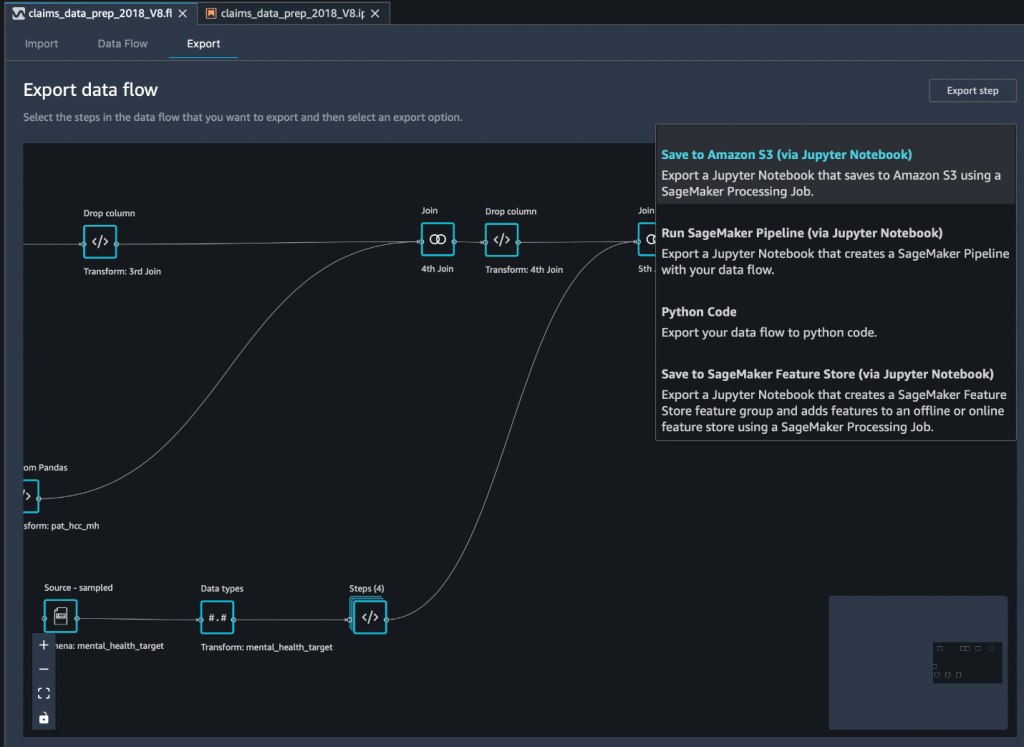

Exportálja a végső adatkészletet az Amazon S3-ba egy Jupyter notebookon keresztül

Utolsó lépésként az adatkészlet exportálása jelenlegi formájában (átalakítva) ide Amazon egyszerű tárolási szolgáltatás (Amazon S3) a jövőbeni modellképzéshez használjuk a Mentés az Amazon S3-ra (a Jupyter Notebookon keresztül) exportálási lehetőség. Ez a notebook elindít egy elosztott és méretezhető Amazon SageMaker feldolgozás feladat, amely a létrehozott receptet (adatfolyamot) alkalmazza a megadott bemenetekre (általában nagyobb adatkészletekre), és elmenti az eredményeket az Amazon S3-ba. Az átalakított oszlopokat (szolgáltatásokat) ide is exportálhatja Amazon SageMaker Feature Store vagy exportálja a transzformációkat folyamatként a segítségével Amazon SageMaker csővezetékek, vagy egyszerűen exportálja a transzformációkat Python-kódként.

Az adatok Amazon S3-ba történő exportálásához három lehetőség közül választhat:

- Exportálja az átalakított adatokat közvetlenül az Amazon S3-ba a Data Wrangler UI-n keresztül

- Exportálja az átalakításokat SageMaker feldolgozási feladatként egy Jupyter notebookon keresztül (ahogyan ezt a bejegyzést is tesszük).

- Exportálja az átalakításokat az Amazon S3-ba egy célcsomóponton keresztül. A feldolgozás után egy célcsomópont közli a Data Wranglerrel, hogy hol tárolja az adatokat. A célcsomópont létrehozása után létrehoz egy feldolgozási feladatot az adatok kimenetéhez.

Következtetés

Ebben a bejegyzésben bemutattuk, hogy az Equilibrium Point IoT hogyan használja a Data Wrangler-t, hogy felgyorsítsa a nagy mennyiségű követelési adatunk betöltésének folyamatát adattisztítás és -átalakítás céljából az ML előkészítése során. Azt is bemutattuk, hogyan építhetjük be a funkciótervezést egyedi átalakításokkal a Pandas és a PySpark használatával a Data Wranglerben, lehetővé téve számunkra, hogy lépésről lépésre (minden egyes csatlakozás után) exportáljuk az adatokat minőségbiztosítási célból. Ezeknek a könnyen használható átalakításoknak a Data Wranglerben történő alkalmazása közel 50%-kal csökkenti a végpontok közötti adatátalakításra fordított időt. Ezenkívül a Data Wrangler gyorsmodell-elemzési funkciója lehetővé tette számunkra, hogy könnyen ellenőrizzük az átalakítások állapotát, miközben végighaladunk az adat-előkészítési és a funkciótervezési folyamaton.

Most, hogy előkészítettük az adatokat a mentális egészségkockázat modellezési esetünkhöz, következő lépésként egy ML modell felépítését tervezzük a SageMaker és az általa kínált beépített algoritmusok felhasználásával, állítási adatkészletünk felhasználásával azon tagok azonosítására, akiknek a mentális egészséget kell keresniük. szolgáltatásokat, mielőtt eljutnak arra a pontra, ahol szükségük van rá. Maradjon velünk!

A szerzőkről

Shibangi Saha az Equilibrium Point adatkutatója. Az egészségügyi kifizető adatokkal kapcsolatos szakértelmét és a gépi tanulást egyesíti, hogy megtervezze, implementálja, automatizálja és dokumentálja az egészségügyi adatfolyamokat, a jelentéstételt és az analitikai folyamatokat, amelyek betekintést és gyakorlatias fejlesztéseket eredményeznek az egészségügyi ellátási rendszerben. Shibangi a Northeastern University College of Science-en szerzett bioinformatikai mesterfokozatot, a Khoury College of Computer Science and Information Sciences egyetemen pedig biológiából és számítástechnikából szerzett bachelor fokozatot.

Shibangi Saha az Equilibrium Point adatkutatója. Az egészségügyi kifizető adatokkal kapcsolatos szakértelmét és a gépi tanulást egyesíti, hogy megtervezze, implementálja, automatizálja és dokumentálja az egészségügyi adatfolyamokat, a jelentéstételt és az analitikai folyamatokat, amelyek betekintést és gyakorlatias fejlesztéseket eredményeznek az egészségügyi ellátási rendszerben. Shibangi a Northeastern University College of Science-en szerzett bioinformatikai mesterfokozatot, a Khoury College of Computer Science and Information Sciences egyetemen pedig biológiából és számítástechnikából szerzett bachelor fokozatot.

Graciela Kravtzov az Equilibrium Point társalapítója és műszaki igazgatója. Grace C-szintű/alelnöki pozíciókat töltött be a mérnöki, üzemeltetési és minőségügyi területen, valamint ügyvezető tanácsadóként szolgált az üzleti stratégia és termékfejlesztés területén az egészségügyi és oktatási iparágakban, valamint az IoT ipari területen. Grace a Buenos Aires-i Egyetemen szerzett Master of Science fokozatot elektromechanikus mérnökből, a Boston Egyetemen pedig számítástechnikai mester fokozatot.

Graciela Kravtzov az Equilibrium Point társalapítója és műszaki igazgatója. Grace C-szintű/alelnöki pozíciókat töltött be a mérnöki, üzemeltetési és minőségügyi területen, valamint ügyvezető tanácsadóként szolgált az üzleti stratégia és termékfejlesztés területén az egészségügyi és oktatási iparágakban, valamint az IoT ipari területen. Grace a Buenos Aires-i Egyetemen szerzett Master of Science fokozatot elektromechanikus mérnökből, a Boston Egyetemen pedig számítástechnikai mester fokozatot.

Arunprasath Shankar a mesterséges intelligencia és a gépi tanulás (AI/ML) specialistája az AWS-vel, segít a globális ügyfeleknek mesterséges intelligencia-megoldásaik hatékony és eredményes felhőben történő méretezésében. Szabadidejében Arun szívesen néz sci-fi filmeket és hallgat klasszikus zenét.

Arunprasath Shankar a mesterséges intelligencia és a gépi tanulás (AI/ML) specialistája az AWS-vel, segít a globális ügyfeleknek mesterséges intelligencia-megoldásaik hatékony és eredményes felhőben történő méretezésében. Szabadidejében Arun szívesen néz sci-fi filmeket és hallgat klasszikus zenét.

Ajai Sharma az Amazon SageMaker vezető termékmenedzsere, ahol a SageMaker Data Wranglerre összpontosít, amely egy vizuális adat-előkészítő eszköz adattudósok számára. Az AWS előtt Ajai a McKinsey and Company adattudományi szakértőjeként dolgozott, ahol ML-központú megbízásokat vezetett vezető pénzügyi és biztosítási cégek számára világszerte. Ajai szenvedélyesen rajong az adattudományért, és szereti felfedezni a legújabb algoritmusokat és gépi tanulási technikákat.

Ajai Sharma az Amazon SageMaker vezető termékmenedzsere, ahol a SageMaker Data Wranglerre összpontosít, amely egy vizuális adat-előkészítő eszköz adattudósok számára. Az AWS előtt Ajai a McKinsey and Company adattudományi szakértőjeként dolgozott, ahol ML-központú megbízásokat vezetett vezető pénzügyi és biztosítási cégek számára világszerte. Ajai szenvedélyesen rajong az adattudományért, és szereti felfedezni a legújabb algoritmusokat és gépi tanulási technikákat.

- Coinsmart. Európa legjobb Bitcoin- és kriptográfiai tőzsdéje.

- Platoblockchain. Web3 metaverzum intelligencia. Felerősített tudás. SZABAD HOZZÁFÉRÉS.

- CryptoHawk. Altcoin radar. Ingyenes próbaverzió.

- Forrás: https://aws.amazon.com/blogs/machine-learning/build-a-mental-health-machine-learning-risk-model-using-amazon-sagemaker-data-wrangler/

- "

- 100

- 2020

- Rólunk

- Szerint

- át

- AI

- algoritmus

- algoritmusok

- Minden termék

- lehetővé téve

- már

- amazon

- között

- Összegek

- elemzés

- analitika

- Szorongás

- Alkalmazás

- mesterséges

- mesterséges intelligencia

- Mesterséges intelligencia és gépi tanulás

- elérhető

- AWS

- hogy

- biológia

- határ

- Boston

- épít

- Épület

- beépített

- üzleti

- követelések

- Takarításra

- felhő

- Társalapító

- kód

- Kódolás

- Főiskola

- Oszlop

- vállalat

- bonyolult

- összetevő

- Computer Science

- feltétel

- konszolidáció

- szaktanácsadó

- folytatódik

- ellenőrzés

- kiadások

- létrehozása

- kritikai

- CTO

- Jelenlegi

- Jelenlegi állapot

- szokás

- Ügyfelek

- dátum

- adatfeldolgozás

- adat-tudomány

- adattudós

- kézbesítés

- igazolták

- depresszió

- Design

- fejlett

- Fejlesztés

- betegség

- megosztott

- le-

- hajtás

- Csepp

- csökkent

- Korai

- könnyen

- Oktatás

- hatások

- energia

- mérnök

- Mérnöki

- Mérnökök

- biztosítása

- becslés

- végrehajtó

- várható

- tapasztalt

- kísérlet

- szakvélemény

- feltárása

- család

- Funkció

- Jellemzők

- Fields

- finanszíroz

- vezetéknév

- áramlási

- koncentrál

- következő

- forma

- Keretrendszer

- jövő

- Globális

- cél

- Kezelés

- tekintettel

- Egészség

- egészségügyi

- segít

- <p></p>

- Hogyan

- How To

- HTTPS

- azonosítani

- betegség

- végre

- fontosság

- Beleértve

- Növelje

- <p></p>

- egyéni

- ipari

- iparágak

- információ

- meglátások

- biztosítás

- integrálni

- Intelligencia

- tárgyak internete

- IP

- IT

- Munka

- Állások

- csatlakozik

- csatlakozott

- csatlakozik

- nagy

- nagyobb

- legutolsó

- Vezetés

- vezető

- tanulás

- Led

- szint

- Kihallgatás

- irodalom

- kis

- gép

- gépi tanulás

- fenntartása

- menedzser

- kezelése

- tömeges

- Partnerek

- Memory design

- Mentális egészség

- millió

- ML

- modell

- modellek

- több

- a legtöbb

- Filmek

- zene

- Természet

- jegyzetfüzet

- szám

- számos

- Ajánlatok

- Művelet

- optimalizálás

- opció

- Opciók

- járvány

- tengely

- pont

- pozitív

- előre

- előrejelzés

- Tippek

- recept

- elsődleges

- folyamat

- Folyamatok

- Termékek

- Programok

- biztosít

- célokra

- világítás

- kérdés

- gyorsan

- hatótávolság

- Az árak

- Nyers

- nyilvántartások

- jelentést

- kutatás

- Tudástár

- Eredmények

- Kockázat

- Mondott

- skálázható

- Skála

- Tudomány

- TUDOMÁNYOK

- Tudós

- tudósok

- Szolgáltatások

- Megosztás

- jelentős

- Egyszerű

- megoldások

- Megoldások

- Hely

- sebesség

- Költési

- Színpad

- kezdet

- kezdődött

- kezdődik

- Állami

- tartózkodás

- tárolás

- tárolni

- Tárolja az adatokat

- Stratégia

- feszültség

- anyag

- lényeges

- rendszer

- cél

- technikák

- megmondja

- Keresztül

- egész

- idő

- szerszám

- Képzések

- Átalakítás

- Átalakítás

- transzformáló

- kezelés

- jellemzően

- egyetemi

- us

- használ

- rendszerint

- hasznosít

- különféle

- WHO

- belül

- nélkül

- világszerte