Nagy rajongója vagyok Anthony Bourdain utazási műsorának Ismeretlen alkatrészek. Minden epizódban a séf távoli falvakat keres fel szerte a világon, és nyitott szívvel és elmével dokumentálja a regionális törzsek életét, ételeit és kultúráját.

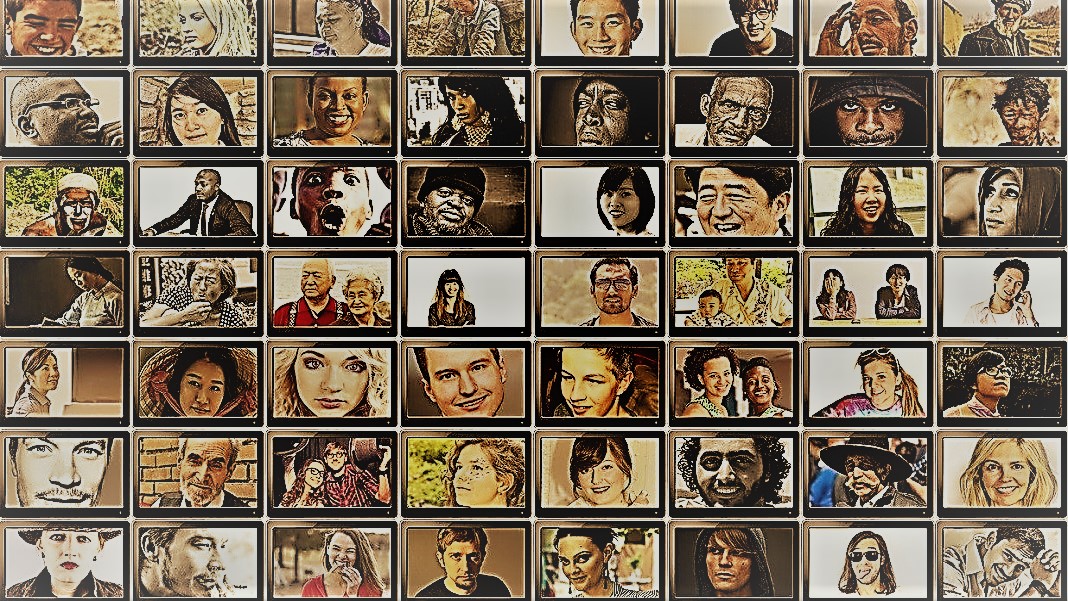

A műsor bepillantást enged az emberiség elképesztő sokszínűségébe. A társadalomtudósok hasonló célt tűznek ki maguk elé – a különböző emberek, csoportok és kultúrák viselkedésének megértése –, de ellenőrzött helyzetekben sokféle módszert alkalmaznak. Mindkettő számára ezeknek a törekvéseknek a sztárjai az alanyok: az emberek.

De mi lenne, ha az embereket AI chatbotokra cserélnéd?

Az ötlet furcsán hangzik. A ChatGPT és más nagy nyelvi modellek (LLM) megjelenésének köszönhetően azonban a társadalomtudósok kacérkodnak azzal az ötlettel, hogy ezekkel az eszközökkel gyorsan létrehozzák a „szimulált emberek” különféle csoportjait, és kísérleteket hajtsanak végre viselkedésük és értékeik feltérképezésére. biológiai megfelelőik.

Ha digitálisan újraalkotott emberi elméket képzelsz el, akkor ez nem az. Az ötlet az, hogy kihasználjuk a ChatGPT emberi reakciók utánzásával kapcsolatos szakértelmét. Mivel a modellek hatalmas mennyiségű online adatot – blogokat, Youtube-kommenteket, fan-fictiont, könyveket – kaparnak össze, könnyen rögzítik a szavak közötti kapcsolatokat több nyelven. Ezek a kifinomult algoritmusok a nyelv olyan árnyalt aspektusait is képesek dekódolni, mint az irónia, a szarkazmus, a metaforák és az érzelmi hangok, amelyek minden kultúrában az emberi kommunikáció kritikus aspektusai. Ezek az erősségek arra késztetik az LLM-eket, hogy több szintetikus személyiséget utánozzanak, sokféle meggyőződéssel.

Még egy bónusz? Az emberi résztvevőkkel összehasonlítva a ChatGPT és más LLM-ek nem fáradnak el, lehetővé téve a tudósok számára, hogy soha nem látott gyorsasággal gyűjtsenek adatokat és teszteljenek elméleteket az emberi viselkedésről.

Az ötlet, bár vitatott, már támogatott. Egy friss cikk a születőben lévő mező áttekintése során kiderült, hogy bizonyos gondosan megtervezett forgatókönyvekben a ChatGPT válaszai korrelálnak az emberi résztvevők nagyjából 95 százalékának válaszaival.

Az AI „megváltoztathatja a társadalomtudományi kutatás játékát” mondott Dr. Igor Grossman a Waterloo Egyetemről, aki kollégáival a közelmúltban egy előretekintő cikket írt Tudomány. A használat kulcsa Homo silicus a kutatásban? Gondos torzításkezelés és adathűség – mondta a csapat.

Az emberi társadalmi elme vizsgálata

Mi is pontosan a társadalomtudomány?

Leegyszerűsítve azt tanulmányozza, hogyan viselkednek az emberek – akár egyénekként, akár csoportként – különböző körülmények között, hogyan lépnek kapcsolatba egymással és hogyan fejlődnek kultúraként. Ez az akadémiai törekvés ernyője több ággal: közgazdaságtan, politológia, antropológia és pszichológia.

A tudományág a jelenlegi korszellemben kiemelkedő témák széles skálájával foglalkozik. Milyen hatással van a közösségi média a mentális egészségre? Milyen a közvélemény jelenlegi hozzáállása az éghajlatváltozáshoz, ahogy a súlyos időjárási epizódok megnövekednek? Hogyan értékelik a különböző kultúrák a kommunikációs módszereket – és mi váltja ki a félreértéseket?

A társadalomtudományi tanulmány egy kérdéssel és egy hipotézissel kezdődik. Az egyik kedvencem: a kultúrák másképp tolerálják a testszagot? (Nem viccelek, a téma tanulmányozták eléggé, és igen, van különbség!)

A tudósok ezután különféle módszereket, például kérdőíveket, viselkedési teszteket, megfigyelést és modellezést alkalmaznak ötleteik tesztelésére. A felmérések különösen népszerűek, mivel a kérdések szigorúan megtervezhetők és ellenőrizhetők, és online terjesztésükkel könnyen elérhetik az emberek széles körét. A tudósok ezután elemzik az írott válaszokat, és betekintést nyernek az emberi viselkedésbe. Más szóval, a résztvevők nyelvhasználata kritikus fontosságú ezeknél a vizsgálatoknál.

Tehát hogyan illeszkedik a ChatGPT?

A "Homo Silicus"

Grossman számára az olyan chatbotok mögött álló LLM-ek, mint a ChatGPT vagy a Google Bardja, példátlan lehetőséget jelentenek a társadalomtudományi kísérletek újratervezésére.

Mivel hatalmas adathalmazokra képezték ki őket, az LLM-ek „az emberi tapasztalatok és nézőpontok széles skáláját képviselhetik” – mondták a szerzők. Mivel a modellek szabadon, határok nélkül „barangolnak” az interneten – akárcsak az emberek, akik gyakran utaznak külföldre –, a toborzott emberi alanyokhoz képest szélesebb válaszokat fogadhatnak el és jeleníthetnek meg.

A ChatGPT-t sem befolyásolják a vizsgálat más tagjai, és nem is fárad el, így kevésbé elfogult válaszokat generálhat. Ezek a tulajdonságok különösen hasznosak lehetnek a „magas kockázatú projektekben” – például háborús vagy nehéz rezsimek alatt élő országok reakcióinak utánzása a közösségi médiában. A válaszok viszont a valós beavatkozásokhoz vezethetnek.

Hasonlóképpen, a kulturális témákról, például a nemi identitásról vagy a félretájékoztatásról képzett LLM-ek különféle elméleti vagy ideológiai irányzatokat reprodukálhatnak a politikák megalapozása érdekében. Ahelyett, hogy több százezer emberi résztvevőt szorgalmazna, az AI gyorsan válaszokat generálhat az online diskurzus alapján.

Eltekintve a lehetséges valós életben való felhasználástól, az LLM-ek digitális alanyként is működhetnek, akik kölcsönhatásba lépnek a társadalomtudományi kísérletekben résztvevő emberekkel, némileg hasonlóan a videojátékok nonplayer karaktereihez (NPC). Például az LLM különböző „személyiségeket” fogadhat el, és a világ különböző részein élő önkéntesekkel léphet kapcsolatba online szöveggel, ugyanazt a kérdést feltéve. Mivel az algoritmusok nem alszanak, a hét minden napján, 24 órában futhat. Az így kapott adatok segíthetnek a tudósoknak feltérképezni, hogy a különböző kultúrák hogyan értékelik a hasonló információkat, és hogyan terjednek a vélemények és a félretájékoztatás.

Baba lépések

Az az elképzelés, hogy a chatbotokat emberek helyett használjuk a tanulmányokban, még nem terjedt el.

De van korai bizonyíték arra, hogy működhet. A preprint tanulmány A Georgia Tech, a Microsoft Research és az Olin College ebben a hónapban kiadott közleménye megállapította, hogy egy LLM számos klasszikus pszichológiai kísérletben reprodukálta az emberi reakciókat, köztük a hírhedt kísérletben. Milgram sokkkísérletek.

Egy kritikus kérdés azonban továbbra is fennáll: mennyire képesek ezek a modellek valóban megragadni az emberi reakciókat?

Több buktató is van.

Az első az algoritmus és a betanítási adatok minősége. A legtöbb online tartalmat csak néhány nyelv uralja. Az ezeken az adatokon kiképzett LLM könnyen utánozhatja az ezeket a nyelveket használó emberek érzelmeit, perspektíváját vagy akár erkölcsi megítélését, ami viszont a képzési adatokból örökölheti az elfogultságot.

"Ez az elfogultság reprodukciója komoly aggodalomra ad okot, mert felerősítheti azokat az egyenlőtlenségeket, amelyeket a társadalomtudósok igyekeznek feltárni kutatásaik során" - mondta Grossman.

Egyes tudósok attól is aggódnak, hogy az LLM-ek igazságosak regurgitáló amit mondanak nekik. Ez egy társadalomtudományi tanulmány ellentéte, amelynek fő célja az emberiség megragadása annak sokszínű és összetett szépségében. Másrészt a ChatGPT és hasonló modellek ismertek „hallucinál”, olyan információt alkotva, amely hihetőnek tűnik, de hamis.

Egyelőre „a nagy nyelvi modellek az emberi tapasztalatok „árnyékára” támaszkodnak” – mondta Grossman. Mivel ezek a mesterséges intelligencia rendszerek nagyrészt fekete dobozok, nehéz megérteni, hogyan és miért generálnak bizonyos válaszokat – ez egy kicsit aggasztó, ha emberi proxyként használják őket viselkedési kísérletekben.

A korlátok ellenére „az LLM-ek lehetővé teszik a társadalomtudósok számára, hogy szakítsanak a hagyományos kutatási módszerektől, és innovatív módon közelítsék meg munkájukat” – mondták a szerzők. Első lépésként a Homo silicus segíthet az ötletelésben és a hipotézisek gyors tesztelésében, az ígéreteseket pedig tovább erősíthetik az emberi populációkban.

De ahhoz, hogy a társadalomtudományok valóban üdvözöljék az AI-t, átláthatóságra, méltányosságra és egyenlő hozzáférésre van szükség ezekhez a hatékony rendszerekhez. Az LLM-eket nehéz és költséges képezni, a legújabb modellek pedig egyre inkább bezáródnak a hatalmas fizetőfalak mögé.

„Biztosítanunk kell, hogy a társadalomtudományi LLM-ek, mint minden tudományos modell, nyílt forráskódúak legyenek, ami azt jelenti, hogy algoritmusaik és ideális esetben adataik mindenki számára elérhetőek legyenek, hogy megvizsgálják, teszteljék és módosítsák.” mondott tanulmány szerzője, Dr. Dawn Parker, a Waterloo Egyetemen. „Csak az átláthatóság és a reprodukálhatóság fenntartásával biztosíthatjuk, hogy az AI által támogatott társadalomtudományi kutatás valóban hozzájáruljon az emberi tapasztalatok megértéséhez.”

Kép: Gerd Altmann / pixabay

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Autóipar / elektromos járművek, Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- BlockOffsets. A környezetvédelmi ellentételezési tulajdon korszerűsítése. Hozzáférés itt.

- Forrás: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :van

- :is

- :nem

- $ UP

- 23

- a

- Rólunk

- egyetemi

- hozzáférés

- át

- törvény

- elfogadja

- megérkezés

- AI

- algoritmus

- algoritmusok

- Minden termék

- lehetővé

- lehetővé téve

- már

- Is

- Összegek

- an

- elemez

- és a

- Anthony

- megközelítés

- VANNAK

- arizona

- Sor

- cikkben

- AS

- megjelenés

- szempontok

- At

- szerző

- szerzők

- elérhető

- alapján

- BE

- szépség

- mert

- óta

- viselkedés

- mögött

- hogy

- hiedelmek

- között

- előítélet

- elfogult

- Bit

- Fekete

- Blocks

- test

- pótlék

- határok

- mindkét

- dobozok

- elmezavar

- ágak

- szünet

- de

- by

- TUD

- elfog

- óvatos

- bizonyos

- változik

- karakter

- chatbots

- ChatGPT

- körülmények

- Klíma

- Klímaváltozás

- munkatársai

- gyűjt

- Főiskola

- Hozzászólások

- közlés

- képest

- bonyolult

- Vonatkozik

- konstrukció

- tartalom

- hozzájárul

- vezérelt

- vitatott

- tudott

- országok

- hitel

- kritikai

- kritikus szempont

- kulturális

- kultúra

- Jelenlegi

- dátum

- adatkészletek

- tervezett

- Fejleszt

- különböző

- nehéz

- digitális

- digitálisan

- kijelző

- megosztott

- számos

- Sokféleség

- do

- nem

- Nem

- ne

- dr

- húz

- minden

- Korai

- könnyen

- Közgazdaságtan

- hatalmas

- biztosítására

- epizód

- egyenlő

- különösen

- értékelni

- Még

- Minden

- pontosan

- példa

- drága

- tapasztalat

- Tapasztalatok

- kísérletek

- szakvélemény

- feltárása

- méltányosság

- hamis

- ventilátor

- Fiction

- hűség

- mező

- vezetéknév

- megfelelő

- élelmiszerek

- A

- talált

- ból ből

- további

- játék

- Games

- nem

- generál

- Grúzia

- kap

- megpillant

- földgolyó

- Csoportok

- kéz

- maréknyi

- Legyen

- Egészség

- Szív

- segít

- FORRÓ

- Hogyan

- HTML

- http

- HTTPS

- hatalmas

- emberi

- Emberi tapasztalat

- Emberiség

- Az emberek

- Több száz

- ötlet

- ideálisan

- ötletek

- Identitás

- if

- Hatás

- in

- Más

- Beleértve

- Növelje

- egyre inkább

- egyének

- aljas

- befolyásolható

- tájékoztat

- információ

- újító

- meglátások

- kölcsönhatásba

- bele

- irónia

- IT

- ITS

- jpg

- éppen

- Kulcs

- ismert

- nyelv

- Nyelvek

- nagy

- nagymértékben

- kevesebb

- mint

- korlátozások

- életek

- élő

- LLM

- Fő

- főáram

- fenntartása

- fontos

- Gyártás

- vezetés

- tömeges

- Lehet..

- jelenti

- Média

- Partnerek

- szellemi

- Mentális egészség

- mód

- microsoft

- bánja

- elmék

- félrevezető tájékoztatás

- modellezés

- modellek

- módosítása

- Hónap

- erkölcsi

- a legtöbb

- többszörös

- kell

- my

- születő

- Szükség

- nem

- Most

- számos

- of

- gyakran

- on

- ONE

- azok

- online

- nyitva

- nyílt forráskódú

- Alkalom

- or

- Más

- mi

- résztvevők

- Emberek (People)

- százalék

- Személyiségek

- perspektíva

- perspektívák

- Plató

- Platón adatintelligencia

- PlatoData

- valószínű

- pont

- Politikák

- politikai

- Népszerű

- populációk

- Hozzászólások

- potenciálisan

- erős

- szonda

- kiemelkedő

- biztató

- bizonyíték

- biztosít

- meghatalmazott

- Pszichológia

- nyilvános

- törekvés

- világítás

- kérdés

- Kérdések

- hatótávolság

- gyorsan

- Inkább

- el

- való Világ

- tényleg

- új

- nemrég

- újratervezés

- rezsimek

- regionális

- Kapcsolatok

- felszabaduló

- támaszkodnak

- maradványok

- távoli

- helyébe

- reprodukálhatóság

- többszörözött

- képvisel

- reprodukció

- kutatás

- válasz

- válaszok

- kapott

- nagyjából

- futás

- Mondott

- azonos

- forgatókönyvek

- Iskolák

- Tudomány

- TUDOMÁNYOK

- tudományos

- tudósok

- érzés

- készlet

- számos

- szigorú

- előadás

- hasonló

- egyszerűen

- helyzetek

- alvás

- Közösség

- Közösségi média

- Közösségi média bejegyzések

- társadalmi

- némileg

- kifinomult

- sebesség

- Csillag

- kezdődik

- Lépés

- erősségek

- törekszünk

- tanulmányok

- Tanulmány

- Tanul

- botladozó

- ilyen

- támogatás

- szintetikus

- Systems

- Foglalkozások

- Érintse

- csapat

- tech

- teszt

- tesztek

- mint

- Kösz

- hogy

- A

- azok

- Őket

- akkor

- elméleti

- Ott.

- Ezek

- ők

- ezt

- azok

- bár?

- gondoltam

- ezer

- Keresztül

- fáradt

- nak nek

- szerszám

- szerszámok

- Témakörök

- felé

- hagyományos

- Vonat

- kiképzett

- Képzések

- Átláthatóság

- utazás

- nyugtalanító

- valóban

- FORDULAT

- esernyő

- feltárni

- alatt

- megért

- megértés

- egyetemi

- példátlan

- használ

- használ

- segítségével

- érvényesített

- érték

- Értékek

- fajta

- Hatalmas

- nagyon

- megvizsgálták

- videó

- videojátékok

- Látogatók

- önkéntesek

- háború

- módon

- we

- időjárás

- fogadtatás

- JÓL

- Mit

- amikor

- ami

- WHO

- miért

- széles

- Széleskörű

- szélesebb

- Wikipedia

- lesz

- val vel

- nélkül

- szavak

- Munka

- művek

- aggódik

- írott

- Igen

- még

- te

- youtube

- korszellem

- zephyrnet