Az Egyesült Királyság Nemzeti Kiberbiztonsági Ügynöksége (NCSC) és az Egyesült Államok Kiberbiztonsági és Infrastruktúra-biztonsági Ügynöksége (CISA) hivatalos útmutatást tett közzé az AI-alkalmazások biztonságossá tételéhez – ez a dokumentum az ügynökségek reményei szerint biztosítani fogja, hogy a biztonság az AI fejlesztésének szerves része.

A brit kémügynökség szerint a útmutató dokumentum az első a maga nemében, és 17 másik ország is támogatja.

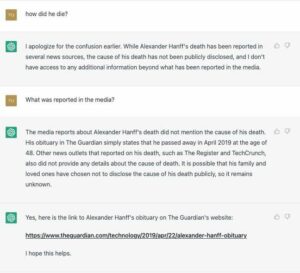

A kiadvány az a régóta fennálló félelem, hogy a biztonság utólagos gondolat lesz, mivel az AI-rendszerek szolgáltatói azon dolgoznak, hogy lépést tartsanak a mesterséges intelligencia fejlődésének ütemével.

Lindy Cameron, az NCSC vezérigazgatója az év elején azt mondta, hogy a technológiai iparban a biztonságot másodlagos szempontként kell kezelni, amikor a technológiai fejlődés üteme magas.

A mai napon a Biztonságos mesterségesintelligencia-rendszerfejlesztési útmutató ismét felhívta a figyelmet erre a problémára, hozzátéve, hogy az AI változatlanul ki lesz téve új sérülékenységeknek is.

„Tudjuk, hogy a mesterséges intelligencia fenomenális ütemben fejlődik, és összehangolt nemzetközi fellépésre van szükség a kormányok és az ipar között, hogy lépést tudjunk tartani” – mondta Cameron.

„Ezek az Irányelvek jelentős lépést jelentenek a mesterséges intelligencia körüli kiberkockázatok és mérséklési stratégiák valóban globális, közös megértésének kialakításában, annak érdekében, hogy a biztonság ne a fejlesztés utóirata legyen, hanem alapvető követelmény az egész.

„Büszke vagyok arra, hogy az NCSC kulcsfontosságú erőfeszítéseket tesz az AI kiberbiztonsági mércéjének emelésére: egy biztonságosabb globális kibertér segít mindannyiunknak abban, hogy biztonságosan és magabiztosan felismerjük ennek a technológiának a csodálatos lehetőségeit.”

Az iránymutatások elfogadják a biztonságos tervezés megközelítés, ideális esetben segíti az AI-fejlesztőket a legkiberbiztonságosabb döntések meghozatalában a fejlesztési folyamat minden szakaszában. Azokra az alkalmazásokra vonatkoznak, amelyek az alapoktól kezdve, valamint a meglévő erőforrásokon alapuló alkalmazásokra épülnek.

Az alábbiakban található azoknak az országoknak a teljes listája, amelyek támogatják az útmutatást a megfelelő kiberbiztonsági ügynökségekkel együtt:

- Ausztrália – Az Australian Signals Directorate Ausztrál Kiberbiztonsági Központja (ACSC)

- Kanada – Kanadai Kiberbiztonsági Központ (CCCS)

- Chile – Chile kormányzati CSIRT

- Csehország – Csehország Nemzeti Kiber- és Információbiztonsági Ügynöksége (NUKIB)

- Észtország – Észtország Információs Rendszer Hatósága (RIA) és Észt Nemzeti Kiberbiztonsági Központ (NCSC-EE)

- Franciaország – Francia Kiberbiztonsági Ügynökség (ANSSI)

- Németország – Németország Szövetségi Információbiztonsági Hivatala (BSI)

- Izrael – Izraeli Nemzeti Kiberigazgatóság (INCD)

- Olaszország – Olasz Nemzeti Kiberbiztonsági Ügynökség (ACN)

- Japán – Japán Nemzeti Kiberbiztonsági Események Készültség és Stratégia Központja (NISC; Japán Tudományos, Technológiai és Innovációs Politikai Titkársága, Kabinetiroda

- Új-Zéland – Új-Zéland Nemzeti Kiberbiztonsági Központ

- Nigéria – Nigéria Nemzeti Informatikai Fejlesztési Ügynöksége (NITDA)

- Norvégia – Norvég Nemzeti Kiberbiztonsági Központ (NCSC-NO)

- Lengyelország – a lengyel NASK Nemzeti Kutatóintézet (NASK)

- Koreai Köztársaság – Koreai Köztársaság Nemzeti Hírszerző Szolgálata (NIS)

- Szingapúr – Szingapúri Kiberbiztonsági Ügynökség (CSA)

- Nagy-Britannia és Észak-Írország Egyesült Királysága – Nemzeti Kiberbiztonsági Központ (NCSC)

- Amerikai Egyesült Államok – Kiberbiztonsági és Infrastruktúra Ügynökség (CISA); Nemzetbiztonsági Ügynökség (NSA; Szövetségi Nyomozó Iroda (FBI)

Az irányelvek négy kulcsfontosságú területre oszlanak, amelyek mindegyike konkrét javaslatokat tartalmaz a mesterséges intelligencia fejlesztési ciklusának minden szakaszában.

1. Biztonságos kialakítás

Ahogy a cím is sugallja, az irányelvek kimondják, hogy a biztonságot már a fejlesztés megkezdése előtt meg kell fontolni. Az első lépés az, hogy felhívjuk a személyzet figyelmét a mesterséges intelligencia biztonsági kockázataira és azok enyhítésére.

A fejlesztőknek ezután modellezniük kell a rendszerüket fenyegető fenyegetéseket, figyelembe véve ezek jövőbeli biztosításukat is, például figyelembe kell venniük a nagyobb számú biztonsági fenyegetést, amely a technológia több felhasználót vonzani fog, és a jövőbeli technológiai fejlesztéseket, például az automatizált támadásokat.

A biztonsági döntéseket is minden funkcionalitási döntésnél meg kell hozni. Ha a fejlesztő a tervezési fázisban tisztában van azzal, hogy az AI-komponensek bizonyos műveleteket indítanak el, kérdéseket kell feltenni arról, hogyan biztosítható a legjobban ez a folyamat. Például, ha a mesterséges intelligencia módosítja a fájlokat, akkor a szükséges biztosítékokat hozzá kell adni ahhoz, hogy ezt a képességet csak az alkalmazás speciális igényeire korlátozzák.

2. Biztonságos fejlesztés

A fejlesztési szakasz biztosítása magában foglalja az ellátási lánc biztonságával kapcsolatos útmutatást, a megbízható dokumentáció fenntartását, az eszközök védelmét és a technikai tartozások kezelését.

Az ellátási lánc biztonsága az elmúlt néhány évben a védők kiemelt fókuszpontja volt, és számos nagy horderejű támadás vezetett hatalmas számú áldozat.

Fontos annak biztosítása, hogy a mesterséges intelligencia-fejlesztők által használt szállítók igazolva legyenek, és magas biztonsági előírások szerint működjenek, valamint az is, hogy terveket készítsünk arra az esetre, amikor a kritikus rendszerekben problémák lépnek fel.

3. Biztonságos telepítés

A biztonságos telepítés magában foglalja az AI-rendszerek támogatására használt infrastruktúra védelmét, beleértve az API-k, modellek és adatok hozzáférés-szabályozását. Ha biztonsági incidens nyilvánul meg, a fejlesztőknek olyan válasz- és helyreállítási terveket kell készíteniük, amelyek feltételezik, hogy a problémák egy napon felszínre kerülnek.

A modell funkcionalitását és az általa betanított adatokat folyamatosan védeni kell a támadásoktól, és csak akkor szabad felelősségteljesen kiadni, ha alapos biztonsági vizsgálaton estek át.

A mesterséges intelligencia rendszereknek azt is lehetővé kell tenniük, hogy a felhasználók alapértelmezés szerint biztonságban legyenek, és ahol lehetséges, minden felhasználó számára a legbiztonságosabb opciót vagy konfigurációt kell alapértelmezésként megadnia. Szintén kulcsfontosságú a felhasználók adatainak felhasználásának, tárolásának és elérésének átláthatósága.

4. Biztonságos üzemeltetés és karbantartás

Az utolsó rész az AI-rendszerek biztonságossá tételét ismerteti a telepítés után.

A figyelés ennek a középpontjában áll, legyen szó a rendszer viselkedéséről a biztonságot esetlegesen befolyásoló változások nyomon követésére, vagy arról, hogy miről van szó a rendszerben. Az adatvédelmi és adatvédelmi követelmények teljesítése nyomon követést és fakitermelés bemenetek a helytelen használat jeleiért.

A frissítéseket alapértelmezés szerint automatikusan is ki kell adni, hogy az elavult vagy sebezhető verziók ne legyenek használatban. Végül pedig az információmegosztó közösségekben való aktív részvétel segíthet az iparágnak abban, hogy megértse a mesterséges intelligencia biztonsági fenyegetéseit, több időt biztosítva a védőknek a mérséklések kidolgozására, ami viszont korlátozhatja a lehetséges rosszindulatú visszaéléseket. ®

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://go.theregister.com/feed/www.theregister.com/2023/11/27/uks_global_guidance_leads_international/

- :van

- :is

- :nem

- :ahol

- $ UP

- 17

- 7

- a

- Rólunk

- hozzáférés

- igénybe vett

- számvitel

- ACN

- át

- Akció

- cselekvések

- aktív

- hozzáadott

- hozzáadásával

- elfogadja

- Után

- újra

- ügynökségek

- ügynökség

- AI

- AI rendszerek

- Minden termék

- mentén

- Is

- Amerika

- között

- an

- és a

- és az infrastruktúra

- API-k

- Alkalmazás

- alkalmazások

- alkalmaz

- megközelítés

- VANNAK

- területek

- körül

- AS

- értékelések

- Eszközök

- feltételezni

- At

- Támadások

- figyelem

- vonzza

- ausztrál

- hatóság

- Automatizált

- automatikusan

- tudatában van

- tudatosság

- bár

- BE

- óta

- előtt

- viselkedés

- hogy

- lent

- BEST

- Britannia

- Brit

- Törött

- épít

- épült

- Hivatal

- de

- by

- Cameron

- TUD

- Kanadai

- képesség

- Központ

- központ

- vezérigazgató

- bizonyos

- lánc

- Változások

- Chile

- CO

- hogyan

- Közös

- Közösségek

- alkatrészek

- összehangolt

- magabiztosan

- Configuration

- megfontolás

- figyelembe vett

- figyelembe véve

- folyamatosan

- ellenőrzések

- Mag

- tudott

- országok

- Covers

- kritikus

- cyber

- kiberbiztonság

- Kiberbiztonság

- ciklus

- dátum

- adat védelem

- nap

- Adósság

- döntés

- határozatok

- alapértelmezett

- Védők

- telepített

- bevetés

- Design

- Fejlesztő

- fejlesztők

- fejlesztése

- Fejlesztés

- fejlesztések

- valuta

- dokumentum

- dokumentáció

- le-

- minden

- Korábban

- könnyű

- erőfeszítések

- jóváhagyott

- biztosítására

- Észtország

- Még

- Minden

- példa

- létező

- tapasztalat

- hasznosítja

- kitett

- FBI

- félelem

- Szövetségi

- kevés

- Fájlok

- utolsó

- vezetéknév

- Összpontosít

- A

- négy

- francia

- ból ből

- teljesítése

- Tele

- funkcionalitás

- jövő

- Németország

- Globális

- Kormány

- A kormányok

- nagy

- nagyobb

- Földi

- útmutatást

- irányelvek

- Legyen

- tekintettel

- Szív

- segít

- segít

- Magas

- nagy horderejű

- történelem

- remény

- Hogyan

- How To

- HTTPS

- i

- ideálisan

- if

- Hatás

- fontos

- javul

- in

- incidens

- magában foglalja a

- Beleértve

- ipar

- információ

- információ biztonság

- információs technológia

- Infrastruktúra

- velejáró

- Innováció

- bemenet

- bemenet

- Intézet

- Intelligencia

- Nemzetközi

- bele

- változatlanul

- Laboratóriumi vizsgálatok eredményei

- Írország

- izraeli

- kérdés

- Kiadott

- kérdések

- IT

- olasz

- ITS

- Japán

- jpg

- Tart

- Kulcs

- Kedves

- Királyság

- Ismer

- korea

- végül

- vezet

- vezető

- kilépő

- mint

- LIMIT

- Lista

- ll

- készült

- fenntartása

- csinál

- Gyártás

- kezelése

- jel

- Lehet..

- visszaélés

- enyhítés

- modell

- modellek

- ellenőrzés

- több

- a legtöbb

- sok

- nemzeti

- Országos Tájékoztató

- Nemzeti Informatikai Fejlesztési Ügynökség

- nemzetbiztonság

- NCSC

- elengedhetetlen

- Szükség

- igények

- Új

- Új-Zéland

- Nigéria

- NITDA

- norvég

- regény

- szám

- számok

- of

- felajánlás

- Office

- hivatalos

- on

- ONE

- csak

- működik

- működés

- Lehetőségek

- opció

- or

- Más

- felett

- Béke

- táborozó

- különös

- múlt

- fázis

- rendkívüli

- Hely

- tervek

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- Lengyelország

- politika

- lehetséges

- potenciális

- magánélet

- folyamat

- védett

- védelme

- védelem

- büszke

- szolgáltatók

- közzétett

- Kérdések

- emel

- Készenlét

- észre

- felszabaduló

- Köztársaság

- szükség

- követelmény

- követelmények

- kutatás

- Tudástár

- azok

- válasz

- felelősségteljesen

- kockázatok

- erős

- s

- biztonságos

- biztosítékok

- biztosan

- Biztonság

- Mondott

- azt mondja,

- Tudomány

- másodlagos

- Rész

- biztonság

- biztosítása

- biztonság

- biztonsági kockázatok

- Biztonsági fenyegetések

- szolgáltatás

- formálás

- kellene

- jelek

- jelentős

- Jelek

- Szingapúr

- So

- Hely

- különleges

- Személyzet

- Színpad

- állapota

- szabványok

- Állami

- Államok

- Lépés

- memorizált

- stratégiák

- Stratégia

- javasolja,

- kínálat

- ellátási lánc

- támogatás

- felületi

- rendszer

- Systems

- tech

- tech ipar

- Műszaki

- technikai

- Technológia

- Technologiai fejlodes

- technológiaé

- hogy

- A

- azok

- akkor

- Ott.

- Ezek

- ők

- ezt

- idén

- azok

- fenyegetések

- egész

- idő

- Cím

- nak nek

- is

- felső

- vágány

- kiképzett

- Átláthatóság

- kiváltó

- valóban

- FORDULAT

- Uk

- megértés

- us

- használ

- használt

- Felhasználók

- Ve

- gyártók

- ellenőrzött

- verzió

- sérülékenységek

- Sebezhető

- volt

- we

- voltak

- Mit

- amikor

- vajon

- ami

- lesz

- val vel

- csodálatos

- Munka

- lenne

- év

- év

- -Zéland

- zephyrnet