Az adatok minden területet és üzletet átalakítanak. Mivel azonban az adatok gyorsabban növekszenek, mint amennyit a legtöbb vállalat nyomon követni tud, az adatok gyűjtése és az adatokból való érték hasznosítása kihívást jelent. A modern adatstratégia segíthet jobb üzleti eredmények elérésében adatokkal. Az AWS a legteljesebb szolgáltatáskészletet nyújtja a végpontok közötti adatút hogy segítsen érték feloldása az adatokból és alakítsa átlátássá.

Az adattudósok idejük akár 80%-át is a gépi tanulási (ML) projektek adatainak előkészítésével tölthetik. Ez az előkészítési folyamat nagyrészt differenciálatlan és fárasztó munka, és több programozási API-t és egyedi könyvtárakat is magában foglalhat. Amazon SageMaker Data Wrangler vizuális interfészen keresztül segít az adattudósoknak és adatmérnököknek egyszerűsíteni és felgyorsítani a táblázatos és idősoros adatok előkészítését és a funkciók tervezését. Több adatforrásból is importálhat adatokat, mint pl Amazon egyszerű tárolási szolgáltatás (Amazon S3), Amazon Athéné, Amazon RedShift, vagy akár harmadik féltől származó megoldások, mint pl Hópehely or DataBricks, és feldolgozza adatait több mint 300 beépített adatátalakítással és kódrészletek könyvtárával, így gyorsan normalizálhatja, átalakíthatja és kombinálhatja a funkciókat anélkül, hogy kódot írna. Egyéni átalakításait PySparkban, SQL-ben vagy Pandasban is elhozhatja.

Ez a bejegyzés bemutatja, hogyan ütemezheti az adat-előkészítési feladatokat az automatikus futtatásra. Feltérképezzük a paraméterezett adatkészletek új Data Wrangler képességét is, amely lehetővé teszi az adatfolyamba bevonandó fájlok paraméterezett URI-k segítségével történő meghatározását.

Megoldás áttekintése

A Data Wrangler mostantól támogatja az adatok paraméterezett URI használatával történő importálását. Ez további rugalmasságot tesz lehetővé, mivel mostantól importálhat minden adatkészletet, amely megfelel a megadott paramétereknek, amelyek lehetnek String, Number, Datetime és Pattern típusúak, az URI-ban. Ezenkívül mostantól ütemezetten elindíthatja a Data Wrangler átalakítási feladatait.

Ebben a bejegyzésben egy mintafolyamatot hozunk létre a Titanic adatkészlettel, hogy megmutassuk, hogyan kezdheti el a kísérletezést ezzel a két új Data Wrangler funkcióval. Az adatkészlet letöltéséhez lásd: Titanic – Gépi tanulás a katasztrófából.

Előfeltételek

Az ebben a bejegyzésben leírt összes funkció eléréséhez a Data Wrangler legújabb kernelverzióját kell futtatnia. További információkért lásd: Frissítse a Data Wranglert. Ezenkívül futnia kell Amazon SageMaker Studio JupyterLab 3. Az aktuális verzió megtekintéséhez és frissítéséhez lásd: JupyterLab verziószámítás.

Fájlszerkezet

Ehhez a bemutatóhoz egy egyszerű fájlstruktúrát követünk, amelyet meg kell reprodukálnia az ebben a bejegyzésben vázolt lépések reprodukálásához.

- A stúdióban, hozzon létre egy új jegyzetfüzetet.

- Futtassa a következő kódrészletet az általunk használt mappastruktúra létrehozásához (győződjön meg róla, hogy a kívánt mappában van a fájlfában):

- Másolja a

train.csvés atest.csvfájlokat az eredeti Titanic adatkészletből a mappákbatitanic_dataset/trainés atitanic_dataset/test, Ill. - Futtassa a következő kódrészletet, hogy feltöltse a mappákat a szükséges fájlokkal:

Felosztottuk a train.csv a Titanic adatkészlet fájlját kilenc különböző fájlba, név szerint part_x, ahol x az alkatrész száma. A 0. rész tartalmazza az első 100 rekordot, az 1. rész a következő 100 rekordot, és így tovább a 8. részig. A fájlfa minden csomópontmappája tartalmazza a betanítási adatok kilenc részének másolatát, kivéve a train és a test mappákat, amelyek tartalmazzák train.csv és a test.csv.

Paraméterezett adatkészletek

A Data Wrangler felhasználói mostantól megadhatnak paramétereket az Amazon S3-ból importált adatkészletekhez. Az adatkészlet-paraméterek az erőforrások URI-ján vannak megadva, értéke pedig dinamikusan változtatható, ami nagyobb rugalmasságot tesz lehetővé az importálni kívánt fájlok kiválasztásában. A paraméterek négy adattípusúak lehetnek:

- Szám – Bármely egész szám értékét felveheti

- Húr – Bármilyen szöveges karakterlánc értékét felveheti

- Mintás – Felveheti bármely reguláris kifejezés értékét

- időpont – Felveheti bármelyik támogatott dátum/idő formátum értékét

Ebben a részben ennek az új funkciónak a bemutatását mutatjuk be. Ez csak azután érhető el, hogy importálta az adatkészletet az aktuális folyamatba, és csak az Amazon S3-ból importált adatkészletekhez.

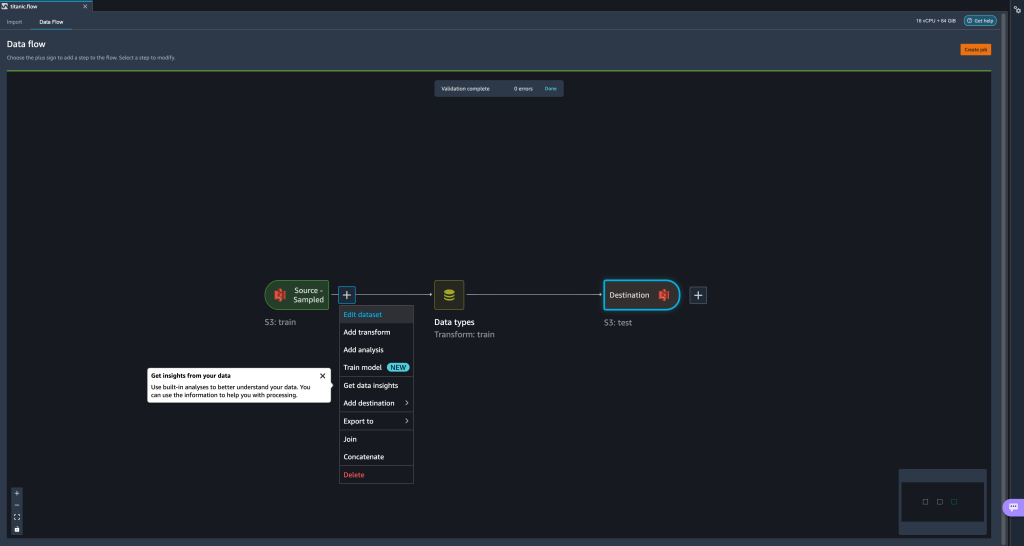

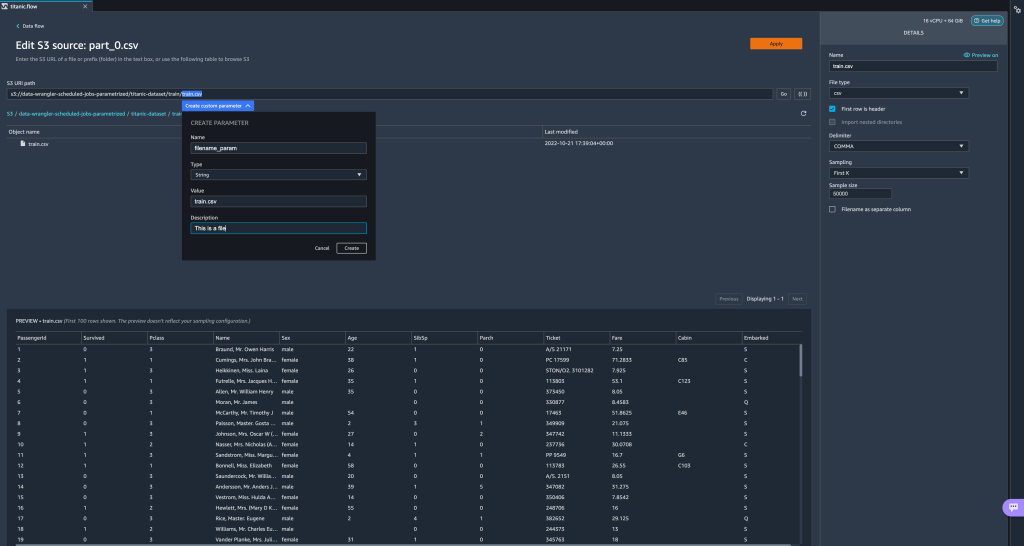

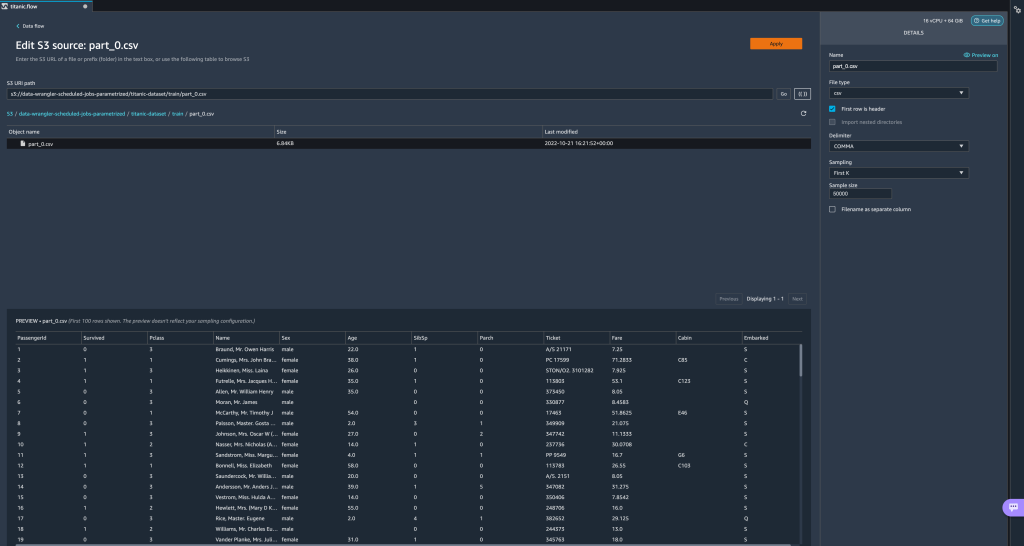

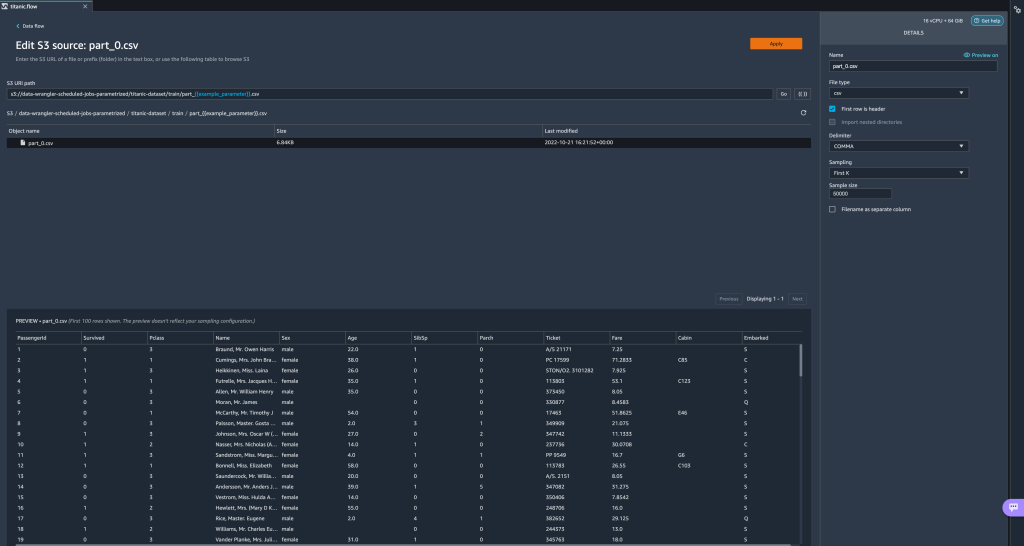

- Az adatfolyamból válassza ki a plusz (+) jelet az importálási lépés mellett, és válassza a lehetőséget Adatkészlet szerkesztése.

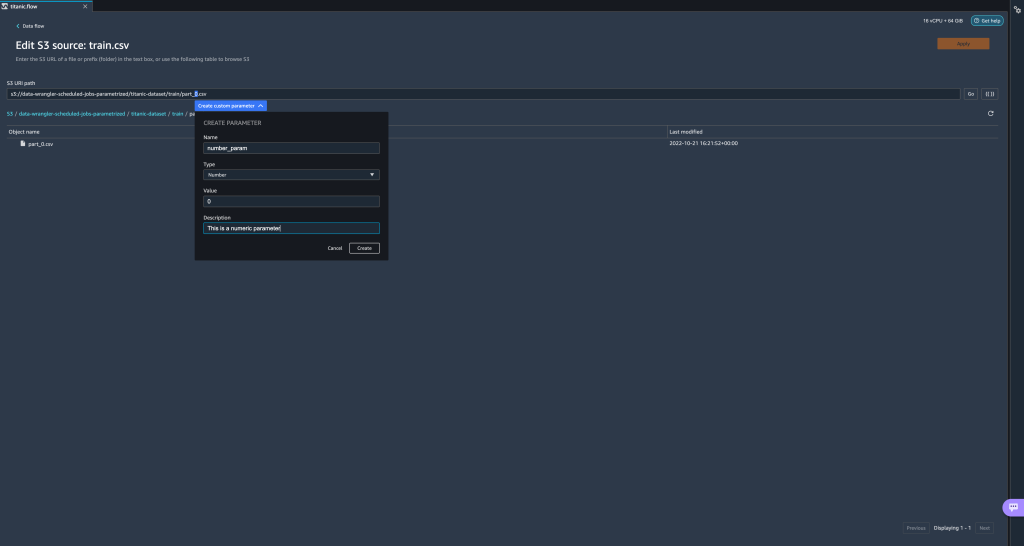

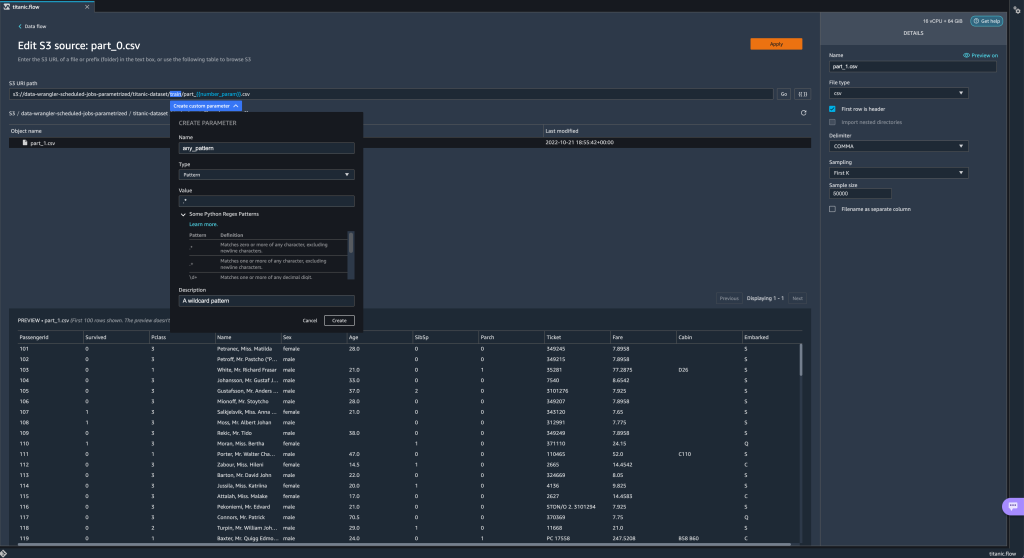

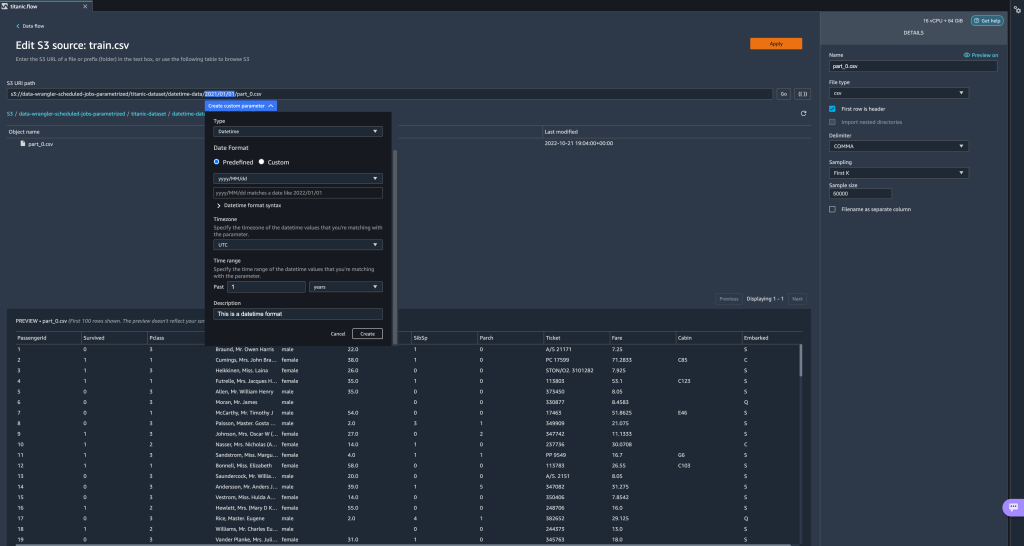

- Az új paraméterek létrehozásának előnyben részesített (és legegyszerűbb) módja az URI egy részének kiemelése és kiválasztása Egyéni paraméter létrehozása a legördülő menüben. Minden létrehozni kívánt paraméterhez négy dolgot kell megadnia:

- Név

- típus

- Alapértelmezett érték

- Leírás

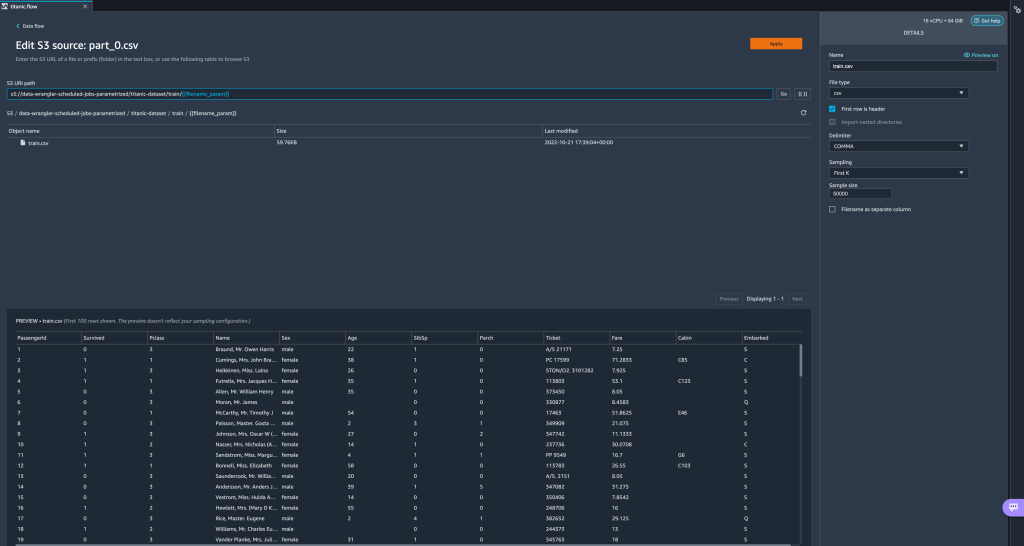

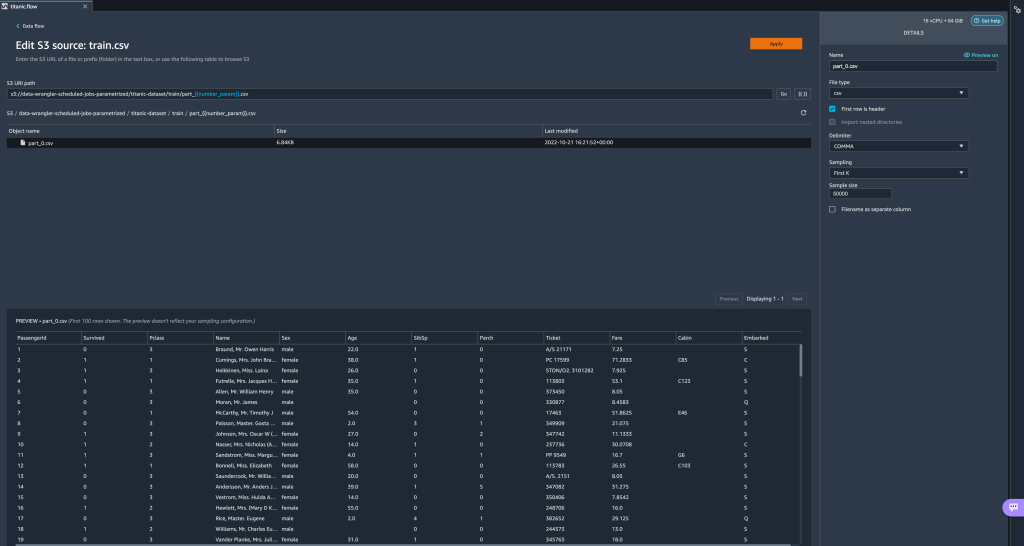

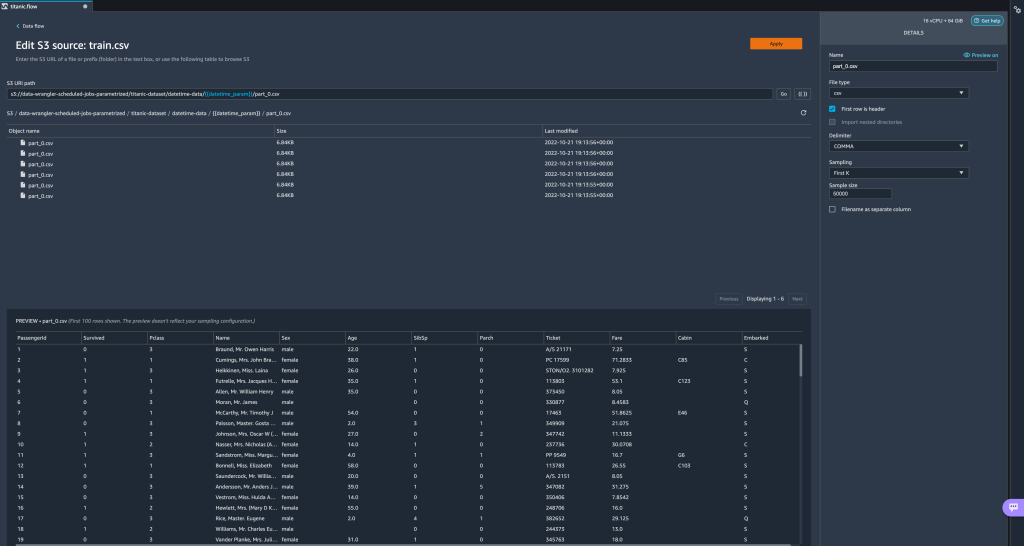

Itt létrehoztunk egy String típusú paramétertfilename_paramalapértelmezett értékkeltrain.csv. Most láthatja a paraméter nevét dupla zárójelek között, helyettesítve az URI-nak azt a részét, amelyet korábban kiemeltünk. Mivel ennek a paraméternek a meghatározott értéke az volttrain.csv, most látjuk a fájlttrain.csvszerepel az import táblázatban.

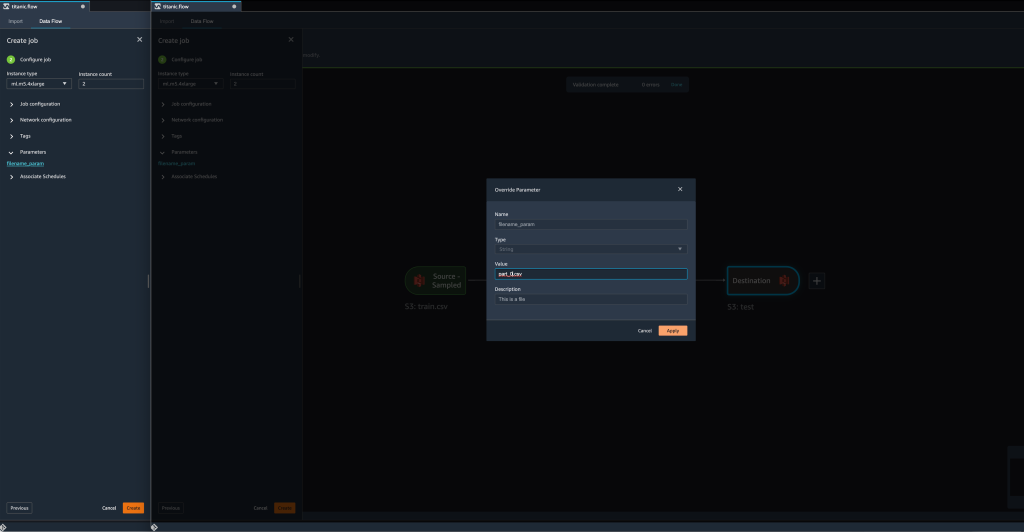

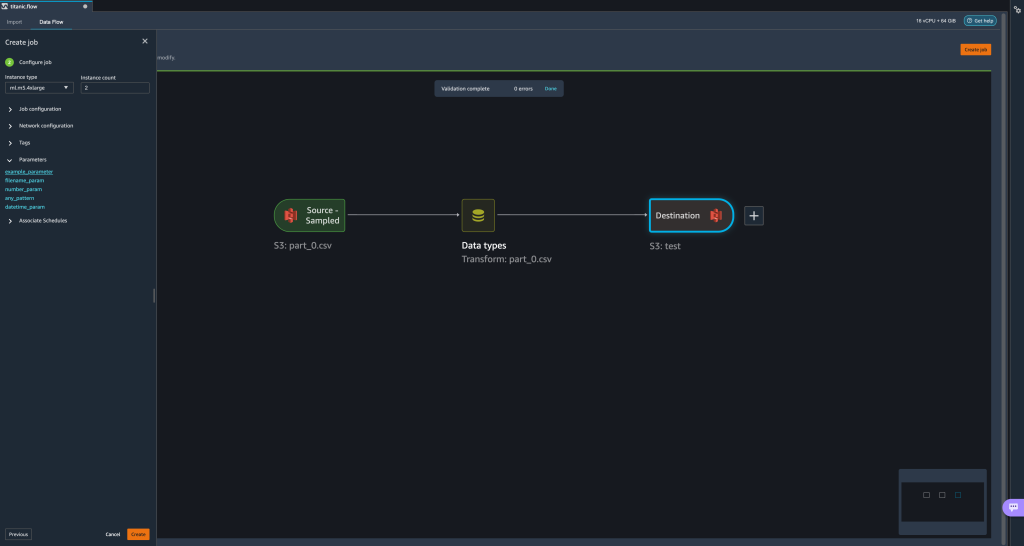

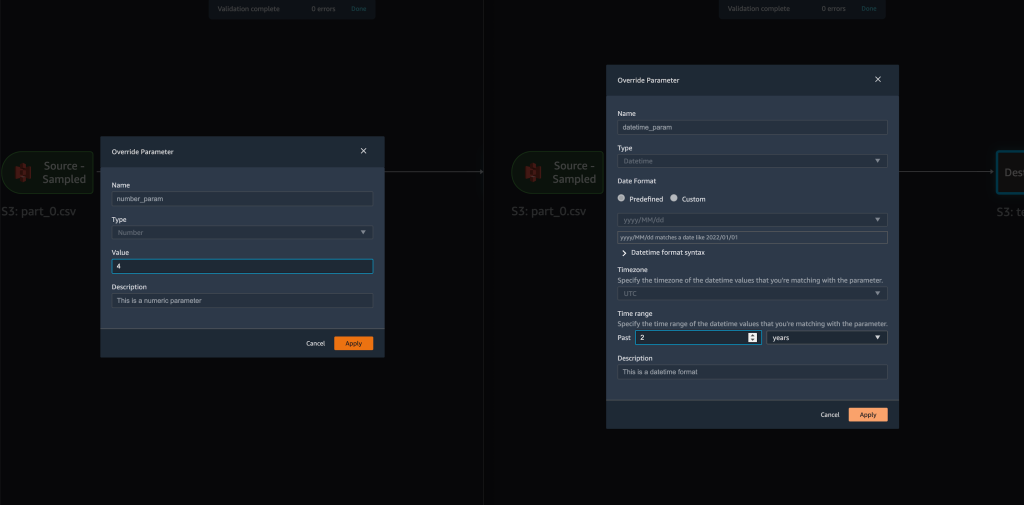

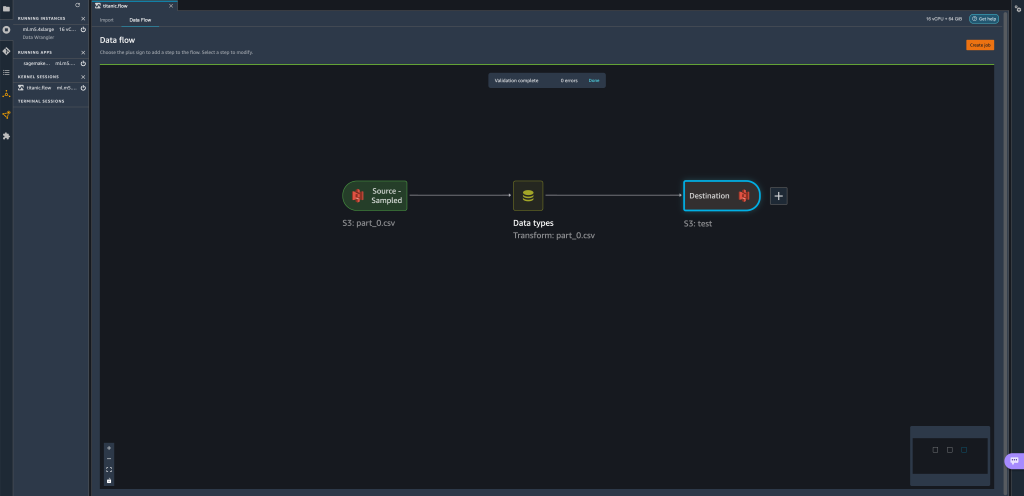

- Amikor megpróbálunk létrehozni egy átalakítási munkát, a Munka konfigurálása lépést, most látjuk a paraméterek szakaszt, ahol láthatjuk az összes meghatározott paraméterünk listáját.

- A paraméter kiválasztása lehetőséget ad a paraméter értékének megváltoztatására, ebben az esetben a transzformálandó bemeneti adathalmaz megváltoztatására a meghatározott folyamnak megfelelően.

Feltéve, hogy megváltoztatjuk az értékétfilename_paramból bőltrain.csvnak nekpart_0.csv, az átalakítási munka most tartpart_0.csv(feltéve, hogy egy fájl a névvelpart_0.csvugyanabban a mappában található), mint az új bemeneti adatok.

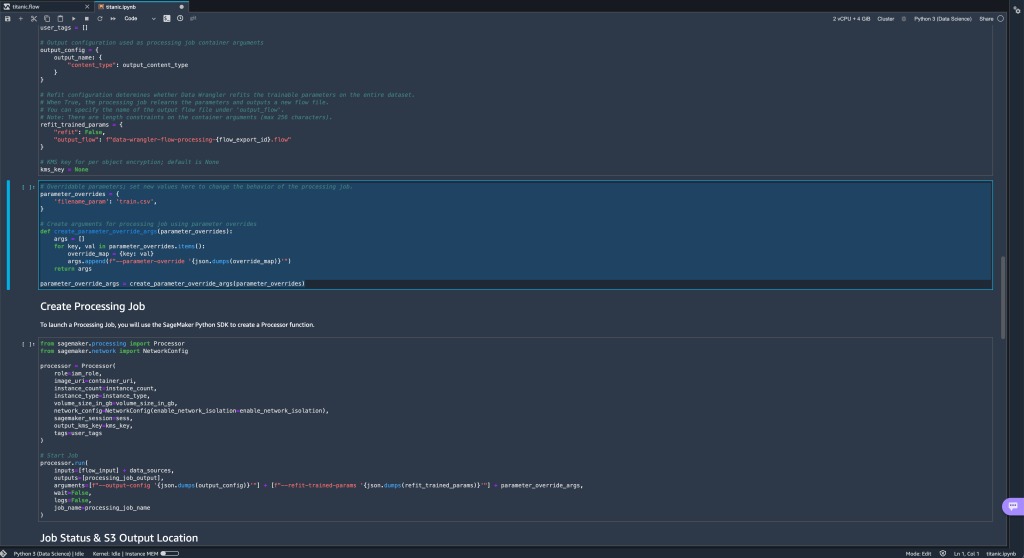

- Ezenkívül, ha megpróbálja exportálni a folyamatot egy Amazon S3 célhelyre (Jupyter notebookon keresztül), akkor most egy új cella jelenik meg, amely tartalmazza a megadott paramétereket.

Vegye figyelembe, hogy a paraméter az alapértelmezett értékét veszi fel, de megváltoztathatja, ha lecseréli az értékét aparameter_overridesszótárat (a szótár kulcsait változatlanul hagyva).

Ezenkívül új paramétereket hozhat létre a paraméterek UI. - Nyissa meg a paraméter ikon kiválasztásával ({{}}) mellett található Go választási lehetőség; mindkettő az URI elérési út értéke mellett található.

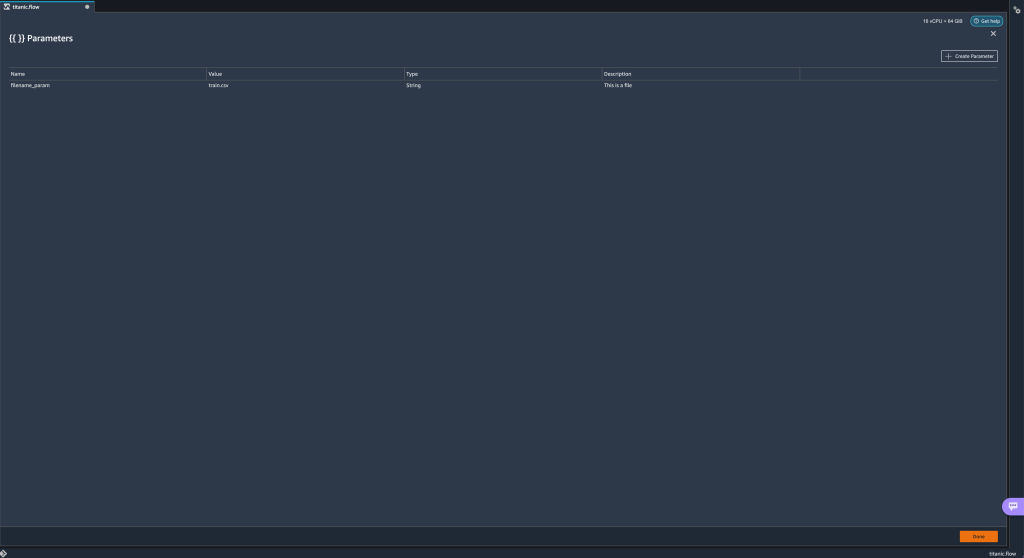

Megnyílik egy táblázat a folyamatfájlban jelenleg létező összes paraméterrel (

Megnyílik egy táblázat a folyamatfájlban jelenleg létező összes paraméterrel (filename_paramezen a ponton). - Választással új paramétereket hozhat létre a folyamathoz Paraméter létrehozása.

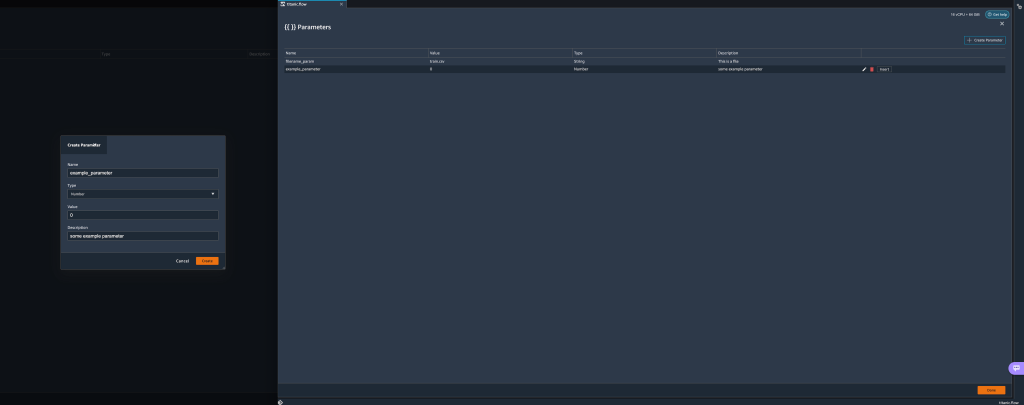

Megnyílik egy felugró ablak, ahol új egyéni paramétert hozhat létre. - Itt létrehoztunk egy újat

example_parameterszámtípusként 0 alapértelmezett értékkel. Ez az újonnan létrehozott paraméter most a listában szerepel paraméterek asztal. Ha az egérmutatót a paraméter fölé viszi, megjelennek a lehetőségek szerkesztése, törölés betétlap.

- Belülről a paraméterek UI, beillesztheti az egyik paramétert az URI-ba a kívánt paraméter kiválasztásával és kiválasztásával betétlap.

Ez hozzáadja a paramétert az URI végéhez. Át kell helyeznie az URI-n belül a kívánt szakaszba.

- Módosítsa a paraméter alapértelmezett értékét, alkalmazza a módosítást (a modálisból), válassza ki Go, és válassza a frissítés ikont az előnézeti lista frissítéséhez a kiválasztott adatkészlettel az újonnan meghatározott paraméter értéke alapján.

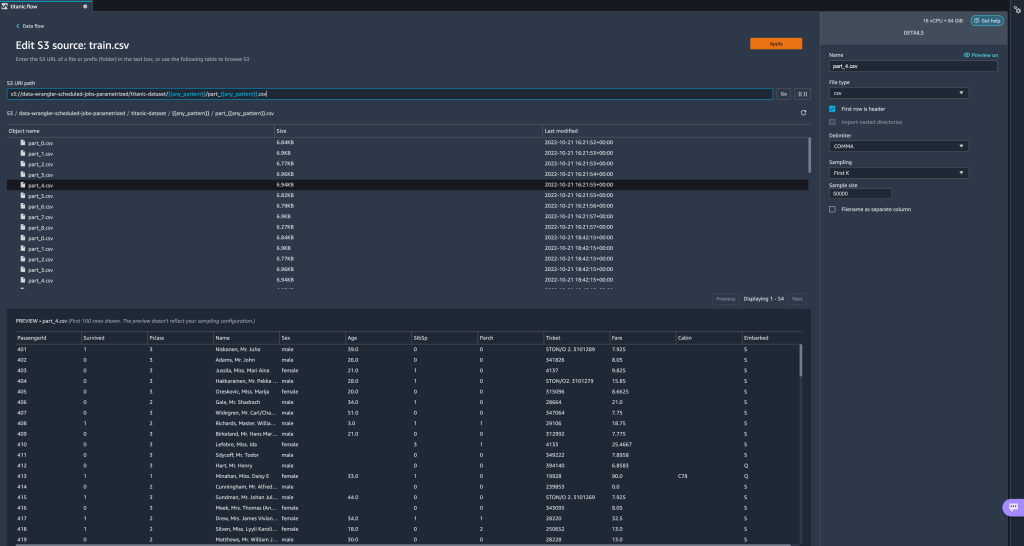

Most nézzünk meg más paramétertípusokat. Tegyük fel, hogy most van egy több részre osztott adatkészletünk, ahol minden fájlnak van egy cikkszáma.

Most nézzünk meg más paramétertípusokat. Tegyük fel, hogy most van egy több részre osztott adatkészletünk, ahol minden fájlnak van egy cikkszáma. - Ha dinamikusan szeretnénk módosítani a fájlszámot, akkor a következő képernyőképen látható módon definiálhatunk egy Number paramétert.

Vegye figyelembe, hogy a kiválasztott fájl az, amelyik megfelel a paraméterben megadott számnak.

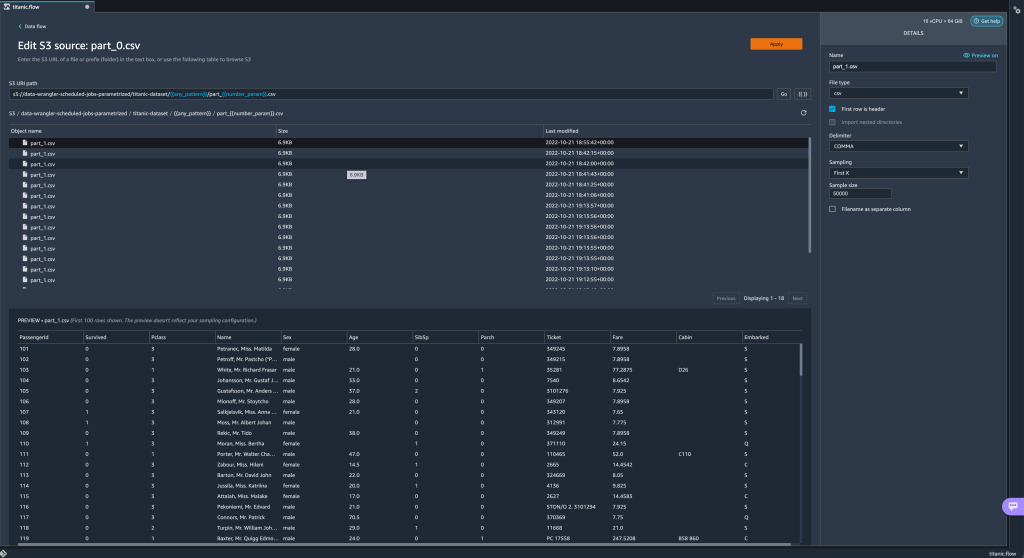

Vegye figyelembe, hogy a kiválasztott fájl az, amelyik megfelel a paraméterben megadott számnak. Most mutassuk be, hogyan kell használni a Pattern paramétert. Tegyük fel, hogy importálni akarjuk az összes

Most mutassuk be, hogyan kell használni a Pattern paramétert. Tegyük fel, hogy importálni akarjuk az összes part_1.csvalatti összes mappában található fájlokattitanic-dataset/mappát. A minta paraméterei bármilyen érvényes reguláris kifejezést vehetnek fel; példaként látható néhány regex minta. - Hozzon létre egy Pattern paramétert

any_patternhogy megfeleljen a alatti bármely mappának vagy fájlnaktitanic-dataset/mappa alapértelmezett értékkel.*.Vegye észre, hogy a helyettesítő karakter nem egyetlen * (csillag), hanem van egy pontja is. - Jelölje ki a

titanic-dataset/részét, és hozzon létre egy egyéni paramétert. Ezúttal a Mintás típus. Ez a minta kiválasztja az összes megnevezett fájlt

Ez a minta kiválasztja az összes megnevezett fájlt part-1.csvalatti mappák bármelyikébőltitanic-dataset/. Egy paraméter többször is használható egy útvonalon. A következő példában az újonnan létrehozott paraméterünket használjuk

Egy paraméter többször is használható egy útvonalon. A következő példában az újonnan létrehozott paraméterünket használjuk any_patternkétszer az URI-nkban, hogy megfeleljen az alábbi mappák bármelyikében található alkatrészfájloknaktitanic-dataset/. Végül hozzunk létre egy Datetime paramétert. A dátum-idő paraméterek akkor hasznosak, ha olyan útvonalakkal foglalkozunk, amelyek dátum és idő szerint vannak particionálva, például a Amazon Kinesis Data Firehose (Lásd: Dinamikus particionálás a Kinesis Data Firehose-ban). Ehhez a bemutatóhoz a datetime-data mappában található adatokat használjuk.

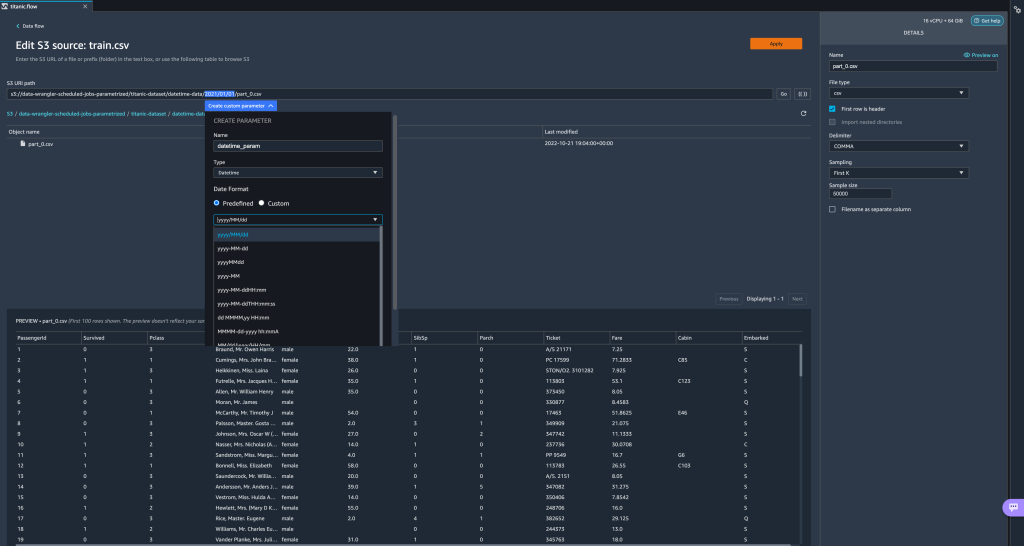

Végül hozzunk létre egy Datetime paramétert. A dátum-idő paraméterek akkor hasznosak, ha olyan útvonalakkal foglalkozunk, amelyek dátum és idő szerint vannak particionálva, például a Amazon Kinesis Data Firehose (Lásd: Dinamikus particionálás a Kinesis Data Firehose-ban). Ehhez a bemutatóhoz a datetime-data mappában található adatokat használjuk. - Válassza ki az útvonalnak azt a részét, amely egy dátum/idő, és hozzon létre egy egyéni paramétert. Válaszd a időpont paraméter típusa.

A Datetime adattípus kiválasztásakor további részleteket kell megadnia. - Először is meg kell adnia a dátumformátumot. Választhat az előre meghatározott dátum/idő formátumok közül, vagy létrehozhat egy egyedit.

Az előre meghatározott dátum/idő formátumok esetén a jelmagyarázat példát mutat a kiválasztott formátumnak megfelelő dátumra. Ehhez a bemutatóhoz a formátumot választjuk éééé/hh/nn.

- Ezután adjon meg egy időzónát a dátum/idő értékekhez.

Például az aktuális dátum lehet 1. január 2022. egy időzónában, de lehet 2. január 2022. egy másik időzónában. - Végül kiválaszthatja az időtartományt, amely lehetővé teszi az adatfolyamba bevonni kívánt fájlok tartományának kiválasztását.

Megadhatja az időtartományt órákban, napokban, hetekben, hónapokban vagy években. Ebben a példában szeretnénk lekérni az összes fájlt az elmúlt évből. - Adja meg a paraméter leírását, és válassza ki Teremt.

Ha több adatkészletet használ különböző időzónákkal, az idő nem konvertálódik automatikusan; minden fájlt vagy forrást elő kell feldolgoznia, hogy egy időzónává alakítsa át. A kiválasztott fájlok a tavalyi adatoknak megfelelő mappák összes állománya.

A kiválasztott fájlok a tavalyi adatoknak megfelelő mappák összes állománya.

- Most, ha létrehozunk egy adatátalakítási feladatot, láthatjuk az összes definiált paraméterünk listáját, és felülírhatjuk az alapértelmezett értékeket, így az átalakítási feladatok kiválasztják a megadott fájlokat.

Feldolgozási feladatok ütemezése

Mostantól ütemezheti a feldolgozási feladatokat, hogy automatizálja az adatátalakítási feladatok futtatását és az átalakított adatok exportálását az Amazon S3 vagy az Amazon SXNUMX-ba. Amazon SageMaker Feature Store. A munkákat az Ön igényeinek megfelelő időre és gyakorisággal ütemezheti.

Ütemezett feldolgozási feladatok használata Amazon EventBridge szabályok a munka ütemezéséhez. Ezért előfeltételként meg kell győződnie arról, hogy a AWS Identity and Access Management (IAM) szerepkört használ a Data Wrangler, nevezetesen a Amazon SageMaker végrehajtási szerep a Studio-példány engedélye van EventBridge-szabályok létrehozására.

IAM konfigurálása

Folytassa a következő frissítésekkel az IAM SageMaker végrehajtási szerepkörben, amely megfelel annak a Studio-példánynak, ahol a Data Wrangler folyamat fut:

- Csatlakoztassa a AmazonEventBridgeFullAccess kezelt politika.

- Szabályzat csatolása feldolgozási feladat létrehozására vonatkozó engedély megadásához:

- Engedélyezze az EventBridge-et a szerepvállaláshoz a következő bizalmi szabályzat hozzáadásával:

Alternatív megoldásként, ha más szerepkört használ a feldolgozási feladat futtatásához, alkalmazza a 2. és 3. lépésben ismertetett házirendeket erre a szerepkörre. Az IAM konfigurációval kapcsolatos részletekért lásd: Ütemezés létrehozása az új adatok automatikus feldolgozásához.

Készítsen ütemtervet

Ütemezés létrehozásához nyissa meg a folyamatot a Data Wrangler folyamatszerkesztőben.

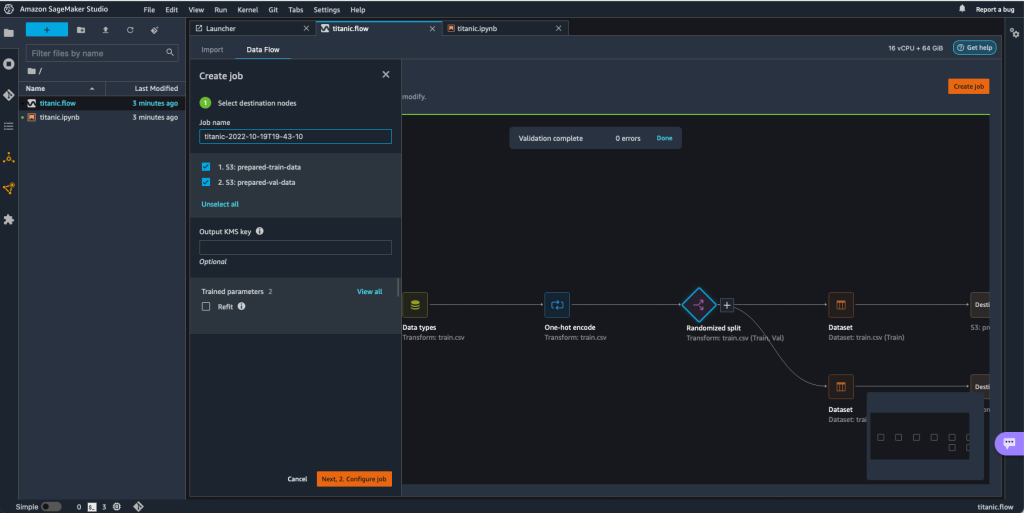

- A Adatáramlás lapot választani Állás létrehozása.

- Állítsa be a szükséges mezőket, és válassza ki Ezután 2. Állítsa be a feladatot.

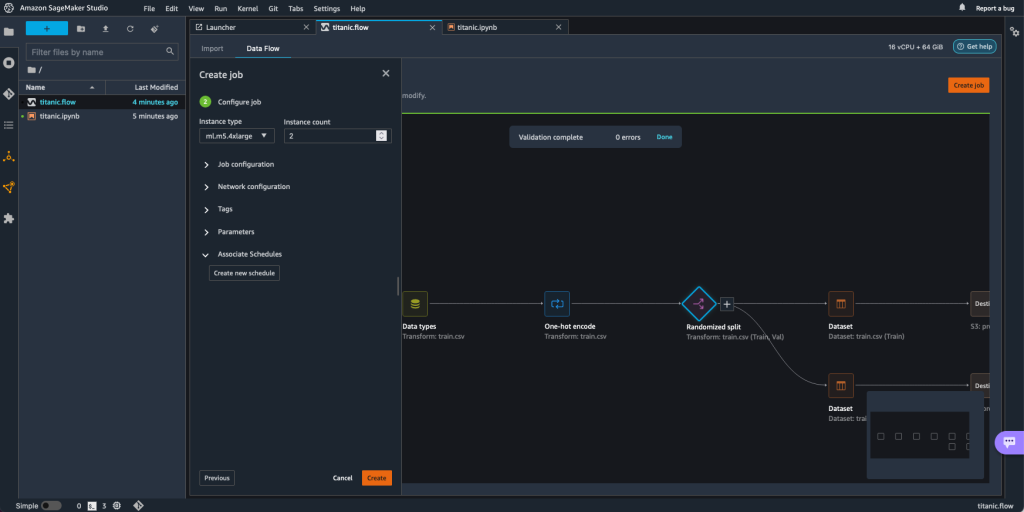

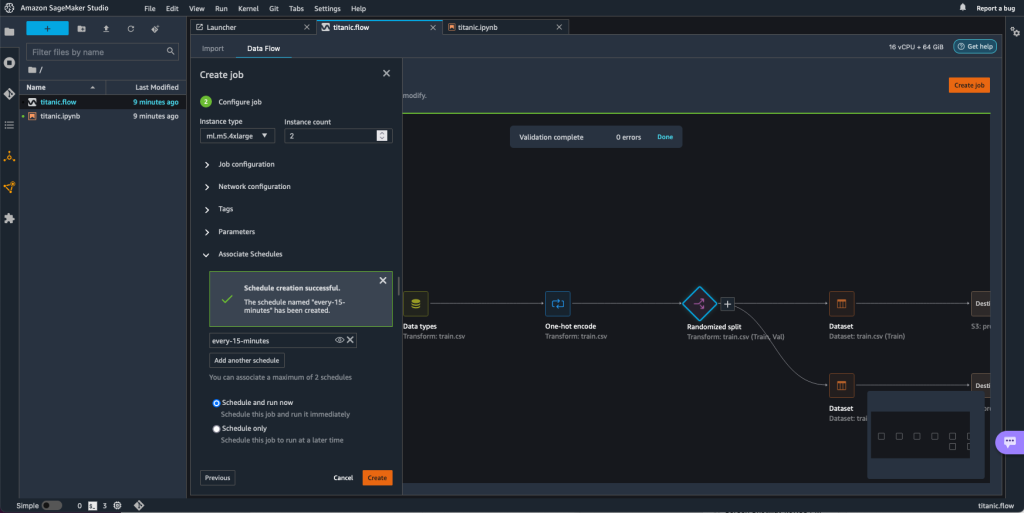

- Bontsa Társulási ütemezések.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Új ütemterv létrehozása.

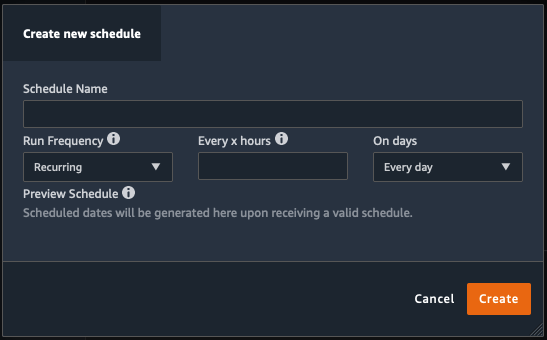

A Új ütemterv létrehozása párbeszédablak nyílik meg, ahol megadhatja a feldolgozási feladat ütemezésének részleteit.

A párbeszédpanel nagy rugalmasságot kínál az ütemezés meghatározásához. Beállíthatja például, hogy a feldolgozási feladat egy adott időpontban vagy X óránként, a hét meghatározott napjain fusson.

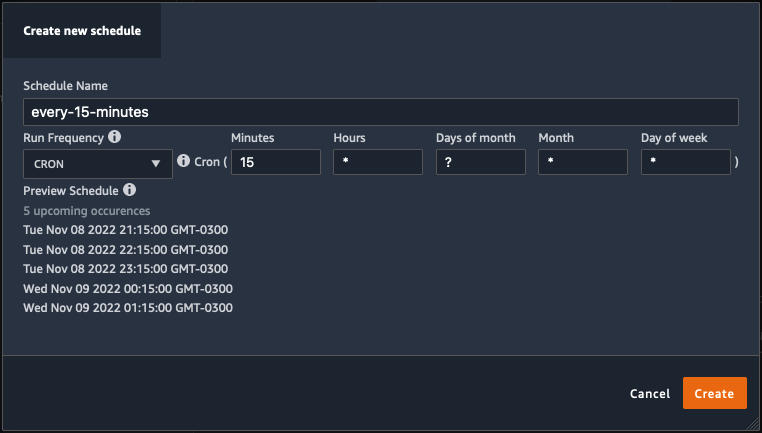

A periodicitás percekig szemcsés lehet.

- Határozza meg az ütemezés nevét és gyakoriságát, majd válassza ki Teremt az ütemezés mentéséhez.

- Lehetősége van azonnal elindítani a feldolgozási feladatot az ütemezéssel együtt, amely gondoskodik a jövőbeni futtatásokról, vagy hagyja, hogy a feladat csak az ütemezés szerint fusson.

- Ugyanahhoz a feldolgozási feladathoz további ütemezést is megadhat.

- A feldolgozási feladat ütemezésének befejezéséhez válassza a lehetőséget Teremt.

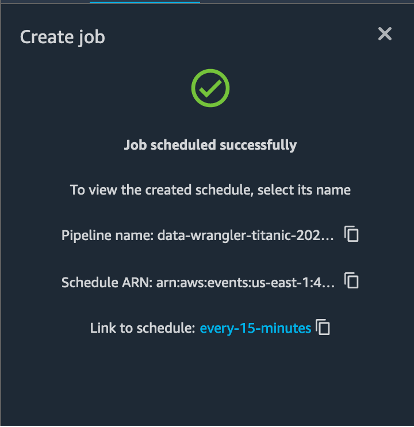

A „Feladat sikeresen ütemezve” üzenet jelenik meg. Ezen túlmenően, ha úgy dönt, hogy a feladatot csak az ütemezésnek megfelelően hagyja futni, akkor megjelenik egy hivatkozás a most létrehozott EventBridge-szabályra.

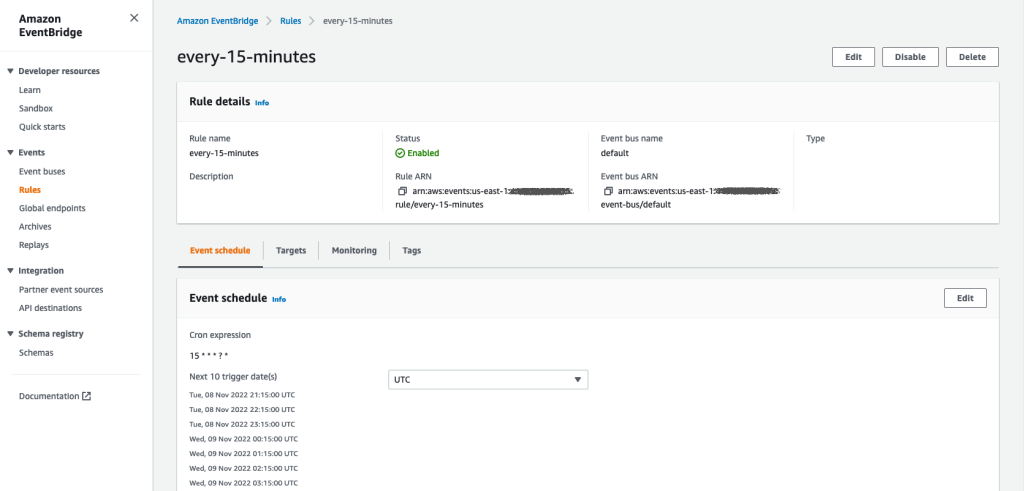

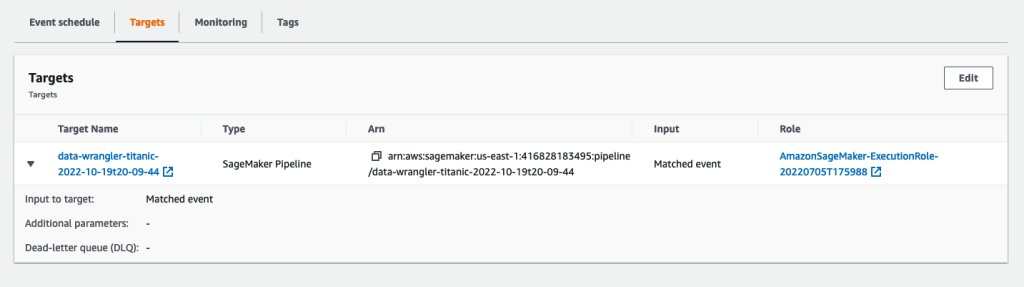

Ha az ütemezési hivatkozást választja, egy új lap nyílik meg a böngészőben, amelyen az EventBridge szabály látható. Ezen az oldalon további módosításokat végezhet a szabályon, és nyomon követheti annak hívási előzményeit. Az ütemezett feldolgozási feladat leállításához törölje az ütemezés nevét tartalmazó eseményszabályt.

Az EventBridge szabály egy SageMaker folyamatot jelenít meg célként, amely a meghatározott ütemezés szerint indul el, és a folyamat részeként meghívott feldolgozási feladatot.

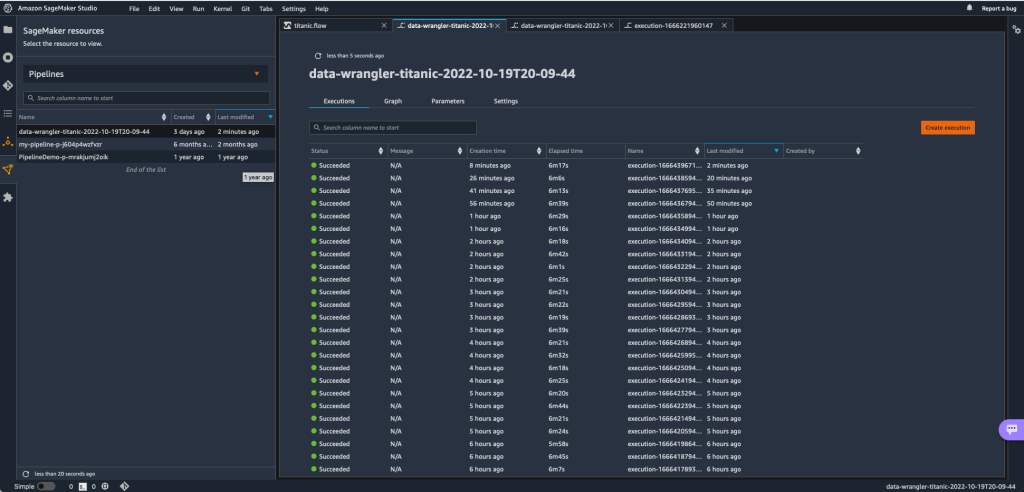

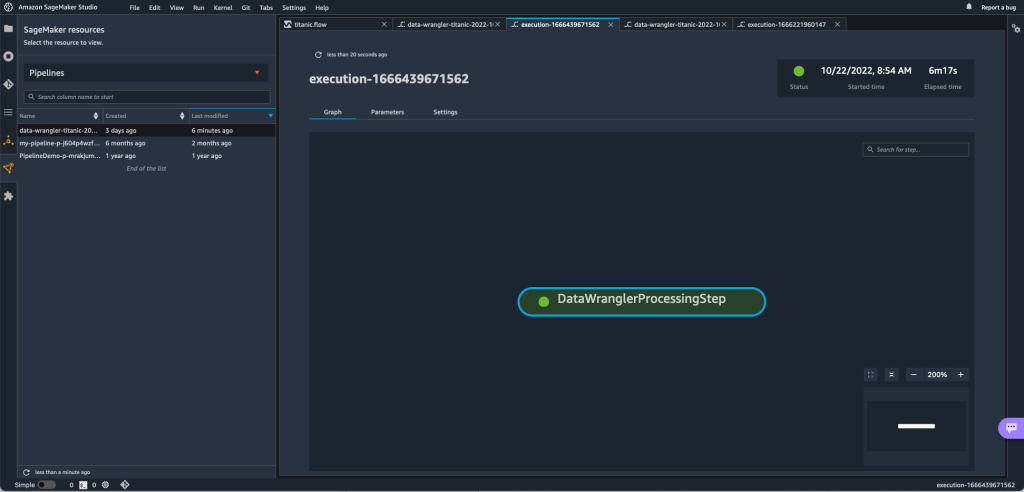

A SageMaker folyamat nyomon követéséhez lépjen vissza a Studio-ba, és válassza ki a SageMaker források ikon, válassza ki Csővezetékek, és válassza ki a nyomon követni kívánt folyamat nevét. Most láthat egy táblázatot a folyamat összes jelenlegi és múltbeli futtatásával és állapotával.

További részletek megtekintéséhez kattintson duplán egy adott bejegyzésre.

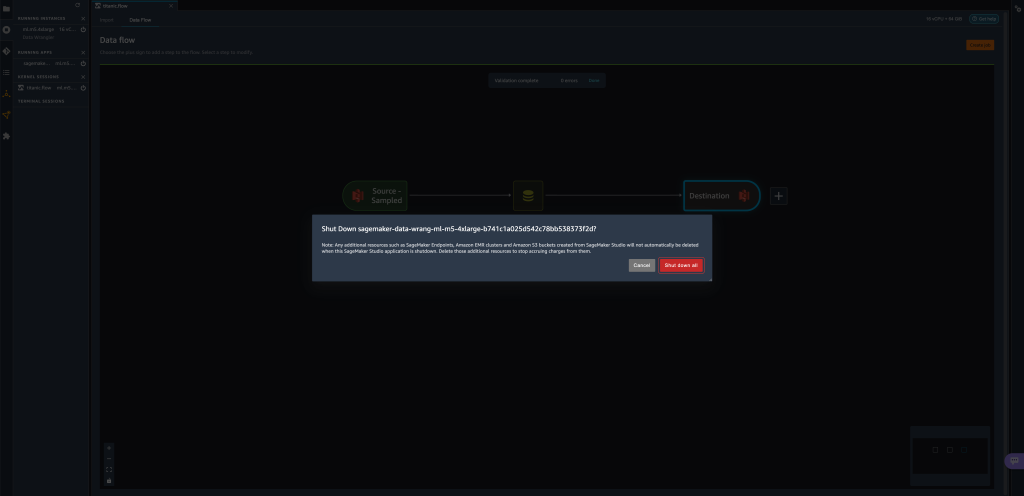

Tisztítsuk meg

Ha nem használja a Data Wranglert, ajánlatos leállítani azt a példányt, amelyen fut, hogy elkerülje a további költségeket.

A munkavesztés elkerülése érdekében mentse el az adatfolyamot, mielőtt leállítja a Data Wranglert.

- Az adatfolyam Stúdióba való mentéséhez válassza a lehetőséget filé, majd válassza ki Adatmentés Wrangler Flow. A Data Wrangler 60 másodpercenként automatikusan menti az adatfolyamot.

- A Data Wrangler példány leállításához a Studio alkalmazásban válassza a lehetőséget Példányok és kernelek futtatása.

- Alatt ALKALMAZÁSOK FUTÁSA, válassza ki a leállítás ikont a mellett

sagemaker-data-wrangler-1.0app.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Zárja be az összeset megerősítéséhez.

A Data Wrangler egy ml.m5.4xnagy példányon fut. Ez a példány eltűnik innen FUTÁSI PÉLDATOK amikor leállítja a Data Wrangler alkalmazást.

A Data Wrangler alkalmazás leállítása után újra kell indulnia, amikor legközelebb megnyit egy Data Wrangler folyamatfájlt. Ez eltarthat néhány percig.

Következtetés

Ebben a bejegyzésben bemutattuk, hogyan lehet paraméterekkel importálni adatkészleteit Data Wrangler-folyamatok segítségével, és adatátalakítási feladatokat hozhat létre rajtuk. A paraméterezett adatkészletek nagyobb rugalmasságot tesznek lehetővé a használt adatkészletekkel kapcsolatban, és lehetővé teszik a folyamatok újrafelhasználását. Bemutattuk azt is, hogyan állíthat be ütemezett feladatokat az adatátalakítások és az Amazon S3-ba vagy a Feature Store-ba történő exportálás automatizálásához, az igényeinek megfelelő időben és gyakorisággal, közvetlenül a Data Wrangler felhasználói felületéről.

Ha többet szeretne megtudni az adatfolyamok használatáról a Data Wranglerrel, lásd: Hozzon létre és használjon Data Wrangler Flow-t és a Amazon SageMaker árképzés. A Data Wrangler használatának megkezdéséhez lásd: Készítsen ML adatokat az Amazon SageMaker Data Wrangler segítségével.

A szerzőkről

David Laredo prototípuskészítő építész az Amazon Web Services prototípus- és felhőmérnöki csapatánál, ahol több gépi tanulási prototípus kifejlesztésében is segített az AWS-ügyfelek számára. Az elmúlt 6 évben gépi tanulással foglalkozik, ML modelleket képez és finomhangolt, valamint végpontok közötti folyamatokat valósított meg e modellek gyártásához. Érdeklődési területe az NLP, az ML alkalmazások és a végpontok közötti ML.

David Laredo prototípuskészítő építész az Amazon Web Services prototípus- és felhőmérnöki csapatánál, ahol több gépi tanulási prototípus kifejlesztésében is segített az AWS-ügyfelek számára. Az elmúlt 6 évben gépi tanulással foglalkozik, ML modelleket képez és finomhangolt, valamint végpontok közötti folyamatokat valósított meg e modellek gyártásához. Érdeklődési területe az NLP, az ML alkalmazások és a végpontok közötti ML.

Givanildo Alves az Amazon Web Services prototípus-készítési és felhőmérnöki csapatának prototípuskészítő építésze, aki az AWS-en elérhető művészet bemutatásával segíti az ügyfeleket az innovációban és a felgyorsításban, mivel már számos prototípust implementált a mesterséges intelligencia körül. Hosszú pályafutása van a szoftvermérnöki területen, korábban az Amazon.com.br szoftverfejlesztő mérnökeként dolgozott.

Givanildo Alves az Amazon Web Services prototípus-készítési és felhőmérnöki csapatának prototípuskészítő építésze, aki az AWS-en elérhető művészet bemutatásával segíti az ügyfeleket az innovációban és a felgyorsításban, mivel már számos prototípust implementált a mesterséges intelligencia körül. Hosszú pályafutása van a szoftvermérnöki területen, korábban az Amazon.com.br szoftverfejlesztő mérnökeként dolgozott.

Adrian Fuentes programmenedzser az Amazon Web Services prototípus-készítési és felhőmérnöki csapatánál, újításokkal az ügyfelek számára a gépi tanulás, az IoT és a blokklánc területén. Több mint 15 éves tapasztalattal rendelkezik projektek menedzselésében és megvalósításában, valamint 1 éves tapasztalattal rendelkezik az AWS-nél.

Adrian Fuentes programmenedzser az Amazon Web Services prototípus-készítési és felhőmérnöki csapatánál, újításokkal az ügyfelek számára a gépi tanulás, az IoT és a blokklánc területén. Több mint 15 éves tapasztalattal rendelkezik projektek menedzselésében és megvalósításában, valamint 1 éves tapasztalattal rendelkezik az AWS-nél.

- AI

- ai művészet

- ai art generátor

- van egy robotod

- Amazon gépi tanulás

- Amazon SageMaker Data Wrangler

- Közlemények

- mesterséges intelligencia

- mesterséges intelligencia tanúsítás

- mesterséges intelligencia a bankszektorban

- mesterséges intelligencia robot

- mesterséges intelligencia robotok

- mesterséges intelligencia szoftver

- AWS gépi tanulás

- blockchain

- blokklánc konferencia ai

- coingenius

- társalgási mesterséges intelligencia

- kriptokonferencia ai

- dall's

- adatfeldolgozás

- mély tanulás

- google azt

- Közepes (200)

- gépi tanulás

- Paraméterezett adatkészletek

- Plató

- plato ai

- Platón adatintelligencia

- Platón játék

- PlatoData

- platogaming

- skála ai

- Ütemezett munkák

- szintaxis

- Technikai útmutató

- zephyrnet