Erősítő egy új élő rádiós alkalmazás az Amazontól. Az Amp segítségével saját rádióműsoraidat vezetheted, és dalokat játszhatsz az Amazon Music katalógusból, vagy ráhangolódhatsz és hallgathatsz más Amp-felhasználók műsorait. Egy olyan környezetben, ahol bőséges és változatos a tartalom, fontos, hogy a felhasználói élményt az egyes felhasználók egyéni ízléséhez igazítsák, így könnyen megtalálhatják a nekik tetsző műsorokat, és új tartalmakat fedezhetnek fel, amelyek örömet szereznének.

Az Amp gépi tanulást (ML) használ, hogy személyre szabott ajánlásokat adjon az élő és közelgő Amp műsorokhoz az alkalmazás kezdőlapján. Az ajánlásokat egy Random Forest modell segítségével számítjuk ki, a műsorok népszerűségét (például a hallgatások és a kedvelések számát), az alkotó népszerűségét (például a legutóbbi műsorok lejátszásainak teljes számát) és a felhasználó személyes rokonságát tükröző jellemzőket használva. egy műsor témájához és alkotójához. Az affinitásokat a rendszer vagy implicit módon a felhasználó viselkedési adataiból, vagy kifejezetten érdeklődésre számot tartó témákból (például popzene, baseball vagy politika) számítja ki, amint azt a felhasználói profilok megadják.

Ez egy sorozat 2. része az adatelemzés és az ML for Amp használatáról, valamint egy személyre szabott műsorajánló-platform létrehozásáról. A platform 3%-os növekedést mutatott a nyomon követett ügyfelek elkötelezettségi mutatóiban (műsor kedvelése, alkotó követése, a közelgő műsorokról szóló értesítések engedélyezése) 2022 májusi indulása óta.

Hivatkozni rész 1 megtudhatja, hogyan gyűjtötték és dolgozták fel a viselkedési adatokat az adat- és analitikai rendszerek segítségével.

Megoldás áttekintése

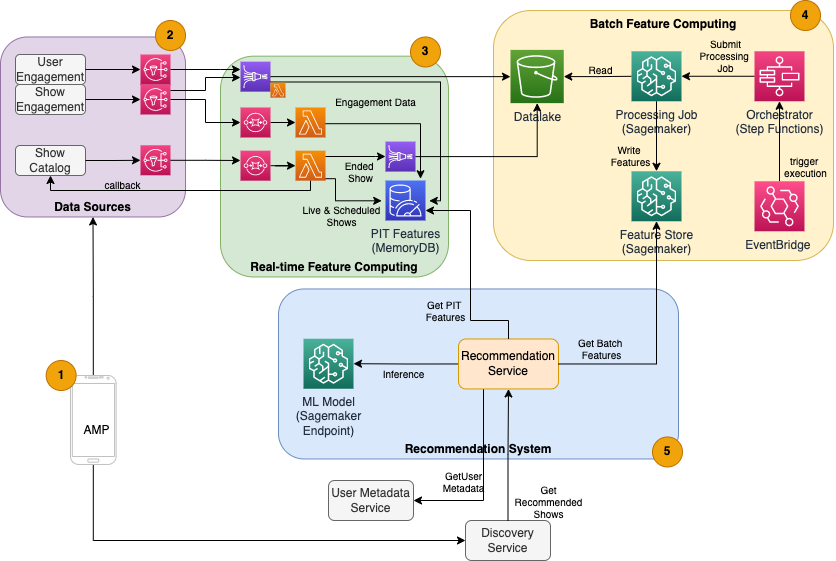

Az Amp ML-alapú műsorajánlója öt fő összetevőből áll, amint azt a következő architektúra diagram mutatja:

- Az Amp mobilalkalmazás.

- Háttérszolgáltatások, amelyek összegyűjtik a viselkedési adatokat, például a kedveléseket és a követéseket, valamint műsorokkal kapcsolatos információkat sugároznak, például állapotfrissítéseket, amikor a műsorok élőben indulnak.

- Viselkedési és műsoradatok valós idejű feldolgozása, valamint valós idejű (online) funkciók számítása és tárolása.

- Kötegelt (offline) szolgáltatás számítástechnika és tárolás.

- Egy ajánlórendszer, amely kezeli a bejövő kéréseket az alkalmazás hátterétől a műsorok listájának lekéréséhez. Ez magában foglalja a valós idejű következtetéseket a műsorok rangsorolására a személyre szabott és nem személyre szabott funkciók alapján.

Ez a bejegyzés a 3., 4. és 5. részre összpontosít, hogy a következőket részletezze:

A következő diagram a magas szintű architektúrát és annak összetevőit mutatja be.

A következő szakaszokban további részleteket közölünk a valós idejű jellemzőszámításról, a kötegelt jellemzőszámításról, a valós idejű következtetésekről, a működési állapotról és az általunk megfigyelt eredményekről.

Valós idejű jellemző számítástechnika

Egyes funkciókat, mint például a kedvelések és a hallgatások száma egy műsornál, folyamatosan streamelni kell, és úgy kell használni, ahogy van, míg más funkciókat, például az 5 percnél hosszabb hallgatási munkamenetek számát, valós időben is nyers adatként kell átalakítani. for sessions streaming. Az ilyen típusú jellemzőket, ahol az értékeket a következtetés időpontjában kell kiszámítani, úgy nevezzük időpont (PIT) jellemzői. A PIT-funkciók adatait gyorsan frissíteni kell, és a legújabb verziót alacsony késleltetéssel kell írni és olvasni (20 adás esetén felhasználónként 1,000 ezredmásodperc alatt). Az adatoknak tartós tárolóban is kell lenniük, mert a hiányzó vagy részleges adatok az ajánlások romlását és az ügyfélélmény romlását okozhatják. Az olvasási/írási késleltetés mellett a PIT-funkciók alacsony tükrözési időt is igényelnek. Az elmélkedési idő az az idő, amely alatt egy funkció elérhetővé válik a közreműködő események kibocsátása után, például a műsor kedvelőinek és a PIT LikeCount funkció frissítése között eltelt idő.

Az adatok forrásai az alkalmazást közvetlenül kiszolgáló háttérszolgáltatások. Az adatok egy részét a rendszer metrikákká alakítja, amelyeket ezután továbbít Amazon Simple Notification Service (Amazon SNS) a downstream figyelőkhöz, mint például az ML funkció transzformációs folyamat. A memórián belüli adatbázisok, például a MemoryDB ideális szolgáltatást jelentenek a tartós tároláshoz és az ultragyors teljesítményhez nagy mennyiség mellett. Az a számítási komponens, amely átalakítja és a szolgáltatásokat MemoryDB-be írja, a Lambda. Az alkalmazásforgalom az időtől és a naptól függően napi és heti csúcsok és zuhanások mintáit követi. A lambda lehetővé teszi a bejövő események mennyiségének automatikus skálázását. Az egyes metrikus transzformációk függetlensége miatt a Lambda, amely önmagában is állapot nélküli szolgáltatás, jól illeszkedik ehhez a problémához. Elhelyezés Amazon Simple Queue Service (Amazon SQS) az Amazon SNS és a Lambda között nemcsak az üzenetvesztést akadályozza meg, hanem pufferként is működik olyan váratlan forgalomkitörések esetén, amelyeknek az előre konfigurált Lambda párhuzamossági korlátai nem biztos, hogy elegendőek a kiszolgáláshoz.

Kötegelt jellemző számítástechnika

Azokat a funkciókat, amelyek korábbi viselkedési adatokat használnak a felhasználó folyamatosan változó ízlésének megjelenítésére, bonyolultabb kiszámítani, és nem lehet valós időben kiszámítani. Ezeket a funkciókat egy kötegelt folyamat számítja ki, amely gyakran fut le, például naponta egyszer. A kötegelt funkciókhoz tartozó adatoknak támogatniuk kell a gyors lekérdezést az adatok szűréséhez és összesítéséhez, és hosszú időszakokat is felölelhetnek, így nagyobb volumenűek lesznek. Mivel a kötegjellemzőket a rendszer bemenetként is lekéri és elküldi valós idejű következtetéshez, ezeket továbbra is alacsony késleltetéssel kell olvasni.

A kötegelt jellemzőszámításhoz szükséges nyers adatok gyűjtése nem rendelkezik a PIT-funkcióknál rövidebb tükrözési idővel, ami lehetővé teszi az események hosszabb pufferelését és a metrikák kötegelt átalakítását. Ez a megoldás a Kinesis Data Firehose-t, egy felügyelt szolgáltatást használta, amellyel gyorsan közvetített adatfolyamokat több célállomásra, például Amazon egyszerű tárolási szolgáltatás (Amazon S3) az S3 Data Lake állandó mérőszámaihoz, amelyeket offline számításokhoz lehet használni. A Kinesis Data Firehose eseménypuffert és Lambda-integrációt biztosít ezeknek a mutatóknak az egyszerű összegyűjtéséhez, kötegelt átalakításához és az Amazon S3-hoz való megőrzéséhez, hogy később a kötegelt jellemző számítástechnika felhasználhassa őket. A kötegelt szolgáltatásszámítások nem rendelkeznek ugyanolyan alacsony késleltetésű olvasási/írási követelményekkel, mint a PIT-funkciókkal, ezért az Amazon S3 a jobb választás, mert olcsó, tartós tárhelyet biztosít ilyen nagy mennyiségű üzleti mérőszám tárolására.

Kezdeti ML modellünk 21 kötegelt funkciót használ, amelyeket naponta számítanak ki az elmúlt 2 hónapban rögzített adatok alapján. Ezek az adatok felhasználónként tartalmazzák a lejátszási és alkalmazástevékenységi előzményeket, és a felhasználók számával és az alkalmazáshasználat gyakoriságával együtt nőnek. Az ilyen léptékű szolgáltatástervezés automatizált folyamatot igényel a szükséges bemeneti adatok lekéréséhez, párhuzamos feldolgozásához, és az eredmény állandó tárhelyre történő exportálásához. A feldolgozó infrastruktúrára csak a számítások idejére van szükség. SageMaker feldolgozás előre elkészített Docker lemezképeket biztosít, amelyek tartalmazzák az Apache Sparkot és az elosztott adatfeldolgozási feladatok nagy léptékű futtatásához szükséges egyéb függőségeket. A feldolgozási feladatok mögöttes infrastruktúráját teljes mértékben a SageMaker felügyeli. A fürt erőforrásai a feladat időtartamára vannak kiépítve, és a feladat befejezésekor megtisztulnak.

A kötegelt folyamat minden egyes lépése – adatgyűjtés, szolgáltatástervezés, szolgáltatásmegmaradás – egy olyan munkafolyamat része, amely hibakezelést, újrapróbálkozásokat és állapotátmeneteket igényel. Val vel AWS lépésfunkciók, létrehozhat egy állapotgépet, és feloszthatja a munkafolyamatot több elő- és utófeldolgozási lépésre, valamint egy lépésre, amellyel a szolgáltatásokat a SageMaker Feature Store-ban, vagy a többi adatot az Amazon S3-ban tárolhatja. A Step Functions állapotgépe ezen keresztül aktiválható Amazon EventBridge a kötegelt számítás automatizálásához, hogy meghatározott ütemezés szerint fusson, például minden nap 10:00 UTC-kor.

A jellemzők kiszámítása után azokat verziószámmal kell ellátni és tárolni kell, hogy a következtetések levonásakor, valamint a modell átképzése során beolvashatók legyenek. A saját funkciótárolási és -kezelési szolgáltatás létrehozása helyett használhatja a SageMaker Feature Store szolgáltatást. A Feature Store egy teljesen felügyelt, célirányosan felépített adattár az ML modellek funkcióinak tárolására, megosztására és kezelésére. Tárolja az ML-szolgáltatások előzményeit az offline áruházban (Amazon S3), és API-kat is biztosít egy online áruház számára, hogy lehetővé tegye a legújabb funkciók alacsony késleltetésű beolvasását. Az offline áruház kiszolgálhatja az előzményadatokat további modellképzéshez és kísérletezéshez, és az online áruházat az ügyfelek felé néző API-k hívhatják fel, hogy valós idejű következtetéseket lehessen elérni. Ahogy szolgáltatásainkat személyre szabottabb tartalom biztosítása érdekében fejlesztjük, további ML-modellek betanítására számítunk, és a Feature Store segítségével kereshet, fedezhet fel és újra felhasználhat funkciókat e modellek között.

Valós idejű következtetés

A valós idejű következtetés általában megköveteli az ML modellek végpontok mögötti tárolását. Ezt megteheti webszerverek vagy tárolók használatával, de ehhez ML mérnöki erőfeszítésekre és infrastruktúrára van szükség a kezeléséhez és karbantartásához. A SageMaker megkönnyíti az ML-modellek valós idejű végpontokra történő telepítését. A SageMaker lehetővé teszi az ML-modellek betanítását és feltöltését, valamint a SageMaker-végpontok létrehozásával és konfigurálásával való tárolását. A valós idejű következtetés kielégíti a műsorok rangsorolására vonatkozó alacsony késleltetésű követelményeket, ahogy az Amp kezdőlapján böngészhetők.

A felügyelt tárhely mellett a SageMaker felügyelt végpontok skálázását is biztosítja. A SageMaker következtetés lehetővé teszi egy automatikus skálázási szabályzat meghatározását minimális és maximális példányszámmal, valamint a méretezés kiváltására szolgáló célhasználattal. Így könnyedén bővítheti vagy kicsinyítheti a kereslet változásait.

Működési egészség

A rendszer által a valós idejű funkciók számítása során kezelt események száma az alkalmazáshasználat természetes mintájának megfelelően változik (nagyobb vagy alacsonyabb forgalom a napszaktól vagy a hét napjától függően). Hasonlóképpen, a valós idejű következtetésre vonatkozó kérelmek száma skálázza az egyidejű alkalmazásfelhasználók számát. Ezek a szolgáltatások váratlan forgalmi csúcsokat is elérnek a népszerű alkotók közösségi médiában történő önremóciója miatt. Bár fontos annak biztosítása, hogy a rendszer felfelé és lefelé skálázható legyen a bejövő forgalom sikeres és takarékos kiszolgálása érdekében, az is fontos, hogy figyeljük a működési mutatókat, és figyelmeztessük a váratlan működési problémákat, hogy megelőzzük az adatok és a szolgáltatások elvesztését az ügyfelek számára. E szolgáltatások állapotának nyomon követése egyszerű amazonfelhőóra. A CloudWatch segítségével azonnal elérhetők a létfontosságú szolgáltatási állapotmérők, például a hibák és a műveletek késleltetése, valamint a kihasználtsági mutatók, például a memória-, lemez- és CPU-használat. Fejlesztőcsapatunk mérőszám-irányítópultokat és automatizált felügyeletet használ annak biztosítására, hogy ügyfeleinket magas rendelkezésre állás mellett (99.8%) és alacsony késleltetéssel (kevesebb, mint 200 ezredmásodperc végponttól végpontig) tudjuk kiszolgálni ügyfeleink számára, hogy felhasználónként megkaphassuk az ajánlott műsorokat.

Az eredmény mérése

Az ebben a bejegyzésben ismertetett, ML-alapú műsorajánló előtt egy egyszerűbb heurisztikus algoritmus az Amp rangsorolta a műsorokat a felhasználó személyes érdeklődési körébe tartozó témakörök alapján, amelyek önmagukban jelentek meg a profiljában. Beállítottunk egy A/B-tesztet, hogy mérjük az ML-alapú ajánlókra való váltás hatását a felhasználók korábbi alkalmazásinterakcióiból származó adatok alapján. A siker mutatóiként az olyan mutatók javulását azonosítottuk, mint a hallgatás időtartama és az elköteleződési műveletek száma (műsor kedvelése, műsor készítőjének követése, értesítések bekapcsolása). Az A/B-tesztelés során a felhasználók 50%-a kapott műsorajánlatokat az ML-alapú ajánlón keresztül, és 3%-kal javult az ügyfelek elköteleződési mutatói, és 0.5%-kal javult a lejátszás időtartama.

Következtetés

A célirányosan épített szolgáltatásokkal az Amp csapata kevesebb mint 3 hónapon belül ki tudta adni az ebben a bejegyzésben leírt személyre szabott műsorajánló API-t. A rendszer jól skálázható a jól ismert műsorvezetők vagy marketingkampányok által generált előre nem látható terhelésekre is, amelyek felhasználói beáramlást generálhatnak. A megoldás felügyelt szolgáltatásokat használ a feldolgozáshoz, a képzéshez és a hostinghoz, ami segít csökkenteni a rendszer napi karbantartására fordított időt. Mindezeket a felügyelt szolgáltatásokat a CloudWatch segítségével is figyelemmel kísérhetjük, hogy biztosítsuk az éles rendszerek folyamatos állapotát.

Az Amp ML-alapú ajánlójának első verziójának A/B tesztelése egy szabályalapú megközelítéssel szemben (amely csak az ügyfelek érdeklődési témái szerint rendezi a megjelenítéseket) azt mutatta, hogy az ML-alapú ajánló jobb minőségű tartalmat tesz elérhetővé a vásárlók számára változatosabb témákból. , ami nagyobb számú követést és engedélyezett értesítést eredményez. Az Amp csapata folyamatosan dolgozik a modellek fejlesztésén, hogy rendkívül releváns ajánlásokat tudjon nyújtani.

A Feature Store szolgáltatással kapcsolatos további információkért látogasson el a webhelyre Amazon SageMaker Feature Store és tekintse meg a többi ügyfélhasználati esetet a AWS gépi tanulási blog.

A szerzőkről

Tulipán Gupta az Amazon Web Services megoldástervezője. Az Amazonnal együttműködve technológiai megoldásokat tervez, épít és telepít az AWS-re. Segíti az ügyfeleket a bevált gyakorlatok átvételében, miközben a megoldást telepíti az AWS-ben, és az Analytics és az ML rajongó. Szabadidejében szeret úszni, túrázni és társasjátékozni.

Tulipán Gupta az Amazon Web Services megoldástervezője. Az Amazonnal együttműködve technológiai megoldásokat tervez, épít és telepít az AWS-re. Segíti az ügyfeleket a bevált gyakorlatok átvételében, miközben a megoldást telepíti az AWS-ben, és az Analytics és az ML rajongó. Szabadidejében szeret úszni, túrázni és társasjátékozni.

David Kuo az Amazon Web Services megoldástervezője. Az AWS-ügyfelekkel együttműködve technológiai megoldásokat tervez, épít és telepít az AWS-re. A Media and Entertainment ügyfelekkel dolgozik, és érdeklődik a gépi tanulási technológiák iránt. Szabadidejében azon töpreng, mit kezdjen a szabadidejével.

David Kuo az Amazon Web Services megoldástervezője. Az AWS-ügyfelekkel együttműködve technológiai megoldásokat tervez, épít és telepít az AWS-re. A Media and Entertainment ügyfelekkel dolgozik, és érdeklődik a gépi tanulási technológiák iránt. Szabadidejében azon töpreng, mit kezdjen a szabadidejével.

Manolya McCormick az Amp Sr szoftverfejlesztő mérnöke az Amazonon. Elosztott rendszereket tervez és épít az AWS használatával az ügyfelek által használt alkalmazások kiszolgálására. Szabadidejében szívesen olvas és főz új recepteket.

Manolya McCormick az Amp Sr szoftverfejlesztő mérnöke az Amazonon. Elosztott rendszereket tervez és épít az AWS használatával az ügyfelek által használt alkalmazások kiszolgálására. Szabadidejében szívesen olvas és főz új recepteket.

Jeff Christophersen az Amp idősebb adatmérnöke az Amazonon. Azon dolgozik, hogy olyan Big Data-megoldásokat tervezzen, építsen és telepítsen az AWS-en, amelyek hasznos betekintést nyújtanak. Segíti a belső csapatokat a méretezhető és automatizált megoldások elfogadásában, emellett az Analytics és a Big Data rajongója. Szabadidejében, amikor nem ül sílécen, megtalálhatja a mountain bike-ján.

Jeff Christophersen az Amp idősebb adatmérnöke az Amazonon. Azon dolgozik, hogy olyan Big Data-megoldásokat tervezzen, építsen és telepítsen az AWS-en, amelyek hasznos betekintést nyújtanak. Segíti a belső csapatokat a méretezhető és automatizált megoldások elfogadásában, emellett az Analytics és a Big Data rajongója. Szabadidejében, amikor nem ül sílécen, megtalálhatja a mountain bike-ján.

- AI

- ai művészet

- ai art generátor

- van egy robotod

- Amazon SageMaker

- mesterséges intelligencia

- mesterséges intelligencia tanúsítás

- mesterséges intelligencia a bankszektorban

- mesterséges intelligencia robot

- mesterséges intelligencia robotok

- mesterséges intelligencia szoftver

- AWS gépi tanulás

- blockchain

- blokklánc konferencia ai

- coingenius

- társalgási mesterséges intelligencia

- kriptokonferencia ai

- Ügyfélmegoldások

- dall's

- mély tanulás

- google azt

- gépi tanulás

- Plató

- plato ai

- Platón adatintelligencia

- Platón játék

- PlatoData

- platogaming

- skála ai

- szintaxis

- zephyrnet