Ennek a bejegyzésnek a társírói Christopher Diaz, Sam Kinard, Jaime Hidalgo és Daniel Suarez a CCC Intelligent Solutions-tól.

Ebben a bejegyzésben megbeszéljük, hogyan CCC intelligens megoldások (CCC) kombinálva Amazon SageMaker más AWS-szolgáltatásokkal egy olyan egyedi megoldás létrehozásához, amely képes befogadni az elképzelt komplex mesterséges intelligencia (AI) modellek típusait. A CCC egy vezető szoftver-szolgáltatásként (SaaS) platform a több billió dolláros vagyon- és balesetbiztosítási gazdaság számára, amely biztosítja a biztosítók, javítók, autógyártók, alkatrészszállítók, hitelezők és egyebek működését. A CCC felhőtechnológia több mint 30,000 XNUMX vállalkozást köt össze, amelyek digitalizálják a kritikus fontosságú munkafolyamatokat, a kereskedelmet és a vásárlói élményeket. A mesterséges intelligencia, a dolgok internete (IoT), az ügyfélélmény, valamint a hálózat- és munkafolyamat-kezelés megbízható vezetője, a CCC olyan innovációkat kínál, amelyek elősegítik az emberek életének előrehaladását, amikor az a legfontosabb.

A kihívás

A CCC évente több mint 1 billió dolláros követeléstranzakciót dolgoz fel. Ahogy a vállalat folyamatosan fejlődik, hogy integrálja az AI-t meglévő és új termékkatalógusába, ehhez kifinomult megközelítésekre van szükség a multimodális gépi tanulási (ML) együttes modellek képzéséhez és telepítéséhez az összetett üzleti igények megoldásához. Ezek olyan modellek, amelyek a CCC által az évek során továbbfejlesztett, szabadalmaztatott algoritmusokat és szakterületi szakértelmet foglalják magukban. Ezeknek a modelleknek képesnek kell lenniük árnyalt adatok és ügyfélszabályok új rétegeinek befogadására, hogy egységes előrejelzési eredményeket hozzanak létre. Ebben a blogbejegyzésben megtudjuk, hogyan használta ki a CCC az Amazon SageMaker tárhelyszolgáltatást és más AWS-szolgáltatásokat, hogy több multimodális modellt telepítsen vagy tároljon egy ensemble következtetési folyamatban.

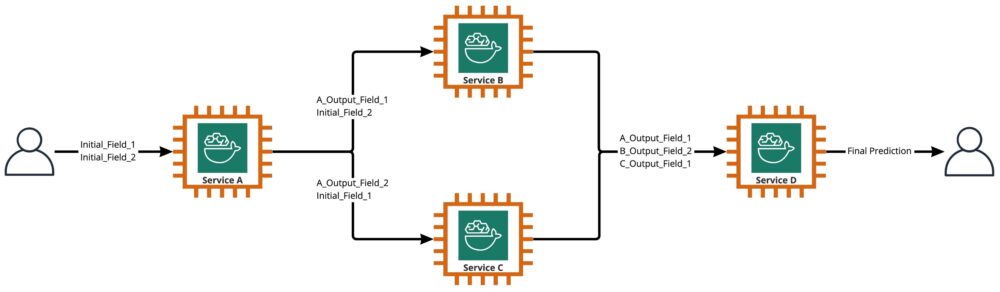

Amint az a következő ábrán látható, az együttes két vagy több modell gyűjteménye, amelyek lineáris vagy nemlineáris módon futnak egyetlen előrejelzés létrehozására. Ha lineárisan halmozzuk fel, az együttes egyedi modelljei közvetlenül előhívhatók előrejelzésekhez, majd később konszolidálhatók az egyesítéshez. Időnként az ensemble modellek soros következtetési folyamatként is megvalósíthatók.

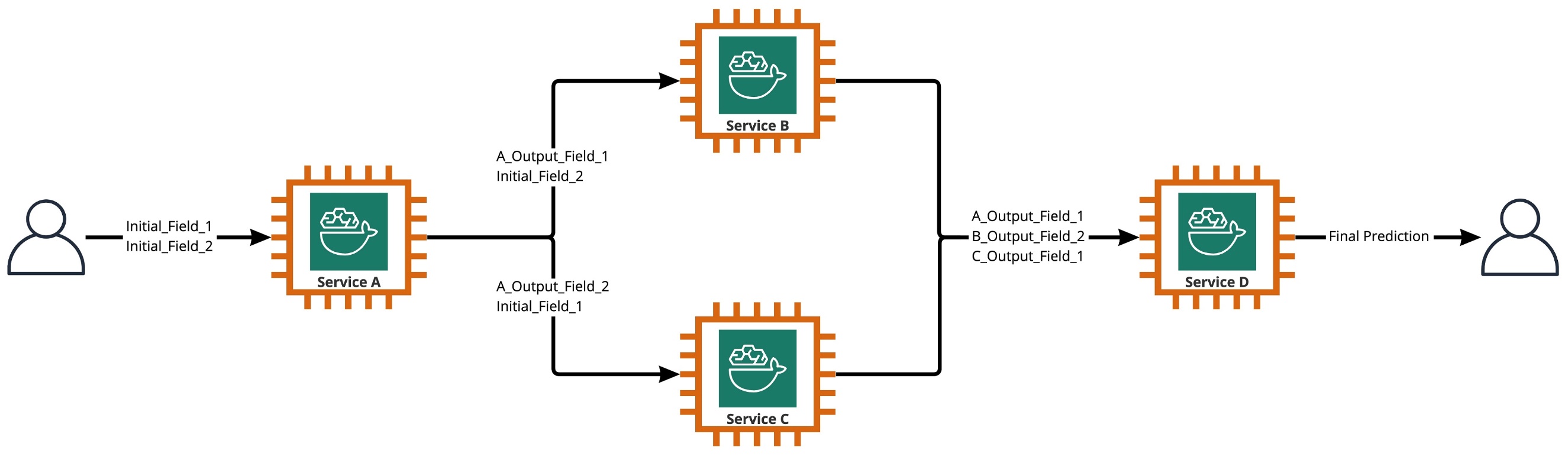

A mi felhasználási esetünkben az ensemble pipeline szigorúan nemlineáris, amint az a következő ábrán látható. A nemlineáris ensemble pipeline-ok elméletileg közvetlenül aciklikus gráfok (DAG). A mi használati esetünkben ez a DAG-folyamat párhuzamosan futó független modellekkel (B, C) és más olyan modellekkel is rendelkezett, amelyek korábbi lépésekből származó előrejelzéseket használnak (D szolgáltatás).

A CCC kutatás-vezérelt kultúrájából kirajzolódó gyakorlat az, hogy folyamatosan felülvizsgálják azokat a technológiákat, amelyekkel több értéket lehet elérni az ügyfelek számára. Ahogy a CCC szembesült ezzel az együttes kihívással, a vezetés elindított egy koncepcióbizonyítási (POC) kezdeményezést, hogy alaposan felmérje az AWS kínálatát, és konkrétan feltárja, vajon az Amazon SageMaker és más AWS-eszközök képesek-e kezelni az egyes mesterséges intelligencia-modelleket összetett, nemlineárisan. együttesek.

Az együttes elmagyarázta: Ebben az összefüggésben az együttes 2 vagy több mesterségesintelligencia-modellből álló csoport, amelyek együttesen 1 általános előrejelzést hoznak létre.

A kutatást mozgató kérdések

Használható-e az Amazon SageMaker olyan komplex mesterséges intelligencia-modell-együttesek befogadására, amelyek együttesen egy átfogó előrejelzést adnak? Ha igen, a SageMaker kínálhat-e más előnyöket, például fokozott automatizálást, megbízhatóságot, felügyeletet, automatikus méretezést és költségmegtakarítási intézkedéseket?

Ha alternatív módszereket talál a CCC mesterséges intelligencia-modelleinek a felhőszolgáltatók technológiai fejlesztései segítségével, akkor a CCC versenytársainál gyorsabban tudja piacra dobni az AI-megoldásokat. Ezenkívül az egynél több telepítési architektúra rugalmasságot biztosít a költségek és a teljesítmény közötti egyensúly megtalálásához az üzleti prioritások alapján.

Követelményeink alapján véglegesítettük a szolgáltatások alábbi listáját, mint ellenőrzőlistát egy éles szintű telepítési architektúrához:

- Komplex együttesek támogatása

- Garantált üzemidő minden komponenshez

- Testreszabható automatikus méretezés a telepített AI modellekhez

- Az AI modell be- és kimenetének megőrzése

- Használati mutatók és naplók az összes összetevőhöz

- Költségmegtakarítási mechanizmusok

Mivel a CCC mesterséges intelligencia-megoldásainak többsége számítógépes látásmodellekre támaszkodik, új architektúrára volt szükség a folyamatosan növekvő felbontású kép- és videofájlok támogatásához. Erősen szükség volt ennek az architektúrának aszinkron modellként történő megtervezésére és megvalósítására.

A kutatási ciklusok és a kezdeti benchmarking erőfeszítések után a CCC megállapította, hogy a SageMaker tökéletesen megfelel a gyártási követelmények többségének, különösen a garantált üzemidő, amelyet a SageMaker biztosít a legtöbb következtetési összetevőhöz. Az Amazon SageMaker Asynchronous Inference végpontjainak alapértelmezett funkciója az Amazon S3 bemeneti/kimeneti mentése leegyszerűsíti az összetett együttesekből előállított adatok megőrzését. Ezenkívül, mivel minden mesterséges intelligencia-modellt saját végpontja tárol, könnyebbé válik az automatikus skálázási szabályzatok kezelése a modell vagy a végpont szintjén. A kezelés egyszerűsítésével a fejlesztőcsapatok több időt fordíthatnak a skálázási szabályzatok finomhangolására, hogy minimalizálják a számítási erőforrások túlzott kiépítését.

Miután úgy döntöttünk, hogy az architektúra kulcsfontosságú elemeként a SageMaker-t használjuk, arra is rájöttünk, hogy a SageMaker egy még nagyobb architektúra része lehet, számos más, szerver nélküli AWS által felügyelt szolgáltatással kiegészítve. Erre a választásra azért volt szükség, hogy megkönnyítsék ennek az összetett architektúrának a magasabb rendű hangszerelési és megfigyelhetőségi igényeit.

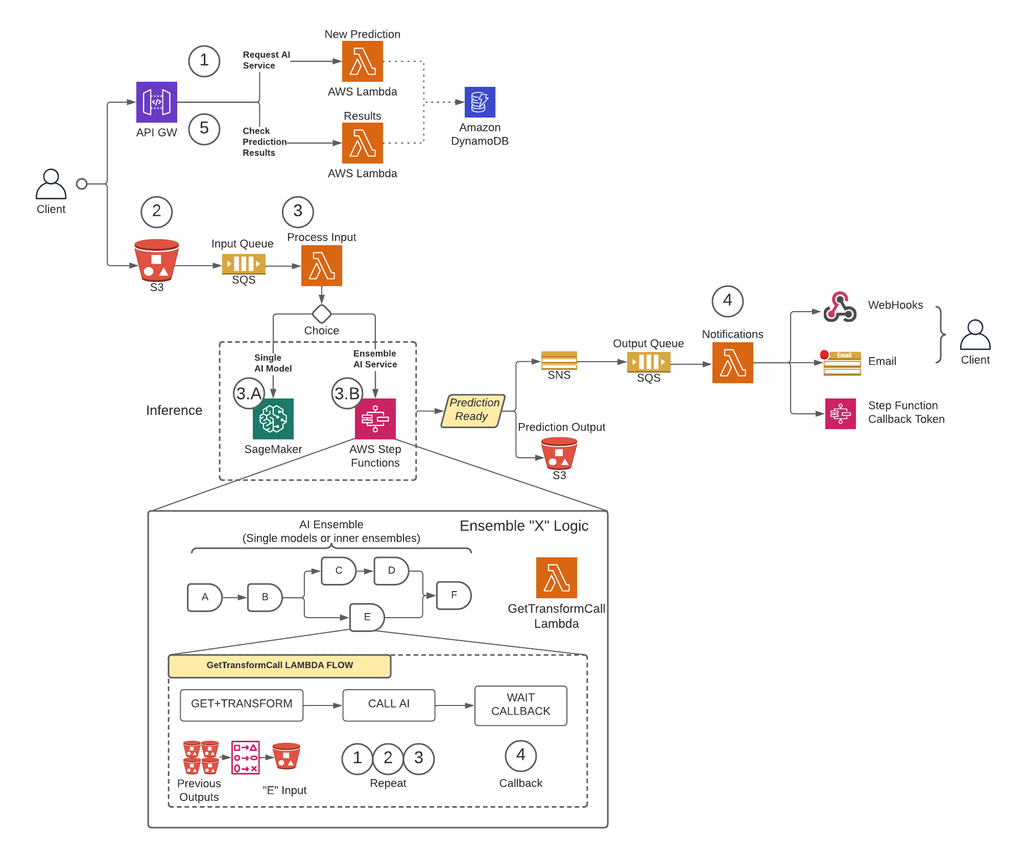

Először is, a hasznos adatok méretére vonatkozó korlátozások eltávolítása és az időtúllépési kockázat nagymértékű csökkentése érdekében a nagy forgalmú forgatókönyvek során a CCC olyan architektúrát vezetett be, amely aszinkron módon futtatja az előrejelzéseket A SageMaker aszinkron következtetés végpontjai más AWS által felügyelt szolgáltatásokkal párosulva, mint alapvető építőelemként. Ezenkívül a rendszer felhasználói felülete követi a tűz és felejtsd el tervezési mintát. Más szóval, ha a felhasználó feltöltötte bemenetét a rendszerbe, nem kell többet tennie. Értesítést kapnak, ha az előrejelzés elérhető lesz. Az alábbi ábra az aszinkron eseményvezérelt architektúránk magas szintű áttekintését szemlélteti. Az elkövetkező részben vessünk egy pillantást a tervezett architektúra végrehajtási folyamatába.

Lépésről-lépésre megoldás

1 lépés

Az ügyfél kérést nyújt be a AWS API átjáró végpont. A kérés tartalma tartalmazza annak az AI-szolgáltatásnak a nevét, amelytől előrejelzésre van szükségük, valamint a kívánt értesítési módot.

Ezt a kérést továbbítják a Lambda nevű függvény Új jóslat, melynek fő feladatai:

- Ellenőrizze, hogy az ügyfél által kért szolgáltatás elérhető-e.

- Rendeljen egyedi előrejelzési azonosítót a kérelemhez. Ezt az előrejelzési azonosítót használhatja a felhasználó az előrejelzés állapotának ellenőrzésére a teljes folyamat során.

- Létrehoz egy Amazon S3 előre aláírt URL, amelyet a felhasználónak a következő lépésben kell használnia az előrejelzési kérelem bemeneti tartalmának feltöltéséhez.

- Hozzon létre bejegyzést Amazon DynamoDB a beérkezett kérelem információival.

A Lambda függvény ezután az API-átjáró-végponton keresztül választ küld egy üzenettel, amely tartalmazza a kéréshez rendelt előrejelzési azonosítót és az Amazon S3 előre aláírt URL-címét.

2 lépés

Az ügyfél biztonságosan feltölti a predikciós bemeneti tartalmat egy S3 tárolóba az előző lépésben előállított előre aláírt URL használatával. A bemeneti tartalom az AI-szolgáltatástól függ, és állhat képekből, táblázatos adatokból vagy a kettő kombinációjából.

3 lépés

Az S3 tároló úgy van konfigurálva, hogy eseményt indítson el, amikor a felhasználó feltölti a bemeneti tartalmat. Ezt az értesítést a rendszer egy Amazon SQS-sorba küldi, és egy Lambda-függvény kezeli Folyamat bemenet Az Folyamat bemenet A Lambda beszerzi az előrejelzési azonosítóhoz kapcsolódó információkat a DynamoDB-től, hogy megkapja annak a szolgáltatásnak a nevét, amelyhez a kérést el kell küldeni.

Ez a szolgáltatás lehet egyetlen mesterséges intelligencia modell is, ebben az esetben a Folyamat bemenet A Lambda kérést küld a SageMaker végponthoz, amely a modellt tárolja (3-A lépés), vagy lehet egy ensemble AI szolgáltatás, amely esetben a Folyamat bemenet A Lambda kérést küld a lépésfüggvények állapotgépéhez, amely az együttes logikát tárolja (3-B lépés).

Bármelyik opció esetén (egy AI modell vagy ensemble AI szolgáltatás), amikor a végső előrejelzés készen áll, a megfelelő S3 tárolóban tárolódik, és a hívó fél értesítést kap az 1. lépésben meghatározott módszerrel (az értesítésekről bővebben a lépésben olvashat 4).

3-A lépés

Ha az előrejelzési azonosító egyetlen AI-modellhez van társítva, a Folyamat bemenet A Lambda kérést küld a modellt kiszolgáló SageMaker végponthoz. Ebben a rendszerben kétféle SageMaker végpont támogatott:

- Aszinkron: A Folyamat bemenet A Lambda kérést küld a SageMaker aszinkron végpontjához. Az azonnali válasz tartalmazza az S3 helyet, ahová a SageMaker elmenti az előrejelzés kimenetét. Ez a kérés aszinkron, a tűz és felejts mintát követi, és nem blokkolja a Lambda függvény végrehajtási folyamatát.

- Egyidejű: A Folyamat bemenet A Lambda kérést küld a SageMaker szinkron végponthoz. Mivel szinkron kérésről van szó, a Process Input megvárja a választ, és miután megkapta, eltárolja azt az S3-ban, a SageMaker aszinkron végpontjaihoz hasonló módon.

Mindkét esetben (szinkron vagy aszinkron végpontok) az előrejelzés feldolgozása egyenértékű módon történik, a kimenetet egy S3 tárolóban tárolva. Amikor az aszinkron SageMaker végpont befejez egy előrejelzést, egy Amazon SNS esemény aktiválódik. Ez a viselkedés a szinkron végpontok esetében is megismétlődik, további logikával a Lambda függvényben.

3-B lépés

Ha a predikciós azonosító egy AI együtteshez van társítva, a Folyamat bemenet A Lambda elküldi a kérést az adott AI-együtteshez társított lépésfüggvényhez. Amint fentebb említettük, az AI Ensemble olyan architektúra, amely AI-modellek csoportján alapul, amelyek együtt dolgoznak egyetlen általános előrejelzés létrehozása érdekében. Az AI együttes hangszerelése lépésfunkción keresztül történik.

A step funkciónak egy lépése van minden AI szolgáltatásonként, amely az együttest tartalmazza. Minden lépés meghív egy Lambda funkciót, amely előkészíti a megfelelő AI-szolgáltatás bemenetét a korábbi lépések korábbi AI-szolgáltatáshívásaiból származó kimeneti tartalom különböző kombinációival. Ezután felhívja az egyes AI-szolgáltatásokat, amelyek ebben az összefüggésben egyetlen AI-modell vagy egy másik AI-együttes is elsorvadhat.

Ugyanez a lambda-függvény, az ún GetTransformCall Az AI Ensemble közbenső előrejelzéseinek kezelésére használt lépések függvényében végig használatos, de minden lépéshez különböző bemeneti paraméterekkel. Ez a bemenet tartalmazza a meghívandó AI-szolgáltatás nevét. Tartalmazza a leképezési definíciót is a megadott AI-szolgáltatás bemenetének létrehozásához. Ez egy egyéni szintaxis használatával történik, amelyet a Lambda képes dekódolni, ami összefoglalóan egy JSON-szótár, ahol az értékeket le kell cserélni a korábbi AI-előrejelzések tartalmára. A Lambda letölti ezeket a korábbi előrejelzéseket az Amazon S3-ról.

Minden lépésben a GetTransformCall A Lambda beolvassa az Amazon S3-ból azokat a korábbi kimeneteket, amelyek a megadott AI-szolgáltatás bemenetének felépítéséhez szükségesek. Ezután meghívja a Új jóslat Az 1. lépésben korábban használt lambda-kód, és adja meg a szolgáltatás nevét, a visszahívási metódust ("lépési függvény") és a visszahíváshoz szükséges tokent a kérelem hasznos adattartalmában, amely aztán új előrejelzési rekordként kerül mentésre a DynamoDB-be. A Lambda egy S3 vödörben is tárolja az adott szakasz létrehozott bemenetét. Attól függően, hogy ez a szakasz egyetlen AI-modell vagy AI-együttes, a Lambda kérést küld egy SageMaker-végponthoz vagy egy másik lépésfüggvényhez, amely a szülő együttes függőségeként működő AI-együttest kezeli.

A kérés elküldése után a lépésfüggvény függő állapotba kerül, amíg meg nem kapja a visszahívási jogkivonatot, jelezve, hogy a következő szakaszba léphet. A visszahívási token küldésének műveletét a Lambda függvény hajtja végre értesítések (további részletek a 4. lépésben), amikor a köztes előrejelzés készen áll. Ez a folyamat a lépésfüggvényben meghatározott minden egyes szakaszra megismétlődik, amíg a végső előrejelzés el nem készül.

4 lépés

Amikor egy előrejelzés készen áll és az S3 tárolóban tárolódik, SNS-értesítés aktiválódik. Ez az esemény a folyamattól függően különböző módon indítható el:

- Automatikusan, amikor egy SageMaker aszinkron végpont befejez egy előrejelzést.

- A step funkció legutolsó lépéseként.

- By Folyamat bemenet or GetTransformCall Lambda, ha egy szinkron SageMaker-végpont előrejelzést adott vissza.

B és C esetén egy SNS-üzenetet hozunk létre, amely hasonló ahhoz, amit A automatikusan küld.

Az értesítések nevű Lambda-funkció előfizetett ehhez az SNS-témához. Az értesítések a Lambda megkapja az előrejelzési azonosítóval kapcsolatos információkat a DynamoDB-től, frissíti a bejegyzést állapotértékkel „befejezett” vagy „hiba” értékre, és elvégzi a szükséges műveleteket az adatbázisrekordban mentett visszahívási módtól függően.

Ha ez az előrejelzés egy mesterséges intelligencia együttes köztes előrejelzése, a 3-B lépésben leírtak szerint, az ehhez az előrejelzéshez társított visszahívási mód „lépésfüggvény” lesz, és az adatbázisrekord egy visszahívási jogkivonattal lesz társítva az adott lépéshez. lépés funkció. Az értesítések a Lambda a „SendTaskSuccess” vagy a „SendTaskFailure” metódussal hívják meg az AWS Step Functions API-t. Ez lehetővé teszi, hogy a lépés funkció továbblépjen a következő lépésre vagy kilépjen.

Ha az előrejelzés a lépésfunkció végső kimenete, és a visszahívási mód „Webhook” [vagy e-mail, üzenetközvetítők (Kafka) stb.], akkor a Lambda értesítései a megadott módon értesítik a klienst. A felhasználó bármikor lekérheti előrejelzésének állapotát. A kérésnek tartalmaznia kell az 1. lépésben hozzárendelt előrejelzési azonosítót, és a megfelelő URL-re kell mutatnia az API Gateway-en belül, hogy a kérést a Lambda függvényhez irányítsa. eredmények.

Az eredményeket a Lambda kéri a DynamoDB-hez, lekéri a kérés állapotát, és visszaküldi az információkat a felhasználónak. Ha a jóslat állapota az hiba, akkor a válasz tartalmazza a meghibásodás releváns részleteit. Ha az előrejelzés állapota az siker, akkor egy S3 előre aláírt URL-t ad vissza a felhasználó a várható tartalom letöltéséhez.

Eredmények

Az előzetes teljesítménytesztelési eredmények ígéretesek, és alátámasztják a CCC-nek az új telepítési architektúra megvalósításának kiterjesztését.

Figyelemre méltó megfigyelések:

- A tesztek feltárják a nagy átviteli sebességű és 0 százalékos meghibásodási arányú, nagy forgalmú forgatókönyvek esetén a kötegelt vagy egyidejű kérések feldolgozásának erősségét.

- Az üzenetsorok stabilitást biztosítanak a rendszeren belül a kérelmek hirtelen beáramlása esetén, amíg a skálázási triggerek további számítási erőforrásokat nem tudnak biztosítani. A forgalom háromszorosának növelésével az átlagos kérések várakozási ideje csak 3 százalékkal nőtt.

- A stabilitás ára a megnövekedett késleltetés a különböző rendszerkomponensek közötti kommunikációs többlet miatt. Ha a felhasználói forgalom meghaladja az alapvonali küszöböt, a hozzáadott késleltetés részben mérsékelhető több számítási erőforrás biztosításával, ha a teljesítmény nagyobb prioritást élvez a költségekkel szemben.

- A SageMaker aszinkron következtetési végpontjai lehetővé teszik a példányszám nullára skálázását, miközben a végpont aktív marad a kérések fogadásához. Ez a funkció lehetővé teszi, hogy a központi telepítések továbbra is fussanak számítási költségek nélkül, és szükség esetén nulláról skálázhatók fel két forgatókönyv szerint: alacsonyabb tesztkörnyezetekben használt szolgáltatás-telepítések és azok, amelyek minimális forgalmat igényelnek azonnali feldolgozás nélkül.

Következtetés

Amint azt a POC-folyamat során megfigyeltük, a CCC és az AWS által közösen létrehozott innovatív kialakítás szilárd alapot biztosít az Amazon SageMaker más AWS által felügyelt szolgáltatásokkal való használatához, hogy komplex multimodális mesterségesintelligencia-együtteseket fogadhassunk, és hatékonyan és zökkenőmentesen hangoljanak össze következtetési folyamatokat. Az Amazon SageMaker beépített funkcióinak, például az Asynchronous Inference-nek a kihasználásával a CCC-nek több lehetősége nyílik arra, hogy speciális, üzleti szempontból kritikus feladatokra összpontosítson. A CCC kutatás-vezérelt kultúrájának szellemében ez az újszerű architektúra tovább fog fejlődni, miközben a CCC az AWS mellett az előremutató utat járja be abban, hogy hatékony új AI-megoldásokat szabadítson fel az ügyfelek számára.

Az aszinkron következtetési végpontok létrehozásának, meghívásának és figyelésének részletes lépéseiért tekintse meg a dokumentáció, amely szintén tartalmazza a mintafüzet hogy segítsen az indulásban. Az árakkal kapcsolatos információkért látogasson el ide Amazon SageMaker árképzés.

Példák az aszinkron következtetés használatára strukturálatlan adatokkal, mint például a számítógépes látás és a természetes nyelvi feldolgozás (NLP), lásd: Futtasson számítógépes képi következtetést nagyméretű videókon az Amazon SageMaker aszinkron végpontjaival és a Javítsa a nagy értékű kutatást a Hugging Face és az Amazon SageMaker aszinkron következtetési végpontjaival, Ill.

A szerzőkről

Christopher Diaz a CCC Intelligent Solutions vezető kutatás-fejlesztési mérnöke. A K+F csapat tagjaként számos projekten dolgozott, kezdve az ETL-eszközökkel, a háttér webfejlesztésen, a kutatókkal való együttműködésen át az AI-modellek elosztott rendszereken való betanításához, valamint az új AI-szolgáltatások kutatási és üzemeltetési csapatok közötti szállításának megkönnyítéséig. A közelmúltban a felhőszerszám-megoldások kutatására összpontosított, hogy javítsa a vállalat mesterséges intelligenciamodell-fejlesztési életciklusának különböző aspektusait. Szabadidejében szívesen kipróbál új éttermeket szülővárosában, Chicagóban, és annyi LEGO készletet gyűjt össze, amennyi otthonában elfér. Christopher a Northeastern Illinois Egyetemen szerzett számítástechnikai alapképzést.

Christopher Diaz a CCC Intelligent Solutions vezető kutatás-fejlesztési mérnöke. A K+F csapat tagjaként számos projekten dolgozott, kezdve az ETL-eszközökkel, a háttér webfejlesztésen, a kutatókkal való együttműködésen át az AI-modellek elosztott rendszereken való betanításához, valamint az új AI-szolgáltatások kutatási és üzemeltetési csapatok közötti szállításának megkönnyítéséig. A közelmúltban a felhőszerszám-megoldások kutatására összpontosított, hogy javítsa a vállalat mesterséges intelligenciamodell-fejlesztési életciklusának különböző aspektusait. Szabadidejében szívesen kipróbál új éttermeket szülővárosában, Chicagóban, és annyi LEGO készletet gyűjt össze, amennyi otthonában elfér. Christopher a Northeastern Illinois Egyetemen szerzett számítástechnikai alapképzést.

Emmy-díjas Sam Kinard a CCC Intelligent Solutions szoftvermérnöki részlegének vezető menedzsere. A texasi Austinban található, és az AI Runtime Team-tel veszekszik, amely a CCC mesterséges intelligencia-termékeinek magas rendelkezésre állású és nagy léptékű kiszolgálásáért felelős. Szabadidejében Sam élvezi, hogy két csodálatos gyermeke miatt alváshiányban szenved. Sam az austini Texasi Egyetemen szerzett alapképzést számítástechnikából és matematikából.

Emmy-díjas Sam Kinard a CCC Intelligent Solutions szoftvermérnöki részlegének vezető menedzsere. A texasi Austinban található, és az AI Runtime Team-tel veszekszik, amely a CCC mesterséges intelligencia-termékeinek magas rendelkezésre állású és nagy léptékű kiszolgálásáért felelős. Szabadidejében Sam élvezi, hogy két csodálatos gyermeke miatt alváshiányban szenved. Sam az austini Texasi Egyetemen szerzett alapképzést számítástechnikából és matematikából.

Jaime Hidalgo a CCC Intelligent Solutions vezető rendszermérnöke. Mielőtt csatlakozott volna az AI-kutatócsoporthoz, ő vezette a vállalat globális átállását a Microservices Architecture felé, az AWS infrastruktúrájának tervezését, építését és automatizálását a felhőtermékek és -szolgáltatások telepítésének támogatása érdekében. Jelenleg egy helyszíni adatközpont-fürtöt épít és támogat, amelyet mesterséges intelligencia képzéshez építettek, valamint felhőmegoldásokat tervez és épít a vállalat jövőbeli mesterségesintelligencia-kutatására és -telepítésére.

Jaime Hidalgo a CCC Intelligent Solutions vezető rendszermérnöke. Mielőtt csatlakozott volna az AI-kutatócsoporthoz, ő vezette a vállalat globális átállását a Microservices Architecture felé, az AWS infrastruktúrájának tervezését, építését és automatizálását a felhőtermékek és -szolgáltatások telepítésének támogatása érdekében. Jelenleg egy helyszíni adatközpont-fürtöt épít és támogat, amelyet mesterséges intelligencia képzéshez építettek, valamint felhőmegoldásokat tervez és épít a vállalat jövőbeli mesterségesintelligencia-kutatására és -telepítésére.

Daniel Suarez a CCC Intelligent Solutions adattudományi mérnöke. Az AI Engineering csapat tagjaként a mesterséges intelligencia modellek automatizálásán és előkészítésén dolgozik a mérőszámok és az ML műveletek egyéb vonatkozásai gyártásában, értékelésében és monitorozásában. Daniel az Illinois Institute of Technology-n kapott számítástechnikai mesterfokozatot, az Universidad Politecnica de Madridtól pedig távközlési mérnöki mester- és alapdiplomát.

Daniel Suarez a CCC Intelligent Solutions adattudományi mérnöke. Az AI Engineering csapat tagjaként a mesterséges intelligencia modellek automatizálásán és előkészítésén dolgozik a mérőszámok és az ML műveletek egyéb vonatkozásai gyártásában, értékelésében és monitorozásában. Daniel az Illinois Institute of Technology-n kapott számítástechnikai mesterfokozatot, az Universidad Politecnica de Madridtól pedig távközlési mérnöki mester- és alapdiplomát.

Arunprasath Shankar az AWS vezető AI/ML specialista megoldások építésze, aki segít a globális ügyfeleknek mesterséges intelligencia-megoldásaik hatékony és eredményes méretezésében a felhőben. Szabadidejében Arun szívesen néz sci-fi filmeket és hallgat klasszikus zenét.

Arunprasath Shankar az AWS vezető AI/ML specialista megoldások építésze, aki segít a globális ügyfeleknek mesterséges intelligencia-megoldásaik hatékony és eredményes méretezésében a felhőben. Szabadidejében Arun szívesen néz sci-fi filmeket és hallgat klasszikus zenét.

Justin McWhirter az AWS Solutions Architect menedzsere. Csodálatos Solutions Architects csapattal dolgozik, akik segítik az ügyfeleket abban, hogy pozitív tapasztalatokat szerezzenek az AWS platform alkalmazása során. Amikor nem dolgozik, Justin szeret videojátékokat játszani a két fiával, jégkorongozni, és terepjáró dzsipjével.

Justin McWhirter az AWS Solutions Architect menedzsere. Csodálatos Solutions Architects csapattal dolgozik, akik segítik az ügyfeleket abban, hogy pozitív tapasztalatokat szerezzenek az AWS platform alkalmazása során. Amikor nem dolgozik, Justin szeret videojátékokat játszani a két fiával, jégkorongozni, és terepjáró dzsipjével.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- Platoblockchain. Web3 metaverzum intelligencia. Felerősített tudás. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/how-ccc-intelligent-solutions-created-a-custom-approach-for-hosting-complex-ai-models-using-amazon-sagemaker/

- 000

- 1

- 100

- 7

- a

- Képes

- Rólunk

- felett

- Akció

- aktív

- aciklikus

- hozzáadott

- További

- Ezen kívül

- Elfogadása

- fejlesztések

- AI

- AI Engineering

- ai kutatás

- AI szolgáltatások

- AI képzés

- AI / ML

- algoritmusok

- Minden termék

- mellett

- alternatív

- elképesztő

- amazon

- Amazon SageMaker

- és a

- Évente

- Másik

- api

- megközelítés

- megközelít

- megfelelő

- építészet

- mesterséges

- mesterséges intelligencia

- Mesterséges intelligencia (AI)

- szempontok

- kijelölt

- társult

- szerzők

- autógyártók

- Automatikus

- automatikusan

- automatizálás

- Automatizálás

- elérhetőség

- elérhető

- átlagos

- díj

- AWS

- AWS lépésfunkciók

- háttér

- Egyenleg

- alapján

- kiindulási

- mert

- válik

- előtt

- hogy

- lent

- benchmarking

- haszon

- Előnyök

- között

- Blokk

- Blocks

- Blog

- Doboz

- hoz

- brókerek

- épít

- Épület

- épít

- épült

- üzleti

- vállalkozások

- hívás

- hívott

- Hívó

- kéri

- képes

- eset

- esetek

- katalógus

- ccc

- Központ

- kihívás

- ellenőrizze

- Chicago

- Gyerekek

- választás

- Christopher

- követelések

- osztály

- vásárló

- ügyfél részére

- felhő

- FELHŐTECHNOLÓGIA

- Fürt

- kód

- együttműködő

- Gyűjtő

- gyűjtemény

- kombináció

- kombinációk

- kombinált

- Kereskedelem

- közlés

- vállalat

- Társaságé

- verseny

- Befejezi

- bonyolult

- összetevő

- alkatrészek

- áll

- Kiszámít

- számítógép

- Computer Science

- Számítógépes látás

- egyidejű

- összeköt

- konstrukció

- tartalmaz

- tartalom

- kontextus

- folytatódik

- tovább

- folyamatos

- Mag

- Megfelelő

- Költség

- kiadások

- tudott

- összekapcsolt

- teremt

- készítette

- kultúra

- Jelenleg

- szokás

- vevő

- Vásárlói élmény

- Ügyfelek

- ciklusok

- DAG

- Daniel

- dátum

- Adatközpont

- adat-tudomány

- adatbázis

- határozott

- mély

- mély merülést

- alapértelmezett

- szállít

- kézbesítés

- Függőség

- attól

- függ

- telepíteni

- telepített

- bevetés

- bevetések

- leírt

- Design

- tervezett

- tervezés

- tervek

- részletes

- részletek

- eltökélt

- Fejlesztés

- különböző

- digitalizálás

- közvetlenül

- felfedez

- megvitatni

- megosztott

- elosztott rendszerek

- domain

- letöltés

- vezetés

- alatt

- minden

- szerzett

- könnyebb

- gazdaság

- hatékonyan

- eredményesen

- erőfeszítések

- bármelyik

- lehetővé teszi

- Endpoint

- mérnök

- Mérnöki

- belép

- Egész

- belépés

- környezetek

- Egyenértékű

- különösen

- stb.

- értékelés

- Még

- esemény

- fejlődik

- példák

- végrehajtás

- létező

- Kilépés

- tapasztalat

- Tapasztalatok

- szakvélemény

- magyarázható

- terjed

- Arc

- szembe

- megkönnyítése

- megkönnyítését

- Kudarc

- Divat

- gyorsabb

- Funkció

- Jellemzők

- Ábra

- Fájlok

- utolsó

- véglegesített

- megtalálása

- megfelelő

- Rugalmasság

- áramlási

- Összpontosít

- következő

- következik

- Előre

- Alapítvány

- ból ből

- funkció

- funkciós

- funkcionalitás

- funkciók

- jövő

- Games

- gateway

- generál

- generált

- kap

- Globális

- grafikonok

- nagymértékben

- Csoport

- Garantált

- fogantyú

- tekintettel

- segít

- segít

- Magas

- magas szinten

- <p></p>

- Kezdőlap

- vendéglátó

- házigazdája

- tárhely

- Hogyan

- How To

- HTML

- HTTPS

- ICE

- Illinois

- kép

- képek

- azonnali

- végre

- végrehajtás

- végre

- in

- Más

- tartalmaz

- beleértve

- magában foglalja a

- Növelje

- <p></p>

- növekvő

- független

- egyéni

- információ

- Infrastruktúra

- kezdetben

- Kezdeményezés

- újítások

- újító

- bemenet

- példa

- Intézet

- biztosítás

- integrálni

- Intelligencia

- Intelligens

- Felület

- Internet

- internet a dolgok

- tárgyak internete

- IT

- csatlakozott

- json

- Justin

- Tart

- tartás

- nyelv

- nagy

- nagyobb

- keresztnév

- Késleltetés

- indított

- tojók

- vezet

- vezető

- Vezetés

- vezető

- vezetékek

- TANUL

- tanulás

- Led

- hitelezők

- szint

- erőfölény

- korlátozások

- Lista

- Kihallgatás

- életek

- elhelyezkedés

- gép

- gépi tanulás

- készült

- Fő

- Többség

- csinál

- KÉSZÍT

- kezelése

- sikerült

- vezetés

- menedzser

- kezeli

- kezelése

- sok

- térképészet

- piacára

- mester

- matematika

- Anyag

- számít

- intézkedések

- Találkozik

- tag

- említett

- üzenet

- módszer

- Metrics

- microservices

- elvándorlás

- minimális

- ML

- Mód

- modell

- modellek

- monitor

- ellenőrzés

- több

- a legtöbb

- mozog

- Filmek

- mozgó

- többszörös

- zene

- név

- Természetes

- Természetes nyelvi feldolgozás

- elengedhetetlen

- Szükség

- igények

- hálózat

- Új

- új termék

- következő

- NLP

- bejelentés

- értesítések

- regény

- kapott

- megszerzése

- ajánlat

- Ajánlat

- ONE

- Művelet

- Lehetőségek

- opció

- hangszerelés

- Más

- átfogó

- áttekintés

- saját

- Párhuzamos

- paraméterek

- rész

- Elmúlt

- Mintás

- emberek

- százalék

- tökéletes

- Teljesít

- teljesítmény

- csővezeték

- döntő

- emelvény

- Plató

- Platón adatintelligencia

- PlatoData

- játék

- PoC

- pont

- Politikák

- pozitív

- állás

- potenciális

- erős

- Bekapcsolom

- gyakorlat

- előrejelzés

- Tippek

- Készít

- előző

- korábban

- ár

- árazás

- prioritás

- folyamat

- Feldolgozott

- Folyamatok

- feldolgozás

- gyárt

- Termékek

- Termelés

- Termékek

- projektek

- biztató

- ingatlan

- szabadalmazott

- ad

- szolgáltatók

- biztosít

- amely

- ellátás

- K + F

- kezdve

- Arány

- kész

- realizált

- kap

- kapott

- kap

- új

- rekord

- csökkenteni

- összefüggő

- megbízhatóság

- eltávolítása

- megismételt

- helyébe

- többszörözött

- kérni

- kéri

- kötelező

- követelmények

- megköveteli,

- kutatás

- kutatók

- Felbontás

- Tudástár

- válasz

- felelős

- Éttermek

- Eredmények

- visszatérés

- visszatérő

- mutatják

- Kritika

- Kockázat

- Útvonal

- szabályok

- futás

- futás

- SaaS

- sagemaker

- Sam

- azonos

- Megtakarítás

- megtakarítás

- Skála

- skálázás

- forgatókönyvek

- sci-fi

- Tudomány

- zökkenőmentesen

- Rész

- biztosan

- elküldés

- idősebb

- sorozatszám

- vagy szerver

- szolgálja

- szolgáltatás

- Szolgáltatások

- szolgáló

- Szettek

- kellene

- mutatott

- hasonló

- egyszerűsítése

- óta

- egyetlen

- Méret

- alvás

- So

- szoftver

- szoftverfejlesztés

- szilárd

- megoldások

- Megoldások

- Megoldása

- kifinomult

- szakember

- specializált

- különleges

- kifejezetten

- meghatározott

- szellem

- Stabilitás

- egymásra rakva

- Színpad

- kezdődött

- Állami

- Állapot

- Lépés

- Lépései

- memorizált

- árnyékolók

- erő

- erős

- tárgy

- ilyen

- hirtelen

- ÖSSZEFOGLALÓ

- szállítók

- támogatás

- Támogatott

- Támogatja

- szintaxis

- rendszer

- Systems

- Feladat

- feladatok

- csapat

- csapat

- technikai

- Technologies

- Technológia

- távközlés

- teszt

- Tesztelés

- Texas

- A

- az információ

- Az állam

- azok

- dolgok

- alaposan

- küszöb

- Keresztül

- egész

- áteresztőképesség

- idő

- alkalommal

- nak nek

- együtt

- jelképes

- szerszámok

- téma

- felé

- forgalom

- Vonat

- Képzések

- Tranzakciók

- kiváltó

- váltott

- Trillió

- Megbízható

- típusok

- egyedi

- egyetemi

- közelgő

- Frissítések

- feltöltve

- üzemidő

- URL

- us

- használ

- használati eset

- használó

- felhasználói felület

- érték

- Értékek

- fajta

- különféle

- keresztül

- videó

- videojátékok

- Videók

- látomás

- őrzés

- módon

- háló

- webfejlesztés

- Mit

- vajon

- ami

- míg

- WHO

- lesz

- belül

- nélkül

- csodálatos

- szavak

- Munka

- együtt dolgozni

- dolgozott

- munkafolyamatok

- dolgozó

- művek

- lenne

- év

- te

- zephyrnet

- nulla