Bevezetés

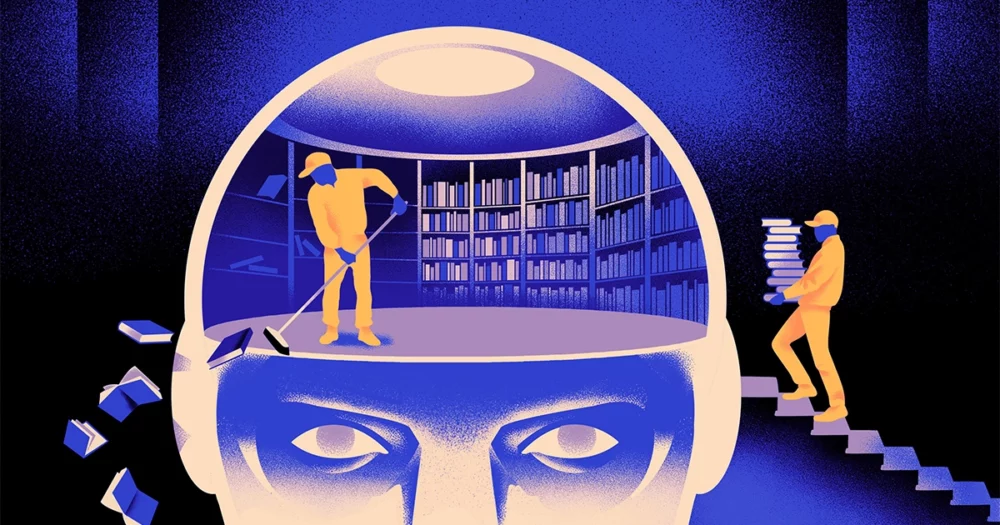

Egy informatikusokból álló csapat létrehozta a fürgébb, rugalmasabb típus gépi tanulási modell. A trükk: Időnként el kell felejtenie, amit tud. És bár ez az új megközelítés nem fogja kiszorítani a legnagyobb alkalmazásokat alátámasztó hatalmas modelleket, többet elárulhat arról, hogy ezek a programok hogyan értik a nyelvet.

Az új kutatás „jelentős előrelépést jelent a területen” – mondta Jea Kwon, mesterséges intelligencia mérnök a dél-koreai Alaptudományi Intézetben.

A manapság használt mesterséges intelligencia nyelvi motorokat többnyire az üzemelteti mesterséges idegi hálózat. A hálózat minden egyes „neuronja” egy matematikai függvény, amely jeleket fogad más ilyen neuronoktól, bizonyos számításokat végez, és jeleket küld tovább a neuronok több rétegén keresztül. Kezdetben az információáramlás többé-kevésbé véletlenszerű, de a betanítás révén az idegsejtek közötti információáramlás javul, ahogy a hálózat alkalmazkodik a betanítási adatokhoz. Ha egy mesterséges intelligenciakutató például kétnyelvű modellt szeretne létrehozni, akkor a modellt egy nagy halom szöveggel képezné ki mindkét nyelvből, ami a neuronok közötti kapcsolatokat úgy állítja be, hogy az egy nyelvű szöveget a megfelelővel kapcsolja össze. szavak a másikban.

De ez a képzési folyamat sok számítási teljesítményt igényel. Ha a modell nem működik túl jól, vagy a későbbiekben megváltoznak a felhasználó igényei, akkor nehéz adaptálni. „Tegyük fel, hogy van egy modellje, amely 100 nyelvet tartalmaz, de képzelje el, hogy az egyik kívánt nyelvet nem fedi le” – mondta. Mikel Artetxe, az új kutatás társszerzője és a Reka AI startup alapítója. "Elölről kezdheted, de nem ideális."

Artetxe és kollégái megpróbálták megkerülni ezeket a korlátokat. Néhány évvel ezelőtt, Artetxe és mások egy neurális hálózatot képeztek ki egy nyelven, majd törölték azt, amit a szavak építőköveiről, az úgynevezett tokenekről tudott. Ezeket a neurális hálózat első rétegében, az úgynevezett beágyazó rétegben tárolják. Magára hagyták a modell összes többi rétegét. Az első nyelv tokenek törlése után a modellt áttanították a második nyelvre, amely a beágyazási réteget az adott nyelvből származó új tokenekkel töltötte meg.

Annak ellenére, hogy a modell nem egyező információkat tartalmazott, az átképzés működött: a modell képes volt megtanulni és feldolgozni az új nyelvet. A kutatók azt feltételezték, hogy míg a beágyazó réteg a nyelvben használt szavakra jellemző információkat tárolt, addig a hálózat mélyebb szintjei több elvont információt tároltak az emberi nyelvek mögött meghúzódó fogalmakról, ami aztán segített a modellnek megtanulni a második nyelvet.

„Ugyanabban a világban élünk. Ugyanazokat a dolgokat különböző szavakkal képzeljük el” különböző nyelveken – mondta Yihong Chen, a legutóbbi cikk vezető szerzője. „Ez az oka annak, hogy ugyanaz a magas szintű érvelés van a modellben. Az alma valami édes és lédús, nem csak egy szó.

Bevezetés

Noha ez a felejtős megközelítés hatékony módja volt egy új nyelv hozzáadásának egy már betanított modellhez, az átképzés továbbra is igényes volt – sok nyelvi adatot és feldolgozási teljesítményt igényelt. Chen egy módosítást javasolt: A képzés, a beágyazási réteg törlése, majd az újraképzés helyett rendszeresen vissza kell állítania a beágyazási réteget a képzés kezdeti körében. "Ezzel az egész modell hozzászokik a visszaállításhoz" - mondta Artetxe. „Ez azt jelenti, hogy ha ki akarja terjeszteni a modellt egy másik nyelvre, akkor könnyebb, mert ezt csinálja.”

A kutatók egy általánosan használt nyelvi modellt vettek fel, az úgynevezett Roberta, periodikus felejtési technikájukkal betanították, és összehasonlították ugyanazon modell teljesítményével, amikor a szokásos, nem felejtő megközelítéssel képezték. A felejtős modell valamivel rosszabbul teljesített, mint a hagyományos, 85.1 pontot kapott a 86.1-hez képest a nyelvi pontosság egyik általános mérőszáma alapján. Aztán átképeztek a modelleket más nyelvekre, sokkal kisebb, mindössze 5 milliós tokenből álló adatkészleteket használva az első képzés során használt 70 milliárd helyett. A standard modell pontossága átlagosan 53.3-ra csökkent, a felejtő modellé viszont csak 62.7-re.

A felejtő modell is sokkal jobban járt, ha a csapat számítási korlátokat szabott az átképzés során. Amikor a kutatók 125,000 5,000 lépésről mindössze 57.8-re csökkentették a képzési hosszt, a felejtési modell pontossága átlagosan 37.2-ra, míg a standard modell XNUMX-re esett, ami semmivel sem jobb, mint a véletlenszerű találgatások.

Bevezetés

A csapat arra a következtetésre jutott, hogy az időszakos felejtés jobbá teszi a modellt általában a nyelvtanulásban. "Mivel [ők] folyamatosan elfelejtenek és újratanulnak a képzés során, később könnyebb lesz valami újat tanítani a hálózatnak" - mondta. Jevgenyij Nikisin, a Mila kutatója, egy quebeci mély tanulási kutatóközpont. Azt sugallja, hogy amikor a nyelvi modellek megértenek egy nyelvet, azt mélyebb szinten teszik, mint az egyes szavak jelentése.

A megközelítés hasonló a saját agyunk működéséhez. „Az emberi memória általában nem túl jó a nagy mennyiségű részletes információ pontos tárolására. Ehelyett az emberek hajlamosak emlékezni a tapasztalataink lényegére, elvonatkoztatni és extrapolálni” – mondta Benjamin Levy, a San Francisco-i Egyetem idegkutatója. „A mesterséges intelligencia emberszerűbb folyamatokkal, például az adaptív felejtéssel történő engedélyezése az egyik módja annak, hogy rugalmasabb teljesítményt érjenek el.”

Amellett, hogy mit mondana a megértés működéséről, az Artetxe reméli, hogy a rugalmasabb elfelejtő nyelvi modellek segíthetnek abban, hogy a legújabb mesterséges intelligencia áttörést több nyelven is elhozzák. Bár a mesterséges intelligencia modelljei jól kezelik a spanyolt és az angolt, két nyelvet és bőséges oktatási anyagokat, a modellek nem olyan jók anyanyelvén, a baszk nyelven, amely Északkelet-Spanyolországra jellemző helyi nyelv. „A nagy technológiai cégek legtöbb modellje nem csinálja jól” – mondta. „A meglévő modellek baszk nyelvre igazítása a helyes út.”

Chen egy olyan világ elé néz, ahol több mesterséges intelligencia virág virágzik. „Olyan helyzetre gondolok, amikor a világnak nincs szüksége egyetlen nagy nyelvi modellre. Olyan sokan vannak” – mondta. „Ha egy gyárban nyelvi modelleket gyártanak, akkor ilyen technológiára van szükség. Egyetlen alapmodellje van, amely gyorsan alkalmazkodik az új tartományokhoz.”

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :van

- :is

- :nem

- :ahol

- ][p

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Rólunk

- KIVONAT

- pontosság

- pontosan

- alkalmazkodni

- adaptív

- alkalmazkodik

- hozzá

- mellett

- előre

- Után

- AI

- AI modellek

- Minden termék

- kizárólag

- már

- Is

- Összegek

- an

- és a

- Másik

- Apple

- megközelítés

- alkalmazások

- VANNAK

- AS

- At

- szerző

- átlagos

- bázis

- alapvető

- mert

- válik

- óta

- mögött

- Jobb

- között

- Nagy

- nagy tech

- Legnagyobb

- Billió

- Blocks

- Virágzik

- mindkét

- áttörések

- hoz

- Épület

- de

- by

- számítások

- hívott

- TUD

- Központ

- változik

- chen

- megkerülése

- Társszerző

- munkatársai

- Közös

- általában

- Companies

- képest

- számítási

- számítógép

- számítástechnika

- számítási teljesítmény

- fogalmak

- megkötött

- kapcsolatok

- tartalmazott

- hagyományos

- tudott

- fedett

- teremt

- készítette

- vágás

- dátum

- adatkészletek

- csökkent

- mély

- mély tanulás

- mélyebb

- igényes

- részletes

- DID

- különböző

- do

- Nem

- Ennek

- domainek

- ne

- csökkent

- alatt

- minden

- könnyebb

- Hatékony

- beágyazás

- mérnök

- Motorok

- Angol

- Egész

- Egyenértékű

- példa

- létező

- Tapasztalatok

- terjed

- gyár

- kevés

- mező

- megtöltött

- vezetéknév

- rugalmas

- áramlási

- A

- Előre

- alapító

- Francisco

- ból ből

- funkció

- általános

- általában

- kap

- GitHub

- Go

- jó

- Kezelés

- Kemény

- Legyen

- he

- segít

- segített

- magas szinten

- övé

- reméli,

- Hogyan

- HTTPS

- hatalmas

- emberi

- emberféle

- Az emberek

- ideális

- if

- kép

- kiszabott

- javítja

- in

- egyéni

- információ

- kezdetben

- alapvetően

- helyette

- Intézet

- IT

- éppen

- Tart

- Kedves

- tudja

- korea

- nyelv

- Nyelvek

- nagy

- a későbbiekben

- legutolsó

- réteg

- tojók

- vezet

- TANUL

- tanulás

- balra

- Hossz

- kevesebb

- szint

- szintek

- mint

- korlátozások

- határértékek

- él

- helyi

- MEGJELENÉS

- Sok

- gép

- gépi tanulás

- magazin

- csinál

- Gyártás

- sok

- anyagok

- matematikai

- jelentése

- eszközök

- intézkedés

- Memory design

- esetleg

- millió

- modell

- modellek

- több

- többnyire

- sok

- többszörös

- kell

- bennszülött

- Szükség

- igények

- hálózat

- ideg-

- neurális hálózat

- neuronok

- Új

- nem

- of

- on

- ONE

- csak

- or

- Más

- Egyéb

- mi

- felett

- saját

- Papír

- teljesítmény

- időszakos

- Plató

- Platón adatintelligencia

- PlatoData

- zuhant

- hatalom

- powered

- folyamat

- Folyamatok

- feldolgozás

- Feldolgozási teljesítmény

- Programok

- Quantamagazine

- Quebec

- gyorsan

- véletlen

- Inkább

- kap

- fogadó

- új

- eszébe jut

- kötelező

- kutatás

- kutató

- kutatók

- mutatják

- körül

- fut

- Mondott

- azonos

- San

- San Francisco

- azt mondják

- Tudomány

- tudósok

- pontszám

- kaparni

- Második

- Úgy tűnik,

- szelektív

- küld

- Szettek

- ő

- kellene

- jelek

- jelentős

- hasonló

- helyzet

- kisebb

- So

- néhány

- valami

- Dél

- Dél-Korea

- Spanyolország

- spanyol

- különleges

- standard

- kezdet

- indítás

- Lépései

- Még mindig

- memorizált

- tárolása

- ilyen

- javasolja,

- édes

- tart

- Tanítási

- csapat

- tech

- tech cégek

- technika

- Technológia

- Inkább

- szöveg

- mint

- hogy

- A

- az információ

- a világ

- azok

- Őket

- akkor

- Ezek

- ők

- dolgok

- Gondolkodás

- ezt

- bár?

- Keresztül

- nak nek

- Ma

- tokenek

- vett

- Vonat

- kiképzett

- Képzések

- trükk

- kipróbált

- csípés

- kettő

- megért

- megértés

- egyetemi

- használ

- használt

- segítségével

- nagyon

- akar

- akar

- volt

- Út..

- we

- webp

- JÓL

- Mit

- amikor

- ami

- míg

- miért

- val vel

- szó

- szavak

- Munka

- dolgozott

- művek

- világ

- rosszabb

- lenne

- év

- te

- zephyrnet