Bevezetés

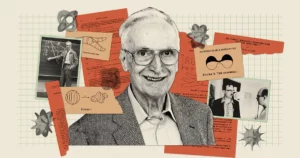

A mesterséges intelligencia erősebbnek tűnik, mint valaha, az olyan chatbotokkal, mint a Bard és a ChatGPT, amelyek hihetetlenül emberi szövegek előállítására képesek. De minden tehetségük ellenére ezek a botok továbbra is elgondolkodtatják a kutatókat: csináljanak ilyen modelleket igazából megérteni mit mondanak? „Egyértelmű, hogy egyesek azt hiszik, hogy igen” – mondta a mesterséges intelligencia úttörője Geoff Hinton egy legutóbbi beszélgetés Andrew Ng-vel: „És egyesek azt hiszik, hogy csak sztochasztikus papagájok.”

Ez a hangulatos kifejezés egy 2021-ből származik papír társszerzője Emily Bender, a Washingtoni Egyetem számítógépes nyelvésze. Azt sugallja, hogy a nagy nyelvi modellek (LLM-ek) – amelyek a modern chatbotok alapját képezik – csak a már látott információk kombinálásával generálnak szöveget, „a jelentésre való utalás nélkül” – írták a szerzők, ami az LLM-et „sztochasztikus papagájvá teszi”.

Ezek a modellek napjaink legnagyobb és legjobb csevegőrobotjai közül sokat működnek, ezért Hinton azzal érvelt, hogy ideje meghatározni, hogy mit értenek. A kérdés számára több, mint tudományos. „Amíg megvannak ezek a véleménykülönbségek”, mondta Ng-nek, „nem fogunk tudni konszenzusra jutni a veszélyekről”.

Az új kutatások talán sejtetik a választ. által kidolgozott elmélet Sanjeev Arora a Princeton Egyetem és Anirudh Goyal, a Google DeepMind kutatója azt sugallja, hogy a mai LLM-ek közül a legnagyobbak nem sztochasztikus papagájok. A szerzők azzal érvelnek, hogy amint ezek a modellek egyre nagyobbak, és egyre több adatra képezik őket, javulnak az egyéni nyelvi képességeiken, és újakat is fejlesztenek azáltal, hogy a készségeket a megértésre utaló módon kombinálják – olyan kombinációk, amelyek valószínűleg nem léteznek a képzési adatokban. .

Ez az elméleti megközelítés, amely matematikailag bizonyítható érvet szolgáltat arra vonatkozóan, hogyan és miért képes egy LLM olyan sok képességet kifejleszteni, meggyőzte az olyan szakértőket, mint Hinton és mások. És amikor Arora és csapata tesztelte néhány előrejelzését, azt találták, hogy ezek a modellek szinte pontosan a várt módon viselkednek. Mindent összevetve, határozottan alátámasztották, hogy a legnagyobb LLM-ek nem csak azt mondják, amit korábban láttak.

"[Ezek] nem csak utánozhatják azt, amit az edzési adatokban láttak" - mondta Sébastien Bubeck, a Microsoft Research matematikusa és informatikusa, aki nem vett részt a munkában. – Ez az alapvető meglátás.

Több adat, több teljesítmény

A megjelenése váratlan és változatos képességek az LLM-ekben, mondhatni, meglepetésként ért. Ezek a képességek nem nyilvánvaló következményei a rendszerek felépítésének és képzésének. Az LLM egy hatalmas mesterséges neurális hálózat, amely egyes mesterséges neuronokat köt össze. Ezeket a kapcsolatokat a modell paramétereinek nevezzük, és számuk az LLM méretét jelöli. A képzés abból áll, hogy az LLM-nek egy mondatot adunk, amelynek utolsó szója el van takarva, például: „Az üzemanyag egy karba és egy ___-ba kerül.” Az LLM valószínűségi eloszlást jósol a teljes szókincsére, tehát ha mondjuk ezer szót tud, akkor ezer valószínűséget jósol. Ezután kiválasztja a legvalószínűbb szót a mondat befejezéséhez – feltehetően a „láb”.

Kezdetben az LLM rosszul választott szavakat. A betanító algoritmus ezután kiszámít egy veszteséget – az LLM válasza és az eredeti mondat tényleges szava közötti távolságot valamilyen nagydimenziós matematikai térben –, és ezt a veszteséget használja a paraméterek módosítására. Ugyanezt a mondatot figyelembe véve az LLM jobb valószínűségi eloszlást fog kiszámítani, és a vesztesége valamivel alacsonyabb lesz. Az algoritmus ezt a betanítási adatok minden mondatára (esetleg több milliárd mondatra) teszi, amíg az LLM teljes vesztesége elfogadható szintre nem csökken. Hasonló eljárást használnak az LLM tesztelésére olyan mondatokon, amelyek nem szerepeltek a betanítási adatokban.

Egy képzett és tesztelt LLM, ha új szöveges promptot kap, generálja a legvalószínűbb következő szót, hozzáfűzi a prompthoz, generál egy másik következő szót, és így folytatja, látszólag koherens választ adva. A betanítási folyamatban semmi sem utal arra, hogy a nagyobb, több paraméterrel és betanítási adattal felépített LLM-eknek is javítaniuk kellene azokon a feladatokon, amelyek megválaszolása indokolást igényel.

De igen. A kellően nagy LLM-ek olyan képességeket mutatnak be – az elemi matematikai feladatok megoldásától a mások fejében zajló eseményekre vonatkozó kérdések megválaszolásáig –, amelyekkel a kisebb modellek nem rendelkeznek, noha mindegyiket hasonló módon képezték ki.

– Honnan jött ez a [képesség]? – tűnődött Arora. – És ez kiderülhet a következő szó előrejelzéséből?

A készségek összekapcsolása a szöveggel

Arora összefogott Goyallal, hogy analitikusan válaszoljon az ilyen kérdésekre. „Megpróbáltunk egy elméleti keretet kidolgozni, hogy megértsük, hogyan történik a megjelenés” – mondta Arora.

A duó a véletlen gráfoknak nevezett matematikai objektumok felé fordult. A gráf pontok (vagy csomópontok) gyűjteménye, amelyeket vonalak (vagy élek) kötnek össze, és egy véletlenszerű gráfban bármely két csomópont közötti él jelenléte véletlenszerűen – mondjuk egy érmefeldobással – diktálható. Az érme elfogult lehet, így bizonyos valószínűséggel felbukkan p. Ha az érme egy adott csomópontpárhoz ér, egy él képződik a két csomópont között; különben kapcsolat nélkül maradnak. Mivel az értéke p változásokat, a grafikonok tulajdonságaikban hirtelen átmeneteket mutathatnak. Például, mikor p túllép egy bizonyos küszöbértéket, az elszigetelt csomópontok – azok, amelyek nem kapcsolódnak egyetlen másik csomóponthoz sem – hirtelen eltűnnek.

Arora és Goyal rájött, hogy a véletlenszerű grafikonok, amelyek bizonyos küszöbértékek elérése után váratlan viselkedést váltanak ki, alkalmasak lehetnek az LLM-ek viselkedésének modellezésére. A neurális hálózatok szinte túl bonyolultak az elemzéshez, de a matematikusok régóta tanulmányozzák a véletlenszerű gráfokat, és különféle eszközöket fejlesztettek ki elemzésükre. Talán a véletlen gráfelmélet módot adna a kutatóknak arra, hogy megértsék és előre jelezzék a nagy LLM-ek látszólag váratlan viselkedését.

A kutatók úgy döntöttek, hogy a „kétoldalú” gráfokra összpontosítanak, amelyek kétféle csomópontot tartalmaznak. Modelljükben a csomópontok egyik típusa szövegrészeket reprezentál – nem egyes szavakat, hanem darabokat, amelyek akár néhány oldal hosszúságú bekezdések is lehetnek. Ezek a csomópontok egyenes vonalban vannak elrendezve. Alattuk, egy másik sorban a másik csomópontkészlet található. Ezek az adott szövegrész értelmezéséhez szükséges készségeket képviselik. Mindegyik képesség szinte bármi lehet. Talán az egyik csomópont az LLM azon képességét képviseli, hogy megértse a „mert” szót, amely magában foglalja az okság fogalmát; egy másik azt jelképezheti, hogy képes két szám osztására; egy másik pedig az irónia felismerésének képességét képviselheti. „Ha megérted, hogy a szöveg ironikus, sok minden megfordul” – mondta Arora. "Ez a szavak előrejelzése szempontjából lényeges."

Az egyértelműség kedvéért, az LLM-eket nem a készségeket szem előtt tartva képezik vagy tesztelik; csak a következő szó előrejelzésének javítására készültek. De Arora és Goyal meg akarta érteni az LLM-eket azon képességek szemszögéből, amelyekre szükség lehet egyetlen szöveg megértéséhez. Egy készségcsomópont és egy szövegcsomópont, vagy több készségcsomópont és egy szövegcsomópont közötti kapcsolat azt jelenti, hogy az LLM-nek szüksége van ezekre a készségekre, hogy megértse az adott csomópontban található szöveget. Ezenkívül több szövegrész is származhat ugyanabból a készségből vagy készségkészletből; például az irónia megértésének képességét képviselő készségcsomópontok készlete csatlakozna a számos szöveges csomóponthoz, ahol az irónia előfordul.

A kihívás most az volt, hogy összekapcsoljuk ezeket a kétoldalú gráfokat a tényleges LLM-ekkel, és megnézzük, vajon a grafikonok elárulhatnak-e valamit az erőteljes képességek megjelenéséről. A kutatók azonban nem hagyatkozhattak semmilyen információra a tényleges LLM-ek képzéséről vagy teszteléséről – az olyan cégek, mint az OpenAI vagy a DeepMind, nem teszik közzé képzési vagy tesztadataikat. Ezenkívül Arora és Goyal meg akarta jósolni, hogyan fognak viselkedni az LLM-ek, amikor még nagyobbak lesznek, és nem állnak rendelkezésre ilyen információk a következő chatbotokról. Volt azonban egy kulcsfontosságú információ, amelyhez a kutatók hozzáférhettek.

2021 óta az LLM-ek és más neurális hálózatok teljesítményét tanulmányozó kutatók egy univerzális vonást tapasztaltak. Észrevették, hogy ahogy egy modell növekszik, akár méretben, akár a betanítási adatok mennyiségében, a tesztadatok vesztesége (az új szövegekre, betanítás utáni előrejelzett és helyes válaszok különbsége) nagyon specifikus módon csökken. Ezeket a megfigyeléseket neurális skálázási törvényeknek nevezett egyenletekben kódolták. Tehát Arora és Goyal úgy tervezte meg elméletét, hogy ne az egyéni LLM-től, chatbottól vagy képzési és tesztadatok halmazától származó adatoktól függjön, hanem az egyetemes törvénytől, amelyet ezektől a rendszerektől elvárnak: a skálázási törvények által megjósolt veszteségtől.

Úgy érveltek, hogy a javuló teljesítmény – a neurális skálázási törvények szerint – összefüggésbe hozható a jobb készségekkel. Ezeket a továbbfejlesztett készségeket pedig a kétoldalú gráfjaikban a készségcsomópontok szövegcsomópontokhoz való kapcsolásával lehet meghatározni. Ennek a kapcsolatnak a létrehozása – a neurális skálázási törvények és a bipartit gráfok között – volt a kulcs, amely lehetővé tette számukra a folytatást.

A készségek bővítése

A kutatók azzal kezdték, hogy feltételezték, hogy létezik egy hipotetikus kétrészes gráf, amely megfelel egy LLM tesztadatokon való viselkedésének. Az LLM tesztadatok veszteségében bekövetkezett változás magyarázatára elképzeltek egy módot a grafikon segítségével annak leírására, hogy az LLM hogyan szerez készségeket.

Vegyük például azt a képességet, hogy „érti az iróniát”. Ezt az ötletet egy készségcsomópont képviseli, így a kutatók azt vizsgálják, hogy ez a készségcsomópont mely szöveges csomópontokhoz kapcsolódik. Ha ezeknek a kapcsolódó szövegcsomópontoknak majdnem mindegyike sikeres – ami azt jelenti, hogy az LLM előrejelzései az ezen csomópontok által képviselt szövegre nagyon pontosak –, akkor az LLM kompetens ebben a speciális készségben. De ha a készségcsomópont kapcsolatainak több mint egy része hibás szöveges csomópontokhoz megy, akkor az LLM megbukik ezen a képességen.

A kétoldalú gráfok és az LLM-ek közötti kapcsolat lehetővé tette Arora és Goyal számára, hogy a véletlen gráfelmélet eszközeit használják az LLM viselkedésének proxy segítségével történő elemzésére. Ezen grafikonok tanulmányozása bizonyos kapcsolatokat tárt fel a csomópontok között. Ezek a kapcsolatok viszont logikus és tesztelhető módon magyarázzák, hogy a nagy modellek hogyan szerezték meg a váratlan képességeik eléréséhez szükséges készségeket.

Arora és Goyal először egy kulcsfontosságú viselkedést magyarázott el: miért válnak a nagyobb LLM-ek képzettebbé az egyéni képességek terén kisebb társaiknál. Az idegi skálázási törvények által megjósolt alacsonyabb tesztveszteséggel kezdték. A grafikonon ezt az alacsonyabb tesztveszteséget a sikertelen tesztcsomópontok hányadának csökkenése jelenti. Így összességében kevesebb a sikertelen tesztcsomópont. És ha kevesebb a sikertelen tesztcsomópont, akkor kevesebb a kapcsolat a sikertelen tesztcsomópontok és a készségcsomópontok között. Ezért több készségcsomópont kapcsolódik a sikeres tesztcsomópontokhoz, ami arra utal, hogy a modell készségei egyre nagyobbak. „A veszteség nagyon csekély csökkenése azt eredményezi, hogy a gép elsajátítja ezeket a készségeket” – mondta Goyal.

Ezután a pár megtalálta a módját, hogy megmagyarázza egy nagyobb modell váratlan képességeit. Ahogy az LLM mérete növekszik, és a tesztvesztesége csökken, a készségcsomópontok véletlenszerű kombinációi hoznak létre kapcsolatokat az egyes szövegcsomópontokhoz. Ez azt sugallja, hogy az LLM egyre jobban képes egyszerre több készség használatára, és több készség felhasználásával kezd el szöveget generálni – kombinálva például az irónia használatának képességét a „mert” szó megértésével – még akkor is, ha ezek a pontos kombinációk a készségek egyetlen szövegrészben sem szerepeltek a képzési adatokban.

Képzeljünk el például egy LLM-et, amely már használhat egy készséget szöveg generálására. Ha egy nagyságrenddel megnöveli az LLM paramétereinek vagy betanítási adatainak számát, hasonlóan kompetens lesz a két készségeket igénylő szöveg létrehozásában is. Ha még egy nagyságrenddel feljebb lépünk, az LLM immár négy képességet igénylő feladatokat is végre tud hajtani, ismét azonos szintű kompetenciával. A nagyobb LLM-eknek több módja van a készségek összeállítására, ami a képességek kombinatorikus robbanásához vezet.

És ahogy egy LLM-t felnagyítanak, egyre valószínűtlenebbé válik annak lehetősége, hogy a képzési adatokban találkozott a készségek összes ilyen kombinációjával. A véletlen gráfelmélet szabályai szerint minden kombináció a lehetséges képességek véletlenszerű mintavételéből adódik. Tehát, ha körülbelül 1,000 mögöttes egyéni készségcsomópont van a grafikonon, és négy készséget szeretne kombinálni, akkor körülbelül 1,000-től a negyedik hatványig – azaz 1 billióig – lehetséges kombinálni őket.

Arora és Goyal ezt annak bizonyítékaként látja, hogy a legnagyobb LLM-ek nem csupán a képzési adataikban látott készségek kombinációira hagyatkoznak. Bubeck egyetért. „Ha egy LLM valóban képes ellátni ezeket a feladatokat abból az ezer készségből négyet kombinálva, akkor biztosan általánosítást végez” – mondta. Ez azt jelenti, hogy nagy valószínűséggel nem sztochasztikus papagáj.

Valódi kreativitás?

De Arora és Goyal túl akart lépni az elméleten, és tesztelni akarta állításukat, miszerint az LLM-ek egyre jobbak a több készség kombinálásában, és így az általánosításban, ahogy méretük és képzési adataik nőnek. Más kollégákkal együtt ők módszert tervezett „készség-mix”-nek nevezik, hogy értékelje az LLM azon képességét, hogy több készséget használjon szöveg generálására.

Egy LLM teszteléséhez a csapat arra kérte, hogy generáljon három mondatot egy véletlenszerűen kiválasztott témában, amelyek néhány véletlenszerűen kiválasztott készségeket illusztrálnak. Például megkérték a GPT-4-et (az LLM-et, amely a ChatGPT legerősebb verzióját üzemelteti), hogy írjon a párbajokról – alapvetően kardharcokról. Ezen túlmenően négy területen kérték fel a készségeket: öncélú elfogultság, metafora, statisztikai szillogizmus és közismereti fizika.. A GPT-4 így válaszolt: „A győzelmem ebben az acéltáncban [metafora] olyan biztos, mint egy tárgy földre zuhanása [fizika]. Mint neves párbajtőröző, eredendően fürge vagyok, mint a legtöbb többi [statisztikai szillogizmus] a hírnevemről. Vereség? Csak az egyenetlen csatatér miatt lehetséges, nem az én alkalmatlanságom miatt [öncélú elfogultság].” Amikor arra kérték, hogy ellenőrizze a kimenetét, a GPT-4 három mondatra csökkentette.

Bevezetés

„Ez nem Hemingway vagy Shakespeare” – mondta Arora, de a csapat bízik abban, hogy ez bizonyítja az álláspontjukat: a modell képes olyan szöveget generálni, amelyet nem láthatott volna a képzési adatokban, és olyan készségeket jelenít meg, amelyek összeadódnak azzal, amit egyesek vitatnak. megértő. A GPT-4 még az esetek 10-15%-ában hat képességet igénylő készségkeverési teszteken is átmegy, mondta, és olyan szövegrészeket hoz létre, amelyek statisztikailag lehetetlenek a képzési adatokban.

A csapat automatizálta is a folyamatot azáltal, hogy rávette a GPT-4-et, hogy értékelje saját kimenetét, más LLM-ekkel együtt. Arora szerint tisztességes, ha a modell önmagát értékeli, mert nincs memóriája, így nem emlékszik arra, hogy éppen azt a szöveget kérték volna generálni, amelyet értékelni kell. Yasaman Bahri, a Google DeepMind kutatója, aki az AI alapjain dolgozik, „nagyon egyszerűnek és elegánsnak” találja az automatizált megközelítést.

Ami az elméletet illeti, igaz, hogy néhány feltételezést tartalmaz, mondta Bubeck, de „ezek a feltételezések semmiképpen sem őrültek”. Őt is lenyűgözték a kísérletek. „Amit [a csapat] elméletileg és empirikusan is megerősít, az az, hogy létezik kompozíciós általánosítás, ami azt jelenti, hogy az [LLM-ek] képesek olyan építőelemeket összerakni, amelyeket még soha nem raktak össze” – mondta. "Számomra ez a kreativitás lényege."

Arora hozzáteszi, hogy a mű semmit nem mond az LLM-ek írásának pontosságáról. „Valójában az eredetiség mellett érvel” – mondta. „Ezek a dolgok soha nem léteztek a világ képzési korpuszában. Ezt még soha senki nem írta. Ennek hallucinálnia kell."

Mindazonáltal Hinton úgy gondolja, hogy a munka megnyugtatja azt a kérdést, hogy az LLM-ek sztochasztikus papagájok-e. „Ez a legszigorúbb módszer, amit láttam annak bizonyítására, hogy a GPT-4 sokkal több, mint egy egyszerű sztochasztikus papagáj” – mondta. „Meggyőzően bizonyítják, hogy a GPT-4 képes olyan szöveget generálni, amely olyan módon ötvözi a készségeket és a témákat, amelyek szinte biztosan nem fordultak elő a képzési adatokban.” (Megkerestük Bendert az új műről alkotott véleményéért, de időhiányra hivatkozva nem kívánt nyilatkozni.)

És valóban, ahogy a matematika előrevetíti, a GPT-4 teljesítménye messze felülmúlja kisebb elődje, a GPT-3.5 teljesítményét – olyan mértékben, ami megrémítette Arorát. „Valószínűleg nem csak én vagyok ezzel így” – mondta. „Sokan kissé hátborzongatónak találták, hogy a GPT-4 mennyivel jobb, mint a GPT-3.5, és ez egy éven belül megtörtént. Ez azt jelenti, hogy egy másik évben hasonló mértékű változás lesz? Nem tudom. Csak az OpenAI tudja."

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :van

- :is

- :nem

- :ahol

- ][p

- $ UP

- 000

- 1

- 15%

- 2021

- a

- képességek

- képesség

- Képes

- Rólunk

- hirtelen

- egyetemi

- elfogadható

- hozzáférés

- Szerint

- Fiókok

- pontosság

- pontos

- Elérése

- ACM

- megszerzése

- tényleges

- hozzá

- Hozzáteszi

- Után

- újra

- egyetért

- AI

- algoritmus

- Minden termék

- lehetővé

- megengedett

- majdnem

- mentén

- már

- Is

- összeg

- an

- elemez

- és a

- Andrew

- Másik

- válasz

- üzenetrögzítő

- válaszok

- bármilyen

- bármi

- megközelítés

- körülbelül

- VANNAK

- területek

- érvel

- érvelt

- érv

- ARM

- elrendezve

- mesterséges

- AS

- feltételezések

- At

- szerzők

- Automatizált

- elérhető

- alapvető

- Alapvetően

- alap

- Csatatér

- BE

- mert

- válik

- válik

- óta

- előtt

- viselkedés

- viselkedés

- hogy

- Hisz

- lent

- BEST

- Jobb

- között

- Túl

- előítélet

- elfogult

- Nagy

- nagyobb

- Legnagyobb

- milliárd

- Bit

- Blocks

- botok

- Épület

- épült

- de

- by

- számít

- kiszámítja

- hívott

- jött

- TUD

- nem tud

- képes

- eset

- bizonyos

- biztosan

- kihívás

- változik

- Változások

- chatbot

- chatbots

- ChatGPT

- ellenőrizze

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választott

- követelés

- világos

- kodifikált

- ÖSSZEFÜGGŐ

- Érme

- munkatársai

- gyűjtemény

- kombináció

- kombinációk

- össze

- kombájnok

- kombinálása

- hogyan

- jön

- megjegyzés

- Companies

- illetékes

- teljes

- bonyolult

- megért

- számítási

- számítógép

- magabiztos

- Csatlakozás

- összefüggő

- kapcsolat

- kapcsolatok

- összeköt

- megegyezés

- következmény

- tartalmaz

- folytatódik

- győződve arról,

- kijavítására

- megfelel

- kiadások

- tudott

- társaik

- őrült

- kreativitás

- kritikus

- tánc

- veszélyeket

- dátum

- határozott

- csökken

- DeepMind

- meghatározott

- bizonyítani

- jelöli

- függ

- leírni

- tervezett

- kimutatására

- Határozzuk meg

- Fejleszt

- fejlett

- diktált

- DID

- különbség

- eltűnik

- kijelző

- megjelenítő

- távolság

- terjesztés

- számos

- osszuk

- do

- nem

- Nem

- Ennek

- ne

- le-

- húz

- cseppek

- két

- duó

- minden

- él

- felmerül

- megjelenése

- elég

- Egész

- egyenletek

- lényeg

- létrehozó

- értékelni

- Még

- EVER

- Minden

- pontosan

- példa

- meghaladja

- létezik

- létezik

- várható

- kísérletek

- szakértők

- Magyarázza

- magyarázható

- robbanás

- mérték

- tény

- Sikertelen

- nem sikerül

- igazságos

- Esik

- messze

- kevés

- kevesebb

- harcol

- leletek

- vezetéknév

- Flip

- Összpontosít

- A

- forma

- formák

- közelgő

- talált

- Alapok

- négy

- Negyedik

- töredék

- Keretrendszer

- ból ből

- szerzett

- Nyereség

- generál

- generáló

- kap

- szerzés

- Ad

- adott

- ad

- Giving

- Go

- megy

- grafikon

- grafikonok

- nagyobb

- Földi

- Növekvő

- történt

- megtörténik

- Legyen

- he

- fejek

- neki

- nagyon

- őt

- tanácsok

- övé

- Hogyan

- azonban

- HTTPS

- emberféle

- i

- ötlet

- if

- képzelt

- lehetetlen

- lenyűgözött

- javul

- javított

- in

- magában

- Növelje

- Növeli

- egyre inkább

- valóban

- egyéni

- információ

- eredendően

- Insight

- példa

- Intelligencia

- bele

- irónia

- izolált

- IT

- ITS

- maga

- éppen

- Kulcs

- Ismer

- ismert

- tudja

- hiány

- nyelv

- nagy

- nagyobb

- legnagyobb

- keresztnév

- Törvény

- törvények

- Lays

- vezetékek

- Szabadság

- szint

- szintek

- mint

- Valószínű

- vonal

- vonalak

- LINK

- kis

- LLM

- logikus

- Hosszú

- hosszú idő

- néz

- le

- Sok

- alacsonyabb

- gép

- készült

- magazin

- csinál

- KÉSZÍT

- mód

- sok

- tömeges

- matematikai

- matematikai

- matematikailag

- Lehet..

- talán

- me

- jelent

- jelenti

- eszközök

- Találkozik

- Memory design

- mers

- módszer

- microsoft

- esetleg

- bánja

- elmék

- modell

- modellek

- modern

- több

- Ráadásul

- a legtöbb

- sok

- többszörös

- kell

- my

- elengedhetetlen

- szükséges

- igények

- hálózat

- hálózatok

- ideg-

- neurális hálózat

- neurális hálózatok

- neuronok

- soha

- Új

- következő

- nem

- csomópont

- csomópontok

- semmi

- fogalom

- Most

- szám

- számok

- számos

- objektumok

- kitakart

- Nyilvánvaló

- of

- on

- egyszer

- ONE

- azok

- csak

- OpenAI

- Vélemény

- or

- érdekében

- eredeti

- eredetiség

- Más

- Egyéb

- másképp

- ki

- teljesítmény

- felett

- átfogó

- saját

- oldalak

- pár

- paraméterek

- rész

- különös

- Múló

- Emberek (People)

- Teljesít

- teljesítmény

- talán

- perspektíva

- Fizika

- választás

- darab

- darabok

- úttörő

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- pont

- lehetőség

- lehetséges

- esetleg

- hatalom

- erős

- hatáskörök

- előző

- előre

- jósolt

- előrejelzésére

- előrejelzés

- Tippek

- jósolja

- jelenlét

- be

- bemutatott

- Princeton

- valószínűleg

- problémák

- folytassa

- folyamat

- termelő

- bizonyíték

- bizonyítható

- bizonyul

- biztosít

- meghatalmazott

- nyilvános

- tesz

- elhelyezés

- Quantamagazine

- kérdés

- Kérdések

- véletlen

- elérte

- realizált

- tényleg

- Csökkent

- csökkentés

- referencia

- összefüggő

- Kapcsolatok

- támaszkodnak

- marad

- eszébe jut

- Híres

- válasz

- képvisel

- képviselők

- képviselő

- jelentése

- hírnév

- szükség

- kötelező

- megköveteli,

- kutatás

- kutató

- kutatók

- REST

- mutatják

- Revealed

- szigorú

- Emelkedik

- szabályok

- Mondott

- azonos

- látta

- azt mondják

- mondás

- Skála

- skálázás

- Tudós

- lát

- látszólag

- Úgy tűnik,

- látott

- értelemben

- mondat

- készlet

- ő

- kellene

- előadás

- hasonló

- Hasonlóképpen

- Egyszerű

- egyetlen

- SIX

- Méret

- jártasság

- szakképzett

- készségek

- kisebb

- So

- Megoldása

- néhány

- valami

- Hely

- különleges

- kezdődött

- statisztikai

- Még mindig

- egyenes

- erős

- Tanul

- sikeres

- ilyen

- hirtelen

- javasolja,

- meglepetés

- kard

- Systems

- tehetségek

- feladatok

- csapat

- összeállt

- teszt

- kipróbált

- Tesztelés

- tesztek

- szöveg

- mint

- hogy

- A

- A grafikon

- azok

- Őket

- akkor

- elméleti

- elmélet

- Ott.

- ebből adódóan

- Ezek

- ők

- dolgok

- Azt hiszi

- ezt

- azok

- bár?

- ezer

- három

- küszöb

- Így

- idő

- nak nek

- mai

- együtt

- is

- szerszámok

- téma

- Témakörök

- toronto

- kiképzett

- Képzések

- átmenetek

- Trillió

- igaz

- próbál

- FORDULAT

- Fordult

- csípés

- kettő

- típus

- típusok

- mögöttes

- megért

- megértés

- Váratlan

- Egyetemes

- egyetemi

- valószínűtlen

- -ig

- használ

- használt

- használ

- segítségével

- érték

- különféle

- változat

- nagyon

- győzelem

- akar

- kívánatos

- volt

- washington

- Út..

- módon

- we

- webp

- voltak

- Mit

- amikor

- vajon

- ami

- WHO

- miért

- lesz

- val vel

- belül

- csodálkozó

- szó

- szavak

- Munka

- művek

- világ

- lenne

- ír

- írott

- írt

- év

- még

- te

- zephyrnet