Az adatok és betekintések közel valós idejű szállítása lehetővé teszi a vállalkozások számára, hogy gyorsan reagáljanak ügyfeleik igényeire. A valós idejű adatok számos forrásból származhatnak, beleértve a közösségi médiát, az IoT-eszközöket, az infrastruktúra-figyelést, a call center-figyelést és egyebeket. A több forrásból bevitt adatok szélessége és mélysége miatt a vállalkozások olyan megoldásokat keresnek, amelyek megvédik ügyfeleik magánéletét, és megakadályozzák a kényes adatokhoz való hozzáférést a végrendszerekből. Korábban a személyazonosításra alkalmas információk (PII) szabálymotorjaira kellett támaszkodnia, amelyek téves pozitív üzeneteket jelezhettek vagy kihagyhattak adatokat, vagy egyéni gépi tanulási (ML) modelleket kellett készítenie és karbantartania, hogy azonosítsa a személyazonosításra alkalmas információkat a streamelési adatokban. Ezenkívül be kellett vezetnie és karban kell tartania az ezen motorok vagy modellek támogatásához szükséges infrastruktúrát.

A folyamat egyszerűsítése és a költségek csökkentése érdekében használhatja Amazon Comprehend, egy természetes nyelvi feldolgozó (NLP) szolgáltatás, amely az ML-t használja arra, hogy betekintést és kapcsolatokat keressen, például embereket, helyeket, érzéseket és témákat strukturálatlan szövegben. Mostantól használhatja az Amazon Comprehend ML képességeit az ügyfél e-mailekben, a támogatási jegyekben, a termékismertetőkben, a közösségi médiában és egyebekben található személyazonosításra alkalmas adatok észlelésére és törlésére. ML tapasztalat nem szükséges. Elemezheti például a támogatási jegyeket és tudáscikkeket, hogy észlelje a személyazonosításra alkalmas entitásokat, és szerkeszthesse a szöveget a dokumentumok indexelése előtt. Ezt követően a dokumentumok mentesek a személyazonosításra alkalmas adatoktól, és a felhasználók felhasználhatják az adatokat. A személyazonosításra alkalmas entitások szerkesztése segít megvédeni ügyfelei adatait, és betartani a helyi törvényeket és előírásokat.

Ebből a bejegyzésből megtudhatja, hogyan implementálhatja az Amazon Comprehend szolgáltatást a streaming architektúrákba, hogy a személyazonosításra alkalmas adatokat csaknem valós időben szerkeszthesse. Amazon Kinesis Data Firehose val vel AWS Lambda.

Ez a bejegyzés a kiválasztott mezőkből származó adatok törlésére irányul, amelyek a Kinesis Data Firehose segítségével bekerülnek egy adatfolyam-architektúrába, ahol további származékos másolatokat szeretne létrehozni, tárolni és karbantartani az adatokról a végfelhasználók vagy a későbbi alkalmazások számára. Ha használsz Amazon Kinesis adatfolyamok vagy további használati esetei vannak a személyazonosításra alkalmas adatok szerkesztésén kívül, lásd Az Amazon Kinesis Data Analytics, az Amazon Translate és az Amazon Comprehend segítségével SQL-függvények segítségével lefordíthatja, szerkesztheti és elemzi a streaming adatokat, ahol megmutatjuk, hogyan használhatod Amazon Kinesis Data Analytics Studio powered by Apache Zeppelin és a Apache Flash a streaming adatok szövegmezőinek interaktív elemzéséhez, lefordításához és szerkesztéséhez.

Megoldás áttekintése

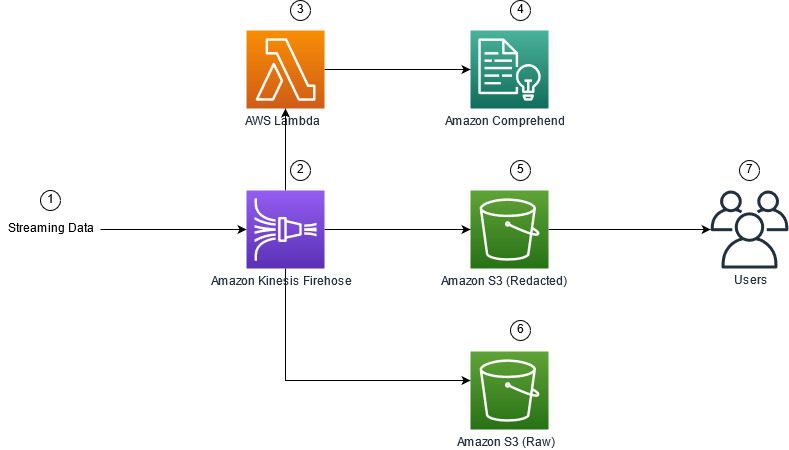

A következő ábra egy példaarchitektúrát mutat be a streaming adatok személyazonosításra alkalmas adatok valós időben történő szerkesztésére, a használatával Amazon egyszerű tárolási szolgáltatás (Amazon S3), Kinesis Data Firehose adattranszformáció, Amazon Comprehendés AWS Lambda. Ezen kívül használjuk a AWS SDK Pythonhoz (Boto3) a lambda funkciókhoz. Amint az a diagramon látható, az S3 nyers tároló nem szerkesztett adatokat, az S3 szerkesztett gyűjtő pedig az Amazon Comprehend használata után szerkesztett adatokat tartalmaz. DetectPiiEntities API egy Lambda függvényen belül.

A felmerülő költségek

A Kinesis Data Firehose, az Amazon S3 és a Lambda költségein kívül ez a megoldás használati költségekkel is jár az Amazon Comprehend részéről. A fizetett összeg a személyazonosításra alkalmas adatokat és a Lambda függvény által feldolgozott karaktereket tartalmazó rekordok teljes számának tényezője. További információkért lásd: Amazon Kinesis Data Firehose árképzés, Amazon Comprehend árképzésés AWS lambda árazás.

Példaként tegyük fel, hogy 10,000 500 naplórekordja van, és a kulcsérték, amelyből a személyazonosításra alkalmas adatokat törölni kívánja, 10,000 karakter. A 50 XNUMX naplóbejegyzésből XNUMX-ben azonosították a személyazonosításra alkalmas adatokat. A költségek részletei a következők:

Személyazonosításra alkalmas adatok költségét tartalmazza:

- Az egyes kulcsértékek mérete = 500 karakter (1 egység = 100 karakter)

- Egységek száma (100 karakter) rekordonként (minimum 3 egység) = 5

- Összes egység = 10,000 5 (rekord) x 1 (egységenként rekord) x 50,000 (Amazon Comprehend kérések rekordonként) = XNUMX XNUMX

- Egységár = 0.000002 USD

- A naplórekordok személyazonosító adatokkal való azonosításának teljes költsége a ContainsPiiEntities API használatával = 0.1 USD [50,000 0.000002 egység x XNUMX USD]

Személyazonosításra alkalmas adatok költségének módosítása:

- Személyazonosításra alkalmas adatokat tartalmazó összes egység = 50 (rekord) x 5 (egységenként rekord) x 1 (Amazon Comprehend kérések rekordonként) = 250

- Egységár = 0.0001 USD

- A személyazonosításra alkalmas adatok helyének azonosításának teljes költsége a DetectPiiEntities API használatával = [egységek száma] x [egységenkénti költség] = 250 x 0.0001 USD = 0.025 USD

Az azonosítás és a szerkesztés teljes költsége:

- Teljes költség: 0.1 USD (ellenőrzés, ha a mező személyazonosító adatokat tartalmaz) + 0.025 USD (a személyazonosításra alkalmas adatokat tartalmazó mezők törlése) = 0.125 USD

Telepítse a megoldást az AWS CloudFormation segítségével

Ehhez a bejegyzéshez egy AWS felhőképződés streaming adatok szerkesztése sablon, amely a megvalósítás teljes részleteit tartalmazza az ismételhető telepítések lehetővé tétele érdekében. Üzembe helyezéskor ez a sablon két S3 tárolót hoz létre: az egyiket az Amazon Kinesis Data Generator (KDG) által bevitt nyers mintaadatok tárolására, a másikat pedig a szerkesztett adatok tárolására. Ezenkívül létrehoz egy Kinesis Data Firehose szállítási adatfolyamot DirectPUT bemenetként, és egy Lambda függvény, amely meghívja az Amazon Comprehendet ContainsPiiEntities és a DetectPiiEntities API a személyazonosításra alkalmas adatok azonosítására és szerkesztésére. A Lambda függvény a felhasználói bevitelre támaszkodik a környezeti változókban annak meghatározásához, hogy mely kulcsértékeket kell megvizsgálni a személyazonosításra alkalmas adatok szempontjából.

Ebben a megoldásban a lambda funkció 100 KB-ra korlátozza a hasznos terhelés méretét. Ha olyan hasznos adatot adnak meg, ahol a szöveg nagyobb, mint 100 KB, a Lambda funkció kihagyja azt.

A megoldás üzembe helyezéséhez hajtsa végre a következő lépéseket:

- Indítsa el a CloudFormation stacket az USA keleti részén (N. Virginia)

us-east-1:

- Adja meg a verem nevét, és hagyja a többi paramétert az alapértelmezett értékükön

- választ Tudomásul veszem, hogy az AWS CloudFormation létrehozhat IAM-erőforrásokat egyéni névvel.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Verem létrehozása.

Erőforrások manuális telepítése

Ha inkább manuálisan szeretné felépíteni az architektúrát az AWS CloudFormation használata helyett, hajtsa végre az ebben a szakaszban található lépéseket.

Hozza létre az S3 vödröket

Hozza létre az S3 vödröket a következő lépésekkel:

- Az Amazon S3 konzolon válassza a lehetőséget Kanalak a navigációs ablaktáblában.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Vödör létrehozása.

- Hozzon létre egy gyűjtőzónát a nyers adatokhoz, egyet pedig a szerkesztett adatokhoz.

- Jegyezze fel az imént létrehozott vödrök nevét.

Hozd létre a Lambda függvényt

A Lambda funkció létrehozásához és üzembe helyezéséhez hajtsa végre a következő lépéseket:

- A Lambda konzolon válassza a lehetőséget Funkció létrehozása.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Szerző a semmiből.

- A Funkció neve, belép

AmazonComprehendPII-Redact. - A Runtime, választ Python 3.9.

- A Építészetválassza x86_64.

- A Végrehajtási szerepválassza Hozzon létre egy új szerepet Lambda engedélyekkel.

- A függvény létrehozása után írja be a következő kódot:

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Telepítése.

- A navigációs panelen válassza a lehetőséget Konfigurációt.

- navigáljon Környezeti változók.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a szerkesztése.

- A Kulcs, belép

keys. - A Érték, adja meg azokat a kulcsértékeket, amelyekből törölni szeretné a személyazonosításra alkalmas adatokat, vesszővel és szóközzel elválasztva. Például írja be

Tweet1,Tweet2ha a bejegyzés következő részében található minta tesztadatokat használja. - A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Megtakarítás.

- navigáljon Általános konfiguráció.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a szerkesztése.

- Módosítsa a Timeout 1 percig.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Megtakarítás.

- navigáljon Engedélyek.

- Válassza ki a szerep nevét az alatt Végrehajtási szerep.

Ön át lesz irányítva a AWS Identity and Access Management (IAM) konzol. - A Engedélyek hozzáadása, választ Szabályzatok csatolása.

- belép

Comprehendlépjen a keresősávba, és válassza ki a házirendetComprehendFullAccess. - A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Szabályzatok csatolása.

Hozza létre a Firehose kézbesítési adatfolyamot

A Firehose kézbesítési adatfolyam létrehozásához hajtsa végre a következő lépéseket:

- A Kinesis Data Firehose konzolon válassza a lehetőséget Kézbesítési adatfolyam létrehozása.

- A forrásválassza Közvetlen PUT.

- A Rendeltetési helyválassza Amazon S3.

- A Kézbesítési adatfolyam neve, belép

ComprehendRealTimeBlog. - Alatt Forrásrekordok átalakítása az AWS Lambdávalválassza Engedélyezett.

- A AWS lambda funkció, írja be a létrehozott függvény ARN-jét, vagy tallózással keresse meg a függvényt

AmazonComprehendPII-Redact. - A Pufferméret, állítsa az értéket 1 MB-ra.

- A Puffer intervallum, hagyja 60 másodpercnek.

- Alatt Úticél beállításai, válassza ki a szerkesztett adatokhoz létrehozott S3 tárolót.

- Alatt Biztonsági mentési beállítások, válassza ki a nyers rekordokhoz létrehozott S3 tárolót.

- Alatt Engedély, hozzon létre vagy frissítsen egy IAM-szerepet, vagy válasszon egy meglévő szerepet a megfelelő jogosultságokkal.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Kézbesítési adatfolyam létrehozása.

Telepítse az adatfolyam-megoldást a Kinesis Data Generator segítségével

Használhatja a Kinesis Data Generator (KDG) mintaadatokat a Kinesis Data Firehose-ba, és tesztelheti a megoldást. A folyamat egyszerűsítése érdekében biztosítunk egy Lambda-függvényt és egy CloudFormation-sablont egy Amazon Cognito felhasználót, és rendelje hozzá a megfelelő engedélyeket a KDG használatához.

- A Amazon Kinesis Data Generator oldal, választ Hozzon létre egy Cognito-felhasználót a CloudFormation segítségével.A rendszer átirányítja az AWS CloudFormation konzolra a verem létrehozásához.

- Adjon meg egy felhasználónevet és jelszót annak a felhasználónak, amellyel bejelentkezik a KDG-be.

- Hagyja a többi beállítást az alapértelmezett értékükön, és hozza létre a veremét.

- A Kimenetek lapon válassza a KDG UI hivatkozást.

- A bejelentkezéshez adja meg felhasználónevét és jelszavát.

Küldje el a tesztrekordokat, és érvényesítse a szerkesztést az Amazon S3-ban

A megoldás teszteléséhez hajtsa végre a következő lépéseket:

- Jelentkezzen be az előző lépésben létrehozott KDG URL-címére.

- Válassza ki azt a régiót, ahol az AWS CloudFormation verem telepítésre került.

- A Adatfolyam/szállítási adatfolyam, válassza ki a létrehozott kézbesítési adatfolyamot (ha használta a sablont, akkor a formátuma megvan

accountnumber-awscomprehend-blog). - A többi beállítást hagyja az alapértelmezett értékükön.

- A rekordsablonhoz létrehozhat saját teszteket, vagy használhatja a következő sablont. Ha az alábbi mintaadatokat használja a teszteléshez, frissített környezeti változókkal kell rendelkeznie a

AmazonComprehendPII-RedactLambda funkcióTweet1,Tweet2. Ha a CloudFormation segítségével telepíti, frissítse a környezeti változókat erreTweet1,Tweet2a létrehozott Lambda függvényen belül. A minta tesztadatok az alábbiak: - A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a Adatok küldése, és várjon néhány másodpercet, amíg a rekordok elküldésre kerülnek az adatfolyamra.

- Néhány másodperc elteltével állítsa le a KDG generátort, és ellenőrizze, hogy az S3 vödreiben vannak-e kézbesített fájlok.

A következő példa a nyers S3 tárolóban lévő nyers adatokra:

Az alábbiakban egy példa látható a szerkesztett S3 tárolóban lévő szerkesztett adatokra:

Az érzékeny információkat eltávolítottuk a törölt üzenetekből, így biztos lehet benne, hogy megoszthatja ezeket az adatokat a végrendszerekkel.

Razzia

Ha végzett ezzel a megoldással, tisztítsa meg erőforrásait az AWS CloudFormation konzol segítségével a példában telepített összes erőforrás törléséhez. Ha követte a kézi lépéseket, manuálisan kell törölnie a két vödröt, a AmazonComprehendPII-Redact funkció, a ComprehendRealTimeBlog folyam, a naplócsoport a ComprehendRealTimeBlog adatfolyamot és a létrehozott IAM-szerepeket.

Következtetés

Ez a bejegyzés bemutatta, hogyan integrálhatja a személyazonosításra alkalmas adatok szerkesztését a közel valós idejű adatfolyam-architektúrába, és hogyan csökkentheti az adatfeldolgozási időt a repülés közbeni szerkesztéssel. Ebben a forgatókönyvben megadja a törölt adatokat a végfelhasználóknak, és a Data Lake rendszergazdája biztosítja a nyers gyűjtőtárat későbbi használatra. Az Amazon Comprehend segítségével további feldolgozást is létrehozhat a hangszín vagy hangulat azonosítása, az adatok entitásainak azonosítása és az egyes üzenetek osztályozása érdekében.

Ennek a bejegyzésnek a részeként minden egyes szolgáltatáshoz egyedi lépéseket biztosítottunk, valamint tartalmaztunk egy CloudFormation-sablont is, amely lehetővé teszi a szükséges erőforrások biztosítását a fiókjában. Ezt a sablont csak a koncepció bizonyítására vagy a tesztelési forgatókönyvekre szabad használni. Ehhez olvassa el a fejlesztői útmutatókat Amazon Comprehend, Lambdaés Kinesis Data Firehose bármilyen szolgáltatási korlátra.

A személyazonosításra alkalmas adatok azonosításának és szerkesztésének megkezdéséhez lásd: Személyazonosításra alkalmas adatok (PII). Az ebben a bejegyzésben található példaarchitektúrával az Amazon Comprehend API-k bármelyikét integrálhatja közel valós idejű adatokkal a Kinesis Data Firehose adatátalakítás segítségével. Ha többet szeretne megtudni arról, hogy mit építhet a közel valós idejű adatokból a Kinesis Data Firehose segítségével, tekintse meg a Amazon Kinesis Data Firehose fejlesztői útmutató. Ez a megoldás minden AWS-régióban elérhető, ahol az Amazon Comprehend és a Kinesis Data Firehose elérhető.

A szerzőkről

Joe Morotti az Amazon Web Services (AWS) megoldástervezője, aki az Egyesült Államok középnyugati részén segíti a vállalati ügyfeleket. Technikai szerepkörök széles skáláját töltötte be, és szívesen bemutatja az ügyfelek művészetét a lehetséges lehetőségekről. Szabadidejében szívesen tölt minőségi időt családjával új helyek felfedezésével és sportcsapata teljesítményének túlértékelésével.

Joe Morotti az Amazon Web Services (AWS) megoldástervezője, aki az Egyesült Államok középnyugati részén segíti a vállalati ügyfeleket. Technikai szerepkörök széles skáláját töltötte be, és szívesen bemutatja az ügyfelek művészetét a lehetséges lehetőségekről. Szabadidejében szívesen tölt minőségi időt családjával új helyek felfedezésével és sportcsapata teljesítményének túlértékelésével.

Sriharsh Adari az Amazon Web Services (AWS) vezető megoldástervezője, ahol segít az ügyfeleknek abban, hogy az üzleti eredményektől visszamenőleg dolgozzanak innovatív megoldásokat az AWS-en. Az évek során több ügyfelének segített az adatplatformok átalakításában az iparági vertikumokban. Fő szakterülete a technológiai stratégia, az adatelemzés és az adattudomány. Szabadidejében szeret teniszezni, mámorosan tévéműsorokat nézni és Tablát játszani.

Sriharsh Adari az Amazon Web Services (AWS) vezető megoldástervezője, ahol segít az ügyfeleknek abban, hogy az üzleti eredményektől visszamenőleg dolgozzanak innovatív megoldásokat az AWS-en. Az évek során több ügyfelének segített az adatplatformok átalakításában az iparági vertikumokban. Fő szakterülete a technológiai stratégia, az adatelemzés és az adattudomány. Szabadidejében szeret teniszezni, mámorosan tévéműsorokat nézni és Tablát játszani.

- AI

- ai művészet

- ai art generátor

- van egy robotod

- Amazon kinezis

- analitika

- mesterséges intelligencia

- mesterséges intelligencia tanúsítás

- mesterséges intelligencia a bankszektorban

- mesterséges intelligencia robot

- mesterséges intelligencia robotok

- mesterséges intelligencia szoftver

- AWS gépi tanulás

- blockchain

- blokklánc konferencia ai

- coingenius

- társalgási mesterséges intelligencia

- kriptokonferencia ai

- dall's

- mély tanulás

- google azt

- Közepes (200)

- Kinesis Data Firehose

- gépi tanulás

- Plató

- plato ai

- Platón adatintelligencia

- Platón játék

- PlatoData

- platogaming

- skála ai

- szintaxis

- zephyrnet