Az egyre nagyobb mesterségesintelligencia- és gépi tanulási modellek iránti szomjúság csillapítása érdekében a Tesla a Hot Chips 34-en rengeteg részletet tárt fel teljesen egyedi szuperszámítógépes architektúrájáról, a Dojo-ról.

A rendszer lényegében egy hatalmas, komponálható szuperszámítógép, bár ellentétben azzal, amit a számítógépen látunk Top 500, egy teljesen egyedi architektúrából épül fel, amely a számítási, hálózati és bemeneti/kimeneti (I/O) szilíciumot az utasításkészlet-architektúráig (ISA), tápellátásig, csomagolásig és hűtésig terjed. Mindez azzal a kifejezett céllal történt, hogy méretre szabott, specifikus gépi tanulási oktatóalgoritmusokat futtasson.

„A valós adatfeldolgozás csak gépi tanulási technikák révén valósítható meg, legyen szó természetes nyelvű feldolgozásról, az emberi látást biztosító utcákon való vezetésről a mindennapi környezettel való interakcióig terjedő robotikáig” – mondta Ganesh Venkataramanan, a Tesla hardvermérnöki részlegének vezető igazgatója. vitaindító beszéde során.

Ugyanakkor azzal érvelt, hogy az elosztott munkaterhelések skálázásának hagyományos módszerei nem gyorsultak fel a gépi tanulás követelményeivel való lépéshez szükséges sebességgel. Valójában a Moore-törvény nem korlátozza, és a mesterséges intelligencia/ML-tanításhoz szükséges rendszerek sem állnak rendelkezésre nagy léptékben, nevezetesen a CPU/GPU valamilyen kombinációja, vagy ritkább esetekben speciális AI-gyorsítók használatával.

„Hagyományosan chipeket építünk, csomagokra rakjuk, a csomagok NYÁK-ra mennek, ami a rendszerekbe kerül. A rendszerek rackbe kerülnek” – mondta Venkataramanan. A probléma az, hogy minden alkalommal, amikor az adat a chipről a csomagba kerül, és kikerül a csomagból, késleltetési és sávszélességi büntetést von maga után.

Adatközponti szendvics

Tehát, hogy megkerülje a korlátokat, Venkataramanan és csapata a nulláról kezdte.

„Rögtön az Elonnal készített interjúm során megkérdezte tőlem, hogy miben különbözik az AI-hoz készült CPU-któl és GPU-któl. Úgy érzem, hogy az egész csapat még mindig válaszol erre a kérdésre.”

Ez vezetett a Dojo képzési lapka kifejlesztéséhez, egy önálló számítási klaszterhez, amely fél köbmétert foglal el, és 556 TFLOPS FP32 teljesítményre képes egy 15 kW-os folyadékhűtéses csomagban.

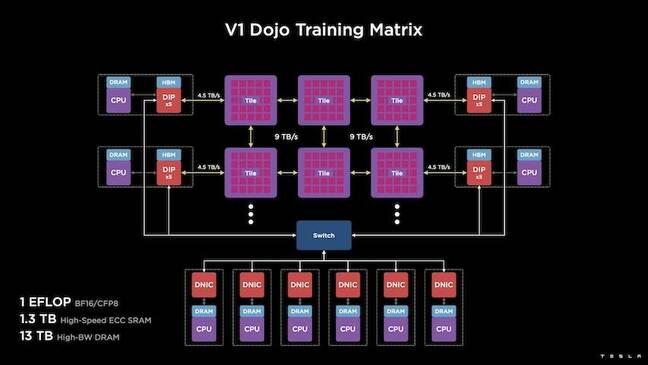

Mindegyik csempe 11 GB SRAM-mal van felszerelve, és egy 9 TB/s-os szöveten keresztül csatlakozik egy egyéni szállítási protokoll segítségével a teljes veremben.

"Ez az oktatási lapka páratlan mennyiségű integrációt jelent a számítógéptől a memóriáig az energiaellátásig, a kommunikációig anélkül, hogy további kapcsolókra lenne szükség" - mondta Venkataramanan.

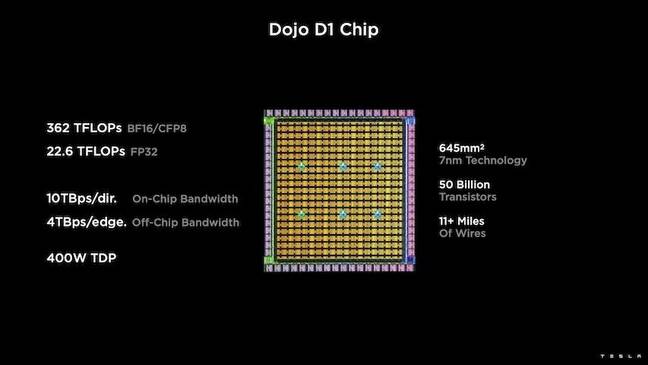

A képzési lapka középpontjában a Tesla D1, egy 50 milliárdos tranzisztoros tömb áll, amely a TSMC 7 nm-es folyamatán alapul. A Tesla szerint minden D1 22 TFLOPS FP32 teljesítményre képes 400 W-os TDP mellett. A Tesla azonban megjegyzi, hogy a chip a lebegőpontos számítások széles skálájának futtatására képes, beleértve néhány egyedi számítást is.

„Ha a tranzisztorokat a milliméteres négyzethez hasonlítjuk, ez valószínűleg mindennek a vérző széle” – mondta Venkataramanan.

A Tesla ezután 25 D1-et vett fel, összegyűjtötte őket az ismert jó formákért, majd becsomagolta a TSMC system-on-wafer technológiájával, hogy „nagy mennyiségű számítási integrációt érjen el nagyon alacsony késleltetéssel és nagyon nagy sávszélességgel” – mondta.

A lapkára épülő rendszer és a függőlegesen egymásra épülő architektúra azonban kihívásokat jelentett az energiaellátás terén.

Venkataramanan szerint a legtöbb gyorsító manapság az energiát közvetlenül a szilícium mellé helyezi. És bár bevált, ez a megközelítés azt jelenti, hogy a gyorsító nagy részét kell szentelni ezeknek az alkatrészeknek, ami miatt ez nem volt praktikus a Dojo számára, magyarázta. Ehelyett a Tesla úgy tervezte a chipjeit, hogy közvetlenül a kocka alján keresztül szállítsák az energiát.

Összeszereljük

„Egy egész adatközpontot vagy egy egész épületet építhetnénk ebből a képzési lapkából, de a képzési csempe csak a számítási rész. Etetni is kell” – mondta Venkataramanan.

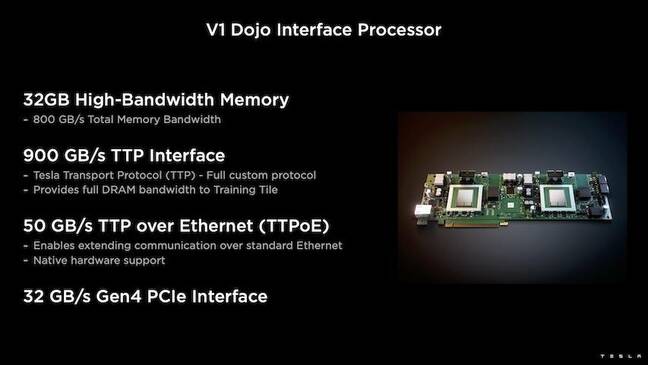

Ehhez a Tesla a Dojo Interface Processort (DIP) is kifejlesztette, amely hídként működik a fogadó CPU és a képzési processzorok között. A DIP a megosztott nagy sávszélességű memória (HBM) forrásaként és nagy sebességű, 400 Gbit/s-os hálózati kártyaként is szolgál.

Mindegyik DIP 32 GB HBM-mel rendelkezik, és ezek közül legfeljebb öt kártya csatlakoztatható egy oktatólapkához 900 GB/s sebességgel, összesen 4.5 TB/s sebességgel a gazdagéphez, így összesen 160 GB HBM csempénként.

A Tesla V1 konfigurációs párjai ezekből a csempékből – vagy 150 D1 matricából – négy, egyenként öt DIP-kártyával felszerelt gazdagép CPU-t támogattak, hogy elérjék a BF16 vagy CFP8 teljesítmény állítólagos exaflopját.

Összerakva mondja Venkataramanan az építészetet – részletesen mélyen itt by A következő platform – lehetővé teszi a Teslának, hogy leküzdje az olyan korlátokat, amelyek az Nvidia és az AMD hagyományos gyorsítóihoz kapcsolódnak.

„Hogyan működnek a hagyományos gázpedálok, általában egy teljes modellt próbálnak beleilleszteni minden egyes gázpedálba. Replikálja meg, majd áramolja át az adatokat mindegyiken” – mondta. „Mi történik, ha egyre nagyobb modelljeink lesznek? Ezek a gyorsítók lemerülhetnek, mert elfogy a memóriájuk.”

Ez nem új keletű probléma – jegyezte meg. Az Nvidia NV-kapcsolója például lehetővé teszi a memória egyesítését nagy GPU-bankok között. Venkataramanan azonban azt állítja, hogy ez nem csak bonyolultabbá teszi, hanem késleltetést és kompromisszumot jelent a sávszélességet illetően.

„Rögtön az indulástól fogva gondolkodtunk ezen. Számítási lapjainkat és mindegyik matricát nagy modellekhez való illesztéshez készítettük” – mondta Venkataramanan.

szoftver

Egy ilyen speciális számítási architektúrához speciális szoftververemre van szükség. Venkataramanan és csapata azonban felismerte, hogy a programozhatóság vagy létrehozza vagy megszakítja a Dojo-t.

„A rendszerek tervezésénél a legfontosabb a szoftvertársak egyszerű programozhatósága” – mondta. "A kutatók nem várják meg, hogy a szoftveresek kézírásos kernelt írjanak, hogy alkalmazkodjanak egy új algoritmushoz, amelyet futtatni akarunk."

Ennek érdekében a Tesla elvetette a kernelek használatának ötletét, és a Dojo architektúráját a fordítók köré tervezte.

„Amit tettünk, a PiTorch-ot használtuk. Létrehoztunk egy köztes réteget, amely segít a párhuzamosításban az alatta lévő hardver méretezésében. Minden alatt kód van lefordítva” – mondta. "Ez az egyetlen módja annak, hogy olyan szoftvercsomagokat hozzunk létre, amelyek alkalmazkodnak minden jövőbeli munkaterheléshez."

Annak ellenére, hogy a szoftveres rugalmasságra helyezik a hangsúlyt, Venkataramanan megjegyzi, hogy a jelenleg a laboratóriumaikban futó platform egyelőre a Tesla használatára korlátozódik.

„Elsősorban belső ügyfeleinkre összpontosítunk” – mondta. „Az Elon nyilvánosságra hozta, hogy idővel ezt a kutatók rendelkezésére bocsátjuk, de erre nincs időkeretünk. ®

- AI

- ai művészet

- ai art generátor

- van egy robotod

- mesterséges intelligencia

- mesterséges intelligencia tanúsítás

- mesterséges intelligencia a bankszektorban

- mesterséges intelligencia robot

- mesterséges intelligencia robotok

- mesterséges intelligencia szoftver

- blockchain

- blokklánc konferencia ai

- coingenius

- társalgási mesterséges intelligencia

- kriptokonferencia ai

- dall's

- mély tanulás

- google azt

- gépi tanulás

- Plató

- plato ai

- Platón adatintelligencia

- Platón játék

- PlatoData

- platogaming

- skála ai

- szintaxis

- A regisztráció

- zephyrnet