Bevezetés

A gépi tanulásban a torzítás-variancia kompromisszum alapvető fogalom, amely bármely prediktív modell teljesítményét befolyásolja. Ez a modell torzítási hibája és varianciahibája közötti kényes egyensúlyra utal, mivel lehetetlen mindkettőt egyidejűleg minimalizálni. A megfelelő egyensúly megtalálása elengedhetetlen a modell optimális teljesítményének eléréséhez.

Ebben a rövid cikkben meghatározzuk a torzítást és az eltérést, elmagyarázzuk, hogyan hatnak ezek a gépi tanulási modellre, és gyakorlati tanácsokat adunk a gyakorlatban való kezelésükhöz.

Az elfogultság és a szórás megértése

Mielőtt belemerülnénk a torzítás és a variancia közötti összefüggésbe, határozzuk meg, mit jelentenek ezek a kifejezések a gépi tanulásban.

A torzítási hiba a modell előrejelzése és az általa megjósolni kívánt helyes értékek közötti különbségre utal (alap igazság). Más szavakkal, a torzítás az a hiba, amelyet a modell a mögöttes adateloszlással kapcsolatos helytelen feltételezései miatt követ el. A nagy torzítású modellek gyakran túlságosan leegyszerűsítettek, nem képesek megragadni az adatok összetettségét, ami alulillesztéshez vezet.

A varianciahiba ezzel szemben a modell érzékenységére utal a betanítási adatok kis ingadozásaira. A nagy szórású modellek túlságosan összetettek, és hajlamosak az adatok zajára, nem pedig az alapul szolgáló mintára illeszkedni, ami túlillesztéshez vezet. Ez gyenge teljesítményt eredményez új, nem látott adatokon.

A nagy torzítás alulillesztéshez vezethet, ahol a modell túl egyszerű ahhoz, hogy rögzítse az adatok összetettségét. Erős feltételezéseket fogalmaz meg az adatokkal kapcsolatban, és nem tudja rögzíteni a bemeneti és kimeneti változók közötti valódi kapcsolatot. Másrészt a nagy szórás túlillesztéshez vezethet, amikor a modell túl bonyolult, és az adatok zaját tanulja meg, nem pedig a bemeneti és kimeneti változók közötti kapcsolatot. Így a túlillesztési modellek hajlamosak túlságosan szorosan illeszkedni a képzési adatokhoz, és nem általánosítanak jól új adatokra, míg az alulillesztési modellek nem is képesek pontosan illeszkedni a képzési adatokhoz.

Mint korábban említettük, a torzítás és a variancia összefügg, és egy jó modell egyensúlyt teremt a torzítási hiba és a varianciahiba között. A torzítás-variancia kompromisszum a két hibaforrás közötti optimális egyensúly megtalálásának folyamata. Az alacsony torzítású és alacsony szórású modell valószínűleg jól teljesít mind a betanítás, mind az új adatok esetében, minimalizálva a teljes hibát.

Az elfogultság-variáns kompromisszum

A torzítás-variancia kompromisszum magja a modell összetettsége és az ismeretlen adatokra való általánosítás képessége közötti egyensúly megteremtése. Általánosságban elmondható, hogy egy összetettebb modell kisebb torzítással, de nagyobb szórással rendelkezik, míg egy egyszerűbb modell nagyobb torzítással, de kisebb szórással.

Mivel lehetetlen egyidejűleg minimalizálni a torzítást és a szórást, a köztük lévő optimális egyensúly megtalálása döntő fontosságú egy robusztus gépi tanulási modell felépítésében. Például, ahogy növeljük egy modell összetettségét, növeljük a szórást is. Ennek az az oka, hogy egy összetettebb modell nagyobb valószínűséggel illeszti be a zajt a képzési adatokba, ami túlillesztéshez vezet.

Másrészt, ha túl egyszerűnek tartjuk a modellt, növeljük a torzítást. Ennek az az oka, hogy egy egyszerűbb modell nem fogja tudni megragadni a mögöttes összefüggéseket az adatokban, ami alulillesztéshez vezet.

A cél egy olyan modell betanítása, amely elég összetett ahhoz, hogy rögzítse a mögöttes összefüggéseket a betanítási adatokban, de nem olyan összetett, hogy illeszkedjen a betanítási adatok zajához.

Bias-Variance kompromisszum a gyakorlatban

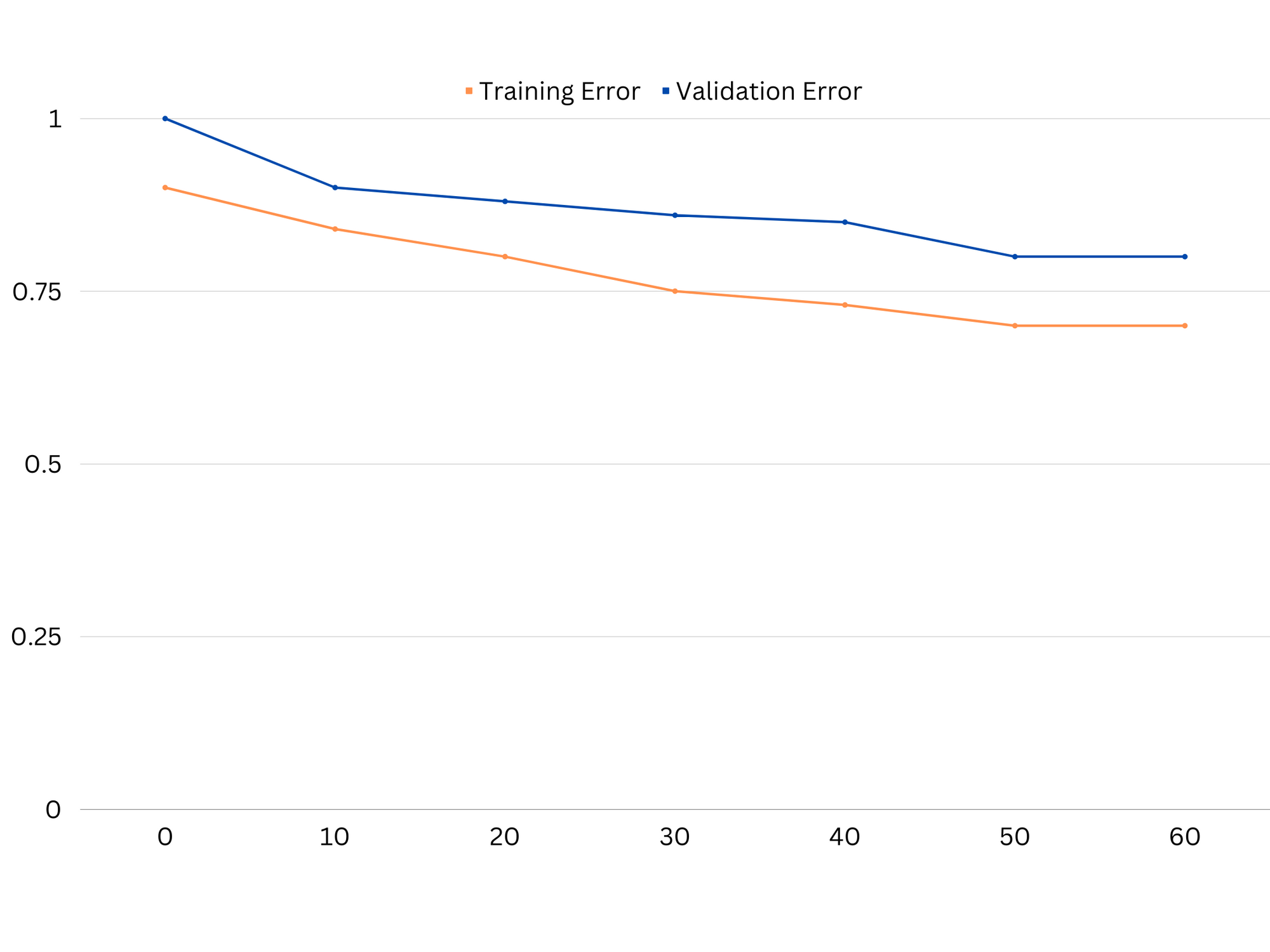

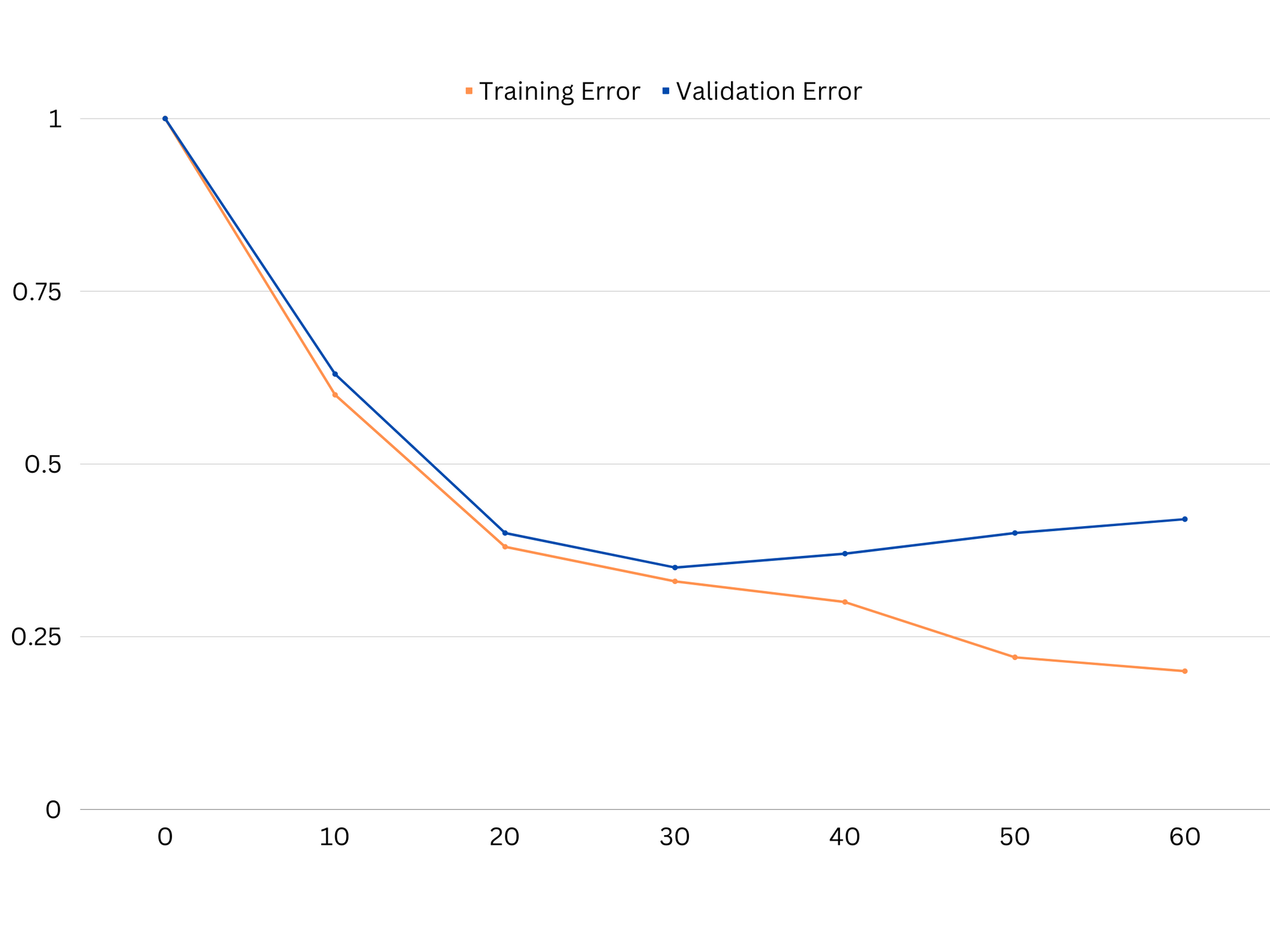

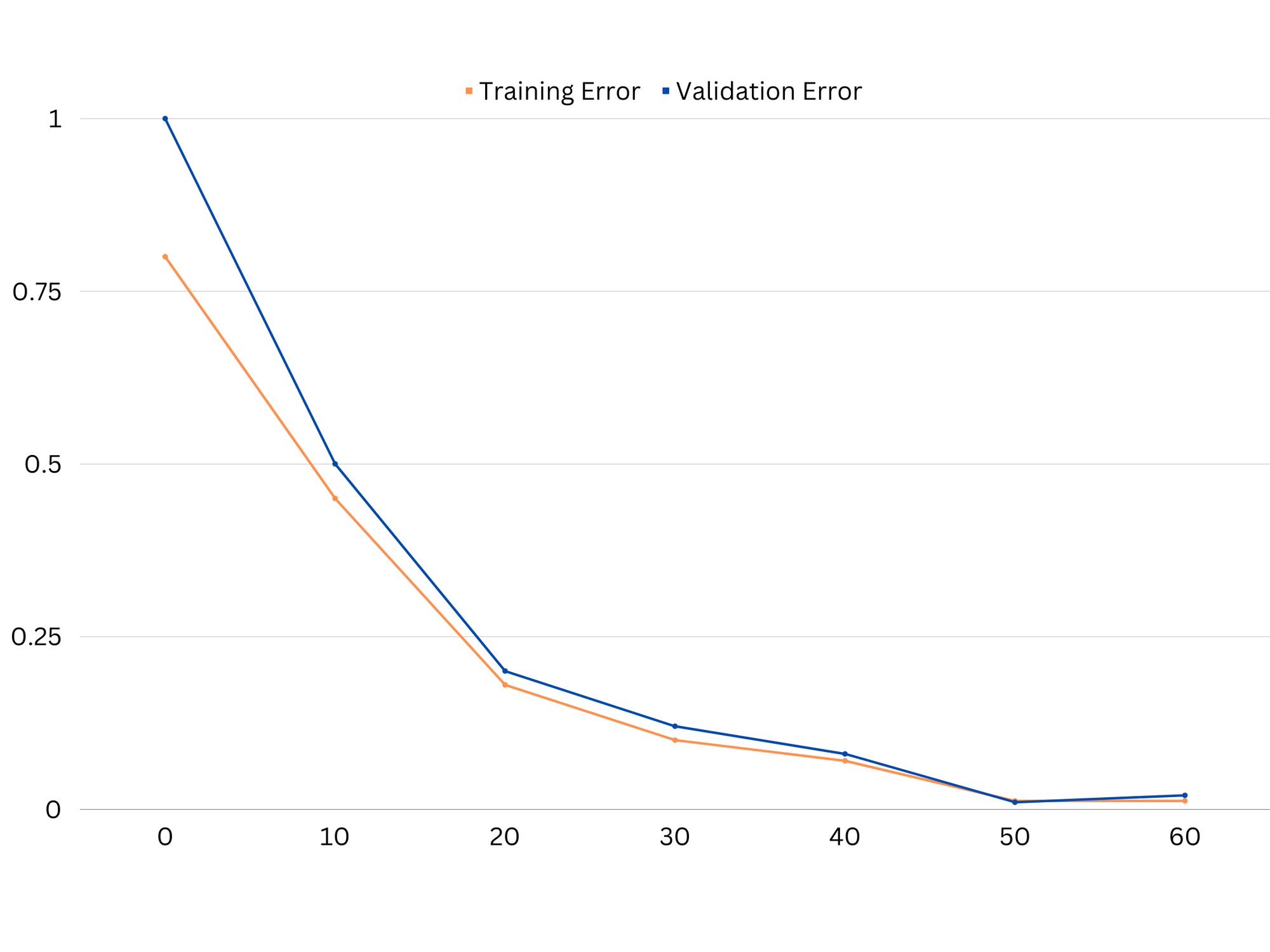

A modell teljesítményének diagnosztizálásához általában kiszámítjuk és összehasonlítjuk a vonatozási és érvényesítési hibákat. Ennek megjelenítésére egy hasznos eszköz a tanulási görbék diagramja, amely a modell teljesítményét mind a vonaton, mind az érvényesítési adatokon megjeleníti a képzési folyamat során. E görbék vizsgálatával megállapíthatjuk, hogy egy modell túlillesztés (nagy szórás), alulillesztés (nagy torzítás) vagy jól illeszkedik-e (optimális egyensúly a torzítás és a variancia között).

Példa egy alulillesztési modell tanulási görbéire. Mind a vonathiba, mind az érvényesítési hiba magas.

A gyakorlatban mind a képzési, mind az érvényesítési adatok alacsony teljesítménye azt sugallja, hogy a modell túl egyszerű, ami alulilleszkedéshez vezet. Másrészt, ha a modell nagyon jól teljesít a betanítási adatokon, de gyengén a tesztadatokon, akkor a modell bonyolultsága valószínűleg túl magas, ami túlillesztést eredményez. Az alulilleszkedés kiküszöbölése érdekében megpróbálhatjuk növelni a modell összetettségét további funkciók hozzáadásával, a tanulási algoritmus megváltoztatásával vagy különböző hiperparaméterek kiválasztásával. Túlillesztés esetén meg kell fontolnunk a modell rendszeresítését vagy olyan technikák alkalmazását, mint a keresztellenőrzés, hogy javítsuk általánosítási képességeit.

Példa egy túlillesztési modell tanulási görbéire. A vonathiba csökken, míg az érvényesítési hiba növekedni kezd. A modell nem tud általánosítani.

A szabályosítás egy olyan technika, amellyel csökkenthető a varianciahiba a gépi tanulási modellekben, segítve ezzel a torzítás-variancia kompromisszumot. Számos különböző rendszerezési technika létezik, mindegyiknek megvannak a maga előnyei és hátrányai. Néhány népszerű regularizációs technika közé tartozik a gerincregresszió, a lasszó regresszió és a rugalmas nettó regularizáció. Mindezek a technikák segítenek megelőzni a túlillesztést azáltal, hogy a modell célfüggvényéhez büntetőtagot adnak, ami visszatartja a szélsőséges paraméterértékeket, és egyszerűbb modellezésre ösztönöz.

Ridge regresszió, más néven L2 regularizáció, a modell paramétereinek négyzetével arányos büntetőtagot ad hozzá. Ez a technika általában kisebb paraméterértékekkel rendelkező modelleket eredményez, ami csökkenti a szórást és javítja az általánosítást. Azonban nem végez funkcióválasztást, így minden funkció a modellben marad.

Tekintse meg gyakorlatias, gyakorlati útmutatónkat a Git tanulásához, amely tartalmazza a bevált gyakorlatokat, az iparág által elfogadott szabványokat és a mellékelt csalólapot. Hagyd abba a guglizást a Git parancsokkal, és valójában tanulni meg!

Lasszó regresszió, vagy L1 regularizáció, a modell paramétereinek abszolút értékével arányos büntetőtagot ad hozzá. Ez a technika ritka paraméterértékekkel rendelkező modellekhez vezethet, amelyek egyes paraméterek nullára állításával hatékonyan hajtják végre a jellemzők kiválasztását. Ez egyszerűbb, könnyebben értelmezhető modelleket eredményezhet.

Rugalmas hálóreguláció az L1 és L2 regularizáció kombinációja, lehetővé téve az egyensúlyt a gerinc és a lasszó regresszió között. A két büntetés közötti arány szabályozásával az elasztikus háló mindkét technika előnyeit elérheti, például jobb általánosítást és jellemzőválasztást.

Példa a jól illeszkedő modell tanulási görbéire.

Következtetések

A torzítás-variancia kompromisszum a gépi tanulás kulcsfontosságú koncepciója, amely meghatározza a modell hatékonyságát és jóságát. Míg a nagy torzítás alulillesztéshez, a nagy szórás pedig túlillesztéshez vezet, a kettő közötti optimális egyensúly megtalálása szükséges a robusztus, új adatokra jól általánosító modellek felépítéséhez.

A tanulási görbék segítségével a túl- vagy alulilleszkedési problémák azonosíthatók, a modell komplexitásának hangolásával vagy a regularizációs technikák implementálásával pedig javítható a teljesítmény mind a betanítási, mind a validációs adatokon, valamint a tesztadatokon.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoAiStream. Web3 adatintelligencia. Felerősített tudás. Hozzáférés itt.

- A jövő pénzverése – Adryenn Ashley. Hozzáférés itt.

- Részvények vásárlása és eladása PRE-IPO társaságokban a PREIPO® segítségével. Hozzáférés itt.

- Forrás: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :is

- :nem

- :ahol

- 1

- 12

- 20

- 8

- a

- képesség

- Képes

- Rólunk

- Abszolút

- pontosan

- Elérése

- elérése

- tulajdonképpen

- hozzáadásával

- cím

- Hozzáteszi

- előnyei

- tanács

- érint

- érintő

- algoritmus

- Minden termék

- lehetővé téve

- Is

- an

- és a

- bármilyen

- VANNAK

- cikkben

- AS

- Egyenleg

- egyenlegek

- BE

- mert

- Előnyök

- között

- előítélet

- határ

- mindkét

- Épület

- de

- by

- számít

- TUD

- képességek

- elfog

- eset

- változó

- választja

- szorosan

- kombináció

- összehasonlítani

- bonyolult

- bonyolultság

- koncepció

- Fontolja

- kontrolling

- Mag

- kijavítására

- kritikus

- dátum

- üzlet

- csökken

- Határozzuk meg

- meghatározza

- különbség

- különböző

- kijelzők

- terjesztés

- nem

- két

- minden

- Korábban

- könnyebb

- hatékonyan

- hatékonyság

- ösztönzi

- elég

- hiba

- hibák

- Még

- vizsgálva

- példa

- Magyarázza

- szélső

- hiányában

- nem sikerül

- Funkció

- Jellemzők

- megtalálása

- megfelelő

- szerelvény

- ingadozások

- Összpontosít

- A

- funkció

- alapvető

- általános

- megy

- cél

- jó

- Földi

- útmutató

- kéz

- hands-on

- Legyen

- segít

- segít

- Magas

- <p></p>

- lebeg

- Hogyan

- How To

- azonban

- HTTPS

- azonosítani

- if

- végrehajtási

- lehetetlen

- javul

- javított

- in

- Más

- tartalmaz

- beleértve

- Növelje

- növekvő

- bemenet

- bele

- Bevezetés

- IT

- ITS

- Tart

- ismert

- L1

- l2

- vezet

- vezető

- vezetékek

- tanulás

- hadd

- LG

- mint

- Valószínű

- ll

- Elő/Utó

- alacsonyabb

- gép

- gépi tanulás

- KÉSZÍT

- említett

- minimalizálása

- modell

- modellek

- több

- elengedhetetlen

- háló

- Új

- Zaj

- szám

- célkitűzés

- of

- gyakran

- on

- optimálisan

- or

- Más

- mi

- ki

- teljesítmény

- saját

- paraméter

- paraméterek

- Mintás

- Teljesít

- teljesítmény

- előadó

- Előadja

- Plató

- Platón adatintelligencia

- PlatoData

- szegény

- Népszerű

- lehetséges

- Gyakorlati

- gyakorlat

- előre

- előrejelzés

- megakadályozása

- problémák

- folyamat

- ad

- Inkább

- hányados

- csökkenteni

- Csökkent

- kifejezés

- összefüggő

- kapcsolat

- Kapcsolatok

- marad

- képvisel

- eredményez

- kapott

- Eredmények

- jobb

- Gyűrű

- erős

- s

- kiválasztás

- Érzékenység

- beállítás

- árnyék

- adatlap

- rövid

- kellene

- Egyszerű

- egyszerre

- kicsi

- kisebb

- So

- néhány

- Források

- négyzet

- Stackabus

- szabványok

- megáll

- erős

- ilyen

- javasolja,

- technikák

- kifejezés

- feltételek

- teszt

- mint

- hogy

- A

- azok

- Őket

- Ott.

- Ezek

- ők

- ezt

- egész

- nak nek

- is

- szerszám

- Végösszeg

- Vonat

- Képzések

- átmenet

- igaz

- igazság

- megpróbál

- kettő

- jellemzően

- képtelen

- mögöttes

- ismeretlen

- használt

- segítségével

- érvényesítés

- érték

- Értékek

- nagyon

- we

- JÓL

- Mit

- vajon

- ami

- míg

- lesz

- val vel

- szavak

- zephyrnet

- nulla