Michael Bronstein, a Twitter gráftanulás-kutatásért felelős vezetője szerint a GPU-k hatékony eszközt jelentenek a gépi tanulási munkaterheléshez, bár nem feltétlenül a megfelelő eszközök minden mesterséges intelligencia-feladathoz.

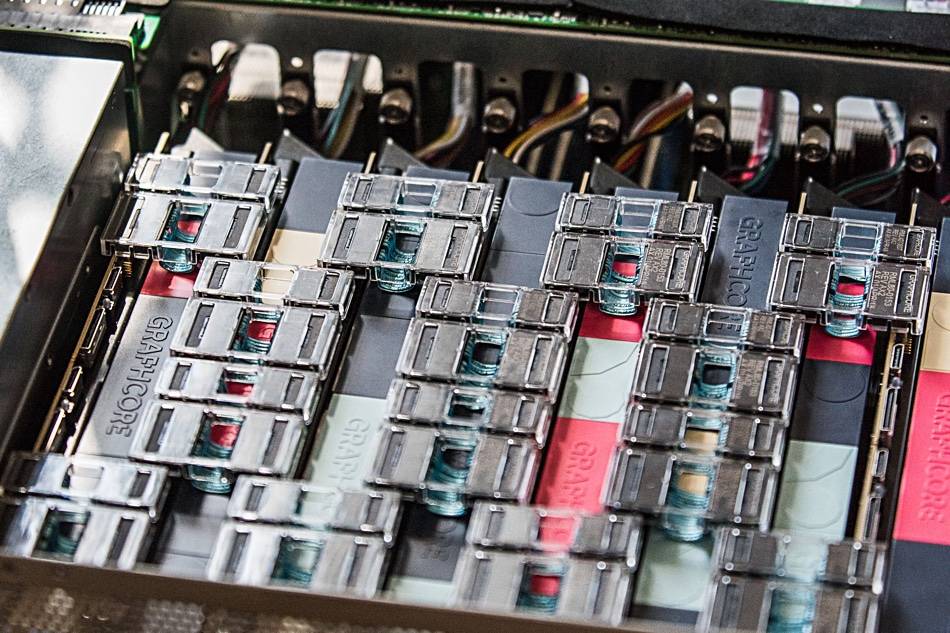

Csapata a közelmúltban kimutatta, hogy a Graphcore mesterséges intelligencia hardvere „nagyságrendi gyorsulást kínál egyetlen IPU processzor és egy Nvidia A100 GPU összehasonlításakor” a temporal graph Network (TGN) modellekben.

„A Graph ML modellek megvalósításához szükséges hardver kiválasztása kulcsfontosságú, de gyakran figyelmen kívül hagyott probléma” – olvasható egy közös cikk írta Bronstein Emanuele Rossival, a Twitter ML kutatójával és Daniel Justusszal, a Graphcore kutatójával.

A gráf neurális hálózatok lehetőséget kínálnak a rend megtalálására összetett rendszerekben, és általánosan használják a közösségi hálózatokban és az ajánlórendszerekben. Ezeknek a környezeteknek a dinamikus természete azonban különösen nagy kihívást jelent ezeknek a modelleknek a betanítása, magyarázta a trió.

A csoport megvizsgálta a Graphcore IPU-inak életképességét számos TGN modell kezelésében. A kezdeti tesztelést egy kis TGN modellen végezték el a JODIE Wikipédia adatkészlet, amely összekapcsolja a felhasználókat az oldalakon végzett szerkesztésekkel. A grafikon 8,227 felhasználót és 1,000 cikket tartalmazott, összesen 9,227 csomópontot. A JODIE egy nyílt forráskódú előrejelző rendszer, amelyet az időbeli interakciós hálózatok értelmezésére terveztek.

A trió kísérletei feltárták, hogy a nagy tételméretek gyengébb érvényesítést és következtetési pontosságot eredményeztek a kisebb tételméretekhez képest.

„A csomópontmemória és a grafikon kapcsolat csak a teljes köteg feldolgozása után frissül” – írta a trió. "Ezért az egy köteg későbbi eseményei elavult információkra támaszkodhatnak, mivel nem tudnak a korábbi eseményekről."

A 10-es kötegméret használatával azonban a csoport el tudta érni az optimális érvényesítési és következtetési pontosságot, de megjegyzik, hogy az IPU teljesítménye még akkor is jobb volt, mint a GPU-é, még nagy kötegméretek használata esetén is.

„A 10-es kötegoldal használata esetén a TGN körülbelül 11-szer gyorsabban betanítható az IPU-n, és még nagy, 200-as kötegméret mellett is háromszor gyorsabb a képzés az IPU-n” – áll a bejegyzésben. "Minden művelet során az IPU hatékonyabban kezeli a kis tételeket."

A csapat azt állítja, hogy a Graphcore nagy processzoron belüli SRAM-gyorsítótárának gyors memória-hozzáférése és nagy áteresztőképessége előnyhöz juttatta az IPU-t.

Ez a teljesítménybeli előny azokra a grafikonmodellekre is kiterjedt, amelyek meghaladták az IPU processzoron belüli memóriáját – mindegyik IPU rendelkezik 1 GB-os SRAM gyorsítótárral –, ami lassabb DRAM-memóriát igényel a chipekhez.

Bronstein csapata megállapította, hogy 261 millió Twitter-felhasználó között 15.5 millió felhasználóból álló gráfmodellt teszteltek, és a DRAM használata a csomópontmemóriában kétszeresére csökkentette a teljesítményt.

Amikor azonban több részgráfot indukált egy szintetikus adatkészlet alapján, amely tízszer akkora, mint a Twitter-gráf, a csapat a grafikon méretétől függetlenül skálázott átviteli sebességet talált. Más szóval, a teljesítmény a lassabb memóriahasználat eredménye, és nem a modell mérete.

"Ezzel a technikával az IPU-n a TGN szinte tetszőleges grafikonméretre alkalmazható, csak a rendelkezésre álló gazdagépmemória mennyisége korlátozza, miközben megőrzi a nagyon magas átviteli sebességet a betanítás és a következtetések során" - olvasható a cikkben.

A csapat arra a következtetésre jutott, hogy a Graphcore IPU architektúrája jelentős előnyt mutat a GPU-kkal szemben olyan munkaterhelésekben, ahol a számítási és memória-hozzáférés heterogén.

Azonban a tágabb kitétel az, hogy az ML-kutatóknak alaposan meg kell fontolniuk a hardverválasztást, és nem szabad alapértelmezetten GPU-kat használniuk.

„A mögöttes hardvert absztraháló felhőalapú számítástechnikai szolgáltatások bizonyos lustasághoz vezetnek e tekintetben” – írta a trió. „Reméljük, hogy tanulmányunk több figyelmet fordít erre a fontos témára, és megnyitja az utat a jövőbeni, hatékonyabb algoritmusok és hardverarchitektúrák előtt a Graph ML alkalmazásokhoz.” ®

- AI

- ai művészet

- ai art generátor

- van egy robotod

- mesterséges intelligencia

- mesterséges intelligencia tanúsítás

- mesterséges intelligencia a bankszektorban

- mesterséges intelligencia robot

- mesterséges intelligencia robotok

- mesterséges intelligencia szoftver

- blockchain

- blokklánc konferencia ai

- coingenius

- társalgási mesterséges intelligencia

- kriptokonferencia ai

- dall's

- mély tanulás

- google azt

- gépi tanulás

- Plató

- plato ai

- Platón adatintelligencia

- Platón játék

- PlatoData

- platogaming

- skála ai

- szintaxis

- A regisztráció

- zephyrnet