Ma bejelentjük, hogy elérhetőek a mintajegyzetfüzetek, amelyek kérdésekre válaszoló feladatokat mutatnak be a Retrieval Augmented Generation (RAG) alapú megközelítéssel, nagy nyelvi modellekkel (LLM) Amazon SageMaker JumpStart. A RAG és LLM-ekkel történő szöveggenerálás lehetővé teszi tartomány-specifikus szövegkimenetek generálását az LLM-eknek betáplált kontextus részeként meghatározott külső adatok megadásával.

A JumpStart egy gépi tanulási (ML) központ, amely segíthet felgyorsítani az ML utazást. A JumpStart számos előre betanított nyelvi modellt kínál, ún alapozó modellek amelyek segíthetnek olyan feladatok végrehajtásában, mint a cikkek összegzése, a kérdések megválaszolása, valamint a beszélgetés generálása és képalkotás.

Ebben a bejegyzésben bemutatjuk a RAG-ot és annak előnyeit, és bemutatjuk, hogyan lehet gyorsan kezdeni egy mintafüzet használatával egy kérdésmegválaszolási feladat megoldását a Jumpstart LLM-ekkel való RAG implementációjával. Két megközelítést mutatunk be:

- Hogyan lehet megoldani a problémát a nyílt forráskóddal LangChain könyvtár és Amazon SageMaker végpontokat néhány kódsorban

- A SageMaker KNN algoritmus használata nagyméretű adatok szemantikai kereséséhez SageMaker végpontok használatával

LLMS és megszorítások

Az LLM-ek nagy mennyiségű strukturálatlan adatra vannak kiképezve, és nagyszerűek az általános szöveggenerálásban. Az LLM-ek ténybeli ismereteket tárolhatnak, ha paramétereiket a természetes nyelvi adatok nagy tömegére képezik.

A készen kapható, előre képzett LLM-ek használatának van néhány korlátozása:

- Általában offline képzettek, így a modell agnosztikussá teszi a legújabb információkat (például egy 2011–2018 között kiképzett chatbotnak nincs információja a COVID-19-ről).

- Előrejelzéseket készítenek úgy, hogy csak a paramétereiben tárolt információkat keresik, ami rosszabb értelmezhetőséghez vezet.

- Leginkább általános tartományi korpuszokra képezték ki őket, így kevésbé hatékonyak a tartományspecifikus feladatokban. Vannak olyan forgatókönyvek, amikor azt szeretné, hogy a modellek konkrét adatok alapján generáljanak szöveget általános adatok helyett. Például egy egészségbiztosító azt szeretné, ha a kérdésre válaszoló robotja a vállalati dokumentumtárában vagy adatbázisában tárolt legfrissebb információk alapján válaszolna a kérdésekre, így a válaszok pontosak és tükrözik egyedi üzleti szabályaikat.

Jelenleg két népszerű módja van a konkrét adatok hivatkozásának az LLM-ekben:

- Szúrjon be adatokat kontextusként a modell promptba, hogy megadja azokat az információkat, amelyeket a modell felhasználhat az eredmény létrehozásakor

- Finomítsa a modellt egy prompt és befejező párokat tartalmazó fájl megadásával

A kontextus alapú megközelítés kihívása, hogy a modellek korlátozott kontextusmérettel rendelkeznek, és előfordulhat, hogy az összes dokumentum kontextusként való szerepeltetése nem fér bele a modell megengedett kontextusméretébe. A használt modelltől függően nagyobb kontextus esetén további költségek is felmerülhetnek.

A finomhangolás megközelítéséhez a megfelelő formátumú információ előállítása időigényes és költséges. Ezen túlmenően, ha a finomhangoláshoz használt külső adatok gyakran változnak, az gyakori finomhangolásra és átképzésre lenne szükség a pontos eredmények eléréséhez. A gyakori képzés hatással van a piacra jutási sebességre, és növeli a megoldás teljes költségét.

E korlátozások bemutatására egy LLM Flan T5 XXL modellt használtunk, és a következő kérdést tettük fel:

A következő választ kapjuk:

Amint látja, a válasz nem pontos. A helyes válasz az kell legyen, hogy az összes SageMaker-példány támogatja a Managed Spot Training-et.

Megpróbáltuk ugyanazt a kérdést, de további kontextust adtak át a kérdéshez:

Ezúttal a következő választ kaptuk:

A válasz jobb, de még mindig nem pontos. Valós éles felhasználási esetekben azonban a felhasználók különféle lekérdezéseket küldhetnek, és a pontos válaszok érdekében érdemes lehet a statikus kontextus részeként az összes rendelkezésre álló információt vagy annak nagy részét belefoglalni a pontos válaszok létrehozásához. Ezért ezzel a megközelítéssel elérhetjük a kontextusméret-korlátozást, mert még a feltett kérdéshez nem releváns információk is elküldésre kerülnek a kontextus részeként. Itt használhatja a RAG-alapú megközelítést, hogy méretezhető és pontos válaszokat hozzon létre a felhasználói lekérdezésekre.

Visszakeresés kiterjesztett generáció

Az általunk tárgyalt megszorítások megoldására használhatjuk a Retrieval Augmented Generation (RAG) funkciót az LLM-ekkel. A RAG lekéri az adatokat a nyelvi modellen kívülről (nem paraméteres), és kibővíti a promptokat azáltal, hogy a releváns leolvasott adatokat kontextusban adja hozzá. RAG modelleket mutatott be Lewis et al. 2020-ban modellként, ahol a parametrikus memória egy előre betanított seq2seq modell, a nem paraméteres memória pedig a Wikipédia sűrű vektorindexe, amelyhez egy előre betanított neurális retrieverrel lehet hozzáférni.

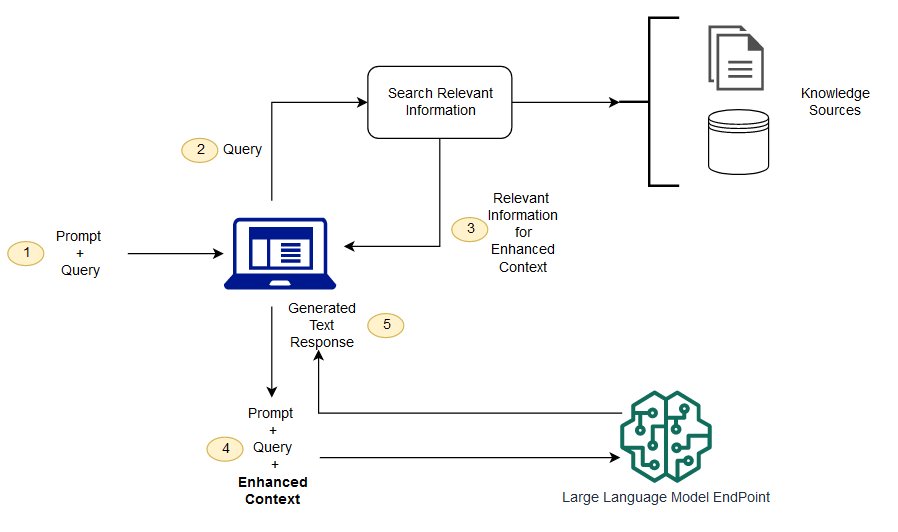

A RAG-ban a külső adatok több adatforrásból származhatnak, például dokumentumtárból, adatbázisokból vagy API-kból. Első lépésként a dokumentumokat és a felhasználói lekérdezést olyan formátumba kell konvertálni, hogy összehasonlíthatóak legyenek, és elvégezhető legyen a relevanciakeresés. A formátumok összehasonlíthatósága érdekében a relevanciakereséshez egy dokumentumgyűjteményt (tudástárat) és a felhasználó által benyújtott lekérdezést a program numerikus ábrázolássá alakítja beágyazott nyelvi modellek segítségével. A beágyazások lényegében a fogalom numerikus megjelenítései a szövegben. Ezután a felhasználói lekérdezés beágyazása alapján a releváns szöveget a beágyazási térben végzett hasonlósági keresés azonosítja a dokumentumgyűjteményben. Ezután a felhasználó által megadott prompt hozzá lesz fűzve a keresett releváns szöveggel, és hozzáadódik a kontextushoz. A prompt most elküldésre kerül az LLM-nek, és mivel a kontextus az eredeti prompt mellett releváns külső adatokat is tartalmaz, a modell kimenete releváns és pontos.

A referenciadokumentumok naprakész információinak fenntartásához aszinkron módon frissítheti a dokumentumokat és frissítheti a dokumentumok beágyazott ábrázolását. Ily módon a frissített dokumentumokat a jövőbeni kérdésekre történő válaszok generálására használják fel, hogy pontos válaszokat adjanak.

A következő diagram bemutatja a RAG és az LLM-ekkel való használat fogalmi folyamatát.

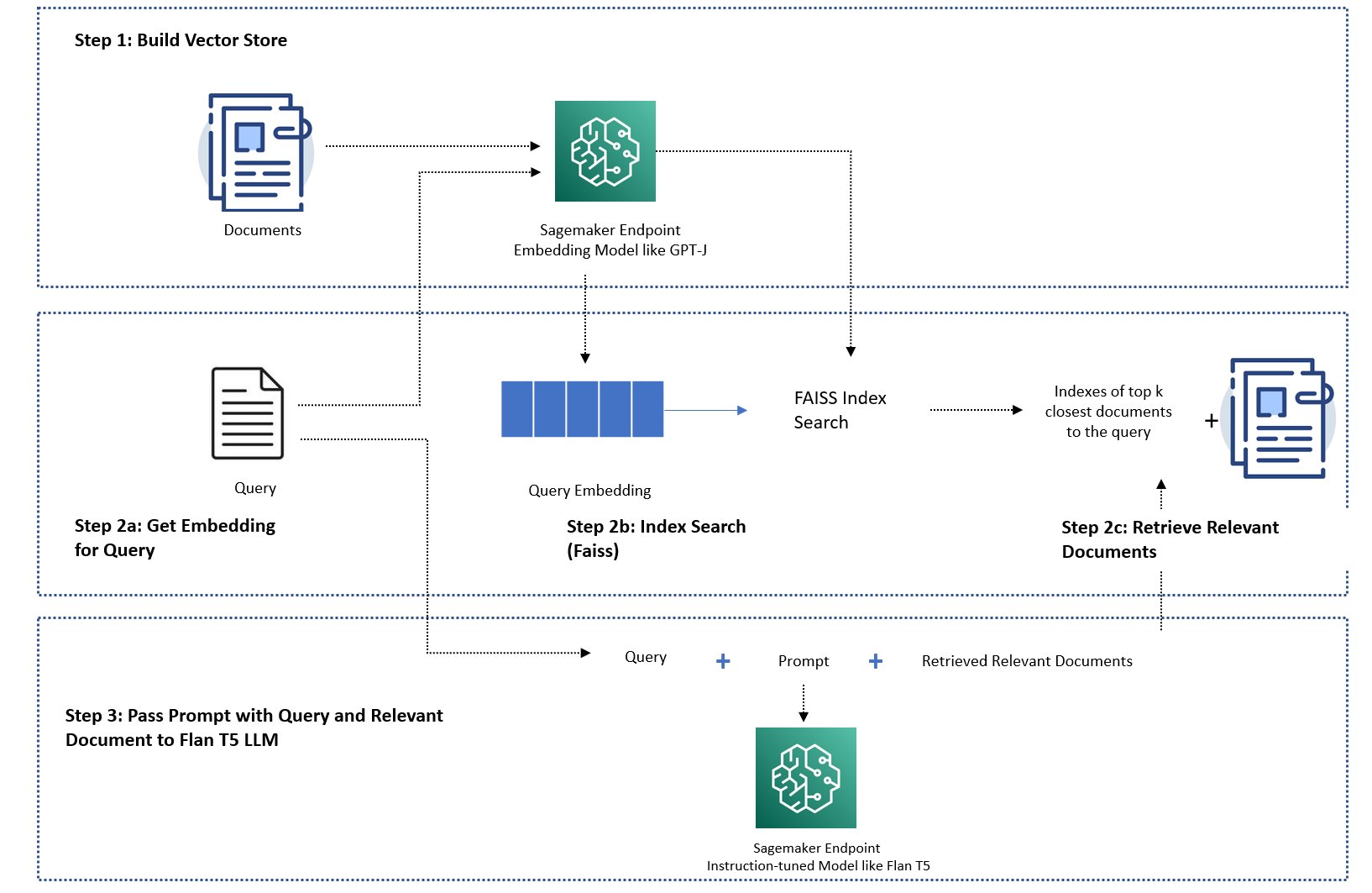

Ebben a bejegyzésben bemutatjuk, hogyan lehet megvalósítani egy kérdésre válaszoló alkalmazást a következő lépésekkel:

- A SageMaker GPT-J-6B beágyazási modellel beágyazást hozhat létre a tudáskönyvtárban lévő egyes dokumentumokhoz.

- A felhasználói lekérdezés alapján azonosítsa a legfontosabb K legfontosabb dokumentumot.

- A lekérdezéshez hozza létre a lekérdezés beágyazását ugyanazzal a beágyazási modellel.

- Keressen a beágyazási térben a legfontosabb K legrelevánsabb dokumentum indexei között a memórián belüli FAISS kereséssel.

- Használja az indexeket a megfelelő dokumentumok lekéréséhez.

- Használja a letöltött releváns dokumentumokat kontextusként a prompt és a kérdéshez, és küldje el őket a SageMaker LLM-nek a válasz generálásához.

A következő megközelítéseket mutatjuk be:

- Hogyan lehet megoldani egy kérdésre válaszoló feladatot a SageMaker LLM-ekkel, végpontok beágyazásával és a LangChain nyílt forráskódú könyvtárral néhány sornyi kóddal. Konkrétan két SageMaker végpontot használunk az LLM-hez (Flan T5 XXL) és a beágyazási modellhez (GPT-J 6B), és a használt vektoradatbázis a memóriában van. FAISS. További részletekért lásd a GitHub repo.

- Ha a memóriában lévő FAISS nem fér bele a nagy adathalmazba, akkor a SageMaker KNN algoritmus a szemantikai keresés végrehajtásához, amely szintén a FAISS-t használja alapul szolgáló keresési algoritmusként. A részletekért lásd a GitHub repo.

A következő ábra a megoldás architektúráját mutatja be.

JumpStart RAG-alapú implementációs notebook LangChainnel

LangChain egy nyílt forráskódú keretrendszer nyelvi modelleken alapuló alkalmazások fejlesztésére. A LangChain általános felületet biztosít számos különböző LLM számára. Ezenkívül megkönnyíti a fejlesztők számára a különböző LLM-ek összekapcsolását és hatékony alkalmazások létrehozását. A LangChain szabványos interfészt biztosít a memóriához és memóriamegvalósítások gyűjteményét az ügynökök vagy láncok hívásai közötti állapot megőrzéséhez.

A LangChain számos egyéb segédfunkcióval rendelkezik, amelyek növelhetik a fejlesztők termelékenységét. Ezek a szolgáltatások közé tartozik a prompt sablon, amely segít testreszabni a promptokat a prompt sablonban lévő változók használatával, ügynökök a végpontok közötti alkalmazások létrehozásához, indexek a lánc keresési és visszakeresési lépéseihez, és még sok más. A LangChain képességeinek további felfedezéséhez tekintse meg a LangChain dokumentáció.

LLM modell létrehozása

Első lépésként telepítse az Ön által választott JumpStart LLM modellt. Ebben a bemutatóban a Jumpstart Flan T5 XXL modell végpontját használjuk. A telepítési utasításokat lásd: Zero-shot felszólítás a Flan-T5 alapozó modellhez az Amazon SageMaker JumpStartban. A használati esettől függően más, utasításokkal hangolt modelleket is telepíthet, mint pl Flan T5 UL2 or BloomZ 7B1. Részletekért lásd a példafüzet.

A SageMaker LLM végpont LangChainnel való használatához használjuk langchain.llms.sagemaker_endpoint.SagemakerEndpoint, amely a SageMaker LLM végpontot absztrahálja. Átalakítást kell végrehajtanunk a kérés és a válasz hasznos adata számára, amint az a LangChain SageMaker integráció következő kódjában látható. Vegye figyelembe, hogy előfordulhat, hogy módosítania kell a kódot ContentHandler alapuló content_type és elfogadja az Ön által választott LLM-modell formátumát.

Hozza létre a beágyazási modellt

Ezután el kell készítenünk a beágyazott modellünket. Telepítjük a GPT-J 6B modell beágyazási modellként. Ha JumpStart beágyazási modellt használ, akkor testre kell szabnia a LangChain SageMaker végpont beágyazási osztályt, és átalakítania kell a modellkérést és választ a LangChainnel való integrációhoz. A részletes megvalósításhoz lásd a GitHub repo.

Töltsön be tartományspecifikus dokumentumokat a LangChain dokumentumbetöltővel, és hozzon létre egy indexet

Az általunk használt CSVLoader csomag a LangChainben a CSV-formátumú dokumentumok dokumentumbetöltőbe való betöltéséhez:

Ezt követően a TextSplitter segítségével előre feldolgozzuk az adatokat beágyazási célokra, és a SageMaker beágyazási modellt használjuk. GPT-J -6B a beágyazás létrehozásához. A beágyazást egy FAISS vektortárban tároljuk az index létrehozásához. Ezt az indexet arra használjuk, hogy olyan releváns dokumentumokat keressünk, amelyek szemantikailag hasonlóak a felhasználó lekérdezéséhez.

A következő kód megmutatja, hogyan hajtja végre ezeket a lépéseket a VectorstoreIndexCreator osztály mindössze néhány sornyi kóddal a LangChainben, hogy a RAG-val való kérdésmegválaszolás tömör megvalósítását hozza létre:

Használja az indexet a releváns kontextus kereséséhez, és adja át az LLM-modellnek

Ezután használja a lekérdezési metódust a létrehozott indexen, és adja át a felhasználó kérdését és a SageMaker LLM végpontját. A LangChain kiválasztja a legjobb négy legközelebbi dokumentumot (K=4), és átadja a dokumentumokból kinyert releváns kontextust, hogy pontos választ generáljon. Lásd a következő kódot:

A következő választ kapjuk a lekérdezésre a Flan T5 XXL RAG-alapú megközelítésével:

A válasz pontosabbnak tűnik ahhoz a válaszhoz, amelyet más korábban bemutatott megközelítésekkel kaptunk, amelyeknek nincs kontextusa vagy statikus kontextusa, amely esetleg nem mindig releváns.

Alternatív megközelítés a RAG megvalósításához több testreszabással a SageMaker és a LangChain használatával

Ebben a részben egy másik megközelítést mutatunk be a RAG megvalósításához a SageMaker és a LangChain használatával. Ez a megközelítés rugalmasságot kínál a legfontosabb K paraméterek konfigurálásához a dokumentumokban történő relevanciakereséshez. Lehetővé teszi a LangChain funkció használatát is prompt sablonok, amelyek lehetővé teszik a prompt létrehozásának egyszerű paraméterezését a promptok kemény kódolása helyett.

A következő kódban kifejezetten a FAISS-t használjuk a tudástárban lévő egyes dokumentumok beágyazásának létrehozására a SageMaker GPT-J-6B beágyazási modellel. Ezután azonosítjuk a legfontosabb K (K=3) legrelevánsabb dokumentumot a felhasználói lekérdezés alapján.

Ezután egy prompt sablont használunk, és láncoljuk a SageMaker LLM-hez:

Az általunk talált három legfontosabb (K=3) releváns dokumentumot elküldjük a prompthoz egy LangChain lánc segítségével:

Ezzel a RAG-megvalósítási megközelítéssel ki tudtuk használni a LangChain prompt sablonok további rugalmasságát, és testre szabhattuk a keresett dokumentumok számát a relevanciaegyezéshez a felső K hiperparaméter segítségével.

JumpStart RAG-alapú implementációs notebook a SageMaker KNN-nel

Ebben a részben a RAG-alapú megközelítést valósítjuk meg a KNN-algoritmus segítségével a releváns dokumentumok megkeresésére a továbbfejlesztett kontextus létrehozásához. Ebben a megközelítésben nem LangChaint használunk, hanem ugyanazt az adatkészletet Amazon SageMaker GYIK tudásdokumentumként, a GPT-J-6B és az LLM Flan T5 XXL modellek beágyazásával ugyanúgy, mint az előző LangChain megközelítésben.

Ha nagy adatkészlettel rendelkezik, a SageMaker KNN algoritmus hatékony szemantikai keresést biztosíthat. A SageMaker KNN algoritmus szintén a FAISS-t használja keresési algoritmusként. A megoldás jegyzetfüzete itt található GitHub.

Először az LLM Flan T5 XXL és GPT-J 6B beágyazó modelleket az előző részben leírtakhoz hasonlóan telepítjük. A tudásadatbázis minden rekordjához létrehozunk egy beágyazási vektort a GPT-J beágyazási modell segítségével.

Ezután használjuk a SageMaker KNN képzési feladat a tudásadatok beágyazásának indexeléséhez. Az adatok indexeléséhez használt algoritmus a következő FAISS. Szeretnénk megtalálni az öt legfontosabb dokumentumot, ezért beállítjuk a TOP_K változó 5-re. Létrehozzuk a KNN-algoritmus becslőjét, lefuttatjuk a betanítási feladatot, és telepítjük a KNN-modellt, hogy megtaláljuk a lekérdezésnek megfelelő öt legfontosabb dokumentum indexét. Lásd a következő kódot:

Ezután létrehozzuk a lekérdezés beágyazási reprezentációját a GPT-J-6B beágyazási modell segítségével, amelyet a tudáskönyvtár dokumentumok beágyazásának létrehozásához használtunk:

Ezután a KNN-végpontot használjuk, és átadjuk a lekérdezés beágyazását a KNN-végpontnak, hogy megkapjuk a legfontosabb K legrelevánsabb dokumentum indexeit. Az indexek segítségével lekérjük a megfelelő szöveges dokumentumokat. Ezután összefűzzük a dokumentumokat, ügyelve arra, hogy ne lépje túl a kontextus maximális megengedett hosszát. Lásd a következő kódot:

Most elérkeztünk az utolsó lépéshez, amelyben egyesítjük a lekérdezést, a promptot és a szöveget tartalmazó szövegkörnyezetet a releváns dokumentumokból, és átadjuk a szöveggeneráló LLM Flan T5 XXL modellnek a válasz generálásához.

A következő választ kapjuk a lekérdezésre a Flan T5 XXL RAG-alapú megközelítésével:

Tisztítsuk meg

Ügyeljen arra, hogy törölje a jegyzetfüzetben létrehozott végpontokat, amikor nem használja őket, hogy elkerülje a költségek ismétlődését.

Következtetés

Ebben a bejegyzésben egy RAG-alapú megközelítés megvalósítását mutattuk be LLM-ekkel a kérdésmegválaszolási feladatokhoz kétféle megközelítéssel: LangChain és a beépített KNN algoritmus. A RAG-alapú megközelítés optimalizálja a szöveggenerálás pontosságát a Flan T5 XXL használatával azáltal, hogy dinamikusan biztosít releváns kontextust, amelyet a dokumentumok listájának keresésével hoztak létre.

Ezeket a jegyzetfüzeteket úgy használhatja a SageMakerben, ahogy vannak, vagy testreszabhatja őket igényei szerint. A testreszabáshoz használhatja saját dokumentumkészletét a tudástárban, használhat más relevanciakeresési megvalósításokat, például az OpenSearch-t, és használhat más beágyazási modelleket és szöveggeneráló LLM-eket, amelyek elérhetők a JumpStartban.

Kíváncsian várjuk, hogy mit épít a JumpStart-ra RAG-alapú megközelítéssel!

A szerzőkről

Dr. Xin Huang az Amazon SageMaker JumpStart és az Amazon SageMaker beépített algoritmusainak vezető alkalmazott tudósa. A skálázható gépi tanulási algoritmusok fejlesztésére összpontosít. Kutatási területe a természetes nyelvi feldolgozás, a táblázatos adatok magyarázható mély tanulása és a nem-paraméteres tér-idő klaszterezés robusztus elemzése. Számos közleményt publikált az ACL-ben, az ICDM-ben, a KDD konferenciákon és a Royal Statistical Society: A sorozatban.

Dr. Xin Huang az Amazon SageMaker JumpStart és az Amazon SageMaker beépített algoritmusainak vezető alkalmazott tudósa. A skálázható gépi tanulási algoritmusok fejlesztésére összpontosít. Kutatási területe a természetes nyelvi feldolgozás, a táblázatos adatok magyarázható mély tanulása és a nem-paraméteres tér-idő klaszterezés robusztus elemzése. Számos közleményt publikált az ACL-ben, az ICDM-ben, a KDD konferenciákon és a Royal Statistical Society: A sorozatban.

Rachna Chadha az AWS stratégiai számláinak fő megoldástervezője, az AI/ML. Rachna optimista, aki hisz abban, hogy az AI etikus és felelős használata javíthatja a társadalmat a jövőben, és gazdasági és társadalmi jólétet hozhat. Szabadidejében Rachna szereti a családjával tölteni az idejét, túrázni és zenét hallgatni.

Rachna Chadha az AWS stratégiai számláinak fő megoldástervezője, az AI/ML. Rachna optimista, aki hisz abban, hogy az AI etikus és felelős használata javíthatja a társadalmat a jövőben, és gazdasági és társadalmi jólétet hozhat. Szabadidejében Rachna szereti a családjával tölteni az idejét, túrázni és zenét hallgatni.

Dr. Kyle Ulrich Alkalmazott tudós, az Amazon SageMaker beépített algoritmuscsapatával. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Kyle Ulrich Alkalmazott tudós, az Amazon SageMaker beépített algoritmuscsapatával. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Hemant Singh gépi tanulási mérnök, aki tapasztalattal rendelkezik az Amazon SageMaker JumpStart és az Amazon SageMaker beépített algoritmusaiban. Mesterképzését a Courant Institute of Mathematical Sciences-ben, a B.Tech-et pedig az IIT Delhiben szerezte. Tapasztalattal rendelkezett a gépi tanulás sokféle problémáján a természetes nyelvi feldolgozás, a számítógépes látás és az idősorelemzés területén.

Hemant Singh gépi tanulási mérnök, aki tapasztalattal rendelkezik az Amazon SageMaker JumpStart és az Amazon SageMaker beépített algoritmusaiban. Mesterképzését a Courant Institute of Mathematical Sciences-ben, a B.Tech-et pedig az IIT Delhiben szerezte. Tapasztalattal rendelkezett a gépi tanulás sokféle problémáján a természetes nyelvi feldolgozás, a számítógépes látás és az idősorelemzés területén.

Manas Dadarkar egy szoftverfejlesztési menedzser, aki az Amazon Forecast szolgáltatás tervezési részlegének tulajdonosa. Szenvedélyesen törekszik a gépi tanulás alkalmazásaira, és arra, hogy az ML technológiákat mindenki számára könnyen elérhetővé tegye, hogy átvehesse és üzembe helyezze a termelésben. A munkán kívül számos érdeklődési köre van, beleértve az utazást, az olvasást, valamint a barátokkal és családdal eltöltött időt.

Manas Dadarkar egy szoftverfejlesztési menedzser, aki az Amazon Forecast szolgáltatás tervezési részlegének tulajdonosa. Szenvedélyesen törekszik a gépi tanulás alkalmazásaira, és arra, hogy az ML technológiákat mindenki számára könnyen elérhetővé tegye, hogy átvehesse és üzembe helyezze a termelésben. A munkán kívül számos érdeklődési köre van, beleértve az utazást, az olvasást, valamint a barátokkal és családdal eltöltött időt.

Dr. Ashish Khetan vezető alkalmazott tudós az Amazon SageMaker beépített algoritmusaival, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.

Dr. Ashish Khetan vezető alkalmazott tudós az Amazon SageMaker beépített algoritmusaival, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoAiStream. Web3 adatintelligencia. Felerősített tudás. Hozzáférés itt.

- A jövő pénzverése – Adryenn Ashley. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/question-answering-using-retrieval-augmented-generation-with-foundation-models-in-amazon-sagemaker-jumpstart/

- :van

- :is

- :nem

- :ahol

- $ UP

- 1

- 10

- 100

- 11

- 12

- 13

- 26%

- 500

- 7

- 8

- 9

- a

- Képes

- Rólunk

- absztraktokat

- gyorsul

- elfogadja

- igénybe vett

- Fiókok

- pontosság

- pontos

- aktív

- hozzá

- hozzáadott

- hozzáadásával

- mellett

- További

- Hozzáteszi

- elfogadja

- Előny

- előnyei

- szerek

- AI

- AI / ML

- AL

- algoritmus

- algoritmusok

- Minden termék

- lehetővé teszi, hogy

- mentén

- Is

- mindig

- amazon

- Amazon előrejelzés

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Összegek

- an

- elemzés

- és a

- bejelent

- Másik

- válasz

- válaszok

- API-k

- Alkalmazás

- alkalmazások

- alkalmazott

- alkalmaz

- megközelítés

- megközelít

- építészet

- VANNAK

- TERÜLET

- cikkben

- AS

- At

- bővített

- elérhetőség

- elérhető

- elkerülése érdekében

- AWS

- alapján

- bayesi

- BE

- mert

- úgy gondolja,

- Jobb

- között

- Bot

- hoz

- épít

- beépített

- üzleti

- de

- by

- hívott

- kéri

- TUD

- képességek

- eset

- esetek

- lánc

- láncok

- kihívás

- Változások

- chatbot

- választás

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- osztály

- csoportosítás

- kód

- Kódolás

- gyűjtemény

- össze

- hogyan

- vállalat

- hasonló

- képest

- befejezés

- számítógép

- Számítógépes látás

- koncepció

- fogalmi

- konferenciák

- korlátok

- tartalmaz

- kontextus

- Beszélgetés

- megtérít

- átalakított

- kijavítására

- Megfelelő

- Költség

- Covid-19

- teremt

- készítette

- létrehozása

- teremtés

- Jelenleg

- testreszabás

- testre

- dátum

- adat-tudomány

- adatbázis

- adatbázisok

- mély

- mély tanulás

- Delhi

- bizonyítani

- igazolták

- attól

- telepíteni

- telepített

- bevetés

- leírni

- részletes

- részletek

- Fejleszt

- Fejlesztő

- fejlesztők

- fejlesztése

- Fejlesztés

- DID

- különbség

- különböző

- tárgyalt

- számos

- dokumentum

- dokumentumok

- Nem

- Ennek

- domain

- csinált

- Herceg

- herceg egyetem

- dinamikusan

- E&T

- minden

- Korábban

- könnyebb

- könnyen

- Hatékony

- beágyazott

- beágyazás

- lehetővé teszi

- végtől végig

- Endpoint

- mérnök

- Mérnöki

- fokozott

- biztosítása

- Vállalkozás

- lényegében

- etikai

- Még

- mindenki

- példa

- meghaladta

- tapasztalat

- feltárása

- külső

- család

- Funkció

- Jellemzők

- Fed

- kevés

- filé

- utolsó

- Találjon

- megtalálása

- vezetéknév

- megfelelő

- rögzített

- Rugalmasság

- áramlási

- koncentrál

- következő

- A

- Előrejelzés

- formátum

- Előre

- talált

- Alapítvány

- négy

- Keretrendszer

- gyakori

- gyakran

- barátok

- ból ből

- további

- jövő

- általános

- generál

- generált

- generáló

- generáció

- kap

- adott

- nagy

- kellett

- Kemény

- Legyen

- he

- Egészség

- egészségbiztosítás

- segít

- segít

- neki

- Magas

- övé

- Találat

- Hogyan

- How To

- azonban

- HTML

- HTTPS

- Kerékagy

- i

- azonosított

- azonosítani

- if

- Illinois

- kép

- Hatások

- végre

- végrehajtás

- importál

- javul

- in

- tartalmaz

- Beleértve

- index

- indexek

- információ

- példa

- helyette

- Intézet

- utasítás

- biztosítás

- integrálni

- integráció

- érdekek

- Felület

- bele

- Bevezetett

- IT

- ITS

- Munka

- utazás

- jpg

- json

- éppen

- tudás

- nyelv

- nagy

- nagyarányú

- nagyobb

- legutolsó

- vezető

- tanulás

- Hossz

- könyvtár

- mint

- Kedvencek

- korlátozás

- korlátozások

- Korlátozott

- határértékek

- vonalak

- Lista

- Kihallgatás

- LLM

- kiszámításának

- rakodó

- helyszínek

- néz

- keres

- MEGJELENÉS

- Elő/Utó

- gép

- gépi tanulás

- fenntartása

- csinál

- KÉSZÍT

- Gyártás

- sikerült

- menedzser

- sok

- piacára

- Mérkőzés

- egyező

- matematikai

- maximális

- Lehet..

- Memory design

- módszer

- ML

- modell

- modellek

- több

- a legtöbb

- sok

- többszörös

- zene

- Természetes

- Természetes nyelvi feldolgozás

- Szükség

- szükséges

- igények

- következő

- nem

- jegyzetfüzet

- Most

- szám

- of

- Ajánlatok

- Nem elérhető

- on

- csak

- nyílt forráskódú

- Optimalizálja

- or

- eredeti

- Más

- mi

- teljesítmény

- kívül

- átfogó

- saját

- csomag

- papírok

- paraméterek

- rész

- különös

- elhalad

- Elmúlt

- bérletek

- szenvedélyes

- Teljesít

- tervek

- Plató

- Platón adatintelligencia

- PlatoData

- Népszerű

- állás

- powered

- erős

- Tippek

- Predictor

- előző

- Fő

- Probléma

- problémák

- Folyamatok

- feldolgozás

- Termékek

- Termelés

- termelékenység

- jólét

- ad

- feltéve,

- biztosít

- amely

- közzétett

- célokra

- lekérdezések

- kérdés

- Kérdések

- gyorsan

- hatótávolság

- Inkább

- Olvasás

- kész

- igazi

- rekord

- tükröznie

- régiók

- raktár

- képviselet

- kérni

- kutatás

- kutató

- válasz

- válaszok

- felelős

- Eredmények

- visszatérés

- erős

- királyi

- szabályok

- futás

- sagemaker

- azonos

- Megtakarítás

- skálázható

- forgatókönyvek

- Tudomány

- TUDOMÁNYOK

- Tudós

- Keresés

- keres

- Rész

- szakaszok

- lát

- látás

- kiválasztott

- MAGA

- küld

- idősebb

- Sorozat

- Series of

- A sorozat

- szolgáltatás

- Szolgáltatások

- készlet

- kellene

- előadás

- mutatott

- Műsorok

- hasonló

- Méret

- So

- Közösség

- Társadalom

- szoftver

- szoftverfejlesztés

- megoldások

- SOLVE

- Források

- Hely

- különleges

- sebesség

- Költési

- Spot

- standard

- kezdődött

- Állami

- statisztikai

- Lépés

- Lépései

- Még mindig

- tárolni

- memorizált

- Stratégiai

- előfizetések

- ilyen

- ellátó

- támogatás

- Támogatott

- Vesz

- Feladat

- feladatok

- csapat

- tech

- Technologies

- sablon

- sablonok

- mint

- hogy

- A

- A terület

- az információ

- Az állam

- azok

- Őket

- akkor

- Ott.

- ebből adódóan

- Ezek

- ők

- ezt

- három

- idő

- Idősorok

- nak nek

- együtt

- felső

- Vonat

- kiképzett

- Képzések

- Átalakítás

- Átalakítás

- kipróbált

- kettő

- mögöttes

- egyedi

- egyetemi

- up-to-date

- Frissítések

- frissítve

- Használat

- használ

- használati eset

- használt

- használó

- Felhasználók

- segítségével

- rendszerint

- hasznosság

- különféle

- Tényleges

- virtuális gép

- látomás

- akar

- volt

- Út..

- módon

- we

- voltak

- Mit

- amikor

- ami

- míg

- WHO

- Wikipedia

- lesz

- val vel

- belül

- Munka

- dolgozó

- lenne

- te

- A te

- zephyrnet