Ini adalah postingan tamu oleh AK Roy dari Qualcomm AI.

Amazon Elastic Compute Cloud (Amazon EC2) Instans DL2q, yang didukung oleh akselerator Qualcomm AI 100 Standard, dapat digunakan untuk menerapkan beban kerja pembelajaran mendalam (DL) di cloud dengan biaya yang efisien. Mereka juga dapat digunakan untuk mengembangkan dan memvalidasi performa dan keakuratan beban kerja DL yang akan diterapkan pada perangkat Qualcomm. Instans DL2q adalah instans pertama yang menghadirkan teknologi kecerdasan buatan (AI) Qualcomm ke cloud.

Dengan delapan akselerator Qualcomm AI 100 Standard dan total memori akselerator 128 GiB, pelanggan juga dapat menggunakan instans DL2q untuk menjalankan aplikasi AI generatif yang populer, seperti pembuatan konten, peringkasan teks, dan asisten virtual, serta aplikasi AI klasik untuk pemrosesan bahasa alami dan visi komputer. Selain itu, akselerator Qualcomm AI 100 menghadirkan teknologi AI yang sama dengan yang digunakan pada ponsel pintar, kendaraan otonom, komputer pribadi, dan headset realitas yang diperluas, sehingga instans DL2q dapat digunakan untuk mengembangkan dan memvalidasi beban kerja AI ini sebelum diterapkan.

Sorotan instans DL2q baru

Setiap instans DL2q menggabungkan delapan akselerator Qualcomm Cloud AI100, dengan kinerja agregat lebih dari 2.8 PetaOps kinerja inferensi Int8 dan 1.4 PetaFlops kinerja inferensi FP16. Mesin virtual ini memiliki total 112 inti AI, kapasitas memori akselerator sebesar 128 GB, dan bandwidth memori sebesar 1.1 TB per detik.

Setiap instans DL2q memiliki 96 vCPU, kapasitas memori sistem sebesar 768 GB dan mendukung bandwidth jaringan 100 Gbps serta Toko Blok Amazon Elastic (Amazon EBS) penyimpanan 19 Gbps.

| Nama instansi | vCPU | Akselerator Cloud AI100 | Memori akselerator | Memori akselerator BW (agregat) | Memori contoh | Jaringan contoh | Bandwidth penyimpanan (Amazon EBS). |

| DL2q.24xbesar | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Inovasi akselerator Qualcomm Cloud AI100

System-on-chip (SoC) akselerator Cloud AI100 adalah arsitektur multi-core yang dirancang khusus dan dapat diskalakan, mendukung berbagai kasus penggunaan pembelajaran mendalam mulai dari pusat data hingga edge. SoC ini menggunakan inti komputasi skalar, vektor, dan tensor dengan kapasitas SRAM on-die yang terdepan di industri sebesar 126 MB. Inti-inti tersebut saling terhubung dengan mesh network-on-chip (NoC) dengan bandwidth tinggi dan latensi rendah.

Akselerator AI100 mendukung beragam model dan kasus penggunaan. Tabel di bawah menyoroti kisaran dukungan model.

| Kategori model | Jumlah model | Contoh |

| NLP | 157 | BERT, BART, FasterTransformer, T5, kode Z MOE |

| AI Generatif – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| AI Generatif – Gambar | 3 | Difusi stabil v1.5 dan v2.1, OpenAI CLIP |

| CV – Klasifikasi gambar | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Deteksi objek | 23 | YOLO v2, v3, v4, v5, dan v7, SSD-ResNet, RetinaNet |

| CV – Lainnya | 15 | LPRNet, Resolusi super/SRGAN, ByteTrack |

| Jaringan otomotif* | 53 | Persepsi dan LIDAR, pejalan kaki, jalur, dan deteksi lampu lalu lintas |

| Total | > 300 ,war | ,war |

* Sebagian besar jaringan otomotif adalah jaringan komposit yang terdiri dari perpaduan jaringan individual.

SRAM on-die yang besar pada akselerator DL2q memungkinkan penerapan teknik kinerja tingkat lanjut yang efisien seperti presisi eksponen mikro MX6 untuk menyimpan bobot dan presisi eksponen mikro MX9 untuk komunikasi akselerator-ke-akselerator. Teknologi mikro-eksponen dijelaskan dalam pengumuman industri Open Compute Project (OCP) berikut: AMD, Arm, Intel, Meta, Microsoft, NVIDIA, dan Qualcomm Menstandarkan Format Data Presisi Sempit Generasi Berikutnya untuk AI » Proyek Open Compute.

Pengguna instance dapat menggunakan strategi berikut untuk memaksimalkan kinerja per biaya:

- Simpan bobot menggunakan presisi mikro-eksponen MX6 di memori DDR pada akselerator. Penggunaan presisi MX6 memaksimalkan pemanfaatan kapasitas memori yang tersedia dan bandwidth memori untuk menghasilkan throughput dan latensi terbaik di kelasnya.

- Lakukan komputasi dalam FP16 untuk memberikan akurasi kasus penggunaan yang diperlukan, sambil menggunakan SRAM on-chip yang unggul dan TOP cadangan pada kartu, untuk mengimplementasikan kernel MX6 hingga FP16 berlatensi rendah berkinerja tinggi.

- Gunakan strategi batching yang dioptimalkan dan ukuran batch yang lebih tinggi dengan menggunakan SRAM on-chip besar yang tersedia untuk memaksimalkan penggunaan kembali bobot, sekaligus mempertahankan aktivasi on-chip semaksimal mungkin.

DL2q AI Stack dan rantai alat

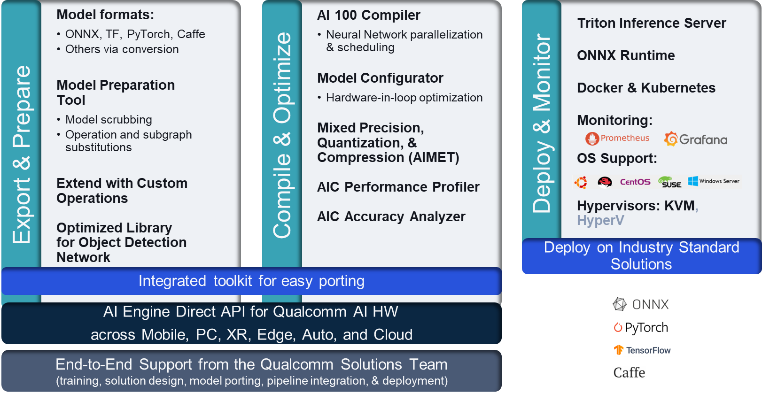

Instans DL2q disertai dengan Qualcomm AI Stack yang memberikan pengalaman pengembang yang konsisten di seluruh Qualcomm AI di cloud dan produk Qualcomm lainnya. Tumpukan AI Qualcomm dan teknologi AI dasar yang sama berjalan pada instans DL2q dan perangkat edge Qualcomm, memberikan pelanggan pengalaman pengembang yang konsisten, dengan API terpadu di seluruh lingkungan pengembangan cloud, otomotif, komputer pribadi, extended reality, dan ponsel cerdas mereka.

Toolchain memungkinkan pengguna instans untuk dengan cepat melakukan onboarding model yang telah dilatih sebelumnya, mengkompilasi dan mengoptimalkan model untuk kemampuan instans, dan selanjutnya menerapkan model yang dikompilasi untuk kasus penggunaan inferensi produksi dalam tiga langkah yang ditunjukkan pada gambar berikut.

Untuk mempelajari lebih lanjut tentang menyetel performa model, lihat Parameter Kinerja Utama Cloud AI 100 Dokumentasi.

Memulai instans DL2q

Dalam contoh ini, Anda mengkompilasi dan menyebarkan yang telah dilatih sebelumnya model BERT dari Wajah Memeluk pada instans DL2q EC2 menggunakan AMI DL2q yang telah dibuat sebelumnya, dalam empat langkah.

Anda dapat menggunakan yang sudah dibuat sebelumnya Qualcomm DLAMI pada instans atau mulai dengan AMI Amazon Linux2 dan buat AMI DL2q Anda sendiri dengan Platform Cloud AI 100 dan SDK Aplikasi yang tersedia di sini Layanan Penyimpanan Sederhana Amazon (Amazon S3) keranjang: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

Langkah-langkah selanjutnya menggunakan DL2q AMI bawaan, Qualcomm Basis AL2 DLAMI.

Gunakan SSH untuk mengakses instans DL2q Anda dengan Qualcomm Base AL2 DLAMI AMI dan ikuti langkah 1 hingga 4.

Langkah 1. Siapkan lingkungan dan instal paket yang diperlukan

- Instal Python 3.8.

- Siapkan lingkungan virtual Python 3.8.

- Aktifkan lingkungan virtual Python 3.8.

- Instal paket yang diperlukan, seperti yang ditunjukkan di dokumen persyaratan.txt tersedia di situs Github publik Qualcomm.

- Impor perpustakaan yang diperlukan.

Langkah 2. Impor modelnya

- Impor dan tokenisasi model.

- Tentukan masukan sampel dan ekstrak

inputIdsdanattentionMask. - Ubah model menjadi ONNX, yang kemudian dapat diteruskan ke kompiler.

- Anda akan menjalankan model dengan presisi FP16. Jadi, Anda perlu memeriksa apakah model tersebut berisi konstanta di luar rentang FP16. Meneruskan model ke

fix_onnx_fp16berfungsi untuk menghasilkan file ONNX baru dengan perbaikan yang diperlukan.

Langkah 3. Kompilasi modelnya

Grafik qaic-exec alat kompiler antarmuka baris perintah (CLI) digunakan untuk mengkompilasi model. Masukan ke kompiler ini adalah file ONNX yang dihasilkan pada langkah 2. Kompiler menghasilkan file biner (disebut QPC, Untuk Wadah program Qualcomm) di jalur yang ditentukan oleh -aic-binary-dir argumen.

Dalam perintah kompilasi di bawah, Anda menggunakan empat inti komputasi AI dan satu ukuran batch untuk mengkompilasi model.

QPC dihasilkan di bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc folder.

Langkah 4. Jalankan modelnya

Siapkan sesi untuk menjalankan inferensi pada akselerator Qualcomm Cloud AI100 di instance DL2q.

Pustaka Qualcomm qaic Python adalah sekumpulan API yang menyediakan dukungan untuk menjalankan inferensi pada akselerator Cloud AI100.

- Gunakan panggilan Session API untuk membuat instance sesi. Panggilan Session API adalah titik masuk untuk menggunakan pustaka qaic Python.

- Susun ulang data dari buffer keluaran dengan

output_shapedanoutput_type. - Decode output yang dihasilkan.

Berikut adalah keluaran kalimat masukan “Anjing [MASK] di atas matras”.

Itu dia. Hanya dengan beberapa langkah, Anda mengkompilasi dan menjalankan model PyTorch pada instans DL2q Amazon EC2. Untuk mempelajari lebih lanjut tentang orientasi dan kompilasi model pada instans DL2q, lihat Dokumentasi Tutorial Cloud AI100.

Untuk mempelajari lebih lanjut tentang arsitektur model DL mana yang cocok untuk instans AWS DL2q dan matriks dukungan model saat ini, lihat Dokumentasi Qualcomm Cloud AI100.

Tersedia sekarang

Anda dapat meluncurkan instans DL2q hari ini di Wilayah AWS AS Barat (Oregon) dan Eropa (Frankfurt) sebagai Sesuai permintaan, Pendiam, dan Instans Spot, atau sebagai bagian dari a Rencana Tabungan. Seperti biasa dengan Amazon EC2, Anda hanya membayar sesuai penggunaan. Untuk informasi lebih lanjut, lihat Harga Amazon EC2.

Instans DL2q dapat disebarkan menggunakan AWS Deep Learning AMI (DLAMI), dan gambar kontainer tersedia melalui layanan terkelola seperti Amazon SageMaker, Layanan Amazon Elastic Kubernetes (Amazon EKS), Layanan Kontainer Elastis Amazon (Amazon ECS), dan Kluster Paralel AWS.

Untuk mempelajari lebih lanjut, kunjungi Instans DL2q Amazon EC2 halaman, dan kirimkan masukan ke AWS re:Posting untuk EC2 atau melalui kontak AWS Support Anda yang biasa.

Tentang penulis

AK Roy adalah Direktur Manajemen Produk di Qualcomm, untuk produk dan solusi AI Cloud dan Pusat Data. Dia memiliki pengalaman lebih dari 20 tahun dalam strategi dan pengembangan produk, dengan fokus saat ini pada kinerja terbaik di kelasnya dan solusi kinerja/$ end-to-end untuk inferensi AI di Cloud, untuk berbagai kasus penggunaan, termasuk GenAI, LLM, Auto dan Hybrid AI.

AK Roy adalah Direktur Manajemen Produk di Qualcomm, untuk produk dan solusi AI Cloud dan Pusat Data. Dia memiliki pengalaman lebih dari 20 tahun dalam strategi dan pengembangan produk, dengan fokus saat ini pada kinerja terbaik di kelasnya dan solusi kinerja/$ end-to-end untuk inferensi AI di Cloud, untuk berbagai kasus penggunaan, termasuk GenAI, LLM, Auto dan Hybrid AI.

Jianying Lang adalah Arsitek Solusi Utama di AWS Worldwide Specialist Organization (WWSO). Dia memiliki lebih dari 15 tahun pengalaman kerja di bidang HPC dan AI. Di AWS, dia fokus membantu pelanggan menerapkan, mengoptimalkan, dan menskalakan beban kerja AI/ML mereka pada instans komputasi yang dipercepat. Dia bersemangat menggabungkan teknik di bidang HPC dan AI. Jianying meraih gelar PhD di bidang Fisika Komputasi dari University of Colorado di Boulder.

Jianying Lang adalah Arsitek Solusi Utama di AWS Worldwide Specialist Organization (WWSO). Dia memiliki lebih dari 15 tahun pengalaman kerja di bidang HPC dan AI. Di AWS, dia fokus membantu pelanggan menerapkan, mengoptimalkan, dan menskalakan beban kerja AI/ML mereka pada instans komputasi yang dipercepat. Dia bersemangat menggabungkan teknik di bidang HPC dan AI. Jianying meraih gelar PhD di bidang Fisika Komputasi dari University of Colorado di Boulder.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :memiliki

- :adalah

- $NAIK

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 tahun

- 15%

- 17

- 19

- 20

- 20 tahun

- 22

- 23

- 7

- 75

- 8

- 84

- a

- Tentang Kami

- atas

- dipercepat

- akselerator

- akselerator

- mengakses

- disertai

- ketepatan

- di seluruh

- aktivasi

- Selain itu

- maju

- agregat

- AI

- AI / ML

- Semua

- juga

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- dan

- Pengumuman

- Apa pun

- api

- Lebah

- aplikasi

- aplikasi

- arsitektur

- ADALAH

- argumen

- ARM

- buatan

- AS

- asisten

- At

- mobil

- otomotif

- otonom

- tersedia

- AWS

- kapak

- Bandwidth

- mendasarkan

- BE

- sebelum

- di bawah

- Luar

- BIN

- Memblokir

- Berkembang

- membawa

- luas

- penyangga

- membangun

- by

- panggilan

- bernama

- CAN

- kemampuan

- Kapasitas

- kartu

- kasus

- memeriksa

- klasik

- awan

- Colorado

- menggabungkan

- Komunikasi

- luas

- komputasi

- menghitung

- komputer

- Visi Komputer

- komputer

- komputasi

- konsisten

- Terdiri dari

- kontak

- Wadah

- mengandung

- Konten

- Pembuatan Konten

- membuat

- terbaru

- pelanggan

- data

- Datacenter

- mendalam

- belajar mendalam

- didefinisikan

- Derajat

- menyampaikan

- memberikan

- menyebarkan

- dikerahkan

- penyebaran

- dijelaskan

- mengembangkan

- Pengembang

- Pengembangan

- alat

- Devices

- Difusi

- Kepala

- dokumentasi

- Anjing

- penggerak

- dinamis

- Tepi

- efisien

- antara

- mempekerjakan

- memungkinkan

- ujung ke ujung

- masuk

- Lingkungan Hidup

- lingkungan

- Eropa

- contoh

- pengalaman

- kenyataan yang diperluas

- ekstrak

- palsu

- Fitur

- umpan balik

- beberapa

- bidang

- Fields

- Angka

- File

- Pertama

- cocok

- Fokus

- berfokus

- mengikuti

- berikut

- Untuk

- ditemukan

- empat

- Frankfurt

- dari

- fungsi

- fusi

- umumnya

- menghasilkan

- dihasilkan

- generasi

- generatif

- AI generatif

- GitHub

- diberikan

- baik

- Tamu

- tamu Post

- he

- headset

- membantu

- di sini

- kinerja tinggi

- lebih tinggi

- highlight

- memegang

- HPC

- HTML

- HTTPS

- Hibrida

- i

- BEI

- if

- gambar

- gambar

- melaksanakan

- implementasi

- mengimpor

- in

- Termasuk

- menggabungkan

- sendiri-sendiri

- industri

- industri terkemuka

- informasi

- memasukkan

- install

- contoh

- Intel

- Cerdas

- saling berhubungan

- Antarmuka

- IT

- jpg

- hanya

- kunci

- Jalur

- bahasa

- besar

- Latensi

- jalankan

- BELAJAR

- pengetahuan

- perpustakaan

- Perpustakaan

- cahaya

- baris

- beban

- berhasil

- pengelolaan

- masker

- Matriks

- max

- Maksimalkan

- memaksimalkan

- maksimum

- Memori

- jala

- meta

- Microsoft

- menit

- model

- model

- dimodifikasi

- lebih

- paling

- nama

- sempit

- Alam

- Pengolahan Bahasa alami

- perlu

- Perlu

- jaringan

- jaringan

- jaringan

- New

- generasi selanjutnya

- sekarang

- mati rasa

- Nvidia

- obyek

- of

- on

- Di atas kapal

- Onboarding

- ONE

- hanya

- Buka

- OpenAI

- Optimize

- dioptimalkan

- or

- Oregon

- organisasi

- OS

- Lainnya

- di luar

- keluaran

- output

- lebih

- sendiri

- paket

- halaman

- bagian

- lulus

- Lulus

- bergairah

- path

- Membayar

- untuk

- prestasi

- pribadi

- phd

- Fisika

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- Populer

- mungkin

- Pos

- didukung

- Ketelitian

- sebelumnya

- Utama

- pengolahan

- Diproduksi

- menghasilkan

- Produk

- manajemen Produk

- Produksi

- Produk

- program

- proyek

- menyediakan

- menyediakan

- publik

- Ular sanca

- pytorch

- Qualcomm

- segera

- jarak

- RE

- Bacaan

- Kenyataan

- daerah

- wajib

- Persyaratan

- penahan

- kembali

- menggunakan kembali

- roy

- Run

- berjalan

- berjalan

- sama

- Save

- penghematan

- terukur

- Skala

- SDK

- Kedua

- melihat

- mengirim

- putusan pengadilan

- Urutan

- layanan

- Layanan

- Sidang

- set

- dia

- ditunjukkan

- Sederhana

- menyederhanakan

- situs web

- Ukuran

- smartphone

- smartphone

- So

- Solusi

- ketegangan

- spesialis

- tumpukan

- standar

- awal

- mulai

- Langkah

- Tangga

- penyimpanan

- menyimpan

- menyimpan

- Penyelarasan

- Kemudian

- seperti itu

- unggul

- mendukung

- pendukung

- Mendukung

- SYS

- sistem

- tabel

- teknik

- Teknologi

- teks

- bahwa

- Grafik

- mereka

- kemudian

- Ini

- mereka

- ini

- tiga

- Melalui

- keluaran

- melalui

- untuk

- hari ini

- tokenisasi

- alat

- tops

- obor

- Total

- lalu lintas

- terlatih

- transformer

- benar

- menyetel

- tutorial

- terpadu

- universitas

- us

- menggunakan

- gunakan case

- kasus penggunaan

- bekas

- Pengguna

- menggunakan

- biasa

- v1

- MENGESAHKAN

- nilai

- maya

- penglihatan

- Mengunjungi

- we

- jaringan

- layanan web

- BAIK

- Barat

- Apa

- yang

- sementara

- lebar

- Rentang luas

- akan

- dengan

- Word

- kerja

- industri udang di seluruh dunia.

- tahun

- Kamu

- Anda

- zephyrnet.dll