Data Pengguna: Makanan Vital LLM

Ya! RT @bryce suka kutipan ini “Jika Anda tidak membayarnya, Anda bukanlah pelanggannya; Andalah produk yang dijual.” http://bit.ly/93JYCJ

— Tim O'Reilly (@timoreilly) September 2, 2010

Tetap di atas berita crypto, dapatkan pembaruan harian di kotak masuk Anda.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :memiliki

- :adalah

- :bukan

- 7

- 8

- a

- kemampuan

- Mutlak

- Menurut

- tepat

- beradaptasi

- menangani

- Menambahkan

- maju

- silam

- setuju

- AI

- Layanan AI

- Sistem AI

- bertujuan

- Alexa

- Rata

- Semua

- memungkinkan

- juga

- selalu

- Amazon

- an

- dan

- Antropik

- mengharapkan

- Apa pun

- berlaku

- ADALAH

- AS

- menganggap

- At

- tersedia

- menghindari

- sadar

- berdasarkan

- BE

- karena

- makhluk

- diyakini

- bermanfaat

- Lebih baik

- antara

- by

- CAN

- klaim

- klien

- komersial

- komitmen

- melakukan

- Perusahaan

- perusahaan

- kompetitif

- konsep

- Kekhawatiran

- terus-menerus

- Konten

- konteks

- terus-menerus

- kontrol

- Mudah

- percakapan

- hak cipta

- bisa

- sangat penting

- kripto

- Berita Kripto

- terbaru

- pelanggan

- pelanggan

- harian

- gelap

- data

- privasi data

- perdebatan

- dekade

- Dekripsi

- mendalam

- belajar mendalam

- Default

- Membela

- mengantarkan

- tergantung

- penolakan

- perselisihan

- Keragaman

- do

- dokumen

- tidak

- dolar

- Dont

- selama

- Produktif

- Tepi

- efektivitas

- antara

- interaksi

- meningkatkan

- Memastikan

- penting

- etis

- etika

- contoh

- Pasar Valas

- pengalaman

- luas

- tingkat

- luar

- menghadapi

- Untuk

- Bekas

- Didirikan di

- Gratis

- dari

- mendapatkan

- menghasilkan

- dihasilkan

- menghasilkan

- generatif

- AI generatif

- mendapatkan

- mendapatkan

- raksasa

- Memberikan

- Go

- memberikan

- memahami

- tumbuh

- berat

- jujur

- kehormatan

- Namun

- http

- HTTPS

- manusia

- cita-cita

- if

- memperbaiki

- in

- sendiri-sendiri

- informasi

- cendekiawan

- kekayaan intelektual

- niat

- interaksi

- intern

- IP

- IT

- NYA

- Diri

- kunci

- bahasa

- besar

- Terbaru

- Hukum

- memimpin

- BELAJAR

- pengetahuan

- Informasi

- Leverage

- 'like'

- Llama

- LLM

- cinta

- membuat

- Membuat

- Mungkin..

- Media

- meta

- jutaan

- model

- model

- lebih

- paling

- jaringan

- saraf

- jaringan saraf

- New

- berita

- mendapatkan

- of

- on

- OpenAI

- or

- seolah-olah

- jika tidak

- kami

- di luar

- output

- lebih

- sendiri

- memiliki

- dibayar

- pihak

- pihak

- pola

- Membayar

- pembayaran

- pribadi

- Personalisasi

- Personalized

- Foto

- plato

- Kecerdasan Data Plato

- Data Plato

- kebijaksanaan

- potensi

- kekuasaan

- kuat

- praktek

- meramalkan

- Prediksi

- preferensi

- lazim

- pribadi

- swasta

- Diproduksi

- Produk

- meminta

- milik

- memberikan

- menyediakan

- publik

- kepercayaan publik

- di depan umum

- mengutip

- balap

- RE

- dunia nyata

- menerima

- memperhalus

- menganggap

- relatif

- melepaskan

- relevan

- Dilaporkan

- permintaan

- peneliti

- tanggung jawab

- Terungkap

- hak

- saingan

- rt

- Ryan

- s

- mengatakan

- mengatakan

- adegan

- layanan

- Layanan

- set

- Share

- harus

- Keraguan

- So

- Sosial

- media sosial

- terjual

- MENGEJA

- juru bicara

- startup

- Pernyataan

- tinggal

- Langkah

- sistem

- Berduaan

- tech

- raksasa teknologi

- teknik

- istilah

- teks

- bahwa

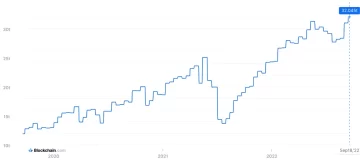

- Grafik

- mereka

- Mereka

- Ini

- mereka

- ini

- Tim

- untuk

- hari ini

- puncak

- Pelatihan VE

- terlatih

- Pelatihan

- Transparansi

- Tren

- Kepercayaan

- bawah

- memahami

- pemahaman

- mendatang

- diperbarui

- Pembaruan

- upgrade

- upload

- menggunakan

- bekas

- Pengguna

- Pengguna

- menggunakan

- Berharga

- berbagai

- versi

- Video

- vital

- Suara

- volume

- adalah

- we

- adalah

- ketika

- apakah

- yang

- mengapa

- akan

- dengan

- Word

- akan

- Kamu

- Anda

- zephyrnet.dll