Saya penggemar berat acara perjalanan Anthony Bourdain Bagian Tidak Diketahui. Di setiap episode, sang koki mengunjungi desa-desa terpencil di seluruh dunia, mendokumentasikan kehidupan, makanan, dan budaya suku-suku daerah dengan hati dan pikiran terbuka.

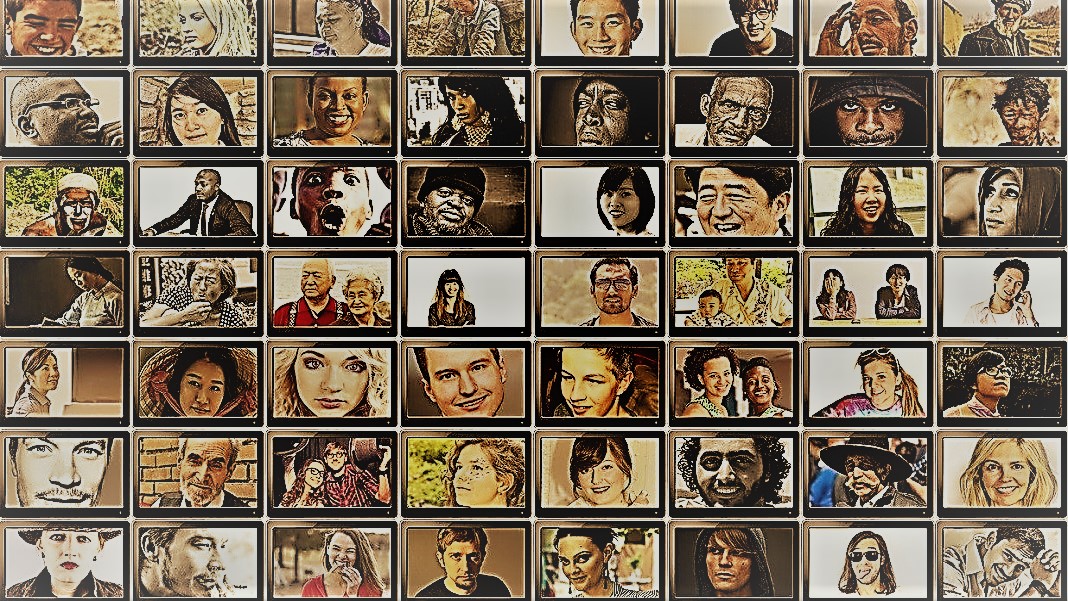

Pertunjukan ini memberikan gambaran sekilas tentang keragaman manusia yang menakjubkan. Ilmuwan sosial memiliki tujuan yang sama—memahami perilaku orang, kelompok, dan budaya yang berbeda—tetapi menggunakan berbagai metode dalam situasi yang terkendali. Bagi keduanya, bintang dari pengejaran ini adalah subjeknya: manusia.

Tetapi bagaimana jika Anda mengganti manusia dengan AI chatbots?

Gagasan itu terdengar tidak masuk akal. Namun berkat munculnya ChatGPT dan model bahasa besar (LLM) lainnya, ilmuwan sosial tergoda dengan gagasan menggunakan alat ini untuk dengan cepat membangun beragam kelompok "manusia simulasi" dan menjalankan eksperimen untuk menyelidiki perilaku dan nilai mereka sebagai proksi untuk rekan biologis mereka.

Jika Anda membayangkan pikiran manusia yang dibuat ulang secara digital, bukan itu. Idenya adalah memanfaatkan keahlian ChatGPT dalam meniru respons manusia. Karena para model mengorek sejumlah besar data online—blog, komentar Youtube, fiksi penggemar, buku—mereka dengan mudah menangkap hubungan antara kata-kata dalam berbagai bahasa. Algoritme canggih ini juga dapat memecahkan kode aspek bernuansa bahasa, seperti ironi, sarkasme, metafora, dan nada emosional, aspek kritis komunikasi manusia di setiap budaya. Kekuatan ini mengatur LLM untuk meniru banyak kepribadian sintetik dengan berbagai keyakinan.

Bonus lain? Dibandingkan dengan peserta manusia, ChatGPT dan LLM lainnya tidak lelah, memungkinkan para ilmuwan mengumpulkan data dan menguji teori tentang perilaku manusia dengan kecepatan yang belum pernah terjadi sebelumnya.

Idenya, meski kontroversial, sudah mendapat dukungan. Artikel terbaru meninjau bidang yang baru lahir menemukan bahwa dalam skenario tertentu yang dirancang dengan hati-hati, respons ChatGPT berkorelasi dengan sekitar 95 persen peserta manusia.

AI "dapat mengubah permainan untuk penelitian ilmu sosial," tersebut Dr. Igor Grossman di University of Waterloo, yang bersama rekan-rekannya baru-baru ini menulis artikel untuk melihat ke depan di Ilmu. Kunci untuk menggunakan Homo silika dalam penelitian? Manajemen bias yang hati-hati dan kesetiaan data, kata tim tersebut.

Menyelidiki Pikiran Masyarakat Manusia

Apa sebenarnya ilmu sosial itu?

Sederhananya, itu mempelajari bagaimana manusia — baik sebagai individu atau sebagai kelompok — berperilaku dalam keadaan yang berbeda, bagaimana mereka berinteraksi satu sama lain dan berkembang sebagai budaya. Ini adalah payung pengejaran akademik dengan berbagai cabang: ekonomi, ilmu politik, antropologi, dan psikologi.

Disiplin menangani berbagai topik yang menonjol dalam zeitgeist saat ini. Apa dampak media sosial terhadap kesehatan mental? Apa sikap publik saat ini terhadap perubahan iklim seiring dengan meningkatnya episode cuaca buruk? Bagaimana budaya yang berbeda menghargai metode komunikasi—dan apa yang memicu kesalahpahaman?

Sebuah studi ilmu sosial dimulai dengan pertanyaan dan hipotesis. Salah satu favorit saya: apakah budaya menoleransi bau badan secara berbeda? (Tidak bercanda, topik telah dipelajari sedikit, dan ya, ada perbedaan!)

Ilmuwan kemudian menggunakan berbagai metode, seperti kuesioner, tes perilaku, observasi, dan pemodelan untuk menguji ide-ide mereka. Survei adalah alat yang sangat populer, karena pertanyaannya dapat dirancang dan diperiksa secara ketat dan dengan mudah menjangkau banyak orang saat didistribusikan secara online. Para ilmuwan kemudian menganalisis tanggapan tertulis dan menarik wawasan tentang perilaku manusia. Dengan kata lain, penggunaan bahasa peserta sangat penting untuk studi ini.

Jadi bagaimana ChatGPT cocok?

'Homo Silicus'

Bagi Grossman, LLM di belakang chatbots seperti ChatGPT atau Google's Bard mewakili peluang yang belum pernah ada sebelumnya untuk mendesain ulang eksperimen ilmu sosial.

Karena mereka dilatih pada kumpulan data yang sangat besar, LLM “dapat mewakili beragam pengalaman dan perspektif manusia,” kata para penulis. Karena model "berkeliaran" dengan bebas tanpa batas melintasi internet—seperti orang yang sering bepergian ke luar negeri—mereka mungkin mengadopsi dan menampilkan respons yang lebih luas dibandingkan dengan subjek manusia yang direkrut.

ChatGPT juga tidak terpengaruh oleh anggota studi lain atau menjadi lelah, berpotensi memungkinkannya menghasilkan respons yang kurang bias. Ciri-ciri ini mungkin sangat berguna dalam “proyek berisiko tinggi”—misalnya, meniru tanggapan orang yang tinggal di negara berperang atau di bawah rezim yang sulit melalui postingan media sosial. Pada gilirannya, tanggapan dapat menginformasikan intervensi dunia nyata.

Demikian pula, LLM yang dilatih tentang topik hangat budaya seperti identitas gender atau informasi yang salah dapat mereproduksi aliran pemikiran teoretis atau ideologis yang berbeda untuk menginformasikan kebijakan. Daripada dengan susah payah mengumpulkan ratusan ribu peserta manusia, AI dapat dengan cepat menghasilkan tanggapan berdasarkan wacana online.

Selain penggunaan kehidupan nyata yang potensial, LLM juga dapat bertindak sebagai subjek digital yang berinteraksi dengan peserta manusia dalam eksperimen ilmu sosial, agak mirip dengan karakter nonpemain (NPC) dalam video game. Misalnya, LLM dapat mengadopsi "kepribadian" yang berbeda dan berinteraksi dengan sukarelawan manusia di seluruh dunia secara online menggunakan teks dengan mengajukan pertanyaan yang sama kepada mereka. Karena algoritme tidak tidur, algoritme dapat berjalan 24/7. Data yang dihasilkan kemudian dapat membantu para ilmuwan mengeksplorasi bagaimana beragam budaya mengevaluasi informasi serupa dan bagaimana opini—dan informasi yang salah—menyebar.

Bayi Langkah

Gagasan menggunakan chatbot sebagai pengganti manusia dalam penelitian belum menjadi arus utama.

Tapi ada bukti awal bahwa itu bisa berhasil. A studi pracetak dirilis bulan ini dari Georgia Tech, Microsoft Research, dan Olin College menemukan bahwa LLM mereplikasi respons manusia dalam berbagai eksperimen psikologi klasik, termasuk yang terkenal Eksperimen kejutan Milgram.

Namun pertanyaan kritis tetap ada: seberapa baik model ini benar-benar dapat menangkap respons manusia?

Ada beberapa batu sandungan.

Pertama adalah kualitas algoritma dan data pelatihan. Sebagian besar konten online didominasi oleh beberapa bahasa saja. LLM yang dilatih pada data ini dapat dengan mudah meniru sentimen, perspektif, atau bahkan penilaian moral orang yang menggunakan bahasa tersebut—pada gilirannya mewarisi bias dari data pelatihan.

“Reproduksi bias ini menjadi perhatian utama karena dapat memperbesar perbedaan yang ingin diungkapkan oleh para ilmuwan sosial dalam penelitian mereka,” kata Grossman.

Beberapa ilmuwan juga khawatir bahwa LLM adil muntah apa yang mereka diberitahu. Ini adalah antitesis dari studi ilmu sosial, di mana poin utamanya adalah menangkap kemanusiaan dengan segala keindahannya yang beragam dan kompleks. Di sisi lain, ChatGPT dan model serupa diketahui “berhalusinasi,” mengarang informasi yang terdengar masuk akal tetapi salah.

Untuk saat ini, "model bahasa besar mengandalkan 'bayangan' pengalaman manusia," kata Grossman. Karena sistem AI ini sebagian besar adalah kotak hitam, sulit untuk memahami bagaimana atau mengapa mereka menghasilkan respons tertentu—agak merepotkan saat menggunakannya sebagai perwakilan manusia dalam eksperimen perilaku.

Terlepas dari keterbatasan, "LLM memungkinkan ilmuwan sosial untuk melepaskan diri dari metode penelitian tradisional dan mendekati pekerjaan mereka dengan cara yang inovatif," kata para penulis. Sebagai langkah pertama, Homo silicus dapat membantu bertukar pikiran dan menguji hipotesis dengan cepat, dengan hipotesis yang menjanjikan akan divalidasi lebih lanjut dalam populasi manusia.

Tetapi agar ilmu sosial benar-benar menyambut AI, perlu ada transparansi, keadilan, dan akses yang setara ke sistem yang kuat ini. LLM sulit dan mahal untuk dilatih, dengan model terbaru semakin ditutup di belakang paywalls yang besar dan kuat.

“Kita harus memastikan bahwa LLM ilmu sosial, seperti semua model ilmiah, adalah sumber terbuka, artinya algoritme dan data idealnya tersedia untuk semua orang untuk diteliti, diuji, dan dimodifikasi,” tersebut penulis studi Dr. Dawn Parker di University of Waterloo. “Hanya dengan mempertahankan transparansi dan replikasi, kami dapat memastikan bahwa penelitian ilmu sosial yang dibantu AI benar-benar berkontribusi pada pemahaman kami tentang pengalaman manusia.”

Gambar Kredit: Gerd Altmann / Pixabay

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :memiliki

- :adalah

- :bukan

- $NAIK

- 23

- a

- Tentang Kami

- akademik

- mengakses

- di seluruh

- Bertindak

- mengambil

- kedatangan

- AI

- algoritma

- algoritma

- Semua

- mengizinkan

- Membiarkan

- sudah

- juga

- jumlah

- an

- menganalisa

- dan

- Anthony

- pendekatan

- ADALAH

- arizona

- susunan

- artikel

- AS

- penampilan

- aspek

- At

- penulis

- penulis

- tersedia

- berdasarkan

- BE

- Kecantikan

- karena

- menjadi

- laku

- di belakang

- makhluk

- keyakinan

- antara

- prasangka

- bias

- Bit

- Black

- Blok

- tubuh

- bonus

- perbatasan

- kedua

- kotak

- brainstorm

- cabang

- Istirahat

- tapi

- by

- CAN

- menangkap

- hati-hati

- tertentu

- perubahan

- karakter

- chatbots

- ChatGPT

- keadaan

- Iklim

- Perubahan iklim

- rekan

- mengumpulkan

- Perguruan tinggi

- komentar

- Komunikasi

- dibandingkan

- kompleks

- Perhatian

- membangun

- Konten

- berkontribusi

- dikendalikan

- kontroversial

- bisa

- negara

- kredit

- kritis

- aspek kritis

- kultural

- budaya

- terbaru

- data

- kumpulan data

- dirancang

- mengembangkan

- berbeda

- sulit

- digital

- digital

- Display

- didistribusikan

- beberapa

- Keragaman

- do

- tidak

- Tidak

- Dont

- dr

- seri

- setiap

- Awal

- mudah

- Ekonomi

- besar sekali

- memastikan

- episode

- sama

- terutama

- mengevaluasi

- Bahkan

- Setiap

- persis

- contoh

- mahal

- pengalaman

- Pengalaman

- eksperimen

- keahlian

- menyelidiki

- keadilan

- palsu

- kipas

- Fiksi

- kesetiaan

- bidang

- Pertama

- cocok

- makanan

- Untuk

- ditemukan

- dari

- lebih lanjut

- permainan

- Games

- Gender

- menghasilkan

- Georgia

- mendapatkan

- Melihat sekilas

- bumi

- Grup

- tangan

- segenggam

- Memiliki

- Kesehatan

- Hati

- membantu

- PANAS

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTML

- http

- HTTPS

- besar

- manusia

- Pengalaman Manusia

- Kemanusiaan

- Manusia

- Ratusan

- ide

- idealnya

- ide-ide

- identitas

- if

- Dampak

- in

- Di lain

- Termasuk

- Meningkatkan

- makin

- individu

- hina

- terpengaruh

- memberitahu

- informasi

- inovatif

- wawasan

- berinteraksi

- ke

- ironi

- IT

- NYA

- jpg

- hanya

- kunci

- dikenal

- bahasa

- Bahasa

- besar

- sebagian besar

- kurang

- 'like'

- keterbatasan

- hidup

- hidup

- LLM

- Utama

- Arus utama

- mempertahankan

- utama

- Membuat

- pengelolaan

- besar-besaran

- Mungkin..

- makna

- Media

- Anggota

- mental yang

- Kesehatan mental

- metode

- Microsoft

- keberatan

- pikiran

- Keterangan yg salah

- pemodelan

- model

- memodifikasi

- Bulan

- moral

- paling

- beberapa

- harus

- my

- baru lahir

- Perlu

- tidak

- sekarang

- banyak sekali

- of

- sering

- on

- ONE

- yang

- secara online

- Buka

- open source

- Kesempatan

- or

- Lainnya

- kami

- peserta

- Konsultan Ahli

- persen

- Kepribadian

- perspektif

- perspektif

- plato

- Kecerdasan Data Plato

- Data Plato

- masuk akal

- Titik

- Kebijakan

- politik

- Populer

- populasi

- Posts

- berpotensi

- kuat

- penyelidikan

- menonjol

- menjanjikan

- bukti

- menyediakan

- wakil

- Psikologi

- publik

- pengejaran

- kualitas

- pertanyaan

- Pertanyaan

- jarak

- cepat

- agak

- mencapai

- dunia nyata

- benar-benar

- baru

- baru-baru ini

- mendesain ulang

- diet

- daerah

- Hubungan

- dirilis

- mengandalkan

- sisa

- terpencil

- diganti

- replikasi

- direplikasi

- mewakili

- reproduksi

- penelitian

- tanggapan

- tanggapan

- dihasilkan

- kira-kira

- Run

- Tersebut

- sama

- skenario

- Sekolah

- Ilmu

- ILMU PENGETAHUAN

- ilmiah

- ilmuwan

- sentimen

- set

- beberapa

- parah

- Menunjukkan

- mirip

- hanya

- situasi

- tidur

- Sosial

- media sosial

- Posting Media Sosial

- masyarakat

- agak

- mutakhir

- kecepatan

- Bintang

- dimulai

- Langkah

- kekuatan

- berjuang

- studi

- Belajar

- Belajar

- sandungan

- seperti itu

- mendukung

- sintetis

- sistem

- Mengatasi

- Tap

- tim

- tech

- uji

- tes

- dari

- Terima kasih

- bahwa

- Grafik

- mereka

- Mereka

- kemudian

- teoretis

- Sana.

- Ini

- mereka

- ini

- itu

- meskipun?

- pikir

- ribuan

- Melalui

- lelah

- untuk

- alat

- alat

- Topik

- terhadap

- tradisional

- Pelatihan VE

- terlatih

- Pelatihan

- Transparansi

- perjalanan

- mengganggu

- benar-benar

- MENGHIDUPKAN

- payung

- menemukan

- bawah

- memahami

- pemahaman

- universitas

- belum pernah terjadi sebelumnya

- menggunakan

- kegunaan

- menggunakan

- divalidasi

- nilai

- Nilai - Nilai

- variasi

- Luas

- sangat

- diperiksa

- Video

- Video game

- Kunjungan

- relawan

- perang

- cara

- we

- Cuaca

- selamat datang

- BAIK

- Apa

- ketika

- yang

- SIAPA

- mengapa

- lebar

- Rentang luas

- lebih luas

- Wikipedia

- akan

- dengan

- tanpa

- kata

- Kerja

- bekerja

- kuatir

- tertulis

- iya nih

- namun

- Kamu

- Youtube

- Semangat waktu tertentu

- zephyrnet.dll