Data mengubah setiap bidang dan setiap bisnis. Namun, dengan pertumbuhan data yang lebih cepat daripada yang dapat dilacak sebagian besar perusahaan, mengumpulkan data dan mendapatkan nilai dari data tersebut merupakan hal yang menantang untuk dilakukan. SEBUAH strategi data modern dapat membantu Anda menciptakan hasil bisnis yang lebih baik dengan data. AWS menyediakan rangkaian layanan paling lengkap untuk perjalanan data end-to-end untuk membantu Anda membuka kunci nilai dari data Anda dan mengubahnya menjadi wawasan.

Data scientist dapat menghabiskan hingga 80% waktunya untuk menyiapkan data untuk project machine learning (ML). Proses persiapan ini sebagian besar merupakan pekerjaan yang tidak dapat dibedakan dan membosankan, dan dapat melibatkan beberapa API pemrograman dan pustaka khusus. Pengatur Data Amazon SageMaker membantu data scientist dan data engineer menyederhanakan dan mempercepat penyiapan data tabular dan deret waktu serta rekayasa fitur melalui antarmuka visual. Anda dapat mengimpor data dari beberapa sumber data, seperti Layanan Penyimpanan Sederhana Amazon (Amazon S3), Amazon Athena, Pergeseran Merah Amazon, atau bahkan solusi pihak ketiga seperti Kepingan salju or DataBrick, dan memproses data Anda dengan lebih dari 300 transformasi data bawaan dan pustaka cuplikan kode, sehingga Anda dapat dengan cepat menormalkan, mengubah, dan menggabungkan fitur tanpa menulis kode apa pun. Anda juga dapat membawa transformasi khusus Anda di PySpark, SQL, atau Pandas.

Posting ini menunjukkan bagaimana Anda dapat menjadwalkan pekerjaan persiapan data Anda untuk dijalankan secara otomatis. Kami juga mengeksplorasi kemampuan Data Wrangler baru dari kumpulan data berparameter, yang memungkinkan Anda menentukan file yang akan disertakan dalam aliran data melalui URI berparameter.

Ikhtisar solusi

Data Wrangler sekarang mendukung pengimporan data menggunakan URI berparameter. Ini memungkinkan fleksibilitas lebih lanjut karena Anda sekarang dapat mengimpor semua kumpulan data yang cocok dengan parameter yang ditentukan, yang dapat bertipe String, Number, Datetime, dan Pattern, di URI. Selain itu, Anda sekarang dapat memicu tugas transformasi Data Wrangler sesuai jadwal.

Dalam postingan ini, kami membuat alur sampel dengan kumpulan data Titanic untuk menunjukkan bagaimana Anda dapat mulai bereksperimen dengan dua fitur Data Wrangler baru ini. Untuk mengunduh dataset, lihat Titanic – Pembelajaran Mesin dari Bencana.

Prasyarat

Untuk mendapatkan semua fitur yang dijelaskan dalam posting ini, Anda harus menjalankan Data Wrangler versi kernel terbaru. Untuk informasi lebih lanjut, lihat Perbarui Pengatur Data. Selain itu, Anda harus berlari Studio Amazon SageMaker JupyterLab 3. Untuk melihat versi saat ini dan memperbaruinya, lihat Versi JupyterLab.

Struktur file

Untuk demonstrasi ini, kami mengikuti struktur file sederhana yang harus Anda tiru untuk mereproduksi langkah-langkah yang diuraikan dalam posting ini.

- Di Studio, membuat buku catatan baru.

- Jalankan cuplikan kode berikut untuk membuat struktur folder yang kami gunakan (pastikan Anda berada di folder yang diinginkan di pohon file Anda):

- Salin

train.csvdantest.csvfile dari dataset Titanic asli ke foldertitanic_dataset/traindantitanic_dataset/test, Masing-masing. - Jalankan cuplikan kode berikut untuk mengisi folder dengan file yang diperlukan:

Kami membagi train.csv file dataset Titanic menjadi sembilan file berbeda, bernama part_x, di mana x adalah nomor bagian. Bagian 0 memiliki 100 record pertama, bagian 1 memiliki 100 record berikutnya, dan seterusnya hingga bagian 8. Setiap folder node dari pohon file berisi salinan dari sembilan bagian data pelatihan kecuali untuk train dan test folder, yang berisi train.csv dan test.csv.

Dataset berparameter

Pengguna Data Wrangler kini dapat menentukan parameter untuk kumpulan data yang diimpor dari Amazon S3. Parameter kumpulan data ditentukan pada URI sumber daya, dan nilainya dapat diubah secara dinamis, memungkinkan lebih banyak fleksibilitas untuk memilih file yang ingin kita impor. Parameter dapat terdiri dari empat tipe data:

- Jumlah - Dapat mengambil nilai bilangan bulat apa pun

- Tali – Dapat mengambil nilai string teks apa pun

- pola – Dapat mengambil nilai ekspresi reguler apa pun

- Datetime – Dapat mengambil nilai dari salah satu format tanggal/waktu yang didukung

Di bagian ini, kami memberikan panduan tentang fitur baru ini. Ini hanya tersedia setelah Anda mengimpor set data ke aliran Anda saat ini dan hanya untuk set data yang diimpor dari Amazon S3.

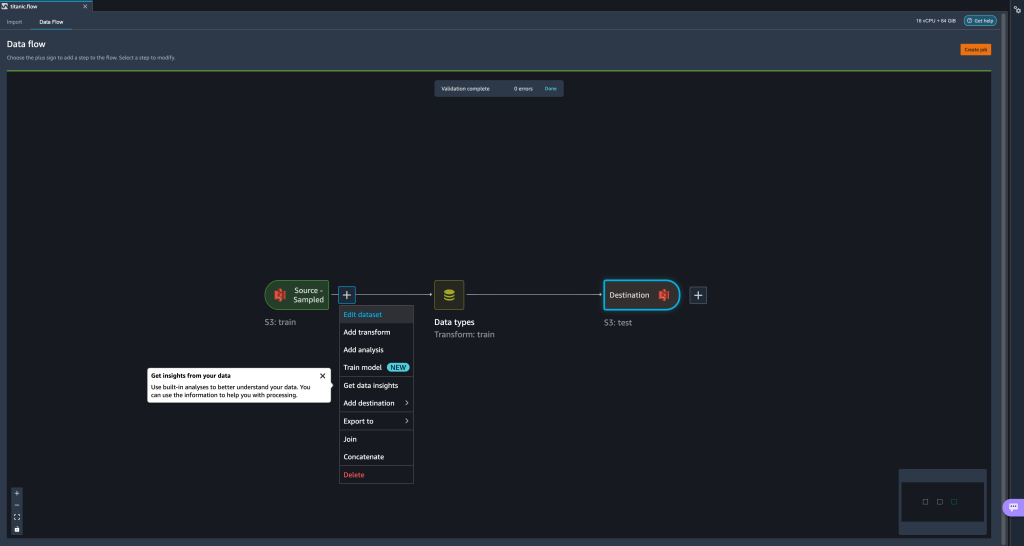

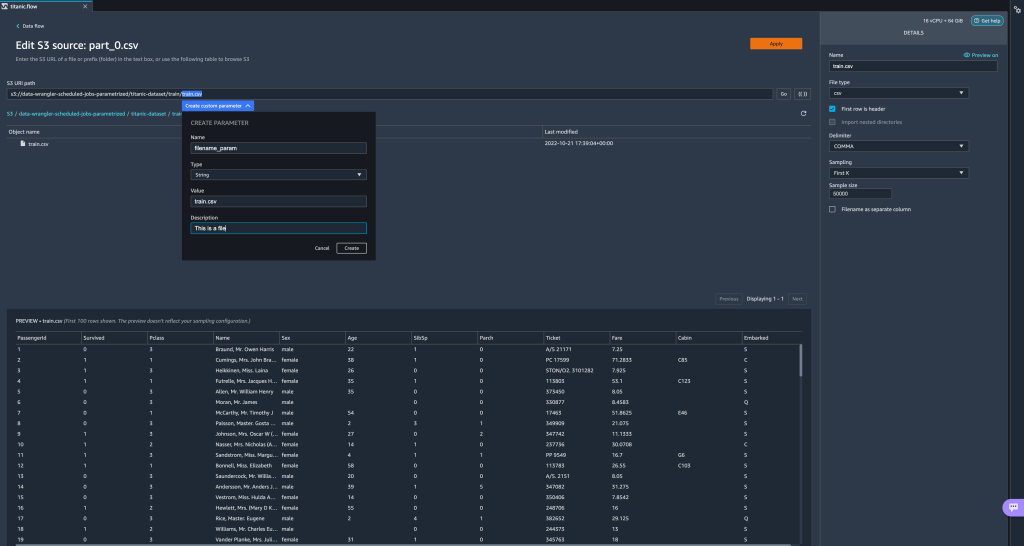

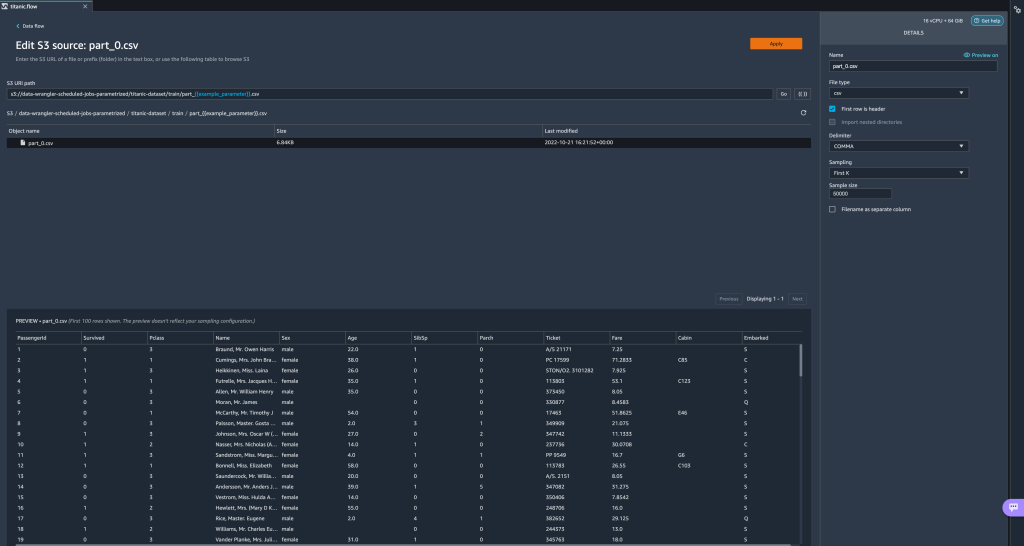

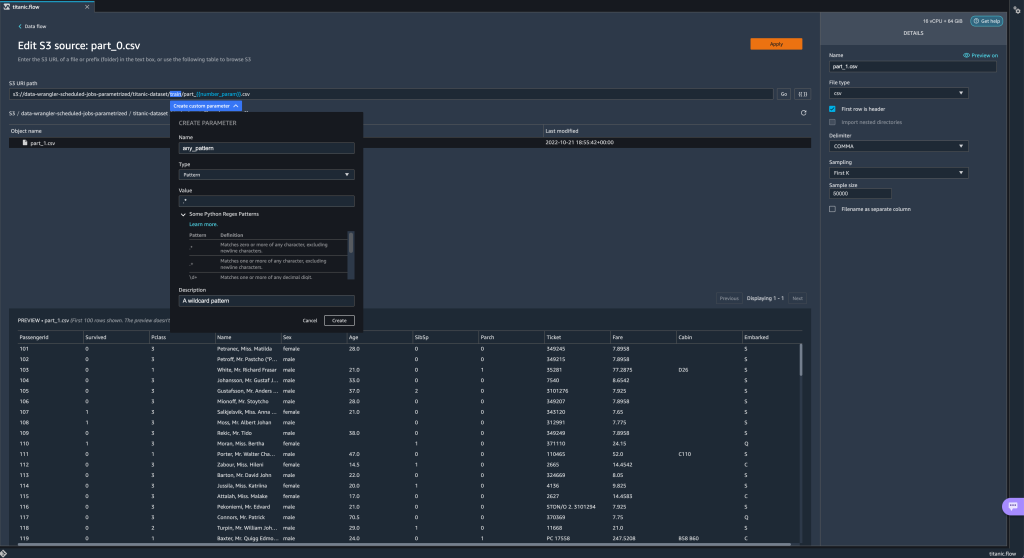

- Dari aliran data Anda, pilih tanda tambah (+) di samping langkah impor dan pilih Edit kumpulan data.

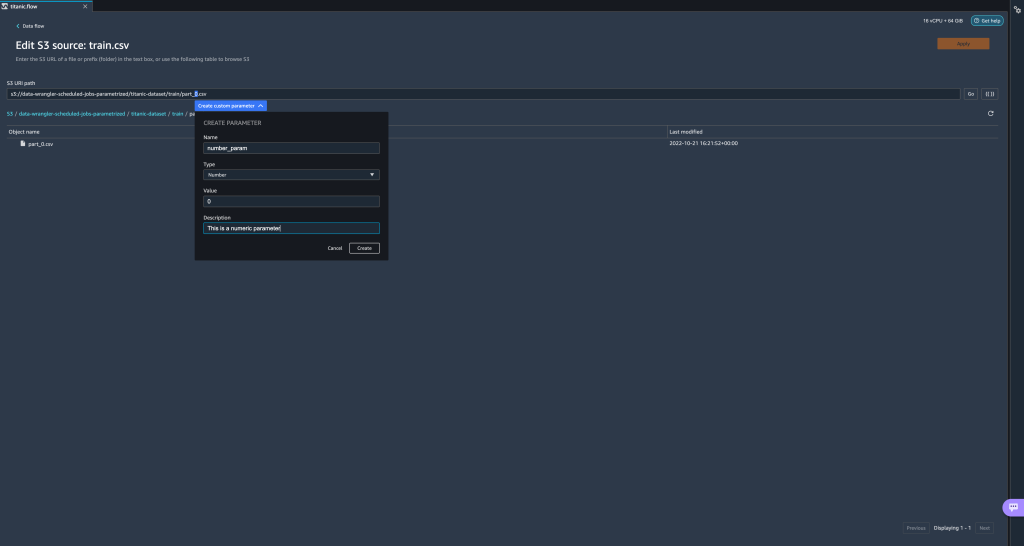

- Metode yang disukai (dan termudah) untuk membuat parameter baru adalah dengan menyorot bagian URI Anda dan memilih Buat parameter khusus pada menu tarik-turun. Anda perlu menentukan empat hal untuk setiap parameter yang ingin Anda buat:

- Nama

- Tipe

- Nilai standar

- Deskripsi Produk

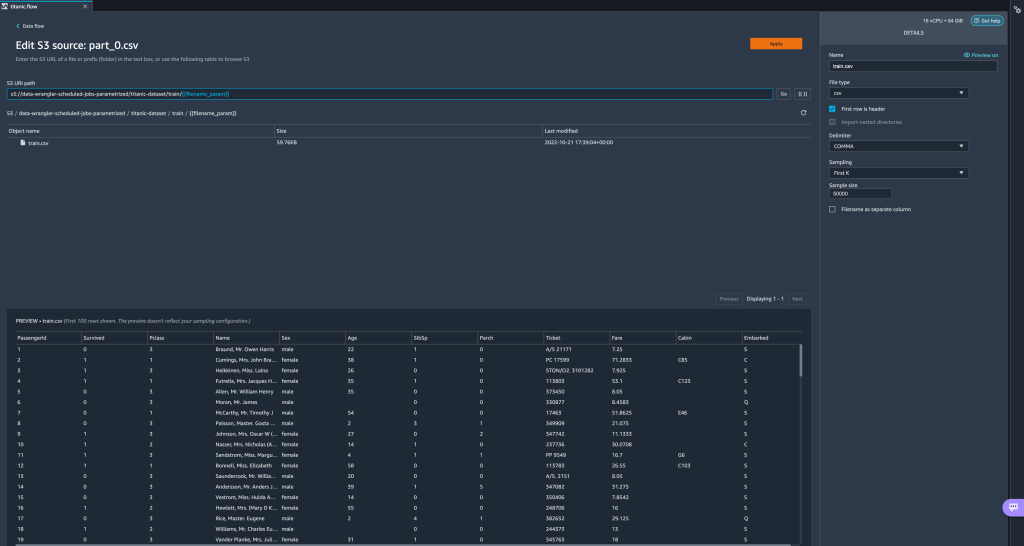

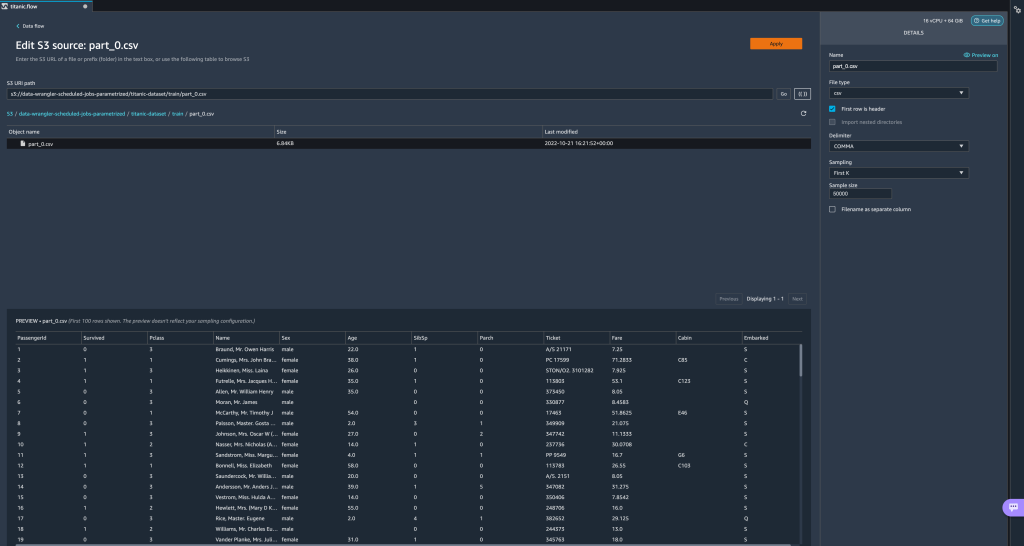

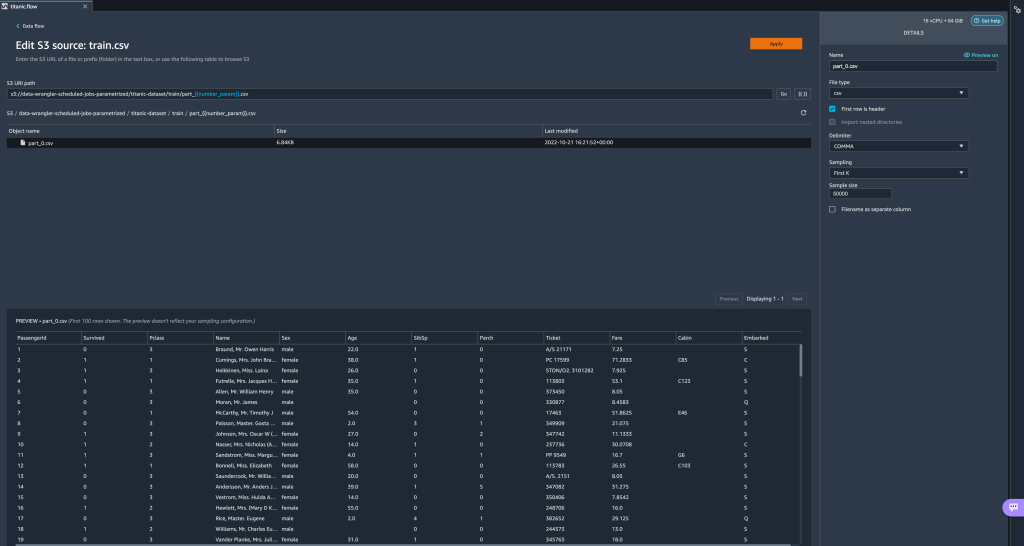

Di sini kami telah membuat parameter tipe String yang disebutfilename_paramdengan nilai default daritrain.csv. Sekarang Anda dapat melihat nama parameter diapit tanda kurung ganda, menggantikan bagian URI yang sebelumnya kami soroti. Karena nilai yang ditentukan untuk parameter ini adalahtrain.csv, kita sekarang melihat filetrain.csvtercantum pada tabel impor.

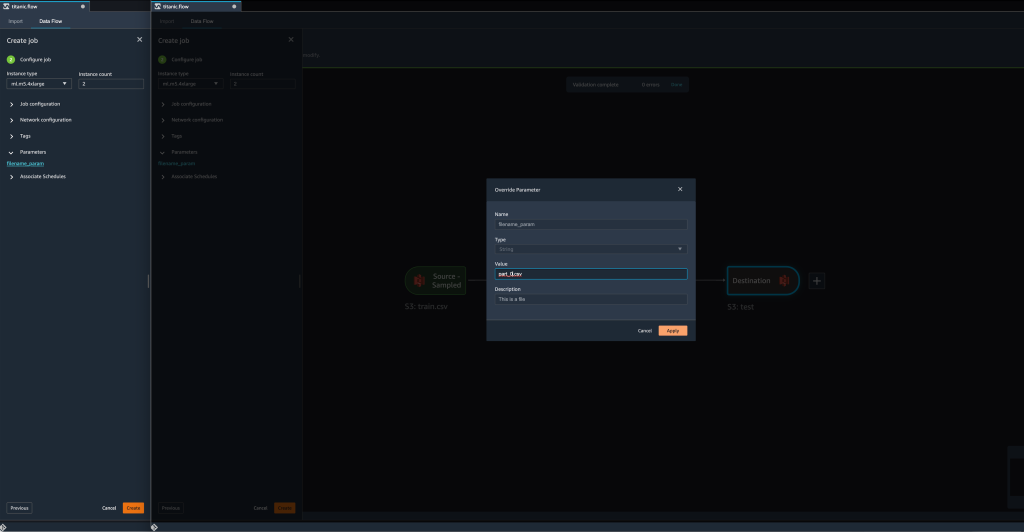

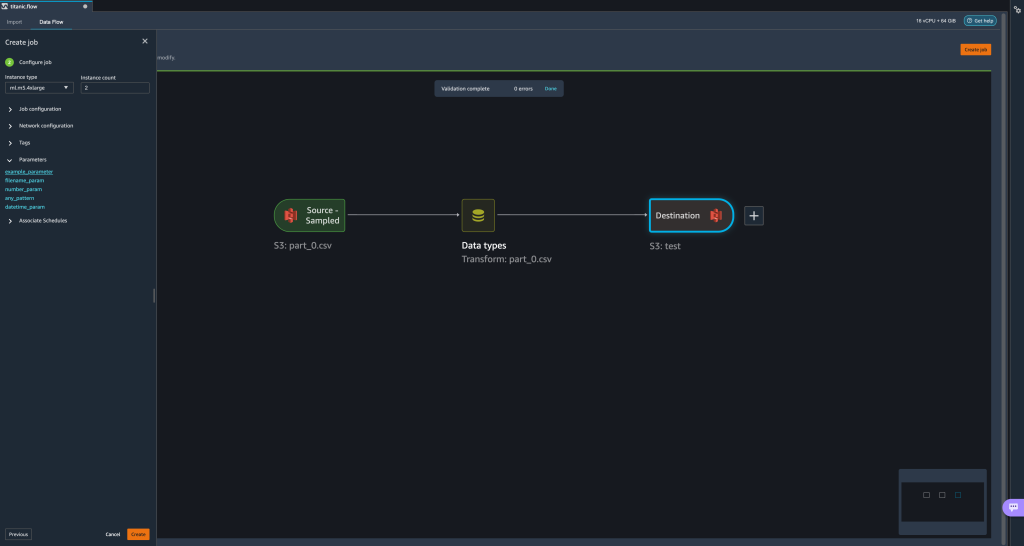

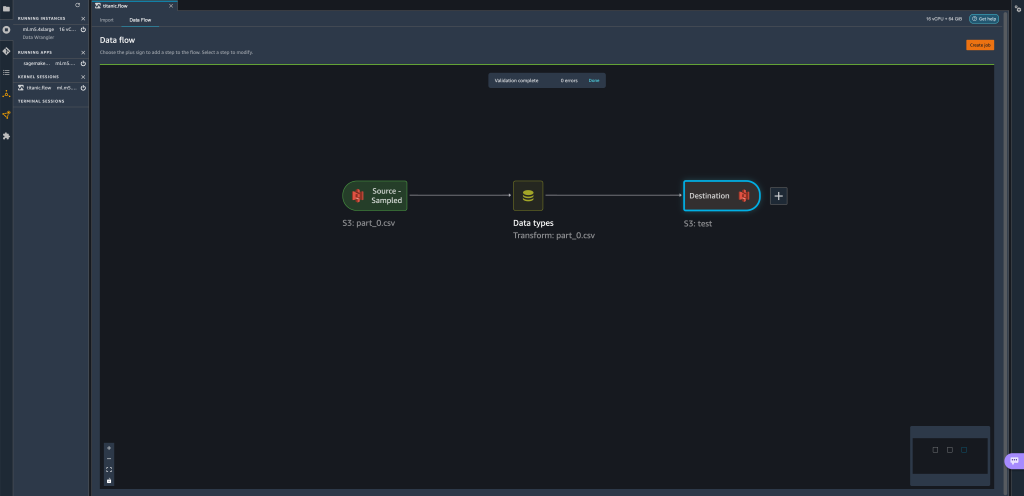

- Saat kami mencoba membuat tugas transformasi, di Konfigurasikan pekerjaan langkah, kita sekarang melihat a parameter bagian, di mana kita dapat melihat daftar semua parameter yang kita tentukan.

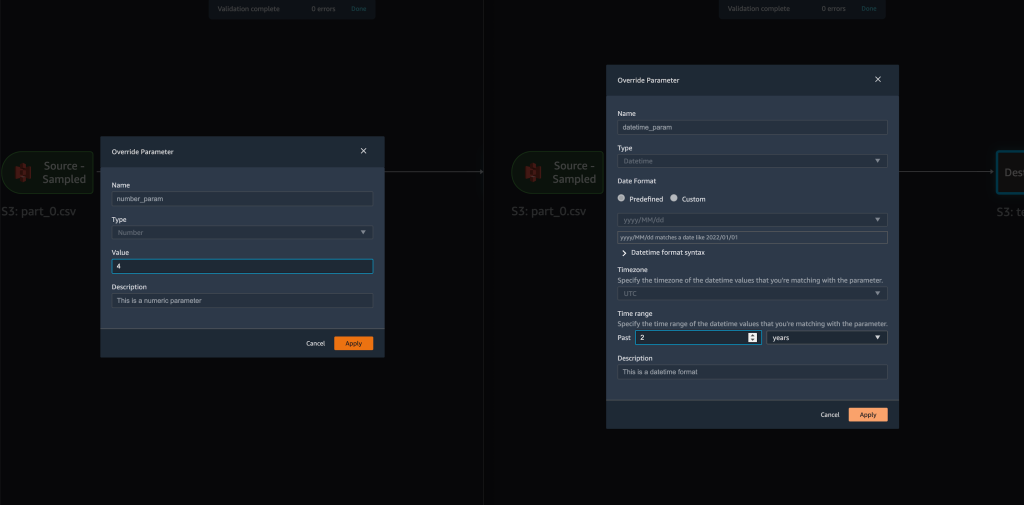

- Memilih parameter memberi kita pilihan untuk mengubah nilai parameter, dalam hal ini, mengubah dataset input untuk diubah sesuai dengan aliran yang ditentukan.

Dengan asumsi kita mengubah nilai darifilename_paramdaritrain.csvuntukpart_0.csv, pekerjaan transformasi sekarang mengambilpart_0.csv(asalkan file dengan namapart_0.csvada di bawah folder yang sama) sebagai data input barunya.

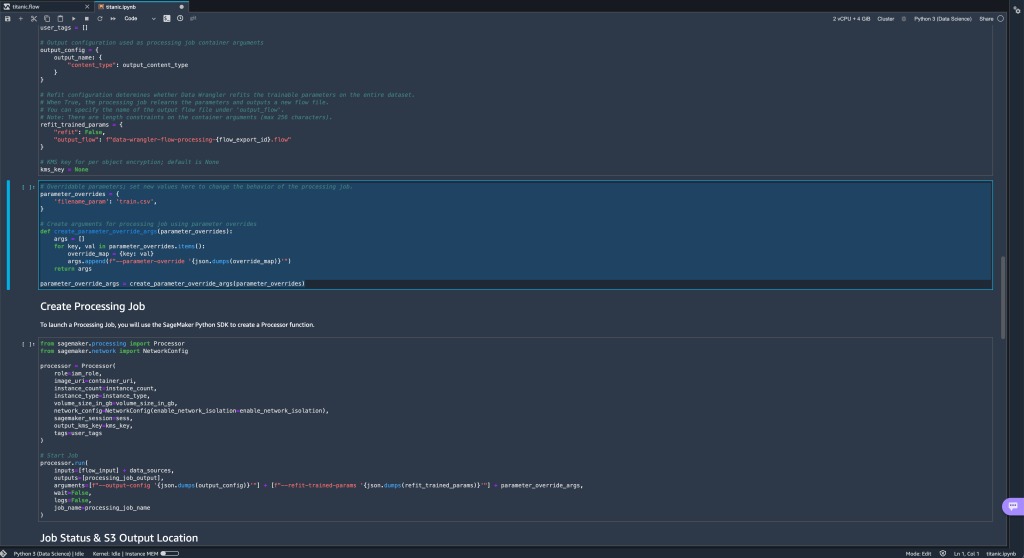

- Selain itu, jika Anda mencoba mengekspor aliran Anda ke tujuan Amazon S3 (melalui notebook Jupyter), Anda sekarang melihat sel baru yang berisi parameter yang Anda tetapkan.

Perhatikan bahwa parameter mengambil nilai defaultnya, tetapi Anda dapat mengubahnya dengan mengganti nilainya diparameter_overrideskamus (sambil membiarkan kunci kamus tidak berubah).

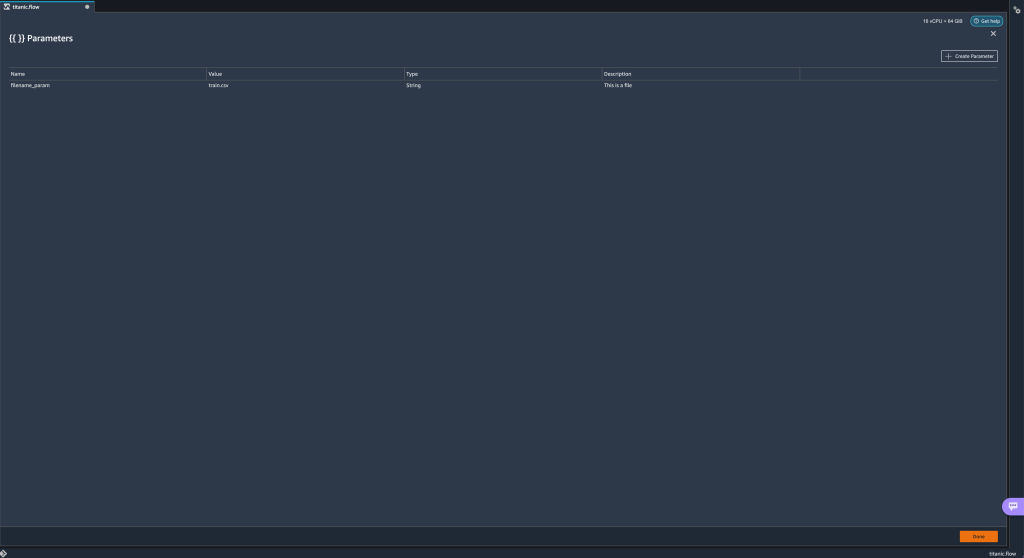

Selain itu, Anda dapat membuat parameter baru dari parameter UI. - Buka dengan memilih ikon parameter ({{}}) terletak di sebelah Go pilihan; keduanya terletak di sebelah nilai jalur URI.

Tabel terbuka dengan semua parameter yang saat ini ada di file aliran Anda (

Tabel terbuka dengan semua parameter yang saat ini ada di file aliran Anda (filename_parampada saat ini). - Anda dapat membuat parameter baru untuk aliran Anda dengan memilih Buat Parameter.

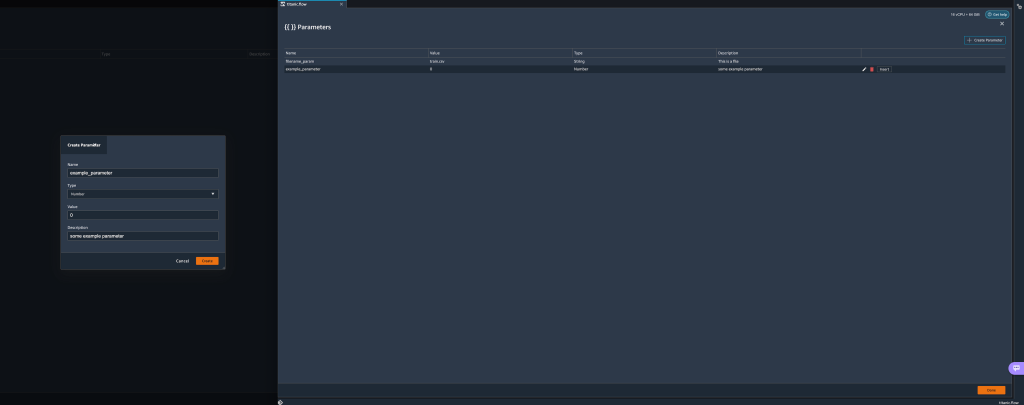

Jendela pop-up terbuka untuk memungkinkan Anda membuat parameter kustom baru. - Di sini, kami telah membuat yang baru

example_parametersebagai tipe Number dengan nilai default 0. Parameter yang baru dibuat ini sekarang terdaftar di parameter meja. Mengarahkan kursor ke parameter akan menampilkan opsi Edit, Delete, dan Menyisipkan.

- Dari dalam parameter UI, Anda dapat memasukkan salah satu parameter Anda ke URI dengan memilih parameter yang diinginkan dan memilih Menyisipkan.

Ini menambahkan parameter ke akhir URI Anda. Anda perlu memindahkannya ke bagian yang diinginkan dalam URI Anda.

- Ubah nilai default parameter, terapkan perubahan (dari modal), pilih Go, dan pilih ikon segarkan untuk memperbarui daftar pratinjau menggunakan set data yang dipilih berdasarkan nilai parameter yang baru ditentukan.

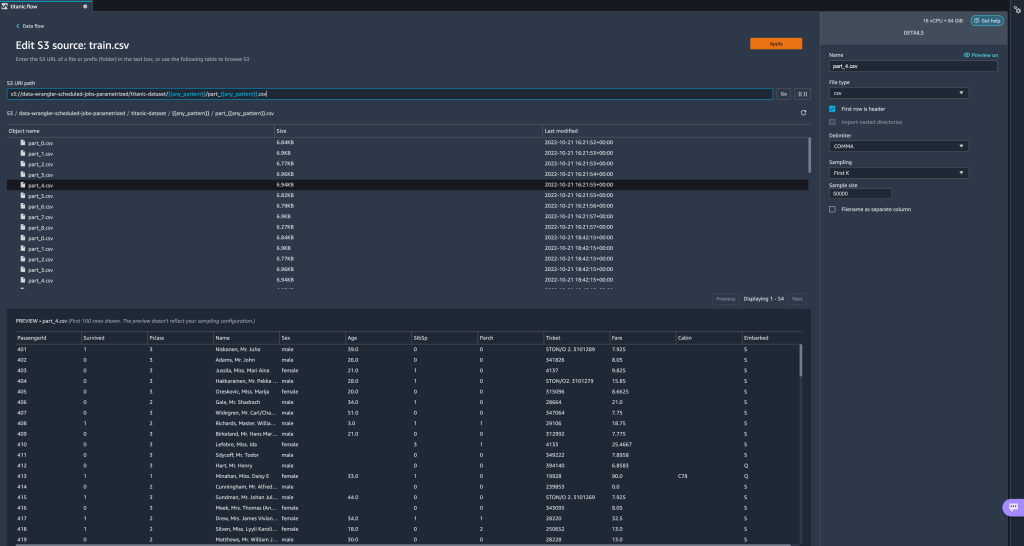

Sekarang mari kita jelajahi jenis parameter lainnya. Asumsikan kita sekarang memiliki kumpulan data yang dibagi menjadi beberapa bagian, di mana setiap file memiliki nomor bagian.

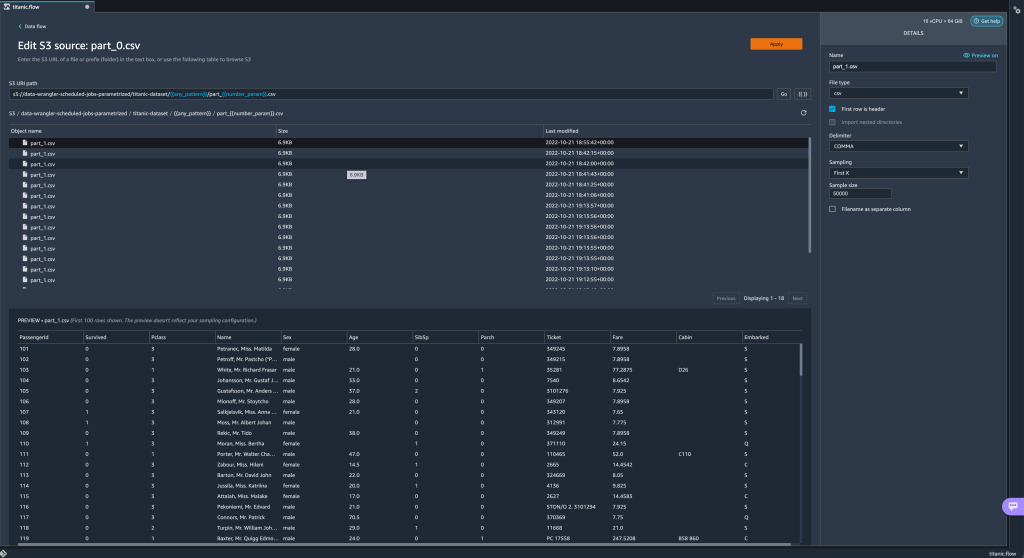

Sekarang mari kita jelajahi jenis parameter lainnya. Asumsikan kita sekarang memiliki kumpulan data yang dibagi menjadi beberapa bagian, di mana setiap file memiliki nomor bagian. - Jika kami ingin mengubah nomor file secara dinamis, kami dapat menentukan parameter Angka seperti yang ditunjukkan pada tangkapan layar berikut.

Perhatikan bahwa file yang dipilih adalah yang cocok dengan nomor yang ditentukan dalam parameter.

Perhatikan bahwa file yang dipilih adalah yang cocok dengan nomor yang ditentukan dalam parameter. Sekarang mari kita tunjukkan cara menggunakan parameter Pola. Misalkan kita ingin mengimpor semua

Sekarang mari kita tunjukkan cara menggunakan parameter Pola. Misalkan kita ingin mengimpor semua part_1.csvfile di semua folder di bawahtitanic-dataset/map. Parameter pola dapat menggunakan ekspresi reguler apa pun yang valid; ada beberapa pola regex yang ditampilkan sebagai contoh. - Buat parameter Pola disebut

any_patternuntuk mencocokkan folder atau file apa pun di bawahtitanic-dataset/folder dengan nilai default.*.Perhatikan bahwa wildcard bukan satu * (tanda bintang) tetapi juga memiliki titik. - Sorot

titanic-dataset/bagian dari jalur dan buat parameter khusus. Kali ini kita memilih pola mengetik. Pola ini memilih semua file yang dipanggil

Pola ini memilih semua file yang dipanggil part-1.csvdari salah satu folder di bawahtitanic-dataset/. Parameter dapat digunakan lebih dari sekali dalam sebuah jalur. Dalam contoh berikut, kami menggunakan parameter yang baru kami buat

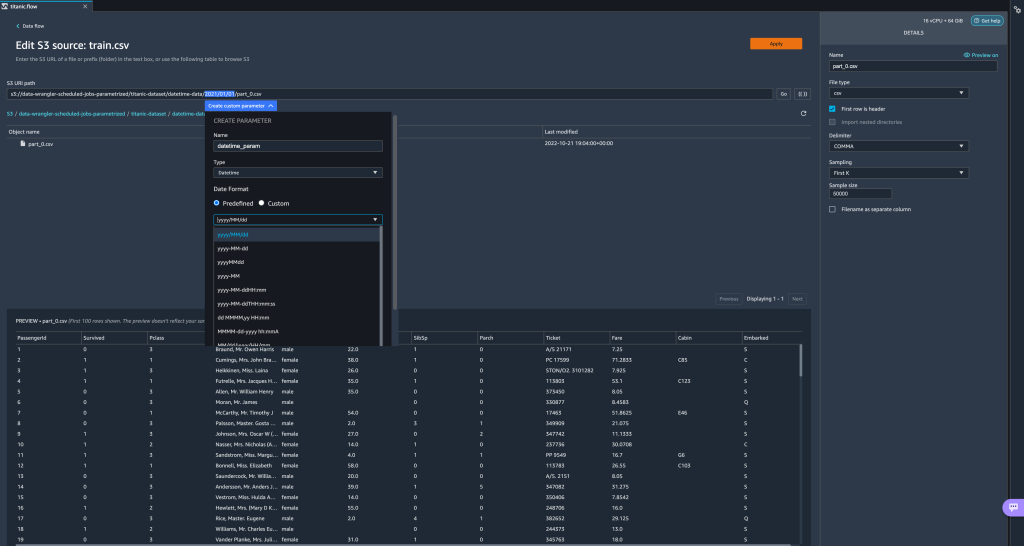

Parameter dapat digunakan lebih dari sekali dalam sebuah jalur. Dalam contoh berikut, kami menggunakan parameter yang baru kami buat any_patterndua kali di URI kami untuk mencocokkan salah satu file bagian di salah satu folder di bawahtitanic-dataset/. Terakhir, mari buat parameter Datetime. Parameter datetime berguna saat kita berurusan dengan jalur yang dipartisi berdasarkan tanggal dan waktu, seperti yang dihasilkan oleh Firehose Data Amazon Kinesis (Lihat Partisi Dinamis di Kinesis Data Firehose). Untuk demonstrasi ini, kami menggunakan data di bawah folder datetime-data.

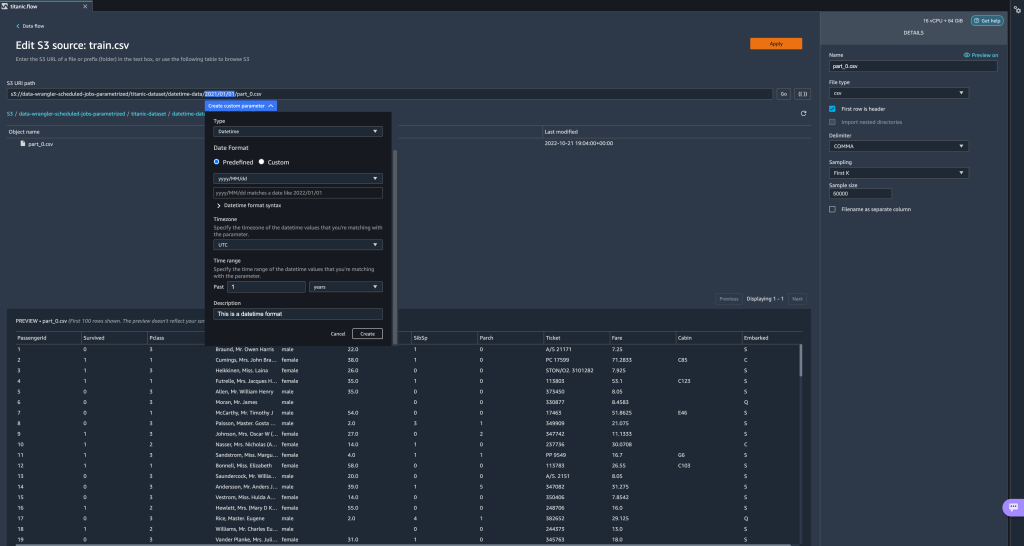

Terakhir, mari buat parameter Datetime. Parameter datetime berguna saat kita berurusan dengan jalur yang dipartisi berdasarkan tanggal dan waktu, seperti yang dihasilkan oleh Firehose Data Amazon Kinesis (Lihat Partisi Dinamis di Kinesis Data Firehose). Untuk demonstrasi ini, kami menggunakan data di bawah folder datetime-data. - Pilih bagian jalur Anda yang merupakan tanggal/waktu dan buat parameter khusus. Memilih Datetime jenis parameter.

Saat memilih tipe data Datetime, Anda perlu mengisi lebih banyak detail. - Pertama-tama, Anda harus memberikan format tanggal. Anda dapat memilih salah satu format tanggal/waktu yang telah ditentukan sebelumnya atau membuat format khusus.

Untuk format tanggal/waktu yang telah ditentukan sebelumnya, legenda memberikan contoh tanggal yang cocok dengan format yang dipilih. Untuk demonstrasi ini, kami memilih format yyyy/MM/hh.

- Selanjutnya, tentukan zona waktu untuk nilai tanggal/waktu.

Misalnya, tanggal saat ini mungkin 1 Januari 2022 di satu zona waktu, tetapi mungkin 2 Januari 2022 di zona waktu lain. - Terakhir, Anda dapat memilih rentang waktu, yang memungkinkan Anda memilih rentang file yang ingin disertakan dalam aliran data.

Anda dapat menentukan rentang waktu Anda dalam jam, hari, minggu, bulan, atau tahun. Untuk contoh ini, kami ingin mendapatkan semua file dari tahun lalu. - Berikan deskripsi parameter dan pilih membuat.

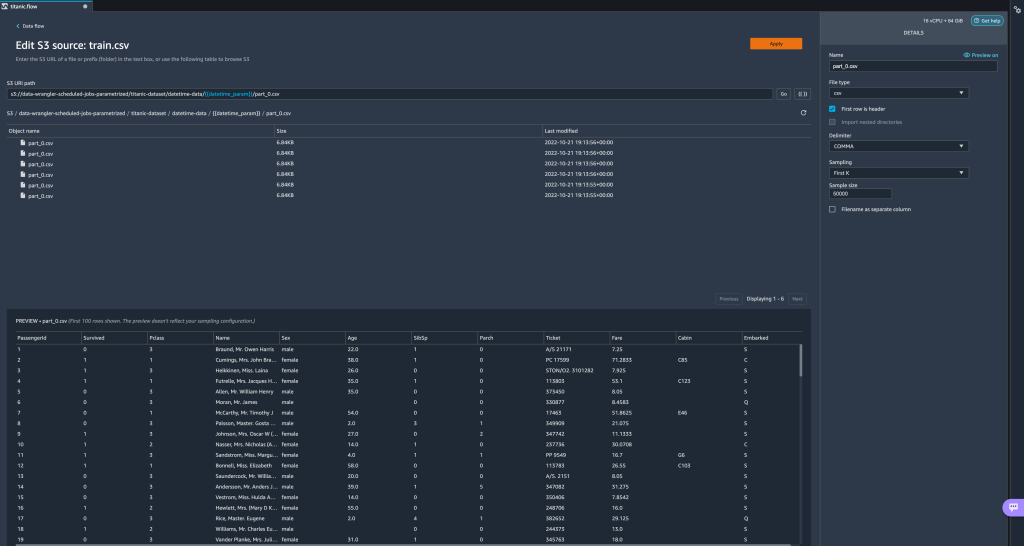

Jika Anda menggunakan beberapa kumpulan data dengan zona waktu berbeda, waktu tidak akan dikonversi secara otomatis; Anda perlu memproses setiap file atau sumber untuk mengonversinya menjadi satu zona waktu. File yang dipilih adalah semua file di bawah folder yang sesuai dengan data tahun lalu.

File yang dipilih adalah semua file di bawah folder yang sesuai dengan data tahun lalu.

- Sekarang jika kita membuat tugas transformasi data, kita dapat melihat daftar semua parameter yang ditentukan, dan kita dapat mengganti nilai defaultnya sehingga tugas transformasi kita memilih file yang ditentukan.

Menjadwalkan pekerjaan pemrosesan

Anda sekarang dapat menjadwalkan tugas pemrosesan untuk mengotomatiskan menjalankan tugas transformasi data dan mengekspor data Anda yang telah diubah ke Amazon S3 atau Toko Fitur Amazon SageMaker. Anda dapat menjadwalkan pekerjaan dengan waktu dan periode yang sesuai dengan kebutuhan Anda.

Pekerjaan pemrosesan terjadwal digunakan Jembatan Acara Amazon aturan untuk menjadwalkan pekerjaan itu dijalankan. Oleh karena itu, sebagai prasyarat, Anda harus memastikan bahwa Identitas AWS dan Manajemen Akses (IAM) peran yang digunakan oleh Data Wrangler, yaitu Amazon SageMaker peran eksekusi dari instance Studio, memiliki izin untuk membuat aturan EventBridge.

Konfigurasi IAM

Lanjutkan dengan pembaruan berikut pada peran eksekusi IAM SageMaker yang sesuai dengan instans Studio tempat aliran Data Wrangler berjalan:

- Lampirkan AmazonEventBridgeAkses Penuh kebijakan yang dikelola.

- Lampirkan kebijakan untuk memberikan izin untuk membuat tugas pemrosesan:

- Berikan izin EventBridge untuk menjalankan peran tersebut dengan menambahkan kebijakan kepercayaan berikut:

Alternatifnya, jika Anda menggunakan peran yang berbeda untuk menjalankan tugas pemrosesan, terapkan kebijakan yang diuraikan dalam langkah 2 dan 3 ke peran tersebut. Untuk detail tentang konfigurasi IAM, lihat Buat Jadwal untuk Memproses Data Baru Secara Otomatis.

Buat jadwal

Untuk membuat jadwal, buka alur Anda di editor alur Data Wrangler.

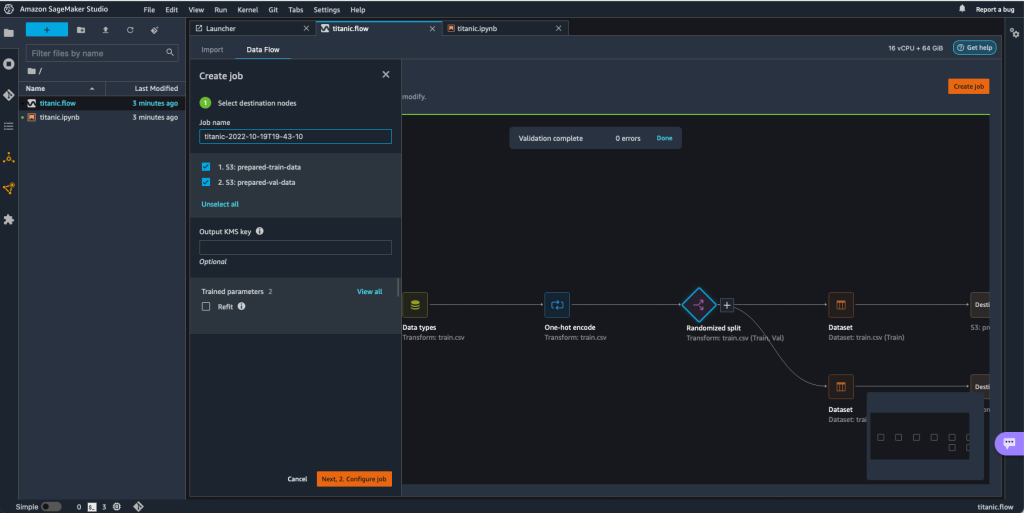

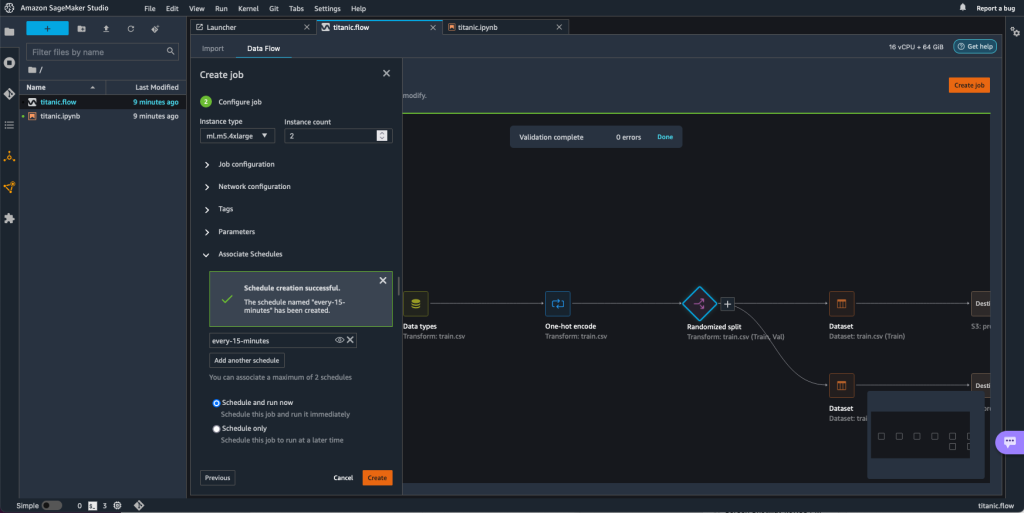

- pada Aliran data tab, pilih Ciptakan pekerjaan.

- Konfigurasikan bidang yang diperlukan dan pilih Selanjutnya, 2. Konfigurasi pekerjaan.

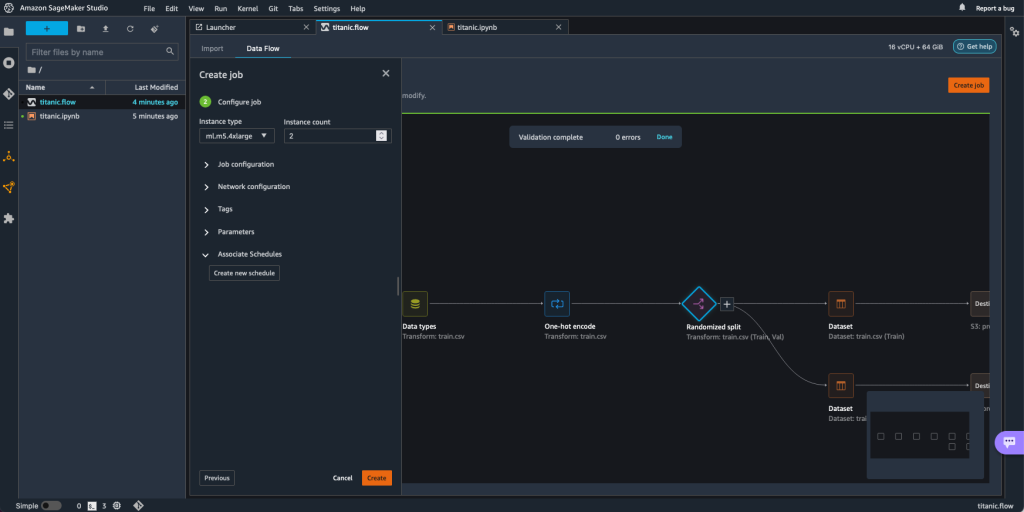

- Lihat lebih lanjut Jadwal Asosiasi.

- Pilih Buat jadwal baru.

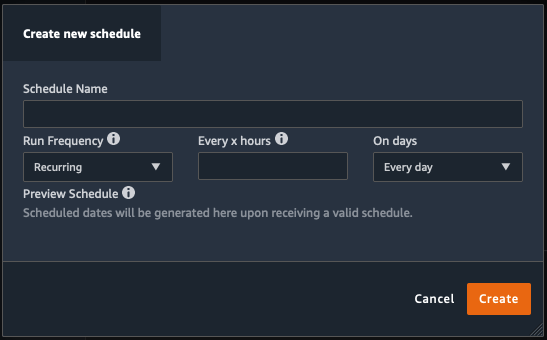

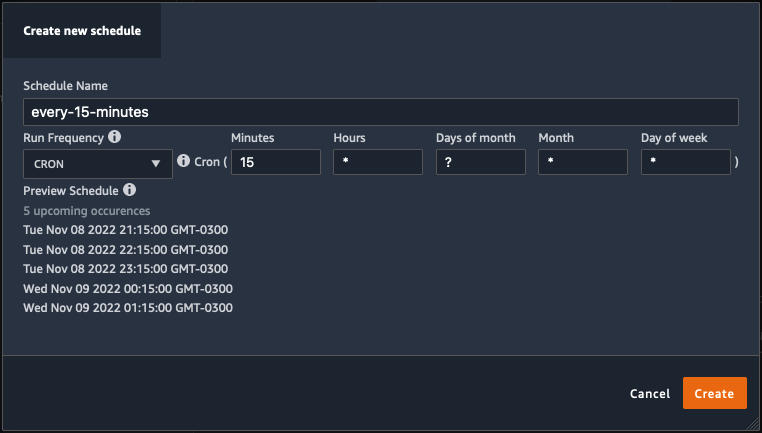

Grafik Buat jadwal baru dialog terbuka, tempat Anda menentukan detail jadwal pekerjaan pemrosesan.

Dialog menawarkan fleksibilitas yang besar untuk membantu Anda menentukan jadwal. Anda dapat menjalankan, misalnya, pekerjaan pemrosesan pada waktu tertentu atau setiap X jam, pada hari tertentu dalam seminggu.

Periodisitas dapat terperinci hingga tingkat menit.

- Tentukan nama jadwal dan periodisitas, lalu pilih membuat untuk menyimpan jadwal.

- Anda memiliki opsi untuk segera memulai tugas pemrosesan bersama dengan penjadwalan, yang menangani proses selanjutnya, atau membiarkan tugas berjalan hanya sesuai jadwal.

- Anda juga dapat menentukan jadwal tambahan untuk pekerjaan pemrosesan yang sama.

- Untuk menyelesaikan jadwal pekerjaan pemrosesan, pilih membuat.

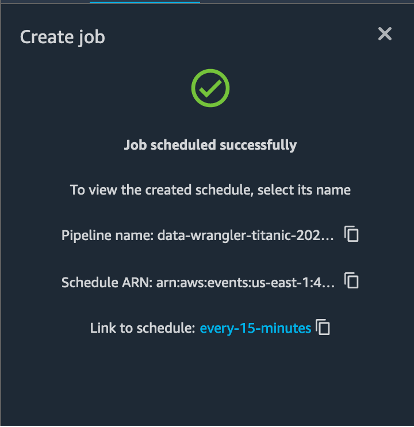

Anda melihat pesan "Pekerjaan berhasil dijadwalkan". Selain itu, jika Anda memilih untuk membiarkan pekerjaan hanya berjalan sesuai jadwal, Anda akan melihat tautan ke aturan EventBridge yang baru saja Anda buat.

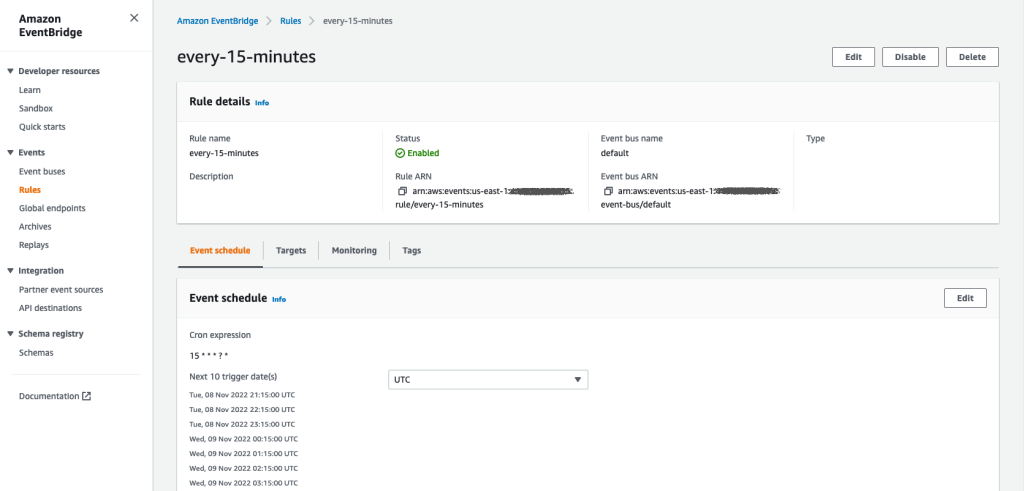

Jika Anda memilih tautan jadwal, tab baru di browser akan terbuka, menampilkan aturan EventBridge. Di halaman ini, Anda dapat membuat modifikasi lebih lanjut pada aturan dan melacak riwayat pemanggilannya. Untuk menghentikan pekerjaan pemrosesan terjadwal Anda berjalan, hapus aturan acara yang berisi nama jadwal.

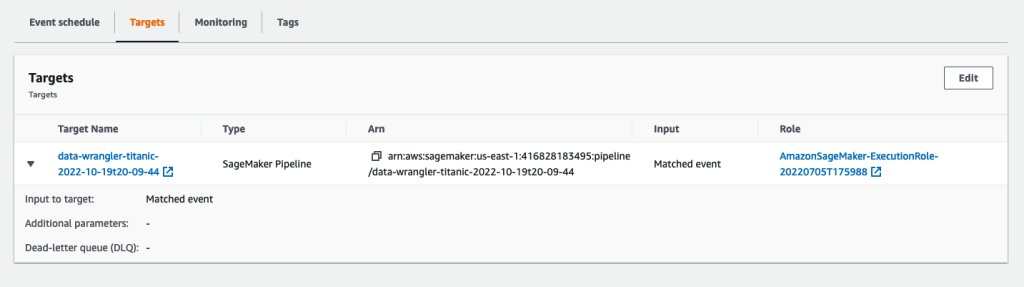

Aturan EventBridge menampilkan pipeline SageMaker sebagai targetnya, yang dipicu menurut jadwal yang ditentukan, dan tugas pemrosesan dipanggil sebagai bagian dari pipeline.

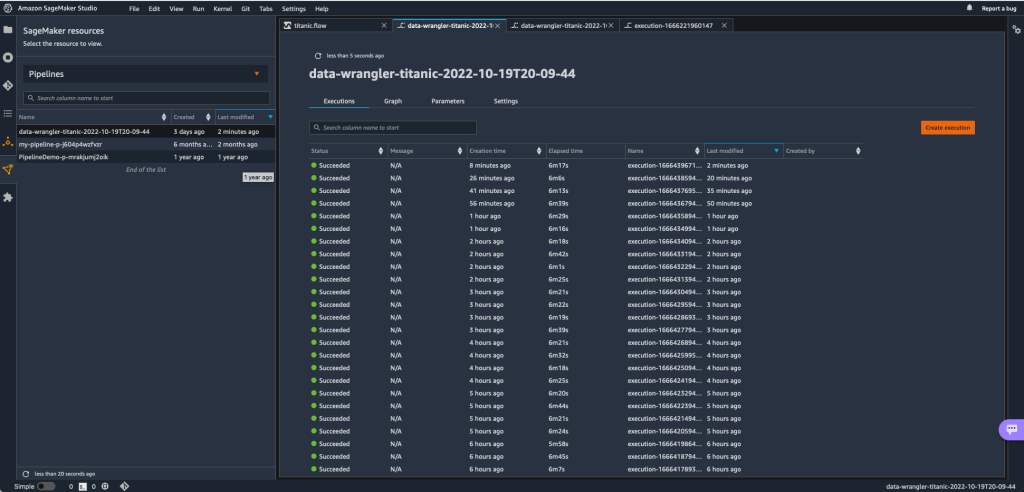

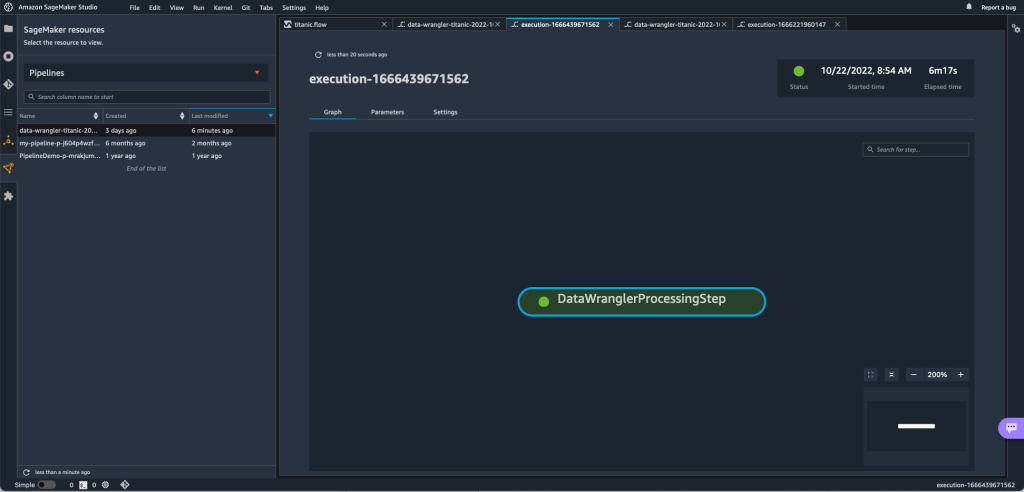

Untuk melacak jalannya pipeline SageMaker, Anda dapat kembali ke Studio, pilih Sumber daya SageMaker ikon, pilih Jaringan pipa, dan pilih nama alur yang ingin Anda lacak. Anda sekarang dapat melihat tabel dengan semua proses saat ini dan sebelumnya serta status alur tersebut.

Anda dapat melihat detail lebih lanjut dengan mengklik dua kali entri tertentu.

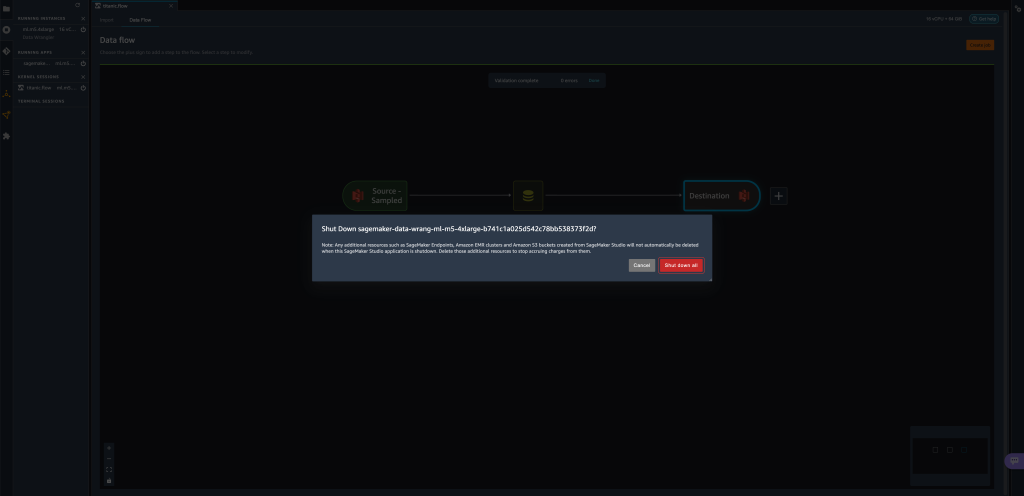

Membersihkan

Saat Anda tidak menggunakan Data Wrangler, disarankan untuk mematikan instans yang dijalankannya untuk menghindari biaya tambahan.

Untuk menghindari kehilangan pekerjaan, simpan aliran data Anda sebelum mematikan Data Wrangler.

- Untuk menyimpan aliran data Anda di Studio, pilih File, Lalu pilih Simpan Aliran Data Wrangler. Data Wrangler secara otomatis menyimpan aliran data Anda setiap 60 detik.

- Untuk mematikan instance Data Wrangler, di Studio, pilih Menjalankan Instance dan Kernel.

- Bawah APLIKASI YANG SEDANG BERJALAN, pilih ikon matikan di sebelah

sagemaker-data-wrangler-1.0.

- Pilih Matikan semua untuk mengkonfirmasi.

Data Wrangler berjalan pada instance ml.m5.4xlarge. Contoh ini menghilang dari INSTALASI YANG BERJALAN saat Anda mematikan aplikasi Data Wrangler.

Setelah Anda mematikan aplikasi Data Wrangler, itu harus dimulai ulang saat berikutnya Anda membuka file aliran Data Wrangler. Ini bisa memakan waktu beberapa menit.

Kesimpulan

Dalam postingan ini, kami mendemonstrasikan bagaimana Anda dapat menggunakan parameter untuk mengimpor kumpulan data Anda menggunakan alur Data Wrangler dan membuat tugas transformasi data di dalamnya. Kumpulan data berparameter memungkinkan lebih banyak fleksibilitas pada kumpulan data yang Anda gunakan dan memungkinkan Anda untuk menggunakan kembali aliran Anda. Kami juga mendemonstrasikan bagaimana Anda dapat menyiapkan tugas terjadwal untuk mengotomatiskan transformasi data dan mengekspor ke Amazon S3 atau Feature Store, pada waktu dan periode yang sesuai dengan kebutuhan Anda, langsung dari dalam antarmuka pengguna Data Wrangler.

Untuk mempelajari lebih lanjut tentang menggunakan aliran data dengan Data Wrangler, lihat Buat dan Gunakan Aliran Data Wrangler dan Harga Amazon SageMaker. Untuk memulai dengan Data Wrangler, lihat Siapkan Data ML dengan Amazon SageMaker Data Wrangler.

Tentang penulis

David Laredo adalah Arsitek Prototyping untuk tim Prototyping dan Cloud Engineering di Amazon Web Services, di mana dia telah membantu mengembangkan beberapa prototipe pembelajaran mesin untuk pelanggan AWS. Dia telah bekerja dalam pembelajaran mesin selama 6 tahun terakhir, melatih dan menyempurnakan model ML dan mengimplementasikan pipeline end-to-end untuk memproduksi model tersebut. Bidang minatnya adalah NLP, aplikasi ML, dan ML end-to-end.

David Laredo adalah Arsitek Prototyping untuk tim Prototyping dan Cloud Engineering di Amazon Web Services, di mana dia telah membantu mengembangkan beberapa prototipe pembelajaran mesin untuk pelanggan AWS. Dia telah bekerja dalam pembelajaran mesin selama 6 tahun terakhir, melatih dan menyempurnakan model ML dan mengimplementasikan pipeline end-to-end untuk memproduksi model tersebut. Bidang minatnya adalah NLP, aplikasi ML, dan ML end-to-end.

Givanildo Alves adalah Arsitek Prototyping dengan tim Prototyping dan Cloud Engineering di Amazon Web Services, membantu klien berinovasi dan mempercepat dengan menunjukkan seni kemungkinan di AWS, setelah menerapkan beberapa prototipe seputar kecerdasan buatan. Dia memiliki karir panjang dalam rekayasa perangkat lunak dan sebelumnya bekerja sebagai Insinyur Pengembangan Perangkat Lunak di Amazon.com.br.

Givanildo Alves adalah Arsitek Prototyping dengan tim Prototyping dan Cloud Engineering di Amazon Web Services, membantu klien berinovasi dan mempercepat dengan menunjukkan seni kemungkinan di AWS, setelah menerapkan beberapa prototipe seputar kecerdasan buatan. Dia memiliki karir panjang dalam rekayasa perangkat lunak dan sebelumnya bekerja sebagai Insinyur Pengembangan Perangkat Lunak di Amazon.com.br.

Adrian Fuentes adalah Manajer Program dengan tim Prototyping dan Cloud Engineering di Amazon Web Services, berinovasi untuk pelanggan dalam pembelajaran mesin, IoT, dan blockchain. Dia memiliki lebih dari 15 tahun pengalaman mengelola dan mengimplementasikan proyek dan 1 tahun masa kerja di AWS.

Adrian Fuentes adalah Manajer Program dengan tim Prototyping dan Cloud Engineering di Amazon Web Services, berinovasi untuk pelanggan dalam pembelajaran mesin, IoT, dan blockchain. Dia memiliki lebih dari 15 tahun pengalaman mengelola dan mengimplementasikan proyek dan 1 tahun masa kerja di AWS.

- AI

- ai seni

- generator seni ai

- punya robot

- Pembelajaran Mesin Amazon

- Pengatur Data Amazon SageMaker

- Pengumuman

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- pengolahan data

- belajar mendalam

- google itu

- Menengah (200)

- Mesin belajar

- Dataset berparameter

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- Pekerjaan terjadwal

- sintaksis

- Petunjuk Teknis

- zephyrnet.dll