Amazon SageMaker adalah layanan yang terkelola sepenuhnya yang memberi setiap developer dan ilmuwan data kemampuan untuk membangun, melatih, dan menerapkan model machine learning (ML) dalam skala besar dengan cepat. ML direalisasikan dalam inferensi. SageMaker menawarkan empat opsi Inferensi:

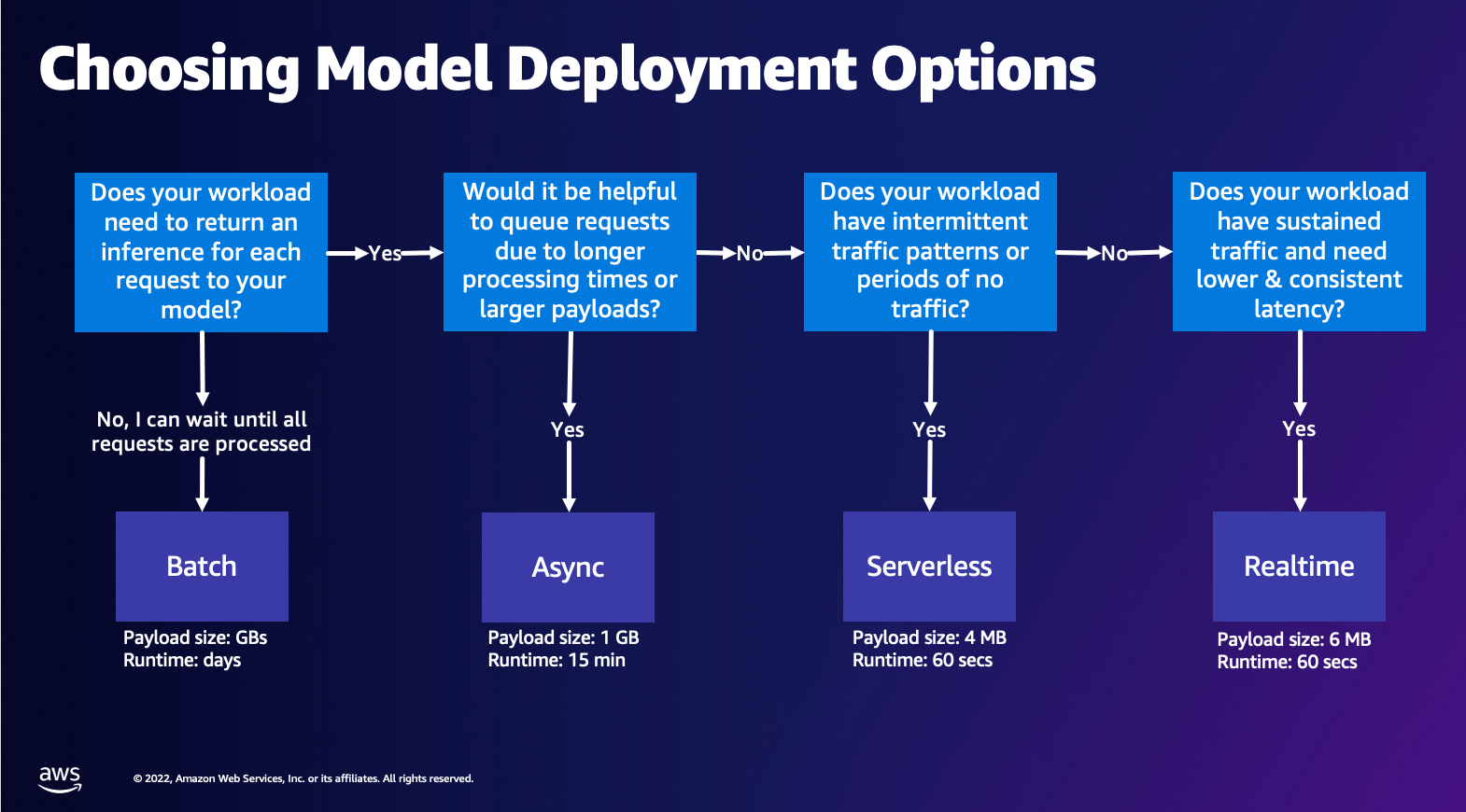

Keempat opsi ini dapat secara luas diklasifikasikan ke dalam opsi inferensi Online dan Batch. Dalam Inferensi Online, permintaan diharapkan diproses saat tiba, dan aplikasi yang menggunakan mengharapkan respons setelah setiap permintaan diproses. Ini dapat terjadi secara sinkron (Inferensi waktu nyata, tanpa server) atau secara tidak sinkron (inferensi asinkron). Dalam pola sinkron, aplikasi yang mengonsumsi diblokir dan tidak dapat melanjutkan hingga menerima respons. Beban kerja ini cenderung menjadi aplikasi waktu nyata, seperti deteksi penipuan kartu kredit online, di mana respons diharapkan dalam urutan milidetik hingga detik dan muatan permintaan kecil (beberapa MB). Dalam pola asinkron, pengalaman aplikasi tidak diblokir (misalnya, mengajukan klaim asuransi melalui aplikasi seluler), dan biasanya memerlukan ukuran muatan yang lebih besar dan/atau waktu pemrosesan yang lebih lama. Dalam inferensi Offline, agregasi (batch) permintaan inferensi diproses bersama, dan tanggapan diberikan hanya setelah seluruh batch diproses. Biasanya, beban kerja ini tidak sensitif terhadap latensi, melibatkan volume data yang besar (beberapa GB), dan dijadwalkan pada irama reguler (misalnya, menjalankan deteksi objek pada rekaman kamera keamanan di penghujung hari atau memproses data penggajian di akhir bulan).

Pada tulang telanjang, Inferensi Waktu Nyata SageMaker terdiri dari model, kerangka kerja/wadah yang Anda gunakan, dan infrastruktur/instance yang mendukung titik akhir yang Anda terapkan. Dalam posting ini, kami akan mengeksplorasi bagaimana Anda dapat membuat dan memanggil Titik Akhir Model Tunggal.

Memilih opsi penerapan model

Memilih jenis inferensi yang tepat bisa jadi sulit, dan panduan sederhana berikut dapat membantu Anda. Ini bukan diagram alur yang ketat, jadi jika Anda menemukan bahwa opsi lain bekerja lebih baik untuk Anda, silakan gunakan itu. Secara khusus, Inferensi Real-Time adalah opsi yang bagus untuk menghosting model Anda saat Anda memiliki latensi yang rendah dan konsisten (dalam urutan milidetik atau detik) dan beban kerja sensitif throughput. Anda dapat mengontrol jenis instans dan menghitung di belakang titik akhir Anda sambil juga mengonfigurasi Penskalaan Otomatis kebijakan untuk menangani lalu lintas. Ada dua opsi Inferensi SageMaker lain yang juga dapat Anda gunakan untuk membuat titik akhir. Inferensi Asinkron adalah saat Anda memiliki ukuran muatan yang besar dan bandwidth latensi yang mendekati waktu nyata. Ini adalah pilihan yang baik, terutama untuk model NLP dan Computer Vision yang memiliki waktu prapemrosesan lebih lama. Inferensi Tanpa Server adalah opsi yang bagus ketika Anda memiliki lalu lintas yang terputus-putus dan tidak ingin mengelola penskalaan infrastruktur. Resep untuk membuat titik akhir tetap sama terlepas dari jenis Inferensi yang Anda pilih. Dalam posting ini, kami akan fokus pada pembuatan titik akhir berbasis instans waktu nyata, tetapi Anda dapat dengan mudah menyesuaikannya dengan salah satu Opsi Inferensi lainnya berdasarkan kasus penggunaan Anda. Terakhir, inferensi Batch berlangsung offline, sehingga Anda dapat memberikan satu set data yang ingin Anda dapatkan inferensinya dan kami akan menjalankannya. Ini juga berbasis instans, sehingga Anda dapat memilih instans optimal untuk beban kerja Anda. Karena tidak ada titik akhir yang aktif dan berjalan, Anda hanya membayar selama durasi pekerjaan. Ini bagus untuk memproses gigabyte data dan durasi pekerjaan bisa berhari-hari. Ada fitur bawaan untuk mempermudah pekerjaan dengan data terstruktur dan pengoptimalan untuk mendistribusikan data terstruktur secara otomatis. Beberapa contoh kasus penggunaan adalah pemodelan kecenderungan, pemeliharaan prediktif, dan prediksi churn. Semua ini dapat berlangsung offline secara massal karena tidak harus bereaksi terhadap peristiwa tertentu.

Menghosting model di Titik Akhir SageMaker

Pada intinya, Titik Akhir SageMaker Real-Time terdiri dari model dan infrastruktur yang Anda pilih untuk mendukung Titik Akhir. SageMaker menggunakan wadah untuk meng-host model, yang berarti Anda memerlukan wadah yang menyiapkan lingkungan dengan benar untuk kerangka kerja yang Anda gunakan untuk setiap model yang Anda sediakan. Misalnya, jika Anda bekerja dengan model Sklearn, Anda harus meneruskan skrip/data model Anda ke dalam wadah yang menyiapkan Sklearn dengan benar. Untungnya, SageMaker menyediakan gambar yang dikelola untuk kerangka kerja populer, seperti TensorFlow, PyTorch, Sklearn, dan HuggingFace. Anda dapat mengambil dan memanfaatkan gambar-gambar ini menggunakan level tinggi SDK Python SageMaker dan masukkan skrip model dan data Anda ke dalam wadah ini. Jika SageMaker tidak memiliki wadah yang didukung, Anda juga dapat Bangun Wadah Anda Sendiri dan Dorong gambar kustom Anda sendiri, instal dependensi yang diperlukan untuk model Anda.

SageMaker mendukung model terlatih dan pra-terlatih. Di paragraf sebelumnya ketika kita berbicara tentang skrip/data model, kita merujuk hal ini. Anda dapat memasang skrip pada penampung Anda, atau jika Anda memiliki artefak model yang telah dilatih sebelumnya (misalnya, `model.joblib` untuk SKLearn), maka Anda dapat memberikan ini bersama dengan gambar Anda ke SageMaker. Untuk memahami Inferensi SageMaker, ada tiga entitas utama yang akan Anda buat dalam proses pembuatan Endpoint:

- SageMaker Model Entity – Di sini Anda dapat meneruskan data model/skrip model terlatih dan gambar yang sedang Anda kerjakan, baik yang dimiliki oleh AWS atau dibuat oleh Anda.

- Pembuatan konfigurasi titik akhir – Di sini Anda menentukan infrastruktur Anda, artinya Anda memilih jenis instans, jumlah, dll.

- Pembuatan titik akhir – Ini adalah Titik Akhir REST yang meng-host model Anda yang Anda panggil untuk mendapatkan respons. Mari kita lihat bagaimana Anda dapat menggunakan Gambar SageMaker terkelola dan gambar yang dibuat khusus untuk menerapkan titik akhir.

Persyaratan titik akhir waktu nyata

- Sebelum membuat Endpoint, Anda harus memahami jenis Model apa yang ingin Anda host. Jika itu adalah model Kerangka, seperti TensorFlow, PyTorch, atau MXNet, maka Anda dapat menggunakan salah satu gambar Kerangka yang sudah dibuat sebelumnya.

Jika itu adalah model khusus, atau Anda ingin fleksibilitas penuh dalam membuat wadah yang akan dijalankan SageMaker untuk inferensi, maka Anda dapat membangun wadah Anda sendiri.

Titik Akhir SageMaker terdiri dari Model Pembuat Sage dan Konfigurasi titik akhir.

Jika Anda menggunakan Boto3, maka Anda akan membuat kedua objek tersebut. Jika tidak, jika Anda menggunakan SageMaker Python SDK, maka Konfigurasi Titik Akhir dibuat atas nama Anda saat Anda menggunakan .deploy(..) fungsi.

Entitas SageMaker:

- Model Pembuat Sage:

- Berisi detail gambar inferensi, lokasi artefak model di Layanan Penyimpanan Sederhana Amazon (Amazon S3), konfigurasi jaringan, dan Identitas dan Manajemen Akses AWS (IAM) peran yang akan digunakan oleh Endpoint.

- SageMaker memerlukan artefak model Anda untuk dikompresi dalam a

.tar.gzmengajukan. SageMaker secara otomatis mengekstrak ini.tar.gzfile ke dalam/opt/ml/model/direktori di wadah Anda. Jika Anda menggunakan salah satu wadah kerangka kerja, seperti TensorFlow, PyTorch, atau MXNet, wadah mengharapkan struktur TAR Anda sebagai berikut:- TensorFlow

- PyTorch

- MX Net

- Sklearn

- TensorFlow

- Saat menggunakan gambar Kerangka, kami dapat menyediakan skrip titik masuk khusus, tempat kami dapat menerapkan pemrosesan pra dan pasca kami sendiri. Dalam kasus kami, skrip inferensi dikemas dalam model.tar.gz di bawah direktori /code.

- SageMaker memerlukan artefak model Anda untuk dikompresi dalam a

- Berisi detail gambar inferensi, lokasi artefak model di Layanan Penyimpanan Sederhana Amazon (Amazon S3), konfigurasi jaringan, dan Identitas dan Manajemen Akses AWS (IAM) peran yang akan digunakan oleh Endpoint.

-

- Konfigurasi titik akhir

- Berisi informasi infrastruktur yang diperlukan untuk menerapkan Model SageMaker ke Endpoint.

- Misalnya, Model SageMaker yang kami buat ditentukan di sini serta Jenis Instance dan jumlah Instance Awal.

Kerangka kerja dan BYOC

-

- Mengambil gambar SageMaker

- Bagian ini tidak selalu diperlukan dan diabstraksikan oleh SageMaker Python SDK melalui estimator. Namun, jika Anda ingin dapat mengambil gambar yang dikelola SageMaker untuk diperluas, Anda bisa mendapatkan gambar yang tersedia melalui SDK. Berikut ini adalah contoh pengambilan gambar TF 2.2 untuk inferensi.

- Kerangka

- Jika Anda ingin menerapkan Model Kerangka, seperti TensorFlow, PyTorch, atau MXNet, maka yang Anda butuhkan hanyalah artefak model.

- Lihat dokumentasi untuk menerapkan model langsung dari artefak model untuk TensorFlow, PyTorch, atau MX Net.

- Mengambil gambar SageMaker

-

- Memilih antara 1P dan BYOC

- SageMaker SDK juga mengabstraksikan penanganan gambar, seperti yang Anda lihat di bagian Kerangka sebelumnya. Ini memiliki estimator siap pakai untuk Sklearn, TensorFlow, dan PyTorch yang secara otomatis memilih gambar untuk Anda berdasarkan versi yang Anda pilih. Kemudian Anda dapat meneruskan skrip pelatihan/inferensi melalui Modus Skrip ke dalam estimator ini.

- Tidak semua paket dan gambar didukung oleh SageMaker, dan dalam hal ini Anda harus bawa wadah sendiri (BYOC). Ini berarti membangun Dockerfile yang akan menyiapkan lingkungan yang tepat untuk penyajian model Anda. Contohnya adalah modul Spacy NLP, dan tidak ada wadah SageMaker yang dikelola untuk kerangka kerja ini. Oleh karena itu, Anda harus menyediakan Dockerfile yang menginstal Spacy. Di dalam wadah, Anda juga memasang skrip inferensi model Anda. Mari kita bahas dengan cepat komponen yang Anda sediakan dalam format Bring Your Own Container, karena ini tetap konsisten untuk sebagian besar contoh.

- "nginx.conf" adalah file konfigurasi untuk front-end nginx. Anda tidak perlu mengedit file ini, kecuali jika Anda ingin menyetel bagian ini.

- “prediktor.py“ adalah program yang benar-benar mengimplementasikan server web Flask dan kode model untuk aplikasi Anda. Anda dapat memiliki file atau fungsi Python lebih lanjut di wadah Anda yang dapat Anda panggil di file ini.

- "melayani" adalah program dimulai ketika wadah dimulai untuk hosting. Itu hanya meluncurkan server gunicorn, yang menjalankan beberapa contoh aplikasi Flask yang ditentukan dalam predictor.py. Seperti nginx.conf, Anda tidak perlu mengedit file ini kecuali ada penyetelan lebih lanjut yang ingin Anda lakukan.

- "kereta" adalah program yang dipanggil ketika wadah dijalankan untuk pelatihan. Anda akan memodifikasi program ini untuk mengimplementasikan algoritme pelatihan Anda. Jika Anda membawa model atau kerangka kerja yang telah dilatih sebelumnya seperti Spacy, maka Anda tidak memerlukan file ini.

- “wsgi.py“ adalah pembungkus kecil yang digunakan untuk memanggil aplikasi Flask. Anda seharusnya dapat mengambil file ini apa adanya, kecuali jika Anda telah mengubah nama file prediktor.py Anda. Dalam hal ini, pastikan bahwa memetakan dengan benar di sini.

- Memilih antara 1P dan BYOC

-

- Skrip inferensi khusus

- Wadah SageMaker Framework memberi Anda fleksibilitas untuk menangani pemrosesan pra/pasca permintaan dan pemuatan model menggunakan skrip titik masuk khusus/inference.py.

- Lihat dokumentasi untuk membuat skrip inference.py khusus untuk TensorFlow, PyTorch dan MX Net.

- Wadah khusus

- Skrip inferensi khusus

Berbagai cara Anda dapat berinteraksi dengan Titik Akhir SageMaker

Ada banyak opsi untuk menggunakan SageMaker secara terprogram sehingga Anda dapat memanggil model yang digunakan untuk mendapatkan inferensi. Itu Antarmuka Baris Perintah AWS (AWS CLI), API REST, Formasi AWS Cloud, Kit Pengembangan AWS Cloud (AWS CDK), dan AWS SDK adalah alat umum yang ditawarkan oleh AWS dan didukung secara luas oleh layanan AWS lainnya. Untuk SageMaker, kami juga memiliki SageMaker Python SDK. Sekarang, mari kita bandingkan berbagai opsi untuk membuat, memanggil, dan mengelola Titik Akhir SageMaker.

Selain CLI SageMaker, ada dua cara secara terprogram agar Anda dapat berinteraksi dengan Endpoint di SageMaker melalui SDK. Mari kita lihat beberapa perbedaan antara SDK Python SageMaker dan SDK Boto3 Python:

- SDK “Python” SageMaker tingkat tinggi – SDK ini adalah pustaka sumber terbuka yang menyediakan abstraksi tingkat lebih tinggi yang secara khusus dimaksudkan untuk memanggil API SageMaker secara terprogram menggunakan Python. Bagian yang baik dari SDK ini adalah sangat mudah untuk memanggil API sagemaker, banyak pekerjaan berat yang sudah dilakukan seperti memanggil API secara sinkron/mode asinkron (membantu menghindari polling), skema permintaan/respons yang lebih sederhana, kode yang jauh lebih sedikit, dan banyak lagi. kode yang lebih sederhana. SageMaker Python SDK menyediakan beberapa abstraksi tingkat tinggi untuk bekerja dengan SageMaker. Paket ini dimaksudkan untuk menyederhanakan berbagai proses ML di SageMaker.

- AWS SDK (Boto3 SDK) tingkat rendah – SDK ini bekerja pada tingkat yang lebih rendah dengan memungkinkan pengguna untuk memilih dari bahasa pemrograman yang didukung dan memanggil layanan AWS apa pun secara terprogram. Ini tidak hanya khusus untuk SageMaker tetapi dapat digunakan secara umum untuk semua layanan AWS. AWS SDK tingkat rendah tersedia dalam berbagai bahasa pemrograman, seperti .NET, Python, Java, Node.js, dll. Salah satu SDK populer yang digunakan adalah boto3 python SDK, yang populer di komunitas ilmuwan data untuk ML. Bagian yang baik dari SDK ini adalah sangat ringan dan tersedia secara default diinstal pada AWS Lambda Waktu tayang. Selanjutnya, Anda dapat menggunakan SDK ini untuk berinteraksi dengan layanan AWS apa pun di luar SageMaker.

Kedua SDK ini dapat digunakan untuk tugas yang sama, tetapi dalam beberapa kasus lebih intuitif untuk menggunakan satu lebih dari yang lain. SageMaker Python SDK direkomendasikan untuk pengujian yang mudah sementara AWS SDK/Boto3 direkomendasikan untuk kasus penggunaan produksi untuk kontrol kinerja yang lebih baik. Misalnya, SageMaker sebagai layanan menyediakan gambar yang dibuat sebelumnya dan dipelihara untuk kerangka kerja populer, seperti Sklearn, PyTorch, dan TensorFlow. Penggunaan SageMaker SDK akan sangat berguna untuk mengambil gambar pembelajaran mendalam, melatih model menggunakan Pengukur, dan menerapkan model dengan mudah menggunakan panggilan API sederhana. Contoh untuk menunjukkan ini dalam tindakan dapat ditemukan di sini.

Di sisi lain, terkadang Anda memiliki model yang telah dilatih sebelumnya atau kerangka kerja berbeda yang mungkin Anda gunakan. Ini membutuhkan lebih banyak penyesuaian dan SageMaker SDK tidak selalu menawarkan itu. Kami memiliki tiga langkah penting dan panggilan API boto3 terkait yang perlu kami jalankan untuk menerapkan titik akhir: Pembuatan Model, Pembuatan Konfigurasi Endpoint, dan Pembuatan Titik Akhir. Dua entitas pertama diabstraksikan dengan SageMaker SDK dengan kerangka kerja yang kami dukung, tetapi kami melihat detail tersebut dengan Boto3 SDK. Contoh ekstensif untuk menunjukkan langkah-langkah yang terlibat dalam menggunakan Boto3 SDK untuk membuat dan mengelola titik akhir dapat ditemukan di sini.

Pertimbangan hosting SageMaker

SageMaker Real-Time Inference memiliki dua pengoptimalan utama yang dapat Anda pertimbangkan: 1/ Pengoptimalan kinerja, dan 2/ Pengoptimalan biaya. Mari kita lihat dulu optimasi kinerja, seperti ketika kita berurusan dengan beban kerja yang sensitif terhadap latensi, setiap milidetik sangat penting. Ada berbagai kenop yang dapat Anda setel untuk mengoptimalkan latensi dan throughput Anda. Pada tingkat instance, Anda dapat menggunakan Rekomendasi Inferensi, alat pengujian beban bawaan kami, untuk membantu Anda memilih jenis instans yang tepat dan menghitung beban kerja Anda. Memanfaatkan kombinasi komputasi yang tepat akan membantu Anda dengan kinerja dan biaya. Anda juga dapat menyetel di tingkat wadah dan kerangka kerja.

Pertanyaan untuk ditanyakan pada diri sendiri meliputi:

- Kerangka kerja apa yang Anda gunakan?

- Apakah ada variabel lingkungan yang dapat Anda sesuaikan di dalam wadah Anda?

Contohnya adalah memaksimalkan Performa TensorFlow dengan container SageMaker. Contoh lain dari pengoptimalan tingkat penampung adalah menggunakan gRPC daripada REST di belakang titik akhir Anda. Terakhir, Anda juga dapat mengoptimalkan di tingkat skrip. Apakah kode inferensi Anda membutuhkan waktu ekstra di blok tertentu? Mengatur waktu setiap baris skrip Anda akan membantu Anda menangkap hambatan apa pun dalam kode Anda.

Ada tiga cara untuk melihat meningkatkan pemanfaatan dari titik akhir Waktu Nyata Anda:

- Titik Akhir Multi-model (MME)

- Anda dapat meng-host ribuan model di belakang satu titik akhir. Ini sempurna untuk kasus penggunaan di mana Anda tidak memerlukan titik akhir khusus untuk setiap model Anda. MME berfungsi paling baik jika model memiliki ukuran dan latensi yang sama serta termasuk dalam kerangka kerja ML yang sama. Ini biasanya dapat digunakan ketika Anda tidak perlu memanggil model yang sama setiap saat. Anda dapat memuat model masing-masing secara dinamis ke Titik Akhir SageMaker untuk melayani permintaan Anda. Contoh yang menampilkan aksi MME dapat ditemukan di sini. Jika Anda ingin mempelajari lebih lanjut tentang berbagai peringatan dan praktik terbaik untuk model hosting di MME, lihat posting di sini.

- Titik Akhir Multi-Kontainer (MCE)

- Alih-alih menggunakan beberapa titik akhir untuk meng-host beberapa kontainer, Anda dapat melihat hosting hingga 15 kontainer pada satu titik akhir. Masing-masing wadah ini dapat dipanggil secara langsung. Oleh karena itu, Anda dapat melihat model hosting yang berbeda dari kerangka kerja yang berbeda semuanya pada satu titik akhir. Opsi ini paling baik bila wadah menunjukkan karakteristik penggunaan dan kinerja yang serupa. Contoh yang menampilkan MCE dapat ditemukan di sini. Jika Anda ingin mempelajari lebih lanjut tentang berbagai peringatan dan praktik terbaik untuk model hosting di MCE, lihat postingan di sini.

- Pipa Inferensi Serial (SIP)

- Jika Anda memiliki alur langkah-langkah dalam logika inferensi Anda, maka Anda dapat menggunakan Serial Inference Pipeline (SIP). SIP memungkinkan Anda merangkai 2-15 kontainer bersama-sama di belakang satu titik akhir. SIP bekerja dengan baik ketika Anda memiliki langkah-langkah pra-pemrosesan dan pasca-pemrosesan. Jika Anda ingin mempelajari lebih lanjut tentang pola desain untuk saluran pipa inferensi serial, lihat posting di sini.

Pengoptimalan utama kedua yang perlu diingat adalah biaya. Inferensi Waktu Nyata adalah salah satu dari tiga opsi dalam membuat Titik Akhir SageMaker. Titik Akhir SageMaker berjalan setiap saat kecuali dihapus. Oleh karena itu, Anda harus melihat peningkatan pemanfaatan titik akhir yang pada gilirannya memberikan manfaat biaya.

SageMaker juga menawarkan Paket Hemat. Savings Plans dapat mengurangi biaya Anda hingga 64%. Ini adalah komitmen jangka waktu 1 atau 3 tahun untuk jumlah penggunaan yang konsisten ($/jam). Lihat ini link untuk informasi lebih lanjut. Dan lihat ini link untuk mengoptimalkan biaya Inferensi di Amazon SageMaker.

Kesimpulan

Dalam posting ini, kami menunjukkan kepada Anda beberapa praktik terbaik untuk memilih di antara berbagai opsi hosting model di SageMaker. Kami membahas persyaratan Titik Akhir SageMaker, dan juga membandingkan persyaratan dan fungsionalitas Framework dan BYOC. Selain itu, kami berbicara tentang berbagai cara Anda dapat memanfaatkan Titik Akhir Real-Time untuk menghosting model ML Anda dalam produksi. dengan cara yang hemat biaya, dan memiliki kinerja tinggi.

Lihat yang sesuai Repositori GitHub dan coba contoh-contohnya.

Tentang penulis

Raghu Ramesha adalah Arsitek Solusi ML dengan tim Layanan Amazon SageMaker. Dia berfokus untuk membantu pelanggan membangun, menerapkan, dan memigrasikan beban kerja produksi ML ke SageMaker dalam skala besar. Dia mengkhususkan diri dalam pembelajaran mesin, AI, dan domain visi komputer, dan memegang gelar master di bidang Ilmu Komputer dari UT Dallas. Di waktu senggangnya, ia senang bepergian dan fotografi.

Raghu Ramesha adalah Arsitek Solusi ML dengan tim Layanan Amazon SageMaker. Dia berfokus untuk membantu pelanggan membangun, menerapkan, dan memigrasikan beban kerja produksi ML ke SageMaker dalam skala besar. Dia mengkhususkan diri dalam pembelajaran mesin, AI, dan domain visi komputer, dan memegang gelar master di bidang Ilmu Komputer dari UT Dallas. Di waktu senggangnya, ia senang bepergian dan fotografi.

Ram Vegaraju adalah Arsitek ML dengan tim Layanan SageMaker. Dia berfokus untuk membantu pelanggan membangun dan mengoptimalkan solusi AI/ML mereka di Amazon SageMaker. Di waktu luangnya, dia suka bepergian dan menulis.

Ram Vegaraju adalah Arsitek ML dengan tim Layanan SageMaker. Dia berfokus untuk membantu pelanggan membangun dan mengoptimalkan solusi AI/ML mereka di Amazon SageMaker. Di waktu luangnya, dia suka bepergian dan menulis.

Marc Karpa adalah Arsitek ML dengan tim Layanan SageMaker. Dia berfokus untuk membantu pelanggan merancang, menerapkan, dan mengelola beban kerja ML dalam skala besar. Di waktu luangnya, ia senang bepergian dan menjelajahi tempat-tempat baru.

Marc Karpa adalah Arsitek ML dengan tim Layanan SageMaker. Dia berfokus untuk membantu pelanggan merancang, menerapkan, dan mengelola beban kerja ML dalam skala besar. Di waktu luangnya, ia senang bepergian dan menjelajahi tempat-tempat baru.

Dhawal Patel adalah Arsitek Pembelajaran Mesin Utama di AWS. Dia telah bekerja dengan organisasi mulai dari perusahaan besar hingga perusahaan rintisan menengah pada masalah yang terkait dengan komputasi terdistribusi dan kecerdasan buatan. Dia berfokus pada pembelajaran mendalam, termasuk NLP dan domain visi komputer. Dia membantu pelanggan mencapai inferensi model performa tinggi di Amazon SageMaker.

Dhawal Patel adalah Arsitek Pembelajaran Mesin Utama di AWS. Dia telah bekerja dengan organisasi mulai dari perusahaan besar hingga perusahaan rintisan menengah pada masalah yang terkait dengan komputasi terdistribusi dan kecerdasan buatan. Dia berfokus pada pembelajaran mendalam, termasuk NLP dan domain visi komputer. Dia membantu pelanggan mencapai inferensi model performa tinggi di Amazon SageMaker.

Saurabh Trikande adalah Manajer Produk Senior untuk Inferensi Amazon SageMaker. Dia bersemangat bekerja dengan pelanggan dan termotivasi oleh tujuan mendemokratisasi pembelajaran mesin. Dia berfokus pada tantangan inti yang terkait dengan penerapan aplikasi ML yang kompleks, model ML multi-penyewa, pengoptimalan biaya, dan membuat penerapan model pembelajaran mendalam lebih mudah diakses. Di waktu luangnya, Saurabh menikmati hiking, belajar tentang teknologi inovatif, mengikuti TechCrunch, dan menghabiskan waktu bersama keluarganya.

Saurabh Trikande adalah Manajer Produk Senior untuk Inferensi Amazon SageMaker. Dia bersemangat bekerja dengan pelanggan dan termotivasi oleh tujuan mendemokratisasi pembelajaran mesin. Dia berfokus pada tantangan inti yang terkait dengan penerapan aplikasi ML yang kompleks, model ML multi-penyewa, pengoptimalan biaya, dan membuat penerapan model pembelajaran mendalam lebih mudah diakses. Di waktu luangnya, Saurabh menikmati hiking, belajar tentang teknologi inovatif, mengikuti TechCrunch, dan menghabiskan waktu bersama keluarganya.

- Lanjutan (300)

- AI

- ai seni

- generator seni ai

- punya robot

- Amazon SageMaker

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll