Pengantar

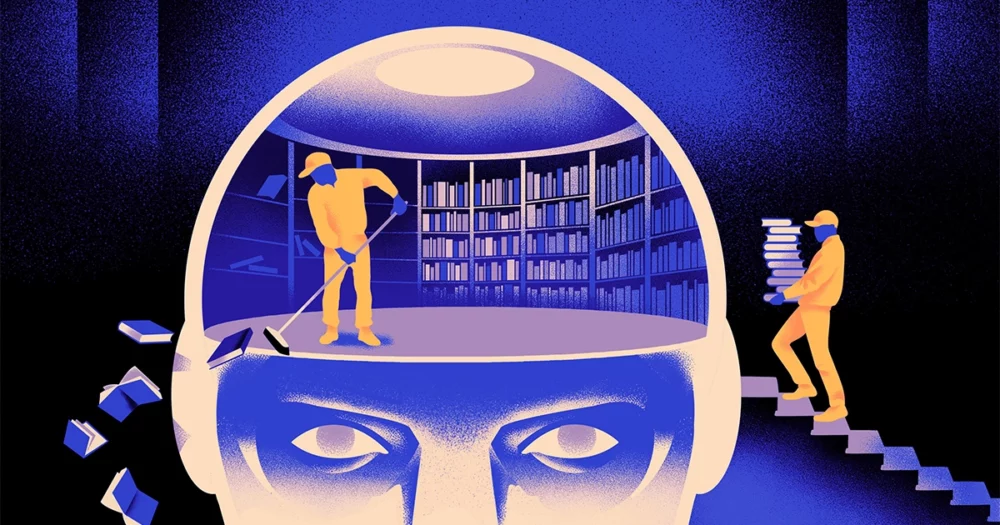

Sebuah tim ilmuwan komputer telah menciptakan a tipe yang lebih gesit, lebih fleksibel model pembelajaran mesin. Caranya: Ia harus secara berkala melupakan apa yang diketahuinya. Meskipun pendekatan baru ini tidak akan menggantikan model-model besar yang mendasari aplikasi-aplikasi terbesar, pendekatan baru ini dapat mengungkapkan lebih banyak tentang bagaimana program-program ini memahami bahasa.

Penelitian baru ini menandai “kemajuan signifikan di bidang ini,” katanya Jea Kwon, seorang insinyur AI di Institute for Basic Science di Korea Selatan.

Mesin bahasa AI yang digunakan saat ini sebagian besar didukung oleh jaringan saraf tiruan. Setiap “neuron” dalam jaringan adalah fungsi matematika yang menerima sinyal dari neuron lain, menjalankan beberapa perhitungan, dan mengirimkan sinyal melalui beberapa lapisan neuron. Awalnya aliran informasi kurang lebih acak, namun melalui pelatihan, aliran informasi antar neuron meningkat seiring dengan adaptasi jaringan terhadap data pelatihan. Jika seorang peneliti AI ingin membuat model bilingual, misalnya, dia akan melatih model tersebut dengan tumpukan besar teks dari kedua bahasa, yang akan menyesuaikan koneksi antar neuron sedemikian rupa sehingga dapat menghubungkan teks dalam satu bahasa dengan bahasa yang setara. kata-kata di sisi lain.

Namun proses pelatihan ini membutuhkan banyak daya komputasi. Jika modelnya tidak bekerja dengan baik, atau jika kebutuhan pengguna berubah di kemudian hari, akan sulit untuk mengadaptasinya. “Misalnya Anda memiliki model yang memiliki 100 bahasa, tetapi bayangkan satu bahasa yang Anda inginkan tidak tercakup,” katanya Mikel Artetxe, salah satu penulis penelitian baru dan pendiri startup AI Reka. “Anda bisa memulai dari awal, tapi itu tidak ideal.”

Artetxe dan rekan-rekannya telah mencoba untuk menghindari keterbatasan ini. Beberapa tahun yang lalu, Artetxe dan yang lainnya melatih jaringan saraf dalam satu bahasa, lalu menghapus apa yang diketahuinya tentang bahan penyusun kata, yang disebut token. Ini disimpan di lapisan pertama jaringan saraf, yang disebut lapisan penyematan. Mereka membiarkan semua lapisan model lainnya. Setelah menghapus token bahasa pertama, mereka melatih ulang model pada bahasa kedua, yang mengisi lapisan penyematan dengan token baru dari bahasa tersebut.

Meskipun model tersebut berisi informasi yang tidak cocok, pelatihan ulang berhasil: Model dapat mempelajari dan memproses bahasa baru. Para peneliti menduga bahwa meskipun lapisan penyematan menyimpan informasi spesifik tentang kata-kata yang digunakan dalam bahasa tersebut, tingkat jaringan yang lebih dalam menyimpan lebih banyak informasi abstrak tentang konsep di balik bahasa manusia, yang kemudian membantu model mempelajari bahasa kedua.

“Kita hidup di dunia yang sama. Kami mengonsep hal yang sama dengan kata-kata yang berbeda” dalam bahasa yang berbeda, kata Yi Hong Chen, penulis utama makalah terbaru. “Itulah mengapa Anda memiliki alasan tingkat tinggi yang sama dalam model tersebut. Sebuah apel adalah sesuatu yang manis dan berair, bukan hanya sebuah kata.”

Pengantar

Meskipun pendekatan melupakan ini merupakan cara yang efektif untuk menambahkan bahasa baru ke model yang sudah dilatih, pelatihan ulang masih tetap menuntut — hal ini memerlukan banyak data linguistik dan kekuatan pemrosesan. Chen menyarankan perubahan: Daripada melatih, menghapus lapisan penyematan, lalu melatih ulang, mereka harus menyetel ulang lapisan penyematan secara berkala selama putaran awal pelatihan. “Dengan melakukan ini, seluruh model akan terbiasa melakukan pengaturan ulang,” kata Artetxe. “Itu berarti ketika Anda ingin memperluas model ke bahasa lain, itu lebih mudah, karena itulah yang selama ini Anda lakukan.”

Para peneliti mengambil model bahasa yang umum digunakan yang disebut Roberta, melatihnya menggunakan teknik melupakan secara berkala, dan membandingkannya dengan performa model yang sama saat dilatih dengan pendekatan standar dan tanpa melupakan. Model lupa memberikan kinerja yang sedikit lebih buruk dibandingkan model konvensional, yaitu menerima skor 85.1 dibandingkan dengan 86.1 pada satu ukuran umum keakuratan bahasa. Kemudian mereka melatih ulang model tersebut dalam bahasa lain, menggunakan kumpulan data yang jauh lebih kecil, yaitu hanya 5 juta token, dibandingkan 70 miliar yang mereka gunakan pada pelatihan pertama. Akurasi model standar rata-rata menurun menjadi 53.3, namun model lupa hanya turun menjadi 62.7.

Model lupa juga bekerja jauh lebih baik jika tim menerapkan batasan komputasi selama pelatihan ulang. Ketika para peneliti mengurangi panjang pelatihan dari 125,000 langkah menjadi hanya 5,000, akurasi model lupa rata-rata menurun menjadi 57.8, sedangkan model standar turun menjadi 37.2, yang tidak lebih baik dari tebakan acak.

Pengantar

Tim menyimpulkan bahwa lupa secara berkala tampaknya membuat model tersebut lebih baik dalam mempelajari bahasa secara umum. “Karena [mereka] terus-menerus lupa dan belajar kembali selama pelatihan, mengajarkan jaringan sesuatu yang baru nantinya menjadi lebih mudah,” katanya Evgenii Nikishin, seorang peneliti di Mila, sebuah pusat penelitian pembelajaran mendalam di Quebec. Hal ini menunjukkan bahwa ketika model bahasa memahami suatu bahasa, mereka melakukannya pada tingkat yang lebih dalam dari sekedar makna kata-kata individual.

Pendekatannya mirip dengan cara kerja otak kita. “Ingatan manusia secara umum tidak begitu baik dalam menyimpan informasi detail dalam jumlah besar secara akurat. Sebaliknya, manusia cenderung mengingat inti pengalaman kita, mengabstraksi dan mengekstrapolasi,” katanya Benyamin Levy, seorang ahli saraf di Universitas San Francisco. “Mengaktifkan AI dengan proses yang lebih mirip manusia, seperti lupa adaptif, adalah salah satu cara untuk menghasilkan kinerja yang lebih fleksibel.”

Selain penjelasan tentang cara kerja pemahaman, Artetxe berharap model bahasa lupa yang lebih fleksibel juga dapat membantu membawa terobosan AI terbaru ke lebih banyak bahasa. Meskipun model AI pandai menangani bahasa Spanyol dan Inggris, dua bahasa dengan materi pelatihan yang cukup, model tersebut tidak begitu baik dengan bahasa aslinya, Basque, bahasa lokal khusus untuk Spanyol bagian timur laut. “Sebagian besar model dari perusahaan teknologi besar tidak melakukannya dengan baik,” katanya. “Mengadaptasi model yang ada ke Basque adalah cara yang tepat.”

Chen juga menantikan dunia di mana lebih banyak bunga AI bermekaran. “Saya sedang memikirkan situasi di mana dunia tidak memerlukan satu model bahasa yang besar. Kami punya banyak sekali,” katanya. “Jika ada pabrik yang membuat model bahasa, Anda memerlukan teknologi semacam ini. Ia memiliki satu model dasar yang dapat dengan cepat beradaptasi dengan domain baru.”

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :memiliki

- :adalah

- :bukan

- :Di mana

- ][P

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Tentang Kami

- ABSTRAK

- ketepatan

- akurat

- menyesuaikan

- adaptif

- beradaptasi

- menambahkan

- tambahan

- memajukan

- Setelah

- AI

- Model AI

- Semua

- sendirian

- sudah

- juga

- jumlah

- an

- dan

- Lain

- Apple

- pendekatan

- aplikasi

- ADALAH

- AS

- At

- penulis

- rata-rata

- mendasarkan

- dasar

- karena

- menjadi

- menjadi

- di belakang

- Lebih baik

- antara

- Besar

- teknologi besar

- Terbesar

- Milyar

- Blok

- Berkembang

- kedua

- terobosan

- membawa

- Bangunan

- tapi

- by

- perhitungan

- bernama

- CAN

- pusat

- perubahan

- chen

- mengelakkan

- Penulis Bersama

- rekan

- Umum

- umum

- Perusahaan

- dibandingkan

- komputasi

- komputer

- komputasi

- daya komputasi

- konsep

- Disimpulkan

- Koneksi

- berisi

- konvensional

- bisa

- tercakup

- membuat

- dibuat

- Memotong

- data

- set data

- menurun

- mendalam

- belajar mendalam

- lebih dalam

- menuntut

- terperinci

- MELAKUKAN

- berbeda

- do

- Tidak

- melakukan

- domain

- Dont

- menjatuhkan

- selama

- setiap

- mudah

- Efektif

- embedding

- insinyur

- Mesin

- Inggris

- Seluruh

- Setara

- contoh

- ada

- Pengalaman

- memperpanjang

- pabrik

- beberapa

- bidang

- terisi

- Pertama

- fleksibel

- aliran

- Untuk

- Depan

- pendiri

- Francisco

- dari

- fungsi

- Umum

- umumnya

- mendapatkan

- GitHub

- Go

- baik

- Penanganan

- Sulit

- Memiliki

- he

- membantu

- membantu

- tingkat tinggi

- -nya

- berharap

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTTPS

- besar

- manusia

- seperti manusia

- Manusia

- ideal

- if

- membayangkan

- Dikenakan

- meningkatkan

- in

- sendiri-sendiri

- informasi

- mulanya

- mulanya

- sebagai gantinya

- Lembaga

- IT

- hanya

- Menjaga

- Jenis

- tahu

- Korea

- bahasa

- Bahasa

- besar

- kemudian

- Terbaru

- lapisan

- lapisan

- memimpin

- BELAJAR

- pengetahuan

- meninggalkan

- Panjang

- kurang

- Tingkat

- adalah ide yang bagus

- 'like'

- keterbatasan

- batas

- hidup

- lokal

- TERLIHAT

- Lot

- mesin

- Mesin belajar

- majalah

- membuat

- Membuat

- banyak

- bahan

- matematis

- makna

- cara

- mengukur

- Memori

- mungkin

- juta

- model

- model

- lebih

- kebanyakan

- banyak

- beberapa

- harus

- asli

- Perlu

- kebutuhan

- jaringan

- saraf

- saraf jaringan

- Neuron

- New

- tidak

- of

- on

- ONE

- hanya

- or

- Lainnya

- Lainnya

- kami

- lebih

- sendiri

- kertas

- prestasi

- berkala

- plato

- Kecerdasan Data Plato

- Data Plato

- jatuh

- kekuasaan

- didukung

- proses

- proses

- pengolahan

- Memproses Daya

- program

- Majalah kuantitas

- Quebec

- segera

- acak

- agak

- menerima

- menerima

- baru

- ingat

- wajib

- penelitian

- peneliti

- peneliti

- mengungkapkan

- bulat

- berjalan

- Tersebut

- sama

- San

- San Fransisco

- mengatakan

- Ilmu

- ilmuwan

- skor

- menggaruk

- Kedua

- tampaknya

- selektif

- mengirimkan

- set

- dia

- harus

- sinyal

- penting

- mirip

- situasi

- lebih kecil

- So

- beberapa

- sesuatu

- Selatan

- Korea Selatan

- Spanyol

- Spanyol

- tertentu

- standar

- awal

- startup

- Tangga

- Masih

- tersimpan

- menyimpan

- seperti itu

- Menyarankan

- manis

- Dibutuhkan

- Pengajaran

- tim

- tech

- perusahaan teknologi

- teknik

- Teknologi

- Cenderung

- teks

- dari

- bahwa

- Grafik

- informasi

- Dunia

- mereka

- Mereka

- kemudian

- Ini

- mereka

- hal

- Pikir

- ini

- meskipun?

- Melalui

- untuk

- hari ini

- Token

- mengambil

- Pelatihan VE

- terlatih

- Pelatihan

- trik

- mencoba

- mencubit

- dua

- memahami

- pemahaman

- universitas

- menggunakan

- bekas

- menggunakan

- sangat

- ingin

- ingin

- adalah

- Cara..

- we

- webp

- BAIK

- Apa

- ketika

- yang

- sementara

- mengapa

- dengan

- Word

- kata

- Kerja

- bekerja

- bekerja

- dunia

- lebih buruk

- akan

- tahun

- Kamu

- zephyrnet.dll