Pada November 2022, kami mengumumkan yang dapat digunakan pelanggan AWS untuk menghasilkan gambar dari teks Difusi Stabil model menggunakan Mulai Lompatan Amazon SageMaker. Hari ini, kami dengan senang hati memperkenalkan fitur baru yang memungkinkan pengguna mewarnai gambar dengan model Difusi Stabil. Inpainting mengacu pada proses mengganti sebagian gambar dengan gambar lain berdasarkan prompt tekstual. Dengan menyediakan gambar asli, gambar topeng yang menguraikan bagian yang akan diganti, dan perintah tekstual, model Difusi Stabil dapat menghasilkan gambar baru yang menggantikan area yang disamarkan dengan objek, subjek, atau lingkungan yang dijelaskan dalam perintah tekstual.

Anda dapat menggunakan inpainting untuk memulihkan gambar yang rusak atau membuat gambar baru dengan subjek atau gaya baru di bagian tertentu. Dalam bidang desain arsitektur, pengecatan Difusi Stabil dapat diterapkan untuk memperbaiki area cetak biru bangunan yang tidak lengkap atau rusak, memberikan informasi yang tepat untuk kru konstruksi. Dalam kasus pencitraan MRI klinis, kepala pasien harus ditahan, yang dapat menyebabkan hasil di bawah standar karena artefak pemotongan yang menyebabkan hilangnya data atau berkurangnya akurasi diagnostik. Pengecatan gambar dapat secara efektif membantu mengurangi hasil yang kurang optimal ini.

Dalam posting ini, kami menyajikan panduan komprehensif tentang penerapan dan menjalankan inferensi menggunakan model inpainting Difusi Stabil dalam dua metode: melalui antarmuka pengguna (UI) JumpStart di Studio Amazon SageMaker, dan secara terprogram melalui API JumpStart tersedia di SDK Python SageMaker.

Ikhtisar solusi

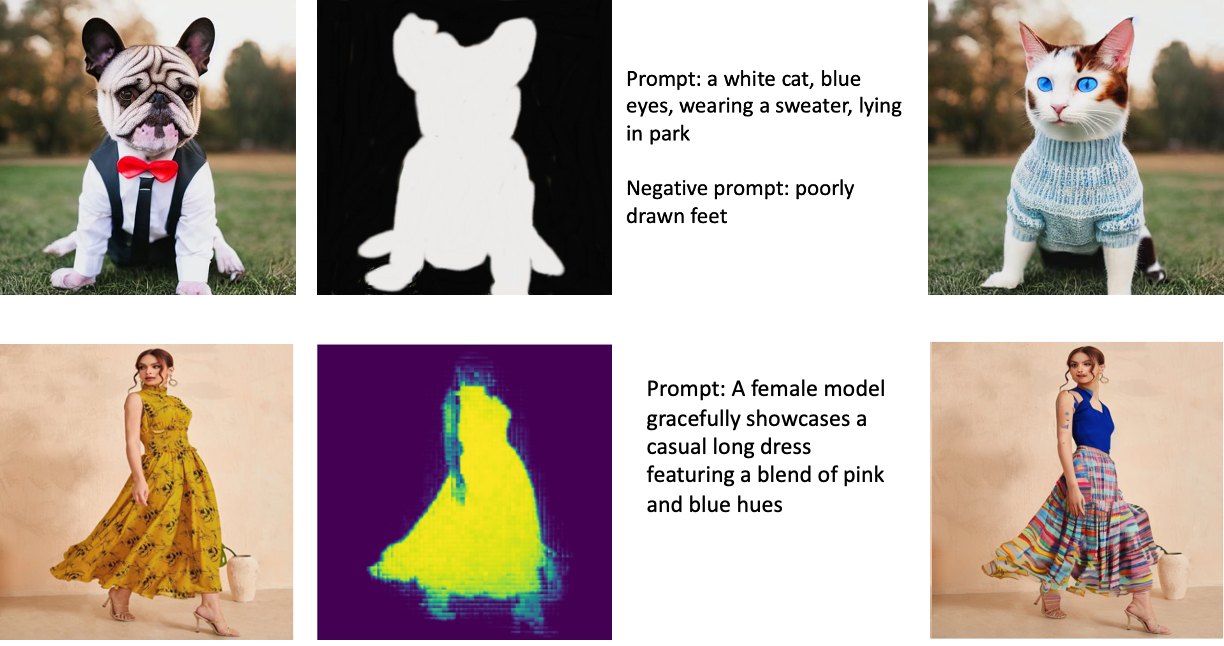

Gambar berikut adalah contoh lukisan. Gambar asli ada di kiri, gambar topeng ada di tengah, dan gambar bercat yang dihasilkan oleh model ada di kanan. Untuk contoh pertama, model diberikan gambar asli, gambar topeng, dan prompt tekstual "kucing putih, mata biru, mengenakan sweter, berbaring di taman", serta prompt negatif "kaki yang ditarik dengan buruk". ” Untuk contoh kedua, prompt tekstualnya adalah "Seorang model wanita dengan anggun menampilkan gaun panjang kasual yang menampilkan perpaduan warna pink dan biru,"

Menjalankan model besar seperti Stable Diffusion memerlukan skrip inferensi khusus. Anda harus menjalankan pengujian end-to-end untuk memastikan bahwa skrip, model, dan instance yang diinginkan bekerja sama secara efisien. JumpStart menyederhanakan proses ini dengan menyediakan skrip siap pakai yang telah diuji dengan kuat. Anda dapat mengakses skrip ini dengan satu klik melalui Studio UI atau dengan sangat sedikit baris kode melalui API JumpStart.

Bagian berikut memandu Anda menerapkan model dan menjalankan inferensi menggunakan Studio UI atau JumpStart API.

Perhatikan bahwa dengan menggunakan model ini, Anda menyetujui Lisensi CreativeML Open RAIL++-M.

Akses JumpStart melalui UI Studio

Di bagian ini, kami mengilustrasikan penerapan model JumpStart menggunakan UI Studio. Video yang menyertai mendemonstrasikan menemukan model pewarnaan Stable Diffusion inpainting yang telah dilatih sebelumnya di JumpStart dan menerapkannya. Halaman model menawarkan detail penting tentang model dan penggunaannya. Untuk melakukan inferensi, kami menggunakan jenis instans ml.p3.2xlarge, yang memberikan akselerasi GPU yang diperlukan untuk inferensi latensi rendah dengan harga yang terjangkau. Setelah instans hosting SageMaker dikonfigurasi, pilih Menyebarkan. Titik akhir akan beroperasi dan disiapkan untuk menangani permintaan inferensi dalam waktu kurang lebih 10 menit.

JumpStart menyediakan contoh notebook yang dapat membantu mempercepat waktu yang diperlukan untuk menjalankan inferensi pada titik akhir yang baru dibuat. Untuk mengakses buku catatan di Studio, pilih Buka Buku Catatan dalam Gunakan Endpoint dari Studio bagian dari halaman titik akhir model.

Gunakan JumpStart secara terprogram dengan SageMaker SDK

Memanfaatkan UI JumpStart memungkinkan Anda menerapkan model terlatih secara interaktif hanya dengan beberapa klik. Sebagai alternatif, Anda dapat menggunakan model JumpStart secara terprogram dengan menggunakan API yang terintegrasi dalam SageMaker Python SDK.

Di bagian ini, kami memilih model terlatih yang sesuai di JumpStart, menerapkan model ini ke titik akhir SageMaker, dan melakukan inferensi pada titik akhir yang diterapkan, semuanya menggunakan SageMaker Python SDK. Contoh berikut berisi cuplikan kode. Untuk mengakses kode lengkap dengan semua langkah yang disertakan dalam demonstrasi ini, lihat Pengantar untuk pengeditan Gambar JumpStart – Pengecatan Difusi Stabil contoh buku catatan.

Deploy model yang telah dilatih sebelumnya

SageMaker menggunakan kontainer Docker untuk berbagai tugas build dan runtime. JumpStart menggunakan Wadah Pembelajaran Mendalam SageMaker (DLC) yang spesifik kerangka kerja. Kami pertama-tama mengambil paket tambahan apa pun, serta skrip untuk menangani pelatihan dan inferensi untuk tugas yang dipilih. Kemudian artefak model pra-pelatihan diambil secara terpisah model_uris, yang memberikan fleksibilitas pada platform. Hal ini memungkinkan beberapa model terlatih untuk digunakan dengan satu skrip inferensi. Kode berikut mengilustrasikan proses ini:

Selanjutnya, kami menyediakan sumber daya tersebut untuk a Model SageMaker contoh dan gunakan titik akhir:

Setelah model diterapkan, kami dapat memperoleh prediksi real-time darinya!

Memasukkan

Inputnya adalah gambar dasar, gambar topeng, dan prompt yang menjelaskan subjek, objek, atau lingkungan yang akan diganti di bagian yang disamarkan. Membuat gambar topeng yang sempurna untuk efek lukisan melibatkan beberapa praktik terbaik. Mulailah dengan prompt tertentu, dan jangan ragu untuk bereksperimen dengan berbagai pengaturan Difusi Stabil untuk mencapai hasil yang diinginkan. Gunakan gambar topeng yang sangat mirip dengan gambar yang ingin Anda lukis. Pendekatan ini membantu algoritme pengecatan dalam melengkapi bagian gambar yang hilang, menghasilkan tampilan yang lebih alami. Gambar berkualitas tinggi umumnya memberikan hasil yang lebih baik, jadi pastikan gambar dasar dan topeng Anda memiliki kualitas yang baik dan mirip satu sama lain. Selain itu, pilih gambar topeng yang besar dan halus untuk mempertahankan detail dan meminimalkan artefak.

Titik akhir menerima gambar dasar dan topeng sebagai nilai RGB mentah atau gambar yang disandikan base64. Penangan inferensi menerjemahkan gambar berdasarkan content_type:

- Untuk

content_type = “application/json”, payload input harus berupa kamus JSON dengan nilai RGB mentah, perintah tekstual, dan parameter opsional lainnya - Untuk

content_type = “application/json;jpeg”, muatan input harus berupa kamus JSON dengan gambar berenkode base64, perintah tekstual, dan parameter opsional lainnya

Keluaran

Titik akhir dapat menghasilkan dua jenis keluaran: gambar RGB berenkode Base64 atau kamus JSON dari gambar yang dihasilkan. Anda dapat menentukan format keluaran mana yang Anda inginkan dengan menyetel accept sundulan ke "application/json" or "application/json;jpeg" masing-masing untuk gambar JPEG atau base64.

- Untuk

accept = “application/json”, titik akhir mengembalikan kamus JSON dengan nilai RGB untuk gambar - Untuk

accept = “application/json;jpeg”, titik akhir mengembalikan kamus JSON dengan gambar JPEG sebagai byte yang dikodekan dengan pengkodean base64.b64

Perhatikan bahwa mengirim atau menerima muatan dengan nilai RGB mentah mungkin mencapai batas default untuk muatan input dan ukuran respons. Oleh karena itu, sebaiknya gunakan gambar yang disandikan base64 dengan pengaturan content_type = “application/json;jpeg” dan terima = "application/json;jpeg".

Kode berikut adalah contoh permintaan inferensi:

Parameter yang didukung

Model lukisan Difusi Stabil mendukung banyak parameter untuk pembuatan gambar:

- gambar – Gambar asli.

- masker – Gambar di mana bagian yang dihitamkan tetap tidak berubah selama pembuatan gambar dan bagian putih diganti.

- cepat – Perintah untuk memandu pembuatan gambar. Itu bisa berupa string atau daftar string.

- num_inference_steps (opsional) – Jumlah langkah denoising selama pembuatan gambar. Lebih banyak langkah menghasilkan gambar berkualitas lebih tinggi. Jika ditentukan, itu harus berupa bilangan bulat positif. Perhatikan bahwa lebih banyak langkah inferensi akan menghasilkan waktu respons yang lebih lama.

- skala_panduan (opsional) – Skala panduan yang lebih tinggi menghasilkan gambar yang lebih dekat hubungannya dengan prompt, dengan mengorbankan kualitas gambar. Jika ditentukan, itu harus pelampung.

guidance_scale<=1diabaikan. - negatif_prompt (opsional) – Ini memandu pembuatan gambar melawan prompt ini. Jika ditentukan, itu harus berupa string atau daftar string dan digunakan dengan

guidance_scale. Jikaguidance_scaledinonaktifkan, ini juga dinonaktifkan. Selain itu, jika prompt adalah daftar string, makanegative_promptjuga harus daftar string. - benih (opsional) – Ini memperbaiki keadaan acak untuk reproduktifitas. Jika ditentukan, itu harus bilangan bulat. Setiap kali Anda menggunakan prompt yang sama dengan seed yang sama, gambar yang dihasilkan akan selalu sama.

- batch_size (opsional) – Jumlah gambar yang dihasilkan dalam satu lintasan maju. Jika menggunakan instans yang lebih kecil atau menghasilkan banyak gambar, kurangi

batch_sizemenjadi angka kecil (1-2). Jumlah gambar = jumlah prompt*num_images_per_prompt.

Keterbatasan dan bias

Meskipun Stable Diffusion memiliki kinerja yang mengesankan dalam pengecatan, ia mengalami beberapa keterbatasan dan bias. Ini termasuk tetapi tidak terbatas pada:

- Model mungkin tidak menghasilkan wajah atau anggota tubuh yang akurat karena data pelatihan tidak menyertakan gambar yang memadai dengan fitur ini.

- Model dilatih di Kumpulan data LAION-5B, yang memiliki konten khusus dewasa dan mungkin tidak sesuai untuk penggunaan produk tanpa pertimbangan lebih lanjut.

- Model mungkin tidak bekerja dengan baik dengan bahasa non-Inggris karena model dilatih pada teks bahasa Inggris.

- Model tidak dapat menghasilkan teks yang bagus di dalam gambar.

- Pengecatan Difusi Stabil biasanya bekerja paling baik dengan gambar dengan resolusi lebih rendah, seperti 256×256 atau 512×512 piksel. Saat bekerja dengan gambar beresolusi tinggi (768×768 atau lebih tinggi), metode ini mungkin kesulitan mempertahankan tingkat kualitas dan detail yang diinginkan.

- Meskipun penggunaan benih dapat membantu mengontrol reproduktifitas, pewarnaan Difusi Stabil masih dapat menghasilkan hasil yang bervariasi dengan sedikit perubahan pada masukan atau parameter. Ini mungkin menyulitkan untuk menyempurnakan output untuk persyaratan tertentu.

- Metode ini mungkin mengalami kesulitan dalam menghasilkan tekstur dan pola yang rumit, terutama ketika mereka menjangkau area yang luas di dalam gambar atau sangat penting untuk menjaga keseluruhan koherensi dan kualitas wilayah yang dicat.

Untuk informasi lebih lanjut tentang keterbatasan dan bias, lihat Kartu model Pengecatan Difusi Stabil.

Solusi pengecatan dengan topeng dihasilkan melalui prompt

CLIPSeq adalah teknik pembelajaran mendalam lanjutan yang memanfaatkan kekuatan model CLIP (Contrastive Language-Image Pretraining) pra-pelatihan untuk menghasilkan topeng dari gambar masukan. Pendekatan ini memberikan cara yang efisien untuk membuat topeng untuk tugas-tugas seperti segmentasi gambar, inpainting, dan manipulasi. CLIPSeq menggunakan CLIP untuk menghasilkan deskripsi teks dari gambar masukan. Deskripsi teks kemudian digunakan untuk menghasilkan topeng yang mengidentifikasi piksel dalam gambar yang relevan dengan deskripsi teks. Topeng kemudian dapat digunakan untuk mengisolasi bagian gambar yang relevan untuk diproses lebih lanjut.

CLIPSeq memiliki beberapa keunggulan dibandingkan metode lain untuk menghasilkan topeng dari gambar masukan. Pertama, ini adalah metode yang lebih efisien, karena tidak memerlukan citra untuk diproses oleh algoritme segmentasi citra terpisah. Kedua, lebih akurat, karena dapat menghasilkan topeng yang lebih selaras dengan teks deskripsi gambar. Ketiga, ini lebih serbaguna, karena Anda dapat menggunakannya untuk membuat topeng dari berbagai macam gambar.

Namun, CLIPSeq juga memiliki beberapa kekurangan. Pertama, teknik ini mungkin memiliki keterbatasan dalam hal materi pelajaran, karena bergantung pada model CLIP pra-pelatihan yang mungkin tidak mencakup domain atau bidang keahlian tertentu. Kedua, ini bisa menjadi metode yang sensitif, karena rentan terhadap kesalahan dalam teks deskripsi gambar.

Untuk informasi lebih lanjut, lihat Penataan busana virtual dengan AI generatif menggunakan Amazon SageMaker.

Membersihkan

Setelah Anda selesai menjalankan notebook, pastikan untuk menghapus semua sumber daya yang dibuat dalam proses untuk memastikan penagihan dihentikan. Kode untuk membersihkan titik akhir tersedia di terkait buku catatan.

Kesimpulan

Dalam postingan ini, kami menunjukkan cara menerapkan model pewarnaan Stable Diffusion pra-pelatihan menggunakan JumpStart. Kami menunjukkan cuplikan kode di pos ini—kode lengkap dengan semua langkah dalam demo ini tersedia di Pengantar JumpStart – Tingkatkan kualitas gambar yang dipandu oleh prompt contoh buku catatan. Cobalah solusinya sendiri dan kirimkan komentar Anda kepada kami.

Untuk mempelajari lebih lanjut tentang model dan cara kerjanya, lihat sumber daya berikut:

Untuk mempelajari lebih lanjut tentang JumpStart, lihat posting berikut:

Tentang Penulis

Dr Vivek Madan adalah Ilmuwan Terapan dengan tim JumpStart Amazon SageMaker. Dia mendapatkan gelar PhD dari University of Illinois di Urbana-Champaign dan merupakan Peneliti Pasca Doktoral di Georgia Tech. Dia adalah peneliti aktif dalam pembelajaran mesin dan desain algoritma dan telah menerbitkan makalah di konferensi EMNLP, ICLR, COLT, FOCS, dan SODA.

Dr Vivek Madan adalah Ilmuwan Terapan dengan tim JumpStart Amazon SageMaker. Dia mendapatkan gelar PhD dari University of Illinois di Urbana-Champaign dan merupakan Peneliti Pasca Doktoral di Georgia Tech. Dia adalah peneliti aktif dalam pembelajaran mesin dan desain algoritma dan telah menerbitkan makalah di konferensi EMNLP, ICLR, COLT, FOCS, dan SODA.

Alfred Shen adalah Spesialis AI/ML Senior di AWS. Dia telah bekerja di Silicon Valley, memegang posisi teknis dan manajerial di berbagai sektor termasuk kesehatan, keuangan, dan teknologi tinggi. Dia adalah peneliti AI/ML terapan yang berdedikasi, berkonsentrasi pada CV, NLP, dan multimodalitas. Karyanya telah dipamerkan dalam publikasi seperti EMNLP, ICLR, dan Kesehatan Masyarakat.

Alfred Shen adalah Spesialis AI/ML Senior di AWS. Dia telah bekerja di Silicon Valley, memegang posisi teknis dan manajerial di berbagai sektor termasuk kesehatan, keuangan, dan teknologi tinggi. Dia adalah peneliti AI/ML terapan yang berdedikasi, berkonsentrasi pada CV, NLP, dan multimodalitas. Karyanya telah dipamerkan dalam publikasi seperti EMNLP, ICLR, dan Kesehatan Masyarakat.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/inpaint-images-with-stable-diffusion-using-amazon-sagemaker-jumpstart/

- :adalah

- $NAIK

- 10

- 100

- 2022

- 7

- a

- Tentang Kami

- mempercepat

- Setuju

- Menerima

- mengakses

- ketepatan

- tepat

- Mencapai

- aktif

- Tambahan

- Selain itu

- Dewasa

- maju

- keuntungan

- terjangkau

- Setelah

- terhadap

- AI

- AI / ML

- bantu

- algoritma

- selaras

- Semua

- memungkinkan

- selalu

- Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- dan

- Lain

- api

- Lebah

- terapan

- pendekatan

- sesuai

- sekitar

- arsitektur

- ADALAH

- DAERAH

- daerah

- AS

- At

- secara otomatis

- tersedia

- AWS

- mendasarkan

- berdasarkan

- BE

- karena

- TERBAIK

- Praktik Terbaik

- Lebih baik

- prasangka

- penagihan

- Campuran

- Biru

- membangun

- Bangunan

- by

- CAN

- kasus

- lepas

- KUCING

- menyebabkan

- pusat

- tertentu

- menantang

- memeriksa

- Pilih

- kelas

- Klik

- Klinis

- rapat

- kode

- komentar

- lengkap

- menyelesaikan

- luas

- konferensi

- pertimbangan

- konstruksi

- mengandung

- Wadah

- Wadah

- Konten

- kontrol

- membuat

- dibuat

- membuat

- adat

- pelanggan

- data

- kehilangan data

- dedicated

- mendalam

- belajar mendalam

- Default

- memberikan

- menunjukkan

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- dijelaskan

- deskripsi

- Mendesain

- diinginkan

- rinci

- rincian

- Difusi

- cacat

- beberapa

- Buruh pelabuhan

- Tidak

- domain

- Dont

- selama

- setiap

- efektif

- efek

- efisien

- efisien

- antara

- memungkinkan

- ujung ke ujung

- Titik akhir

- Inggris

- memastikan

- masuk

- Lingkungan Hidup

- kesalahan

- terutama

- penting

- contoh

- contoh

- gembira

- eksperimen

- keahlian

- mata

- wajah

- Fashion

- Fitur

- Fitur

- Menampilkan

- kaki

- wanita

- Sudah diambil

- beberapa

- File

- keuangan

- Pertama

- cocok

- keluwesan

- Mengapung

- berikut

- Untuk

- format

- Depan

- dari

- penuh

- lebih lanjut

- umumnya

- menghasilkan

- dihasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- Georgia

- baik

- GPU

- bimbingan

- membimbing

- Panduan

- menangani

- Memiliki

- kepala

- Kesehatan

- kesehatan

- membantu

- berkualitas tinggi

- resolusi tinggi

- lebih tinggi

- Memukul

- memegang

- tuan

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- HTTPS

- mengidentifikasi

- Illinois

- gambar

- gambar

- Pencitraan

- impresif

- in

- memasukkan

- termasuk

- Termasuk

- informasi

- memasukkan

- contoh

- terpadu

- Antarmuka

- memperkenalkan

- IT

- NYA

- jpg

- json

- bahasa

- Bahasa

- besar

- memimpin

- BELAJAR

- pengetahuan

- Tingkat

- 'like'

- keterbatasan

- Terbatas

- batas

- baris

- Daftar

- Panjang

- lagi

- lepas

- mesin

- Mesin belajar

- memelihara

- mempertahankan

- membuat

- manajerial

- manipulasi

- banyak

- masker

- masker

- hal

- Mungkin..

- metode

- metode

- mungkin

- menit

- hilang

- Mengurangi

- ML

- model

- model

- lebih

- lebih efisien

- Selain itu

- MRI

- beberapa

- Alam

- Perlu

- negatif

- New

- nLP

- buku catatan

- novel

- November

- jumlah

- obyek

- memperoleh

- of

- Penawaran

- on

- ONE

- Buka

- operasional

- urutan

- asli

- Lainnya

- menguraikan

- keluaran

- secara keseluruhan

- sendiri

- paket

- halaman

- dokumen

- parameter

- Taman

- bagian

- lulus

- pola

- sempurna

- Melakukan

- prestasi

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- posisi

- positif

- Pos

- Posts

- kekuasaan

- praktek

- perlu

- Prediksi

- Predictor

- siap

- menyajikan

- harga pompa cor beton mini

- proses

- Diproses

- pengolahan

- menghasilkan

- Produk

- memberikan

- disediakan

- menyediakan

- menyediakan

- publik

- kesehatan masyarakat

- publikasi

- diterbitkan

- Ular sanca

- kualitas

- Acak

- Mentah

- real-time

- dunia

- menerima

- sarankan

- menurunkan

- mengurangi

- mengacu

- wilayah

- terkait

- relevan

- sisa

- memperbaiki

- diganti

- permintaan

- permintaan

- membutuhkan

- wajib

- Persyaratan

- membutuhkan

- peneliti

- menyerupai

- Sumber

- tanggapan

- memulihkan

- dihasilkan

- Hasil

- kembali

- Pengembalian

- RGB

- Run

- berjalan

- pembuat bijak

- sama

- Skala

- ilmuwan

- script

- SDK

- Kedua

- Bagian

- bagian

- Sektor

- benih

- segmentasi

- terpilih

- mengirim

- senior

- peka

- terpisah

- pengaturan

- pengaturan

- beberapa

- Silikon

- Silicon Valley

- tunggal

- Ukuran

- kecil

- lebih kecil

- So

- larutan

- beberapa

- merentang

- spesialis

- tertentu

- ditentukan

- stabil

- awal

- Negara

- Tangga

- Masih

- terhenti

- Tali

- Perjuangan

- studio

- subyek

- seperti itu

- Menderita

- cukup

- mendukung

- rentan

- Dibutuhkan

- tugas

- tugas

- tim

- tech

- Teknis

- istilah

- tes

- bahwa

- Grafik

- karena itu

- Ini

- Ketiga

- Melalui

- waktu

- untuk

- hari ini

- bersama

- terlatih

- Pelatihan

- jenis

- khas

- ui

- universitas

- us

- penggunaan

- menggunakan

- Pengguna

- User Interface

- Pengguna

- Penggunaan

- memanfaatkan

- Lembah

- Nilai - Nilai

- variasi

- berbagai

- serba guna

- melalui

- Video

- Cara..

- BAIK

- yang

- putih

- lebar

- akan

- dengan

- dalam

- tanpa

- Kerja

- bekerja sama

- kerja

- bekerja

- Menghasilkan

- Kamu

- Anda

- zephyrnet.dll