Hari ini, kami dengan gembira mengumumkan bahwa model alas bedak Llama 2 yang dikembangkan oleh Meta tersedia untuk pelanggan melalui Mulai Lompatan Amazon SageMaker. Keluarga model bahasa besar (LLM) Llama 2 adalah kumpulan model teks generatif yang telah dilatih dan disempurnakan dengan skala mulai dari 7 miliar hingga 70 miliar parameter. LLM yang disempurnakan, disebut Llama-2-chat, dioptimalkan untuk kasus penggunaan dialog. Anda dapat dengan mudah mencoba model ini dan menggunakannya dengan SageMaker JumpStart, yang merupakan hub pembelajaran mesin (ML) yang menyediakan akses ke algoritme, model, dan solusi ML sehingga Anda dapat memulai ML dengan cepat.

Dalam postingan ini, kami membahas cara menggunakan model Llama 2 melalui SageMaker JumpStart.

Apa itu Llama 2

Llama 2 adalah model bahasa auto-regresif yang menggunakan arsitektur transformator yang dioptimalkan. Llama 2 ditujukan untuk penggunaan komersial dan penelitian dalam bahasa Inggris. Ini hadir dalam berbagai ukuran parameter—7 miliar, 13 miliar, dan 70 miliar—serta variasi yang telah dilatih sebelumnya dan disesuaikan. Menurut Meta, versi yang disetel menggunakan penyempurnaan yang diawasi (SFT) dan pembelajaran penguatan dengan umpan balik manusia (RLHF) untuk menyelaraskan dengan preferensi manusia dalam hal kegunaan dan keamanan. Llama 2 telah dilatih sebelumnya tentang 2 triliun token data dari sumber yang tersedia untuk umum. Model yang disetel ditujukan untuk obrolan seperti asisten, sedangkan model terlatih dapat diadaptasi untuk berbagai tugas pembuatan bahasa alami. Terlepas dari versi model mana yang digunakan pengembang, panduan penggunaan yang bertanggung jawab dari Meta dapat membantu memandu penyesuaian tambahan yang mungkin diperlukan untuk menyesuaikan dan mengoptimalkan model dengan mitigasi keselamatan yang sesuai.

Apa itu SageMaker JumpStart

Dengan SageMaker JumpStart, praktisi ML dapat memilih dari beragam pilihan model fondasi sumber terbuka. Praktisi ML dapat menerapkan model dasar ke model khusus Amazon SageMaker instans dari lingkungan yang terisolasi jaringan dan sesuaikan model menggunakan SageMaker untuk pelatihan dan penerapan model.

Anda sekarang dapat menemukan dan menerapkan Llama 2 dengan beberapa klik Studio Amazon SageMaker atau secara terprogram melalui SageMaker Python SDK, memungkinkan Anda memperoleh performa model dan kontrol MLOps dengan fitur SageMaker seperti Pipa Amazon SageMaker, Debugger Amazon SageMaker, atau log kontainer. Model ini diterapkan di lingkungan aman AWS dan di bawah kendali VPC Anda, membantu memastikan keamanan data. Model Llama 2 saat ini tersedia di Amazon SageMaker Studio, pada awalnya di us-east 1 dan us-west 2 daerah.

Temukan model

Anda dapat mengakses model dasar melalui SageMaker JumpStart di UI SageMaker Studio dan SageMaker Python SDK. Di bagian ini, kita akan membahas cara menemukan model di SageMaker Studio.

SageMaker Studio adalah lingkungan pengembangan terintegrasi (IDE) yang menyediakan antarmuka visual berbasis web tunggal tempat Anda dapat mengakses alat yang dibuat khusus untuk melakukan semua langkah pengembangan ML, mulai dari menyiapkan data hingga membangun, melatih, dan menerapkan model ML Anda. Untuk detail selengkapnya tentang cara memulai dan menyiapkan SageMaker Studio, lihat Studio Amazon SageMaker.

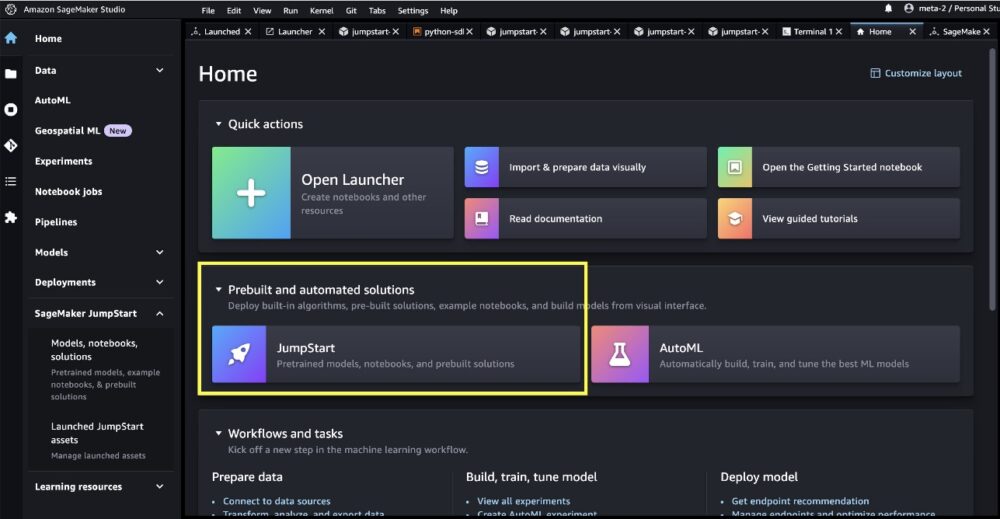

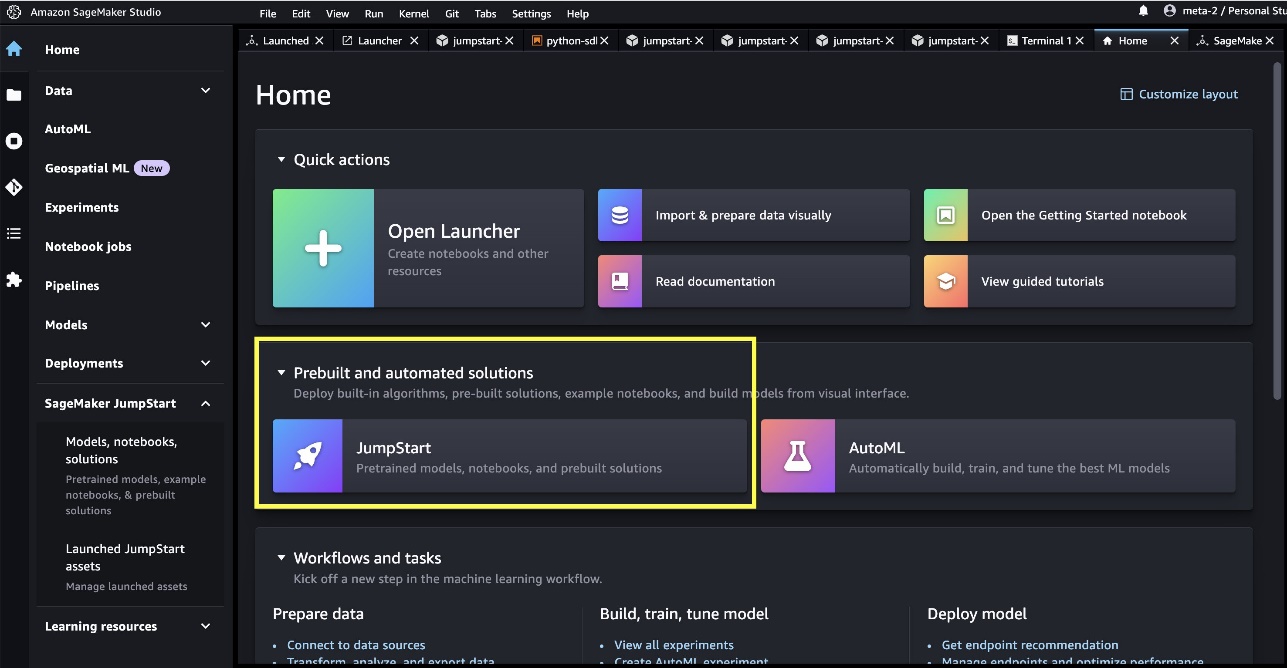

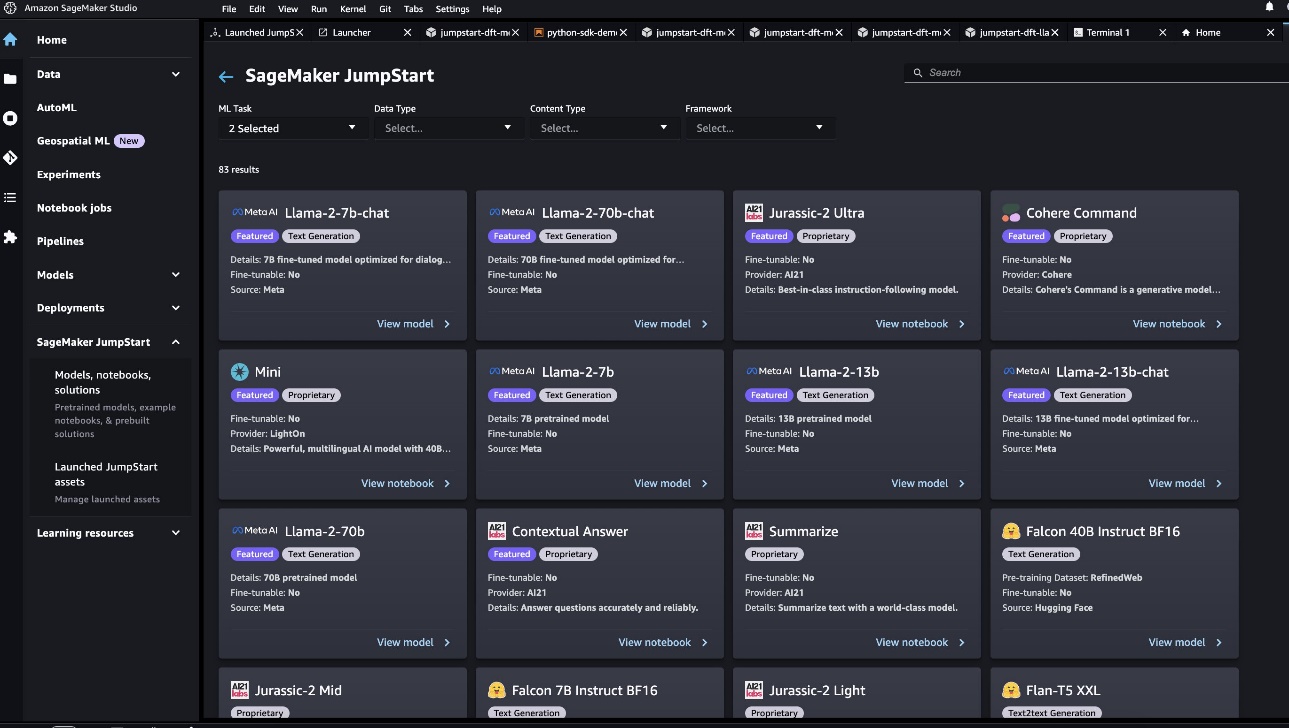

Setelah Anda berada di SageMaker Studio, Anda dapat mengakses SageMaker JumpStart, yang berisi model terlatih, notebook, dan solusi bawaan, di bawah Solusi bawaan dan otomatis.

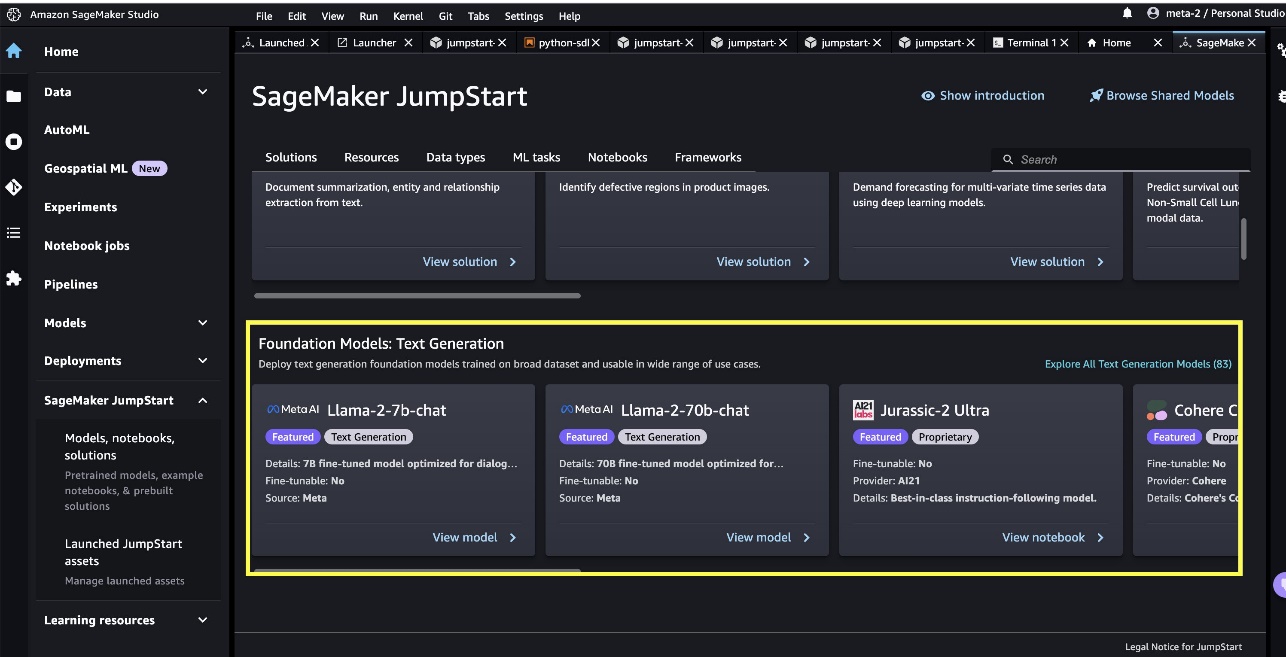

Dari halaman arahan SageMaker JumpStart, Anda dapat menelusuri solusi, model, buku catatan, dan sumber daya lainnya. Anda dapat menemukan dua model andalan Llama 2 di Model Fondasi: Generasi Teks korsel. Jika Anda tidak melihat model Llama 2, perbarui versi SageMaker Studio Anda dengan mematikan dan memulai ulang. Untuk informasi lebih lanjut tentang pembaruan versi, lihat Matikan dan Perbarui Aplikasi Studio.

Anda juga dapat menemukan empat varian model lainnya dengan memilih Jelajahi semua Model Pembuatan Teks atau mencari llama di kotak pencarian.

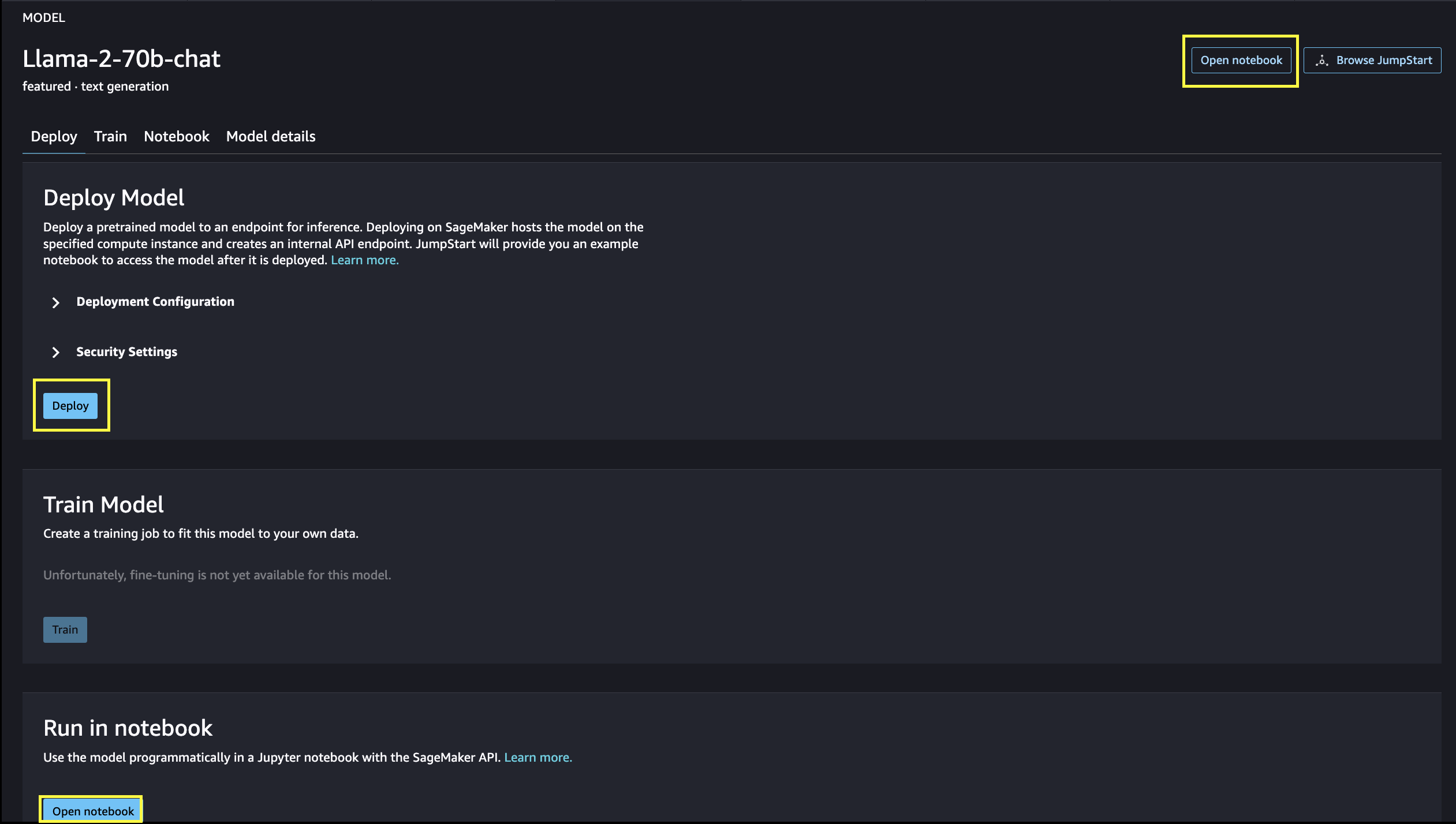

Anda dapat memilih kartu model untuk melihat detail tentang model seperti lisensi, data yang digunakan untuk melatih, dan cara penggunaan. Anda juga dapat menemukan dua tombol, Menyebarkan dan Buka Buku Catatan, yang membantu Anda menggunakan model tersebut.

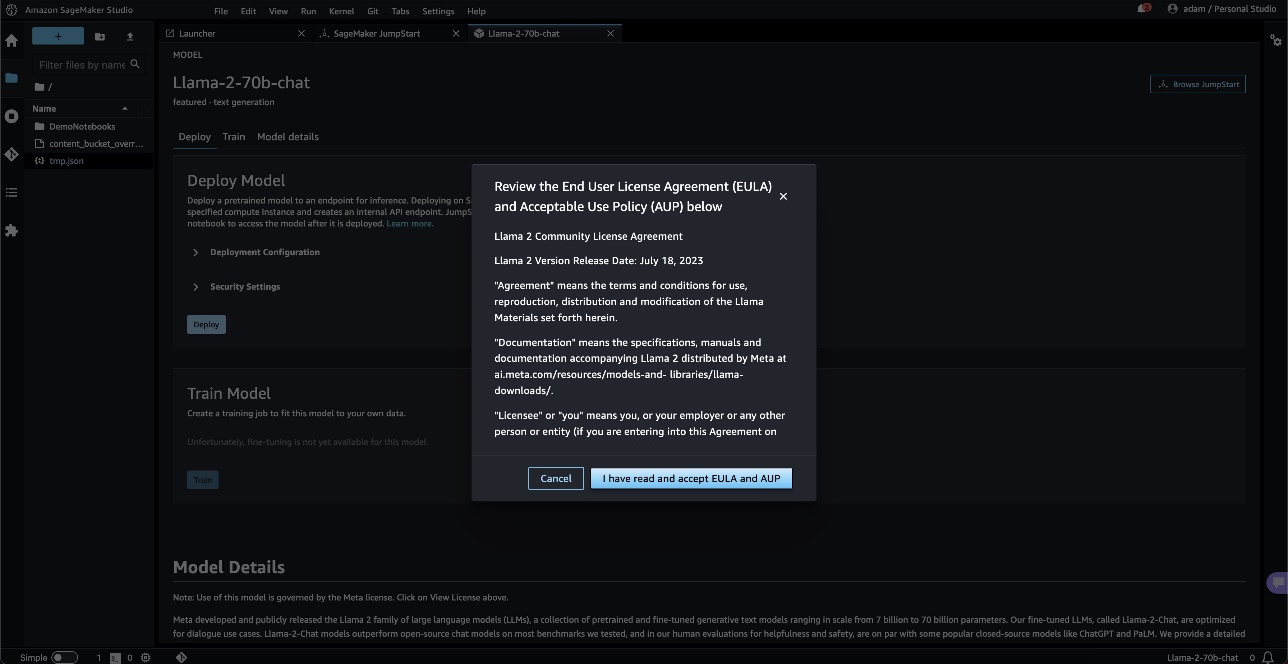

Saat Anda memilih salah satu tombol, pop-up akan menampilkan perjanjian lisensi pengguna akhir dan kebijakan penggunaan yang dapat diterima untuk Anda setujui.

Setelah mengetahuinya, Anda akan melanjutkan ke langkah berikutnya untuk menggunakan model tersebut.

Terapkan model

Ketika Anda memilih Menyebarkan dan menyetujui persyaratannya, penerapan model akan dimulai. Alternatifnya, Anda dapat menyebarkan melalui contoh buku catatan yang muncul dengan memilih Buka Buku Catatan. Contoh notebook memberikan panduan menyeluruh tentang cara menyebarkan model untuk inferensi dan membersihkan sumber daya.

Untuk menerapkan menggunakan notebook, kita mulai dengan memilih model yang sesuai, yang ditentukan oleh model_id. Anda dapat menerapkan salah satu model yang dipilih di SageMaker dengan kode berikut:

Ini menyebarkan model pada SageMaker dengan konfigurasi default, termasuk jenis instans default dan konfigurasi VPC default. Anda dapat mengubah konfigurasi ini dengan menentukan nilai non-default di JumpStartModel. Setelah disebarkan, Anda dapat menjalankan inferensi terhadap titik akhir yang disebarkan melalui prediktor SageMaker:

Model obrolan yang disempurnakan (Obrolan Llama-2-7b, Obrolan Llama-2-13b, Obrolan Llama-2-70b) menerima riwayat obrolan antara pengguna dan asisten obrolan, dan menghasilkan obrolan berikutnya. Model terlatih (Llama-2-7b, Llama-2-13b, Llama-2-70b) memerlukan perintah string dan melakukan penyelesaian teks pada perintah yang disediakan. Lihat kode berikut:

Perhatikan bahwa secara default, accept_eula disetel ke salah. Anda perlu mengatur accept_eula=true untuk memanggil titik akhir dengan sukses. Dengan melakukan ini, Anda menerima perjanjian lisensi pengguna dan kebijakan penggunaan yang dapat diterima seperti yang disebutkan sebelumnya. Anda juga bisa Download perjanjian lisensi.

Custom_attributes yang digunakan untuk meneruskan EULA adalah pasangan kunci/nilai. Kunci dan nilai dipisahkan oleh = dan pasangan dipisahkan oleh ;. Jika pengguna meneruskan kunci yang sama lebih dari sekali, nilai terakhir akan disimpan dan diteruskan ke pengendali skrip (yaitu, dalam kasus ini, digunakan untuk logika kondisional). Misalnya jika accept_eula=false; accept_eula=true diteruskan ke server, lalu accept_eula=true disimpan dan diteruskan ke pengendali skrip.

Parameter inferensi mengontrol proses pembuatan teks di titik akhir. Kontrol token baru maksimum mengacu pada ukuran output yang dihasilkan oleh model. Perhatikan bahwa ini tidak sama dengan jumlah kata karena kosakata model tidak sama dengan kosakata bahasa Inggris, dan setiap token mungkin bukan kata bahasa Inggris. Suhu mengontrol keacakan keluaran. Suhu yang lebih tinggi menghasilkan keluaran yang lebih kreatif dan berhalusinasi. Semua parameter inferensi bersifat opsional.

Tabel berikut mencantumkan semua model Llama yang tersedia di SageMaker JumpStart beserta model_ids, jenis instans default, dan jumlah maksimum total token (jumlah token masukan dan jumlah token yang dihasilkan) yang didukung untuk masing-masing model ini.

| Model Nama | ID Model | Total Token Maks | Jenis Instans Default |

| Panggilan-2-7b | meta-teksgenerasi-llama-2-7b | 4096 | ml.g5.2xbesar |

| Llama-2-7b-obrolan | meta-teksgenerasi-llama-2-7b-f | 4096 | ml.g5.2xbesar |

| Panggilan-2-13b | meta-teksgenerasi-llama-2-13b | 4096 | ml.g5.12xbesar |

| Llama-2-13b-obrolan | meta-teksgenerasi-llama-2-13b-f | 4096 | ml.g5.12xbesar |

| Panggilan-2-70b | meta-teksgenerasi-llama-2-70b | 4096 | ml.g5.48xbesar |

| Llama-2-70b-obrolan | meta-teksgenerasi-llama-2-70b-f | 4096 | ml.g5.48xbesar |

Perhatikan bahwa titik akhir SageMaker memiliki batas waktu habis 60 detik. Jadi, meskipun model mungkin dapat menghasilkan 4096 token, jika pembuatan teks memerlukan waktu lebih dari 60 detik, permintaan akan gagal. Untuk model 7B, 13B, dan 70B, kami sarankan untuk menyetel max_new_tokens masing-masing tidak lebih dari 1500, 1000, dan 500, sambil menjaga jumlah total token kurang dari 4K.

Inferensi dan contoh petunjuk untuk Llama-2-70b

Anda dapat menggunakan model Llama untuk penyelesaian teks pada bagian teks mana pun. Melalui pembuatan teks, Anda dapat melakukan berbagai tugas, seperti menjawab pertanyaan, menerjemahkan bahasa, analisis sentimen, dan banyak lagi. Input payload ke endpoint terlihat seperti kode berikut:

Berikut ini adalah beberapa contoh contoh perintah dan teks yang dihasilkan oleh model. Semua keluaran dihasilkan dengan parameter inferensi {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

Pada contoh berikutnya, kami menunjukkan cara menggunakan model Llama dengan pembelajaran dalam konteks beberapa langkah, di mana kami menyediakan sampel pelatihan yang tersedia untuk model tersebut. Perhatikan bahwa kami hanya membuat inferensi pada model yang diterapkan dan selama proses ini, bobot model tidak berubah.

Inferensi dan contoh petunjuk untuk obrolan Llama-2-70b

Dengan model Llama-2-Chat, yang dioptimalkan untuk kasus penggunaan dialog, masukan ke titik akhir model obrolan adalah riwayat sebelumnya antara asisten obrolan dan pengguna. Anda dapat mengajukan pertanyaan yang kontekstual dengan percakapan yang terjadi selama ini. Anda juga dapat menyediakan konfigurasi sistem, seperti persona yang menentukan perilaku asisten obrolan. Payload masukan ke titik akhir terlihat seperti kode berikut:

Berikut ini adalah beberapa contoh contoh perintah dan teks yang dihasilkan oleh model. Semua keluaran dihasilkan dengan parameter inferensi {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

Pada contoh berikut, pengguna telah melakukan percakapan dengan asisten tentang lokasi wisata di Paris. Selanjutnya, pengguna menanyakan tentang opsi pertama yang direkomendasikan oleh asisten obrolan.

Dalam contoh berikut, kami mengatur konfigurasi sistem:

Membersihkan

Setelah Anda selesai menjalankan buku catatan, pastikan untuk menghapus semua sumber daya sehingga semua sumber daya yang Anda buat dalam proses tersebut terhapus dan penagihan Anda dihentikan:

Kesimpulan

Dalam postingan ini, kami menunjukkan kepada Anda cara memulai model Llama 2 di SageMaker Studio. Dengan ini, Anda memiliki akses ke enam model fondasi Llama 2 yang berisi miliaran parameter. Karena model dasar telah dilatih sebelumnya, model dasar juga dapat membantu menurunkan biaya pelatihan dan infrastruktur serta memungkinkan penyesuaian untuk kasus penggunaan Anda. Untuk memulai SageMaker JumpStart, kunjungi sumber daya berikut:

Tentang penulis

Juni Won adalah manajer produk di SageMaker JumpStart. Dia berfokus untuk membuat model dasar mudah ditemukan dan digunakan untuk membantu pelanggan membangun aplikasi AI generatif. Pengalamannya di Amazon juga mencakup aplikasi belanja seluler dan pengiriman jarak jauh.

Juni Won adalah manajer produk di SageMaker JumpStart. Dia berfokus untuk membuat model dasar mudah ditemukan dan digunakan untuk membantu pelanggan membangun aplikasi AI generatif. Pengalamannya di Amazon juga mencakup aplikasi belanja seluler dan pengiriman jarak jauh.

Dr Vivek Madan adalah Ilmuwan Terapan dengan tim JumpStart Amazon SageMaker. Dia mendapatkan gelar PhD dari University of Illinois di Urbana-Champaign dan merupakan Peneliti Pasca Doktoral di Georgia Tech. Dia adalah peneliti aktif dalam pembelajaran mesin dan desain algoritma dan telah menerbitkan makalah di konferensi EMNLP, ICLR, COLT, FOCS, dan SODA.

Dr Vivek Madan adalah Ilmuwan Terapan dengan tim JumpStart Amazon SageMaker. Dia mendapatkan gelar PhD dari University of Illinois di Urbana-Champaign dan merupakan Peneliti Pasca Doktoral di Georgia Tech. Dia adalah peneliti aktif dalam pembelajaran mesin dan desain algoritma dan telah menerbitkan makalah di konferensi EMNLP, ICLR, COLT, FOCS, dan SODA.  Dr.Kyle Ulrich adalah Ilmuwan Terapan di tim Amazon SageMaker JumpStart. Minat penelitiannya meliputi algoritma pembelajaran mesin yang dapat diskalakan, visi komputer, deret waktu, non-parametrik Bayesian, dan proses Gaussian. Gelar PhD-nya berasal dari Duke University dan dia telah menerbitkan makalah di NeurIPS, Cell, dan Neuron.

Dr.Kyle Ulrich adalah Ilmuwan Terapan di tim Amazon SageMaker JumpStart. Minat penelitiannya meliputi algoritma pembelajaran mesin yang dapat diskalakan, visi komputer, deret waktu, non-parametrik Bayesian, dan proses Gaussian. Gelar PhD-nya berasal dari Duke University dan dia telah menerbitkan makalah di NeurIPS, Cell, dan Neuron.  Dr Ashish Khetan adalah Ilmuwan Terapan Senior di Amazon SageMaker JumpStart dan membantu mengembangkan algoritme pembelajaran mesin. Ia memperoleh gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior di Amazon SageMaker JumpStart dan membantu mengembangkan algoritme pembelajaran mesin. Ia memperoleh gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.  Sundar Ranganathan adalah Kepala Global Spesialis GTM GenAI/Frameworks di AWS. Dia berfokus pada pengembangan strategi GTM untuk model bahasa besar, GenAI, dan beban kerja ML skala besar di seluruh layanan AWS seperti Amazon EC2, EKS, EFA, AWS Batch, dan Amazon SageMaker. Pengalamannya mencakup peran kepemimpinan dalam manajemen produk dan pengembangan produk di NetApp, Micron Technology, Qualcomm, dan Mentor Graphics.

Sundar Ranganathan adalah Kepala Global Spesialis GTM GenAI/Frameworks di AWS. Dia berfokus pada pengembangan strategi GTM untuk model bahasa besar, GenAI, dan beban kerja ML skala besar di seluruh layanan AWS seperti Amazon EC2, EKS, EFA, AWS Batch, dan Amazon SageMaker. Pengalamannya mencakup peran kepemimpinan dalam manajemen produk dan pengembangan produk di NetApp, Micron Technology, Qualcomm, dan Mentor Graphics.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-gelar

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Sanggup

- Tentang Kami

- Setuju

- diterima

- mengakses

- aksesibilitas

- dapat diakses

- Menurut

- mengakui

- di seluruh

- aktif

- menambahkan

- menambahkan

- Tambahan

- alamat

- Setelah

- lagi

- terhadap

- Persetujuan

- AI

- algoritma

- algoritma

- meluruskan

- Semua

- mengizinkan

- sepanjang

- juga

- selalu

- am

- Amazon

- Amazon EC2

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Studio Amazon SageMaker

- Amazon Web Services

- Amerika

- an

- analisis

- dan

- dan infrastruktur

- Mengumumkan

- Lain

- menjawab

- Apa pun

- siapapun

- Aplikasi

- aplikasi

- terapan

- menghargai

- sesuai

- Busur

- arsitektur

- ADALAH

- Seni

- AS

- membantu

- Asisten

- At

- Suasana

- atraksi

- Otomatis

- tersedia

- AWS

- pisang

- dasar

- Pertarungan

- Bayesian

- BE

- indah

- Kecantikan

- menjadi

- karena

- menjadi

- menjadi

- bir

- sebelum

- laku

- Beijing

- Percaya

- diyakini

- TERBAIK

- antara

- penagihan

- Milyar

- miliaran

- Black

- Kotak

- Istirahat

- hati

- luas

- membangun

- Bangunan

- dibangun di

- tapi

- tombol

- by

- bernama

- CAN

- modal

- mobil

- kartu

- korsel

- kasus

- kasus

- KUCING

- perubahan

- Cokelat

- Pilih

- memilih

- Kota

- klasik

- kode

- koleksi

- bergabung

- menggabungkan

- datang

- kedatangan

- komersial

- perusahaan

- penyelesaian

- komputer

- Visi Komputer

- konferensi

- yakin

- konfigurasi

- dianggap

- konstan

- konstruksi

- mengandung

- Wadah

- mengandung

- Konten

- kontekstual

- terus

- terus menerus

- kontrol

- kontrol

- Mudah

- Percakapan

- Biaya

- negara

- keberanian

- menutupi

- membuat

- dibuat

- Kreatif

- kultural

- budaya

- Cangkir

- pelanggan

- kustomisasi

- menyesuaikan

- data

- keamanan data

- dedicated

- dedikasi

- Default

- menetapkan

- pengiriman

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- menyebarkan

- Mendesain

- dirancang

- diinginkan

- tujuan

- tujuan

- rincian

- mengembangkan

- dikembangkan

- Pengembang

- berkembang

- Pengembangan

- Dialog

- perbedaan

- berbeda

- sulit

- menemukan

- khusus

- do

- dokumenter

- melakukan

- dilakukan

- Dont

- dua kali lipat

- turun

- Duke

- universitas adipati

- selama

- e

- setiap

- Terdahulu

- mudah

- Mudah

- Edward

- einstein

- antara

- aktif

- memungkinkan

- akhir

- ujung ke ujung

- Titik akhir

- Teknik

- Inggris

- menikmati

- cukup

- memastikan

- Lingkungan Hidup

- peralatan

- Eter

- Bahkan

- peristiwa

- semua orang

- contoh

- contoh

- gembira

- pengalaman

- eksperimen

- eksperimen

- ekspres

- GAGAL

- Gagal

- adil

- palsu

- keluarga

- terkenal

- jauh

- prestasi

- fitur

- Fitur

- umpan balik

- kaki

- beberapa

- bioskop

- terakhir

- Akhirnya

- Menemukan

- Pertama

- Flagship

- Mengapung

- Mengalir

- berfokus

- berikut

- Untuk

- Depan

- ditemukan

- Prinsip Dasar

- empat

- Prancis

- Perancis

- dari

- sepenuhnya

- lebih lanjut

- masa depan

- Umum

- menghasilkan

- dihasilkan

- generasi

- generatif

- AI generatif

- Georgia

- mendapatkan

- Memberikan

- kaca

- Aksi

- Go

- akan

- grafis

- besar

- lebih besar

- groundbreaking

- Tumbuh

- bimbingan

- membimbing

- memiliki

- Menangani

- terjadi

- senang

- Sulit

- kerja keras

- Memiliki

- memiliki

- he

- kepala

- membantu

- membantu

- membantu

- di sini

- hi

- High

- lebih tinggi

- -nya

- historis

- sejarah

- perumahan

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- HTTPS

- Pusat

- manusia

- i

- ikonis

- ide

- if

- ii

- Illinois

- Dampak

- mengimpor

- penting

- impresif

- in

- memasukkan

- termasuk

- Termasuk

- Tergabung

- informasi

- Infrastruktur

- mulanya

- memasukkan

- terinspirasi

- menginspirasi

- contoh

- segera

- instruksi

- terpadu

- dimaksudkan

- kepentingan

- Antarmuka

- ke

- terpencil

- IT

- NYA

- perjalanan

- jpg

- hanya

- pemeliharaan

- terus

- kunci

- Jenis

- Tahu

- dikenal

- pendaratan

- tengara

- bahasa

- besar

- besar-besaran

- terbesar

- Terakhir

- Terlambat

- jalankan

- Hukum

- Kepemimpinan

- BELAJAR

- Belajar dan Tumbuh

- pengetahuan

- paling sedikit

- kurang

- adalah ide yang bagus

- Lisensi

- Hidup

- cahaya

- 'like'

- MEMBATASI

- daftar

- literatur

- ll

- Llama

- logika

- Panjang

- lama

- mencari

- TERLIHAT

- cinta

- dicintai

- menurunkan

- mesin

- Mesin belajar

- terbuat

- membuat

- MEMBUAT

- Membuat

- pengelolaan

- manajer

- banyak

- keajaiban

- hal

- maksimum

- Mungkin..

- makna

- mengukur

- Media

- medium

- tersebut

- pesan

- meta

- mikron

- menit

- menit

- campuran

- ML

- MLOps

- mobil

- model

- model

- saat

- bulan

- lebih

- paling

- Paling Populer

- gerakan

- film

- banyak

- museum

- Museum

- musik

- nama

- Alam

- perlu

- Perlu

- dibutuhkan

- jaringan

- New

- NY

- berikutnya

- tidak

- buku catatan

- sekarang

- jumlah

- banyak sekali

- NY

- of

- menawarkan

- menawarkan

- Penawaran

- Minyak

- on

- sekali

- ONE

- hanya

- Buka

- open source

- Optimize

- dioptimalkan

- pilihan

- or

- Lainnya

- Lainnya

- jika tidak

- kami

- di luar

- keluaran

- lebih

- secara keseluruhan

- halaman

- pasang

- kertas

- dokumen

- parameter

- parameter

- Paris

- bagian

- lulus

- Lulus

- melewati

- lalu

- perdamaian

- Melakukan

- prestasi

- permanen

- telepon

- foto

- Fisika

- bagian

- Pizza

- plastik

- plato

- Kecerdasan Data Plato

- Data Plato

- dimainkan

- kebijaksanaan

- pop-up

- Populer

- Pos

- pos

- Predictor

- preferensi

- mempersiapkan

- menyajikan

- sebelumnya

- proses

- proses

- Produk

- pengembangan produk

- manajemen Produk

- manajer produk

- Proposal

- bangga

- memberikan

- disediakan

- menyediakan

- menyediakan

- publik

- transportasi umum

- di depan umum

- diterbitkan

- tujuan

- menempatkan

- Ular sanca

- Qualcomm

- Pertanyaan

- Cepat

- segera

- Landai

- keserampangan

- jarak

- mulai

- siap

- alasan

- menerima

- resep

- sarankan

- direkomendasikan

- mengacu

- Bagaimanapun juga

- daerah

- relatif

- relativitas

- ulang

- mewakili

- permintaan

- membutuhkan

- penelitian

- peneliti

- Sumber

- masing-masing

- Menanggapi

- ISTIRAHAT

- mengakibatkan

- Hasil

- Sungai

- Peran

- peran

- Run

- berjalan

- s

- Safety/keselamatan

- pembuat bijak

- garam

- sama

- terukur

- Skala

- ilmuwan

- ilmuwan

- SDK

- SEA

- Pencarian

- mencari

- Bagian

- aman

- keamanan

- melihat

- melihat

- tampak

- terpilih

- memilih

- seleksi

- mengirim

- senior

- sentimen

- Seri

- Layanan

- porsi

- set

- pengaturan

- Bentuknya

- hiu

- tas

- harus

- Menunjukkan

- menunjukkan

- Pertunjukkan

- mematikan

- makna

- penting

- Sederhana

- hanya

- tunggal

- situs web

- Situs

- ENAM

- Ukuran

- Perlahan

- kecil

- So

- sejauh ini

- Sosial

- media sosial

- Solusi

- beberapa

- sumber

- sumber

- khusus

- spesialis

- ditentukan

- kecepatan

- berdiri

- awal

- mulai

- Negara

- Negara

- statistik

- Langkah

- Tangga

- terhenti

- Penyelarasan

- Tali

- struktur

- studio

- Menakjubkan

- subyek

- selanjutnya

- sukses

- berhasil

- seperti itu

- Didukung

- yakin

- simbol

- sistem

- tabel

- Mengambil

- Dibutuhkan

- tugas

- rasa

- tim

- tech

- Teknologi

- sementara

- istilah

- dari

- Terima kasih

- bahwa

- Grafik

- Ibukota

- Masa depan

- Sumber

- Dunia

- mereka

- Mereka

- teori

- Sana.

- Ini

- mereka

- hal

- berpikir

- ini

- meskipun?

- Melalui

- Harimau

- waktu

- Seri waktu

- kali

- Judul

- untuk

- hari ini

- bersama

- token

- Token

- alat

- puncak

- Total

- Menara

- Pelatihan VE

- Pelatihan

- transformator

- menterjemahkan

- Terjemahan

- angkutan

- Triliun

- mencoba

- dua

- mengetik

- jenis

- ui

- bawah

- tak terlupakan

- unik

- universitas

- sampai

- Memperbarui

- Pembaruan

- dapat digunakan

- menggunakan

- gunakan case

- bekas

- Pengguna

- Pengguna

- kegunaan

- menggunakan

- nilai

- Nilai - Nilai

- variasi

- versi

- Versi

- sangat

- melalui

- View

- 'view'

- penglihatan

- Mengunjungi

- pengunjung

- volume

- ingin

- perang

- adalah

- we

- jaringan

- layanan web

- berbasis web

- Situs Web

- BAIK

- Ikan paus

- Apa

- Apa itu

- ketika

- sedangkan

- yang

- sementara

- mengapa

- akan

- Windows

- dengan

- Word

- kata

- Kerja

- bekerja

- dunia

- terkenal di dunia

- membungkus

- tahun

- York

- Kamu

- Anda

- diri

- zephyrnet.dll

- Zip