Selama beberapa tahun terakhir, platform pendidikan online telah melihat peningkatan adopsi dan peningkatan permintaan untuk pembelajaran berbasis video karena menawarkan media yang efektif untuk melibatkan pelajar. Untuk memperluas ke pasar internasional dan mengatasi populasi yang beragam secara budaya dan bahasa, bisnis juga mencari diversifikasi penawaran pembelajaran mereka dengan melokalkan konten ke dalam berbagai bahasa. Bisnis ini mencari cara yang andal dan hemat biaya untuk menyelesaikan kasus penggunaan pelokalan mereka.

Melokalkan konten terutama mencakup menerjemahkan suara asli ke dalam bahasa baru dan menambahkan alat bantu visual seperti subtitle. Secara tradisional, proses ini mahal, manual, dan memakan banyak waktu, termasuk bekerja dengan spesialis pelokalan. Dengan kecanggihan layanan pembelajaran mesin (ML) AWS seperti Amazon Transkripsikan, Amazon Terjemahan, dan Amazon Polly, Anda dapat membuat solusi pelokalan yang layak dan hemat biaya. Anda dapat menggunakan Amazon Transcribe untuk membuat transkrip streaming audio dan video yang ada, lalu menerjemahkan transkrip ini ke dalam berbagai bahasa menggunakan Amazon Translate. Anda kemudian dapat menggunakan Amazon Polly, layanan text-to-speech, untuk mengonversi teks yang diterjemahkan menjadi ucapan manusia yang terdengar alami.

Langkah pelokalan berikutnya adalah menambahkan subtitel ke konten, yang dapat meningkatkan aksesibilitas dan pemahaman, serta membantu pemirsa memahami video dengan lebih baik. Pembuatan subtitel pada konten video dapat menjadi tantangan karena ucapan yang diterjemahkan tidak sesuai dengan waktu bicara aslinya. Sinkronisasi antara audio dan subtitel ini merupakan tugas penting untuk dipertimbangkan karena dapat memutuskan penonton dari konten Anda jika mereka tidak sinkron. Amazon Polly menawarkan solusi untuk tantangan ini dengan mengaktifkan tanda bicara, yang dapat Anda gunakan untuk membuat file subtitle yang dapat disinkronkan dengan output ucapan yang dihasilkan.

Dalam posting ini, kami meninjau solusi pelokalan menggunakan layanan AWS ML di mana kami menggunakan video asli bahasa Inggris dan mengubahnya menjadi bahasa Spanyol. Kami juga fokus menggunakan tanda ucapan untuk membuat file subtitle yang disinkronkan dalam bahasa Spanyol.

Ikhtisar solusi

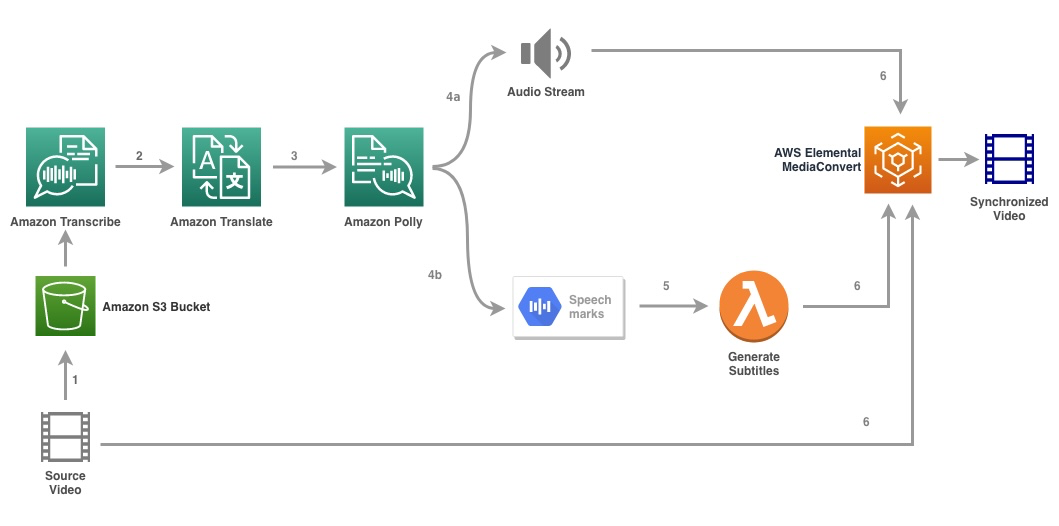

Diagram berikut menggambarkan arsitektur solusi.

Solusinya mengambil file video dan pengaturan bahasa target sebagai input dan menggunakan Amazon Transcribe untuk membuat transkripsi video. Kami kemudian menggunakan Amazon Translate untuk menerjemahkan transkrip ke bahasa target. Teks yang diterjemahkan diberikan sebagai masukan ke Amazon Polly untuk menghasilkan aliran audio dan tanda ucapan dalam bahasa target. Amazon Polly kembali keluaran tanda bicara dalam aliran JSON yang dibatasi garis, yang berisi bidang seperti waktu, jenis, awal, akhir, dan nilai. Nilainya dapat bervariasi tergantung pada jenis tanda ucapan yang diminta dalam input, seperti SSML, viseme, kata, atau kalimat. Untuk tujuan contoh kami, kami meminta jenis tanda bicara as word. Dengan opsi ini, Amazon Polly memecah kalimat menjadi kata-kata tersendiri dalam kalimat dan waktu mulai dan berakhirnya di aliran audio. Dengan metadata ini, tanda ucapan kemudian diproses untuk menghasilkan subtitle untuk aliran audio terkait yang dihasilkan oleh Amazon Polly.

Akhirnya, kami menggunakan Konversi Media Elemen AWS untuk membuat video akhir dengan audio yang diterjemahkan dan subtitle yang sesuai.

Video berikut menunjukkan hasil akhir dari solusi:

Alur kerja AWS Step Functions

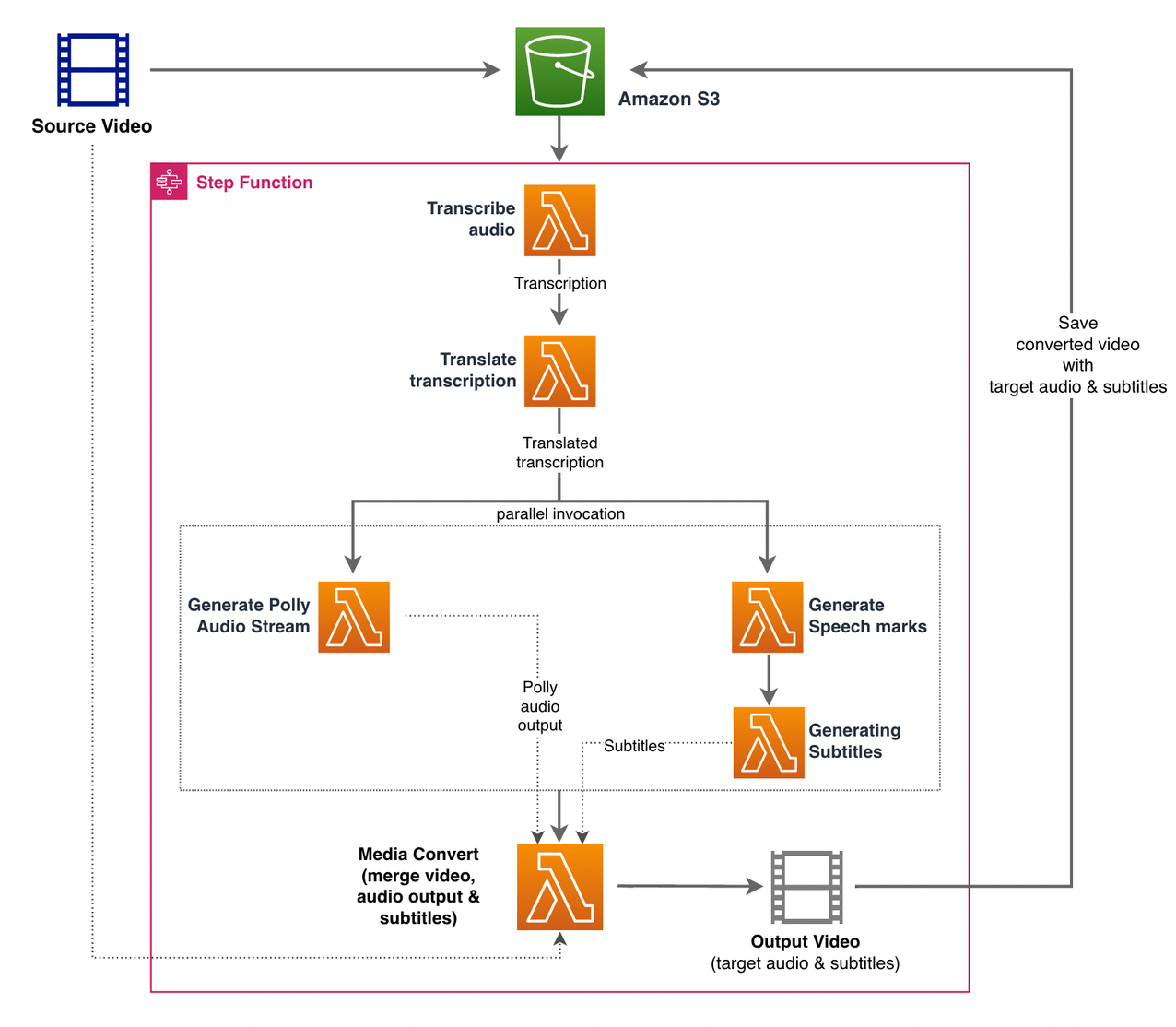

Kami menggunakan Fungsi Langkah AWS untuk mengatur proses ini. Gambar berikut menunjukkan tampilan tingkat tinggi dari alur kerja Fungsi Langkah (beberapa langkah dihilangkan dari diagram untuk kejelasan yang lebih baik).

Langkah-langkah alur kerjanya adalah sebagai berikut:

- Seorang pengguna mengunggah file video sumber ke Layanan Penyimpanan Sederhana Amazon (Amazon S3).

- Grafik Pemberitahuan acara S3 memicu AWS Lambda fungsi state_machine.py (tidak ditampilkan dalam diagram), yang memanggil mesin status Step Functions.

- Langkah pertama, Transkripsikan audio, memanggil fungsi Lambda transkrip.py, yang menggunakan Amazon Transcribe untuk menghasilkan transkrip audio dari video sumber.

Kode contoh berikut menunjukkan cara membuat tugas transkripsi menggunakan Amazon Transcribe bot3 SDK Python:

Setelah pekerjaan selesai, file output disimpan ke dalam ember S3 dan proses berlanjut ke langkah berikutnya untuk menerjemahkan konten.

- Grafik Terjemahkan transkripsi langkah memanggil fungsi Lambda terjemahkan.py yang menggunakan Amazon Translate untuk menerjemahkan transkrip ke bahasa target. Di sini, kami menggunakan terjemahan sinkron/waktu nyata menggunakan terjemahkan_teks fungsi:

Terjemahan sinkron memiliki batasan pada ukuran dokumen yang dapat diterjemahkan; pada tulisan ini, itu diatur ke 5,000 byte. Untuk ukuran dokumen yang lebih besar, pertimbangkan untuk menggunakan rute asinkron untuk membuat pekerjaan menggunakan mulai_teks_translasi_pekerjaan dan memeriksa status melalui deskripsikan_teks_terjemahan_pekerjaan.

- Langkah selanjutnya adalah Fungsi Langkah Paralel negara, di mana kita membuat cabang paralel di mesin negara kita.

- Di cabang pertama, kami memanggil fungsi Lambda fungsi Lambda menghasilkan_polly_audio.py untuk menghasilkan aliran audio Amazon Polly kami:

Di sini kita menggunakan mulai_ucapan_sintesis_tugas metode Amazon Polly Python SDK untuk memicu tugas sintesis ucapan yang membuat audio Amazon Polly. Kami mengatur

OutputFormatuntukmp3, yang memberi tahu Amazon Polly untuk menghasilkan aliran audio untuk panggilan API ini. - Di cabang kedua, kami memanggil fungsi Lambda menghasilkan_speech_marks.py untuk menghasilkan keluaran tanda bicara:

- Di cabang pertama, kami memanggil fungsi Lambda fungsi Lambda menghasilkan_polly_audio.py untuk menghasilkan aliran audio Amazon Polly kami:

- Kami kembali menggunakan mulai_ucapan_sintesis_tugas metode tetapi tentukan

OutputFormatuntukjson, yang memberi tahu Amazon Polly untuk membuat tanda ucapan untuk panggilan API ini.

Pada langkah berikutnya dari cabang kedua, kita memanggil fungsi Lambda menghasilkan_subtitle.py, yang mengimplementasikan logika untuk menghasilkan file subtitle dari keluaran tanda ucapan.

Ini menggunakan modul Python dalam file webvtt_utils.py. Modul ini memiliki beberapa fungsi utilitas untuk membuat file subtitle; salah satu metode tersebut get_phrases_from_speechmarks bertanggung jawab untuk mengurai file tanda ucapan. Struktur JSON tanda ucapan hanya menyediakan waktu mulai untuk setiap kata satu per satu. Untuk membuat pengaturan waktu subtitle yang diperlukan untuk file SRT, pertama-tama kita buat frasa sekitar n (di mana n=10) kata dari daftar kata dalam file tanda ucapan. Kemudian kami menulisnya ke dalam format file SRT, mengambil waktu mulai dari kata pertama dalam frasa, dan untuk waktu akhir kami menggunakan waktu mulai dari kata (n+1) dan menguranginya dengan 1 untuk membuat entri berurutan . Fungsi berikut membuat frasa sebagai persiapan untuk menulisnya ke file SRT:

- Langkah terakhir, Media Convert, memanggil fungsi Lambda buat_mediaconvert_job.py untuk menggabungkan aliran audio dari Amazon Polly dan file subtitle dengan file video sumber untuk menghasilkan file output akhir, yang kemudian disimpan dalam bucket S3. Langkah ini menggunakan

MediaConvert, layanan transcoding video berbasis file dengan fitur tingkat siaran. Ini memungkinkan Anda untuk dengan mudah membuat konten video-on-demand dan menggabungkan kemampuan video dan audio tingkat lanjut dengan antarmuka web yang sederhana. Di sini lagi kita menggunakan Python bot3 SDK untuk membuatMediaConvertpekerjaan:

Prasyarat

Sebelum memulai, Anda harus memiliki prasyarat berikut:

Terapkan solusinya

Untuk menerapkan solusi menggunakan AWS CDK, selesaikan langkah-langkah berikut:

- Clone file gudang:

- Untuk memastikan AWS CDK adalah bootstrap, jalankan perintah

cdk bootstrapdari root repositori: - Ubah direktori kerja ke root repositori dan jalankan perintah berikut:

Secara default, pengaturan audio target diatur ke Bahasa Spanyol AS (es-US). Jika Anda berencana untuk mengujinya dengan bahasa target yang berbeda, gunakan perintah berikut:

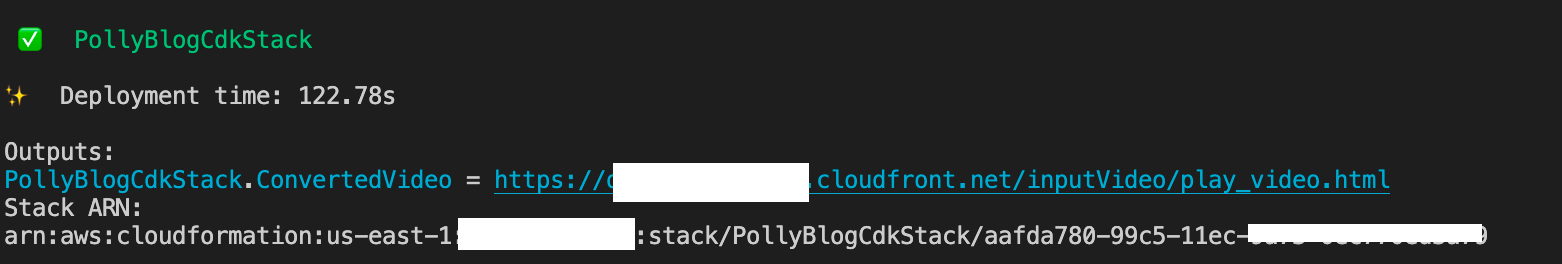

Prosesnya memakan waktu beberapa menit untuk diselesaikan, setelah itu akan ditampilkan tautan yang dapat Anda gunakan untuk melihat file video target dengan audio yang diterjemahkan dan subtitle yang diterjemahkan.

Uji solusinya

Untuk menguji solusi ini, kami menggunakan sebagian kecil dari berikut ini: Video AWS re:Invent 2017 dari YouTube, tempat Amazon Transcribe pertama kali diperkenalkan. Anda juga dapat menguji solusinya dengan video Anda sendiri. Bahasa asli dari video pengujian kami adalah bahasa Inggris. Saat Anda menggunakan solusi ini, Anda dapat menentukan pengaturan audio target atau Anda dapat menggunakan pengaturan audio target default, yang menggunakan bahasa Spanyol untuk menghasilkan audio dan subtitle. Solusinya membuat ember S3 yang dapat digunakan untuk mengunggah file video.

- Di konsol Amazon S3, navigasikan ke bucket

PollyBlogBucket.

- Pilih ember, navigasikan ke

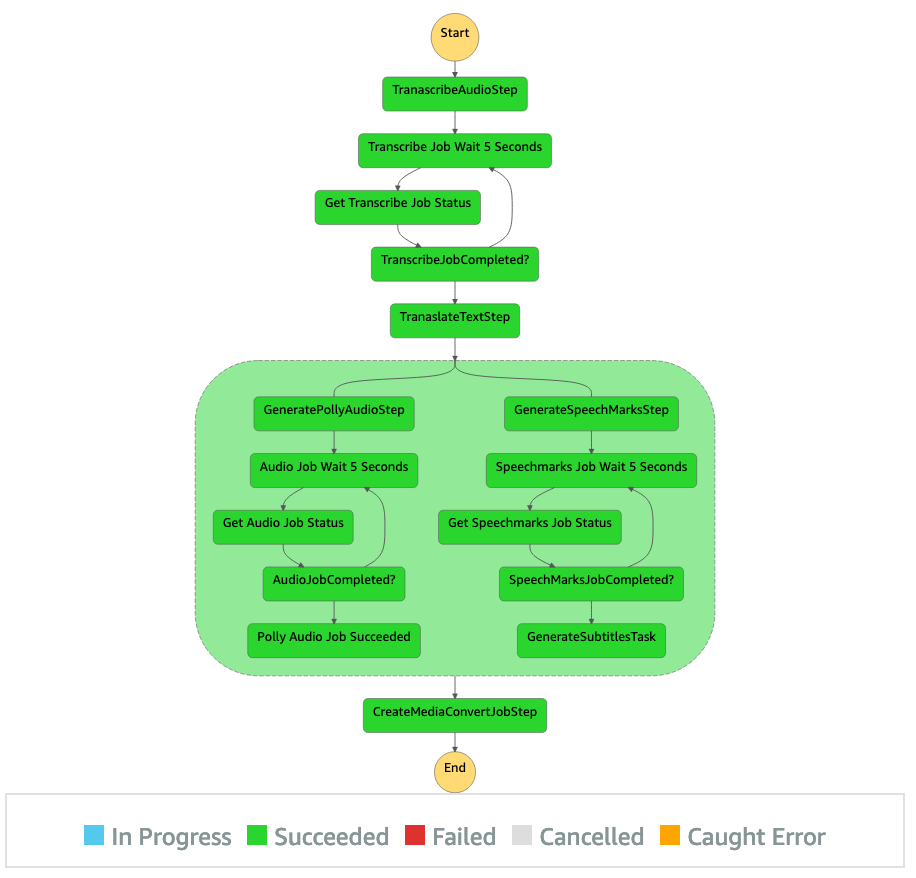

/inputVideodirektori, dan unggah file video (solusinya diuji dengan video bertipe mp4). Pada titik ini, pemberitahuan peristiwa S3 memicu fungsi Lambda, yang memulai mesin status. - Pada konsol Step Functions, telusuri ke mesin status (

ProcessAudioWithSubtitles). - Pilih salah satu menjalankan mesin negara untuk menemukan Inspektur Grafik.

Ini menunjukkan hasil run untuk setiap negara bagian. Alur kerja Step Functions membutuhkan waktu beberapa menit untuk diselesaikan, setelah itu Anda dapat memverifikasi apakah semua langkah berhasil diselesaikan.

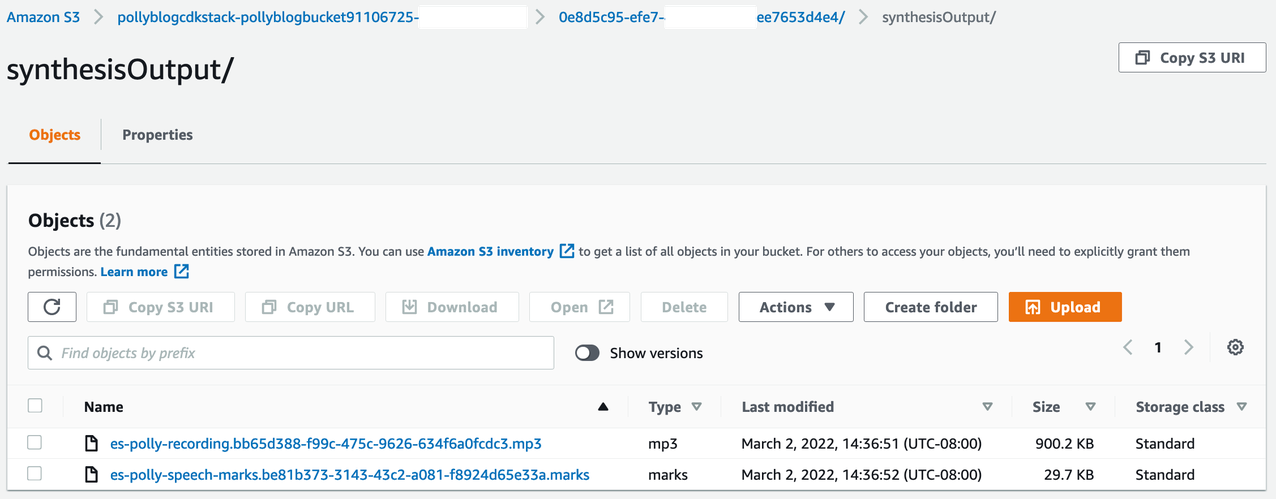

Tinjau hasilnya

Untuk meninjau output, buka konsol Amazon S3 dan periksa apakah file audio (.mp3) dan file tanda ucapan (.marks) disimpan di bucket S3 di bawah <ROOT_S3_BUCKET>/<UID>/synthesisOutput/.

Berikut ini adalah contoh file tanda ucapan yang dihasilkan dari teks terjemahan:

Dalam output ini, setiap bagian teks dipecah dalam hal tanda bicara:

- waktu – Stempel waktu dalam milidetik dari awal aliran audio yang sesuai

- mengetik – Jenis tanda ujaran (kalimat, kata, viseme, atau SSML)

- awal – Offset dalam byte (bukan karakter) dari awal objek dalam teks input (tidak termasuk tanda viseme)

- akhir – Offset dalam byte (bukan karakter) dari akhir objek dalam teks input (tidak termasuk tanda viseme)

- nilai – Kata-kata individu dalam kalimat

File subtitle yang dihasilkan ditulis kembali ke bucket S3. Anda dapat menemukan file di bawah <ROOT_S3_BUCKET>/<UID>/subtitlesOutput/. Periksa file subtitle; konten harus mirip dengan teks berikut:

Setelah file subtitle dan file audio dihasilkan, file video sumber akhir dibuat menggunakan MediaConvert. Periksa konsol MediaConvert untuk memverifikasi apakah status pekerjaan adalah COMPLETE.

Ketika pekerjaan MediaConvert selesai, file video akhir dibuat dan disimpan kembali ke bucket S3, yang dapat ditemukan di bawah <ROOT_S3_BUCKET>/<UID>/convertedAV/.

Sebagai bagian dari penerapan ini, video final didistribusikan melalui sebuah Amazon CloudFront (CDN) dan ditampilkan di terminal atau di Formasi AWS Cloud konsol.

Buka URL di browser untuk melihat video asli dengan opsi tambahan untuk audio dan subtitle. Anda dapat memverifikasi bahwa audio dan subtitle yang diterjemahkan sudah sinkron.

Kesimpulan

Dalam posting ini, kami membahas cara membuat versi bahasa baru dari file video tanpa memerlukan intervensi manual. Pembuat konten dapat menggunakan proses ini untuk menyinkronkan audio dan subtitle video mereka dan menjangkau pemirsa global.

Anda dapat dengan mudah mengintegrasikan pendekatan ini ke dalam jalur produksi Anda sendiri untuk menangani volume dan skala besar sesuai kebutuhan Anda. Amazon Polly menggunakan TTS saraf (NTTS) untuk menghasilkan suara text-to-speech yang alami dan seperti manusia. Ini juga mendukung menghasilkan pidato dari SSML, yang memberi Anda kontrol tambahan atas cara Amazon Polly menghasilkan ucapan dari teks yang disediakan. Amazon Polly juga menyediakan berbagai suara yang berbeda dalam berbagai bahasa untuk mendukung kebutuhan Anda.

Mulai layanan pembelajaran mesin AWS dengan mengunjungi halaman produk, atau rujuk ke Lab Solusi Pembelajaran Mesin Amazon halaman tempat Anda dapat berkolaborasi dengan pakar untuk menghadirkan solusi machine learning ke organisasi Anda.

Sumber daya tambahan

Untuk informasi selengkapnya tentang layanan yang digunakan dalam solusi ini, lihat berikut ini:

Tentang penulis

Reagan Rosario bekerja sebagai arsitek solusi di AWS yang berfokus pada perusahaan teknologi pendidikan. Dia senang membantu pelanggan membangun solusi yang skalabel, sangat tersedia, dan aman di AWS Cloud. Dia memiliki lebih dari satu dekade pengalaman bekerja di berbagai peran teknologi, dengan fokus pada rekayasa perangkat lunak dan arsitektur.

Reagan Rosario bekerja sebagai arsitek solusi di AWS yang berfokus pada perusahaan teknologi pendidikan. Dia senang membantu pelanggan membangun solusi yang skalabel, sangat tersedia, dan aman di AWS Cloud. Dia memiliki lebih dari satu dekade pengalaman bekerja di berbagai peran teknologi, dengan fokus pada rekayasa perangkat lunak dan arsitektur.

Anil Kodali adalah Arsitek Solusi dengan Amazon Web Services. Dia bekerja dengan pelanggan AWS EdTech, membimbing mereka dengan praktik terbaik arsitektur untuk memigrasikan beban kerja yang ada ke cloud dan merancang beban kerja baru dengan pendekatan cloud-first. Sebelum bergabung dengan AWS, dia bekerja dengan pengecer besar untuk membantu mereka dengan migrasi cloud mereka.

Anil Kodali adalah Arsitek Solusi dengan Amazon Web Services. Dia bekerja dengan pelanggan AWS EdTech, membimbing mereka dengan praktik terbaik arsitektur untuk memigrasikan beban kerja yang ada ke cloud dan merancang beban kerja baru dengan pendekatan cloud-first. Sebelum bergabung dengan AWS, dia bekerja dengan pengecer besar untuk membantu mereka dengan migrasi cloud mereka.

Prasanna Saraswathi Krishnan adalah Arsitek Solusi dengan Amazon Web Services yang bekerja dengan pelanggan EdTech. Dia membantu mereka mendorong arsitektur cloud dan strategi data mereka menggunakan praktik terbaik. Latar belakangnya adalah komputasi terdistribusi, analitik data besar, dan rekayasa data. Dia bersemangat tentang pembelajaran mesin dan pemrosesan bahasa alami.

Prasanna Saraswathi Krishnan adalah Arsitek Solusi dengan Amazon Web Services yang bekerja dengan pelanggan EdTech. Dia membantu mereka mendorong arsitektur cloud dan strategi data mereka menggunakan praktik terbaik. Latar belakangnya adalah komputasi terdistribusi, analitik data besar, dan rekayasa data. Dia bersemangat tentang pembelajaran mesin dan pemrosesan bahasa alami.

- AI

- ai seni

- generator seni ai

- punya robot

- Lab Solusi Amazon ML

- Amazon Polly

- Amazon Transkripsikan

- Amazon Terjemahan

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll