Amazon SageMaker memudahkan penerapan model pembelajaran mesin (ML) untuk inferensi real-time dan menawarkan beragam pilihan instance ML yang mencakup CPU dan akselerator seperti Inferensi AWS. Sebagai layanan yang terkelola sepenuhnya, Anda dapat menskalakan penerapan model, meminimalkan biaya inferensi, dan mengelola model secara lebih efektif dalam produksi dengan mengurangi beban operasional. Titik akhir inferensi real-time SageMaker terdiri dari titik akhir HTTP dan instans ML yang diterapkan di beberapa Availability Zone untuk ketersediaan tinggi. Pembuat Sage penskalaan otomatis aplikasi dapat secara dinamis menyesuaikan jumlah instance ML yang disediakan untuk suatu model sebagai respons terhadap perubahan beban kerja. Titik akhir secara seragam mendistribusikan permintaan masuk ke instance ML menggunakan algoritma round-robin.

Saat model ML yang diterapkan pada instance menerima panggilan API dari sejumlah besar klien, distribusi permintaan secara acak dapat bekerja dengan baik ketika tidak banyak variabilitas dalam permintaan dan respons Anda. Namun dalam sistem dengan beban kerja AI generatif, permintaan dan respons bisa sangat bervariasi. Dalam kasus ini, sering kali lebih baik melakukan penyeimbangan beban dengan mempertimbangkan kapasitas dan pemanfaatan instance, bukan penyeimbangan beban acak.

Dalam postingan ini, kami membahas strategi perutean permintaan paling rendah (LOR) SageMaker dan bagaimana strategi ini dapat meminimalkan latensi untuk jenis beban kerja inferensi real-time tertentu dengan mempertimbangkan kapasitas dan pemanfaatan instance ML. Kami membahas manfaatnya dibandingkan mekanisme perutean default dan bagaimana Anda dapat mengaktifkan LOR untuk penerapan model Anda. Terakhir, kami menyajikan analisis komparatif peningkatan latensi dengan LOR dibandingkan strategi perutean default perutean acak.

Strategi SageMaker LOR

Secara default, titik akhir SageMaker memiliki strategi perutean acak. SageMaker kini mendukung strategi LOR, yang memungkinkan SageMaker merutekan permintaan secara optimal ke instans yang paling sesuai untuk melayani permintaan tersebut. SageMaker memungkinkan hal ini dengan memantau beban instans di belakang titik akhir Anda, dan model atau komponen inferensi yang diterapkan pada setiap instans.

Diagram interaktif berikut menunjukkan kebijakan perutean default di mana permintaan yang datang ke titik akhir model diteruskan secara acak ke instance ML.

Diagram interaktif berikut menunjukkan strategi perutean di mana SageMaker akan merutekan permintaan ke instans yang memiliki jumlah permintaan luar biasa paling sedikit.

Secara umum, perutean LOR berfungsi dengan baik untuk model dasar atau model AI generatif ketika model Anda merespons dalam ratusan milidetik hingga menit. Jika respons model Anda memiliki latensi lebih rendah (hingga ratusan milidetik), Anda dapat memperoleh manfaat lebih banyak dari perutean acak. Apapun itu, kami menyarankan Anda menguji dan mengidentifikasi algoritma perutean terbaik untuk beban kerja Anda.

Cara mengatur strategi perutean SageMaker

SageMaker sekarang memungkinkan Anda untuk mengatur RoutingStrategy parameter saat membuat EndpointConfiguration untuk titik akhir. Yang berbeda RoutingStrategy nilai-nilai yang didukung oleh SageMaker adalah:

LEAST_OUTSTANDING_REQUESTSRANDOM

Berikut ini adalah contoh penerapan model pada titik akhir inferensi yang mengaktifkan LOR:

- Buat konfigurasi titik akhir dengan mengatur

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Buat titik akhir menggunakan konfigurasi titik akhir (tidak ada perubahan):

Hasil kinerja

Kami menjalankan tolok ukur kinerja untuk mengukur latensi inferensi ujung ke ujung dan throughput kodegen2-7B model yang dihosting di instans ml.g5.24xl dengan perutean default dan titik akhir perutean cerdas. Model CodeGen2 termasuk dalam keluarga model bahasa autoregresif dan menghasilkan kode yang dapat dieksekusi ketika diberikan perintah bahasa Inggris.

Dalam analisis kami, kami meningkatkan jumlah instance ml.g5.24xl di belakang setiap titik akhir untuk setiap pengujian yang dijalankan seiring dengan peningkatan jumlah pengguna secara bersamaan, seperti yang ditunjukkan pada tabel berikut.

| uji | Jumlah Pengguna Bersamaan | Jumlah Instance |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

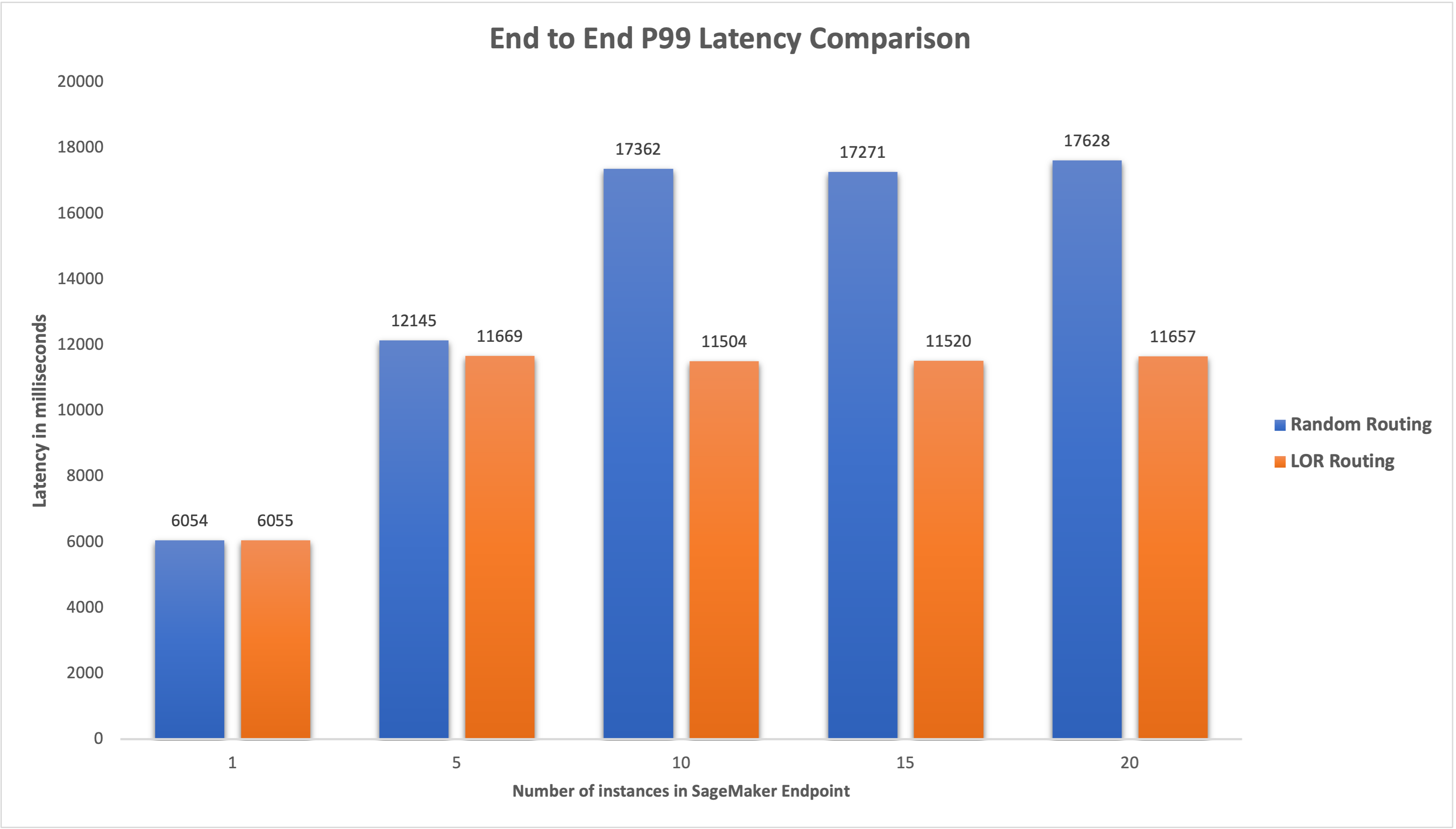

Kami mengukur latensi P99 end-to-end untuk kedua titik akhir dan mengamati peningkatan latensi sebesar 4–33% ketika jumlah instans ditingkatkan dari 5 menjadi 20, seperti yang ditunjukkan pada grafik berikut.

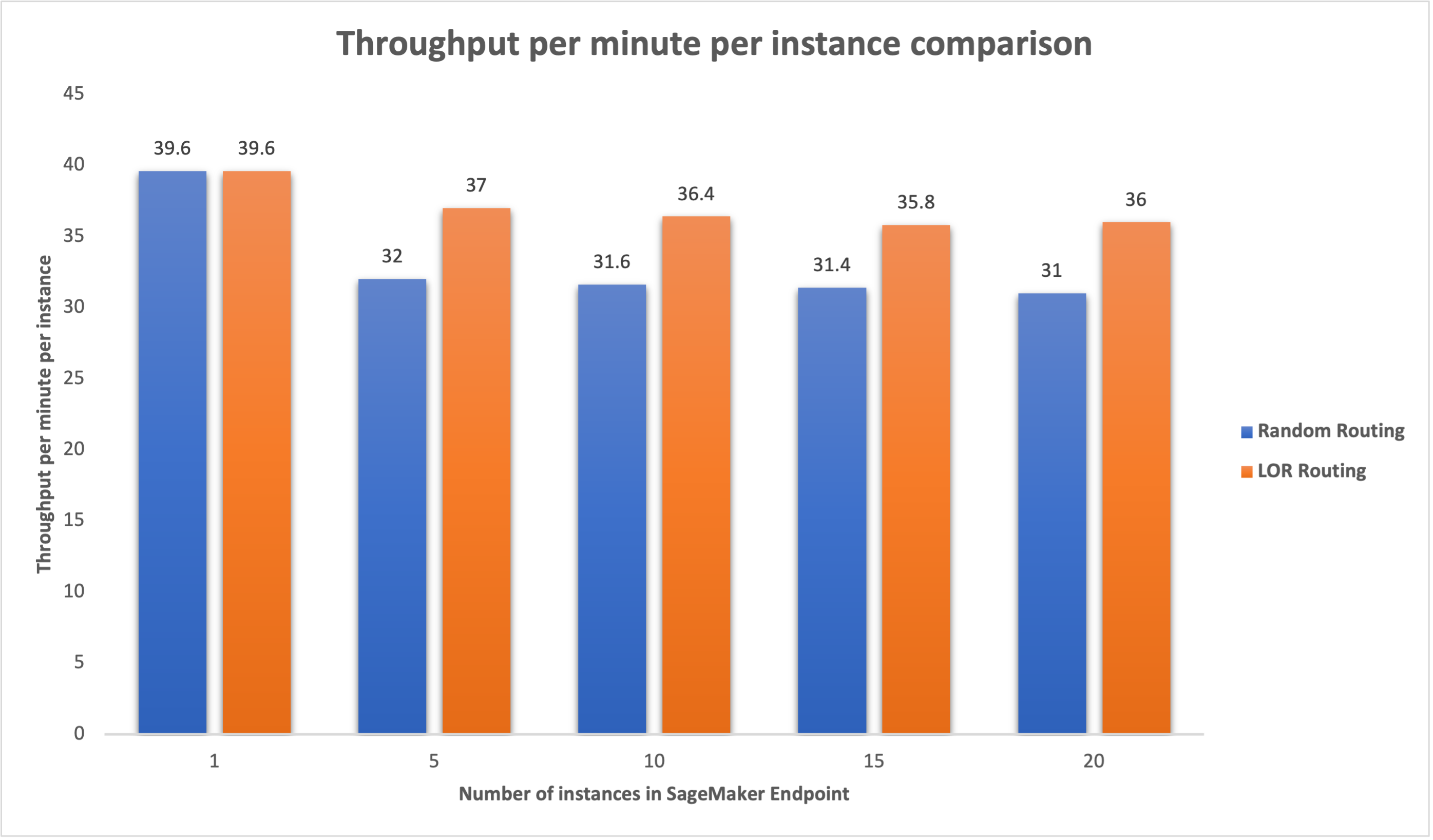

Demikian pula, kami mengamati peningkatan sebesar 15–16% dalam throughput per menit per instans ketika jumlah instans ditingkatkan dari 5 menjadi 20.

Hal ini menggambarkan bahwa perutean cerdas mampu meningkatkan distribusi lalu lintas antar titik akhir, sehingga menghasilkan peningkatan latensi ujung ke ujung dan throughput secara keseluruhan.

Kesimpulan

Dalam postingan ini, kami menjelaskan strategi perutean SageMaker dan opsi baru untuk mengaktifkan perutean LOR. Kami menjelaskan cara mengaktifkan LOR dan manfaatnya bagi penerapan model Anda. Pengujian kinerja kami menunjukkan peningkatan latensi dan throughput selama inferensi real-time. Untuk mempelajari lebih lanjut tentang fitur perutean SageMaker, lihat dokumentasi. Kami mendorong Anda untuk mengevaluasi beban kerja inferensi Anda dan menentukan apakah Anda sudah dikonfigurasikan secara optimal dengan strategi perutean.

Tentang Penulis

James Taman adalah Arsitek Solusi di Amazon Web Services. Dia bekerja dengan Amazon.com untuk merancang, membangun, dan menerapkan solusi teknologi di AWS, dan memiliki minat khusus pada AI dan pembelajaran mesin. Di waktu luangnya, dia senang mencari budaya baru, pengalaman baru, dan mengikuti perkembangan tren teknologi terkini. Anda dapat menemukannya di LinkedIn.

James Taman adalah Arsitek Solusi di Amazon Web Services. Dia bekerja dengan Amazon.com untuk merancang, membangun, dan menerapkan solusi teknologi di AWS, dan memiliki minat khusus pada AI dan pembelajaran mesin. Di waktu luangnya, dia senang mencari budaya baru, pengalaman baru, dan mengikuti perkembangan tren teknologi terkini. Anda dapat menemukannya di LinkedIn.

Venugopal Pai adalah Arsitek Solusi di AWS. Dia tinggal di Bengaluru, India, dan membantu pelanggan asli digital menskalakan dan mengoptimalkan aplikasi mereka di AWS.

Venugopal Pai adalah Arsitek Solusi di AWS. Dia tinggal di Bengaluru, India, dan membantu pelanggan asli digital menskalakan dan mengoptimalkan aplikasi mereka di AWS.

David Nigeria adalah Insinyur Pengembangan Perangkat Lunak Senior di tim Amazon SageMaker, yang saat ini bekerja untuk meningkatkan alur kerja pembelajaran mesin produksi, serta meluncurkan fitur inferensi baru. Di waktu senggangnya, ia berusaha mengikuti perkembangan anak-anaknya.

David Nigeria adalah Insinyur Pengembangan Perangkat Lunak Senior di tim Amazon SageMaker, yang saat ini bekerja untuk meningkatkan alur kerja pembelajaran mesin produksi, serta meluncurkan fitur inferensi baru. Di waktu senggangnya, ia berusaha mengikuti perkembangan anak-anaknya.

Deepti Ragha adalah Insinyur Pengembangan Perangkat Lunak di tim Amazon SageMaker. Pekerjaannya saat ini berfokus pada pembuatan fitur untuk menghosting model pembelajaran mesin secara efisien. Di waktu senggangnya, dia suka jalan-jalan, mendaki gunung, dan menanam tanaman.

Deepti Ragha adalah Insinyur Pengembangan Perangkat Lunak di tim Amazon SageMaker. Pekerjaannya saat ini berfokus pada pembuatan fitur untuk menghosting model pembelajaran mesin secara efisien. Di waktu senggangnya, dia suka jalan-jalan, mendaki gunung, dan menanam tanaman.

Alan Tan adalah Manajer Produk Senior dengan SageMaker, memimpin upaya pada inferensi model besar. Dia bersemangat menerapkan pembelajaran mesin ke bidang analitik. Di luar pekerjaan, dia menikmati alam bebas.

Alan Tan adalah Manajer Produk Senior dengan SageMaker, memimpin upaya pada inferensi model besar. Dia bersemangat menerapkan pembelajaran mesin ke bidang analitik. Di luar pekerjaan, dia menikmati alam bebas.

Dhawal Patel adalah Arsitek Pembelajaran Mesin Utama di AWS. Dia telah bekerja dengan organisasi mulai dari perusahaan besar hingga perusahaan rintisan menengah pada masalah yang terkait dengan komputasi terdistribusi, dan Kecerdasan Buatan. Dia berfokus pada Deep learning termasuk domain NLP dan Computer Vision. Dia membantu pelanggan mencapai inferensi model kinerja tinggi di SageMaker.

Dhawal Patel adalah Arsitek Pembelajaran Mesin Utama di AWS. Dia telah bekerja dengan organisasi mulai dari perusahaan besar hingga perusahaan rintisan menengah pada masalah yang terkait dengan komputasi terdistribusi, dan Kecerdasan Buatan. Dia berfokus pada Deep learning termasuk domain NLP dan Computer Vision. Dia membantu pelanggan mencapai inferensi model kinerja tinggi di SageMaker.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- Sanggup

- Tentang Kami

- akselerator

- Mencapai

- di seluruh

- AI

- Model AI

- Alan

- algoritma

- memungkinkan

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- antara

- an

- analisis

- analisis

- dan

- api

- aplikasi

- Menerapkan

- ADALAH

- DAERAH

- buatan

- kecerdasan buatan

- AS

- At

- mobil

- tersedianya

- AWS

- Saldo

- balancing

- BE

- di belakang

- milik

- benchmarking

- manfaat

- Manfaat

- TERBAIK

- kedua

- luas

- membangun

- Bangunan

- beban

- tapi

- by

- Panggilan

- CAN

- Kapasitas

- kasus

- tertentu

- perubahan

- Perubahan

- klien

- kode

- COM

- kedatangan

- komponen

- komputer

- Visi Komputer

- komputasi

- bersamaan

- konfigurasi

- dikonfigurasi

- pertimbangan

- mengingat

- terdiri

- Biaya

- membuat

- terbaru

- Sekarang

- pelanggan

- Tanggal

- mendalam

- belajar mendalam

- Default

- menyebarkan

- dikerahkan

- penyebaran

- penyebaran

- Mendesain

- Menentukan

- Pengembangan

- berbeda

- membahas

- didistribusikan

- komputasi terdistribusi

- distribusi

- domain

- selama

- dinamis

- setiap

- efektif

- efisien

- upaya

- aktif

- diaktifkan

- mendorong

- ujung ke ujung

- Titik akhir

- insinyur

- Inggris

- perusahaan

- mengevaluasi

- contoh

- Pengalaman

- menjelaskan

- sangat

- keluarga

- Fitur

- Akhirnya

- Menemukan

- berfokus

- berikut

- Untuk

- dasar

- dari

- sepenuhnya

- Umum

- menghasilkan

- generatif

- AI generatif

- gif

- diberikan

- grafik

- Pertumbuhan

- Memiliki

- he

- membantu

- dia

- High

- dia

- -nya

- tuan rumah

- host

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- HTTPS

- Ratusan

- mengenali

- if

- menggambarkan

- memperbaiki

- perbaikan

- perbaikan

- meningkatkan

- in

- Termasuk

- masuk

- Pada meningkat

- India

- contoh

- Intelijen

- interaktif

- bunga

- ke

- IT

- NYA

- jpg

- Menjaga

- anak

- bahasa

- besar

- Perusahaan besar

- Latensi

- Terbaru

- peluncuran

- terkemuka

- BELAJAR

- pengetahuan

- paling sedikit

- hidup

- memuat

- Lot

- menurunkan

- mesin

- Mesin belajar

- MEMBUAT

- mengelola

- berhasil

- manajer

- cara

- Mungkin..

- mengukur

- mekanisme

- milidetik

- menit

- menit

- ML

- model

- model

- pemantauan

- lebih

- beberapa

- New

- nLP

- tidak

- sekarang

- jumlah

- of

- Penawaran

- sering

- on

- operasional

- Optimize

- pilihan

- or

- organisasi

- kami

- di luar

- di luar rumah

- di luar

- terkemuka

- lebih

- secara keseluruhan

- parameter

- tertentu

- bergairah

- untuk

- prestasi

- tanaman

- plato

- Kecerdasan Data Plato

- Data Plato

- kebijaksanaan

- mungkin

- Pos

- menyajikan

- Utama

- masalah

- Produk

- manajer produk

- Produksi

- meminta

- acak

- mulai

- agak

- real-time

- menerima

- sarankan

- mengurangi

- lihat

- Bagaimanapun juga

- terkait

- permintaan

- permintaan

- tanggapan

- tanggapan

- Rute

- rute

- Run

- pembuat bijak

- Skala

- pencarian

- seleksi

- senior

- melayani

- layanan

- Layanan

- set

- pengaturan

- dia

- menunjukkan

- ditunjukkan

- Pertunjukkan

- pintar

- Perangkat lunak

- pengembangan perangkat lunak

- Solusi

- ketegangan

- Startups

- tinggal

- mudah

- strategi

- Penyelarasan

- seperti itu

- Didukung

- Mendukung

- sistem

- tabel

- pengambilan

- Berbicara

- tim

- Teknologi

- uji

- tes

- dari

- bahwa

- Grafik

- Daerah

- mereka

- Sana.

- Ini

- ini

- keluaran

- waktu

- untuk

- lalu lintas

- Perjalanan

- Tren

- jenis

- Pengguna

- menggunakan

- Nilai - Nilai

- variabel

- sangat

- penglihatan

- we

- jaringan

- layanan web

- BAIK

- adalah

- ketika

- yang

- sementara

- akan

- dengan

- Kerja

- bekerja

- Alur kerja

- kerja

- bekerja

- Kamu

- Anda

- zephyrnet.dll

- zona